14 أخطاء شائعة في WordPress Robots.txt يجب تجنبها

نشرت: 2025-01-14Robots.txt هو ملف خادم قوي يخبر برامج زحف البحث وبرامج الروبوت الأخرى بكيفية التصرف على موقع WordPress الخاص بك. يمكن أن يؤثر بشكل كبير على تحسين محرك البحث (SEO) لموقعك، سواء بشكل إيجابي أو سلبي.

لهذا السبب، يجب أن تعرف ما هو هذا الملف وكيفية استخدامه. وإلا، فقد تلحق الضرر بموقعك على الويب، أو على الأقل تترك بعضًا من إمكاناته على الطاولة.

ولمساعدتك على تجنب هذا السيناريو، سنغطي في هذه المقالة ملف robots.txt بالتفصيل. سنحدد ماهيته والغرض منه وكيفية العثور على ملفك وإدارته وما يجب أن يحتوي عليه. بعد ذلك، سنتناول الأخطاء الأكثر شيوعًا التي يرتكبها الأشخاص باستخدام ملف robots.txt الخاص بهم في WordPress، وطرق تجنبها، وكيفية استردادها إذا وجدت أنك ارتكبت خطأ.

ما هو ملف WordPress robots.txt؟

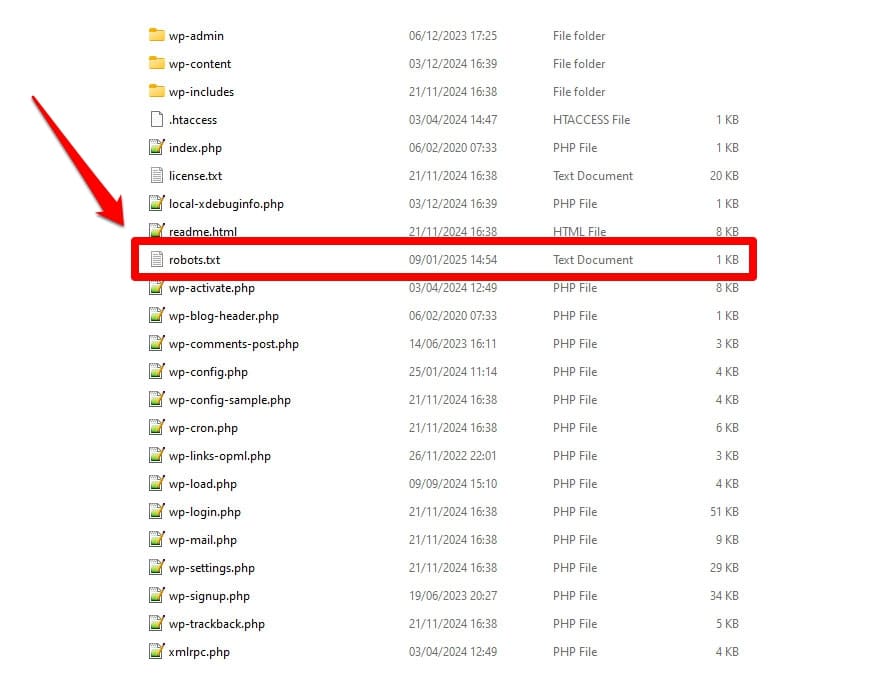

كما ذكرنا سابقًا، فإن ملف robots.txt هو ملف تكوين الخادم. عادةً ما تجده في المجلد الجذر لخادمك.

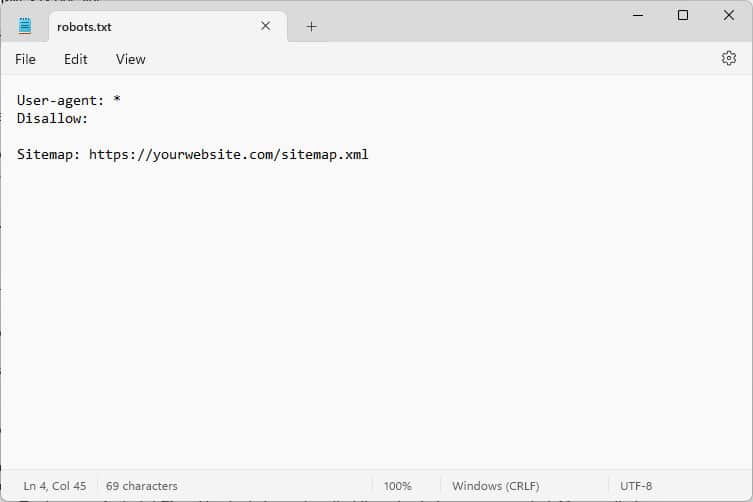

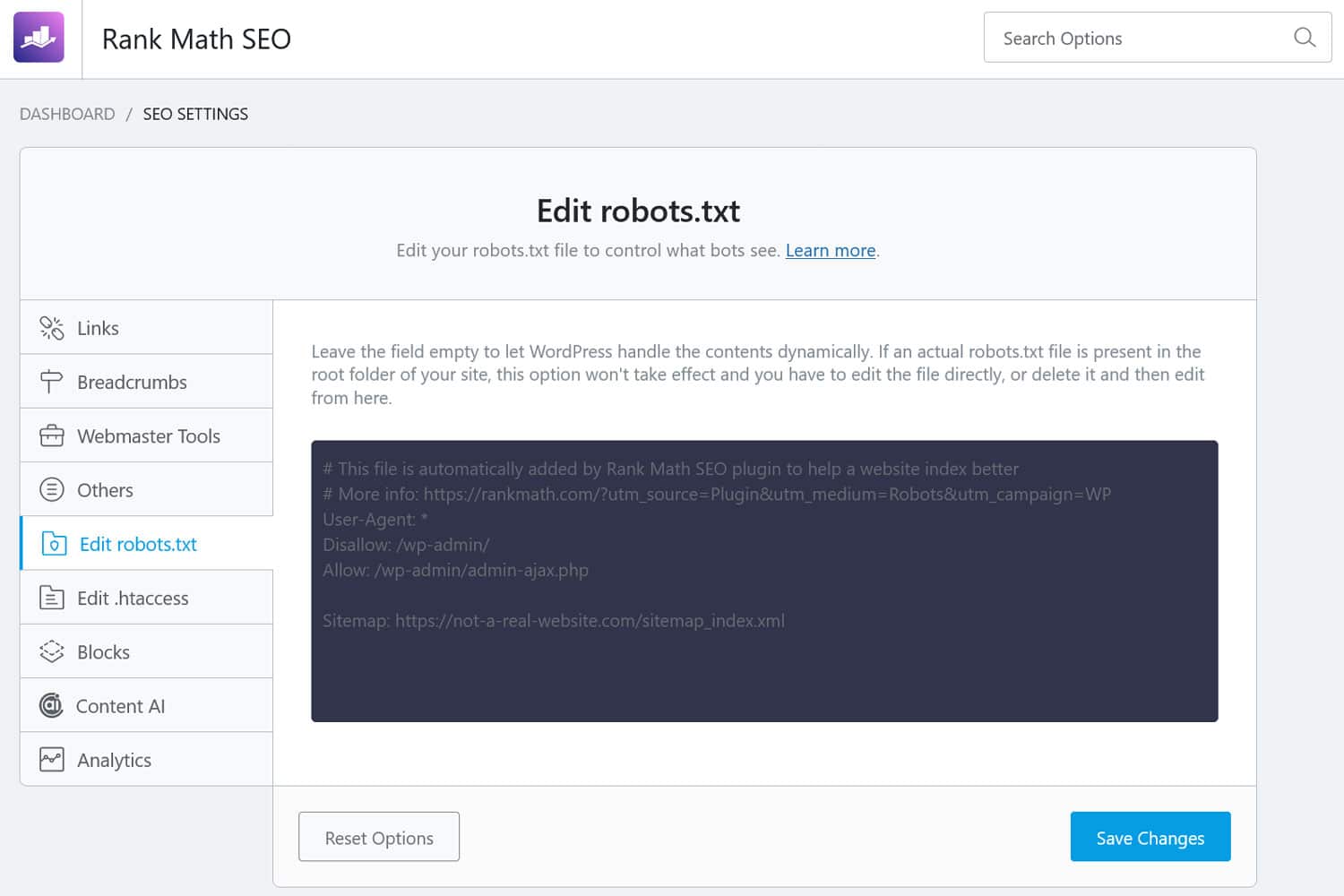

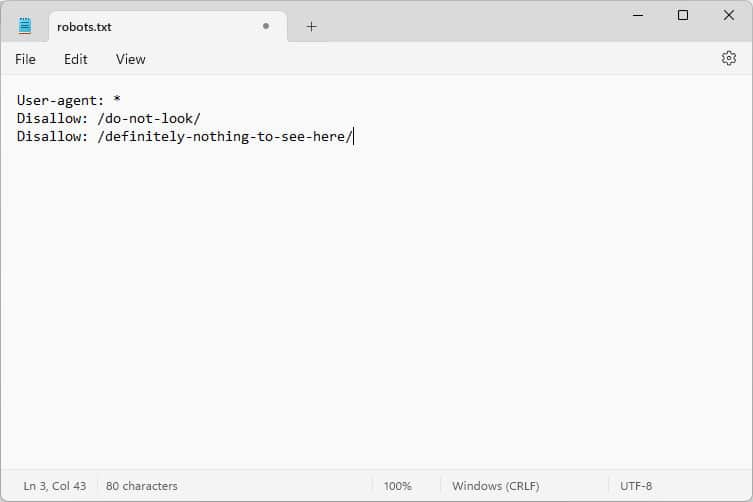

عند فتحه، يبدو المحتوى كما يلي:

هذه الأجزاء من التعليمات البرمجية هي تعليمات تخبر الروبوتات التي تأتي إلى موقع الويب الخاص بك بكيفية التصرف أثناء وجودها هناك - على وجه التحديد، أي أجزاء من موقع الويب الخاص بك يجب الوصول إليها وأيها لا يمكن الوصول إليها.

ما الروبوتات، تسأل؟

الأمثلة الأكثر شيوعًا هي برامج الزحف التلقائية من محركات البحث التي تبحث عن صفحات ويب لفهرستها أو تحديثها، وأيضًا برامج الروبوت من نماذج الذكاء الاصطناعي والأدوات الآلية الأخرى.

ما هي التوجيهات التي يمكنك تقديمها مع هذا الملف؟

يعرف ملف Robots.txt بشكل أساسي أربعة توجيهات رئيسية:

- وكيل المستخدم – يحدد من، ويعني أي مجموعة من الروبوتات الفردية أو القواعد التالية مخصصة لها.

- عدم السماح – يوضح الدلائل أو الملفات أو الموارد التي يُمنع وكيل المستخدم من الوصول إليها.

- السماح - يمكن استخدامه لإعداد الاستثناءات، على سبيل المثال، للسماح بالوصول إلى المجلدات الفردية أو الموارد في الدلائل المحظورة.

- خريطة الموقع - يوجه الروبوتات إلى موقع URL الخاص بخريطة موقع الويب.

يعد User-agent و Disallow فقط إلزاميين لكي يقوم الملف بمهمته؛ التوجيهان الآخران اختياريان. على سبيل المثال، هذه هي الطريقة التي تمنع بها أي روبوتات من الوصول إلى موقعك:

User-agent: * Disallow: /تشير العلامة النجمية إلى أن القاعدة التالية تنطبق على جميع وكلاء المستخدم. تشير الشرطة المائلة بعد Disallow إلى أن جميع الأدلة الموجودة على هذا الموقع محظورة. هذا هو ملف robots.txt الذي تجده عادةً في مواقع التطوير، والذي ليس من المفترض أن تتم فهرسته بواسطة محركات البحث.

ومع ذلك، يمكنك أيضًا إعداد قواعد لبرامج الروبوت الفردية:

User-agent: Googlebot Allow: /private/resources/من المهم ملاحظة أن ملف robots.txt ليس ملزمًا. فقط الروبوتات التابعة للمؤسسات التي تلتزم ببروتوكول استبعاد الروبوتات هي التي ستلتزم بتوجيهاته. يمكن للروبوتات الضارة، مثل تلك التي تبحث عن العيوب الأمنية في موقعك، أن تتجاهلها وسوف تحتاج إلى اتخاذ إجراءات إضافية ضدها.

حتى المنظمات التي تلتزم بالمعيار سوف تتجاهل بعض التوجيهات. سنتحدث عن أمثلة على ذلك أدناه.

ما أهمية ملف robots.txt؟

ليس من الضروري أن يحتوي موقع WordPress الخاص بك على ملف robots.txt. سيعمل موقعك بدونه، ولن تعاقبك محركات البحث لعدم وجوده. ومع ذلك، بما في ذلك واحد يسمح لك بما يلي:

- احتفظ بالمحتوى خارج نتائج البحث، مثل صفحات تسجيل الدخول أو ملفات وسائط معينة.

- امنع برامج زحف البحث من إهدار ميزانية الزحف الخاصة بك على أجزاء غير مهمة من موقعك، وربما تجاهل الصفحات التي تريد فهرستها.

- قم بتوجيه محركات البحث إلى خريطة الموقع الخاصة بك حتى يتمكنوا من استكشاف بقية موقع الويب الخاص بك بسهولة أكبر.

- حافظ على موارد الخادم عن طريق إبعاد الروبوتات المسرفة.

كل هذا يساعد في تحسين موقعك، وخاصةً تحسين محركات البحث (SEO)، ولهذا السبب من المهم أن تفهم كيفية استخدام ملف robots.txt.

كيفية البحث عن ملف robots.txt الخاص بـ WordPress وتحريره وإنشائه

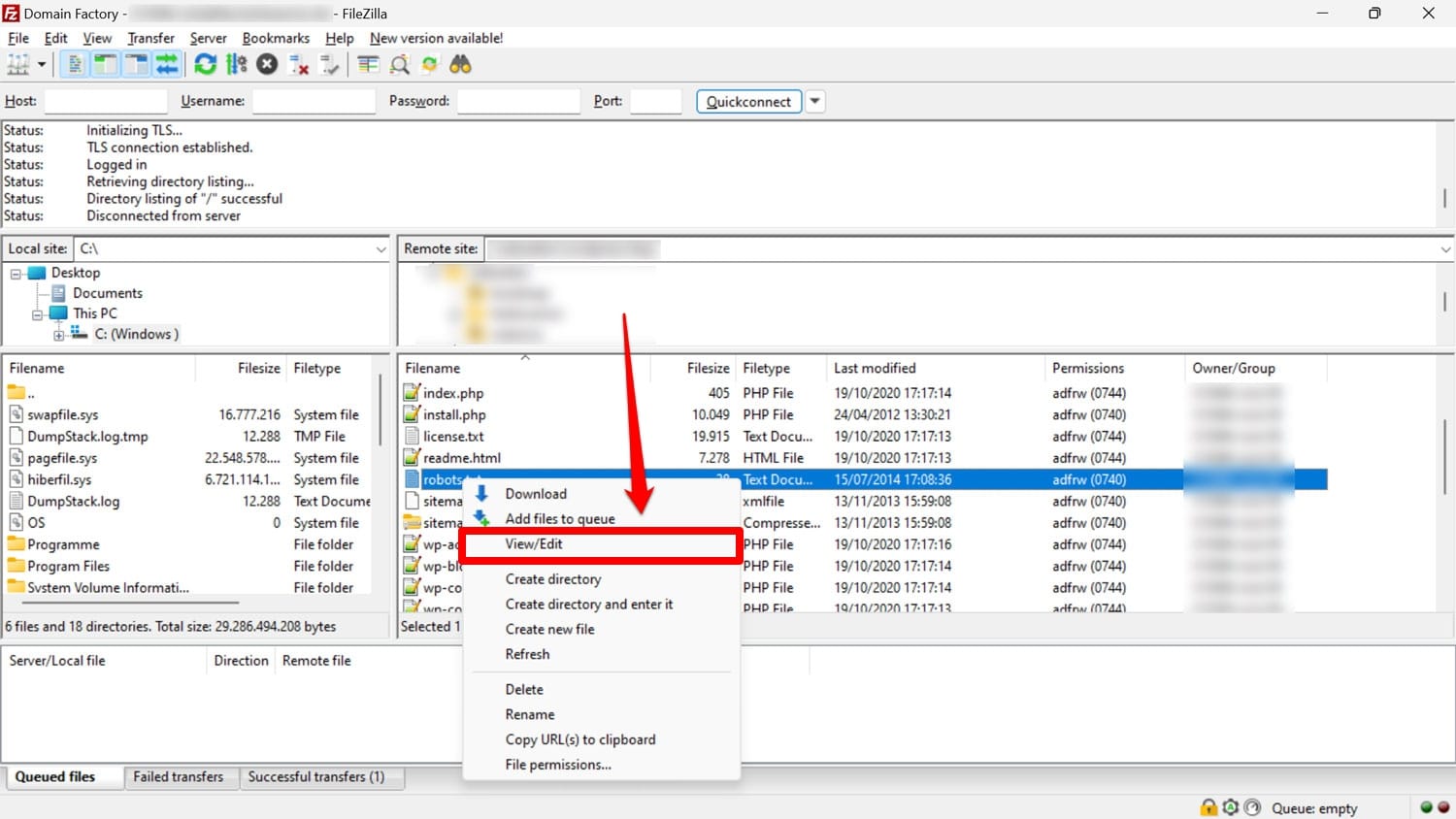

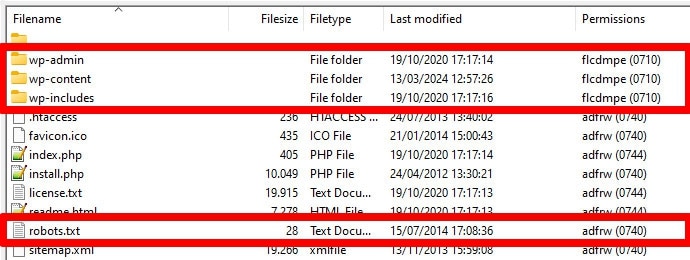

كما ذكرنا سابقًا، عادةً ما يوجد ملف robots.txt في المجلد الجذر لموقع الويب الخاص بك على الخادم. يمكنك الوصول إليه هناك باستخدام عميل FTP مثل FileZilla وتحريره باستخدام أي محرر نصوص.

إذا لم يكن لديك ملف، فمن الممكن ببساطة إنشاء ملف نصي فارغ، وتسميته "robots.txt"، وتعبئته بالتوجيهات، وتحميله.

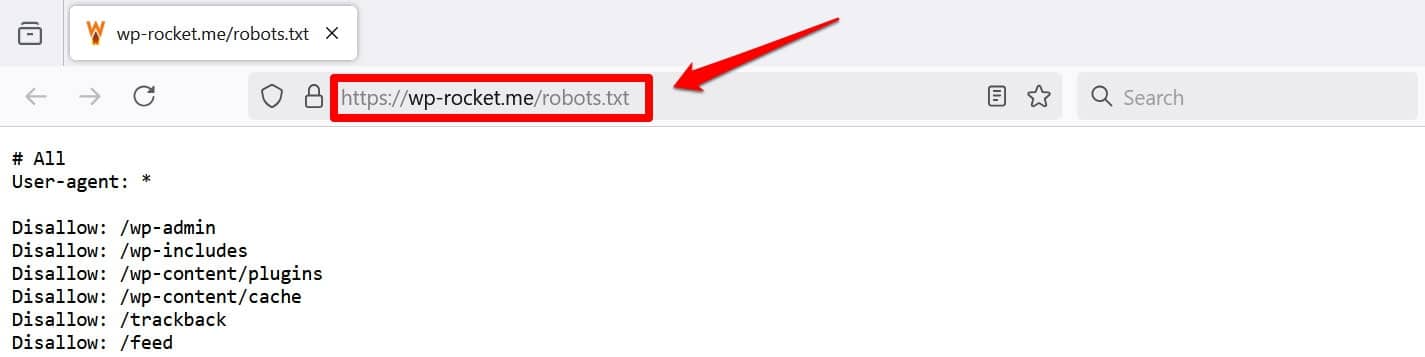

هناك طريقة أخرى لعرض ملفك على الأقل وهي إضافة /robots.txt إلى المجال الخاص بك، على سبيل المثال، https://wp-rocket.me/robots.txt.

بالإضافة إلى ذلك، هناك طرق للوصول إلى الملف من الواجهة الخلفية لـ WordPress. تتيح لك العديد من مكونات SEO الإضافية رؤيتها وإجراء تغييرات عليها غالبًا من واجهة الإدارة.

وبدلاً من ذلك، يمكنك أيضًا استخدام مكون إضافي مثل WPCode.

كيف يبدو ملف WordPress robots.txt الجيد؟

لا توجد إجابة واحدة تناسب الجميع حول التوجيهات التي يجب أن تكون موجودة في ملف موقع الويب الخاص بك؛ ذلك يعتمد على الإعداد الخاص بك. فيما يلي مثال منطقي للعديد من مواقع WordPress:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php Sitemap: https://yourwebsite.com/sitemap.xmlيحقق هذا المثال عدة نتائج:

- يمنع الوصول إلى منطقة الإدارة

- يسمح بالوصول إلى وظائف الإدارة الأساسية

- يوفر موقع خريطة الموقع

يحقق هذا الإعداد توازنًا بين الأمان وأداء تحسين محركات البحث والزحف الفعال.

لا ترتكب هذه الأخطاء الأربعة عشر في ملف robots.txt في WordPress

إذا كان هدفك هو إعداد ملف robots.txt وتحسينه لموقعك، فتأكد من تجنب الأخطاء التالية.

1. تجاهل ملف robots.txt الداخلي في WordPress

حتى إذا لم يكن لديك ملف robots.txt "فعلي" في الدليل الجذر لموقعك، فإن WordPress يأتي مع ملف افتراضي خاص به. من المهم أن تتذكر هذا بشكل خاص إذا وجدت أن محركات البحث لا تقوم بفهرسة موقع الويب الخاص بك.

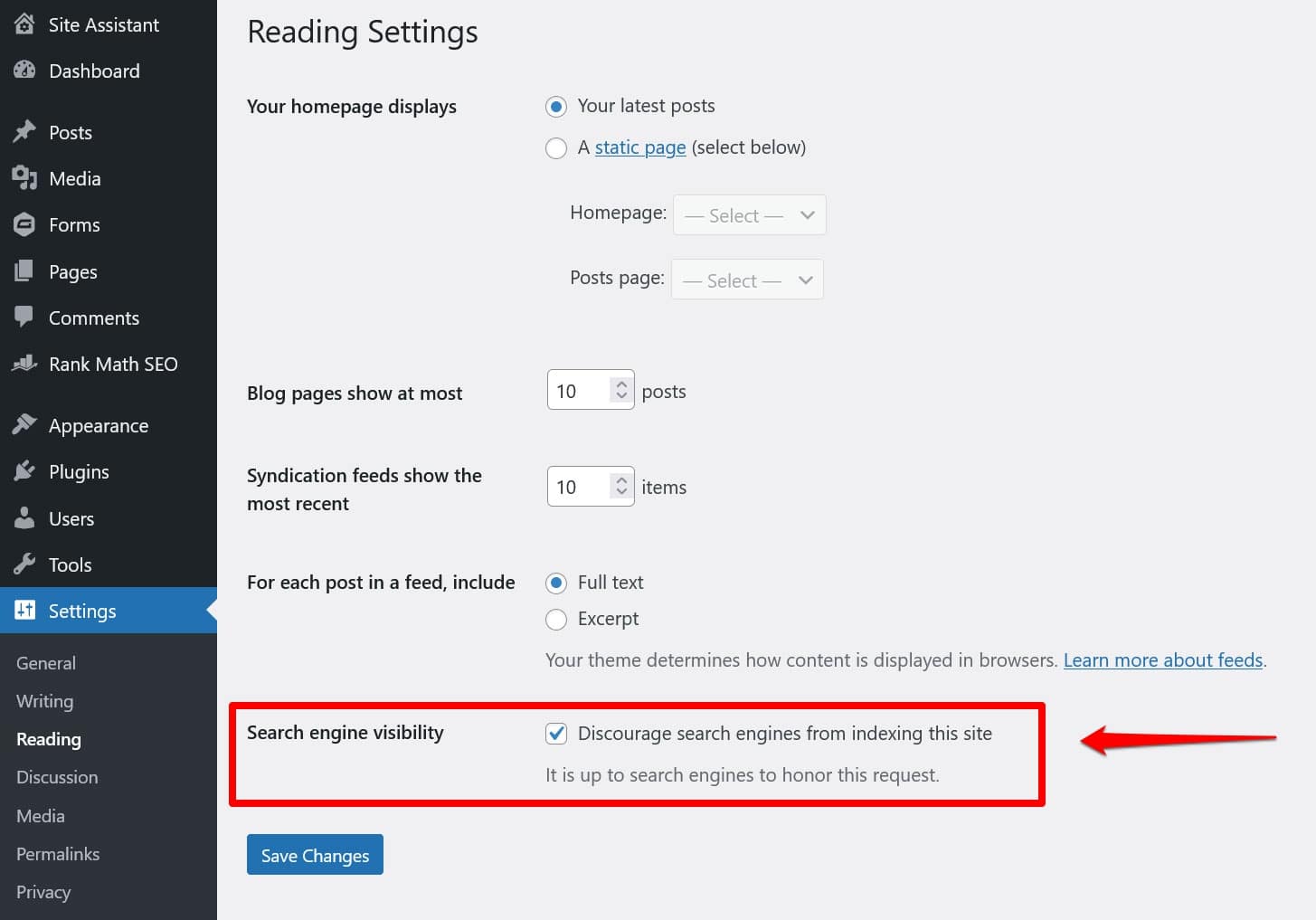

في هذه الحالة، هناك احتمال كبير أنك قمت بتمكين خيار تثبيطهم عن القيام بذلك ضمن الإعدادات > القراءة .

يؤدي هذا إلى وضع توجيه لإبقاء جميع برامج زحف البحث في ملف robots.txt الافتراضي. لتعطيله، قم بإلغاء تحديد المربع واحفظه في الأسفل.

2. وضعه في المكان الخطأ

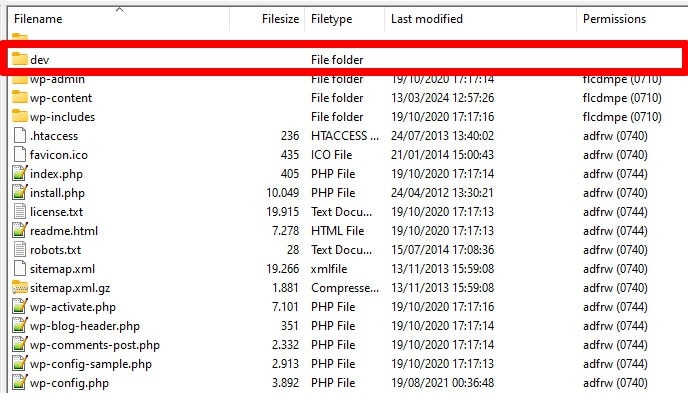

تبحث برامج الروبوت، وخاصة برامج زحف البحث، عن ملف robots.txt الخاص بك في مكان واحد فقط، وهو الدليل الجذر لموقع الويب الخاص بك. إذا قمت بوضعه في أي مكان آخر، مثل مجلد، فلن يجدوه وسيتجاهلونه.

يجب أن يكون الدليل الجذر هو المكان الذي تصل إليه عند الوصول إلى الخادم الخاص بك عبر FTP، إلا إذا قمت بوضع WordPress في دليل فرعي. إذا رأيت المجلدات wp-admin و wp-content و wp-includes ، فأنت في المكان الصحيح.

3. بما في ذلك العلامات القديمة

إلى جانب التوجيهات المذكورة أعلاه، هناك توجيهان آخران قد لا تزال تجدهما في ملفات robots.txt الخاصة بمواقع الويب القديمة:

- Noindex – يُستخدم لتحديد عناوين URL التي ليس من المفترض أن تقوم محركات البحث بفهرستها على موقعك.

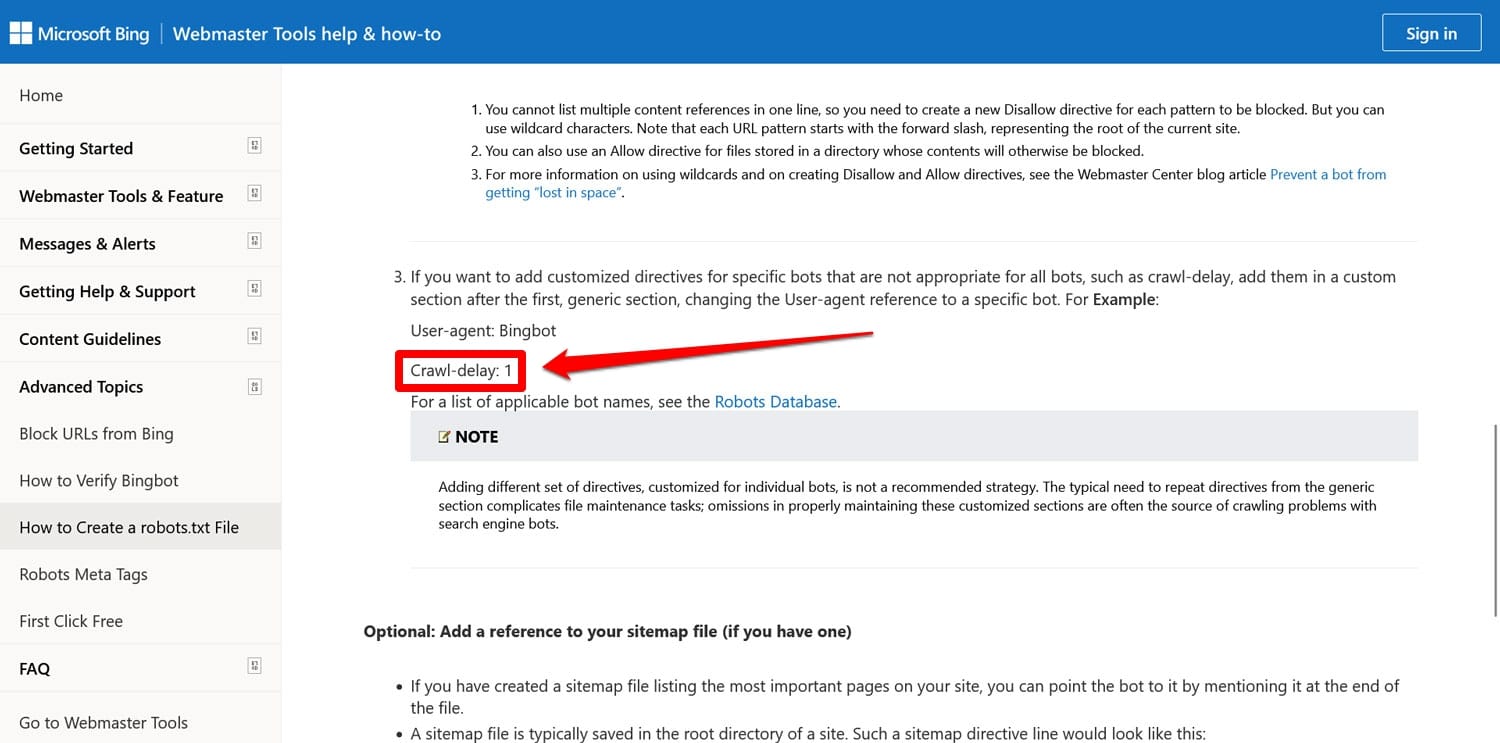

- تأخير الزحف - توجيه يهدف إلى تقييد برامج الزحف حتى لا تؤدي إلى زيادة التحميل على موارد خادم الويب.

يتم الآن تجاهل كلا التوجيهين، على الأقل من قبل جوجل. لا يزال Bing، على الأقل، يحترم تأخير الزحف.

في أغلب الأحيان، من الأفضل عدم استخدام هذه التوجيهات. يساعد هذا في الحفاظ على ملفك بسيطًا ويقلل من مخاطر الأخطاء.

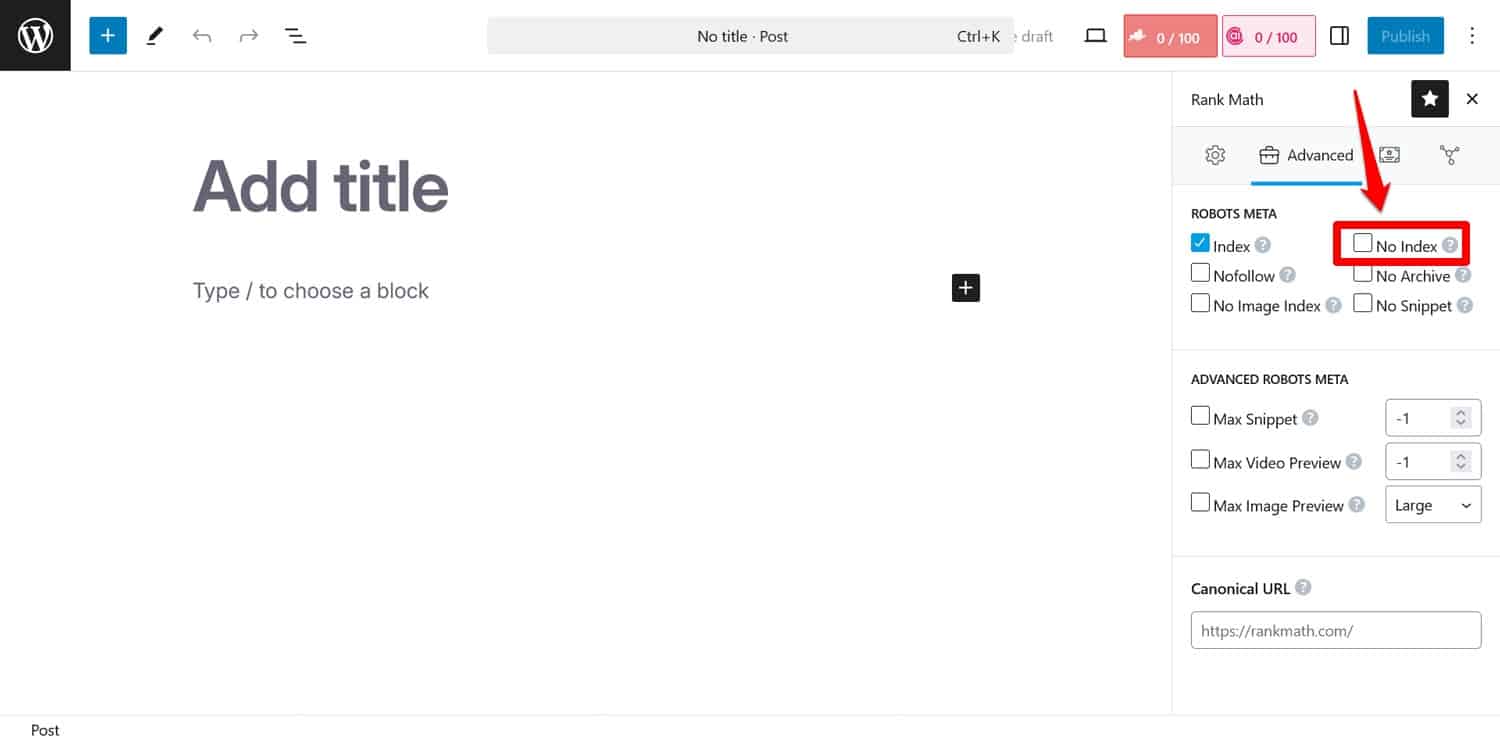

نصيحة: إذا كان هدفك هو منع محركات البحث من فهرسة صفحات معينة، فاستخدم العلامة الوصفية noindex بدلاً من ذلك. يمكنك تنفيذه باستخدام مكون إضافي لتحسين محركات البحث (SEO) على أساس كل صفحة.

إذا قمت بحظر الصفحات عبر ملف robots.txt، فلن تتمكن برامج الزحف من الوصول إلى الجزء الذي ترى فيه علامة noindex . وبهذه الطريقة، قد يستمرون في فهرسة صفحتك ولكن بدون محتواها، وهو ما هو أسوأ.

4. حجب الموارد الأساسية

أحد الأخطاء التي يرتكبها الأشخاص هو استخدام ملف robots.txt لمنع الوصول إلى جميع أوراق الأنماط (ملفات CSS) والبرامج النصية (ملفات JavaScript) على موقع WordPress الخاص بهم للحفاظ على ميزانية الزحف.

ومع ذلك، هذه ليست فكرة جيدة. تعرض روبوتات محرك البحث الصفحات "لرؤيتها" بنفس الطريقة التي يفعلها الزائرون. وهذا يساعدهم على فهم المحتوى حتى يتمكنوا من فهرسته وفقًا لذلك.

من خلال حظر هذه الموارد، قد تعطي محركات البحث انطباعًا خاطئًا عن صفحاتك، مما قد يؤدي إلى عدم فهرستها بشكل صحيح أو الإضرار بترتيبها.

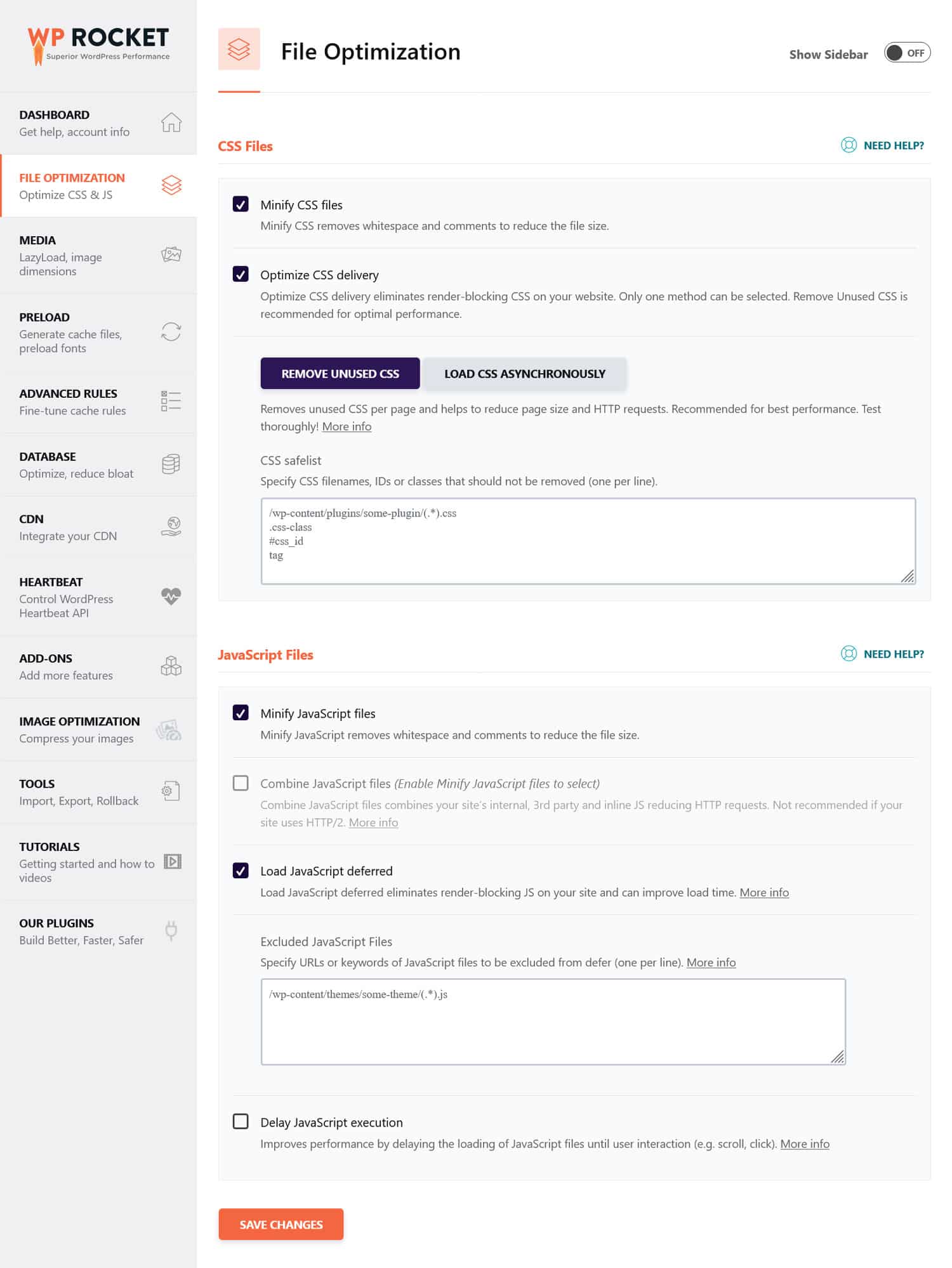

إذا كنت تعتقد أن ملفات CSS وJavaScript قد تعيق أداء موقعك، فمن الأفضل تحسينها ليتم تحميلها بسرعة، سواء بالنسبة إلى برامج الروبوت أو الزوار العاديين. يمكنك القيام بذلك عن طريق تصغير التعليمات البرمجية وضغط ملفات موقع الويب حتى يتم نقلها بشكل أسرع. بالإضافة إلى ذلك، من الممكن تحسين تسليمها عن طريق إزالة التعليمات البرمجية غير المستخدمة وتأجيل موارد حظر العرض.

نصيحة : يمكنك تبسيط هذه العملية باستخدام مكون إضافي للأداء مثل WP Rocket. تسمح لك واجهته سهلة الاستخدام بتحسين تسليم الملفات عن طريق تحديد بعض المربعات في قائمة تحسين الملف .

يأتي WP Rocket أيضًا مزودًا بميزات إضافية لتحسين أداء موقع الويب، بما في ذلك:

- التخزين المؤقت، مع ذاكرة تخزين مؤقت مخصصة للهاتف المحمول

- التحميل البطيء للصور ومقاطع الفيديو

- التحميل المسبق لذاكرة التخزين المؤقت والروابط والملفات الخارجية والخطوط

- تحسين قاعدة البيانات

بالإضافة إلى ذلك، يقوم البرنامج المساعد بتنفيذ العديد من خطوات التحسين تلقائيًا. تتضمن الأمثلة التخزين المؤقت للمتصفح والخادم، وضغط GZIP، وتحسين الصور في الجزء المرئي من الصفحة لتحسين LCP. بهذه الطريقة، سيصبح موقعك أسرع بمجرد تشغيل WP Rocket.

يوفر البرنامج الإضافي أيضًا ضمان استرداد الأموال لمدة 14 يومًا، حتى تتمكن من اختباره بدون مخاطر.

5. الفشل في تحديث ملف robots.txt الخاص بالتطوير

عند إنشاء موقع ويب، يقوم المطورون عادةً بتضمين ملف robots.txt الذي يمنع جميع الروبوتات من الوصول إليه. هذا منطقي. آخر شيء تريده هو أن يظهر موقعك غير المكتمل في نتائج البحث.

تحدث المشكلة فقط عندما تقوم بنقل هذا الملف عن طريق الخطأ إلى خادم الإنتاج الخاص بك وتمنع محركات البحث من فهرسة موقع الويب المباشر الخاص بك أيضًا. تأكد من ذلك إذا رفض المحتوى الخاص بك الظهور في نتائج البحث.

6. عدم تضمين رابط لخريطة الموقع الخاصة بك

يوفر الارتباط بخريطة الموقع الخاصة بك من ملف robots.txt لبرامج زحف محركات البحث قائمة بجميع المحتوى الخاص بك. وهذا يزيد من فرص قيامهم بفهرسة أكثر من مجرد الصفحة الحالية التي وصلوا إليها.

كل ما يتطلبه الأمر هو سطر واحد:

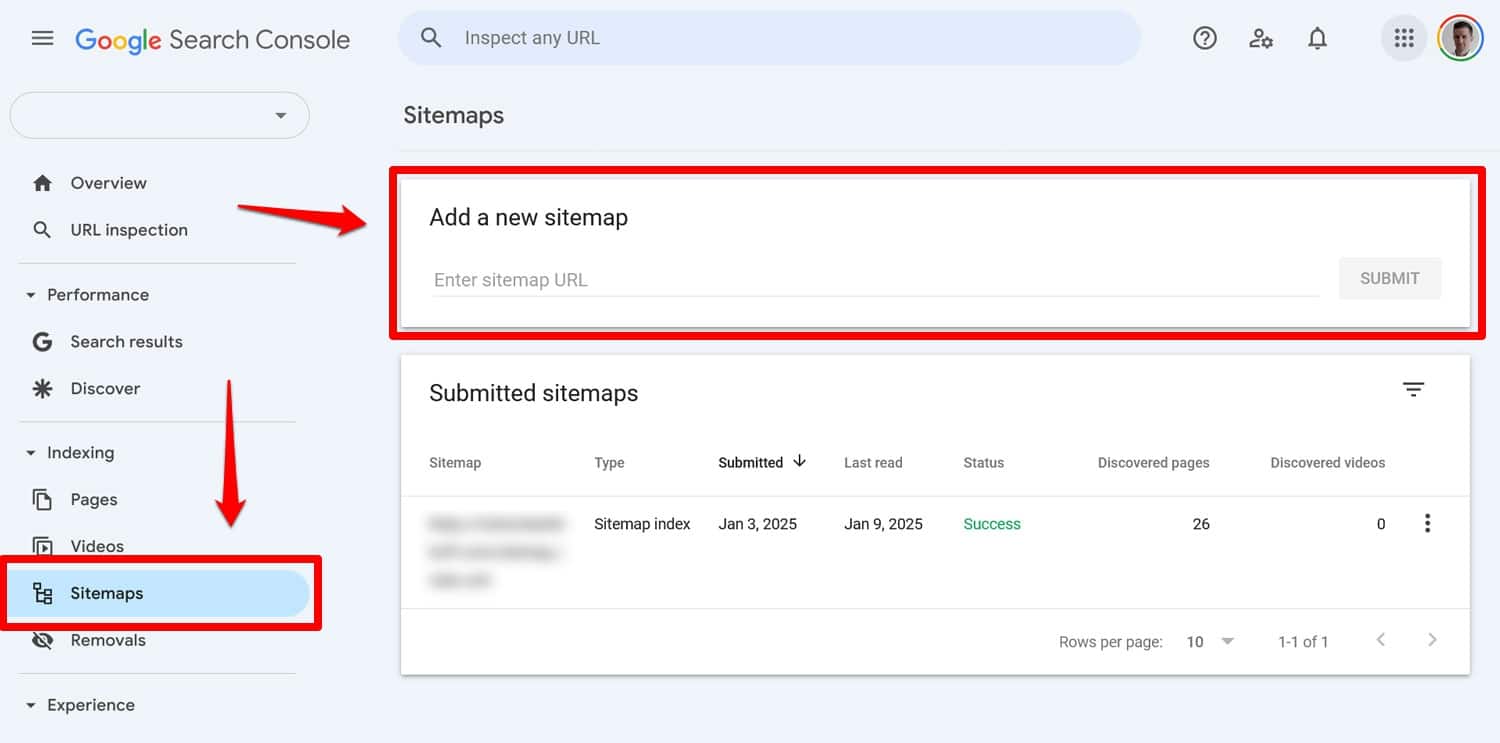

Sitemap: https://yourwebsite.com/sitemap.xmlنعم، يمكنك أيضًا إرسال خريطة الموقع الخاصة بك مباشرةً في أدوات مثل Google Search Console.

ومع ذلك، فإن تضمينه في ملف robots.txt الخاص بك لا يزال مفيدًا، خاصة لمحركات البحث التي لا تستخدم أدوات مشرفي المواقع الخاصة بها.

7. استخدام القواعد المتعارضة

أحد الأخطاء الشائعة في إنشاء ملف robots.txt هو إضافة قواعد تتعارض مع بعضها البعض، مثل:

User-agent: * Disallow: /blog/ Allow: /blog/التوجيهات المذكورة أعلاه تترك محركات البحث غير واضحة بشأن ما إذا كان يجب عليها الزحف إلى الدليل /blog/ أم لا. يؤدي هذا إلى نتائج غير متوقعة ويمكن أن يؤدي إلى الإضرار بتحسين محركات البحث (SEO) الخاص بك.

| هل تشعر بالفضول حول ما الذي يمكن أن يضر بتصنيفات البحث في موقعك وكيفية تجنبه؟ تعرف على ذلك في دليلنا لأخطاء تحسين محركات البحث (SEO). |

لتجنب التعارضات، اتبع أفضل الممارسات التالية:

- استخدم قواعد محددة أولاً - ضع قواعد أكثر تحديدًا قبل القواعد الأوسع.

- تجنب التكرار - لا تقم بتضمين توجيهات متعارضة لنفس المسار.

- اختبر ملف robots.txt – استخدم الأدوات للتأكد من أن القواعد تعمل كما هو متوقع. المزيد عن ذلك أدناه.

8. محاولة إخفاء المحتوى الحساس باستخدام ملف robots.txt

كما ذكرنا سابقًا، فإن ملف robots.txt ليس أداة لإبعاد المحتوى عن نتائج البحث. في الواقع، نظرًا لأن الملف متاح للعامة، فإن استخدامه لحظر المحتوى الحساس قد يكشف عن غير قصد مكان وجود هذا المحتوى بالضبط.

نصيحة : استخدم العلامة الوصفية noindex لإبقاء المحتوى خارج نتائج البحث. بالإضافة إلى ذلك، قم بحماية المناطق الحساسة في موقعك بكلمة مرور لإبقائها آمنة من كل من الروبوتات والمستخدمين غير المصرح لهم.

9. استخدام أحرف البدل بشكل غير صحيح

تسمح لك أحرف البدل بتضمين مجموعات كبيرة من المسارات أو الملفات في توجيهاتك. لقد التقينا بالفعل بواحد في وقت سابق، الرمز *. ويعني "كل مثيل" ويستخدم بشكل متكرر لإعداد القواعد التي تنطبق على جميع وكلاء المستخدم.

رمز بدل آخر هو $، والذي يطبق القواعد على الجزء الأخير من عنوان URL. يمكنك استخدامه، على سبيل المثال، إذا كنت تريد منع برامج الزحف من الوصول إلى جميع ملفات PDF الموجودة على موقعك:

Disallow: /*.pdf$على الرغم من أن أحرف البدل مفيدة، إلا أنها يمكن أن يكون لها عواقب واسعة النطاق. استخدمها بعناية، واختبر دائمًا ملف robots.txt الخاص بك للتأكد من عدم ارتكاب أي أخطاء..

10. الخلط بين عناوين URL المطلقة والنسبية

إليك الفرق بين عناوين URL المطلقة والنسبية:

- عنوان URL المطلق – https://yourwebsite.com/private/

- عنوان URL النسبي – /خاص/

يوصى باستخدام عناوين URL النسبية في توجيهات ملف robots.txt، على سبيل المثال:

Disallow: /private/يمكن أن تتسبب عناوين URL المطلقة في حدوث مشكلات حيث قد تتجاهل برامج الروبوت التوجيه أو تسيء تفسيره. الاستثناء الوحيد هو المسار إلى خريطة الموقع، والذي يجب أن يكون عنوان URL مطلقًا.

11. تجاهل حساسية الحالة

تعتبر توجيهات Robots.txt حساسة لحالة الأحرف. وهذا يعني أن التوجيهين التاليين غير قابلين للتبديل:

Disallow: /Private/ Disallow: /private/إذا وجدت أن ملف robots.txt الخاص بك لا يعمل كما هو متوقع، فتحقق مما إذا كانت الكتابة بالأحرف الكبيرة بشكل غير صحيح هي المشكلة.

12. استخدام الشرطة المائلة الزائدة بشكل غير صحيح

الشرطة المائلة اللاحقة هي شرطة مائلة في نهاية عنوان URL:

- بدون شرطة مائلة زائدة : /directory

- مع شرطة مائلة زائدة : /directory/

في ملف robots.txt، يتم تحديد موارد الموقع المسموح بها وغير المسموح بها. هنا مثال:

Disallow: /private/تمنع القاعدة المذكورة أعلاه برامج الزحف من الوصول إلى الدليل "الخاص" على موقعك وكل شيء فيه. من ناحية أخرى، لنفترض أنك تركت الشرطة المائلة اللاحقة، كما يلي:

Disallow: /privateفي هذه الحالة، ستحظر القاعدة أيضًا الحالات الأخرى التي تبدأ بـ "خاص" على موقعك، مثل:

- https://yourwebsite.com/private.html

- https://yourwebsite.com/privateer

ولذلك، من المهم أن تكون دقيقا. عندما تكون في شك، اختبر ملفك.

13. ملف robots.txt مفقود للنطاقات الفرعية

يحتاج كل نطاق فرعي على موقع الويب الخاص بك (على سبيل المثال، dev.yourwebsite.com) إلى ملف robots.txt الخاص به لأن محركات البحث تتعامل معه ككيانات ويب منفصلة. بدون وجود ملف، فإنك تخاطر بفهرسة برامج الزحف لأجزاء من موقعك كنت تنوي إبقائها مخفية.

على سبيل المثال، إذا كان إصدار التطوير الخاص بك موجودًا في مجلد يسمى "dev" ويستخدم نطاقًا فرعيًا، فتأكد من أنه يحتوي على ملف robots.txt مخصص لحظر برامج زحف البحث.

14. عدم اختبار ملف robots.txt الخاص بك

أحد أكبر الأخطاء عند تكوين ملف WordPress robots.txt هو الفشل في اختباره، خاصة بعد إجراء التغييرات.

كما رأينا، حتى الأخطاء الصغيرة في بناء الجملة أو المنطق يمكن أن تسبب مشكلات كبيرة في تحسين محركات البحث. لذلك، اختبر دائمًا ملف robots.txt الخاص بك.

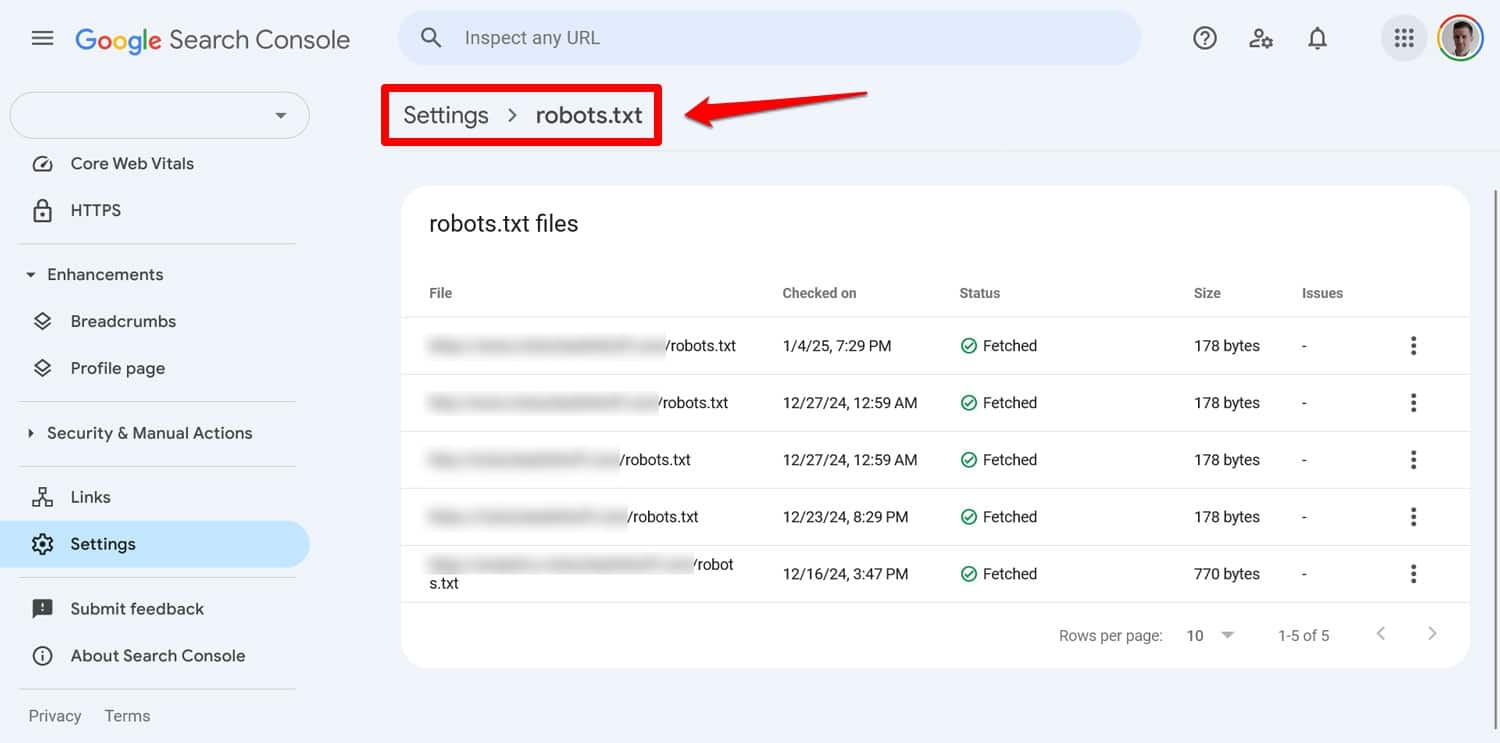

يمكنك رؤية أي مشكلات تتعلق بملفك في Google Search Console ضمن الإعدادات > ملف robots.txt .

هناك طريقة أخرى وهي محاكاة سلوك الزحف باستخدام أداة مثل Screaming Frog. بالإضافة إلى ذلك، استخدم بيئة مرحلية للتحقق من تأثير القواعد الجديدة قبل تطبيقها على موقعك المباشر.

كيفية التعافي من خطأ ملف robots.txt

من السهل ارتكاب الأخطاء في ملف robots.txt، ولكن لحسن الحظ، عادةً ما يكون من السهل إصلاحها بمجرد اكتشافها.

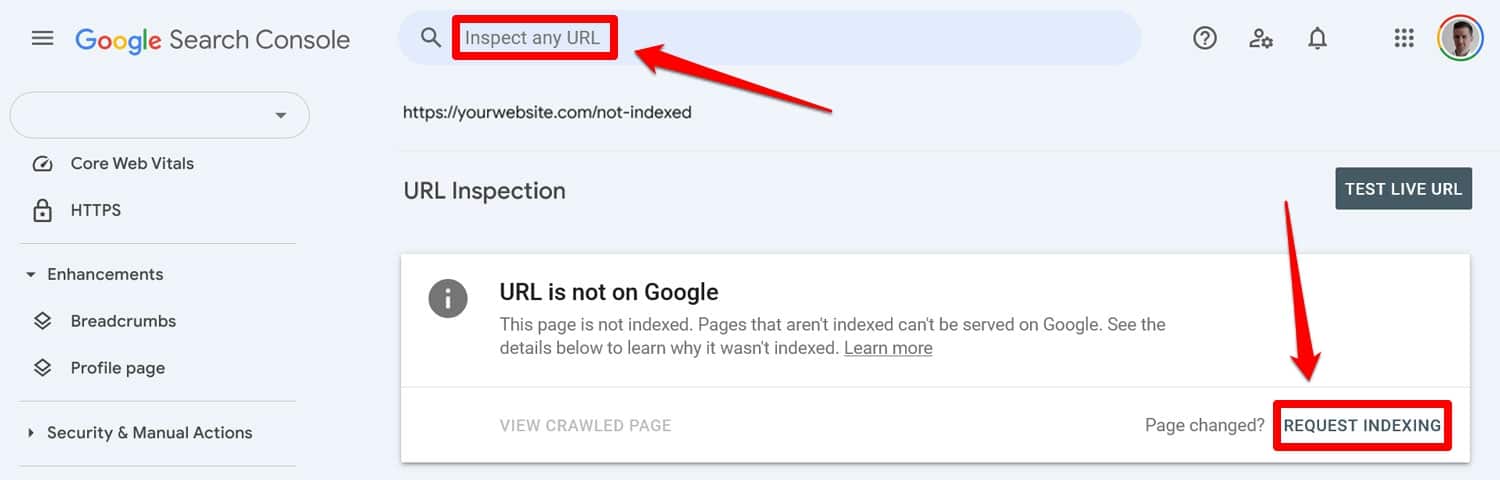

ابدأ بتشغيل ملف robots.txt المحدث من خلال أداة اختبار. وبعد ذلك، إذا تم حظر الصفحات مسبقًا بواسطة توجيهات robots.txt، فأدخلها يدويًا في Google Search Console أو Bing Webmaster Tools لطلب الفهرسة.

بالإضافة إلى ذلك، قم بإعادة إرسال نسخة محدثة من خريطة الموقع الخاصة بك.

وبعد ذلك، إنها مجرد لعبة انتظار. ستقوم محركات البحث بإعادة زيارة موقعك، ونأمل أن تستعيد مكانك في التصنيف العالمي بسرعة.

تحكم في ملف robots.txt الخاص بـ WordPress

مع ملفات robots.txt، درهم وقاية خير من قنطار علاج. خاصة على مواقع الويب الكبيرة، يمكن للملف الخاطئ أن يلحق الضرر بالتصنيفات وحركة المرور والإيرادات.

ولهذا السبب، يجب إجراء أية تغييرات على ملف robots.txt الخاص بموقعك بعناية وبعد إجراء اختبارات مكثفة. إن الوعي بالأخطاء التي يمكن أن ترتكبها هو الخطوة الأولى في منعها.

عندما ترتكب خطأ، حاول ألا تشعر بالذعر. قم بتشخيص الأخطاء، وتصحيح أية أخطاء، ثم إعادة إرسال خريطة الموقع لإعادة الزحف إلى موقعك.

وأخيرًا، تأكد من أن الأداء ليس هو السبب وراء عدم قيام محركات البحث بالزحف إلى موقعك بشكل صحيح. جرب WP Rocket الآن لتجعل موقعك أسرع على الفور!