Was ist der Unterschied zwischen ASCII und Unicode?

Veröffentlicht: 2022-04-10ASCII und Unicode sind die bekanntesten Zeichencodierungsstandards, die derzeit weltweit verwendet werden. Beide Programme sind in der modernen Kommunikation außerordentlich wichtig. Bei Verwendung eines elektronischen Kommunikationsgeräts durchlaufen die Daten die zentrale Verarbeitungseinheit, die die Systemleistung durch Verwendung von Haupt- und Cache-Speicher verbessert. Peripheriegeräte verwenden Schnittstellen, um zwischen dem System und einem angeschlossenen Gerät zu kommunizieren. Bei beiden Kodierungsstandards können Zeichen binär dargestellt werden. Zeichen werden typischerweise in einem Zeichensatz gruppiert. Ein Zeichensatz umfasst:

- alphanumerische Daten (Buchstaben und Zahlen)

- Symbole (*, &, : usw.)

- Steuerzeichen (Backspace, horizontaler Tabulator, Escape usw.)

Ein Zeichensatz ist eine Auswahl von Zeichen, während eine Zeichenkodierung ein Diagramm ist, in dem ein Zeichensatz und ein Wert digital dargestellt werden (z. B.: A=1, B=2). Der ASCII-Standard ist im Wesentlichen beides: Er definiert die Zeichensätze, die er darstellt, und eine Methode, um jedem Zeichen einen numerischen Wert zuzuweisen. Das Wort Unicode hingegen wird in verschiedenen Kontexten verwendet, um verschiedene Dinge zu bedeuten. Betrachten Sie es als einen allumfassenden Begriff, der sich auf einen Zeichensatz und Zahlencodierungen bezieht. Da es jedoch zahlreiche Codierungen gibt, wird der Begriff Unicode normalerweise verwendet, um sich auf den gesamten Zeichensatz zu beziehen, und nicht darauf, wie sie dargestellt werden.

Merkmale von ASCII und Unicode

ASCII

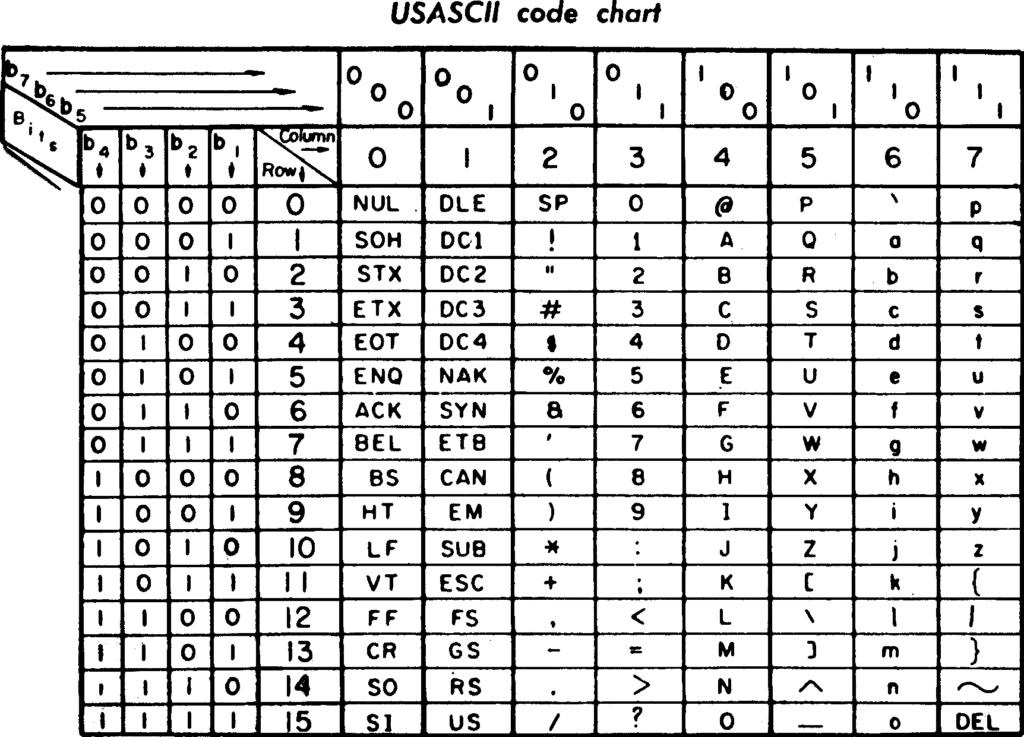

ASCII (American Standard Code for Information Interchange) wurde erstmals 1963 eingeführt. Es hat 128 codierte Zeichen, die hauptsächlich in der englischen Sprache sind, die in modernen Programmiercomputern verwendet werden. Da es seit seiner Einführung nicht aktualisiert wurde, belegt ASCII weniger Platz. Es verwendet 7 Datenbits, um beliebige Zeichen zu codieren, wurde hauptsächlich zur Zeichencodierung im World Wide Web verwendet und wird immer noch häufig für moderne Computerprogramme wie HTML verwendet.

Es codiert Text, indem es ihn in Zahlen umwandelt, da Zahlen einfacher im Computerspeicher gespeichert werden können als das Alphabet. Es gibt auch eine alternative Version, die als Extended ASCII bekannt ist. Mit dieser Technik ist es möglich, das höchstwertige Bit eines 8-Bit-Bytes zu verwenden, damit ASCII 256 Zeichen darstellen kann. Programmierer verwenden den Design-Zeichensatz, um bestimmte Aufgaben zu vereinfachen. Wenn Sie beispielsweise ASCII-Zeichencodes verwenden, wird Text durch Ändern eines einzelnen Bits leicht von Großbuchstaben in Kleinbuchstaben konvertiert. Es verwendet auch einige nicht druckbare Steuerzeichen, die ursprünglich für die Verwendung mit Fernschreib-Druckterminals vorgesehen waren.

Unicode

Der Unicode (Universal Character Set) verarbeitet, speichert und erleichtert den Austausch von Textdaten in jeder Sprache und gilt als der für die Codierung verwendete IT-Standard. Unicode repräsentiert und verarbeitet den Text für Computer, Smartphones und andere technologische Geräte. Es codiert eine Vielzahl von Zeichen, darunter eine breite Palette von Texten in zahlreichen Sprachen, darunter Arabisch, Hebräisch und Griechisch, historische Schriften, mathematische Symbole usw. Unicode unterstützt auch eine beträchtliche Anzahl von Zeichen und nimmt mehr Platz in einem Gerät ein. ASCII-Programmierung ist also ein Teil von Unicode. Unicode verwendet 16 Bits, um die am häufigsten verwendeten Zeichen in einer Vielzahl von Sprachen darzustellen. Entwickler tauschen Daten normalerweise mit einem flachen Codesatz ohne komplexe Codekonvertierungen aus, um Zeichen zu lesen.

Die Unterstützung für Unicode bietet viele Vorteile, darunter:

- Globale Quelle und binär.

- Unterstützung für Mixed-Script-Computing-Umgebungen.

- Verbesserte plattformübergreifende Dateninteroperabilität durch einen gemeinsamen Codesatz.

Benutzerfreundlichkeit

ASCII

- Allgemein akzeptiert

- Da ASCII einen grundlegenden Zeichensatz für die grundlegende Kommunikation verwendet, können Entwickler Schnittstellen entwerfen, die sowohl Computer als auch Menschen verstehen können. ASCII codiert einen Datenstrang wie ASCII-Zeichen, die expliziert und als Daten für Computer oder geplanter lesbarer Text für Menschen dargestellt werden können. Der ASCII-Zeichensatz kann helfen, bestimmte Aufgaben für Programmierer zu vereinfachen.

- Kompakte Zeichenkodierung

- Standardcodes können in 7 Bit ausgedrückt werden, was bedeutet, dass Daten im Standard-ASCII-Zeichensatz ausgedrückt werden können. Dazu müssen nur so viele Bytes gesendet oder gespeichert werden, wie Zahlen in den Daten vorhanden sind.

- Effizient für die Programmierung

- ASCII-Zeichencodes sind gut an Programmiertechniken zum Ändern von Text und Verwenden von Zahlen für Berechnungen oder Speichern als Rohdaten angepasst.

Unicode

- Vereinfachter Bewerbungsprozess

- Alle Symbole werden von der Anwendung zum Schreiben und Lesen von Zeichendaten innerhalb einer einzelnen Codepage benötigt. Dies vereinfacht die Anwendungsentwicklung enorm.

- Einfache Übernahme von bestehendem Code

- Da an den ersten 127 Stellen herkömmliche ASCII-Zeichen stehen, ordnet das Programm jedem dieser Zeichen seinen ursprünglichen ASCII-Wert zu.

- Webkompatibilität

- Da sich Unicode schnell zur universellen Codepage des Webs entwickelt, verlassen sich alle aktuellen Webstandards darauf.

- Mehrsprachige Anwendungen

- Anwendungen, die Unicode verwenden, können eine Vielzahl von Sprachen sowohl in den Daten als auch in der Benutzeroberfläche unterstützen.

- Interoperabilität

- Java-Clients und Active-X basieren beide auf Unicode, sodass sie mit AppServern und UTF-8-Datenbanken kommunizieren können.

Unternehmen hinter dem Produkt & Support

ASCII

Im April 2008 wurde die MediaWorks, Inc. rechtlich von der ASCII Corporation übernommen und bildete die ASCII Media Works, Inc.

Unicode

Das Unicode-Konsortium ist ein gemeinnütziges Unternehmen, das die Internationalisierung von Software entwickelt, pflegt und fördert, einschließlich des definierenden Verhaltens und der Beziehungen zwischen Unicode-Zeichen.

Alternativen

- AppleScript

Apple hat 1993 eine Skriptsprache namens AppleScript entwickelt. Sie ermöglicht es Benutzern, skriptfähige Macintosh-Anwendungen zu steuern. Es ermöglicht Benutzern auch, skriptfähige Macintosh-Anwendungen und Teile von macOS direkt zu steuern. Sie können komplexe Workflows erstellen, Skripte erstellen, sich wiederholende Aufgaben automatisieren, Funktionen aus mehreren skriptfähigen Anwendungen kombinieren und schriftliche Anweisungen erstellen. AppleScript bietet eine begrenzte Anzahl von Befehlen. Es bietet jedoch auch ein Framework, in das Sie zahlreiche aufgabenspezifische Befehle einfügen können (bereitgestellt von skriptfähigen Teilen von macOS und skriptfähigen Anwendungen. AppleScript 2.0 ist jetzt vollständig Unicode-basiert und enthält alle Unicode-Zeichen und wird unabhängig von der Spracheinstellung korrekt beibehalten.

Fazit

Was ist also besser? Alles in allem sind sowohl ASCII als auch Unicode äußerst nützlich, aber letztendlich liegt die Wahl bei Ihnen, basierend auf Ihren Vorlieben und Anforderungen. ASCII eignet sich hervorragend, wenn Sie mit einer kleinen Anzahl von Zeichen arbeiten, die von der Technik bereitgestellt werden, da es weniger Platz benötigt als Unicode. Unicode ist aufgrund seiner großen Vielfalt an Merkmalen und Funktionen sehr gefragt und benutzerfreundlicher. Beides sind hervorragende Codierungstechniken für unterschiedliche Anwendungen.