Wie wir Hyve entwickelt haben, einen KI-Chatbot für WordPress – erste Version jetzt kostenlos

Veröffentlicht: 2024-07-09In den letzten Monaten haben wir mit KI experimentiert, um innovative Tools für WordPress zu entwickeln. Eines unserer jüngsten Projekte, QuickWP, ein KI-gestützter WordPress-Site-Builder, war ein solches Projekt. Aufbauend auf den Dingen, die wir bei der Entwicklung von QuickWP gelernt haben, freuen wir uns, etwas völlig Neues, aber Verwandtes vorstellen zu können!

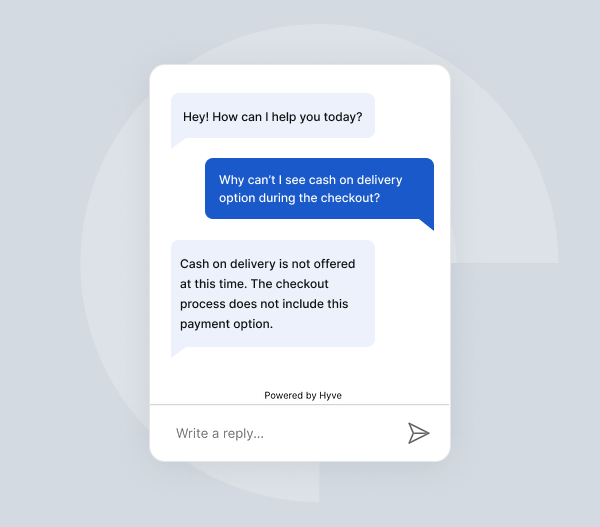

In diesem Beitrag möchte ich Ihnen alles über Hyve erzählen, einen KI-Chatbot für WordPress. Hyve nutzt Ihre WordPress-Inhalte, um intelligent auf Benutzeranfragen zu reagieren und präzise und kontextbezogene Antworten direkt aus den vorhandenen Materialien Ihrer Website bereitzustellen. Okay, das ist ein Bissen, also lass es uns aufschlüsseln:

Kurz gesagt: Hyve arbeitet mit Ihren vorhandenen Inhalten, verwendet sie als Wissensdatenbank und beantwortet Benutzerfragen basierend auf den bereitgestellten Daten.

Wir haben die erste Version von Hyve Ende April veröffentlicht und seitdem viel Feedback von unseren Benutzern erhalten, um das Plugin zu verbessern, mögliche Probleme zu beheben und es in Version 1.1 für unsere Benutzer benutzerfreundlicher zu machen. Heute freuen wir uns, Ihnen mitteilen zu können, dass wir Hyve 1.0.3 für alle unsere Benutzer kostenlos zur Verfügung stellen. Hyve ist Open Source und unter GPLv3 lizenziert.

👉 Wenn Sie Hyve ausprobieren möchten, können Sie das Plugin herunterladen, indem Sie hier auf den Link klicken.

„Aber wo ist der Haken?“ könnte man fragen. In diesem Artikel beantworte ich alle Ihre Fragen, teile den Weg zur Entstehung von Hyve, erkläre, warum wir diese Version öffentlich zugänglich machen und vieles mehr.

Aber fangen wir zunächst von vorne an:

Was ist Hyve?

Vereinfacht ausgedrückt ist Hyve ein KI-Chatbot für WordPress, der OpenAI-APIs in Kombination mit den Daten Ihrer Website verwendet, um die Fragen Ihrer Benutzer zu beantworten. Sie können Hyve hinsichtlich des Inhalts Ihrer Website schulen und Hyve wird diese Informationen verwenden, um genaue und relevante Antworten bereitzustellen. Mit Hyve können Sie Ihre Beiträge, Seiten und sogar benutzerdefinierten Daten als Ihre Wissensquelle nutzen, die wir als Wissensdatenbank bezeichnen.

Alle Daten bleiben in Ihrem WordPress- und OpenAI-Konto. Sie müssen sich nicht mit zusätzlichen Diensten verbinden, um Hyve nutzen zu können. Für das Versionsupdate 1.1 haben wir dieses Video erstellt, um unseren Benutzern einen Rundgang durch Hyve zu geben:

Neben der Wissensdatenbank haben Sie auch weitere Möglichkeiten, Ihren Chatbot anzupassen und zu erfahren, welche Fragen Ihre Benutzer stellen, die aber unbeantwortet bleiben. Mit dieser Funktion können Sie sicherstellen, dass Sie Ihrer Wissensdatenbank die richtigen Fragen hinzufügen.

Ein gescheitertes Hackathon-Projekt

Lassen Sie mich Ihnen die Geschichte erzählen, wie Hyve geboren wurde.

Es ist nicht die Geschichte, nach der Sie gefragt haben, sondern dennoch die Geschichte, die Sie brauchten.

Im März 2023, nur wenige Monate nach der Veröffentlichung von ChatGPT und der Übernahme von Twitter durch KI-Projekte (ja, im März 2023 hieß es noch Twitter); Wir beschlossen, einen zweitägigen Remote-Hackathon im Unternehmen zum Thema KI zu veranstalten.

Ein Entwickler wählte ein Projekt zur Erstellung eines KI-Chatbots für WordPress unter Verwendung von OpenAI-APIs und Daten aus Unternehmensdokumenten. Zu seiner großen Enttäuschung hatte er Schwierigkeiten mit der Aufgabe, und letztendlich scheiterte das Projekt.

An dieser Stelle möchte ich darauf hinweisen, dass ich der Entwickler war.

Falls Sie interessiert sind: Am Ende habe ich einen Last-Minute-Automaten zur Erstellung von Spam-Kommentaren mit OpenAI eingereicht, der kaum 50 Codezeilen umfasste.

Obwohl die Idee nach diesem Hackathon verstummte, diskutierte das Team sie Anfang des Jahres, und dieses Mal haben wir mehr Recherche und Vorbereitung betrieben, bevor wir die erste Codezeile geschrieben haben. Und so wurde Hyve geboren.

Warum scheiterte es also beim ersten Mal und beim zweiten nicht?

Schnelles Engineering, RAG und Feinabstimmung

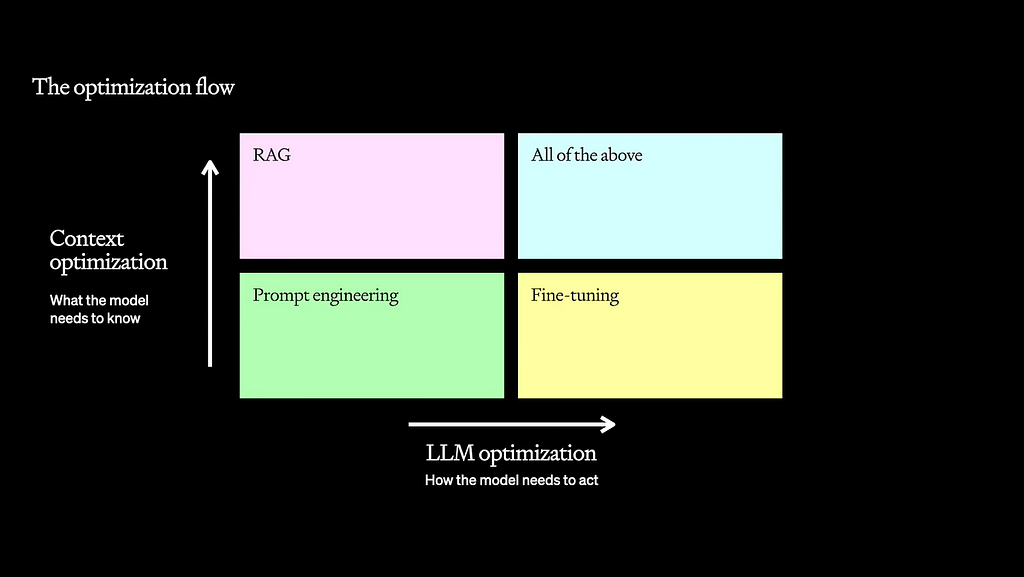

Prompt Engineering, Retrieval-Augmented Generation (RAG) und Fine-Tuning sind Techniken, die bei der Entwicklung von KI-Tools verwendet werden. Bei richtiger Anwendung steigert jede dieser Methoden die Genauigkeit, Relevanz und Gesamtleistung erheblich.

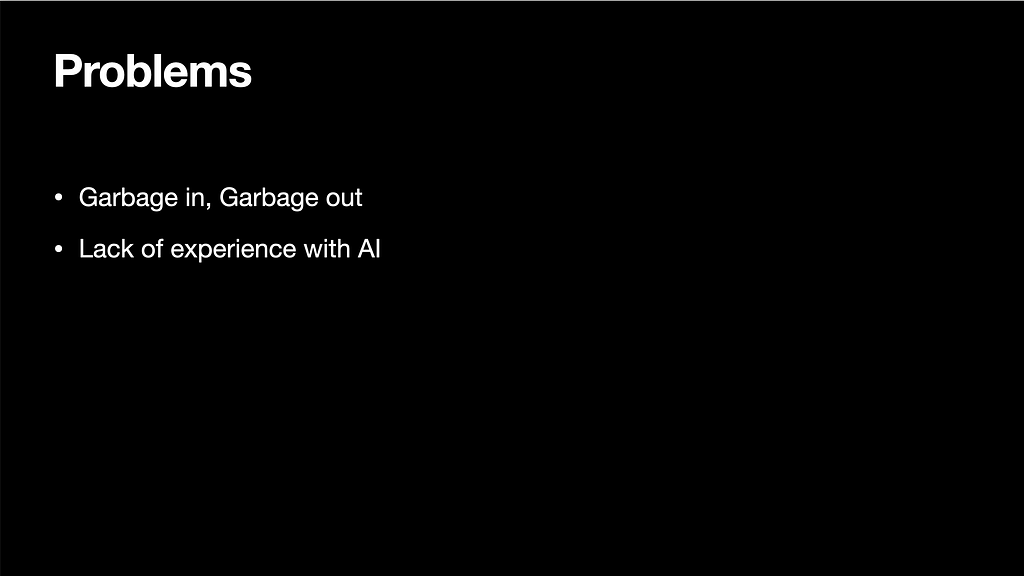

Es ist aber auch wichtig, genau zu wissen, wann man sie nicht verwenden sollte. Beim ersten Hackathon-Projekt machten wir (oder genauer gesagt ich) den Fehler zu glauben, dass Feinabstimmung die Lösung sei.

Als Neuling verstand ich, dass Feinabstimmung der Weg ist, ein KI-Modell für die Ausführung der Aufgabe zu „trainieren“, indem man ihm Hunderte von Beispielen für die Beantwortung jeder Frage zeigt. Aber ich habe mich so geirrt.

Theoretisch hat der Chatbot genau das getan, wofür er trainiert wurde. Es nahm eine Frage des Benutzers entgegen und antwortete mit einigen größtenteils falschen Informationen im Schreibstil und Ton unserer Unternehmensdokumente. Um zu erklären, warum, lassen Sie uns kurz in die Bedeutung all dieser Techniken eintauchen:

Prompte Technik

Die vielleicht berühmteste Technik, die jeder kennt, der mit ChatGPT und anderen KI-Tools arbeitet. Wir geben unserem KI-Modell einige Handlungsanweisungen und legen fest, wie es reagieren soll. Wir könnten ihm beispielsweise eine Liste mit Daten aus 20 E-Mails geben und ihn bitten, diese jeweils in einer Zeile zusammenzufassen. Es nimmt die Daten entgegen und antwortet etwa so:

- Am Dienstag hat Jeff Ihnen eine E-Mail bezüglich der Drucklieferung geschickt.

- Am Freitag haben Sie Geburtstagswünsche von Jeff und Matt erhalten.

- …und so weiter

Dieser Ansatz eignet sich hervorragend für einfache Aufgaben, bei denen wir genau wissen, welche Informationen wir unserer KI geben müssen, wenn wir Fragen stellen, aber er schlägt fehl, wenn Aufgaben viel komplexer sind.

Retrieval-Augmented Generation (RAG)

Wie bereits erwähnt, ist Prompt Engineering bei einfachen Aufgaben effektiv, kann jedoch bei komplexeren Abfragen Probleme bereiten. Hier kommt Retrieval-Augmented Generation (RAG) ins Spiel. RAG verbessert die KI-Fähigkeiten durch die Kombination von abrufbasierten Methoden mit generativen Modellen. Anstatt sich ausschließlich auf die gegebene Eingabeaufforderung zu verlassen, durchsucht RAG eine große Dokumentendatenbank nach relevanten Informationen, die es dann verwendet, um eine genauere und kontextbezogenere Antwort zu generieren.

Der Benutzer könnte beispielsweise fragen: „Bieten Sie Fahrradtouren in Nizza an?“ Mit RAG ruft die KI zunächst für diese Frage relevante Artikel ab und basiert ihre Antwort dann auf den in diesen Artikeln bereitgestellten Informationen.

Oder stellen Sie sich vor, Sie fragen KI nach Wetteraktualisierungen oder Aktienkursen. All dies erfordert, dass Zugriffsinformationen von einer anderen Quelle abgerufen werden.

Dieser Ansatz ist besonders nützlich, wenn es um große Datenmengen geht oder wenn die erforderlichen Informationen nicht direkt bei der ersten Eingabeaufforderung bereitgestellt werden.

In Hyve können wir nicht bei jeder einzelnen Abfrage alle Daten aus der Wissensdatenbank bereitstellen. Dies wäre zu unpraktisch, daher müssen wir die RAG-Technik verwenden, um zunächst zu sammeln, welche Informationen für die Anfrage des Benutzers relevant sind, und diese dann zusammen mit der Frage des Benutzers an die KI weiterzuleiten.

Feinabstimmung

Bei der Feinabstimmung wird ein vorab trainiertes KI-Modell anhand eines bestimmten Datensatzes weiter trainiert, um es für bestimmte Aufgaben oder Bereiche besser geeignet zu machen. Bei der Feinabstimmung geht es weniger darum, der KI genau zu sagen, was sie sagen soll, sondern vielmehr darum, ihr zu helfen, zu verstehen, wie sie antworten soll.

Betrachten Sie beispielsweise den früheren Fall aus dem Abschnitt „Prompt Engineering“, in dem die KI E-Mails zusammenfasst:

- Am Dienstag hat Jeff Ihnen eine E-Mail bezüglich der Drucklieferung geschickt.

- Am Freitag haben Sie Geburtstagswünsche von Jeff und Matt erhalten.

Wenn die KI in diesem Szenario nicht fein abgestimmt wäre, könnte sie Antworten erzeugen, die in Ton oder Format variieren, wodurch die Zusammenfassungen inkonsistent oder für bestimmte Anwendungsfälle weniger nützlich würden. Durch Feinabstimmung können die Reaktionen der KI standardisiert werden, um sicherzustellen, dass sie einem einheitlichen Stil und Ton folgen. Nach der Feinabstimmung könnte die KI einheitlichere Zusammenfassungen wie diese liefern:

- Am Dienstag hat Jeff Sie über den Status der Drucklieferung informiert.

- Am Freitag haben Ihnen sowohl Jeff als auch Matt Geburtstagsgrüße geschickt.

Auch im Hackathon-Projekt hat die Feinabstimmung ihren Zweck erfüllt. Obwohl immer mit einer falschen Antwort geantwortet wurde, antwortete die Antwort immer im gleichen Format und Ton, den wir in unseren Unternehmensdokumenten verwenden. Die Feinabstimmung hat gut funktioniert; Der Fehler lag eher in der Technik, die wir für die Aufgabe gewählt hatten.

Wenn die Feinabstimmung richtig eingesetzt wird, kann sie ein sehr leistungsfähiges Werkzeug zum Erstellen von KI-Modellen für sehr spezifische Aufgaben sein. Tatsächlich kann es an Modellen mit niedrigerem Rang trainiert werden und liefert dennoch viel bessere Ergebnisse als ein Modell mit höherem Rang.

Die richtige Technik wählen

Alle genannten Techniken sind bei richtiger Anwendung äußerst nützlich. Bei falscher Anwendung können sie jedoch auch dazu führen, dass Ihre KI-Tools ihre Aufgabe nicht mehr erfüllen.

Feinabstimmung war für unser Hackathon-Projekt nicht der richtige Ansatz. Hätten wir uns auf das Prompt Engineering mit RAG beschränkt, wären die Ergebnisse viel besser ausgefallen.

Als Faustregel gilt: Beginnen Sie immer nur mit einer zeitnahen Entwicklung. Wenn es genau das tut, was Sie möchten, müssen Sie weder RAG noch Feinabstimmung verwenden.

Wenn es nicht das gewünschte Ergebnis liefert, prüfen Sie, ob weitere Kontextinformationen erforderlich sind oder ob das Format/der Ton konsistent ist. Auf dieser Grundlage kann entschieden werden, ob RAG, Feinabstimmung oder beides erforderlich ist.

Wenn Sie mehr über die Auswahl der richtigen Technik erfahren möchten, empfehle ich Ihnen dringend, sich diesen Vortrag auf dem YouTube-Konto von OpenAI anzusehen.

So funktioniert Hyve

Nachdem wir nun einige Techniken zum Erstellen von KI-Tools besprochen haben, wollen wir untersuchen, wie wir diese bei der Entwicklung eines KI-Chatbots für WordPress verwendet haben.

OpenAI bietet mehrere Möglichkeiten zum Aufbau von Konversations-KIs. Für dieses Projekt haben wir die Assistant-API der Chat Completions-API vorgezogen. Beide APIs haben ihre Vor- und Nachteile, aber wir haben die Assistant-API vorgezogen, da sie es Benutzern ermöglicht, den Chatverlauf einfach anzuzeigen und den Kontext beizubehalten, indem jede Konversation als Thread behandelt wird. Dies war besonders nützlich beim Erstellen von QuickWP, daher haben wir beschlossen, dabei zu bleiben. Andere bevorzugen möglicherweise die Chat Completions API, und das ist auch in Ordnung.

Mit der Assistant-API erstellen wir einen Assistenten, wenn der Benutzer sein OpenAI-Konto verbindet, und richten dort die Eingabeaufforderung ein. Auf diese Weise müssen wir die Eingabeaufforderung nicht bei jeder Anfrage senden, da OpenAI dies verwaltet.

Wenn Benutzer ihre Anfrage an den Chatbot senden, wandeln wir die Frage mithilfe der Embeddings-API von OpenAI in Einbettungen um und führen einen Algorithmus aus, um sie mit der Wissensdatenbank der Website zu vergleichen, um die ähnlichsten Übereinstimmungen zu finden. Anschließend senden wir die beste Übereinstimmung zusammen mit der Frage des Benutzers an den Assistenten und stellen so sicher, dass die KI bei der Beantwortung der Anfrage nur den bereitgestellten Kontext berücksichtigt.

Wir haben über eine Feinabstimmung nachgedacht, um die Antwortqualität zu verbessern, haben uns jedoch vorerst dagegen entschieden, um die Dinge für den Benutzer einfacher zu halten. Möglicherweise optimieren wir ein Modell jedoch in Zukunft, um sicherzustellen, dass es der Aufforderung genau wie beabsichtigt folgt. Im Moment funktioniert Prompt Engineering gut genug, ohne die Komplexität zu erhöhen.

Und jetzt ist Hyve v1.0 kostenlos

Wir haben Hyve im April veröffentlicht und seitdem haben viele Kunden wertvolles Feedback zur Verbesserung der Funktionalität gegeben. Darauf aufbauend haben wir letzten Monat Hyve v1.1 auf den Markt gebracht, das erweiterte Funktionen wie detaillierte Einblicke für Site-Administratoren in unbeantwortete Fragen, größere Anpassungsoptionen für den Assistenten und zahlreiche andere Verbesserungen enthält.

Jetzt freuen wir uns, Ihnen mitteilen zu können, dass Hyve v1.0.3 für alle Benutzer, die es ausprobieren möchten, kostenlos ist. Bei dieser Version handelt es sich um eine einmalige Veröffentlichung, das heißt, sie erhält keine Updates oder Kundensupport. Hyve v1.0.3 enthält alle Funktionen der Originalversion sowie Korrekturen für alle bekannten Fehler.

Durch das Angebot dieser kostenlosen Version hoffen wir, dass mehr Menschen Hyve ausprobieren und uns zusätzliches Feedback und Einblicke in verschiedene Anwendungsfälle geben. Dies wird uns helfen, uns weiter zu verbessern und der Gemeinschaft etwas zurückzugeben.

Wer weiß, vielleicht gefällt Ihnen auch Hyve und Sie entscheiden sich, Updates zu abonnieren. Geben Sie in diesem Fall einfach den Lizenzschlüssel ein und schon erhalten Sie Updates.

Wir nutzten diese Gelegenheit auch, um unsere Reise zum Aufbau eines KI-Chatbots für WordPress mit der Community zu teilen. Die Macher unter Ihnen finden vielleicht etwas Nützliches, oder es könnte Ihnen dabei helfen, zu erklären, wie KI-Chatbots unter der Haube funktionieren.

Wir hoffen, dass Sie Hyve ausprobieren und es genauso gerne nutzen, wie wir es beim Erstellen haben. Wenn Sie Probleme beim Herunterladen/Installieren von Hyve haben oder Fragen an uns haben, hinterlassen Sie unten einen Kommentar. Und auch hier können Sie Hyve v1.0.3 herunterladen, indem Sie auf den Link klicken. Und wenn Sie sich die neueste Version ansehen möchten, finden Sie sie auf der Produktseite von Hyve.