Webcrawler-Liste: Die 10 häufigsten, die im Jahr 2024 die Nase vorn haben

Veröffentlicht: 2023-12-09Hatten Sie jemals Schwierigkeiten, Ihre Website durch ständige Aktualisierungen dynamisch und SEO-freundlich zu halten? Bei Hunderten oder Tausenden von Seiten wird es zu einer Herausforderung, Aktualisierungen manuell an Suchmaschinen weiterzuleiten. Die entscheidende Frage lautet: Wie können Sie sicherstellen, dass sich häufige Inhaltsaktualisierungen positiv auf SEO-Rankings auswirken? Die Lösung liegt in Crawler-Bots. Diese Bots durchsuchen Ihre Sitemap, indizieren neue Updates und spielen eine entscheidende Rolle bei der Verbesserung der SEO. In diesem Blog haben wir eine Webcrawler-Liste zusammengestellt, die Ihre Arbeit einfach und reibungslos macht.

Was ist ein Webcrawler und wie funktioniert er?

Ein Webcrawler ist ein automatisiertes Computerprogramm, das für sich wiederholende Aktionen, insbesondere das Navigieren und Indizieren von Dokumenten im Internet, entwickelt wurde. Suchmaschinen wie Google verwenden es häufig, um das Surfen zu automatisieren und einen Index von Webinhalten zu erstellen. Der Begriff „Crawler“ ist gleichbedeutend mit „Bot“ oder „Spider“, und Googlebot ist ein bekanntes Beispiel.

Nun stellt sich die Frage: Wie funktionieren Webcrawler?

Webcrawler laden zunächst die robot.txt-Datei einer Website herunter, die Sitemaps mit URLs enthält, die zum Crawlen in Frage kommen. Während sie durch die Seiten navigieren, identifizieren Crawler neue URLs über Hyperlinks und fügen sie einer Crawling-Warteschlange hinzu, damit sie sie später möglicherweise erkunden können.

Verschiedene Arten von Webcrawlern: Auf den Punkt gebracht

Um eine Zusammenstellung von Webcrawler-Kategorien zu erstellen, müssen die drei Hauptklassifizierungen erkannt werden: interne Webcrawler , kommerzielle Webcrawler und Open-Source-Webcrawler . Machen wir uns mit diesen Webcrawlern vertraut, bevor wir in die ultimative Webcrawler-Liste eintauchen.

Interner Webcrawler: Diese Webcrawler-Tools werden intern von Organisationen erstellt, um durch ihre spezifischen Websites zu navigieren. Sie dienen verschiedenen Zwecken wie der Erstellung von Sitemaps und der Suche nach defekten Links .

Kommerzieller Webcrawler: Kommerzielle Webcrawler-Tools sind auf dem Markt erhältlich und werden in der Regel von Unternehmen entwickelt, die auf solche Software spezialisiert sind. Darüber hinaus setzen einige namhafte Unternehmen möglicherweise speziell entwickelte Spider ein, die auf ihre individuellen Anforderungen an das Crawlen von Websites zugeschnitten sind.

Open-Source-Webcrawler: Open-Source-Crawler hingegen stehen der Öffentlichkeit unter freien/offenen Lizenzen zur Verfügung, sodass Benutzer sie nach ihren Wünschen nutzen und anpassen können.

Auch wenn ihnen bestimmte erweiterte Funktionen ihrer kommerziellen Gegenstücke fehlen, bieten sie Benutzern die Möglichkeit, in den Quellcode einzutauchen und Einblicke in die Mechanismen des Web-Crawlings zu gewinnen.

Eine zusammengestellte Web-Crawler-Liste: Die häufigsten im Jahr 2024

Kein einzelner Crawler ist darauf ausgelegt, die gesamte Arbeitslast für jede Suchmaschine zu bewältigen. Stattdessen gibt es eine Vielzahl von Webcrawlern, um den Inhalt Ihrer Webseiten zu bewerten, sie zum Nutzen von Benutzern auf der ganzen Welt zu scannen und den unterschiedlichen Anforderungen verschiedener Suchmaschinen gerecht zu werden. Lassen Sie uns nun tiefer in die Webcrawler-Listen eintauchen, die heute verwendet werden.

Googlebot

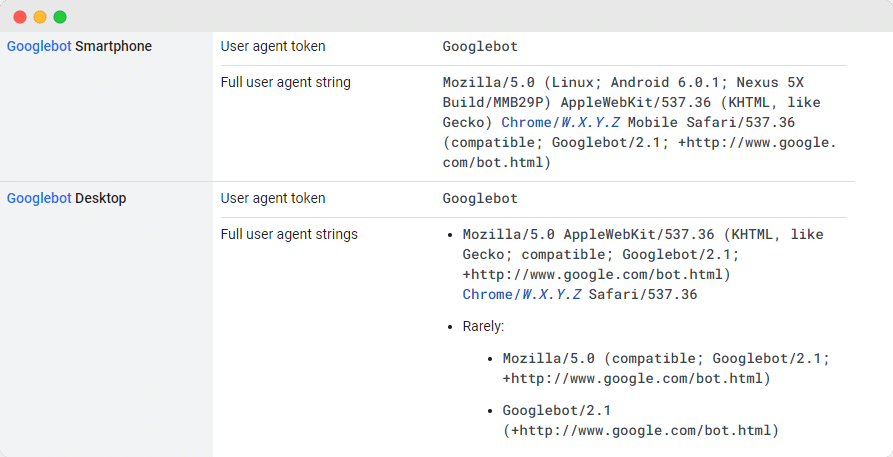

Googlebot , das generische Webcrawler-Tool von Google, spielt eine wichtige Rolle beim Scannen von Websites für die Aufnahme in die Google-Suchmaschine. Obwohl es technisch gesehen zwei Versionen gibt – Googlebot Desktop und Googlebot Smartphone (Mobile), betrachten viele Experten sie als einen einzigen Crawler.

Diese Einheit wird durch ein gemeinsames, einzigartiges Produkt-Token (als User-Agent-Token bezeichnet) aufrechterhalten, das in der robots.txt-Datei jeder Website angegeben ist, wobei der User-Agent einfach „Googlebot“ ist.

Der Googlebot greift routinemäßig auf Ihre Website zu, normalerweise alle paar Sekunden, es sei denn, er wird in der robots.txt-Datei der Website absichtlich blockiert. Die gescannten Seiten werden in einer zentralen Datenbank namens Google Cache gespeichert, sodass Sie frühere Versionen Ihrer Website überprüfen können.

Yandex-Bot

Yandex Spider ist eines der besten Webcrawler-Tools, das exklusiv für die russische Suchplattform Yandex entwickelt wurde, die zu den wichtigsten und am weitesten verbreiteten Suchmaschinen in Russland zählt. Website-Administratoren haben die Möglichkeit, Zugriff auf Yandex Spider zu gewähren, indem sie die Seiten ihrer Website in der robots.txt-Datei konfigurieren.

Darüber hinaus können sie die Zugänglichkeit verbessern, indem sie auf ausgewählten Seiten ein Yandex.Metrica- Tag integrieren, die Seitenindizierung über Yandex Webmaster-Tools aktualisieren oder das IndexNow-Protokoll nutzen – einen exklusiven Bericht, der neue, geänderte oder deaktivierte Seiten identifiziert.

DuckDuck Bot

Der DuckDuckBot fungiert als Suchmaschinen-Crawler für DuckDuckGo und gewährleistet die Privatsphäre Ihres Internetbrowsers. Websitebesitzer können auf die DuckDuckBot-API zugreifen, um zu überprüfen, ob ihre Website gecrawlt wurde.

Während dieses Vorgangs aktualisiert der DuckDuckBot seine API-Datenbank mit neuen IP-Adressen und Benutzeragenten und hilft Webmastern dabei, potenzielle Betrüger oder schädliche Bots zu erkennen, die versuchen, eine Verbindung mit dem DuckDuckBot herzustellen.

Bingbot

Im Jahr 2010 entwickelte Microsoft Bingbot zur Analyse und Katalogisierung von URLs, um sicherzustellen, dass Bing relevante und aktuelle Suchergebnisse liefert. Ähnlich wie beim Googlebot können Websitebesitzer in ihrer robots.txt angeben, ob sie dem „ Bingbot “ das Scannen ihrer Website erlauben oder nicht erlauben.

Darüber hinaus können Entwickler zwischen Mobile-First-Indexierungs-Crawlern und Desktop-Crawlern unterscheiden, da Bingbot kürzlich einen neuen Agententyp eingeführt hat. In Kombination mit den Bing Webmaster Tools bietet dies Webmastern mehr Flexibilität bei der Darstellung, wie ihre Website gefunden und in den Suchergebnissen angezeigt wird.

Apple Bot

Apple hat die Entwicklung des Apple Bot initiiert, um Webseiten für die Integration mit Apples Siri und Spotlight Suggestions zu scannen und zu katalogisieren. Der Apple Bot bewertet verschiedene Kriterien, um die Inhalte zu bestimmen, die in Siri und Spotlight Suggestions priorisiert werden sollen.

Zu diesen Kriterien gehören die Benutzerinteraktion, die Bedeutung von Suchbegriffen, die Quantität und Qualität der Links, standortbezogene Signale und das Gesamtdesign von Webseiten.

Sogou-Spinne

Sogou , eine chinesische Suchmaschine, gilt als erste Suchplattform, die 10 Milliarden chinesische Seiten indexiert. Für diejenigen, die auf dem chinesischen Markt tätig sind, ist die Kenntnis dieses weit verbreiteten Suchmaschinen-Crawlers, des Sogou Spider, von entscheidender Bedeutung. Es hält sich an den Robot-Ausschlusstext und die Crawling-Verzögerungseinstellungen.

Ähnlich wie beim Baidu-Spider empfehlen wir Ihnen, diesen Spider zu deaktivieren, wenn Ihr Unternehmen nicht auf den chinesischen Markt abzielt, um ein langsames Laden der Website zu vermeiden.

Baidu-Spinne

Die wichtigste Suchmaschine in China ist Baidu und ihr exklusiver Crawler ist der Baidu Spider . Da es in China kein Google gibt, ist es von entscheidender Bedeutung, dem Baidu Spider das Crawlen Ihrer Website zu erlauben, wenn Sie den chinesischen Markt ansprechen möchten. Um die Aktivität des Baidu Spider auf Ihrer Website zu erkennen, suchen Sie nach Benutzeragenten wie Baiduspider, Baiduspider-Image, Baiduspider-Video und anderen.

Für diejenigen, die nicht an chinesischen Geschäftsaktivitäten beteiligt sind, könnte es sinnvoll sein, den Baidu Spider mithilfe Ihres robots.txt-Skripts zu blockieren. Auf diese Weise können Sie verhindern, dass der Baidu Spider Ihre Website scannt, wodurch jegliche Möglichkeit ausgeschlossen wird, dass Ihre Seiten auf den Suchmaschinen-Ergebnisseiten (SERPs) von Baidu erscheinen.

Slurp Bot

Der Suchroboter von Yahoo, Slurp Bot , spielt eine entscheidende Rolle beim Crawlen und Indexieren von Seiten nicht nur für Yahoo.com, sondern auch für seine angeschlossenen Plattformen wie Yahoo News, Yahoo Finance und Yahoo Sports.

Das Fehlen dieses Crawlings würde dazu führen, dass relevante Website-Einträge fehlen. Das personalisierte Web-Erlebnis für Benutzer mit relevanteren Ergebnissen wird durch den Beitrag indizierter Inhalte ermöglicht.

Externer Facebook-Hit

Der Facebook Crawler , auch Facebook External Hit genannt, untersucht den HTML-Code einer auf Facebook geteilten Website oder App. Es ist dafür verantwortlich, eine Vorschau der freigegebenen Links auf der Plattform zu erstellen und den Titel, die Beschreibung und das Miniaturbild anzuzeigen.

Das Crawlen muss zeitnah erfolgen, da jede Verzögerung dazu führen kann, dass das benutzerdefinierte Snippet nicht angezeigt wird, wenn der Inhalt auf Facebook geteilt wird.

Swiftbot

Eine personalisierte Suchmaschine, Swiftype, verbessert die Suchfunktionalität Ihrer Website durch die Integration erstklassiger Technologie, Algorithmen, Content-Ingestion-Framework, Clients und Analysetools. Swiftype ist besonders nützlich für Websites mit zahlreichen Seiten und bietet eine benutzerfreundliche Oberfläche zur effizienten Katalogisierung und Indizierung aller Seiten.

Eine entscheidende Rolle in diesem Prozess spielt Swiftbot, der Webcrawler von Swiftype . Swiftbot zeichnet sich insbesondere dadurch aus, dass es Websites ausschließlich auf Basis von Kundenanfragen crawlt, was ihn von anderen Bots unterscheidet.

Top-Webcrawler-Liste, um SEO im Jahr 2024 zu meistern

Die in diesem Blog vorgestellte kuratierte Webcrawler-Liste dient als wertvolle Ressource zur Optimierung des Prozesses, Ihre Website dynamisch und SEO-freundlich zu halten. Wenn Sie sich dem Jahr 2024 nähern, müssen Sie diese besten Webcrawler-Tools in Ihre Strategie integrieren, um sicherzustellen, dass Ihre Website weiterhin an der Spitze der Suchmaschinenrankings bleibt, sodass sich die Teams auf die Erstellung hochwertiger Inhalte konzentrieren können, während die Crawler sich um die Feinheiten der Optimierung kümmern.

Wenn Sie diesen Artikel hilfreich fanden, dann teilen Sie ihn doch mit anderen. Vergessen Sie auch nicht, unseren Blog zu abonnieren und weitere Erkenntnisse wie diese zu erhalten, um im Suchranking hervorzustechen.