So optimieren Sie Ihre WordPress Robots.txt für SEO

Veröffentlicht: 2022-08-23In diesem Blog erfahren wir einige Tipps, wie Sie die SEO Ihrer Website verbessern können, indem Sie die Datei robts.txt optimieren.

Tatsächlich spielt die Robots.txt-Datei eine wichtige Rolle in Bezug auf SEO, da sie Suchmaschinen mitteilt, wie Ihre Website gecrawlt werden kann. Aus diesem Grund gelten Robot.txt-Dateien als eines der leistungsstärksten SEO-Tools.

Später erfahren Sie auch, wie Sie WordPress Robots.txt für SEO erstellen und optimieren können .

Was meinst du mit robots.txt-Datei?

Die Textdatei, die von Websitebesitzern erstellt wird, um Suchmaschinen-Bots mitzuteilen, wie sie auf ihrer Website crawlen und Seiten indizieren können, ist als Robots.txt bekannt

Tatsächlich wird diese Datei im Stammverzeichnis gespeichert. Dieses Verzeichnis wird auch als Hauptordner Ihrer Website bezeichnet. Unten erwähnt ist das Dateiformat für die robots.txt-Datei

Benutzeragent: [Name des Benutzeragenten] Disallow: [URL-String soll nicht gecrawlt werden] Benutzeragent: [Name des Benutzeragenten] Zulassen: [zu crawlende URL-Zeichenfolge] Sitemap: [URL Ihrer XML-Sitemap]

Um bestimmte URLs zuzulassen oder zu verbieten, können Sie verschiedene Anweisungen haben. Außerdem können Sie auch verschiedene Sitemaps hinzufügen. Die Suchmaschinen-Bots werden davon ausgehen, dass sie die Seiten crawlen dürfen, wenn dies eine URL zulässt.

Ein Beispiel für robots.txt ist unten angegeben

User-Agent: * Zulassen: /wp-content/uploads/ Nicht zulassen: /wp-content/plugins/ Nicht zulassen: /wp-admin/ Sitemap: https://example.com/sitemap_index.xml

Im oben genannten Beispiel haben wir zugelassen, dass die Seiten von Suchmaschinen gecrawlt werden und erhalten Indexdateien in den Ordner der WordPress-Uploads.

Danach haben wir den Such-Bots nicht erlaubt, WordPress-Verwaltungsordner und -Plugins zu crawlen und zu indizieren.

Zuletzt haben wir die URL der XML-Sitemap erwähnt.

Benötigen Sie für Ihre WordPress-Website eine Robots.txt-Datei?

Die Suchmaschine beginnt mit dem Crawlen und Indizieren Ihrer Seiten, auch wenn Sie die Textdatei, dh Robots.txt, nicht haben. Aber leider können Sie Ihrer Suchmaschine nicht mitteilen, welche bestimmten Ordner oder Seiten sie durchsuchen soll.

Es wird keinen Gewinn bringen oder keine Wirkung hinterlassen, wenn Sie gerade eine Website oder einen Blog mit weniger Inhalt erstellt haben.

Sobald Sie jedoch Ihre Website mit vielen Inhalten eingerichtet haben und sie zu wachsen begann, benötigen Sie die Kontrolle über die gecrawlten und indizierten Seiten Ihrer Website.

Der erste Grund wird unten angegeben

Für jede Website haben die Suchbots eine Crawling-Quote.

Dies bedeutet eindeutig, dass während der Crawling-Sitzung die bestimmte Anzahl von Seiten gecrawlt wird. Angenommen, das Crawling auf Ihrer Website bleibt unvollständig, dann kommt es noch einmal zurück und setzt das Crawling in einer anderen Sitzung fort.

Aus diesem Grund wird die Indexierungsrate Ihrer Website zum Showdown.

Sie können dieses Problem beheben, indem Sie den Such-Bots nicht erlauben, solche Seiten nicht zu durchsuchen, die nicht erforderlich sind. Einige unwichtige Seiten können Plugin-Dateien, WordPress-Admin-Seiten und Themenordner enthalten.

Das Crawling-Kontingent kann eingespart werden, indem nicht zugelassen wird, dass unerwünschte Seiten gecrawlt werden. Dieser Schritt ist hilfreicher, da die Suchmaschinen nun die Seiten der Website crawlen und sie so schnell wie möglich indizieren können.

Ein weiterer Grund, warum Sie die WordPress Robots.txt-Datei verwenden und optimieren sollten, ist unten angegeben

Wann immer Sie Suchmaschinen daran hindern müssen, Seiten oder Beiträge auf Ihrer Website zu indizieren, können Sie diese Datei verwenden.

Tatsächlich ist dies eine der unangemessensten Methoden, um den Inhalt Ihrer Website vor der Öffentlichkeit zu schützen, aber es wird sich als die beste Unterstützung erweisen, um zu verhindern, dass sie in den Suchergebnissen erscheinen.

Wie wird die Robots.txt-Datei angezeigt?

Eine sehr einfache robots.txt-Datei wird von den meisten populären Blogs verwendet. Der Inhalt kann je nach Anforderung der jeweiligen Website abweichen.

User-Agent: * Nicht zulassen: Sitemap: http://www.example.com/post-sitemap.xml Sitemap: http://www.example.com/page-sitemap.xml Allen Bots wird durch die robots.txt-Datei gestattet, jeden Inhalt zu indizieren und Links zur Website der XML-Sitemap anzubieten. Die folgenden Regeln werden erwähnt, die in robots.txt-Dateien befolgt werden müssen User-Agent: * Zulassen: /wp-content/uploads/ Nicht zulassen: /wp-content/plugins/ Nicht zulassen: /wp-admin/ Nicht zulassen: /readme.html Nicht zulassen: /referieren/ Sitemap: http://www.example.com/post-sitemap.xml Sitemap: http://www.example.com/page-sitemap.xml

Dies weist den Bot an, alle WordPress-Dateien und -Bilder zu indizieren. Dies wird den Such-Bots nicht erlauben, den WordPress-Adminbereich, WordPress-Plug-in-Dateien, Affiliate-Links und die WordPress-Readme-Datei zu indizieren.

Zu robots.txt-Dateien können Sie Sitemaps hinzufügen, die Google-Bots helfen, alle Seiten Ihrer Website zu erkennen.

Jetzt wissen Sie, wie die robots.txt-Datei aussieht, jetzt erfahren wir, wie die robots.txt-Datei in WordPress erstellt werden kann.

Wie erstellt man in WordPress eine robots.txt-Datei?

Um eine robots.txt-Datei in WordPress zu erstellen, gibt es so viele Möglichkeiten. Einige der besten Methoden sind unten aufgeführt. Sie können eine davon auswählen, die für Sie am besten geeignet ist.

Methode 1: Verwenden von All-in-One-SEO, Ändern der Robots.txt-Datei

All in One SEO ist das bekannteste WordPress-Plugin für SEO auf dem Markt, das von mehr als 1 Million Websites verwendet wird.

Das All-in-One-SEO-Plugin ist sehr einfach zu bedienen und bietet daher den robotx.txt-Dateigenerator. Es ist auch hilfreich, WordPress Robots.txt zu optimieren

Wenn Sie dieses SEO-Plugin noch nicht integriert haben, installieren und aktivieren Sie es zuerst über das WordPress-Dashboard. Die kostenlose Version ist auch für Anfänger verfügbar, damit sie ihre Funktionen nutzen können, ohne Geld zu investieren.

Nachdem Sie das Plugin aktiviert haben, können Sie damit beginnen, die robots.txt-Datei direkt aus Ihrem WordPress-Adminbereich zu erstellen oder zu ändern.

Um es zu benutzen

- Gehen Sie zum All-in-One-SEO

- Um nun die robots.txt-Datei zu bearbeiten, klicken Sie auf die Tools

- Wenn Sie nun auf „Benutzerdefinierte robots.txt aktivieren“ klicken, aktivieren Sie die Bearbeitungsoption

- In WordPress können Sie mit diesem Schalter auch eine benutzerdefinierte robots.txt-Datei erstellen.

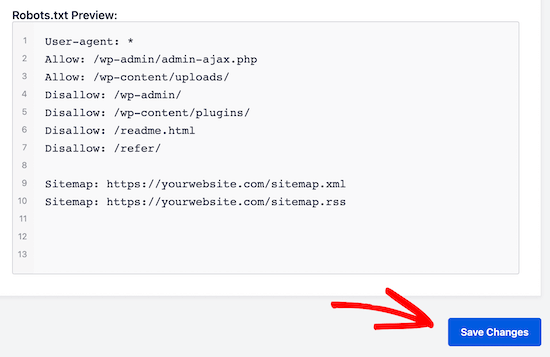

- Jetzt wird Ihre vorhandene robots.txt-Datei vom „All-in-One-SEO-Plugin“ im Abschnitt „robots.txt-Vorschau“ angezeigt. Dies ist am unteren Rand Ihres Web-Bildschirms sichtbar.

Von WordPress wird die hinzugefügte Standardregel von dieser Version angezeigt

Die Standardregeln, die angezeigt werden, scheinen Ihrer Suchmaschine vorzuschlagen, dass sie die WordPress-Kerndateien nicht crawlen müssen, bieten einen Link zur Website der XML-Sitemap und erlauben Bots, den gesamten Inhalt zu indizieren.

Um Ihre robots.txt für SEO zu verbessern, können neue eigene benutzerdefinierte Regeln hinzugefügt werden.

Fügen Sie im Feld „Benutzeragent“ einen Benutzeragenten hinzu, um eine Regel hinzuzufügen. Die Regel wird auf alle Benutzeragenten angewendet, indem ein *.

Wählen Sie nun aus, ob Sie der Suchmaschine das Crawlen der Seiten erlauben möchten oder nicht.

Fügen Sie nun den Verzeichnispfad und den Dateinamen im Feld „Verzeichnispfad“ hinzu.

Auf Ihre robots.txt wird die Regel automatisch angewendet. Klicken Sie auf die Schaltfläche „Regel hinzufügen“, um eine neue Regel hinzuzufügen.

Sofern Sie kein ideales robotx.txt-Format erstellen, empfehlen wir Ihnen, neue Regeln hinzuzufügen.

Die von Ihnen hinzugefügten benutzerdefinierten Regeln sehen so aus

Um Ihre Änderungen zu speichern, vergessen Sie nicht, auf „Änderungen speichern“ zu klicken.

Methode 2: Ändern Sie die Datei Robots.txt manuell mit Hilfe von FTP

Eine andere Methode zur Optimierung von WordPress Robots.txt besteht darin, die Funktionen von FTP-Clients zu nutzen, um mit der Änderung der robots.txt-Datei zu beginnen

Sie müssen sich lediglich mit Hilfe eines FTP-Clients mit Ihrem WordPress-Hosting-Konto verbinden

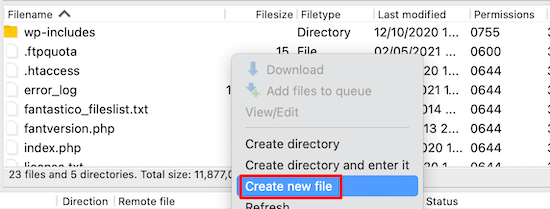

Nach der Anmeldung können Sie im Stammordner der Website die robots.txt-Datei anzeigen.

Wenn Sie es nicht finden können, bedeutet dies, dass Sie keine robots.txt-Datei haben

In einer solchen Situation müssen Sie die robot.txt-Datei erstellen.

Wie bereits erwähnt, ist die robots.txt-Datei normalerweise eine einfache Textdatei, die auf Ihren Computer heruntergeladen werden kann. Sie können es jedoch sogar mit Hilfe eines einfachen Texteditors wie TextEdit, Notepad oder WordPad ändern.

Nachdem Sie alle Änderungen vorgenommen haben, ist es an der Zeit, sie zu speichern. Sie können diese Datei in den Stammordner Ihrer Website hochladen.

Wie können Sie Tests an Ihrer Robots.txt-Datei durchführen?

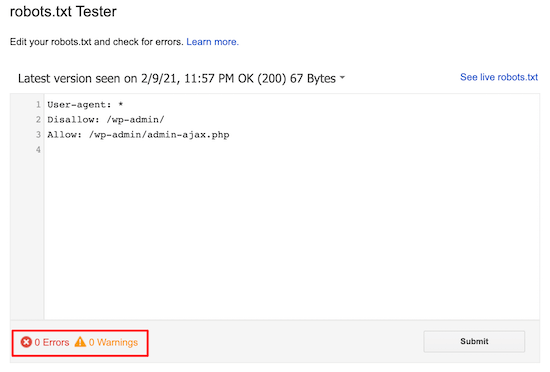

Sie können Tests mit Hilfe des robots.txt-Tester-Tools durchführen.

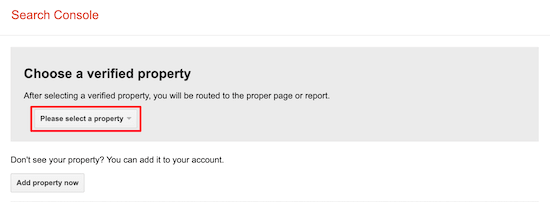

Im Internet finden Sie viele robots.txt-Tester-Tools. Eine der besten ist die Google Search Console.

Um mit diesem Tool arbeiten zu können, benötigen Sie zunächst eine Website, die mit der Google-Suchkonsole verbunden ist. Danach können Sie mit der Nutzung der Funktionen beginnen.

Aus der Dropdown-Liste müssen Sie nur Ihre Immobilie auswählen.

Es wird jedoch automatisch die robots.txt-Datei Ihrer Website auswählen und alle Warnungen und Fehler hervorheben. Dies ist eines der besten Tools, mit denen Sie die WordPress Robots.txt-Datei sehr einfach optimieren können.

Fazit:

Das Hauptmotto bei der Optimierung dieser robots.txt-Datei ist es, Seiten vor dem Crawlen der Seiten zu schützen. Zum Beispiel Seiten im WordPress-Admin-Ordner oder Seiten im wp-plugin-Ordner.

Der häufigste Mythos ist, dass Sie die Crawling-Rate verbessern und schneller indizieren und ein höheres Ranking erzielen können, indem Sie die WordPress-Kategorie blockieren, Seiten und Tags erreichen.

Dies wird jedoch nicht funktionieren, da es gemäß den Webmaster-Richtlinien von Google schief gehen wird.

Wir empfehlen Ihnen dringend, alle oben genannten Punkte zu lesen und zu berücksichtigen.

Wir hoffen, dass dieser Blog Ihnen dabei hilft, eine robots.txt-Datei im richtigen Format für Ihre Website zu erstellen. Und es wird Ihnen helfen, WordPress Robots.txt zu optimieren.