So optimieren Sie Ihre WordPress Robots.txt für SEO mit Yoast SEO

Veröffentlicht: 2023-10-25Suchmaschinenoptimierung (SEO) ist ein entscheidender Bestandteil beim Aufbau einer effektiven Website, und einer der wichtigsten Faktoren für den SEO-Erfolg ist die Verwendung der richtigen Tools zur Optimierung Ihrer Website. Ein solches Tool ist die Datei Robots.txt, die steuert, wie Suchmaschinen-Crawler auf Ihre Inhalte zugreifen und diese indizieren.

Durch die Optimierung Ihrer WordPress Robots.txt-Datei können Sie bessere Platzierungen in Suchmaschinen erzielen, die Sichtbarkeit Ihrer Website verbessern und Ihren Traffic steigern.

Trotz der Bedeutung sind viele Websitebesitzer jedoch nicht mit der richtigen Konfiguration ihrer Robots.txt-Datei vertraut. In diesem Blogbeitrag führen wir Sie durch alles, was Sie wissen müssen, um Ihre WordPress Robots.txt für SEO zu meistern und das volle Potenzial von SEO für Ihre Website auszuschöpfen.

Die Rolle von robots.txt bei SEO verstehen

Das Verständnis der Funktion der robots.txt-Datei bei der Suchmaschinenoptimierung ist wichtig, um Ihre WordPress-Website-Optimierungsbemühungen optimal zu nutzen und die bestmöglichen Ergebnisse zu erzielen. Eine Textdatei namens Robots.txt, die auch als Robots Exclusion Protocol bezeichnet wird, gibt Suchmaschinen-Crawlern Anweisungen, welche Bereiche Ihrer Website sie crawlen und indizieren sollen.

Wenn Bots von Suchmaschinen Ihre Website besuchen, suchen sie zunächst im Stammverzeichnis nach einer Datei namens robots.txt. Diese Datei dient den Bots als Leitfaden und informiert sie darüber, welche Websites und Dateien sie besuchen dürfen und welche nicht.

Wenn Sie Ihre robots.txt-Datei richtig konfigurieren, haben Sie die vollständige Kontrolle über das Material, das Suchmaschinen angezeigt wird, und darüber, was vor ihnen verborgen bleibt.

Durch den Einsatz der robots.txt-Datei soll vor allem die Scan-Effektivität Ihrer Website verbessert werden. Es hilft Suchmaschinen-Bots, sich auf das Crawlen und Indexieren der wichtigsten Teile Ihrer Website zu konzentrieren und so die Verschwendung von Ressourcen für unwichtige Websites oder sensibles Material zu vermeiden, das nicht der breiten Öffentlichkeit zugänglich gemacht werden sollte.

Was genau ist eine Robots.txt-Datei?

Eine einfache Textdatei namens Robots.txt leitet die von Suchmaschinen verwendeten Webcrawler zu bestimmten Webseiten Ihrer Website. Darüber hinaus weist es die Roboter an, bestimmte Websites nicht zu crawlen.

Es ist wichtig, dass Sie die Funktionsweise einer Suchmaschine verstehen, bevor wir mit der eingehenden Analyse dieses Artikels fortfahren.

Crawling, Indexierung und Ranking sind die drei Hauptaktivitäten, die von Suchmaschinen ausgeführt werden.

Das erste, was Suchmaschinen tun, ist, ihre Webcrawler, auch Spider oder Bots genannt, im gesamten World Wide Web auszusenden. Bei diesen als Bots bezeichneten Programmen handelt es sich um intelligente Software, die das gesamte Web auf der Suche nach neuen Verbindungen, Seiten und Websites durchsucht. Unter Crawling versteht man den Vorgang des Durchsuchens von Inhalten im Web.

Die Seiten Ihrer Website werden in einer Datenstruktur organisiert, die verwendet werden kann, nachdem die Bots sie entdeckt haben. Als Indizierung wird dieses Verfahren bezeichnet.

Und am Ende läuft alles auf die Rangliste hinaus. Wenn ein Benutzer eine Suchanfrage eingibt, sollte die Suchmaschine dem Benutzer die besten und relevantesten Informationen anbieten, die sie finden kann, je nachdem, wonach der Benutzer sucht.

Wie sieht die Robots.txt-Datei aus?

Die robots.txt-Datei ist ein wichtiger Bestandteil der Struktur und Funktionalität einer Website, aber haben Sie sich jemals gefragt, wie sie tatsächlich aussieht?

Die Datei gilt für alle Suchmaschinen-Robots, die die Website besuchen, wie durch das Sternchen hinter dem Benutzeragenten angezeigt. Jede Suchmaschine verwendet einen anderen Benutzeragenten, um das Internet zu erkunden.

Beispielsweise nutzt Google den Googlebot, um den Inhalt Ihrer Website für die Google-Suche zu indizieren. Die Zahl dieser Benutzeragenten geht in die Hunderte. Für jeden Benutzeragenten können benutzerdefinierte Anweisungen konfiguriert werden. Die erste Zeile Ihrer robots.txt-Datei sollte beispielsweise lauten: „Wenn Sie spezifische Anweisungen für den Googlebot festlegen möchten, wird dieser als User-Agent: Googlebot bezeichnet.“

Was genau ist das Crawl-Budget?

Unter Crawling-Budget versteht man die Anzahl der Seiten, die eine Suchmaschine innerhalb eines bestimmten Zeitraums auf einer Website crawlen möchte. Sie wird durch verschiedene Faktoren bestimmt, wie etwa die Autorität der Website, ihre Beliebtheit und die Fähigkeit des Servers, Crawling-Anfragen zu verarbeiten. Darüber hinaus sollten Sie darauf achten, dass das Crawl-Budget möglichst effizient für Ihre Website eingesetzt wird.

Wenn Ihre Website mehrere Seiten hat, sollten Ihre wichtigsten Seiten sicherlich zuerst vom Bot gecrawlt werden. Geben Sie dies daher unbedingt in Ihrer robots.txt-Datei ausdrücklich an.

Wie finde und bearbeite ich die robots.txt-Datei in WordPress?

Das Auffinden und Bearbeiten der robots.txt-Datei in WordPress ist ein entscheidender Schritt bei der Optimierung Ihrer Website für Suchmaschinen. Durch die richtige Konfiguration dieser Datei können Sie steuern, welche Teile Ihrer Website für Suchmaschinen-Crawler zugänglich sind, und so sicherstellen, dass sie sich auf die wichtigsten Seiten und Inhalte konzentrieren.

Um die robots.txt-Datei in WordPress zu finden und zu bearbeiten, befolgen Sie diese einfachen Schritte:

1. Melden Sie sich bei Ihrem WordPress-Dashboard an.

2. Navigieren Sie zur Registerkarte „Einstellungen“ im Menü auf der linken Seite.

3. Klicken Sie auf „Lesen“, um auf die Leseeinstellungen zuzugreifen.

4. Scrollen Sie nach unten, bis Sie den Abschnitt „Sichtbarkeit in Suchmaschinen“ finden.

5. Hier sehen Sie eine Option mit der Aufschrift „Suchmaschinen davon abhalten, diese Website zu indizieren“. Stellen Sie sicher, dass diese Option deaktiviert ist, da dadurch eine einfache robots.txt-Datei generiert wird, die den Suchmaschinenzugriff auf Ihre gesamte Website einschränkt.

6. Wenn Sie Ihre robots.txt-Datei weiter anpassen möchten, können Sie dies tun, indem Sie auf das Stammverzeichnis Ihrer Website zugreifen. Dies kann normalerweise über einen FTP-Client oder einen cPanel-Dateimanager erfolgen.

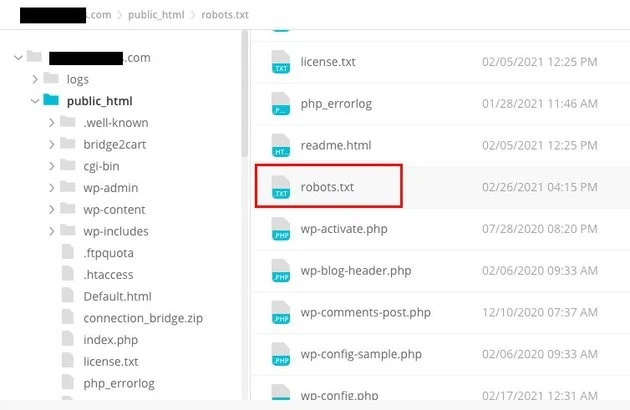

7. Sobald Sie das Stammverzeichnis gefunden haben, suchen Sie nach der Datei mit dem Namen „robots.txt“.

8. Laden Sie eine Kopie der vorhandenen robots.txt-Datei als Backup auf Ihren Computer herunter, falls während der Bearbeitung Probleme auftreten.

9. Öffnen Sie die robots.txt-Datei mit einem Texteditor.

10. Passen Sie die Datei an Ihre Bedürfnisse an. Sie können spezifische Anweisungen hinzufügen, um den Zugriff auf bestimmte Bereiche Ihrer Website zu erlauben oder zu verbieten. Sie können beispielsweise verhindern, dass Suchmaschinen Ihren Admin-Bereich crawlen, indem Sie die folgende Zeile hinzufügen:

1. Nicht zulassen: /wp-admin/

11. Speichern Sie die Änderungen an der robots.txt-Datei und laden Sie sie zurück in das Stammverzeichnis Ihrer Website hoch, um die vorherige Version zu ersetzen.

12. Testen Sie abschließend Ihre robots.txt-Datei mit dem robots.txt-Testtool von Google oder anderen ähnlichen Tools, um sicherzustellen, dass sie richtig konfiguriert ist.

Die Steuerung der Interaktion von Suchmaschinen-Crawlern mit Ihrer Website kann in WordPress durch Identifizieren und Ändern der robots.txt-Datei am richtigen Speicherort erfolgen. Dadurch können Sie die bestmöglichen Ergebnisse hinsichtlich der Sichtbarkeit und des Rankings Ihrer Website erzielen. Wenn Sie sich die Zeit nehmen, sich über diesen Aspekt der Suchmaschinenoptimierung (SEO) zu informieren und ein Experte darin zu werden, sind Sie auf dem besten Weg zum Erfolg Ihrer WordPress-Site.

Wie erstelle ich eine Robots.txt-Datei in WordPress?

Lassen Sie uns fortfahren und eine WordPress-Robots.txt-Datei für SEO erstellen, nachdem wir besprochen haben, was eine robots.txt-Datei ist und warum sie so wichtig ist. WordPress bietet Ihnen zwei unterschiedliche Optionen zum Generieren einer robots.txt-Datei. Die erste Methode beinhaltet die Verwendung eines WordPress-Plugins, während die zweite das manuelle Hochladen der Datei in den Stammordner Ihrer Website beinhaltet.

Schritt 1: Hiermit erstellen Sie mithilfe des Yoast SEO-Plugins eine Robots.txt-Datei

Sie können SEO-Plugins verwenden, um Sie bei der Optimierung Ihrer auf WordPress basierenden Website zu unterstützen. Die meisten dieser Plugins bieten in ihrem Installationspaket einen eigenen robots.txt-Dateigenerator.

Laden Sie zunächst das Plugin herunter und installieren Sie es.

Navigieren Sie zum Plugins-Menü und klicken Sie auf „Neu hinzufügen“. Der nächste Schritt besteht darin, nach dem Yoast SEO-Plugin zu suchen, es herunterzuladen und zu aktivieren, falls Sie es noch nicht haben.

Erstellen Sie im zweiten Schritt die robots.txt-Datei

Erstellen Sie eine Robots-TXT-Datei mit Yoast

Sie werden feststellen, dass die Datei mit einigen Standardanweisungen erstellt wurde.

Der robots.txt-Dateigenerator für Yoast SEO enthält automatisch die folgenden Anweisungen:

Benutzeragent: * Nicht zulassen: /wp-admin/ Erlauben: /wp-admin/admin-ajax.php

Fügen Sie der robots.txt zusätzliche Anweisungen hinzu. Klicken Sie nach der Bearbeitung von robots.txt auf Speichern.

Geben Sie Ihren Domainnamen und „/robots.txt“ ein. Ihre robots.txt-Datei ist vollständig, wenn der Browser die Standardanweisungen anzeigt, wie unten dargestellt.

generierte Robots-txt-Datei

Wir empfehlen Ihnen außerdem, die Sitemap-URL in Ihre robots.txt-Datei einzufügen.

Standard-Robots-txt-Datei

Nachdem das Plugin aktiviert wurde, gehen Sie zu Yoast SEO > Tools und wählen Sie Dateieditor aus dem Dropdown-Menü. Geben Sie Ihren Domänennamen ein und geben Sie anschließend „/robots.txt“ ein. Wenn Sie im Browser nachsehen, werden Ihnen einige Standardanweisungen angezeigt.

Schritt 2: Verwenden Sie FTP, um die Datei „Robots.txt“ manuell zu erstellen

- Der nächste Schritt in diesem Prozess ist das Erstellen einer robots.txt-Datei auf Ihrem lokalen Computer und das anschließende Hochladen dieser in den Stammordner Ihrer WordPress-Website.

- Darüber hinaus benötigen Sie Zugriff auf Ihr WordPress-Hosting über ein FTP-Programm wie Filezilla. Sofern Sie noch nicht über die für die Anmeldung notwendigen Zugangsdaten verfügen, werden Ihnen diese über das Control Panel Ihres Hosting-Dienstes zugänglich gemacht. Daher können Sie nach der Anmeldung mit Ihrem FTP-Programm überprüfen, ob die robots.txt-Datei im Stammordner Ihrer Website vorhanden ist.

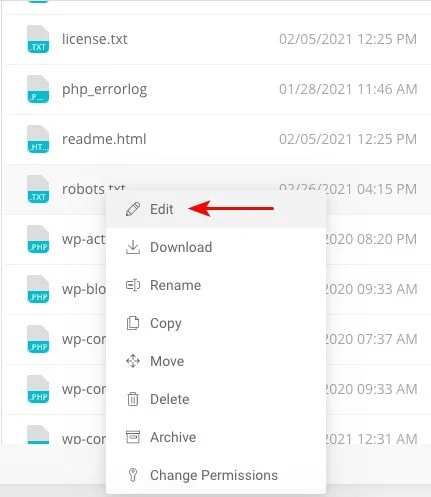

- Klicken Sie mit der rechten Maustaste auf die Datei und wählen Sie Bearbeiten, falls vorhanden.

Wenn Sie sich also erfolgreich mit Ihrem FTP-Client angemeldet haben, können Sie überprüfen, ob sich die robots.txt-Datei im Stammordner Ihrer Website befindet. Durch die Eingabe Ihres Domainnamens gefolgt von „/robots.txt“ können Sie am besten feststellen, ob Ihre Datei erfolgreich hochgeladen wurde oder nicht.

Nachdem Sie Ihre Änderungen vorgenommen haben, klicken Sie auf „Speichern“.

Sie müssen die Datei erstellen, falls sie noch nicht vorhanden ist. Eine Möglichkeit besteht darin, die Anweisungen mit einem einfachen Texteditor wie Notepad zu einer Datei hinzuzufügen. Wie zum Beispiel

Benutzeragent: * Nicht zulassen: /wp-admin/ Erlauben: /wp-admin/admin-ajax.php

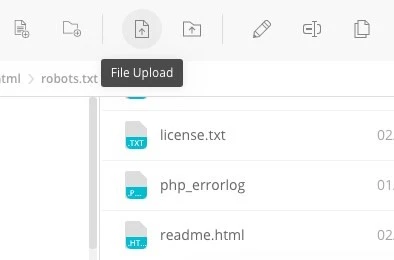

Klicken Sie in Ihrem FTP-Client auf „Datei hochladen“, um die Datei in den Stammordner der Website hochzuladen.

Geben Sie Ihren Domainnamen und „/robots.txt“ ein, um zu sehen, ob Ihre Datei erfolgreich hochgeladen wurde.

Dies ist die Methode zum manuellen Hochladen der robots.txt-Datei auf Ihre WordPress-Website!

Robots.txt: Kennt seine Vor- und Nachteile

Die Vorteile der Verwendung der robots.txt-Datei

Es weist die Suchmaschine an, keine Zeit auf Websites zu verbringen, die nicht indiziert werden sollen, was dazu beiträgt, die Crawling-Budgets der Suchmaschine zu optimieren. Dadurch erhöhen Sie die Wahrscheinlichkeit, dass Suchmaschinen die für Sie wichtigsten Websites crawlen.

Das Blockieren der Bots, die auf diese Weise die Ressourcen Ihres Webservers verschwenden, trägt zur Optimierung des Servers bei.

Es ist nützlich, um Dankesseiten, Zielseiten, Anmeldeseiten und andere Seiten auszublenden, die nicht von Suchmaschinen indiziert werden müssen.

Negative Aspekte der robots.txt-Datei

Mit den hier bereitgestellten Informationen sollten Sie nun in der Lage sein, die robots.txt-Datei auf jeder Website anzuzeigen. Es ist nicht allzu schwer zu verstehen. Geben Sie einfach den Domänennamen ein, gefolgt von „/robots.txt“ und drücken Sie die Eingabetaste.

Allerdings birgt dies bis zu einem gewissen Grad auch eine Gefahr. Es besteht die Möglichkeit, dass die WordPress Robots.txt for SEO-Datei URLs zu einigen internen Seiten Ihrer Website enthält, die nicht von Suchmaschinen indiziert werden sollen.

Beispielsweise kann es sein, dass es eine Seite zum Anmelden gibt, die Sie aus irgendeinem Grund nicht indizieren möchten. Die Erwähnung in der robots.txt-Datei ermöglicht es Angreifern jedoch, die Website einzusehen. Wenn Sie versuchen, bestimmte vertrauliche Informationen zu verbergen, gilt das Gleiche.

Selbst wenn Ihnen beim Schreiben der robots.txt-Datei ein einziger Tippfehler unterläuft, werden alle Ihre Bemühungen zur Suchmaschinenoptimierung (SEO) zunichte gemacht. Dies gilt auch dann, wenn die Datei einfach zu erstellen ist.

Wo soll die Robots.txt-Datei abgelegt werden?

Angenommen, Sie kennen zu diesem Zeitpunkt den Speicherort, an dem die robots.txt-Datei eingefügt werden muss.

Die robots.txt-Datei Ihrer Website sollte sich immer im Stammverzeichnis der Website befinden. Die URL der robots.txt-Datei auf Ihrer Website lautet https://yourdomain.com/robots.txt, wenn Ihr Domainname yourdomain.com lautet.

Zusätzlich zum Platzieren Ihrer robots.txt-Datei im Stammverzeichnis Ihrer Website sollten die folgenden weiteren empfohlenen Vorgehensweisen eingehalten werden:

- Es ist unbedingt erforderlich, Ihrer Datei den Namen robots.txt zu geben.

- Es ist wichtig, den Namen groß zu schreiben. Deshalb müssen Sie es richtig installieren, sonst funktioniert es nicht.

- Jede Anweisung muss in einer separaten Zeile platziert werden.

- Wenn eine URL vollständig ist, sollte sie mit einem „$“-Zeichen gekennzeichnet werden.

- Es sollte nur eine Instanz jedes Benutzeragenten verwendet werden.

- Um Menschen eine Erklärung zum Inhalt Ihrer robots.txt-Datei zu geben, verwenden Sie Kommentare, indem Sie jede Zeile mit einem Hash (#) beginnen.

Testen und Validieren Ihrer robots.txt-Datei

Das Testen und Validieren Ihrer robots.txt-Datei ist ein entscheidender Schritt, um sicherzustellen, dass Suchmaschinen Ihre Website ordnungsgemäß crawlen und indizieren. Eine gut optimierte robots.txt-Datei kann Suchmaschinen daran hindern, auf sensible oder irrelevante Seiten zuzugreifen, die Crawling-Effizienz verbessern und letztendlich die Gesamtleistung Ihrer Website steigern.

Um mit dem Testen Ihrer robots.txt-Datei zu beginnen, können Sie verschiedene Online-Tools nutzen, die speziell für diesen Zweck entwickelt wurden. Mit diesen Tools können Sie Ihre robots.txt-Anweisungen eingeben und simulieren, wie Suchmaschinen diese interpretieren und befolgen.

Durch die Analyse der Ergebnisse können Sie potenzielle Probleme oder Fehlkonfigurationen in Ihrer Datei identifizieren. Die regelmäßige Überwachung und Aktualisierung Ihrer robots.txt-Datei ist von entscheidender Bedeutung, insbesondere wenn Sie Änderungen an der Struktur oder dem Inhalt Ihrer Website vornehmen.

Wenn Sie wachsam bleiben, können Sie eventuell auftretende Probleme schnell erkennen und beheben. Dieser sorgfältige Ansatz trägt letztendlich zur Wahrnehmbarkeit, Indexierung und zum Gesamterfolg Ihrer Website in der digitalen Landschaft bei.

Das hier empfohlene Tool ist die Google Search Console

Sie können Ihre Website zur Google Search Console hinzufügen, indem Sie auf den Link „Eigenschaft jetzt hinzufügen“ klicken und den einfachen Anweisungen auf dem Bildschirm folgen. Nachdem Sie fertig sind, wird im Dropdown-Menü „Bitte wählen Sie eine Immobilie aus“ Ihre Website zu den Optionen hinzugefügt.

Nach Auswahl der Website ruft das Tool automatisch die mit Ihrer Website verknüpfte robots.txt-Datei ab und markiert etwaige Fehler oder Warnungen, sofern vorhanden.

Ist eine Robots.txt-Datei für Ihre WordPress-Website erforderlich?

Tatsächlich benötigt Ihre WordPress-Website eine robots.txt-Datei. Selbst wenn Ihre Website nicht über eine robots.txt-Datei verfügt, wird sie dennoch von Suchmaschinen gecrawlt und indiziert. Nachdem wir nun den Zweck, die Funktionsweise und das Crawling-Budget von robots.txt besprochen haben, warum sollten Sie einen weglassen?

Suchmaschinen werden über die robots.txt-Datei trainiert, was sie crawlen sollen und was noch wichtiger ist, was nicht.

Die Berücksichtigung der negativen Folgen des Crawling-Budgets ist einer der Hauptgründe für die Hinzufügung der robots.txt.

Wie bereits erwähnt, verfügt jede Website über ein Crawl-Budget. Es kommt darauf an, wie viele Websites ein Bot in einer einzigen Sitzung besucht. Der Bot kehrt zurück und setzt sein Crawling in der folgenden Sitzung fort, wenn er in dieser Sitzung nicht alle Seiten Ihrer Website fertigstellt.

Außerdem verringert sich dadurch die Geschwindigkeit, mit der Ihre Website indiziert wird.

Sie können Ihr Crawling-Kontingent schonen, indem Sie das Problem schnell beheben, indem Sie verhindern, dass Such-Bots Medienbestände, Themenverzeichnisse, Plugins und fremde Websites scannen.

Letzte Worte

Bei der Arbeit an Ihrer Website legen wir Wert auf Inhaltsoptimierung, Keyword-Recherche, den Aufbau von Backlinks, die Erstellung einer sitemap.xml und andere SEO-bezogene Aufgaben. WordPress Robots.txt für SEO ist ein Aspekt, den einige Webmaster übersehen.

Die robots.txt-Datei ist möglicherweise nicht sehr wichtig, wenn Ihre Website zum ersten Mal gestartet wird. Wenn Ihre Website jedoch größer wird und mehr Seiten hat, lohnt es sich, wenn wir beginnen, die empfohlene robots.txt-Datei zu verwenden.