WordPress Robots.txtを最適化する方法(高度なガイド)

公開: 2022-02-26多くの人がrobots.txtファイルについて聞いたことがあるかもしれませんが、それがどこにあり、どのように見えるか知っていますか? 最も重要なことは、WordPressのrobot.txtファイルを最適化してSEOを向上させる方法を知っていますか?

この記事では、これらの質問を取り上げて、WordPressrobots.txtファイルの正確で明確な画像を提供します。 そこから、ファイルを利用して、SERPでのオンラインの可視性を高めたり、機密コンテンツを一般の人の目に触れないようにすることができます。

まず、robots.txtの場所とその例から始め、ファイルを編集する方法を強調し、WordPressrobots.txtの最適化に関する高度なヒントでこの投稿を締めくくります。

飛び込みましょう!

- WordPressのrobot.txtの場所はどこですか?

- WordPressでrobot.txtを編集する方法は?

- WordPressRobots.txtファイルをSEO用に最適化する方法

WordPress robots.txtの場所はどこですか?

robots.txtファイルはウェブサイトのルートフォルダにあります。 その主な任務は、サイトをクロールしてインデックスを作成する方法について検索エンジンボットをガイドすることです。 特に、特定のファイルやフォルダへの検索エンジンのアクセスを拒否します。

多くのWordPressサイト所有者は、robots.txtファイルを使用して検索インデックス作成を阻止しています。 直感に反しているようですね。 SEOまたはSERPで1位を獲得することは、オンラインビジネスの成功に重要な要素を果たしているという事実を考慮します。

それでも、サイトが開発モードにある場合、または低品質または個人的なコンテンツが含まれている場合、robot.txtはそれらのコンテンツのブロッククロールとインデックス作成に便利です。 ここから、WordPress robots.txtファイルを最適化して、販売ページ、製品ページ、スポンサー付き投稿などの上位のランディングページに優先順位を付けることができます。

同じように、クロールクォータを最適化することもできます。 クロールクォータ、またはクロウバジェットは、Googleボットが常にクロールするWordPressサイトのページ数を指します。 重要なページが予算をクロールできるようにすることで、検索結果の1ページ目にすばやくインデックスを付けてランク付けすることができます。

ただし、robots.txtファイルの最適化は、適切に行わないとSEOに悪影響を与える可能性があるため、注意してください。

WordPressRobots.txtの例

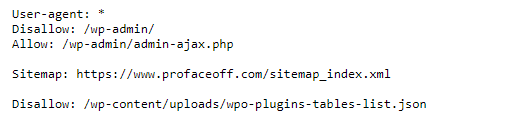

ドメイン名の最後に/robots.txtを追加すると、任意のWebサイトのrobots.txtファイルを表示できます。 したがって、robots.txtファイルは次のようになります。

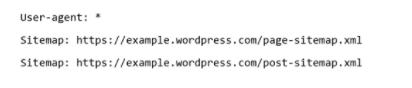

robots.txtファイルのuser-agentは、robots.txtファイルを読み取る検索エンジンです。 ユーザーエージェントでアスタリスクが付いている場合、これはすべての検索エンジンに緑色のライトを与えることを意味します。

robots.txtファイルで、ボットにクロールできるページとコンテンツを許可および禁止します。 ご覧のとおり、検索エンジンがWordPress admin-ajax内のファイルをクロールしてインデックスを作成することを許可し、プラグインと管理フォルダーへのアクセスを禁止しました。

サイトマップは、Webサイト上のすべてのページのリストと詳細を含むXMLファイルです。

WordPressでRobots.txtを編集する方法は?

WordPressでrobots.txtを編集する最も簡単な方法は、プラグインを使用することです。 robots.txtファイルの編集に優れた堅牢なSEOプラグインがいくつかあります。たとえば、オールインワンSEO、YoastSEO、RankMathなどです。

それとは別に、Virtual Robots.txt、WordPress Robots.txt最適化など、WordPressrobots.txtファイルを最適化するためだけに開発されたプラグインに助けを求めることもできます。

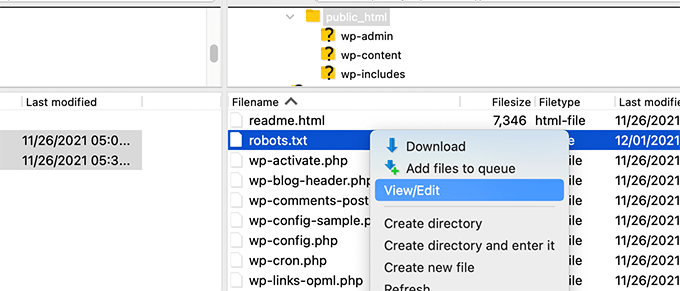

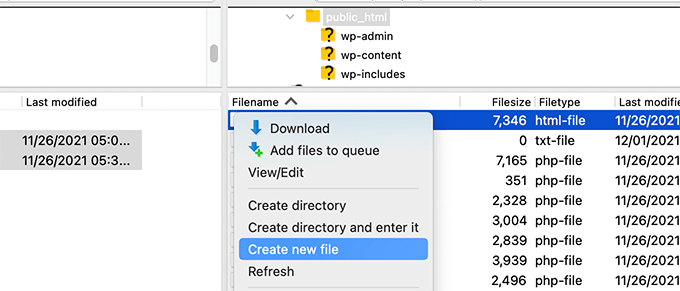

または、FTPクライアントを介してファイルを手動で編集することもできます。 まず、FTPクライアントを使用してWordPressホスティングプロバイダーに接続する必要があります。 その後、Webサイトのルートディレクトリでrobots.txtファイルを見つけます。

そこにrobot.txtファイルが表示されない場合は、サイトにファイルがない可能性があります。 びっくりするのではなく、新しいものを作成するだけです。 右クリックして「新しいファイルを作成」を選択し、デスクトップにダウンロードします。 Robots.txtはプレーンテキストファイルです。つまり、ワードパッドやメモ帳などのテキストエディタを使用して、他のファイルと同じようにダウンロードして編集できます。

その後、変更を更新し、編集したrobots.txtファイルをルートフォルダーに再度アップロードすると、完了です。

Robots.txtファイルをテストする

エディション後、robot.txtファイルが正常に機能することを確認する必要があります。 間違いが発生した場合、あなたのウェブサイトが検索結果ページから除外される結果につながる可能性があります。

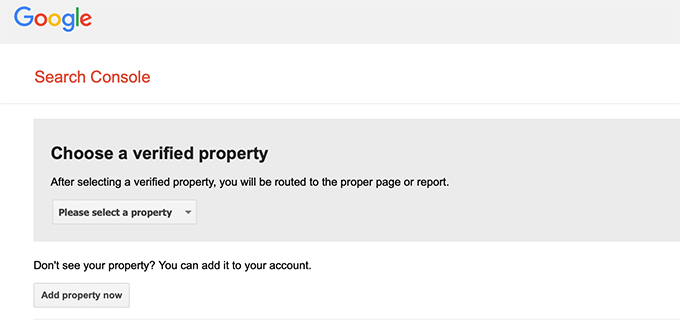

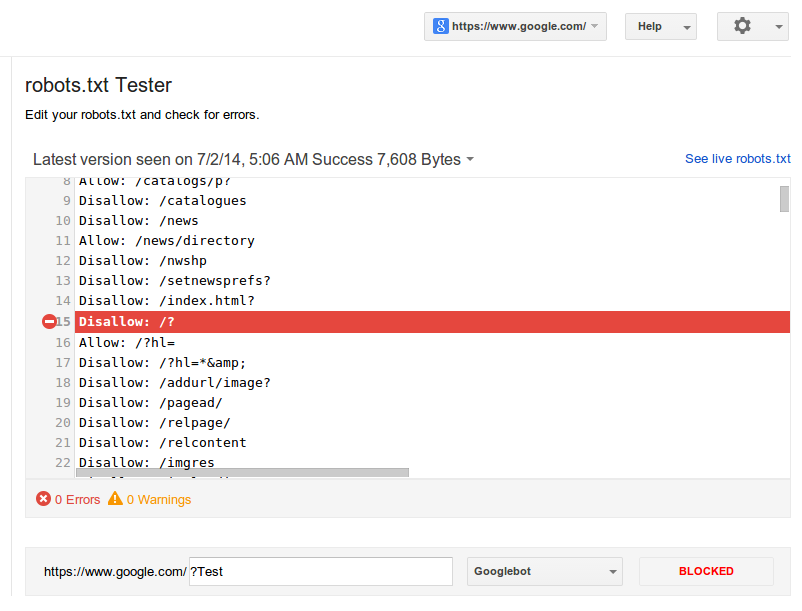

さまざまなrobots.txtテストツールの中で、robots.txtファイルを無料でテストできるGoogle検索コンソールを使用することをお勧めします。

ツールが認証を確認できるように、ウェブサイトのURLをGoogle検索コンソールに送信済みであることを確認してください。 そうでない場合は、検索エンジンにサイトを送信する方法についてのガイドを確認してください。

次に、Google Search Console RobotsTestingToolを使用するとよいでしょう。 ドロップダウンメニューでプロパティを選択すると、すぐにツールがファイルを調べ、エラーや警告があるかどうかを通知します。

それ以上に、このツールを使用すると、サイトの特定のページに入り、特定のユーザーエージェントを選択して、そのページがインデックス作成ブロックされているか、インデックス作成が受け入れられているかを確認できます。

ツールでファイルを直接編集して、テストを再実行することができます。 ただし、実際のファイルは変更されません。 エディションをコピーして実際のファイルに貼り付け、そこに保存する必要がある場合があります。

WordPressRobots.txtファイルをSEO用に最適化する方法

/ wp-admin / 、 / wp-content / plugins / 、 / trackback /、/ readme.htmlなど、機密性の高いページの一部を選択的に禁止し、残りは「許可」のままにすることを強くお勧めします。

さらに、サイトマップを追加することで、WordPressrobots.txtファイルを最適化できます。 WordPressは独自のサイトマップを提供していますが、YoastSEOやAll in One SEOなどのSEOプラグインを使用して、カスタムプラグインを作成できます。 投稿とページに別々のサイトマップを作成することができます。

その時点で、これらのサイトマップをrobots.txtファイルに追加すると、ボットのクロールがより迅速かつ簡単になります。

その上、最適化のアイデアにもかかわらず、robots.txtファイルに過度のタッチや編集を加えないことを強くお勧めします。 これは、ファイルの変更が多すぎると、ページ構造が損なわれ、サイトのクロールを阻止することをボットに通知し損なう可能性があるためです。

つまり、少ないほど多くなります。 サイトマップに焦点を合わせて、最初にトップページを見つけてもらう必要があります。

今すぐオンラインの可視性を高めましょう!

Robots.txtは、クロールクォータを戦略的に最適化し、プライベートコンテンツを検索インデックスから隠すことができる重要なファイルです。

この記事では、robots.txtファイルとは何か、ファイルの場所、ファイルの編集方法について説明しました。 また、WordPressrobots.txtファイルをSEO用に最適化する方法も紹介しました。 問題は、robots.txtのエディションが少ないほど良いということです。 また、キーページの可視性を高めるために、ファイルにカスタムサイトマップを追加することを忘れないでください。

何を待っていますか? 今すぐrobot.txtファイルでオンラインの可視性を高めましょう!