¿Cuál es la diferencia entre ASCII y Unicode?

Publicado: 2022-04-10ASCII y Unicode son los estándares de codificación de caracteres más conocidos que se utilizan actualmente en todo el mundo. Ambos programas son sumamente importantes en las comunicaciones modernas. Cuando se utiliza un dispositivo de comunicaciones electrónicas, los datos pasan por la unidad central de procesamiento que mejora el rendimiento del sistema mediante el uso de la memoria principal y la memoria caché. Los periféricos utilizan interfaces para comunicarse entre el sistema y un dispositivo conectado. Ambos caracteres estándar de codificación se pueden representar en binario. Los caracteres normalmente se agrupan en un conjunto de caracteres. Un juego de caracteres incluye:

- datos alfanuméricos (letras y números)

- símbolos (*, &, : etc.)

- caracteres de control (retroceso, tabulador horizontal, escape, etc.)

Un conjunto de caracteres es una selección de caracteres, mientras que una codificación de caracteres es un gráfico en el que un conjunto de caracteres y un valor se representan digitalmente (por ejemplo, A=1, B=2). El estándar ASCII es esencialmente ambos: define los conjuntos de caracteres que representa y un método para asignar a cada carácter un valor numérico. La palabra Unicode, por otro lado, se usa en varios contextos diferentes para significar cosas diferentes. Piense en ello como un término que lo abarca todo para referirse a un conjunto de caracteres y codificaciones de números. Sin embargo, debido a que existen numerosas codificaciones, el término Unicode generalmente se usa para referirse al conjunto general de caracteres, en lugar de cómo se grafican.

Características de ASCII y Unicode

ASCII

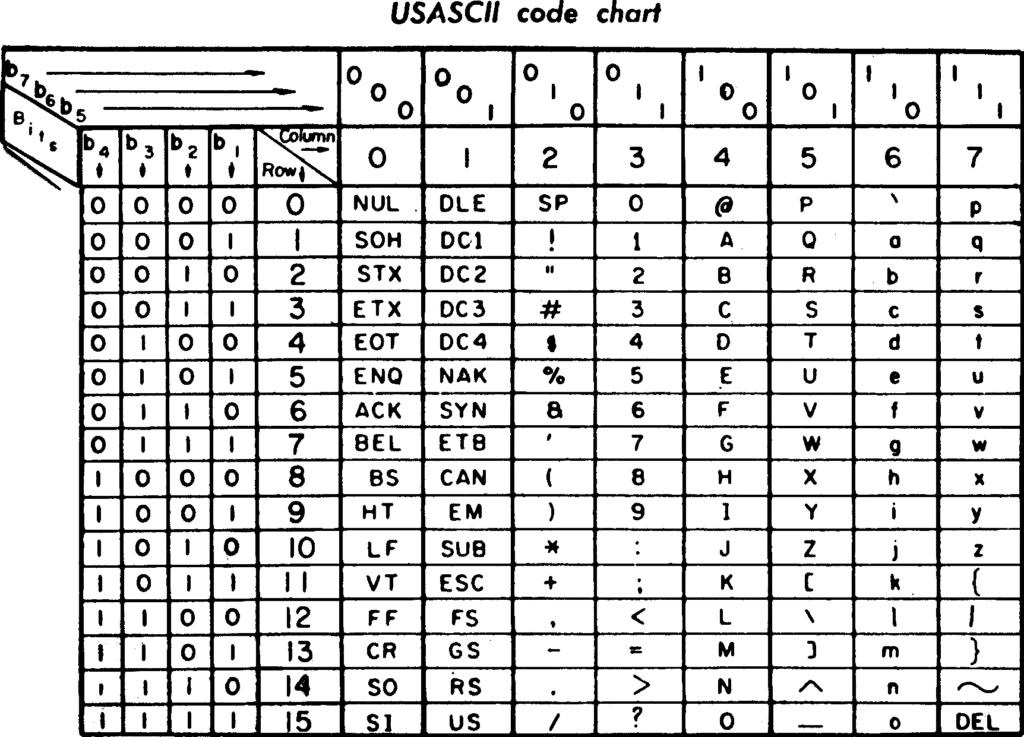

ASCII (Código estándar estadounidense para el intercambio de información) se lanzó por primera vez en 1963. Tiene 128 caracteres codificados, que se encuentran principalmente en el idioma inglés que se usa en las computadoras de programación modernas. Debido a que no se ha actualizado desde sus inicios, ASCII ocupa menos espacio. Utiliza 7 bits de datos para codificar cualquier carácter, se usó principalmente para la codificación de caracteres en la World Wide Web y todavía se usa ampliamente para programas informáticos modernos como HTML.

Codifica texto convirtiéndolo en números porque los números son más fáciles de almacenar en la memoria de la computadora que el alfabeto. También existe una versión alternativa conocida como ASCII extendido. Con esta técnica, es posible utilizar el bit más significativo de un byte de 8 bits para permitir que ASCII presente 256 caracteres. Los programadores usan el conjunto de caracteres de diseño para simplificar ciertas tareas. Por ejemplo, al usar códigos de caracteres ASCII, cambiar un solo bit convierte fácilmente el texto de mayúsculas a minúsculas. También utiliza algunos caracteres de control no imprimibles que inicialmente estaban destinados para su uso con terminales de impresión de teletipo.

Unicode

El proceso Unicode (Conjunto de Caracteres Universales), almacena y facilita el intercambio de datos de texto en cualquier idioma se considera el estándar de TI utilizado para la codificación. Unicode representa y maneja el texto para computadoras, teléfonos inteligentes y otros equipos tecnológicos. Codifica una variedad de caracteres, incluida una amplia gama de texto en numerosos idiomas, incluidos árabe, hebreo y griego, guiones históricos, símbolos matemáticos, etc. Unicode también admite una cantidad considerable de caracteres y ocupa más espacio en un dispositivo. entonces la programación ASCII es parte de Unicode. Unicode utiliza 16 bits para representar los caracteres más utilizados en una multitud de idiomas. Los desarrolladores suelen intercambiar datos utilizando un conjunto de códigos planos sin conversiones de código complejas para leer caracteres.

La compatibilidad con Unicode ofrece muchos beneficios, entre ellos:

- Fuente global y binario.

- Compatibilidad con entornos informáticos de secuencias de comandos mixtas.

- Interoperabilidad de datos multiplataforma mejorada a través de un conjunto de códigos común.

Facilidad de uso

ASCII

- Universalmente aceptado

- Debido a que ASCII utiliza un juego de caracteres básico para las comunicaciones básicas, los desarrolladores pueden diseñar interfaces que tanto las computadoras como las personas puedan comprender. ASCII codifica una hebra de datos como caracteres ASCII que se pueden explicar y presentar como datos para computadoras o texto legible planificado para personas. El juego de caracteres ASCII puede ayudar a simplificar ciertas tareas para los programadores.

- Codificación de caracteres compacta

- Los códigos estándar se pueden expresar en 7 bits, lo que significa que los datos se pueden expresar en el conjunto de caracteres ASCII estándar. Esto solo requiere tantos bytes para enviar o almacenar como números en los datos.

- Eficiente para programar

- Los códigos de caracteres ASCII están bien adaptados a las técnicas de programación para modificar texto y utilizar números para cálculos o almacenamiento como datos sin procesar.

Unicode

- Proceso de solicitud simplificado

- La aplicación requiere todos los símbolos para escribir y leer datos de caracteres dentro de una página de códigos individual. Esto simplifica enormemente el desarrollo de aplicaciones.

- Fácil transferencia de código existente

- Debido a que hay caracteres ASCII tradicionales en sus primeras 127 posiciones, el programa asigna cada uno de estos caracteres a su valor ASCII original.

- Compatibilidad web

- Dado que Unicode se está convirtiendo rápidamente en la página de códigos universal de la web, todos los estándares web actuales se basan en ella.

- Aplicaciones multilingües

- Las aplicaciones que utilizan Unicode pueden admitir una multitud de idiomas tanto en los datos como en la interfaz de usuario.

- interoperabilidad

- Los clientes Java y Active-X están basados en Unicode, por lo que pueden comunicarse con AppServers y bases de datos UTF-8.

Empresa detrás del producto y soporte

ASCII

En abril de 2008, MediaWorks, Inc. fue absorbida legalmente por ASCII Corporation y formó ASCII Media Works, Inc.

Unicode

El Consorcio Unicode es una corporación sin fines de lucro que desarrolla, mantiene y promueve la internacionalización del software, incluida la definición del comportamiento y las relaciones entre los caracteres Unicode.

Alternativas

- AppleScript

Apple creó un lenguaje de secuencias de comandos llamado AppleScript en 1993. Permite a los usuarios controlar aplicaciones de Macintosh programables. También permite a los usuarios controlar aplicaciones Macintosh programables directamente y partes de macOS. Puede crear flujos de trabajo complejos, crear secuencias de comandos, automatizar tareas repetitivas, combinar funciones de varias aplicaciones programables y un conjunto de instrucciones escritas. AppleScript ofrece un número limitado de comandos. Sin embargo, también proporciona un marco en el que puede conectar numerosos comandos específicos de tareas (proporcionados por partes programables de macOS y aplicaciones programables). AppleScript 2.0 ahora está completamente basado en Unicode y contiene todos los caracteres Unicode y se conserva correctamente independientemente de la preferencia de idioma.

Conclusión

Entonces, ¿cuál es mejor? En general, tanto ASCII como Unicode son extremadamente útiles, pero en última instancia, la elección es suya en función de sus preferencias y requisitos. ASCII es excelente cuando se trabaja con una pequeña cantidad de caracteres proporcionados por la técnica, ya que necesita menos espacio que Unicode. Unicode tiene una gran demanda debido a su gran variedad de características y funciones y es más fácil de usar. Ambas son excelentes técnicas de codificación para diferentes aplicaciones.