¿Cómo optimizar fácilmente el WordPress Robots.txt?

Publicado: 2023-02-28Introducción

Existen numerosas técnicas para aumentar el SEO de su sitio web. La optimización de WordPress Robots.txt es uno de los mejores métodos. Dado que permite que los motores de búsqueda escaneen su sitio web, el archivo Robots.txt es conocido como una potente herramienta de SEO. Como resultado, puede mejorar libremente el SEO de su sitio modificando el archivo Robots.txt. Presentaremos claramente algunos enfoques para optimizar WordPress Robots.txt sobre este tema en esta publicación de blog de hoy.

La definición del archivo Robots.txt

A continuación se muestra un resumen del archivo Robots.txt de WordPress.

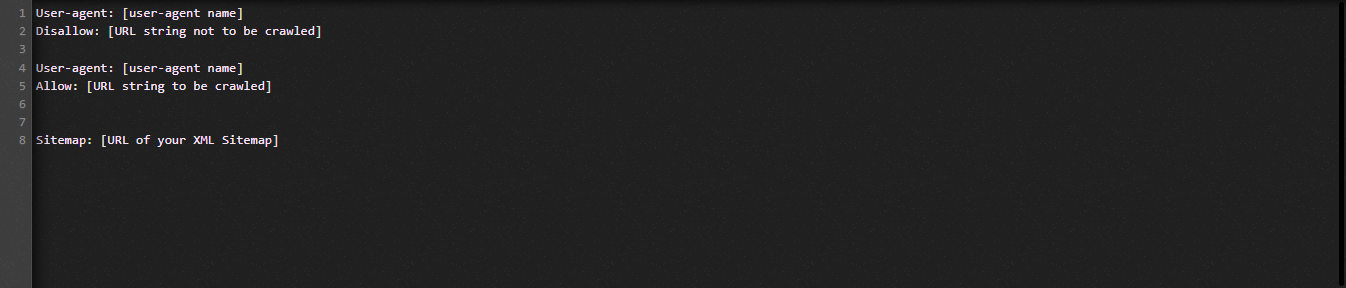

Ahora echemos un vistazo a la estructura fundamental del archivo Robot.txt:

Permítanos definir los términos utilizados en el archivo Robots.txt para usted:

- Agente de usuario: el nombre del rastreador

- No permitir: evita que se rastreen las páginas, las carpetas o los archivos de un sitio web.

- Permitir: habilitar el rastreo de directorios, archivos y páginas

- Mapa del sitio, si se proporciona: muestra la ubicación del mapa del sitio: representa un número o una letra.

- *: Soporte para número o carácter

- $: puede usarlo para restringir las páginas web que incluyen una extensión específica deteniéndose hasta el final de la línea.

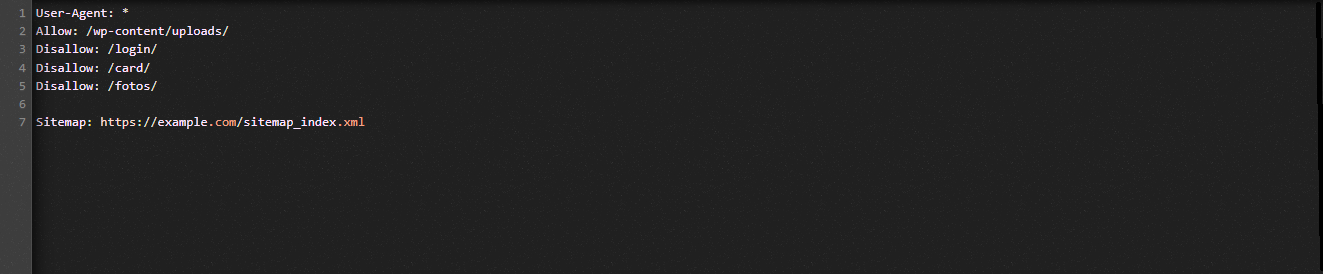

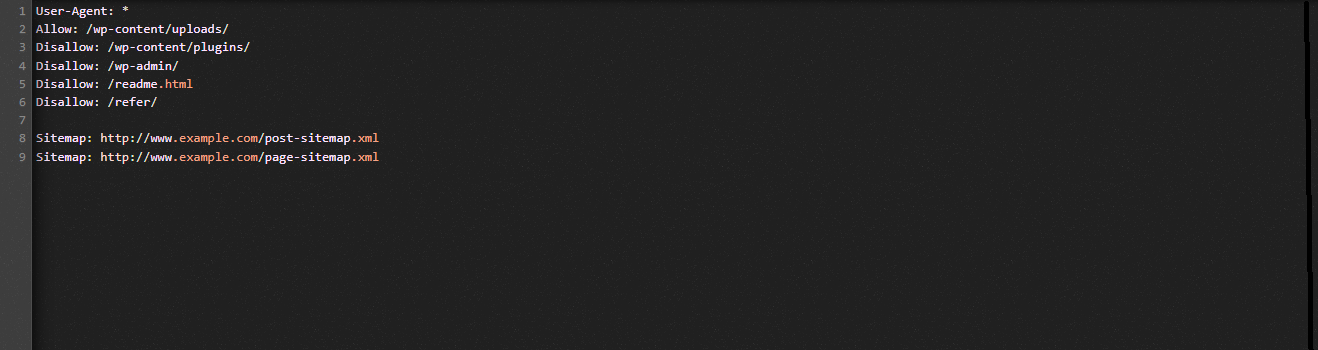

Veamos la siguiente ilustración para ayudarlo a comprender:

Permitimos que los motores de búsqueda rastreen los archivos en la carpeta de carga de WordPress en el ejemplo de Robot.txt.

Sin embargo, restringimos el acceso de los motores de búsqueda a las carpetas de inicio de sesión, tarjeta y fotos.

Finalmente, le proporcionamos la URL del mapa del sitio.

¿Por qué se debe crear un archivo Robots.txt para su sitio web de WordPress?

Sin un archivo Robots.txt, los motores de búsqueda seguirán rastreando e indexando cada página de un sitio web. Sin embargo, rastrearán todo el material de su sitio web en lugar de solo las carpetas o páginas que especifique.

Debe crear un archivo Robots.txt para su sitio web por dos razones clave. En primer lugar, puede gestionar sin esfuerzo toda la información de su sitio web con su ayuda. Depende de usted si las páginas o los directorios deben rastrearse o indexarse. Significa que los motores de búsqueda no rastrearán páginas como archivos de complementos, páginas de administración o directorios de temas. Como resultado, ayudará a la velocidad de carga del índice de su sitio web.

El requisito de evitar que los motores de búsqueda indexen publicaciones o páginas innecesarias es la otra justificación. Por lo tanto, puede evitar fácil y convenientemente que una página o publicación de WordPress aparezca en los resultados de búsqueda.

Cómo optimizar el WordPress Robots.txt más eficiente

En este blog instructivo, le mostraremos cómo crear y mejorar el archivo Robots.txt en su sitio web de WordPress usando dos métodos diferentes:

- Hacer cambios en el archivo Robots.txt usando un complemento: All in One SEO

- Edición manual del archivo Robots.txt con FTP

Para hacer que el archivo Robots.txt sea más efectivo, use el complemento All in One SEO.

Varios complementos SEO de WordPress están disponibles para ayudarlo con este problema en el mercado de WordPress. Pero en este artículo, hemos optado por emplear All in One SEO, un complemento muy querido con más de 2 millones de usuarios, para ayudarlo.

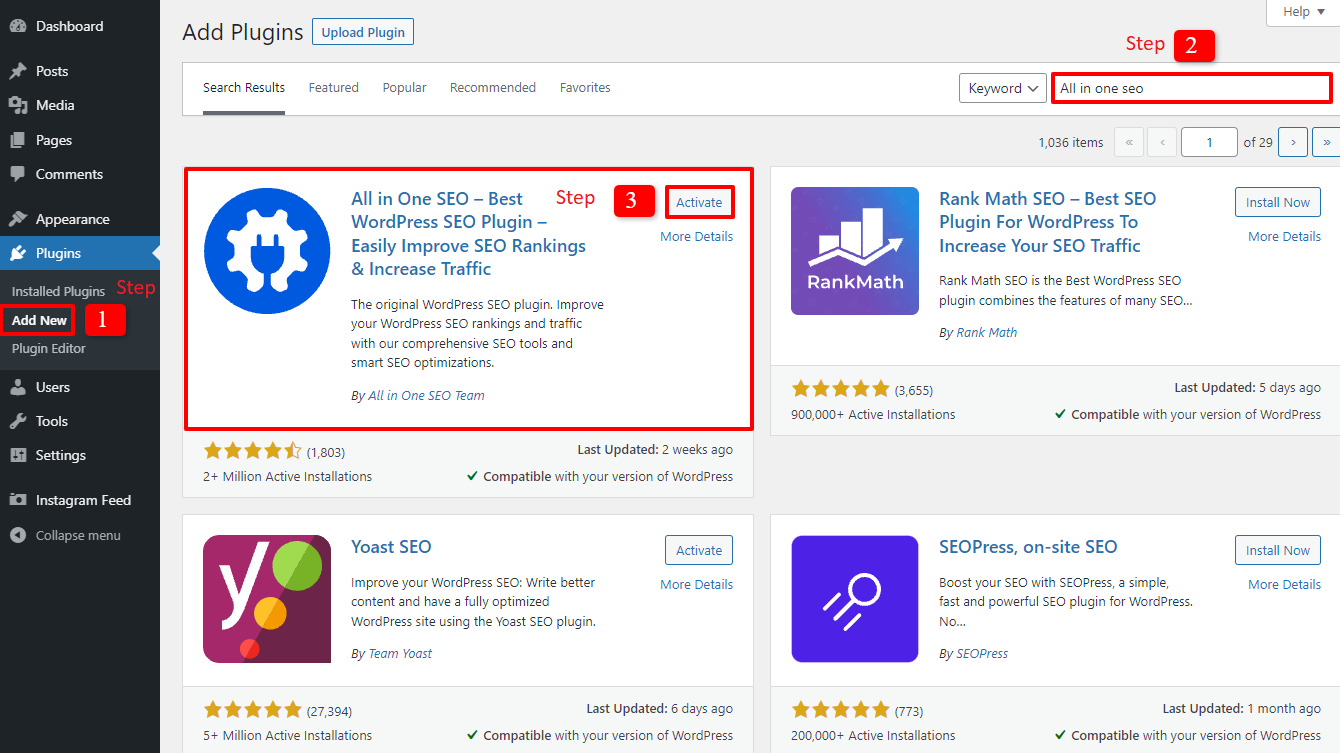

Instalémoslo primero seleccionando Complementos -> Agregar nuevo . luego busque el nombre del complemento, instálelo y luego actívelo .

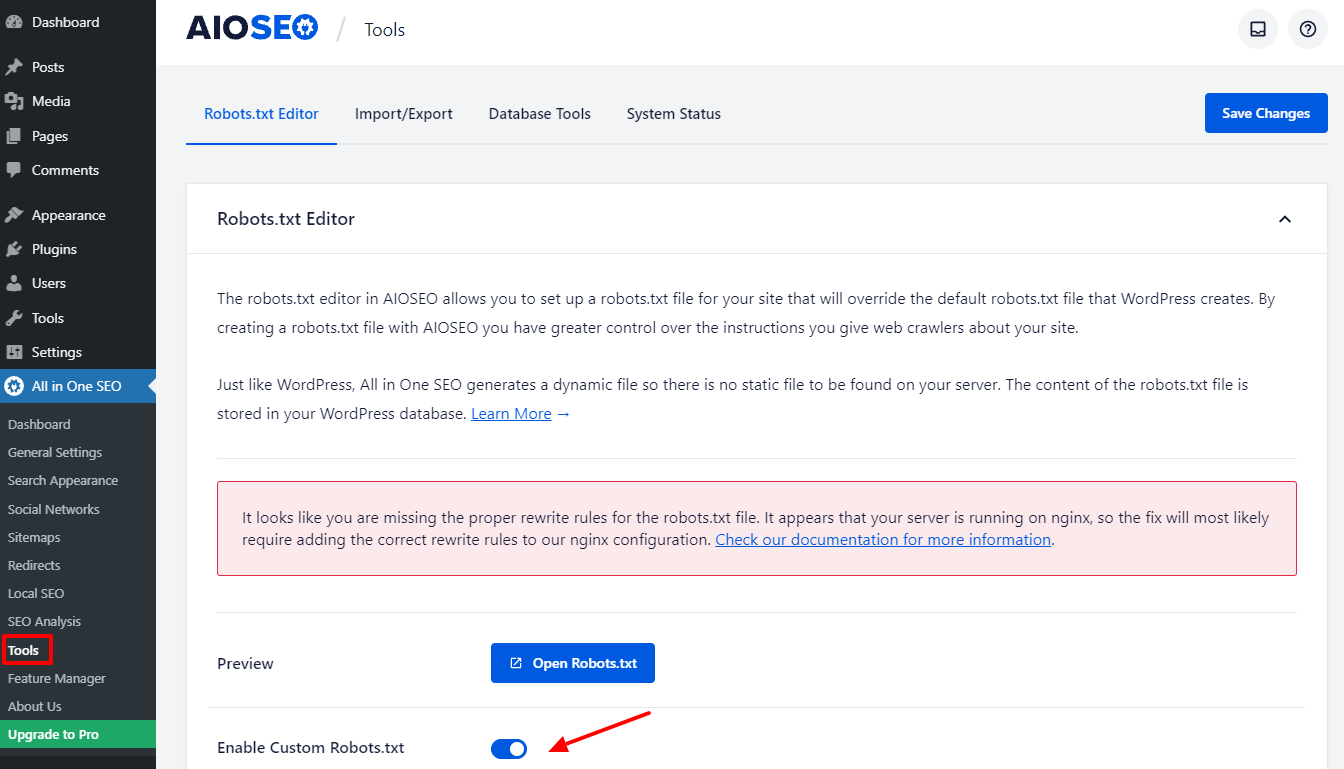

Volverá al panel de administración después de completar unos sencillos pasos. Vaya a Todo en uno SEO -> Herramientas ahora mismo.

Activemos el botón Activar Custome Robots.txt en la sección Editor de Robots.txt para activarlo. Después de encenderlo, puede editar el archivo Robots.txt predeterminado en WordPress.

Cuando nos desplazamos hacia abajo, notará que este complemento muestra un cuadro con una vista previa del archivo Robots.txt. Estas son las reglas predeterminadas de WordPress.

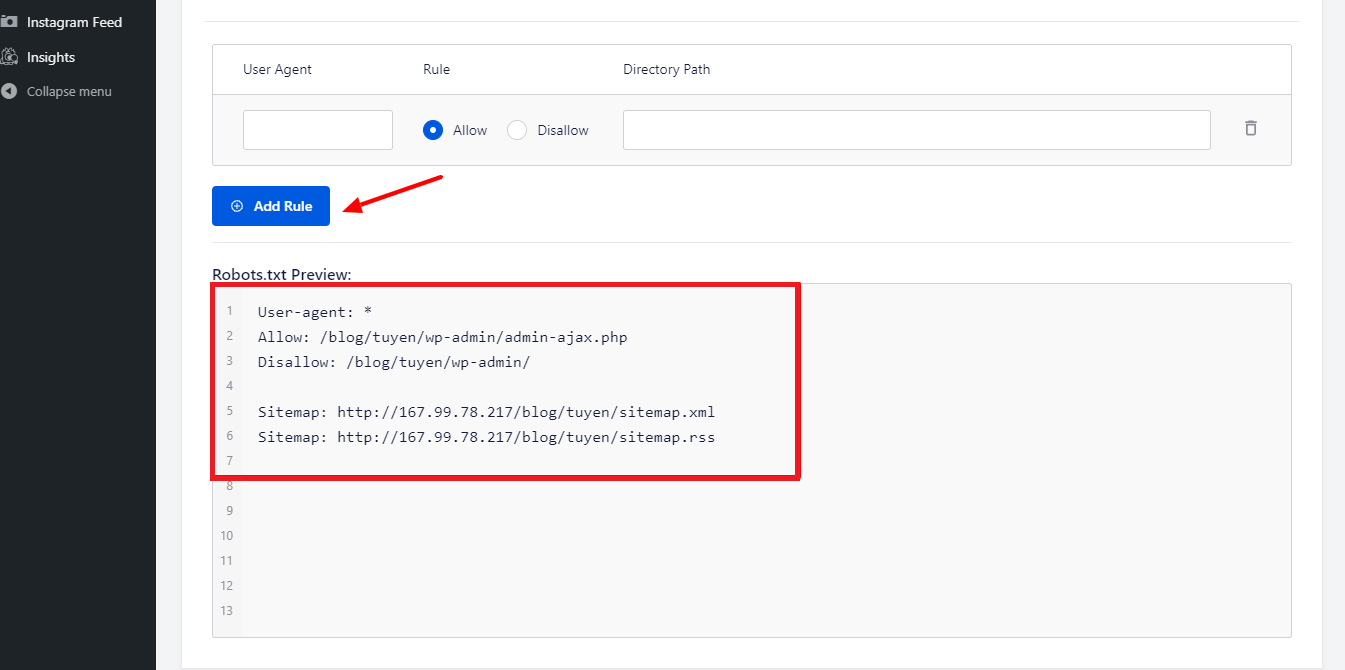

Al seleccionar el botón Agregar regla , puede agregar más de sus propias reglas específicas para ayudar al SEO de su sitio web.

Ingresemos un * en el campo User-Agent para aplicar la regla a todos los agentes de usuario para agregar una nueva regla.

Solo necesita seleccionar Permitir o No permitir para que los robots de búsqueda se rastreen en la siguiente etapa.

No olvide ingresar el nombre del archivo o la ruta del directorio en el campo Ruta del directorio después de eso.

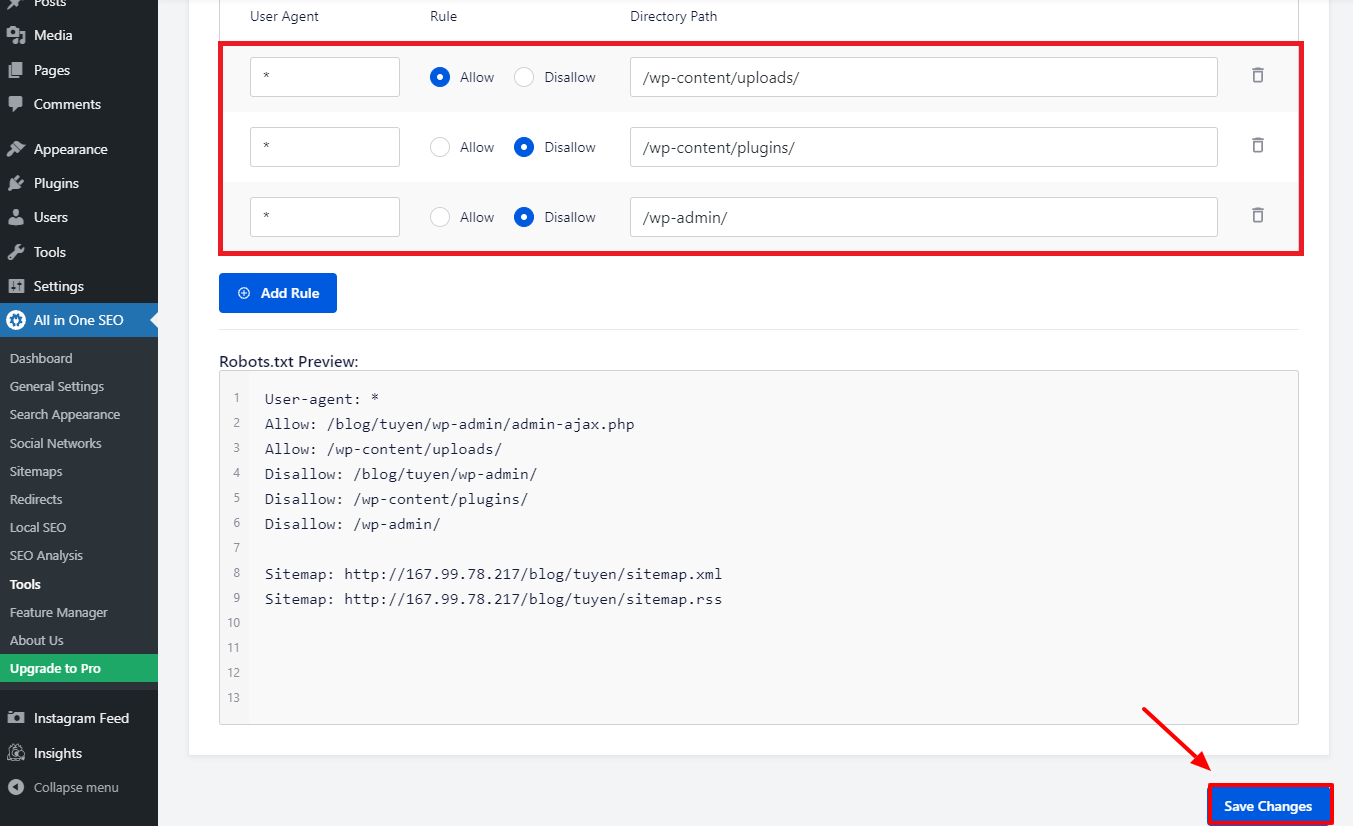

Cuando haya terminado con todas sus preferencias, presionemos el botón Guardar cambios .

Todas las reglas adicionales que ya ha agregado ahora se aplicarán inmediatamente al archivo Robots.txt.

Modifique y optimice manualmente el archivo Robots.txt de WordPress usando FTP

Este es un enfoque diferente para la optimización de WordPress Robots.txt que puede disfrutar. Debe editar el archivo Robots.txt usando un cliente FTP para lograr esto.

Para utilizar el cliente FPT convenientemente, primero establezcamos una conexión a su cuenta de alojamiento de WordPress. Puede notar fácilmente el archivo Robots.txt en la carpeta raíz de su sitio cuando accede a él. Elijamos Ver/Editar haciendo clic con el botón derecho del mouse.

Por otro lado, probablemente no tengas nada si no lo encuentras. Entonces, primero creemos un archivo Robots.txt para su sitio web seleccionando Crear un nuevo archivo con el botón derecho del mouse.

El archivo Robots.txt es un archivo de texto sin formato, por lo que puede descargarlo y editarlo con un editor de texto sin formato como Notepad o TextEdit, entre otros. Simplemente necesita volver a cargarlo en la carpeta raíz de su sitio web después de eso. Parece fácil, ¿no crees?

Asegúrese de que el archivo Robots.txt de su sitio de WordPress esté funcionando.

Su archivo Robots.txt debe probarse una vez que ya lo haya preparado y configurado para que cualquier problema pueda identificarse e informarse. Como resultado, debe probarlo con una herramienta de prueba de Robots.txt. Pruebe Google Search Console, ya que lo recomendamos encarecidamente.

Debe asegurarse de que su sitio web esté vinculado a Google Search Console si desea utilizar este servicio. A continuación, puede utilizar la herramienta de prueba de robots seleccionando la propiedad de la lista de selección. El archivo Robots.txt para su sitio web ahora se agregará automáticamente. Te avisará si hay un error.

Conclusión

En general, el objetivo principal de optimizar el archivo Robots.txt es evitar que los robots de búsqueda accedan a páginas que no son necesarias para el público en general, incluidas las carpetas de complementos o las carpetas de administración. Como resultado, bloquear etiquetas, categorías o páginas de archivo de WordPress no ayudará a su SEO. En otras palabras, para crear un archivo Robots.txt perfecto para su sitio de WordPress, debe seguir el patrón a continuación.

Esperamos que la publicación del blog de hoy le resulte útil para optimizar el archivo Robots.txt de WordPress. Recuerda pasarlo a tus conocidos y otros webmasters. Además, deje un comentario a continuación si tiene alguna pregunta. Por lo tanto, le responderemos tan pronto como podamos. Es hora de que optimices WordPress Robots.txt. Hasta los futuros blogs, cuídense.

Por cierto, tenemos un montón de temas de WordPress contemporáneos, atractivos y gratuitos que son totalmente compatibles con esta útil característica. Vamos a verlos y pedirle a uno de ellos que rediseñe tu sitio web