Cómo optimizar su WordPress Robots.txt para SEO usando Yoast SEO

Publicado: 2023-10-25La optimización de motores de búsqueda (SEO) es una parte crucial de la creación de un sitio web eficaz y uno de los factores más importantes para lograr el éxito del SEO es utilizar las herramientas adecuadas para optimizar su sitio. Una de esas herramientas es el archivo Robots.txt, que controla cómo los rastreadores de los motores de búsqueda acceden e indexan su contenido.

Optimizar su archivo WordPress Robots.txt puede ayudarlo a lograr mejores clasificaciones en los motores de búsqueda, mejorar la visibilidad de su sitio web y aumentar su tráfico.

Sin embargo, a pesar de su importancia, muchos propietarios de sitios web no están familiarizados con cómo configurar correctamente su archivo Robots.txt. En esta publicación de blog, lo guiaremos a través de todo lo que necesita saber para dominar su WordPress Robots.txt para SEO y desbloquear todo el potencial de SEO para su sitio web.

Comprender el papel de robots.txt en SEO

Comprender la función del archivo robots.txt en la optimización de motores de búsqueda es esencial para aprovechar al máximo los esfuerzos de optimización de su sitio web de WordPress y generar los mejores resultados posibles. Un archivo de texto llamado Robots.txt, que también puede denominarse Protocolo de exclusión de robots, brinda instrucciones a los rastreadores de los motores de búsqueda sobre qué áreas de su sitio web deben rastrear e indexar.

Cuando los robots de los motores de búsqueda visitan su sitio web, lo primero que hacen es buscar en el directorio raíz un archivo llamado robots.txt. Este archivo sirve como guía para los bots, informándoles sobre los sitios y archivos que pueden visitar y aquellos que no.

Tienes control total sobre el material que se muestra a los motores de búsqueda y el material que se les oculta si configuras tu archivo robots.txt correctamente.

La eficacia del escaneo de su sitio web debería mejorarse principalmente mediante el uso del archivo robots.txt. Ayuda a los robots de los motores de búsqueda a concentrarse en rastrear e indexar las partes más importantes de su sitio web, evitando así desperdiciar recursos en sitios no esenciales o material confidencial que no debería estar disponible para el público en general.

¿Qué es exactamente un archivo Robots.txt?

Un archivo de texto simple conocido como Robots.txt dirige los rastreadores web utilizados por los motores de búsqueda a determinadas páginas web de su sitio web. Además, indica a los robots que no rastreen ciertos sitios.

Es fundamental que comprenda el funcionamiento de un motor de búsqueda antes de continuar con el análisis en profundidad de este artículo.

El rastreo, la indexación y la clasificación son las tres actividades principales que realizan los motores de búsqueda.

Lo primero que hacen los motores de búsqueda es enviar sus rastreadores web, también conocidos como arañas o bots, por toda la World Wide Web. Estos programas, conocidos como bots, son piezas de software inteligentes que rastrean toda la web en busca de nuevas conexiones, páginas y sitios web. Rastreo es el término que se le da al proceso de búsqueda de contenido en la web.

Las páginas de su sitio web se organizarán en una estructura de datos que podrá usarse después de que los robots las hayan descubierto. Indexación es el nombre que se le da a este procedimiento.

Y al final todo se reduce a la clasificación. Cuando un usuario ingresa una consulta de búsqueda, el motor de búsqueda debe ofrecerle la mejor y más relevante información que pueda encontrar dependiendo de lo que esté buscando.

¿Cómo se ve el archivo Robots.txt?

El archivo robots.txt es un componente vital de la estructura y funcionalidad de un sitio web, pero ¿alguna vez te has preguntado cómo aparece realmente?

El archivo es aplicable a todos los robots de los motores de búsqueda que visitan el sitio web, como lo indica el asterisco que sigue a User-agent. Cada motor de búsqueda utiliza un agente de usuario diferente para explorar Internet.

Por ejemplo, Google utiliza el robot de Google para indexar el contenido de su sitio web para la búsqueda de Google. Estos agentes de usuario se cuentan por cientos. Se pueden configurar instrucciones personalizadas para cada agente de usuario. Por ejemplo, la primera línea de su archivo robots.txt debe ser: “Si desea establecer instrucciones específicas para el robot de Google, se lo conocerá como Agente de usuario: robot de Google.

¿Qué es exactamente el presupuesto de rastreo?

El presupuesto de rastreo se refiere a la cantidad de páginas que un motor de búsqueda está dispuesto a rastrear en un sitio web dentro de un período de tiempo determinado. Está determinado por varios factores, como la autoridad del sitio web, la popularidad y la capacidad del servidor para manejar solicitudes de rastreo. Además, debe asegurarse de que el presupuesto de rastreo se utilice de la manera más eficiente posible para su sitio web.

Seguramente el bot debería rastrear primero sus páginas más importantes si su sitio web tiene varias páginas. Por lo tanto, es imperativo que indique esto específicamente en su archivo robots.txt.

¿Cómo localizar y editar el archivo robots.txt en WordPress?

Localizar y editar el archivo robots.txt en WordPress es un paso crucial para optimizar su sitio web para los motores de búsqueda. Al configurar correctamente este archivo, puede controlar qué partes de su sitio son accesibles para los rastreadores de los motores de búsqueda, asegurándose de que se centren en las páginas y el contenido más importantes.

Para localizar y editar el archivo robots.txt en WordPress, siga estos sencillos pasos:

1. Inicie sesión en su panel de WordPress.

2. Navegue a la pestaña "Configuración" en el menú del lado izquierdo.

3. Haga clic en “Lectura” para acceder a la configuración de lectura.

4. Desplácese hacia abajo hasta encontrar la sección "Visibilidad del motor de búsqueda".

5. Aquí verá una opción que dice "Disuadir a los motores de búsqueda de indexar este sitio". Asegúrese de que esta opción no esté marcada, ya que generará un archivo robots.txt básico que limitará el acceso del motor de búsqueda a todo su sitio.

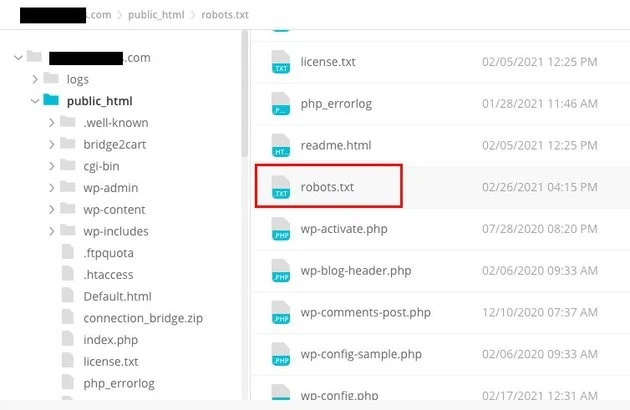

6. Si desea personalizar aún más su archivo robots.txt, puede hacerlo accediendo al directorio raíz de su sitio web. Normalmente, esto se puede hacer a través de un cliente FTP o un administrador de archivos cPanel.

7. Una vez que haya localizado el directorio raíz, busque el archivo llamado "robots.txt".

8. Descargue una copia del archivo robots.txt existente a su computadora como copia de seguridad, en caso de que surja algún problema durante la edición.

9. Abra el archivo robots.txt usando un editor de texto.

10. Personaliza el archivo según tus necesidades. Puede agregar directivas específicas para permitir o no permitir el acceso a ciertas áreas de su sitio. Por ejemplo, puedes evitar que los motores de búsqueda rastreen tu área de administración agregando la siguiente línea:

1. No permitir: /wp-admin/

11. Guarde los cambios en el archivo robots.txt y cárguelo nuevamente en el directorio raíz de su sitio web, reemplazando la versión anterior.

12. Finalmente, pruebe su archivo robots.txt utilizando la herramienta de prueba robots.txt de Google u otras herramientas similares para asegurarse de que esté configurado correctamente.

El control de cómo los rastreadores de los motores de búsqueda interactúan con su sitio web se puede lograr en WordPress identificando y modificando el archivo robots.txt en la ubicación adecuada. Esto le permitirá obtener los mejores resultados posibles en términos de visibilidad y clasificación de su sitio web. Si invierte tiempo en aprender y convertirse en un experto en esta faceta de la optimización de motores de búsqueda (SEO), estará en el camino correcto para lograr el éxito de su sitio de WordPress.

¿Cómo crear un archivo Robots.txt en WordPress?

Sigamos adelante y creemos un archivo Robots.txt de WordPress para SEO ahora que hemos analizado qué es un archivo robots.txt y por qué es tan crucial. WordPress le ofrece dos opciones distintas para generar un archivo robots.txt. El primer método implica el uso de un complemento de WordPress, mientras que el segundo implica la carga manual del archivo a la carpeta raíz de su sitio web.

Paso 1: Se trata de utilizar el complemento Yoast SEO para crear un archivo Robots.txt.

Puede utilizar complementos de SEO para ayudarlo a optimizar su sitio web construido en WordPress. La mayoría de estos complementos proporcionan su propio generador de archivos robots.txt dentro de su paquete de instalación.

Primero, descargue e instale el complemento.

Navegue hasta el menú Complementos y haga clic en "Agregar nuevo". El siguiente paso es buscar el complemento Yoast SEO, descargarlo y activarlo si aún no lo tienes.

Cree el archivo robots.txt como segundo paso.

Crea un archivo de texto de robots usando Yoast

Notarás el archivo creado con algunas directivas predeterminadas.

El generador de archivos robots.txt para Yoast SEO incluirá automáticamente las siguientes directivas:

Agente de usuario: * No permitir: /wp-admin/ Permitir: /wp-admin/admin-ajax.php

Agregue instrucciones adicionales a robots.txt. Después de editar robots.txt, haga clic en Guardar.

Ingrese su nombre de dominio y '/robots.txt'. Su archivo robots.txt estará completo si el navegador muestra las directivas predeterminadas, como se ve a continuación.

archivo de texto de robots generado

También le recomendamos que agregue la URL del mapa del sitio en su archivo robots.txt.

Archivo de texto de robots predeterminado

Una vez habilitado el complemento, vaya a Yoast SEO > Herramientas y elija Editor de archivos en el menú desplegable. Proceda a completar su nombre de dominio y luego continúe con '/robots.txt'. Si observa el navegador, verá que se muestran algunas directivas predeterminadas.

Paso 2: Usar FTP para crear manualmente el archivo Robots.txt

- Crear un archivo robots.txt en su computadora local y luego cargarlo en la carpeta raíz de su sitio web de WordPress es el siguiente paso del proceso.

- Además de esto, necesitará acceso a su alojamiento de WordPress mediante el uso de un programa FTP como Filezilla. Si aún no tiene las credenciales necesarias para iniciar sesión, podrá acceder a ellas a través del panel de control de su servicio de hosting. En consecuencia, puede verificar si el archivo robots.txt está presente en la carpeta raíz de su sitio web después de iniciar sesión con su programa FTP.

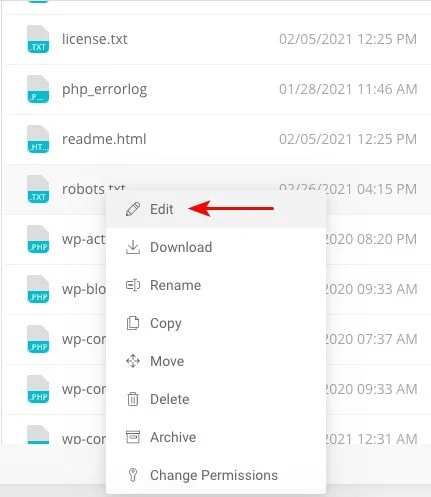

- Haga clic derecho en el archivo y elija editar si existe.

Por lo tanto, cuando haya iniciado sesión correctamente con su cliente FTP, podrá verificar si el archivo robots.txt se encuentra en la carpeta raíz de su sitio web. Ingresar su nombre de dominio seguido de '/robots.txt' es la mejor manera de determinar si su archivo se cargó exitosamente o no.

Después de realizar los cambios, haga clic en "Guardar".

Tendrás que crear el archivo si aún no existe. Se podría crear agregando directivas a un archivo usando un editor de texto básico como el Bloc de notas. Como

Agente de usuario: * No permitir: /wp-admin/ Permitir: /wp-admin/admin-ajax.php

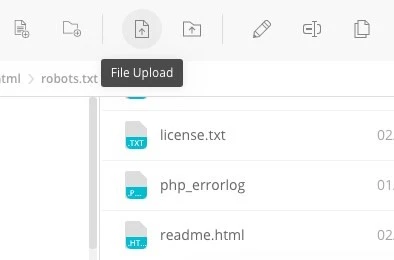

Haga clic en "Cargar archivo" en su cliente FTP para cargar el archivo en la carpeta raíz del sitio web.

Escriba su nombre de dominio y "/robots.txt" para ver si su archivo se ha cargado correctamente.

¡Este es el método para cargar manualmente el archivo robots.txt a su sitio web de WordPress!

Robots.txt: Conoce sus ventajas y desventajas

Los beneficios de utilizar el archivo robots.txt

Le indica al motor de búsqueda que no pierda tiempo en sitios que no desea que se indexen, lo que ayuda a optimizar los presupuestos de rastreo del motor de búsqueda. Al hacerlo, aumenta la probabilidad de que los motores de búsqueda rastreen los sitios que son más esenciales para usted.

Bloquear los bots que están provocando que se desperdicien los recursos de su servidor web de esta manera contribuye a la optimización del servidor.

Es útil para ocultar páginas de agradecimiento, páginas de destino, páginas de inicio de sesión y otras páginas que no necesitan ser indexadas por los motores de búsqueda.

Aspectos negativos del archivo robots.txt

Ahora debería poder ver el archivo robots.txt en cualquier sitio web utilizando la información proporcionada aquí. No es demasiado difícil de entender. Simplemente escriba el nombre del dominio, seguido de "/robots.txt" y presione Enter.

Sin embargo, hasta cierto punto esto también conlleva un peligro. Existe la posibilidad de que el archivo WordPress Robots.txt para SEO contenga URL de algunas de las páginas internas de su sitio web que no desearía que los motores de búsqueda indexaran.

Por ejemplo, puede haber una página para iniciar sesión que no desea indexar por cualquier motivo. Sin embargo, el hecho de que se mencione en el archivo robots.txt hace posible que los atacantes vean el sitio web. Si intenta ocultar cierta información confidencial, se aplica lo mismo.

Incluso si comete un solo error tipográfico al escribir el archivo robots.txt, arruinará todos sus esfuerzos de optimización de motores de búsqueda (SEO). Esto es cierto incluso si el archivo es fácil de crear.

Dónde colocar el archivo Robots.txt

Supongamos que en este punto ya está familiarizado con la ubicación donde se debe insertar el archivo robots.txt.

El archivo robots.txt de su sitio web siempre debe estar ubicado en el directorio raíz del sitio web. La URL del archivo robots.txt en su sitio web será https://yourdomain.com/robots.txt si su nombre de dominio es yourdomain.com.

Además de colocar su archivo robots.txt en el directorio raíz de su sitio web, las siguientes son algunas otras prácticas recomendadas que se deben seguir:

- Es muy necesario darle a tu archivo el nombre robots.txt.

- Es importante escribir el nombre con mayúscula. Por lo tanto, es necesario obtenerlo correctamente o, de lo contrario, no funcionará.

- Cada instrucción debe colocarse en una línea separada.

- Cuando una URL está completa, debe marcarse con un signo "$".

- Sólo se debe utilizar una instancia de cada agente de usuario.

- Para proporcionar a los humanos una explicación del contenido de su archivo robots.txt, utilice comentarios comenzando cada línea con un hash (#).

Probar y validar su archivo robots.txt

Probar y validar su archivo robots.txt es un paso crucial para garantizar que los motores de búsqueda rastreen e indexen correctamente su sitio web. Un archivo robots.txt bien optimizado puede evitar que los motores de búsqueda accedan a páginas confidenciales o irrelevantes, mejorar la eficiencia del rastreo y, en última instancia, mejorar el rendimiento general de su sitio web.

Para comenzar a probar su archivo robots.txt, puede utilizar varias herramientas en línea diseñadas específicamente para este propósito. Estas herramientas le permiten ingresar sus directivas robots.txt y simular cómo los motores de búsqueda las interpretan y siguen.

Al analizar los resultados, puede identificar posibles problemas o configuraciones incorrectas en su archivo. Monitorear y actualizar periódicamente su archivo robots.txt es crucial, especialmente cuando realiza cambios en la estructura o el contenido de su sitio web.

Si permanece alerta, podrá identificar y rectificar rápidamente cualquier problema que pueda surgir. Este enfoque meticuloso contribuirá en última instancia a la perceptibilidad, la indexación y el éxito general de su sitio web en el panorama digital.

La herramienta que sugerimos aquí es Google Search Console

Puede agregar su sitio web a Google Search Console yendo al enlace "Agregar propiedad ahora" y siguiendo las sencillas instrucciones en pantalla que aparecen. Una vez que haya terminado, el menú desplegable denominado "Seleccione una propiedad" incluirá su sitio web entre las opciones.

Después de seleccionar el sitio web, la herramienta obtendrá automáticamente el archivo robots.txt asociado con su sitio web y resaltará los errores o advertencias, si los hay.

¿Es necesario un archivo Robots.txt para su sitio web de WordPress?

De hecho, su sitio web de WordPress necesita un archivo robots.txt. Incluso si su sitio web no tiene un archivo robots.txt, los motores de búsqueda lo rastrearán e indexarán. Ahora que hemos analizado el propósito, el funcionamiento y el presupuesto de rastreo de robots.txt, ¿por qué querrías omitir uno?

Los motores de búsqueda están capacitados sobre qué rastrear y, lo que es más importante, qué no rastrear a través del archivo robots.txt.

Considerar las consecuencias negativas del presupuesto de rastreo es una de las principales razones para agregar el archivo robots.txt.

Como se dijo anteriormente, cada sitio web tiene un presupuesto de rastreo. Todo se reduce a cuántos sitios visita un bot en una sola sesión. El bot regresará y continuará rastreando en la sesión siguiente si no finaliza todas las páginas de su sitio web en esa sesión.

Además, esto reduce el ritmo al que se indexa su sitio web.

Puede guardar su cuota de rastreo solucionando este problema rápidamente evitando que los robots de búsqueda escaneen recursos multimedia, directorios de temas, complementos y sitios extraños.

Ultimas palabras

Priorizamos la optimización de contenido, la investigación de palabras clave, la creación de vínculos de retroceso, la creación de un mapa del sitio.xml y otras tareas relacionadas con SEO mientras trabajamos en su sitio web. WordPress Robots.txt para SEO es un aspecto que algunos webmasters pasan por alto.

Es posible que el archivo robots.txt no sea muy importante cuando se inicia su sitio web por primera vez. Dicho esto, cuando su sitio web crezca y tenga más páginas, obtendrá buenos resultados si comenzamos a utilizar el archivo robots.txt recomendado.