Comment optimiser facilement le WordPress Robots.txt ?

Publié: 2023-02-28Introduction

Il existe de nombreuses techniques pour augmenter le référencement de votre site Web. L'optimisation de WordPress Robots.txt est l'une des meilleures méthodes. Puisqu'il permet aux moteurs de recherche d'analyser votre site Web, le fichier Robots.txt est bien connu comme un puissant outil de référencement. En conséquence, vous pouvez librement améliorer le référencement de votre site en modifiant le fichier Robots.txt. Nous présenterons clairement certaines approches pour optimiser le WordPress Robots.txt sur ce sujet dans ce billet de blog aujourd'hui.

La définition du fichier Robots.txt

Vous trouverez ci-dessous un résumé du fichier Robots.txt de WordPress.

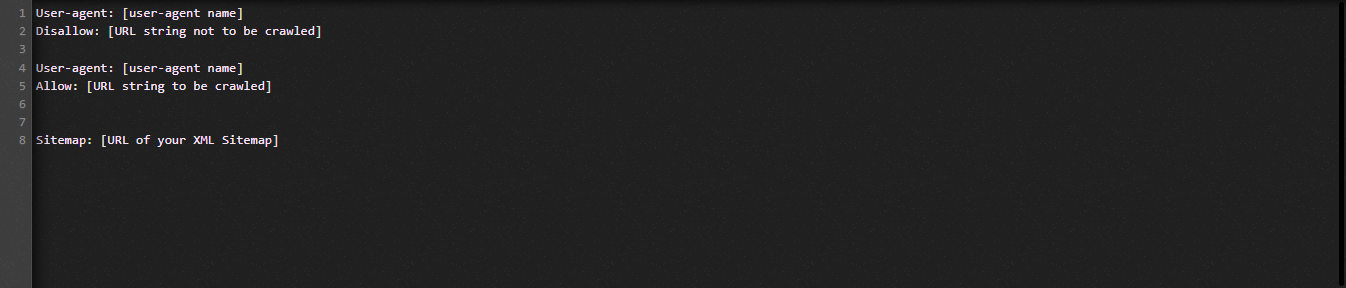

Voyons maintenant la structure fondamentale du fichier Robot.txt :

Laissez-nous définir pour vous les termes utilisés dans le fichier Robots.txt :

- User-agent : le nom du robot d'exploration

- Interdire : empêche l'exploration des pages, des dossiers ou des fichiers d'un site Web.

- Autoriser : activation de l'exploration de répertoires, de fichiers et de pages

- Plan du site, s'il est fourni : affiche l'emplacement du plan du site : représente un chiffre ou une lettre.

- * : représente un chiffre ou un caractère

- $ : Vous pouvez l'utiliser pour restreindre les pages Web qui incluent une extension spécifique en restant jusqu'à la fin de la ligne.

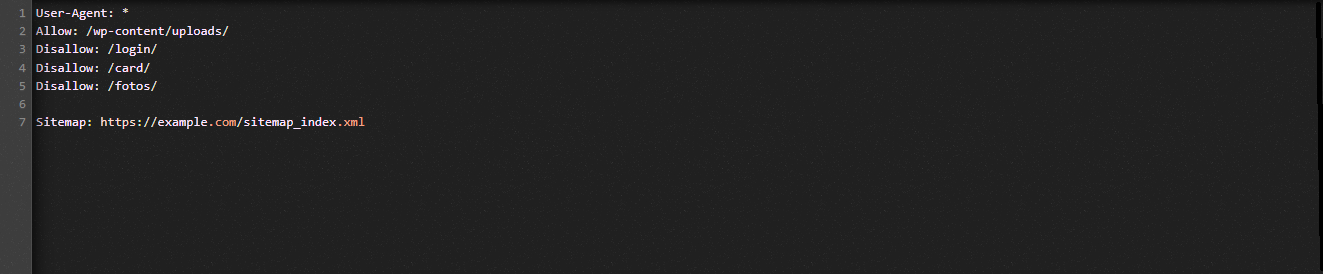

Regardons l'illustration suivante pour vous aider à comprendre :

Nous autorisons les moteurs de recherche à explorer les fichiers du dossier de téléchargement de WordPress dans l'exemple Robot.txt.

Cependant, nous restreignons l'accès des moteurs de recherche aux dossiers de connexion, de carte et de photo.

Enfin, nous lui fournissons l'URL du sitemap.

Pourquoi créer un fichier Robots.txt pour votre site WordPress ?

Sans fichier Robots.txt, les moteurs de recherche continueront d'explorer et d'indexer chaque page d'un site Web. Néanmoins, ils exploreront tout le matériel de votre site Web plutôt que seulement les dossiers ou les pages que vous spécifiez.

Vous devez créer un fichier Robots.txt pour votre site Web pour deux raisons principales. Tout d'abord, vous pouvez gérer sans effort toutes les informations de votre site Web avec son aide. C'est à vous de décider si les pages ou les répertoires doivent être explorés ou indexés. Cela signifie que les pages telles que les fichiers de plug-in, les pages d'administration ou les répertoires de thèmes ne seront pas explorées par les moteurs de recherche. En conséquence, cela aidera la vitesse de chargement de l'index de votre site Web.

L'exigence d'empêcher l'indexation des publications ou des pages inutiles par les moteurs de recherche est l'autre justification. Vous pouvez donc facilement et commodément empêcher une page ou un article WordPress d'apparaître dans les résultats de recherche.

Comment optimiser le WordPress Robots.txt plus efficace

Dans ce blog pédagogique, nous vous montrerons comment créer et améliorer le fichier Robots.txt sur votre site Web WordPress en utilisant deux méthodes différentes :

- Apporter des modifications au fichier Robots.txt à l'aide d'un plugin : All in One SEO

- Modification manuelle du fichier Robots.txt avec FTP

Pour rendre le fichier Robots.txt plus efficace, utilisez le plugin All in One SEO.

Plusieurs plugins WordPress SEO sont disponibles pour vous aider à résoudre ce problème sur le marché WordPress. Mais dans cet article, nous avons choisi d'utiliser All in One SEO, un plugin très apprécié avec plus de 2 millions d'utilisateurs, pour vous aider.

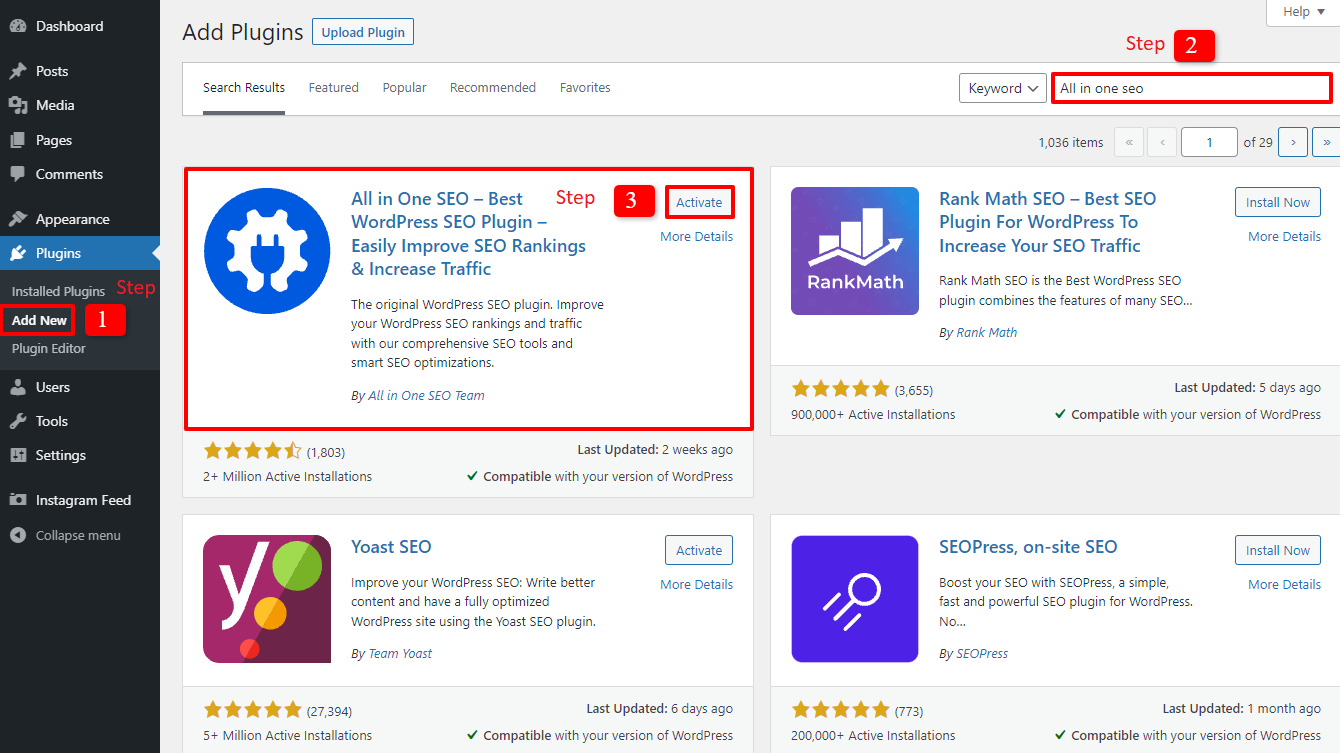

Installons-le d'abord en sélectionnant Plugins -> Add New . puis recherchez le nom du plugin, installez- le, puis activez -le.

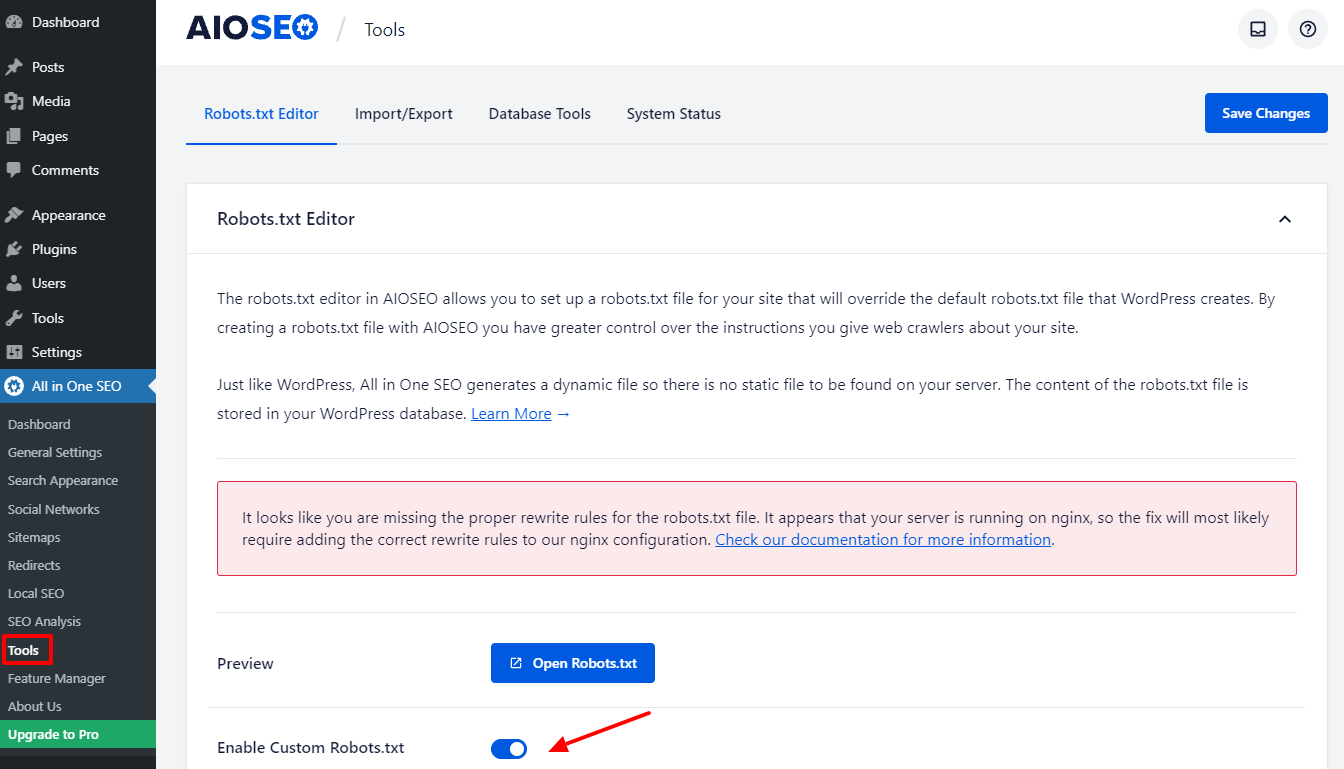

Vous reviendrez au tableau de bord d'administration après avoir suivi quelques étapes faciles. Accédez à Tout en un SEO -> Outils dès maintenant.

Basculons le bouton Enable Custome Robots.txt dans la section Robots.txt Editor pour le rendre actif. Après l'avoir activé, vous pouvez donc modifier le fichier Robots.txt par défaut dans WordPress.

Lorsque nous faisons défiler vers le bas, vous remarquerez que ce plugin affiche une boîte avec un aperçu du fichier Robots.txt. Ce sont les règles par défaut de WordPress.

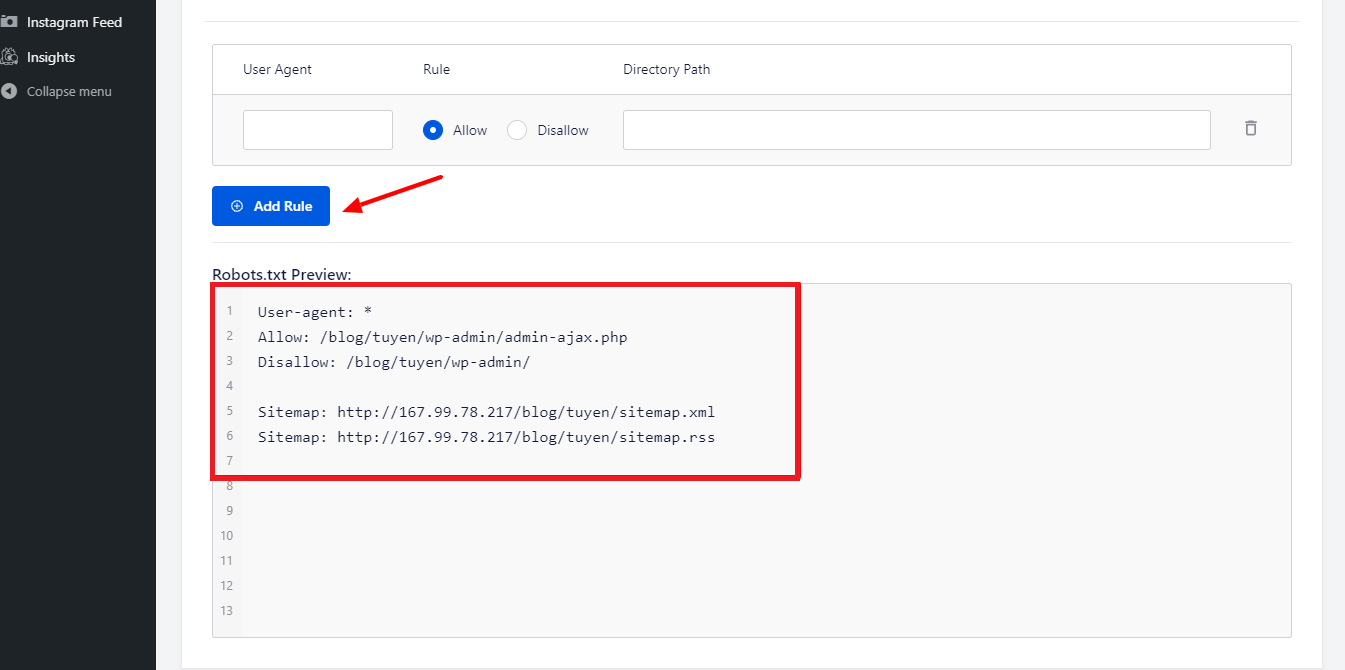

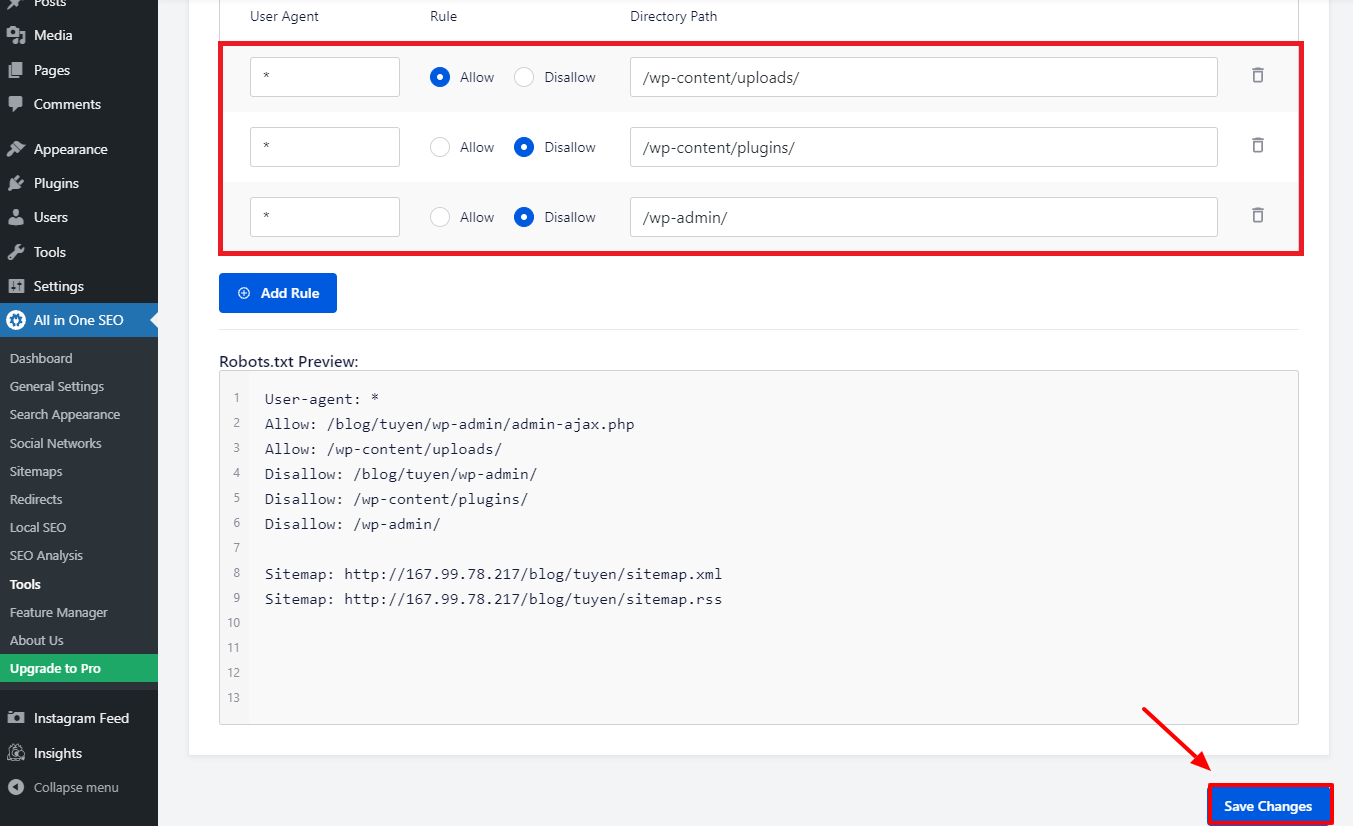

En sélectionnant le bouton Ajouter une règle , vous pouvez ajouter d'autres règles spécifiques pour aider le référencement de votre site Web.

Entrons un * dans le champ User-Agent pour appliquer la règle à tous les agents utilisateurs afin d'ajouter une nouvelle règle.

Il vous suffit de sélectionner Autoriser ou Interdire pour que les robots de recherche explorent à l'étape suivante.

N'oubliez pas d'entrer le nom du fichier ou le chemin du répertoire dans le champ Chemin du répertoire après cela.

Lorsque vous avez terminé avec toutes vos préférences, appuyez sur le bouton Enregistrer les modifications .

Toutes les règles supplémentaires que vous avez déjà ajoutées seront désormais immédiatement appliquées au fichier Robots.txt.

Modifier et optimiser manuellement le WordPress Robots.txt en utilisant FTP

Il s'agit d'une approche différente de l'optimisation de WordPress Robots.txt que vous pourriez apprécier. Vous devez modifier le fichier Robots.txt à l'aide d'un client FTP pour y parvenir.

Pour utiliser le client FPT de manière pratique, commençons par établir une connexion à votre compte d'hébergement WordPress. Vous pouvez facilement remarquer le fichier Robots.txt dans le dossier racine de votre site lorsque vous y accédez. Choisissons Afficher/Modifier en cliquant avec le bouton droit de la souris.

D'un autre côté, vous n'avez probablement rien si vous ne le trouvez pas. Commençons donc par créer un fichier Robots.txt pour votre site Web en sélectionnant Créer un nouveau fichier avec le bouton droit de la souris.

Le fichier Robots.txt est un fichier texte brut, vous pouvez donc le télécharger et le modifier à l'aide d'un éditeur de texte brut comme le Bloc-notes ou TextEdit, entre autres. Il vous suffit ensuite de le télécharger dans le dossier racine de votre site Web. Cela semble facile, vous ne pensez pas ?

Assurez-vous que le fichier Robots.txt de votre site WordPress fonctionne.

Votre fichier Robots.txt doit être testé une fois que vous l'avez déjà préparé et configuré afin que tout problème puisse être identifié et signalé. Par conséquent, vous devez le tester à l'aide d'un outil de test Robots.txt. Essayez Google Search Console, car nous le recommandons vivement.

Vous devez vous assurer que votre site Web est lié à Google Search Console si vous souhaitez utiliser ce service. Vous pouvez ensuite utiliser l'outil de test des robots en sélectionnant la propriété dans la liste de sélection. Le fichier Robots.txt de votre site Web sera maintenant ajouté automatiquement. Il vous alertera en cas d'erreur.

Conclusion

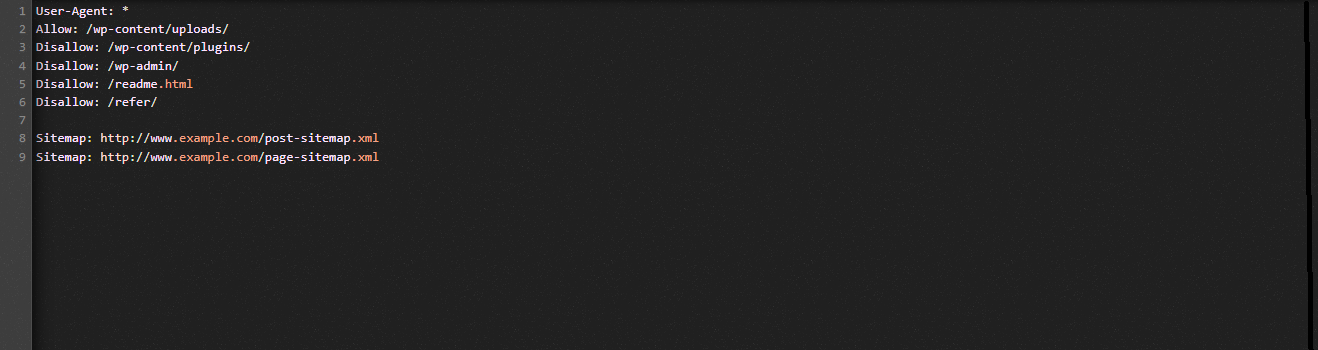

Dans l'ensemble, l'objectif principal de l'optimisation du fichier Robots.txt est d'empêcher les robots de recherche d'accéder à des pages qui ne sont pas requises pour le grand public, y compris les dossiers de plugins ou les dossiers d'administration. Par conséquent, le blocage des balises, catégories ou pages d'archive WordPress n'aidera pas votre référencement. En d'autres termes, pour créer un fichier Robots.txt parfait pour votre site WordPress, vous devez respecter le modèle ci-dessous.

Nous espérons que vous trouverez l'article de blog d'aujourd'hui utile pour optimiser WordPress Robots.txt. N'oubliez pas de le transmettre à vos connaissances et autres webmasters. Veuillez également laisser une remarque ci-dessous si vous avez des questions. Ainsi, nous vous répondrons dans les plus brefs délais. Il est temps pour vous d'optimiser le WordPress Robots.txt. En attendant les futurs blogs, prenez soin de vous.

Soit dit en passant, nous avons une tonne de thèmes WordPress contemporains, attrayants et gratuits qui prennent pleinement en charge cette fonctionnalité utile. Allons les voir et demandons à l'un d'eux de refaire votre site web