Comment optimiser votre WordPress Robots.txt pour le référencement

Publié: 2022-08-23Dans ce blog, nous apprendrons quelques astuces pour améliorer le référencement de votre site Web en optimisant le fichier robts.txt.

En fait, le fichier Robots.txt joue un rôle important en termes de référencement car il indique aux moteurs de recherche comment votre site Web peut être exploré. C'est la raison pour laquelle les fichiers Robot.txt sont considérés comme l'un des outils de référencement les plus puissants.

Plus tard, vous apprendrez également comment créer et optimiser WordPress Robots.txt pour le référencement.

Qu'entendez-vous par fichier robots.txt ?

Le fichier texte créé par les propriétaires de sites Web pour indiquer aux robots des moteurs de recherche comment ils peuvent explorer leur site Web et indexer les pages est appelé Robots.txt.

En fait, dans le répertoire racine, ce fichier est stocké. Ce répertoire est également appelé dossier principal de votre site Web. Mentionné ci-dessous est le format de fichier pour le fichier robots.txt

Agent utilisateur : [nom de l'agent utilisateur] Interdire : [chaîne d'URL à ne pas explorer] Agent utilisateur : [nom de l'agent utilisateur] Autoriser : [chaîne d'URL à explorer] Sitemap : [URL de votre sitemap XML]

Pour autoriser ou interdire des URL particulières, vous pouvez avoir différentes lignes d'instructions. De plus, vous pouvez également ajouter différents plans de site. Les robots des moteurs de recherche considéreront qu'ils sont autorisés à explorer les pages s'ils autorisent une URL.

Un exemple de robots.txt est donné ci-dessous

Agent utilisateur: * Autoriser : /wp-content/uploads/ Interdire : /wp-content/plugins/ Interdire : /wp-admin/ Plan du site : https://example.com/sitemap_index.xml

Dans l'exemple ci-dessus, nous avons permis d'explorer les pages par les moteurs de recherche et d'obtenir des fichiers d'index dans le dossier des téléchargements WordPress.

Après cela, nous n'avons pas autorisé les robots de recherche à explorer et à indexer les dossiers et plugins d'administration WordPress.

Enfin, nous avons mentionné l'URL du sitemap XML.

Pour votre site WordPress, avez-vous besoin d'un fichier Robots.txt ?

Le moteur de recherche commencera à explorer et à indexer vos pages même si vous n'avez pas le fichier texte, c'est-à-dire Robots.txt. Mais malheureusement, vous ne pouvez pas informer votre moteur de recherche du dossier ou de la page qu'il doit explorer.

Cela ne profitera pas ou ne laissera aucun impact si vous venez de créer un site Web ou un blog avec moins de contenu.

Cependant, une fois que vous avez configuré votre site Web avec beaucoup de contenu et qu'il a commencé à se développer, vous aurez besoin de contrôler les pages explorées et indexées de votre site Web.

La première raison est donnée ci-dessous

Pour chaque site Web, les robots de recherche ont un quota d'exploration.

Cela signifie clairement que pendant la session d'exploration, il explorera le nombre spécifique de pages. Supposons que l'exploration de votre site Web reste incomplète, elle reviendra une fois de plus et reprendra l'exploration dans une autre session.

Pour cette raison, le taux d'indexation de votre site Web sera une épreuve de force.

Vous pouvez résoudre ce problème en n'autorisant pas les robots de recherche à explorer ces pages qui ne sont pas nécessaires. Certaines pages sans importance peuvent inclure des fichiers de plug-in, des pages d'administration WordPress et des dossiers de thèmes.

Le quota de crawl peut être enregistré en ne permettant pas aux pages indésirables d'être crawlées. Cette étape sera plus utile car les moteurs de recherche vont désormais explorer les pages du site et pourront les indexer dès que possible.

Une autre raison pour laquelle vous devriez utiliser et optimiser le fichier WordPress Robots.txt est donnée ci-dessous

Chaque fois que vous devez empêcher les moteurs de recherche d'indexer des pages ou des publications sur votre site, vous pouvez utiliser ce fichier.

En fait, c'est l'un des moyens les plus inappropriés de couvrir le contenu de votre site Web du grand public, mais il s'avérera être le meilleur support pour les protéger afin qu'ils apparaissent dans les résultats de recherche.

Comment le fichier Robots.txt apparaît-il ?

Un fichier robots.txt très simple est utilisé par la plupart des blogs populaires. Le contenu peut différer par rapport à l'exigence du site Web particulier.

Agent utilisateur: * Refuser: Plan du site : http://www.example.com/post-sitemap.xml Plan du site : http://www.example.com/page-sitemap.xml Tous les robots seront autorisés par le fichier robots.txt à indexer chaque contenu et à proposer des liens vers le site Web du sitemap XML. Les règles suivantes sont mentionnées et doivent être suivies dans les fichiers robots.txt Agent utilisateur: * Autoriser : /wp-content/uploads/ Interdire : /wp-content/plugins/ Interdire : /wp-admin/ Interdire : /readme.html Interdire : /référer/ Plan du site : http://www.example.com/post-sitemap.xml Plan du site : http://www.example.com/page-sitemap.xml

Cela indiquera au bot d'indexer tous les fichiers et images WordPress. Cela ne permettra pas aux robots de recherche d'indexer la zone d'administration de WordPress, les fichiers de plug-in WordPress, les liens d'affiliation et le fichier Lisez-moi de WordPress.

Aux fichiers robots.txt, vous pouvez ajouter des sitemaps qui aideront les robots Google à reconnaître toutes les pages de votre site Web.

Maintenant que vous savez à quoi ressemble le fichier robots.txt, nous allons maintenant apprendre comment le fichier robots.txt peut être créé dans WordPress.

Dans WordPress, comment construire un fichier robots.txt ?

Pour créer un fichier robots.txt dans WordPress, il existe de nombreuses façons. Certaines des meilleures méthodes sont répertoriées ci-dessous, vous pouvez choisir l'une d'entre elles qui vous convient le mieux.

Méthode 1 : Utiliser All in One SEO, en modifiant le fichier Robots.txt

All in One SEO est le plugin WordPress le plus connu pour le référencement sur le marché, utilisé par plus d'un million de sites Web.

Le plugin All in One SEO est très simple à utiliser et propose donc le générateur de fichiers robotx.txt. Il est également utile d'optimiser WordPress Robots.txt

Si vous n'avez pas encore intégré ce plugin SEO, installez-le et activez-le d'abord depuis le tableau de bord WordPress. La version gratuite est également disponible pour les utilisateurs débutants afin qu'ils puissent utiliser ses fonctionnalités sans investir d'argent.

Après avoir activé le plugin, vous pouvez commencer à l'utiliser pour créer ou modifier le fichier robots.txt directement depuis votre zone d'administration WordPress.

Pour l'utiliser

- Accédez au référencement tout en un

- Maintenant, pour éditer le fichier robots.txt, cliquez sur les outils

- Maintenant, en cliquant sur "activer le fichier robots.txt personnalisé", vous activerez l'option d'édition

- Dans WordPress, vous pouvez également créer un fichier robots.txt personnalisé avec cette bascule.

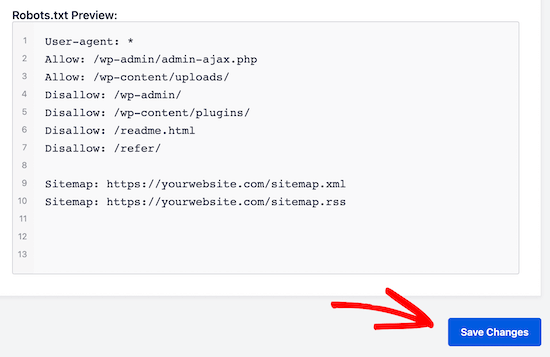

- Maintenant, votre fichier robots.txt existant sera affiché par le "Plug-in SEO tout en un" dans la section "Aperçu robots.txt". Ceci est visible au bas de votre écran Web.

Par WordPress, la règle par défaut qui a été ajoutée sera affichée par cette version

Les règles par défaut qui apparaissent suggèrent à votre moteur de recherche qu'il n'a pas besoin d'explorer les fichiers principaux de WordPress, offrent un lien vers le site Web du sitemap XML et permettent aux robots d'indexer tout son contenu.

Pour améliorer votre robots.txt pour le référencement, de nouvelles règles personnalisées peuvent être ajoutées.

Ajoutez un agent utilisateur dans le champ « Agent utilisateur » pour ajouter une règle. La règle sera appliquée à tous les agents utilisateurs en utilisant un *.

Choisissez maintenant si vous souhaitez autoriser ou non le moteur de recherche à explorer les pages.

Ajoutez maintenant le chemin du répertoire, le nom du fichier dans le champ 'Directory Path'.

A votre robots.txt, la règle sera appliquée automatiquement. Cliquez sur le bouton 'ajouter une règle' pour ajouter une nouvelle règle.

À moins que vous ne créiez un format robotx.txt idéal, nous vous suggérons d'ajouter de nouvelles règles.

Les règles personnalisées que vous avez ajoutées ressembleront à

Pour enregistrer vos modifications ne manquez pas de cliquer sur 'enregistrer les modifications'

Méthode 2 : Modifier le fichier Robots.txt manuellement à l'aide de FTP

Une autre méthode pour optimiser WordPress Robots.txt consiste à utiliser les fonctionnalités des clients FTP pour commencer à modifier le fichier robots.txt

Il vous suffit simplement de vous connecter à votre compte d'hébergement WordPress à l'aide d'un client FTP

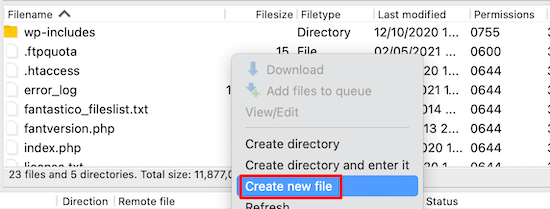

Une fois connecté, dans le dossier racine du site Web, vous pourrez voir le fichier robots.txt.

Si vous ne parvenez pas à le trouver, cela signifie que vous n'avez pas de fichier robots.txt

Dans une telle situation, vous devez créer le fichier robot.txt.

Comme mentionné précédemment, le fichier robots.txt est généralement un simple fichier texte qui peut être téléchargé sur votre ordinateur. Cependant, vous pouvez même le modifier à l'aide d'un éditeur de texte brut tel que TextEdit, Notepad ou WordPad.

Une fois que vous avez effectué toutes les modifications, il est temps de les enregistrer. Vous pouvez télécharger ce fichier dans le dossier racine de votre site Web.

Comment effectuer des tests sur votre fichier Robots.txt ?

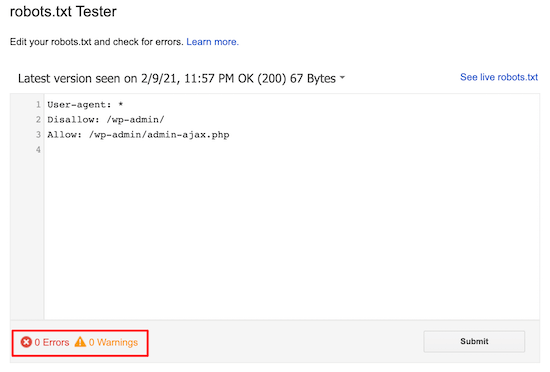

Vous pouvez effectuer des tests à l'aide de l'outil de test robots.txt.

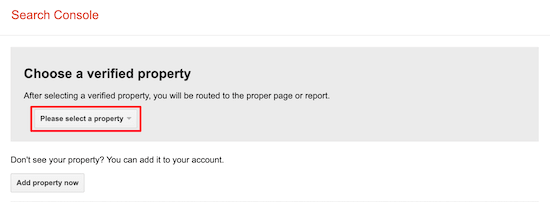

Sur le Web, vous trouverez de nombreux outils de test de robots.txt. L'un des meilleurs est Google Search Console.

Pour travailler avec cet outil, vous devez d'abord disposer d'un site Web connecté à la console de recherche Google. Après cela, vous pouvez commencer à utiliser ses fonctionnalités.

Dans la liste déroulante, il vous suffit de sélectionner votre propriété.

Cependant, il sélectionnera automatiquement le fichier robots.txt de votre site Web et mettra en évidence tous les avertissements et erreurs. C'est l'un des meilleurs outils qui vous aide à optimiser très facilement le fichier WordPress Robots.txt.

Conclusion:

La devise principale de l'optimisation de ce fichier robots.txt est de protéger les pages contre l'exploration des pages. Par exemple, les pages du dossier admin de WordPress ou les pages du dossier wp-plugin.

Le mythe le plus courant est que vous pouvez améliorer le taux de crawl et l'indexer plus rapidement et obtenir un meilleur classement en bloquant la catégorie WordPress, atteindre les pages et les balises.

Mais cela ne fonctionnera pas car cela ira mal selon les directives de Google pour les webmasters.

Nous vous suggérons fortement de lire et de considérer tous les points mentionnés ci-dessus.

Nous espérons que ce blog vous aidera à créer un fichier robots.txt en utilisant le bon format pour votre site Web. Et cela vous aidera à optimiser WordPress Robots.txt.