14 Kesalahan Umum Robots.txt WordPress yang Harus Dihindari

Diterbitkan: 2025-01-14Robots.txt adalah file server canggih yang memberi tahu crawler pencarian dan bot lain bagaimana berperilaku di situs WordPress Anda. Ini dapat sangat mempengaruhi optimasi mesin pencari (SEO) situs Anda, baik secara positif maupun negatif.

Oleh karena itu, Anda harus mengetahui file apa ini dan bagaimana cara menggunakannya. Jika tidak, Anda dapat merusak situs web Anda atau, setidaknya, meninggalkan sebagian potensinya.

Untuk membantu Anda menghindari skenario ini, dalam postingan ini, kami akan membahas file robots.txt secara detail. Kami akan menjelaskan apa itu file, tujuannya, cara menemukan dan mengelola file Anda, dan apa isinya. Setelah itu, kami akan membahas kesalahan paling umum yang dilakukan orang-orang dengan robots.txt WordPress mereka, cara menghindarinya, dan cara memulihkannya jika Anda melakukan kesalahan.

Apa itu robots.txt WordPress?

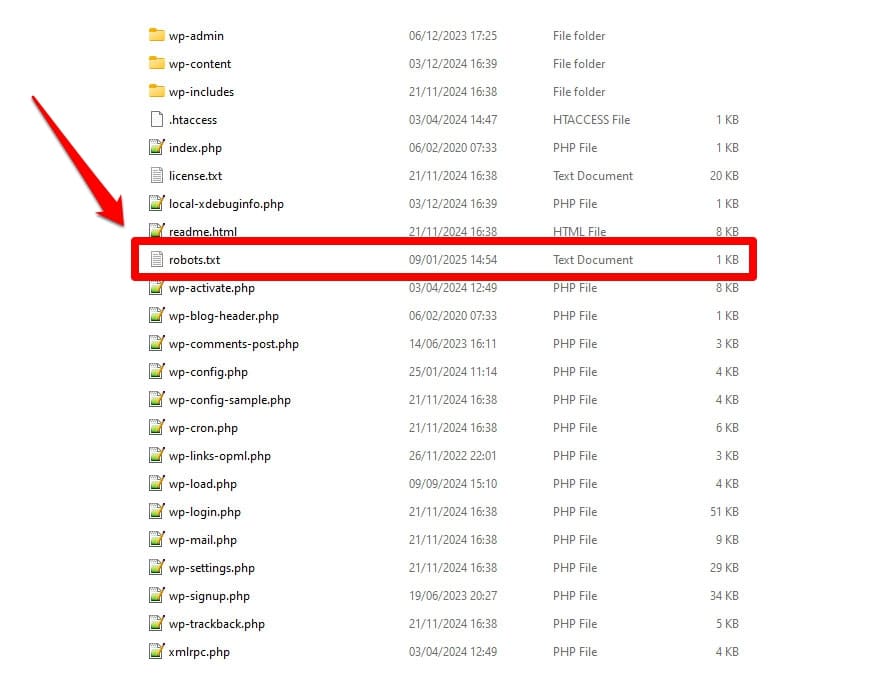

Seperti disebutkan, robots.txt adalah file konfigurasi server. Anda biasanya menemukannya di folder root server Anda.

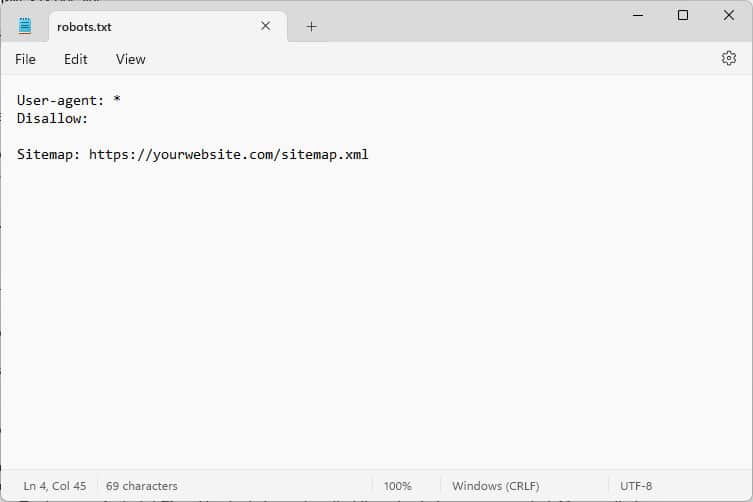

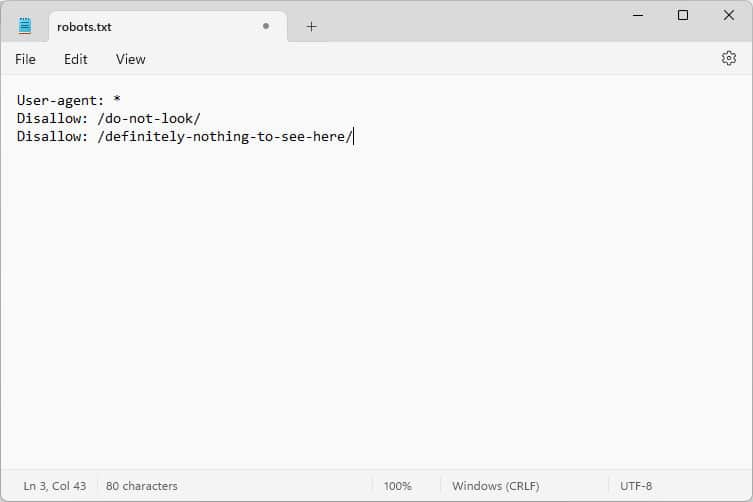

Saat Anda membukanya, isinya terlihat seperti ini:

Potongan kode ini adalah instruksi yang memberi tahu bot yang mengunjungi situs web Anda bagaimana berperilaku saat mereka berada di sana—khususnya, bagian mana dari situs web Anda yang dapat diakses dan mana yang tidak.

Bot apa, Anda bertanya?

Contoh paling umum adalah perayap otomatis dari mesin pencari yang mencari halaman web untuk diindeks atau diperbarui, tetapi juga bot dari model AI dan alat otomatis lainnya.

Arahan Apa yang Dapat Anda Berikan Dengan File Ini?

Robots.txt pada dasarnya mengetahui empat arahan utama:

- Agen-pengguna – Mendefinisikan siapa, artinya kelompok atau bot individu mana yang diperuntukkan bagi aturan berikut.

- Disallow – Menyatakan direktori, file, atau sumber daya yang dilarang diakses oleh agen pengguna.

- Izinkan – Dapat digunakan untuk mengatur pengecualian, misalnya, untuk mengizinkan akses ke folder atau sumber daya individual di direktori terlarang.

- Peta Situs – Mengarahkan bot ke lokasi URL peta situs situs web.

Hanya Agen Pengguna dan Larang yang wajib agar file dapat melakukan tugasnya; dua arahan lainnya bersifat opsional. Misalnya, ini adalah cara Anda memblokir bot apa pun agar tidak mengakses situs Anda:

User-agent: * Disallow: /Tanda bintang menunjukkan bahwa aturan berikut berlaku untuk semua agen pengguna. Garis miring setelah Disallow menyatakan bahwa semua direktori di situs ini terlarang. Ini adalah file robots.txt yang biasa Anda temukan di situs pengembangan, yang tidak seharusnya diindeks oleh mesin pencari.

Namun, Anda juga dapat menyiapkan aturan untuk masing-masing bot:

User-agent: Googlebot Allow: /private/resources/Penting untuk diperhatikan bahwa robots.txt tidak mengikat. Hanya bot dari organisasi yang mematuhi Protokol Pengecualian Robot yang akan mematuhi arahannya. Bot berbahaya, seperti bot yang mencari kelemahan keamanan di situs Anda, dapat dan akan mengabaikannya, dan Anda perlu mengambil tindakan tambahan terhadapnya.

Bahkan organisasi yang mematuhi standar ini akan mengabaikan beberapa arahan. Kita akan membicarakan contohnya lebih jauh di bawah.

Mengapa robots.txt Penting?

Situs WordPress Anda tidak wajib memiliki file robots.txt. Situs Anda akan berfungsi tanpanya, dan mesin pencari tidak akan menghukum Anda karena tidak memilikinya. Namun, menyertakan satu memungkinkan Anda untuk:

- Jauhkan konten dari hasil pencarian, seperti halaman login atau file media tertentu.

- Cegah perayap penelusuran membuang-buang anggaran perayapan pada bagian situs yang tidak penting, yang mungkin mengabaikan laman yang Anda ingin mereka indeks.

- Arahkan mesin telusur ke peta situs Anda sehingga mereka dapat menjelajahi seluruh situs web Anda dengan lebih mudah.

- Pertahankan sumber daya server dengan mencegah bot yang boros.

Semua ini membantu menjadikan situs Anda lebih baik, khususnya SEO Anda, oleh karena itu penting bagi Anda untuk memahami cara menggunakan robots.txt.

Cara Menemukan, Mengedit, dan Membuat robots.txt WordPress Anda

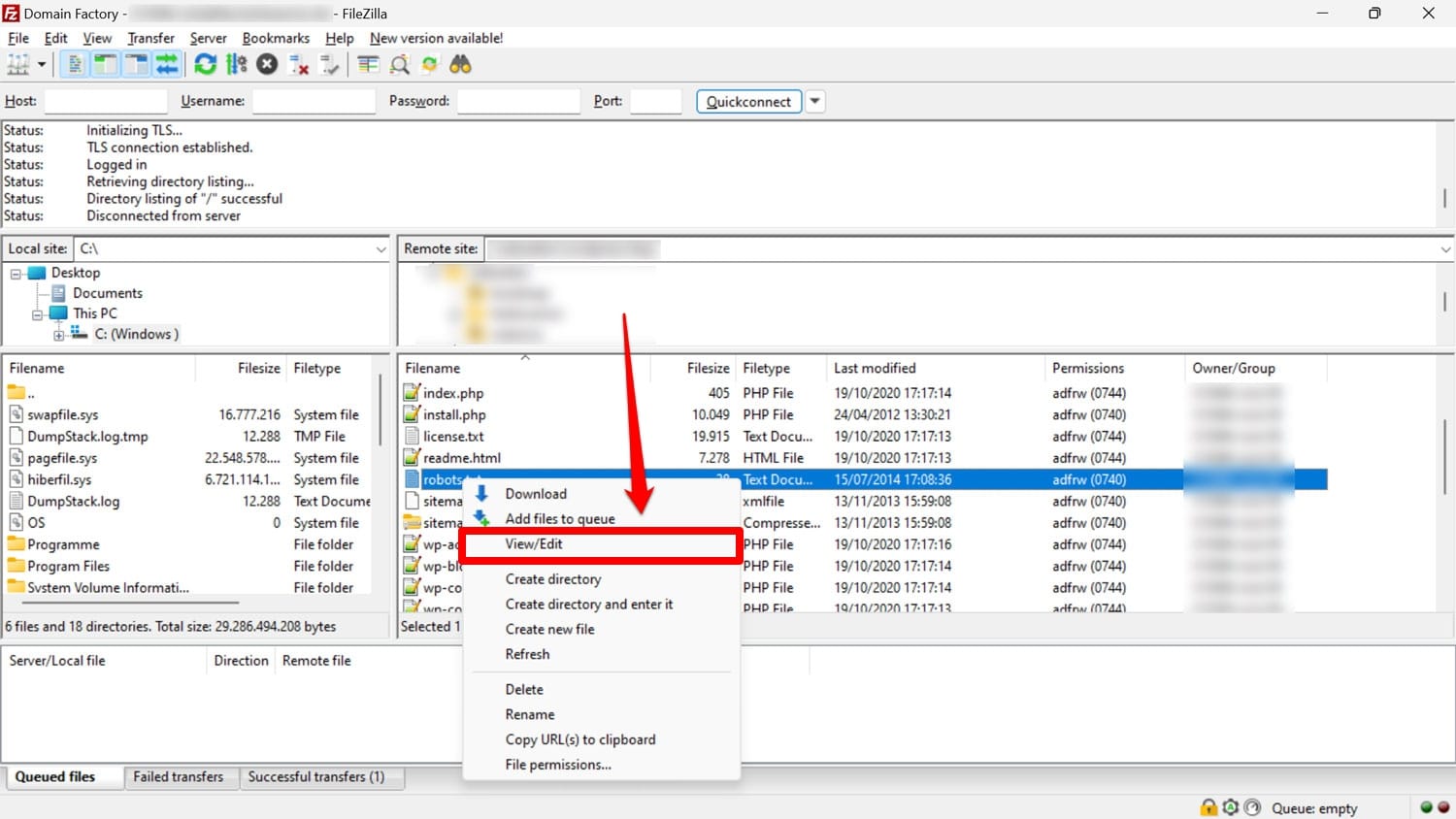

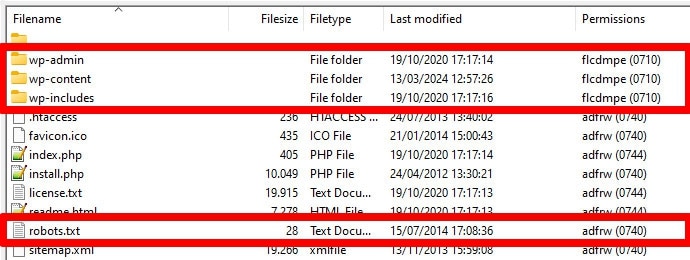

Seperti disebutkan, robots.txt biasanya terletak di folder root situs web Anda di server. Anda dapat mengaksesnya di sana dengan klien FTP seperti FileZilla dan mengeditnya dengan editor teks apa pun.

Jika Anda tidak memilikinya, Anda cukup membuat file teks kosong, beri nama “robots.txt”, isi dengan arahan, dan unggah.

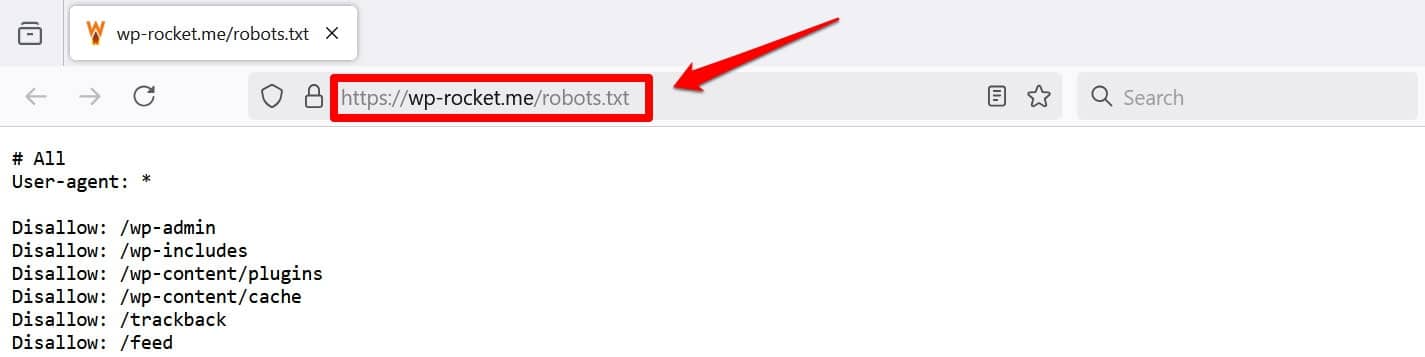

Cara lain untuk setidaknya melihat file Anda adalah dengan menambahkan /robots.txt ke domain Anda, misalnya https://wp-rocket.me/robots.txt.

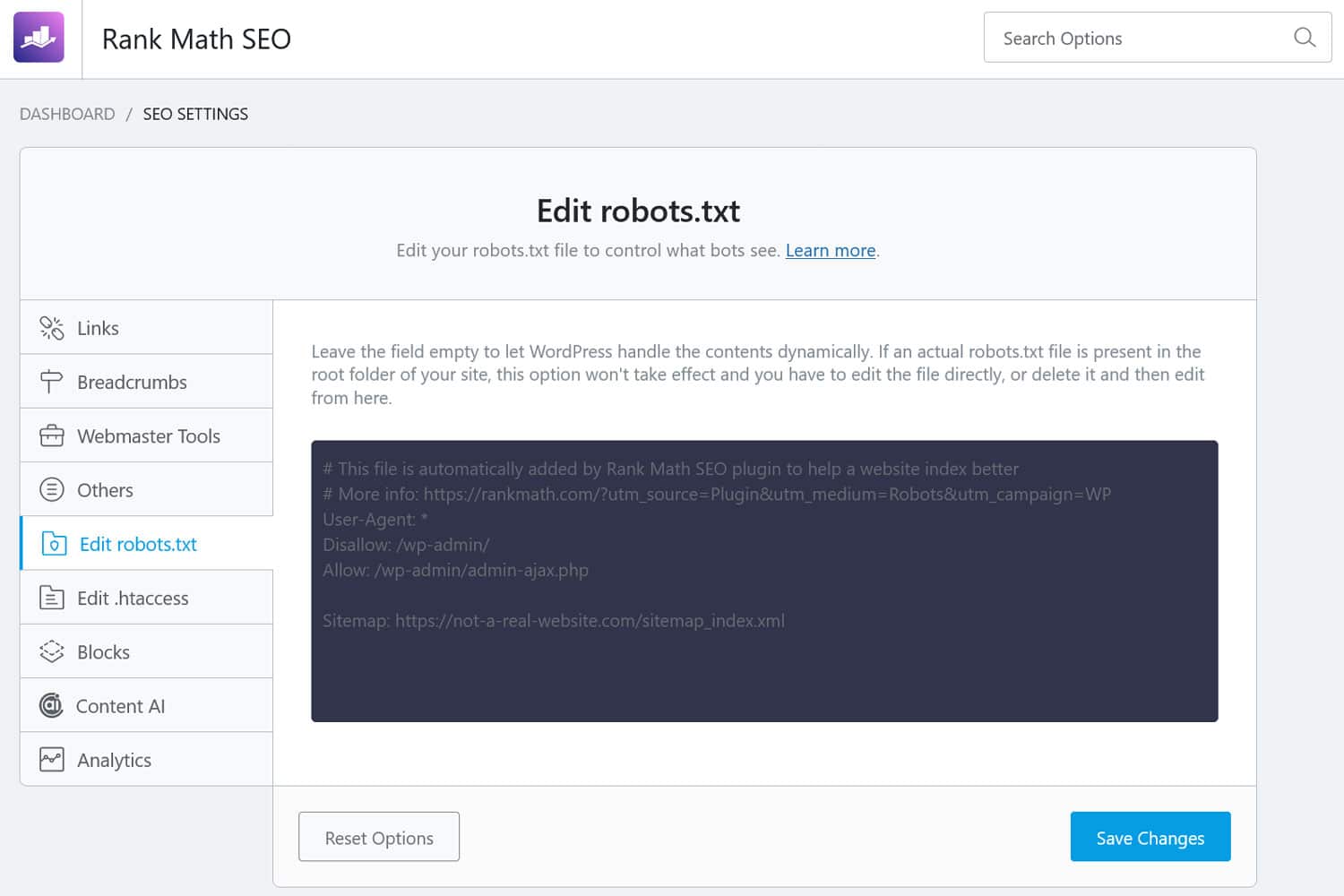

Selain itu, ada cara untuk mengakses file dari back end WordPress. Banyak plugin SEO yang memungkinkan Anda melihat dan sering mengubahnya dari antarmuka administrasi.

Alternatifnya, Anda juga bisa menggunakan plugin seperti WPCode.

Seperti Apa Tampilan File robots.txt WordPress yang Bagus?

Tidak ada jawaban universal mengenai arahan apa yang harus ada dalam file situs web Anda; itu tergantung pada pengaturan Anda. Berikut adalah contoh yang masuk akal untuk banyak situs WordPress:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php Sitemap: https://yourwebsite.com/sitemap.xmlContoh ini mencapai beberapa hasil:

- Ini memblokir akses ke area admin

- Mengizinkan akses ke fungsi admin penting

- Menyediakan lokasi peta situs

Penyiapan ini memberikan keseimbangan antara keamanan, kinerja SEO, dan perayapan yang efisien.

Jangan Lakukan 14 Kesalahan robots.txt WordPress Ini

Jika tujuan Anda adalah menyiapkan dan mengoptimalkan robots.txt untuk situs Anda sendiri, pastikan untuk menghindari kesalahan berikut.

1. Mengabaikan robots.txt internal WordPress

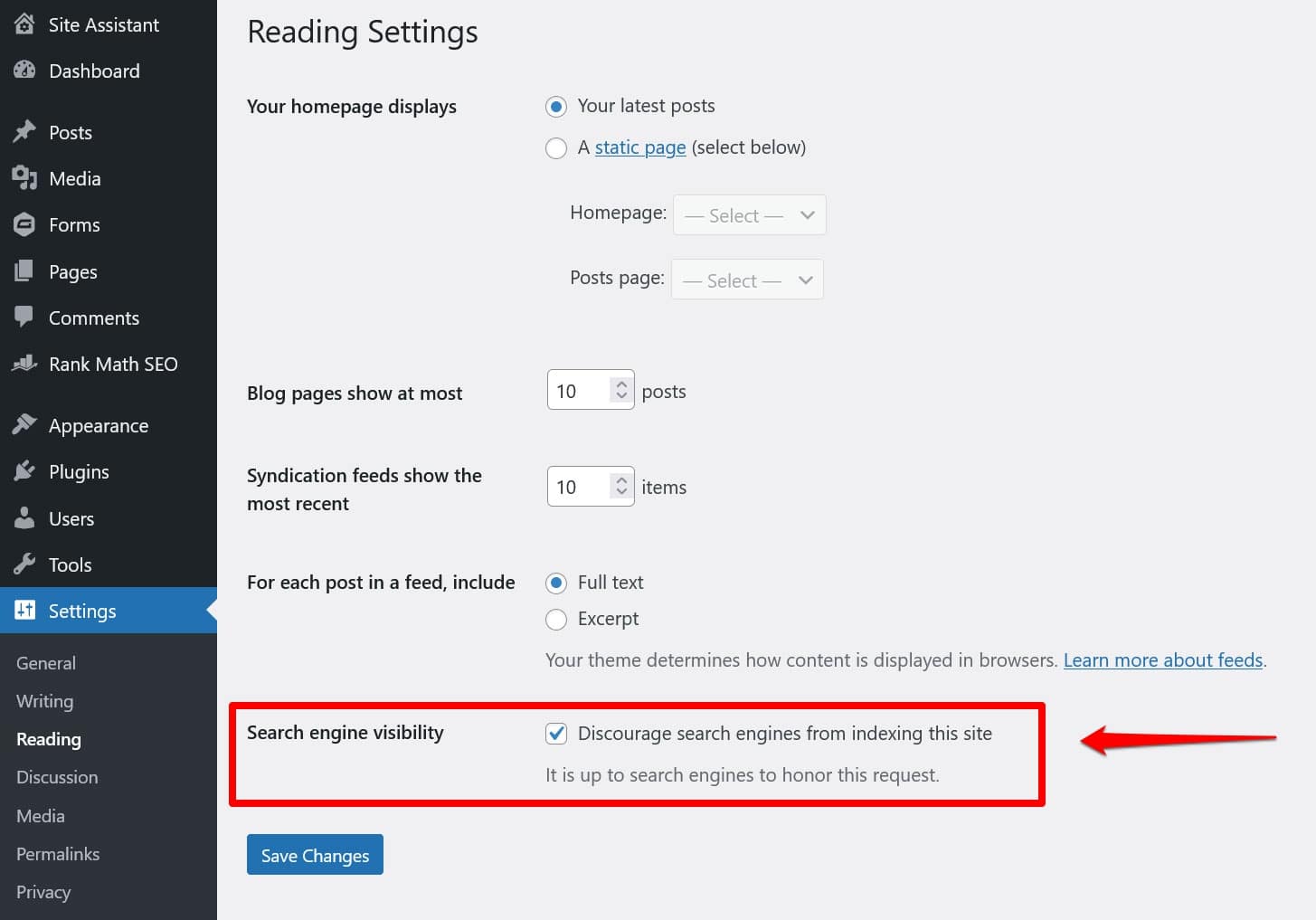

Meskipun Anda tidak memiliki file robots.txt “fisik” di direktori root situs Anda, WordPress hadir dengan file virtualnya sendiri. Hal ini sangat penting untuk diingat jika Anda menemukan bahwa mesin pencari tidak mengindeks situs web Anda.

Dalam hal ini, kemungkinan besar Anda telah mengaktifkan opsi untuk mencegah mereka melakukan hal tersebut di bawah Settings > Reading .

Hal ini memberikan arahan untuk mencegah semua crawler pencarian berada di robots.txt virtual. Untuk menonaktifkannya, hapus centang pada kotak dan simpan di bagian bawah.

2. Menempatkannya di Lokasi yang Salah

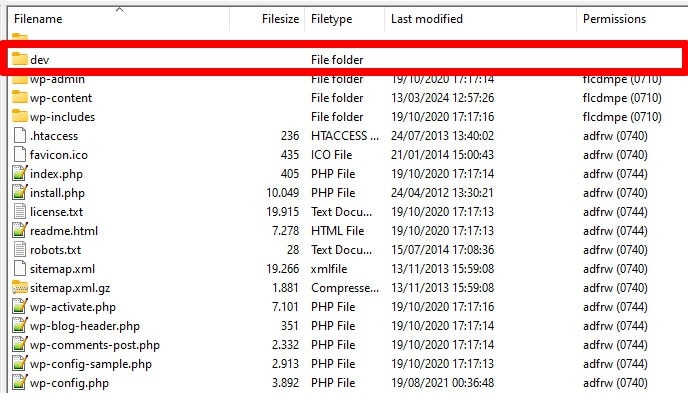

Bot, khususnya perayap penelusuran, mencari file robots.txt Anda hanya di satu lokasi—direktori akar situs web Anda. Jika Anda meletakkannya di tempat lain, misalnya di dalam folder, mereka tidak akan menemukannya dan akan mengabaikannya.

Direktori root Anda harus berada di tempat Anda mendarat ketika Anda mengakses server Anda melalui FTP, kecuali Anda telah menempatkan WordPress di subdirektori. Jika Anda melihat folder wp-admin , wp-content , dan wp-includes , Anda berada di tempat yang tepat.

3. Termasuk Markup yang Kedaluwarsa

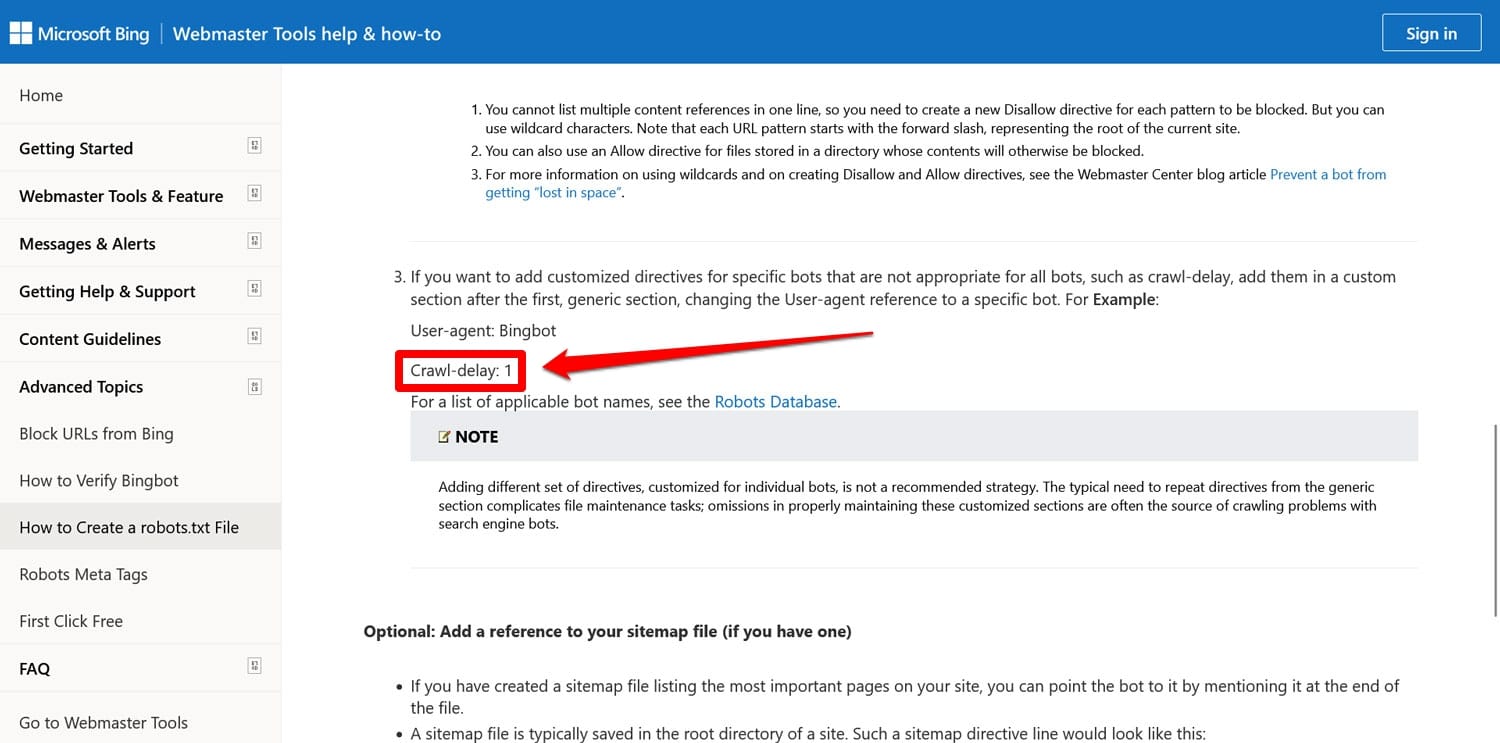

Selain arahan yang disebutkan di atas, ada dua arahan lagi yang mungkin masih Anda temukan di file robots.txt situs web lama:

- Noindex – Digunakan untuk menentukan URL yang tidak boleh diindeks oleh mesin pencari di situs Anda.

- Penundaan perayapan – Perintah yang dimaksudkan untuk membatasi perayap agar tidak membebani sumber daya server web secara berlebihan.

Kedua arahan ini kini diabaikan, setidaknya oleh Google. Bing, setidaknya, masih menerapkan penundaan perayapan.

Pada umumnya, yang terbaik adalah tidak menggunakan arahan ini. Ini membantu menjaga file Anda tetap ramping dan mengurangi risiko kesalahan.

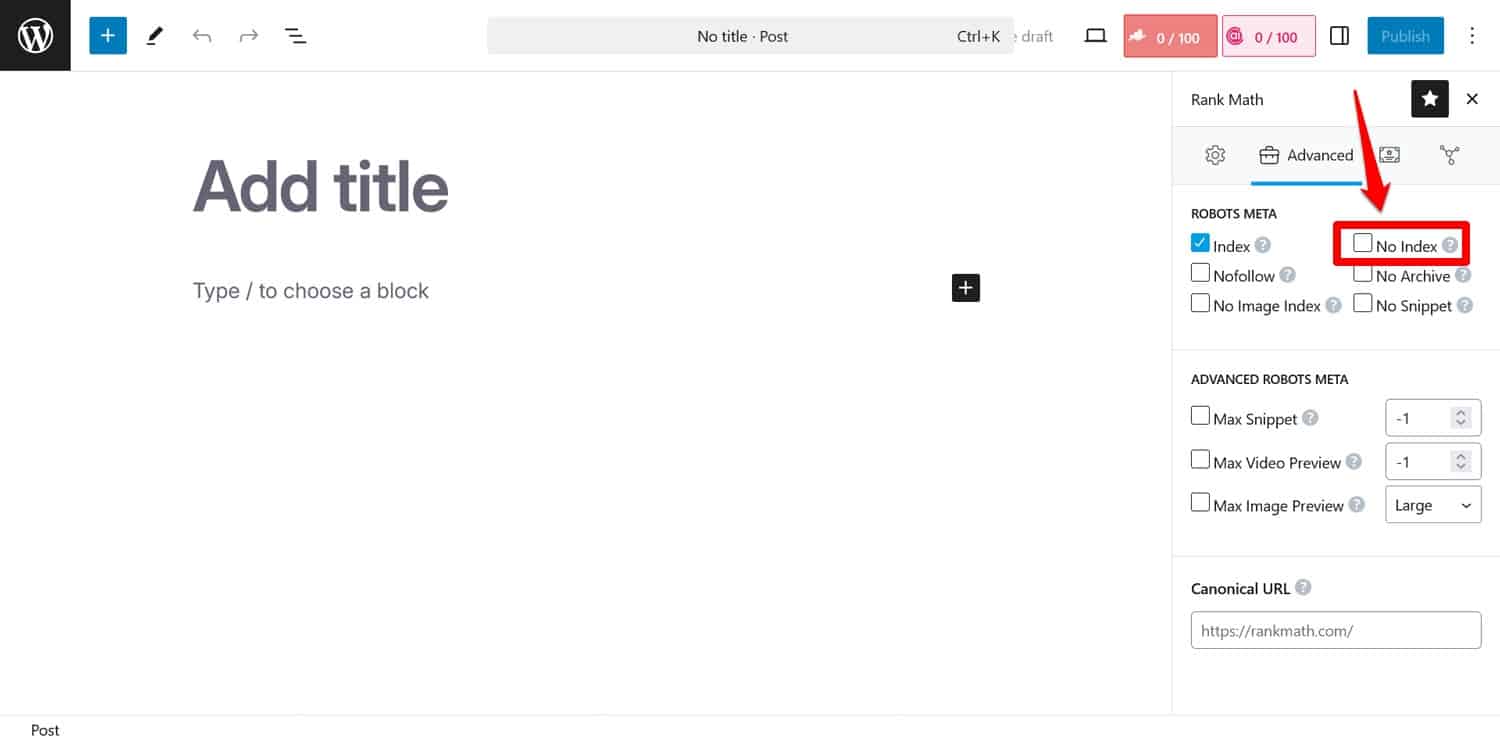

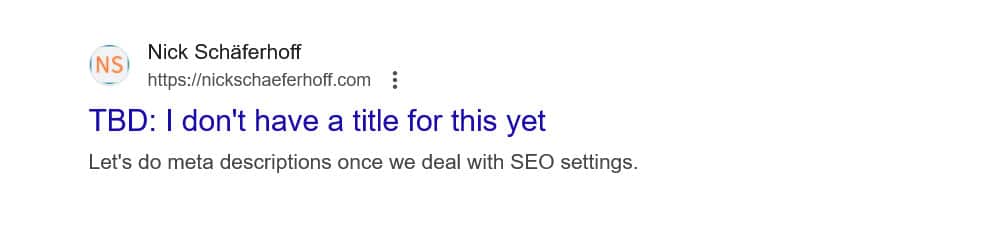

Tip: Jika tujuan Anda adalah mencegah mesin pencari mengindeks halaman tertentu, gunakan tag meta noindex sebagai gantinya. Anda dapat menerapkannya dengan plugin SEO per halaman.

Jika Anda memblokir halaman melalui robots.txt, crawler tidak akan sampai ke bagian di mana mereka melihat tag noindex . Dengan begitu, mereka mungkin masih mengindeks halaman Anda tetapi tanpa kontennya, dan ini lebih buruk lagi.

4. Memblokir Sumber Daya Penting

Salah satu kesalahan yang dilakukan orang adalah menggunakan robots.txt untuk memblokir akses ke semua style sheet (file CSS) dan skrip (file JavaScript) di situs WordPress mereka untuk menghemat anggaran perayapan.

Namun, itu bukanlah ide bagus. Bot mesin pencari merender halaman untuk “melihatnya” dengan cara yang sama seperti yang dilakukan pengunjung. Hal ini membantu mereka memahami konten sehingga mereka dapat mengindeksnya dengan tepat.

Dengan memblokir sumber daya ini, Anda dapat memberikan kesan yang salah pada mesin telusur terhadap laman Anda, sehingga berpotensi menyebabkan laman tersebut tidak diindeks dengan benar atau menurunkan peringkatnya.

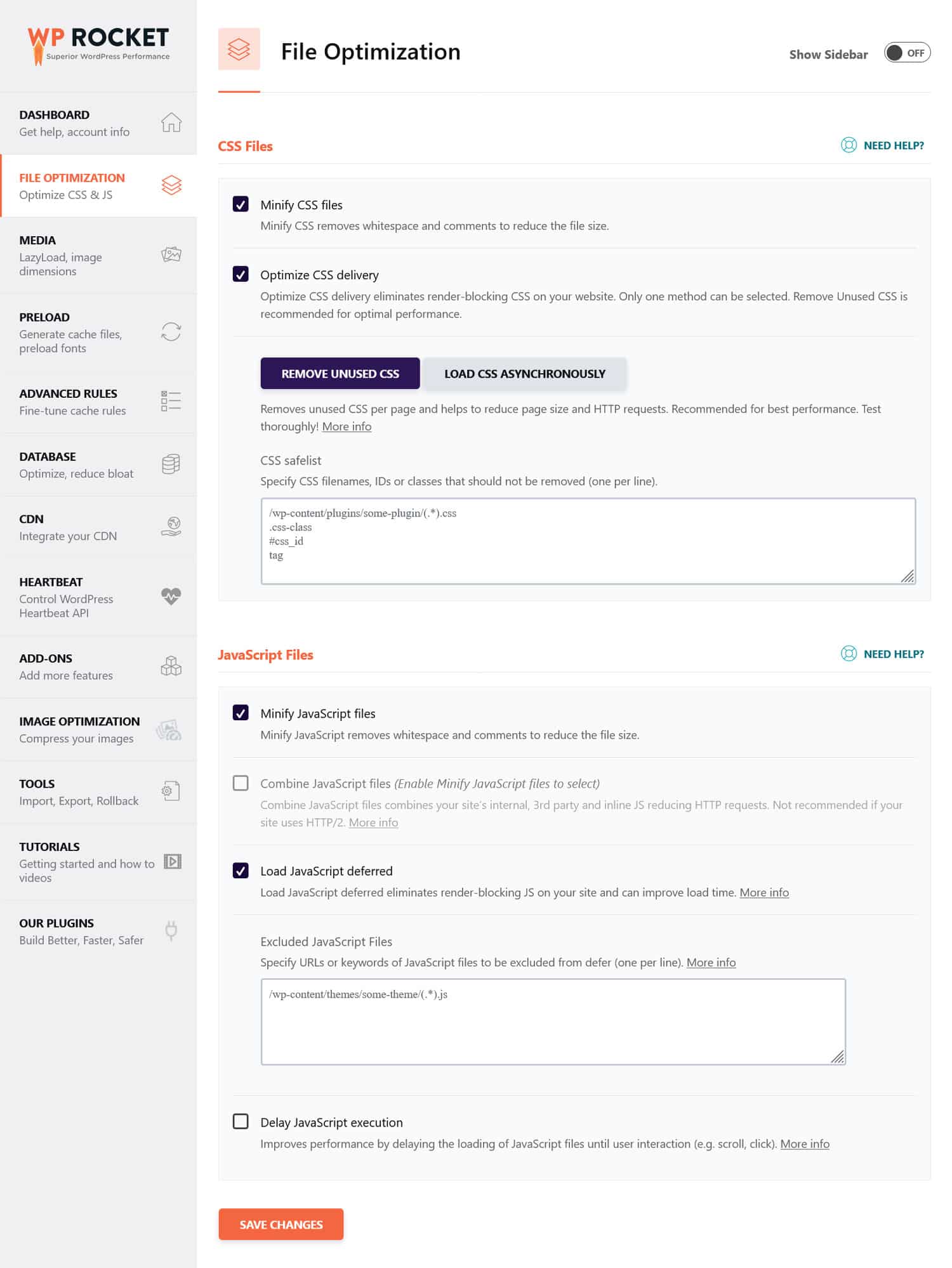

Jika menurut Anda file CSS dan JavaScript dapat menghambat kinerja situs Anda, sebaiknya optimalkan file tersebut agar dimuat dengan cepat, baik untuk bot maupun pengunjung biasa. Anda dapat melakukannya dengan memperkecil kode dan mengompresi file situs web sehingga pengirimannya lebih cepat. Selain itu, pengirimannya dapat dioptimalkan dengan menghilangkan kode yang tidak digunakan dan menunda sumber daya yang memblokir render.

Tip : Anda dapat menyederhanakan proses ini dengan menggunakan plugin kinerja seperti WP Rocket. Antarmukanya yang ramah pengguna memungkinkan Anda mengoptimalkan pengiriman file dengan mencentang beberapa kotak di menu Optimasi File .

WP Rocket juga hadir dengan fitur tambahan untuk meningkatkan kinerja website, antara lain:

- Caching, dengan cache seluler khusus

- Pemuatan lambat untuk gambar dan video

- Pramuat cache, tautan, file eksternal, dan font

- Optimalisasi basis data

Selain itu, plugin menerapkan banyak langkah pengoptimalan secara otomatis. Contohnya termasuk cache browser dan server, kompresi GZIP, dan pengoptimalan gambar paro atas untuk meningkatkan LCP. Dengan begitu, situs Anda akan menjadi lebih cepat hanya dengan mengaktifkan WP Rocket.

Plugin ini juga menawarkan jaminan uang kembali 14 hari, sehingga Anda dapat mengujinya tanpa risiko.

5. Gagal Memperbarui Perkembangan Anda robots.txt

Saat membangun situs web, pengembang biasanya menyertakan file robots.txt yang melarang semua bot mengaksesnya. Ini masuk akal; hal terakhir yang Anda inginkan adalah situs Anda yang belum selesai muncul di hasil pencarian.

Masalah hanya terjadi ketika Anda secara tidak sengaja mentransfer file ini ke server produksi Anda dan memblokir mesin pencari agar tidak mengindeks situs web langsung Anda juga. Periksa ini dengan pasti jika konten Anda menolak muncul di hasil pencarian.

6. Tidak Menyertakan Tautan ke Peta Situs Anda

Menautkan ke peta situs Anda dari robots.txt memberi perayap mesin telusur daftar semua konten Anda. Hal ini meningkatkan peluang Anda bahwa mereka akan mengindeks lebih dari sekedar halaman yang mereka buka saat ini.

Yang diperlukan hanyalah satu baris:

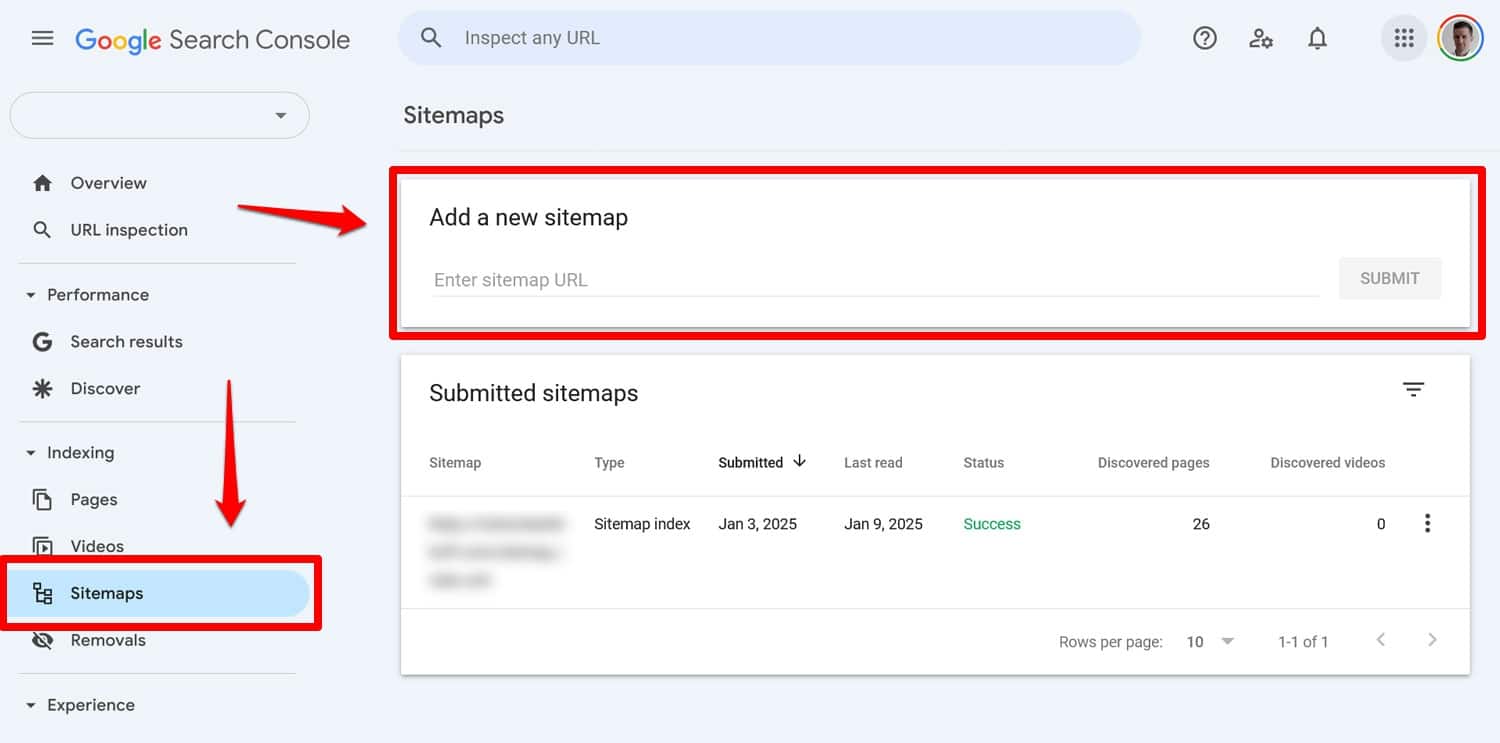

Sitemap: https://yourwebsite.com/sitemap.xmlYa, Anda juga dapat mengirimkan peta situs Anda langsung di alat seperti Google Search Console.

Namun, memasukkannya ke dalam file robots.txt Anda tetap berguna, terutama untuk mesin pencari yang alat webmasternya tidak Anda gunakan.

7. Menggunakan Aturan yang Bertentangan

Salah satu kesalahan umum dalam membuat file robots.txt adalah menambahkan aturan yang bertentangan satu sama lain, seperti:

User-agent: * Disallow: /blog/ Allow: /blog/Petunjuk di atas membuat mesin pencari tidak jelas apakah mereka harus meng-crawl direktori /blog/ atau tidak. Hal ini menyebabkan hasil yang tidak terduga dan dapat merusak SEO Anda.

| Penasaran apa lagi yang dapat merusak peringkat pencarian situs Anda dan bagaimana cara menghindarinya? Pelajari tentang hal itu di panduan kami tentang kesalahan SEO. |

Untuk menghindari konflik, ikuti praktik terbaik berikut:

- Gunakan aturan spesifik terlebih dahulu – Tempatkan aturan yang lebih spesifik sebelum aturan yang lebih luas.

- Hindari redundansi – Jangan sertakan arahan yang berlawanan untuk jalur yang sama.

- Uji file robots.txt Anda – Gunakan alat untuk mengonfirmasi bahwa aturan berfungsi seperti yang diharapkan. Lebih lanjut tentang itu di bawah.

8. Mencoba Menyembunyikan Konten Sensitif Dengan robots.txt

Seperti disebutkan sebelumnya, robots.txt bukanlah alat untuk mencegah konten masuk ke hasil pencarian. Faktanya, karena file tersebut dapat diakses publik, menggunakannya untuk memblokir konten sensitif mungkin secara tidak sengaja mengungkapkan di mana tepatnya konten tersebut berada.

Tip : Gunakan tag meta noindex untuk menjauhkan konten dari hasil pencarian. Selain itu, lindungi area sensitif situs Anda dengan kata sandi agar tetap aman dari robot dan pengguna tidak sah.

9. Penggunaan Wildcard yang Tidak Benar

Wildcard memungkinkan Anda untuk memasukkan kelompok besar jalur atau file dalam arahan Anda. Kita sudah pernah bertemu sebelumnya, simbol *. Artinya “setiap kejadian” dan paling sering digunakan untuk menetapkan aturan yang berlaku untuk semua agen pengguna.

Simbol wildcard lainnya adalah $, yang menerapkan aturan pada bagian akhir URL. Anda dapat menggunakannya, misalnya, jika Anda ingin memblokir crawler agar tidak mengakses semua file PDF di situs Anda:

Disallow: /*.pdf$Meskipun wildcard berguna, namun dapat mempunyai konsekuensi yang luas. Gunakan dengan hati-hati, dan selalu uji file robots.txt Anda untuk memastikan Anda tidak melakukan kesalahan.

10. URL Absolut dan Relatif yang Membingungkan

Berikut perbedaan antara URL absolut dan relatif:

- URL Absolut – https://yourwebsite.com/private/

- URL Relatif – /pribadi/

Sebaiknya Anda menggunakan URL relatif dalam perintah robots.txt Anda, misalnya:

Disallow: /private/URL absolut dapat menyebabkan masalah di mana bot dapat mengabaikan atau salah menafsirkan perintah tersebut. Satu-satunya pengecualian adalah jalur ke peta situs Anda, yang harus berupa URL absolut.

11. Mengabaikan Sensitivitas Huruf Besar

Perintah Robots.txt peka huruf besar-kecil. Ini berarti dua arahan berikut tidak dapat dipertukarkan:

Disallow: /Private/ Disallow: /private/Jika ternyata file robots.txt Anda tidak berfungsi seperti yang diharapkan, periksa apakah kesalahan penggunaan huruf besar dapat menjadi penyebabnya.

12. Penggunaan Trailing Slash yang Salah

Garis miring adalah garis miring di akhir URL:

- Tanpa garis miring : /directory

- Dengan garis miring : /directory/

Di robots.txt, ia memutuskan sumber daya situs mana yang diizinkan dan tidak diizinkan. Berikut ini contohnya:

Disallow: /private/Aturan di atas memblokir perayap mengakses direktori “pribadi” di situs Anda dan semua isinya. Di sisi lain, katakanlah Anda tidak menyertakan garis miring, seperti:

Disallow: /privateDalam hal ini, aturan tersebut juga akan memblokir kejadian lain yang dimulai dengan “pribadi” di situs Anda, seperti:

- https://situswebanda.com/private.html

- https://situswebanda.com/privateer

Oleh karena itu, penting untuk bersikap tepat. Jika ragu, uji file Anda.

13. Robots.txt untuk Subdomain tidak ada

Setiap subdomain di situs web Anda (misalnya, dev.yourwebsite.com) memerlukan file robots.txt sendiri karena mesin telusur memperlakukannya sebagai entitas web terpisah. Tanpa file, Anda berisiko perayap mengindeks bagian situs yang ingin Anda sembunyikan.

Misalnya, jika versi pengembangan Anda ada di folder bernama “dev” dan menggunakan subdomain, pastikan versi tersebut memiliki file robots.txt khusus untuk memblokir crawler penelusuran.

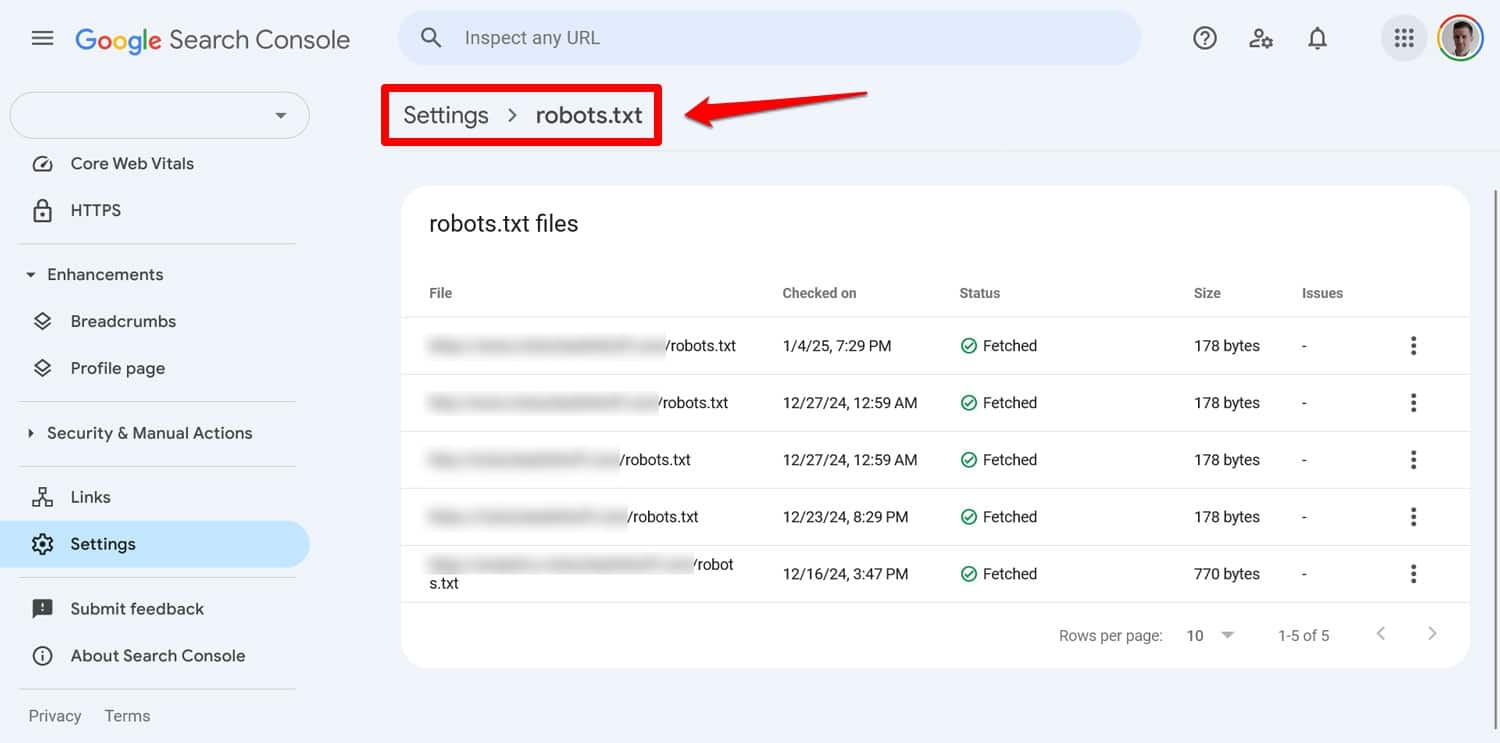

14. Tidak Menguji File robots.txt Anda

Salah satu kesalahan terbesar saat mengonfigurasi file robots.txt WordPress Anda adalah gagal mengujinya, terutama setelah melakukan perubahan.

Seperti yang telah kita lihat, kesalahan kecil sekalipun dalam sintaksis atau logika dapat menyebabkan masalah SEO yang signifikan. Oleh karena itu, selalu uji file robots.txt Anda.

Anda dapat melihat masalah apa pun pada file Anda di Google Search Console pada Setelan > robots.txt .

Cara lain adalah dengan mensimulasikan perilaku perayapan dengan alat seperti Screaming Frog. Selain itu, gunakan lingkungan pementasan untuk memverifikasi dampak aturan baru sebelum menerapkannya ke situs Anda yang sebenarnya.

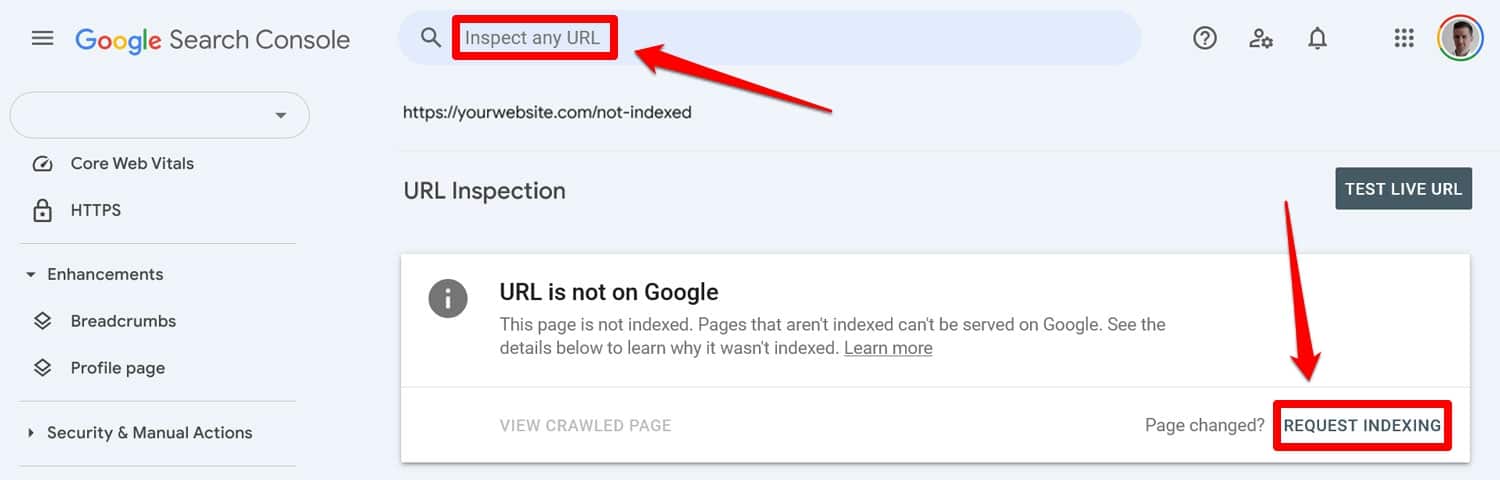

Cara Memulihkan Dari Kesalahan robots.txt

Kesalahan dalam file robots.txt mudah dilakukan, namun untungnya, kesalahan tersebut biasanya juga mudah diperbaiki setelah Anda menemukannya.

Mulailah dengan menjalankan file robots.txt yang telah diperbarui melalui alat pengujian. Kemudian, jika halaman sebelumnya diblokir oleh perintah robots.txt, masukkan halaman tersebut secara manual ke Google Search Console atau Alat Webmaster Bing untuk meminta pengindeksan.

Selain itu, kirimkan ulang versi peta situs Anda yang terbaru.

Setelah itu, tinggal menunggu permainan. Mesin pencari akan mengunjungi kembali situs Anda dan, mudah-mudahan, mengembalikan peringkat Anda dengan cepat.

Kendalikan robots.txt WordPress Anda

Dengan file robots.txt, satu ons pencegahan lebih baik daripada satu pon pengobatan. Khususnya di situs web yang lebih besar, file yang salah dapat merusak peringkat, lalu lintas, dan pendapatan.

Oleh karena itu, setiap perubahan pada robots.txt situs Anda harus dilakukan dengan hati-hati dan melalui pengujian ekstensif. Menyadari kesalahan yang mungkin Anda lakukan adalah langkah awal untuk mencegahnya.

Ketika Anda melakukan kesalahan, cobalah untuk tidak panik. Diagnosis apa yang salah, perbaiki kesalahan apa pun, dan kirim ulang peta situs Anda agar situs Anda dirayapi ulang.

Terakhir, pastikan kinerja bukan alasan mesin telusur tidak meng-crawl situs Anda dengan benar. Coba WP Rocket sekarang untuk membuat situs Anda lebih cepat secara instan!