File robots.txt WordPress… Apa itu dan Apa Fungsinya

Diterbitkan: 2020-11-25Pernahkah Anda bertanya-tanya apa itu file robots.txt dan apa fungsinya? Robots.txt digunakan untuk berkomunikasi dengan perayap web (dikenal sebagai bot) yang digunakan oleh Google dan mesin telusur lainnya. Ini memberi tahu mereka bagian mana dari situs web Anda untuk diindeks dan mana yang harus diabaikan. Dengan demikian, file robots.txt dapat membantu (atau berpotensi merusak!) upaya SEO Anda. Jika Anda ingin situs web Anda mendapat peringkat yang baik, maka pemahaman yang baik tentang robots.txt sangat penting!

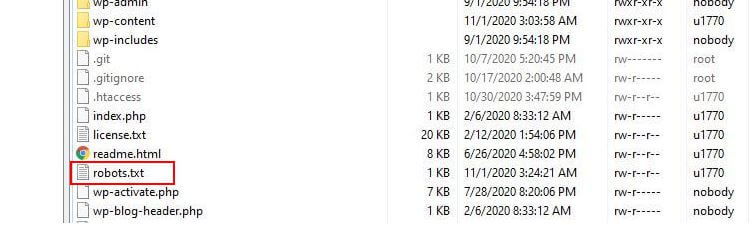

Di manakah lokasi Robots.txt?

WordPress biasanya menjalankan apa yang disebut file robots.txt 'virtual' yang artinya tidak dapat diakses melalui SFTP. Namun Anda dapat melihat konten dasarnya dengan membuka domainanda.com/robots.txt. Anda mungkin akan melihat sesuatu seperti ini:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.phpBaris pertama menentukan di bot mana aturan akan diterapkan. Dalam contoh kami, tanda bintang berarti bahwa aturan akan diterapkan ke semua bot (mis. yang dari Google, Bing, dan sebagainya).

Baris kedua mendefinisikan aturan yang mencegah akses bot ke folder /wp-admin dan baris ketiga menyatakan bahwa bot diizinkan untuk mengurai file /wp-admin/admin-ajax.php.

Tambahkan Aturan Anda Sendiri

Untuk situs WordPress sederhana, aturan default yang diterapkan WordPress ke file robots.txt mungkin lebih dari cukup. Namun jika Anda ingin lebih banyak kontrol dan kemampuan untuk menambahkan aturan Anda sendiri untuk memberikan instruksi yang lebih spesifik kepada bot mesin pencari tentang cara mengindeks situs web Anda, maka Anda perlu membuat file robots.txt fisik Anda sendiri dan meletakkannya di bawah root direktori instalasi Anda.

Ada beberapa alasan yang mungkin ingin mengonfigurasi ulang file robots.txt Anda dan menentukan apa sebenarnya bot yang diizinkan untuk dirayapi. Salah satu alasan utama adalah berkaitan dengan waktu yang dihabiskan oleh bot untuk merayapi situs Anda. Google (dan lainnya) tidak mengizinkan bot menghabiskan waktu tanpa batas di setiap situs web… dengan triliunan halaman, mereka harus mengambil pendekatan yang lebih bernuansa terhadap apa yang akan dirayapi bot mereka dan apa yang akan mereka abaikan dalam upaya mengekstrak informasi yang paling berguna tentang sebuah situs web.

Ketika Anda mengizinkan bot untuk merayapi semua halaman di situs web Anda, sebagian dari waktu perayapan dihabiskan untuk halaman yang tidak penting atau bahkan tidak relevan. Ini membuat mereka memiliki lebih sedikit waktu untuk mengerjakan area yang lebih relevan di situs Anda. Dengan melarang akses bot ke beberapa bagian situs web Anda, Anda meningkatkan waktu yang tersedia bagi bot untuk mengekstrak informasi dari bagian situs Anda yang paling relevan (yang diharapkan akan berakhir diindeks). Karena perayapan lebih cepat, Google lebih cenderung mengunjungi kembali situs web Anda dan menjaga indeks situs Anda tetap mutakhir. Ini berarti posting blog baru dan konten segar lainnya kemungkinan akan diindeks lebih cepat yang merupakan kabar baik.

Contoh Mengedit Robots.txt

Robots.txt menawarkan banyak ruang untuk penyesuaian. Karena itu, kami telah menyediakan serangkaian contoh aturan yang dapat digunakan untuk menentukan cara bot mengindeks situs Anda.

Mengizinkan atau Melarang Bot

Pertama, mari kita lihat bagaimana kita bisa membatasi bot tertentu. Untuk melakukan ini yang perlu kita lakukan adalah mengganti tanda asterisk (*) dengan nama bot user-agent yang ingin kita blokir, misalnya 'MSNBot'. Daftar lengkap agen pengguna yang dikenal tersedia di sini.

User-agent: MSNBot Disallow: /Menempatkan tanda hubung di baris kedua akan membatasi akses bot ke semua direktori.

Untuk mengizinkan hanya satu bot yang merayapi situs kami, kami akan menggunakan proses 2 langkah. Pertama, kami menetapkan bot yang satu ini sebagai pengecualian dan kemudian melarang semua bot seperti ini:

User-agent: Google Disallow: User-agent: * Disallow: /Untuk mengizinkan akses ke semua bot di semua konten, kami menambahkan dua baris ini:

User-agent: * Disallow:Efek yang sama akan dicapai hanya dengan membuat file robots.txt dan kemudian membiarkannya kosong.

Memblokir Akses ke File Tertentu

Ingin menghentikan bot yang mengindeks file tertentu di situs web Anda? Itu mudah! Pada contoh di bawah ini kami telah mencegah mesin pencari mengakses semua file .pdf di situs web kami.

User-agent: * Disallow: /*.pdf$Simbol “$” digunakan untuk menentukan akhir URL. Karena ini peka huruf besar/kecil, file dengan nama my.PDF akan tetap dirayapi (perhatikan CAPS).

Ekspresi Logika Kompleks

Beberapa mesin pencari, seperti Google, memahami penggunaan ekspresi reguler yang lebih rumit. Namun penting untuk dicatat bahwa tidak semua mesin telusur mungkin dapat memahami ekspresi logis di robots.txt.

Salah satu contohnya adalah menggunakan simbol $. Dalam file robots.txt simbol ini menunjukkan akhir dari sebuah url. Jadi, dalam contoh berikut kami telah memblokir bot pencarian dari membaca dan mengindeks file yang diakhiri dengan .php

Disallow: /*.php$Ini berarti /index.php tidak dapat diindeks, tetapi /index.php?p=1 bisa. Ini hanya berguna dalam keadaan yang sangat spesifik dan perlu digunakan dengan hati-hati atau Anda berisiko memblokir akses bot ke file yang tidak Anda maksudkan!

Anda juga dapat menetapkan aturan yang berbeda untuk setiap bot dengan menentukan aturan yang berlaku untuk mereka satu per satu. Contoh kode di bawah ini akan membatasi akses ke folder wp-admin untuk semua bot sementara pada saat yang sama memblokir akses ke seluruh situs untuk mesin pencari Bing. Anda tidak perlu melakukan ini, tetapi ini adalah demonstrasi yang berguna tentang betapa fleksibelnya aturan dalam file robots.txt.

User-agent: * Disallow: /wp-admin/ User-agent: Bingbot Disallow: /Peta Situs XML

Peta situs XML sangat membantu bot pencarian memahami tata letak situs web Anda. Namun agar berguna, bot perlu mengetahui di mana letak peta situs. 'Petunjuk peta situs' digunakan untuk secara khusus memberi tahu mesin telusur bahwa a) peta situs situs Anda ada dan b) di mana mereka dapat menemukannya.

Sitemap: http://www.example.com/sitemap.xml User-agent: * Disallow:Anda juga dapat menentukan beberapa lokasi peta situs:

Sitemap: http://www.example.com/sitemap_1.xml Sitemap: http://www.example.com/sitemap_2.xml User-agent:* DisallowPenundaan Perayapan Bot

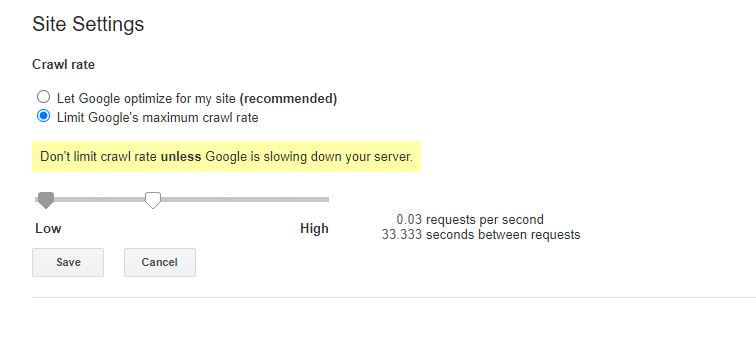

Fungsi lain yang dapat dicapai melalui file robots.txt adalah memberi tahu bot untuk 'memperlambat' perayapan situs Anda. Ini mungkin diperlukan jika Anda menemukan bahwa server Anda kelebihan beban oleh tingkat lalu lintas bot yang tinggi. Untuk melakukan ini, Anda akan menentukan agen pengguna yang ingin Anda perlambat dan kemudian menambahkan penundaan.

User-agent: BingBot Disallow: /wp-admin/ Crawl-delay: 10Kutipan angka (10) dalam contoh ini adalah penundaan yang Anda inginkan terjadi antara perayapan halaman individual di situs Anda. Jadi, dalam contoh di atas kami telah meminta Bot Bing untuk berhenti selama sepuluh detik di antara setiap halaman yang dirayapinya dan dengan demikian memberi server kami sedikit ruang untuk bernafas.

Satu-satunya berita yang sedikit buruk tentang aturan robots.txt khusus ini adalah bahwa bot Google tidak menghormatinya. Namun Anda dapat menginstruksikan bot mereka untuk memperlambat dari dalam Google Search Console.

Catatan tentang aturan robots.txt:

- Semua aturan robots.txt peka huruf besar/kecil. Ketik dengan hati-hati!

- Pastikan tidak ada spasi sebelum perintah di awal baris.

- Perubahan yang dibuat di robots.txt dapat memakan waktu 24-36 jam untuk dicatat oleh bot.

Cara Menguji dan Mengirim File robots.txt WordPress Anda

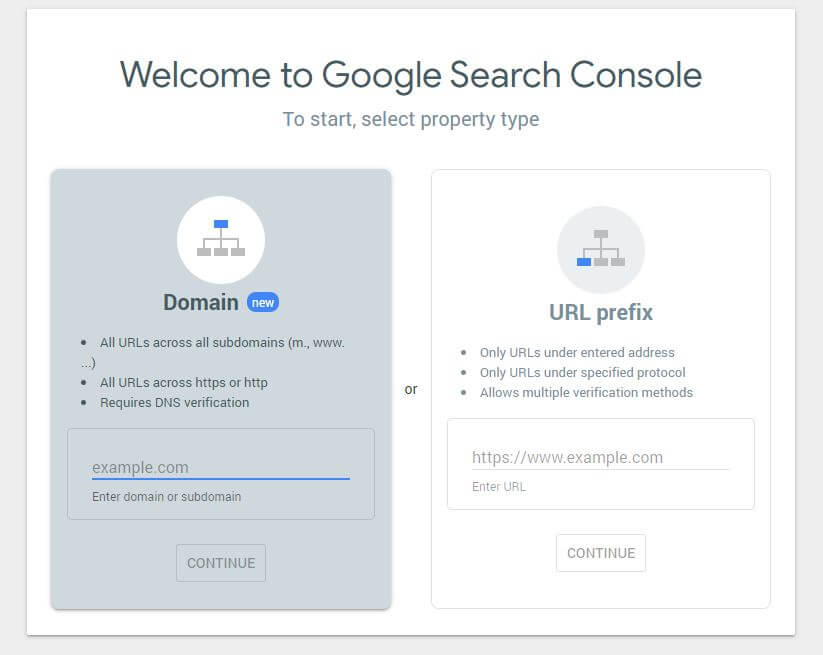

Ketika Anda telah membuat file robots.txt baru, ada baiknya memeriksa apakah tidak ada kesalahan di dalamnya. Anda dapat melakukannya dengan menggunakan Google Search Console.

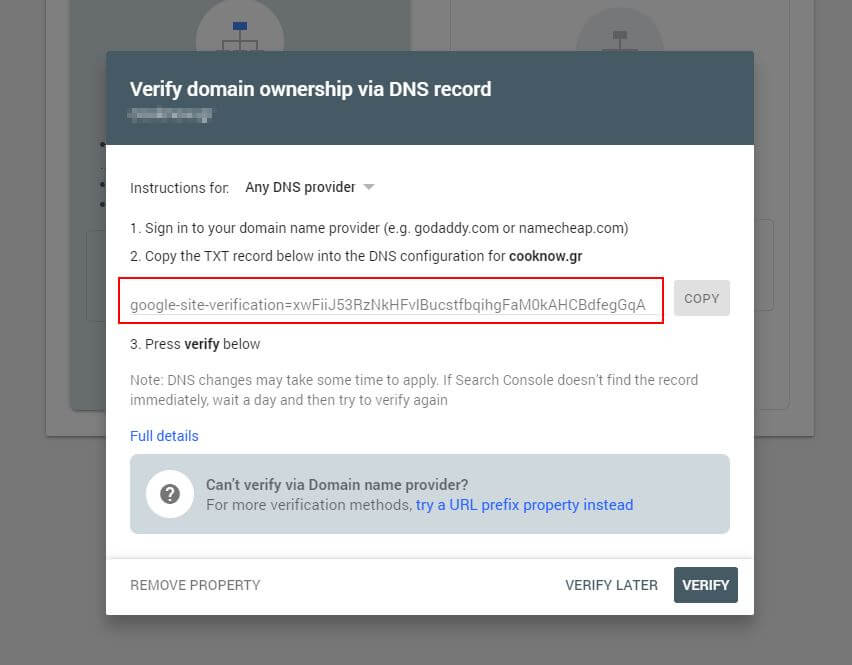

Pertama, Anda harus mengirimkan domain Anda (jika Anda belum memiliki akun Search Console untuk penyiapan situs web Anda). Google akan memberi Anda data TXT yang perlu ditambahkan ke DNS Anda untuk memverifikasi domain Anda.

Setelah pembaruan DNS ini disebarkan (merasa tidak sabar… coba gunakan Cloudflare untuk mengelola DNS Anda), Anda dapat mengunjungi penguji robots.txt dan memeriksa apakah ada peringatan tentang konten file robots.txt Anda.

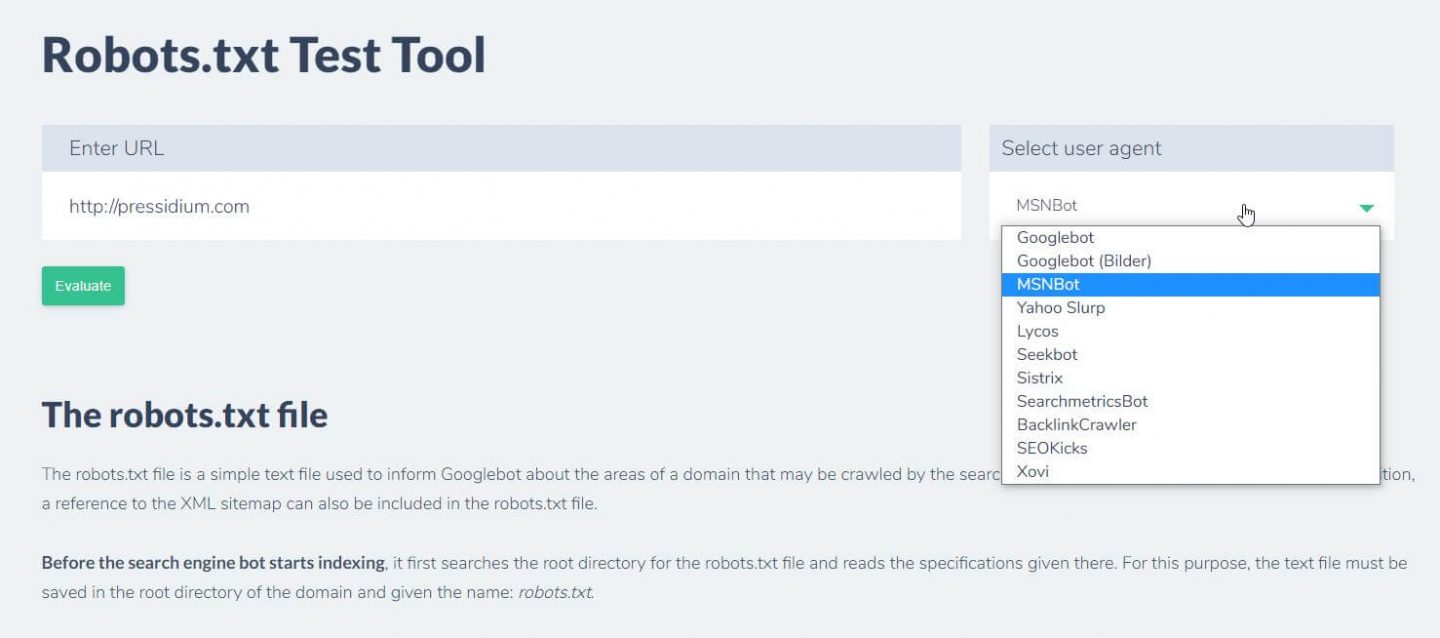

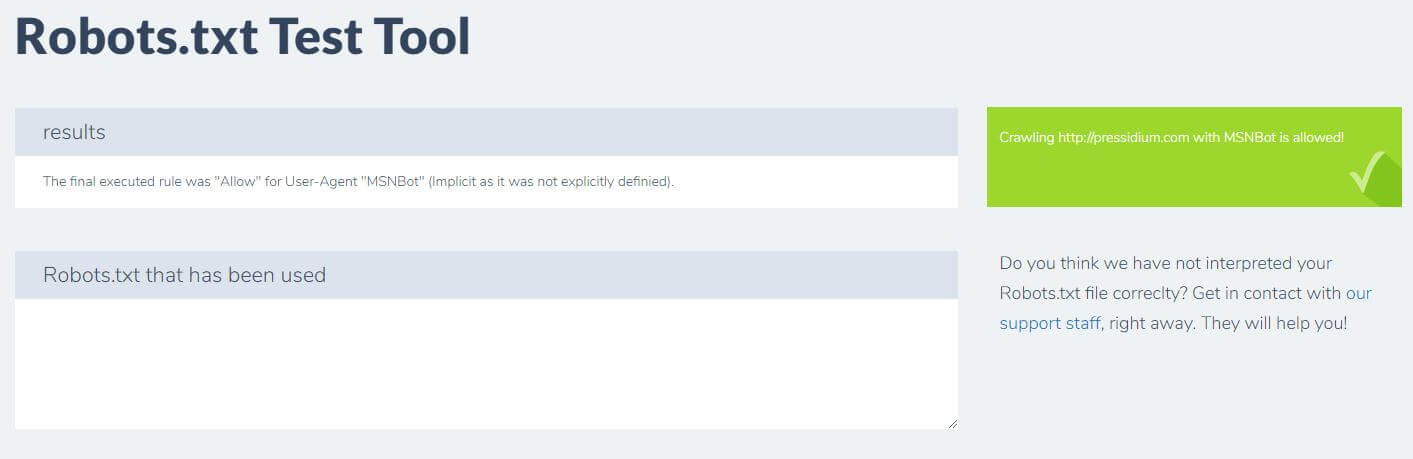

Hal lain yang dapat Anda lakukan untuk menguji aturan yang Anda miliki memiliki efek yang diinginkan adalah dengan menggunakan alat uji robots.txt seperti Ryte.

Anda cukup memasukkan domain Anda dan memilih agen pengguna dari panel di sebelah kanan. Setelah mengirimkan ini, Anda akan melihat hasilnya.

Kesimpulan

Mengetahui cara menggunakan robots.txt adalah alat lain yang berguna dalam perangkat Pengembang Anda. Jika satu-satunya hal yang Anda ambil dari tutorial ini adalah kemampuan untuk memeriksa apakah file robots.txt Anda tidak memblokir bot seperti Google (yang kemungkinan besar tidak akan Anda lakukan) maka itu bukan hal yang buruk! Sama halnya, seperti yang Anda lihat, robots.txt menawarkan sejumlah besar kendali lebih lanjut atas situs web Anda yang mungkin suatu hari nanti berguna.