Qual è la differenza tra ASCII e Unicode?

Pubblicato: 2022-04-10ASCII e Unicode sono gli standard di codifica dei caratteri più conosciuti attualmente utilizzati in tutto il mondo. Entrambi i programmi sono estremamente importanti nelle comunicazioni moderne. Quando si utilizza un dispositivo di comunicazione elettronica, i dati passano attraverso l'unità di elaborazione centrale che migliora le prestazioni del sistema utilizzando la memoria principale e cache. Le periferiche utilizzano le interfacce per comunicare tra il sistema e un dispositivo connesso. Entrambi i caratteri degli standard di codifica possono essere rappresentati in binario. I personaggi sono in genere raggruppati in un set di caratteri. Un set di caratteri include:

- dati alfanumerici (lettere e numeri)

- simboli (*, &, : ecc.)

- caratteri di controllo (Backspace, scheda Orizzontale, Escape, ecc.

Un set di caratteri è una selezione di caratteri, mentre una codifica di caratteri è un grafico in cui un set di caratteri e un valore sono rappresentati digitalmente (es: A=1, B=2). Lo standard ASCII è essenzialmente entrambi: definisce gli insiemi di caratteri che rappresenta e un metodo per assegnare a ciascun carattere un valore numerico. La parola Unicode, d'altra parte, è usata in diversi contesti per indicare cose diverse. Pensalo come un termine onnicomprensivo per riferirsi a un set di caratteri e codifiche numeriche. Tuttavia, poiché esistono numerose codifiche, il termine Unicode viene in genere utilizzato per fare riferimento all'insieme generale di caratteri, piuttosto che al modo in cui sono tracciati.

Funzionalità di ASCII e Unicode

ASCII

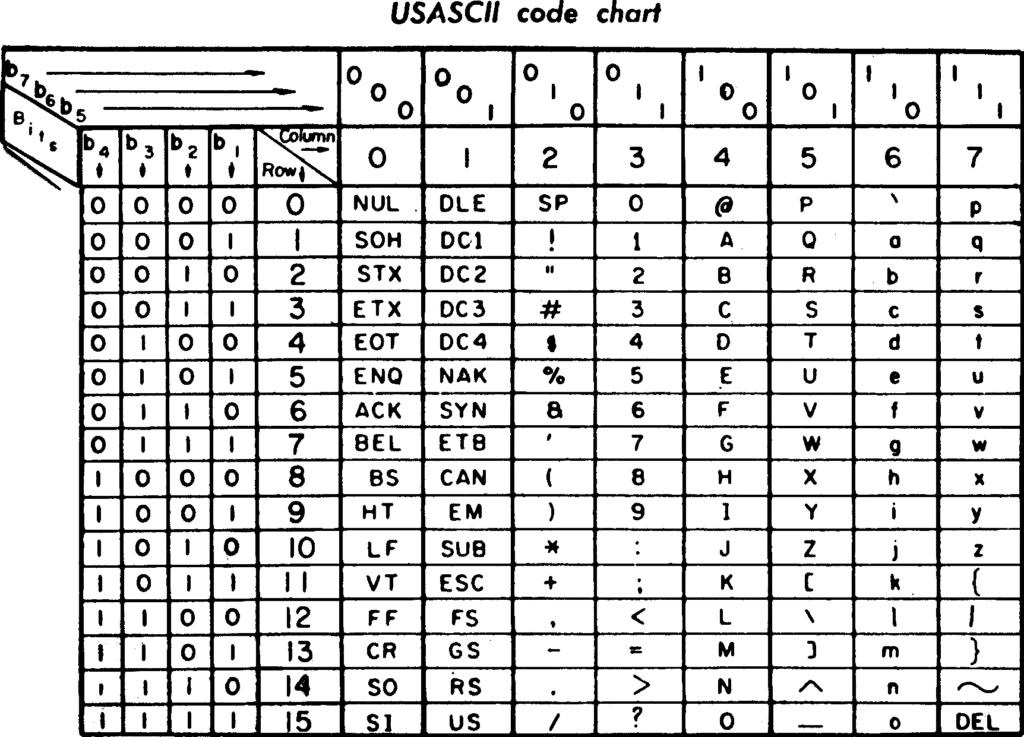

ASCII (American Standard Code for Information Interchange) è stato lanciato per la prima volta nel 1963. Dispone di 128 caratteri codificati, principalmente in lingua inglese utilizzati nei moderni computer di programmazione. Poiché non è stato aggiornato dall'inizio, ASCII occupa meno spazio. Utilizza 7 bit di dati per codificare qualsiasi carattere, è stato utilizzato principalmente per la codifica dei caratteri sul World Wide Web ed è ancora ampiamente utilizzato per i moderni programmi per computer come HTML.

Codifica il testo convertendolo in numeri perché i numeri sono più facili da memorizzare nella memoria del computer rispetto all'alfabeto. Esiste anche una versione alternativa nota come ASCII esteso. Con questa tecnica, è possibile utilizzare il bit più significativo di un byte a 8 bit per consentire a ASCII di presentare 256 caratteri. I programmatori utilizzano il set di caratteri di progettazione per semplificare determinate attività. Ad esempio, utilizzando i codici di caratteri ASCII, la modifica di un singolo bit converte facilmente il testo da maiuscolo a minuscolo. Utilizza anche alcuni caratteri di controllo non stampabili che inizialmente erano destinati all'uso con i terminali di stampa della telescrivente.

Unicode

Il processo Unicode (Universal Character Set), memorizza e facilita lo scambio di dati di testo in qualsiasi lingua è considerato lo standard IT utilizzato per la codifica. Unicode rappresenta e gestisce il testo per computer, smartphone e altre apparecchiature tecnologiche. Codifica una varietà di caratteri, inclusa un'ampia gamma di testo in numerose lingue, inclusi arabo, ebraico e greco, scritture storiche, simboli matematici, ecc. Unicode supporta anche un numero considerevole di caratteri e occupa più spazio in un dispositivo, quindi la programmazione ASCII fa parte di Unicode. Unicode utilizza 16 bit per rappresentare i caratteri usati più frequentemente in una moltitudine di lingue. Gli sviluppatori in genere scambiano i dati utilizzando un set di codici flat senza complesse conversioni di codice per leggere i caratteri.

Il supporto per Unicode offre molti vantaggi, tra cui:

- Sorgente globale e binario.

- Supporto per ambienti di elaborazione a script misti.

- Migliorata l'interoperabilità dei dati multipiattaforma attraverso un set di codici comune.

Facilità d'uso

ASCII

- Accettato universalmente

- Poiché ASCII utilizza un set di caratteri di base per le comunicazioni di base, gli sviluppatori possono progettare interfacce che sia i computer che le persone possono comprendere. ASCII codifica una serie di dati come i caratteri ASCII che possono essere spiegati e presentati come dati per computer o testo leggibile pianificato per le persone. Il set di caratteri ASCII può aiutare a semplificare alcune attività per i programmatori.

- Codifica caratteri compatta

- I codici standard possono essere espressi in 7 bit, il che significa che i dati possono essere espressi nel set di caratteri ASCII standard. Ciò richiede solo tanti byte da inviare o archiviare quanti sono i numeri nei dati.

- Efficiente per la programmazione

- I codici di caratteri ASCII si adattano bene alle tecniche di programmazione per alterare il testo e utilizzare i numeri per i calcoli o l'archiviazione come dati grezzi.

Unicode

- Processo di candidatura semplificato

- Tutti i simboli sono richiesti dall'applicazione per scrivere e leggere i dati dei caratteri all'interno di una singola tabella codici. Questo semplifica enormemente lo sviluppo delle applicazioni.

- Facile trasferimento del codice esistente

- Poiché nelle prime 127 posizioni sono presenti caratteri ASCII tradizionali, il programma assegna ciascuno di questi caratteri al valore ASCII originale.

- Compatibilità web

- Poiché Unicode sta rapidamente diventando la codepage universale del Web, tutti gli attuali standard Web si basano su di esso.

- Applicazioni multilingue

- Le applicazioni che utilizzano Unicode possono supportare una moltitudine di lingue sia nei dati che nell'interfaccia utente.

- Interoperabilità

- I client Java e Active-X sono entrambi basati su Unicode, quindi possono comunicare con AppServer e database UTF-8.

Azienda dietro il prodotto e supporto

ASCII

Nell'aprile del 2008, MediaWorks, Inc. è stata legalmente assorbita da ASCII Corporation e ha costituito ASCII Media Works, Inc.

Unicode

L' Unicode Consortium è una società senza scopo di lucro che sviluppa, mantiene e promuove l'internazionalizzazione del software, compreso il comportamento e le relazioni che definiscono tra i caratteri Unicode.

Alternative

- AppleScript

Apple ha creato un linguaggio di scripting chiamato AppleScript nel 1993. Consente agli utenti di controllare le applicazioni Macintosh con script. Consente inoltre agli utenti di controllare direttamente le applicazioni Macintosh con script e parti di macOS. Puoi creare flussi di lavoro complessi, creare script, automatizzare attività ripetitive, combinare funzionalità da più applicazioni script e set di istruzioni scritte. AppleScript offre un numero limitato di comandi. Tuttavia, fornisce anche un framework in cui è possibile collegare numerosi comandi specifici per attività (forniti da parti script di macOS e applicazioni script. AppleScript 2.0 è ora interamente basato su Unicode e contiene tutti i caratteri Unicode e viene mantenuto correttamente indipendentemente dalla lingua preferita.

Conclusione

Allora quale è meglio? Tutto sommato, sia ASCII che Unicode sono estremamente utili, ma alla fine la scelta è tua in base alle tue preferenze e ai tuoi requisiti. ASCII è ottimo quando si lavora con un numero ridotto di caratteri forniti dalla tecnica, poiché richiede meno spazio di Unicode. Unicode è molto richiesto grazie alla sua grande varietà di caratteristiche e funzioni ed è più intuitivo. Entrambe sono eccellenti tecniche di codifica per diverse applicazioni.