Elenco dei crawler: robot dei crawler Web e come sfruttarli per il successo

Pubblicato: 2022-12-03Per la maggior parte dei marketer, sono necessari aggiornamenti costanti per mantenere aggiornato il proprio sito e migliorare il posizionamento SEO.

Tuttavia, alcuni siti hanno centinaia o addirittura migliaia di pagine, il che rende una sfida per i team che inviano manualmente gli aggiornamenti ai motori di ricerca. Se il contenuto viene aggiornato così frequentemente, come possono i team garantire che questi miglioramenti abbiano un impatto sulle loro classifiche SEO?

È qui che entrano in gioco i robot crawler. Un bot web crawler esplorerà la tua mappa del sito per nuovi aggiornamenti e indicizzerà il contenuto nei motori di ricerca.

In questo post, delineeremo un elenco completo di crawler che copre tutti i bot web crawler che devi conoscere. Prima di addentrarci, definiamo i bot web crawler e mostriamo come funzionano.

Che cos'è un web crawler?

Un web crawler è un programma per computer che scansiona automaticamente e legge sistematicamente le pagine web per indicizzarle per i motori di ricerca. I web crawler sono anche conosciuti come spider o bot.

Affinché i motori di ricerca presentino pagine Web aggiornate e pertinenti agli utenti che avviano una ricerca, deve verificarsi una scansione da parte di un bot web crawler. Questo processo a volte può avvenire automaticamente (a seconda delle impostazioni del crawler e del tuo sito) oppure può essere avviato direttamente.

Molti fattori influenzano il posizionamento SEO delle tue pagine, inclusi pertinenza, backlink, web hosting e altro. Tuttavia, nessuno di questi ha importanza se le tue pagine non vengono scansionate e indicizzate dai motori di ricerca. Questo è il motivo per cui è così fondamentale assicurarsi che il tuo sito consenta le scansioni corrette e rimuova eventuali barriere sulla loro strada.

I bot devono continuamente scansionare e raschiare il web per garantire che vengano presentate le informazioni più accurate. Google è il sito web più visitato negli Stati Uniti e circa il 26,9% delle ricerche proviene da utenti americani:

Tuttavia, non esiste un web crawler che esegua la scansione per ogni motore di ricerca. Ogni motore di ricerca ha punti di forza unici, quindi gli sviluppatori e gli esperti di marketing a volte compilano un "elenco di crawler". Questo elenco di crawler li aiuta a identificare diversi crawler nel loro registro del sito da accettare o bloccare.

Gli esperti di marketing devono assemblare un elenco di crawler completo dei diversi web crawler e capire come valutano il loro sito (a differenza degli scraper di contenuti che rubano il contenuto) per garantire che ottimizzino correttamente le loro pagine di destinazione per i motori di ricerca.

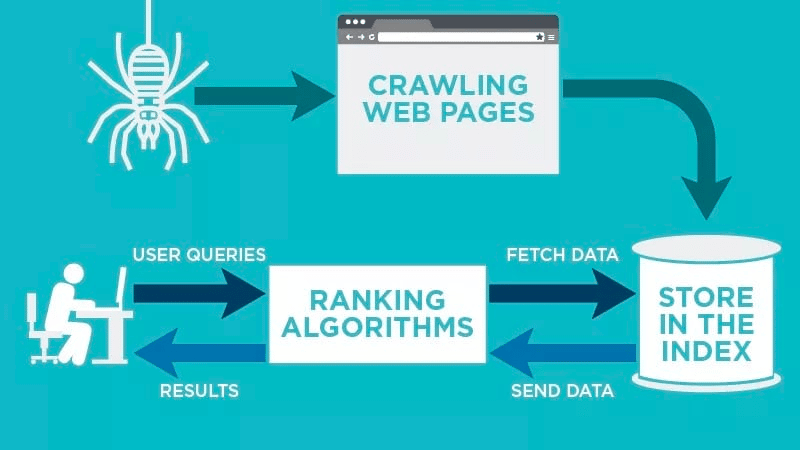

Come funziona un crawler web?

Un web crawler analizzerà automaticamente la tua pagina web dopo che è stata pubblicata e indicizzerà i tuoi dati.

I web crawler cercano parole chiave specifiche associate alla pagina web e indicizzano tali informazioni per motori di ricerca pertinenti come Google, Bing e altri.

Gli algoritmi per i motori di ricerca recupereranno quei dati quando un utente invia una richiesta per la parola chiave pertinente ad essa collegata.

Le scansioni iniziano con URL noti. Si tratta di pagine Web stabilite con vari segnali che indirizzano i crawler Web a tali pagine. Questi segnali potrebbero essere:

- Backlink: il numero di volte in cui un sito si collega ad esso

- Visitatori: quanto traffico è diretto a quella pagina

- Autorità di dominio: la qualità complessiva del dominio

Quindi, memorizzano i dati nell'indice del motore di ricerca. Quando l'utente avvia una query di ricerca, l'algoritmo recupererà i dati dall'indice e questi verranno visualizzati nella pagina dei risultati del motore di ricerca. Questo processo può avvenire in pochi millisecondi, motivo per cui i risultati spesso vengono visualizzati rapidamente.

In qualità di webmaster, puoi controllare quali bot eseguono la scansione del tuo sito. Ecco perché è importante avere un elenco di crawler. È il protocollo robots.txt che risiede all'interno dei server di ogni sito che indirizza i crawler verso nuovi contenuti che devono essere indicizzati.

A seconda di ciò che inserisci nel tuo protocollo robots.txt su ogni pagina web, puoi dire a un crawler di scansionare o evitare di indicizzare quella pagina in futuro.

Comprendendo cosa cerca un web crawler nella sua scansione, puoi capire come posizionare meglio i tuoi contenuti per i motori di ricerca.

Compilazione dell'elenco dei crawler: quali sono i diversi tipi di web crawler?

Quando inizi a pensare alla compilazione del tuo elenco di crawler, ci sono tre tipi principali di crawler da cercare. Questi includono:

- Crawler interni: si tratta di crawler progettati dal team di sviluppo di un'azienda per scansionare il suo sito. In genere vengono utilizzati per il controllo e l'ottimizzazione del sito.

- Crawler commerciali: si tratta di crawler personalizzati come Screaming Frog che le aziende possono utilizzare per eseguire la scansione e valutare in modo efficiente il proprio contenuto.

- Crawler open source : si tratta di crawler gratuiti creati da una varietà di sviluppatori e hacker in tutto il mondo.

È importante comprendere i diversi tipi di crawler esistenti in modo da sapere quale tipo è necessario sfruttare per i propri obiettivi aziendali.

Gli 11 web crawler più comuni da aggiungere al tuo elenco di crawler

Non esiste un crawler che fa tutto il lavoro per ogni motore di ricerca.

Invece, ci sono una varietà di web crawler che valutano le tue pagine web e scansionano il contenuto per tutti i motori di ricerca disponibili per gli utenti di tutto il mondo.

Diamo un'occhiata ad alcuni dei web crawler più comuni oggi.

1. GoogleBot

Googlebot è il web crawler generico di Google che è responsabile della scansione dei siti che verranno visualizzati sul motore di ricerca di Google.

Sebbene esistano tecnicamente due versioni di Googlebot, Googlebot Desktop e Googlebot Smartphone (Mobile), la maggior parte degli esperti considera Googlebot un singolo crawler.

Questo perché entrambi seguono lo stesso token di prodotto univoco (noto come token dell'agente utente) scritto in ogni sito robots.txt . L'agente utente di Googlebot è semplicemente "Googlebot".

Googlebot funziona e in genere accede al tuo sito ogni pochi secondi (a meno che tu non l'abbia bloccato nel file robots.txt del tuo sito). Un backup delle pagine scansionate viene salvato in un database unificato chiamato Google Cache. Ciò ti consente di guardare le vecchie versioni del tuo sito.

Inoltre, Google Search Console è anche un altro strumento che i webmaster utilizzano per capire come Googlebot esegue la scansione del loro sito e per ottimizzare le loro pagine per la ricerca.

2. Bigbot

Bingbot è stato creato nel 2010 da Microsoft per scansionare e indicizzare gli URL per garantire che Bing offra risultati dei motori di ricerca pertinenti e aggiornati per gli utenti della piattaforma.

Proprio come Googlebot, gli sviluppatori o gli esperti di marketing possono definire nel loro robots.txt sul loro sito se approvano o rifiutano l'identificatore dell'agente "bingbot" per scansionare il loro sito.

Inoltre, hanno la capacità di distinguere tra crawler di indicizzazione mobile-first e crawler desktop poiché Bingbot è recentemente passato a un nuovo tipo di agente. Questo, insieme a Bing Webmaster Tools, offre ai webmaster una maggiore flessibilità per mostrare come il loro sito viene scoperto e mostrato nei risultati di ricerca.

3. Bot di Yandex

Yandex Bot è un crawler specifico per il motore di ricerca russo Yandex. Questo è uno dei motori di ricerca più grandi e popolari in Russia.

I webmaster possono rendere le loro pagine del sito accessibili a Yandex Bot tramite il loro file robots.txt .

Inoltre, potrebbero anche aggiungere un tag Yandex.Metrica a pagine specifiche, reindicizzare le pagine nel Webmaster Yandex o emettere un protocollo IndexNow, un rapporto univoco che indica pagine nuove, modificate o disattivate.

4. Robot Apple

Apple ha commissionato all'Apple Bot la scansione e l'indicizzazione delle pagine Web per i suggerimenti Siri e Spotlight di Apple.

Apple Bot prende in considerazione molteplici fattori quando decide quale contenuto elevare nei suggerimenti di Siri e Spotlight. Questi fattori includono il coinvolgimento degli utenti, la pertinenza dei termini di ricerca, il numero/la qualità dei collegamenti, i segnali basati sulla posizione e persino il design della pagina web.

5. Bot DuckDuck

DuckDuckBot è il web crawler per DuckDuckGo, che offre "Protezione della privacy senza soluzione di continuità sul tuo browser web".

I webmaster possono utilizzare l'API DuckDuckBot per verificare se DuckDuck Bot ha eseguito la scansione del loro sito. Mentre esegue la scansione, aggiorna il database dell'API DuckDuckBot con indirizzi IP e agenti utente recenti.

Questo aiuta i webmaster a identificare eventuali impostori o bot dannosi che tentano di essere associati a DuckDuck Bot.

6. Ragno Baidu

Baidu è il principale motore di ricerca cinese e Baidu Spider è l'unico crawler del sito.

Google è vietato in Cina, quindi è importante consentire a Baidu Spider di eseguire la scansione del tuo sito se desideri raggiungere il mercato cinese.

Per identificare il Baidu Spider che esegue la scansione del tuo sito, cerca i seguenti agenti utente: baiduspider, baiduspider-image, baiduspider-video e altri.

Se non stai facendo affari in Cina, potrebbe avere senso bloccare Baidu Spider nel tuo script robots.txt. Ciò impedirà a Baidu Spider di eseguire la scansione del tuo sito, eliminando così ogni possibilità che le tue pagine vengano visualizzate nelle pagine dei risultati dei motori di ricerca (SERP) di Baidu.

7. Ragno Sogou

Sogou è un motore di ricerca cinese che, secondo quanto riferito, è il primo motore di ricerca con 10 miliardi di pagine cinesi indicizzate.

Se stai facendo affari nel mercato cinese, questo è un altro popolare crawler dei motori di ricerca che devi conoscere. Il Sogou Spider segue il testo di esclusione del robot e i parametri di ritardo della scansione.

Come con Baidu Spider, se non vuoi fare affari nel mercato cinese, dovresti disabilitare questo spider per evitare tempi di caricamento lenti del sito.

8. Colpo esterno di Facebook

Facebook External Hit, altrimenti noto come Facebook Crawler, esegue la scansione dell'HTML di un'app o di un sito Web condiviso su Facebook.

Ciò consente alla piattaforma social di generare un'anteprima condivisibile di ciascun collegamento pubblicato sulla piattaforma. Il titolo, la descrizione e l'immagine in miniatura vengono visualizzati grazie al crawler.

Se la scansione non viene eseguita entro pochi secondi, Facebook non mostrerà il contenuto nello snippet personalizzato generato prima della condivisione.

9. Exbot

Exalead è una società di software creata nel 2000 e con sede a Parigi, Francia. L'azienda fornisce piattaforme di ricerca per clienti consumer e aziendali.

Exabot è il crawler per il loro motore di ricerca principale basato sul loro prodotto CloudView.

Come la maggior parte dei motori di ricerca, Exalead tiene conto sia del backlinking che del contenuto delle pagine web durante il posizionamento. Exabot è l'agente utente del robot di Exalead. Il robot crea un "indice principale" che raccoglie i risultati che gli utenti del motore di ricerca vedranno.

10. Robot rapido

Swiftype è un motore di ricerca personalizzato per il tuo sito web. Combina "la migliore tecnologia di ricerca, algoritmi, framework di importazione di contenuti, client e strumenti di analisi".

Se hai un sito complesso con molte pagine, Swifttype ti offre un'interfaccia utile per catalogare e indicizzare tutte le tue pagine.

Swiftbot è il web crawler di Swifttype. Tuttavia, a differenza di altri bot, Swiftbot esegue la scansione solo dei siti richiesti dai clienti.

11. Slurp Bot

Slurp Bot è il robot di ricerca di Yahoo che esegue la scansione e indicizza le pagine per Yahoo.

Questa scansione è essenziale sia per Yahoo.com che per i suoi siti partner, tra cui Yahoo News, Yahoo Finance e Yahoo Sports. Senza di esso, gli elenchi di siti pertinenti non verrebbero visualizzati.

Il contenuto indicizzato contribuisce a un'esperienza web più personalizzata per gli utenti con risultati più pertinenti.

Gli 8 crawler commerciali che i professionisti SEO devono conoscere

Ora che hai 11 dei bot più popolari nel tuo elenco di crawler, diamo un'occhiata ad alcuni dei più comuni crawler commerciali e strumenti SEO per professionisti.

1. Bot di Ahrefs

Ahrefs Bot è un web crawler che compila e indicizza il database di 12 trilioni di link offerto dal popolare software SEO Ahrefs.

Il Bot di Ahrefs visita ogni giorno 6 miliardi di siti web ed è considerato “il secondo crawler più attivo” dietro solo a Googlebot.

Proprio come altri bot, Ahrefs Bot segue le funzioni di robots.txt , oltre alle regole di autorizzazione/disabilitazione nel codice di ogni sito.

2. Robot di Semrush

Il Semrush Bot consente a Semrush, uno dei principali software SEO, di raccogliere e indicizzare i dati del sito per l'utilizzo da parte dei suoi clienti sulla sua piattaforma.

I dati vengono utilizzati nel motore di ricerca di backlink pubblico di Semrush, nello strumento di controllo del sito, nello strumento di controllo del backlink, nello strumento di creazione di collegamenti e nell'assistente alla scrittura.

Esegue la scansione del tuo sito compilando un elenco di URL di pagine Web, visitandoli e salvando determinati collegamenti ipertestuali per visite future.

3. Rogerbot del crawler della campagna di Moz

Rogerbot è il crawler per il principale sito SEO, Moz. Questo crawler raccoglie specificamente contenuti per gli audit del sito della campagna Moz Pro.

Rogerbot segue tutte le regole stabilite nei file robots.txt , quindi puoi decidere se vuoi bloccare/consentire a Rogerbot di scansionare il tuo sito.

I webmaster non saranno in grado di cercare un indirizzo IP statico per vedere quali pagine sono state scansionate da Rogerbot a causa del suo approccio poliedrico.

4. Rana urlante

Screaming Frog è un crawler che i professionisti SEO utilizzano per controllare il proprio sito e identificare le aree di miglioramento che avranno un impatto sul posizionamento nei motori di ricerca.

Una volta avviata la scansione, puoi esaminare i dati in tempo reale e identificare i collegamenti interrotti o i miglioramenti necessari per i titoli delle pagine, i metadati, i robot, i contenuti duplicati e altro ancora.

Per configurare i parametri di scansione, è necessario acquistare una licenza Screaming Frog.

5. Lumar (precedentemente Deep Crawl)

Lumar è un "centro di comando centralizzato per mantenere la salute tecnica del tuo sito". Con questa piattaforma, puoi avviare una scansione del tuo sito per aiutarti a pianificare l'architettura del tuo sito.

Lumar è orgoglioso di essere il "crawler di siti Web più veloce sul mercato" e si vanta di poter eseguire la scansione di fino a 450 URL al secondo.

6. Maestoso

Majestic si concentra principalmente sul monitoraggio e sull'identificazione dei backlink sugli URL.

L'azienda è orgogliosa di avere "una delle fonti più complete di dati di backlink su Internet", evidenziando il suo indice storico che è passato da 5 a 15 anni di link nel 2021.

Il crawler del sito rende disponibili tutti questi dati ai clienti dell'azienda.

7. SEO cognitivo

cognitiveSEO è un altro importante software SEO utilizzato da molti professionisti.

Il crawler cognitiveSEO consente agli utenti di eseguire audit completi del sito che informeranno l'architettura del loro sito e la strategia SEO globale.

Il bot eseguirà la scansione di tutte le pagine e fornirà "un set di dati completamente personalizzato" unico per l'utente finale. Questo set di dati conterrà anche consigli per l'utente su come migliorare il proprio sito per altri crawler, sia per influire sulle classifiche che per bloccare i crawler non necessari.

8. Scansione continua

Oncrawl è un "crawler SEO e analizzatore di log leader del settore" per clienti di livello aziendale.

Gli utenti possono impostare "profili di scansione" per creare parametri specifici per la scansione. Puoi salvare queste impostazioni (inclusi l'URL iniziale, i limiti di scansione, la velocità massima di scansione e altro) per eseguire facilmente la scansione di nuovo con gli stessi parametri stabiliti.

Devo proteggere il mio sito da web crawler dannosi?

Non tutti i crawler sono buoni. Alcuni potrebbero influire negativamente sulla velocità della tua pagina, mentre altri potrebbero tentare di hackerare il tuo sito o avere intenzioni dannose.

Ecco perché è importante capire come impedire ai crawler di accedere al tuo sito.

Stabilendo un elenco di crawler, saprai quali crawler sono i migliori a cui prestare attenzione. Quindi, puoi eliminare quelli sospetti e aggiungerli al tuo elenco di blocco.

Come bloccare i web crawler dannosi

Con il tuo elenco di crawler in mano, sarai in grado di identificare quali bot vuoi approvare e quali devi bloccare.

Il primo passaggio consiste nell'esaminare l'elenco dei crawler e definire l'agente utente e la stringa dell'agente completo associati a ciascun crawler, nonché il relativo indirizzo IP specifico. Questi sono fattori identificativi chiave associati a ciascun bot.

Con l'agente utente e l'indirizzo IP, puoi abbinarli nei record del tuo sito tramite una ricerca DNS o una corrispondenza IP. Se non corrispondono esattamente, potresti avere un bot dannoso che tenta di fingere di essere quello reale.

Quindi, puoi bloccare l'impostore modificando le autorizzazioni utilizzando il tag del sito robots.txt .

Riepilogo

I web crawler sono utili per i motori di ricerca e importanti da comprendere per i professionisti del marketing.

Garantire che il tuo sito venga scansionato correttamente dai crawler giusti è importante per il successo della tua attività. Tenendo un elenco di crawler, puoi sapere a quali prestare attenzione quando compaiono nel registro del tuo sito.

Seguendo i consigli dei crawler commerciali e migliorando i contenuti e la velocità del tuo sito, ai crawler sarà più facile accedere al tuo sito e indicizzare le informazioni corrette per i motori di ricerca e per i consumatori che le cercano.