Elenco dei web crawler: i 10 più comuni per restare al passo nel 2024

Pubblicato: 2023-12-09Hai mai lottato per mantenere il tuo sito dinamico e ottimizzato per il SEO con aggiornamenti costanti? Quando si ha a che fare con centinaia o migliaia di pagine, inviare manualmente gli aggiornamenti ai motori di ricerca diventa impegnativo. La domanda chiave è: come puoi garantire che aggiornamenti frequenti dei contenuti abbiano un impatto positivo sul posizionamento SEO? La soluzione sta nei robot crawler. Questi bot analizzano la mappa del tuo sito, indicizzano i nuovi aggiornamenti e svolgono un ruolo cruciale nel migliorare la SEO. In questo blog abbiamo compilato un elenco di web crawler che renderà il tuo lavoro semplice e fluido.

Cos'è il web crawler e come funziona?

Un web crawler è un programma informatico automatizzato progettato per azioni ripetitive, in particolare la navigazione e l'indicizzazione di documenti online. I motori di ricerca come Google lo utilizzano comunemente per automatizzare la navigazione e creare un indice di contenuti web. Il termine "crawler" è sinonimo di "Bot" o "Spider" e Googlebot ne è un esempio ben noto.

Ora sorge la domanda: come funzionano i web crawler?

I web crawler iniziano scaricando il file robot.txt di un sito web, che contiene le mappe dei siti che elencano gli URL idonei per la scansione. Mentre navigano tra le pagine, i crawler identificano nuovi URL tramite collegamenti ipertestuali e li aggiungono a una coda di scansione per una potenziale esplorazione successiva.

Diversi tipi di web crawler: in poche parole

La creazione di una raccolta di categorie di web crawler implica il riconoscimento delle tre classificazioni principali: web crawler interni , web crawler commerciali e web crawler open source . Facciamo conoscenza con questi web crawler prima di immergerci nell'elenco definitivo dei web crawler.

Web crawler interno: questi strumenti di web crawler vengono creati internamente dalle organizzazioni per navigare attraverso i loro siti Web specifici, servendo a diversi scopi come la generazione di mappe dei siti e la scansione di collegamenti interrotti .

Crawler web commerciale: gli strumenti web crawler commerciali sono quelli accessibili sul mercato per l'acquisto e sono generalmente sviluppati da aziende specializzate in tale software. Inoltre, alcune importanti aziende potrebbero impiegare spider progettati su misura per i loro specifici requisiti di scansione del sito web.

Web Crawler open source: i crawler open source, d'altro canto, sono disponibili al pubblico con licenze gratuite/aperte, consentendo agli utenti di utilizzarli e adattarli in base alle proprie preferenze.

Anche se potrebbero non avere alcune funzionalità avanzate presenti nelle loro controparti commerciali, offrono agli utenti l'opportunità di approfondire il codice sorgente, acquisendo informazioni dettagliate sui meccanismi del web crawling.

Un elenco compilato di web crawler: quelli più comuni nel 2024

Nessun singolo crawler è progettato per gestire l'intero carico di lavoro per ogni motore di ricerca. Invece, esiste una vasta gamma di web crawler per valutare il contenuto delle tue pagine web, scansionandole a vantaggio degli utenti di tutto il mondo e soddisfacendo le diverse esigenze dei vari motori di ricerca. Ora esaminiamo gli elenchi di web crawler in uso oggi.

Googlebot

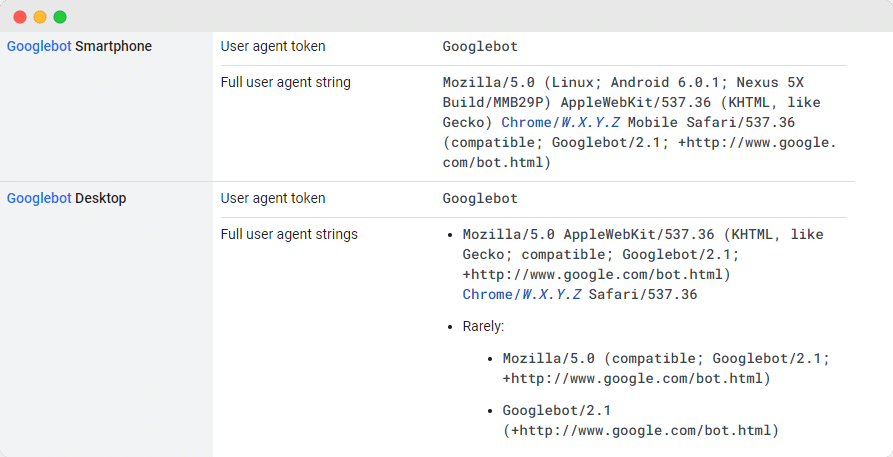

Googlebot , lo strumento web crawler generico di Google, svolge un ruolo fondamentale nella scansione dei siti Web per l'inclusione nel motore di ricerca di Google. Sebbene tecnicamente esistano due versioni, Googlebot Desktop e Googlebot Smartphone (Mobile), molti esperti le considerano come un unico crawler.

Questa unità viene mantenuta tramite un token di prodotto univoco condiviso (denominato token agente utente) specificato nel file robots.txt di ciascun sito, dove l'agente utente è semplicemente "Googlebot".

Googlebot accede regolarmente al tuo sito, in genere ogni pochi secondi, a meno che non venga bloccato intenzionalmente nel file robots.txt del sito. Le pagine scansionate vengono archiviate in un database centralizzato noto come Google Cache, che ti consente di rivedere le versioni storiche del tuo sito.

Yandex Bot

Yandex Spider è uno dei migliori strumenti di web crawler progettato esclusivamente per la piattaforma di ricerca russa, Yandex , che è uno dei motori di ricerca più importanti e ampiamente utilizzati in Russia. Gli amministratori del sito web hanno la possibilità di concedere l'accesso a Yandex Spider configurando le pagine del proprio sito nel file robots.txt.

Inoltre, possono migliorare l'accessibilità incorporando un tag Yandex.Metrica su pagine selezionate, aggiornare l'indicizzazione delle pagine tramite gli strumenti Yandex Webmaster o utilizzare il protocollo IndexNow, un rapporto esclusivo che identifica le pagine nuove, modificate o disattivate.

DuckDuck Bot

DuckDuckBot funziona come crawler del motore di ricerca per DuckDuckGo, garantendo la privacy del tuo browser Internet. I proprietari di siti web possono accedere all'API DuckDuckBot per verificare se il loro sito è stato sottoposto a scansione.

Durante questo processo, DuckDuckBot aggiorna il suo database API con nuovi indirizzi IP e user agent, aiutando i webmaster a rilevare potenziali impostori o bot dannosi che tentano di connettersi con DuckDuckBot.

Binbot

Nel 2010, Microsoft ha sviluppato Bingbot per analizzare e catalogare gli URL, garantendo che Bing fornisca risultati di ricerca pertinenti e aggiornati. Similmente a Googlebot, i proprietari di siti web possono specificare nel proprio robots.txt se consentire o impedire al " bingbot " di scansionare il proprio sito.

Inoltre, gli sviluppatori possono distinguere tra crawler con indicizzazione mobile-first e crawler desktop, poiché Bingbot ha recentemente adottato un nuovo tipo di agente. Questo, combinato con Bing Webmaster Tools, offre ai webmaster una maggiore flessibilità nel presentare il modo in cui il loro sito viene trovato e visualizzato nei risultati di ricerca.

Bot di Apple

Apple ha avviato lo sviluppo dell'Apple Bot per scansionare e catalogare le pagine web per l'integrazione con i suggerimenti Siri e Spotlight di Apple. L' Apple Bot valuta vari criteri per determinare il contenuto a cui dare la priorità nei suggerimenti di Siri e Spotlight.

Questi criteri riguardano l'interazione dell'utente, il significato dei termini di ricerca, la quantità e la qualità dei collegamenti, i segnali basati sulla posizione e la progettazione complessiva delle pagine web.

Ragno Sogou

Sogou , un motore di ricerca cinese, è riconosciuto come la prima piattaforma di ricerca che indicizza 10 miliardi di pagine cinesi. Per coloro che sono impegnati in attività nel mercato cinese, la conoscenza di questo crawler dei motori di ricerca ampiamente utilizzato, il Sogou Spider, è essenziale. Rispetta il testo di esclusione del robot e le impostazioni di ritardo della scansione.

Similmente al Baidu Spider, se la tua attività non si rivolge al mercato cinese, ti suggeriamo di disattivare questo spider per evitare un caricamento lento del sito web.

Baidu Ragno

Il motore di ricerca principale in Cina è Baidu e il suo crawler esclusivo è Baidu Spider . A causa dell’assenza di Google in Cina, diventa fondamentale consentire a Baidu Spider di eseguire la scansione del tuo sito web se miri a rivolgerti al mercato cinese. Per riconoscere l'attività di Baidu Spider sul tuo sito, controlla gli user agent come baiduspider, baiduspider-image, baiduspider-video e altri.

Per coloro che non sono impegnati in attività commerciali cinesi, potrebbe essere ragionevole bloccare Baidu Spider utilizzando lo script robots.txt. In questo modo, puoi impedire a Baidu Spider di scansionare il tuo sito, eliminando ogni possibilità che le tue pagine appaiano nelle pagine dei risultati del motore di ricerca di Baidu (SERP).

Slurp Bot

Il robot di ricerca di Yahoo, Slurp Bot , svolge un ruolo cruciale nella scansione e nell'indicizzazione delle pagine non solo di Yahoo.com ma anche delle sue piattaforme affiliate come Yahoo News, Yahoo Finance e Yahoo Sports.

L'assenza di questa scansione comporterebbe l'assenza di elenchi di siti pertinenti. L'esperienza web personalizzata per gli utenti, caratterizzata da risultati più pertinenti, è resa possibile dal contributo di contenuti indicizzati.

Colpo esterno di Facebook

Il crawler di Facebook , noto anche come Facebook External Hit, esamina l'HTML di un sito Web o di un'app condivisa su Facebook. È responsabile della creazione di un'anteprima dei collegamenti condivisi sulla piattaforma, visualizzando il titolo, la descrizione e l'immagine in miniatura.

La scansione deve avvenire tempestivamente, poiché qualsiasi ritardo potrebbe comportare la mancata visualizzazione dello snippet personalizzato quando il contenuto viene condiviso su Facebook.

Swiftbot

Un motore di ricerca personalizzato, Swiftype, migliora la funzionalità di ricerca del tuo sito web integrando tecnologie, algoritmi, framework di inserimento di contenuti, client e strumenti di analisi di prim'ordine. Particolarmente vantaggioso per i siti Web con numerose pagine, Swiftype fornisce un'interfaccia intuitiva per catalogare e indicizzare in modo efficiente tutte le pagine.

A svolgere un ruolo fondamentale in questo processo è Swiftbot, il web crawler di Swiftype . In particolare, Swiftbot si distingue per la scansione esclusiva dei siti in base alle richieste dei clienti, distinguendolo dagli altri bot.

Elenco dei migliori web crawler per padroneggiare la SEO nel 2024

L'elenco curato dei web crawler presentato in questo blog costituisce una risorsa preziosa per semplificare il processo di mantenimento del tuo sito dinamico e ottimizzato per la SEO. Mentre ti avvicini al 2024, devi incorporare questi migliori strumenti di web crawler nella tua strategia per garantire che il tuo sito web rimanga in prima linea nelle classifiche dei motori di ricerca, consentendo ai team di concentrarsi sulla creazione di contenuti di qualità mentre i crawler gestiscono le complessità dell'ottimizzazione.

Se hai trovato questo articolo pieno di risorse, condividilo con altri. Inoltre, non dimenticare di iscriverti al nostro blog e troverai ulteriori approfondimenti come questi per distinguerti nel ranking delle ricerche.