Come ottimizzare facilmente WordPress Robots.txt?

Pubblicato: 2023-02-28introduzione

Esistono numerose tecniche per aumentare la SEO del tuo sito web. L'ottimizzazione di WordPress Robots.txt è uno dei metodi migliori. Poiché consente ai motori di ricerca di scansionare il tuo sito Web, il file Robots.txt è ben noto come un potente strumento SEO. Di conseguenza, puoi migliorare liberamente la SEO del tuo sito modificando il file Robots.txt. Oggi presenteremo chiaramente alcuni approcci per ottimizzare WordPress Robots.txt su questo argomento in questo post del blog.

La definizione del file Robots.txt

Di seguito è riportato un riepilogo del file Robots.txt di WordPress.

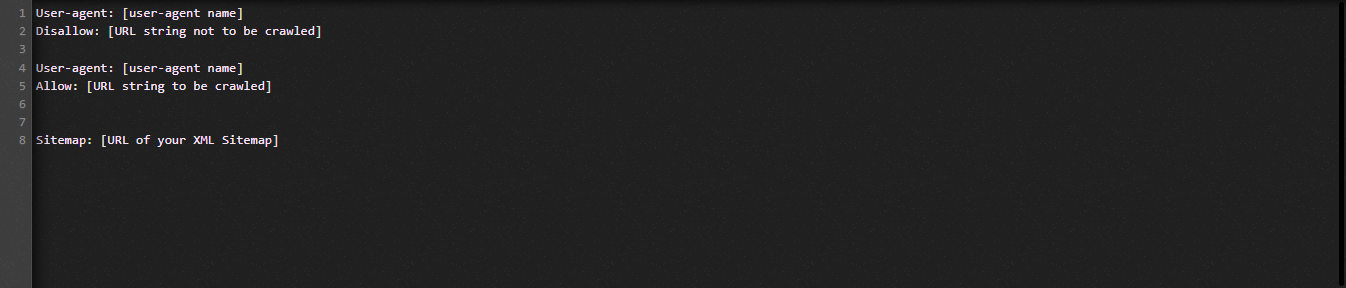

Diamo ora un'occhiata alla struttura fondamentale del file Robot.txt:

Cerchiamo di definire i termini utilizzati nel file Robots.txt per te:

- User-agent: il nome del crawler

- Non consentire: impedisce la scansione delle pagine, delle cartelle o dei file di un sito Web.

- Consenti: abilitazione della ricerca per indicizzazione di directory, file e pagine

- Mappa del sito, se fornita: mostra la posizione della mappa del sito: rappresenta un numero o una lettera.

- *: Sta per numero o carattere

- $: puoi usarlo per limitare le pagine Web che includono un'estensione specifica rimanendo in piedi fino alla fine della riga.

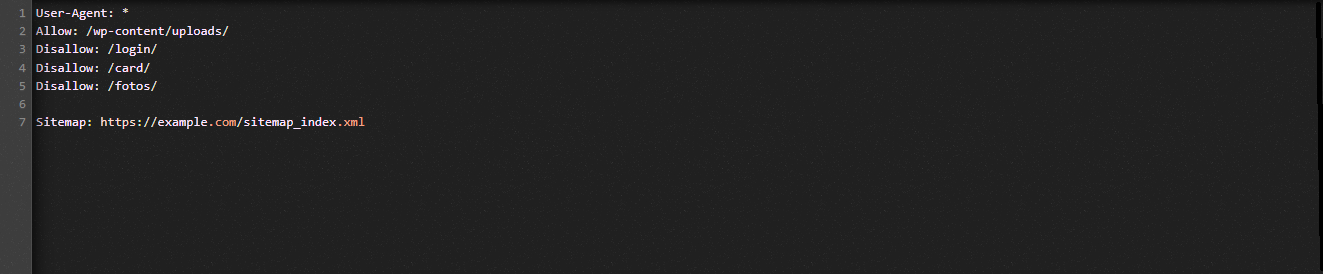

Diamo un'occhiata alla seguente illustrazione per aiutarti a comprendere:

Consentiamo ai motori di ricerca di eseguire la scansione dei file nella cartella dei caricamenti di WordPress nell'esempio Robot.txt.

Tuttavia, limitiamo l'accesso dei motori di ricerca alle cartelle di login, scheda e foto.

Infine, gli forniamo l'URL della mappa del sito.

Perché dovrebbe essere creato un file Robots.txt per il tuo sito Web WordPress?

Senza un file Robots.txt, i motori di ricerca continuano a scansionare e indicizzare ogni pagina di un sito web. Tuttavia, eseguiranno la scansione di tutto il materiale sul tuo sito Web anziché solo delle cartelle o delle pagine specificate.

Dovresti creare un file Robots.txt per il tuo sito web per due motivi principali. Prima di tutto, puoi gestire senza sforzo tutte le informazioni sul tuo sito web con la sua assistenza. Se le pagine o le directory debbano essere scansionate o indicizzate dipende da te. Significa che pagine come file di plug-in, pagine di amministrazione o directory di temi non verranno scansionate dai motori di ricerca. Di conseguenza, aiuterà la velocità di caricamento dell'indice del tuo sito web.

L'obbligo di impedire che i post o le pagine non necessari vengano indicizzati dai motori di ricerca è l'altra giustificazione. Puoi quindi impedire facilmente e comodamente che una pagina o un post di WordPress venga visualizzato nei risultati di ricerca.

Come ottimizzare WordPress Robots.txt in modo più efficiente

In questo blog didattico, ti mostreremo come creare e migliorare il file Robots.txt sul tuo sito Web WordPress utilizzando due metodi diversi:

- Apportare modifiche al file Robots.txt utilizzando un plug-in: All in One SEO

- Modifica manuale del file Robots.txt con FTP

Per rendere più efficace il file Robots.txt, utilizza il plug-in All in One SEO.

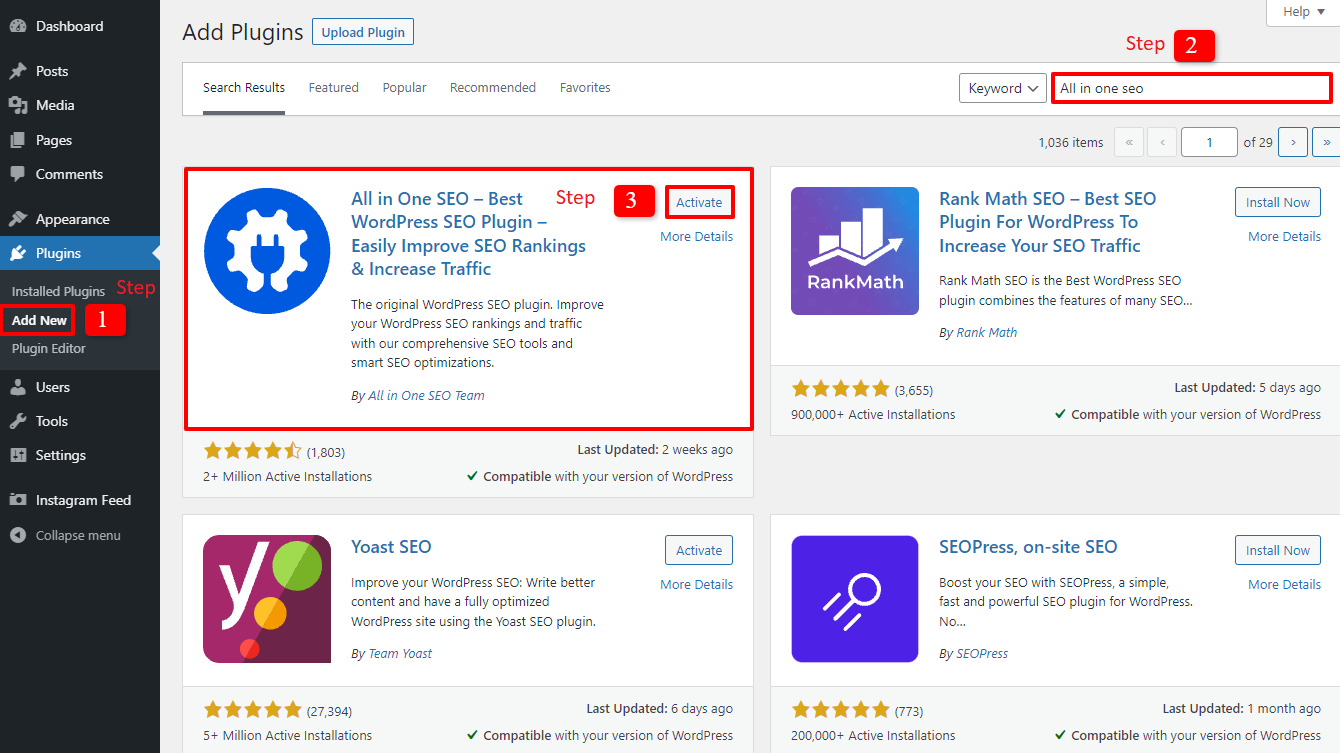

Diversi WordPress SEO Plugin sono disponibili per aiutarti con questo problema nel mercato di WordPress. Ma in questo articolo, abbiamo scelto di utilizzare All in One SEO, un plug-in molto apprezzato con oltre 2 milioni di utenti, per aiutarti.

Installiamolo prima selezionando Plugin -> Aggiungi nuovo . quindi cerca il nome del plug-in, installalo e quindi attivalo .

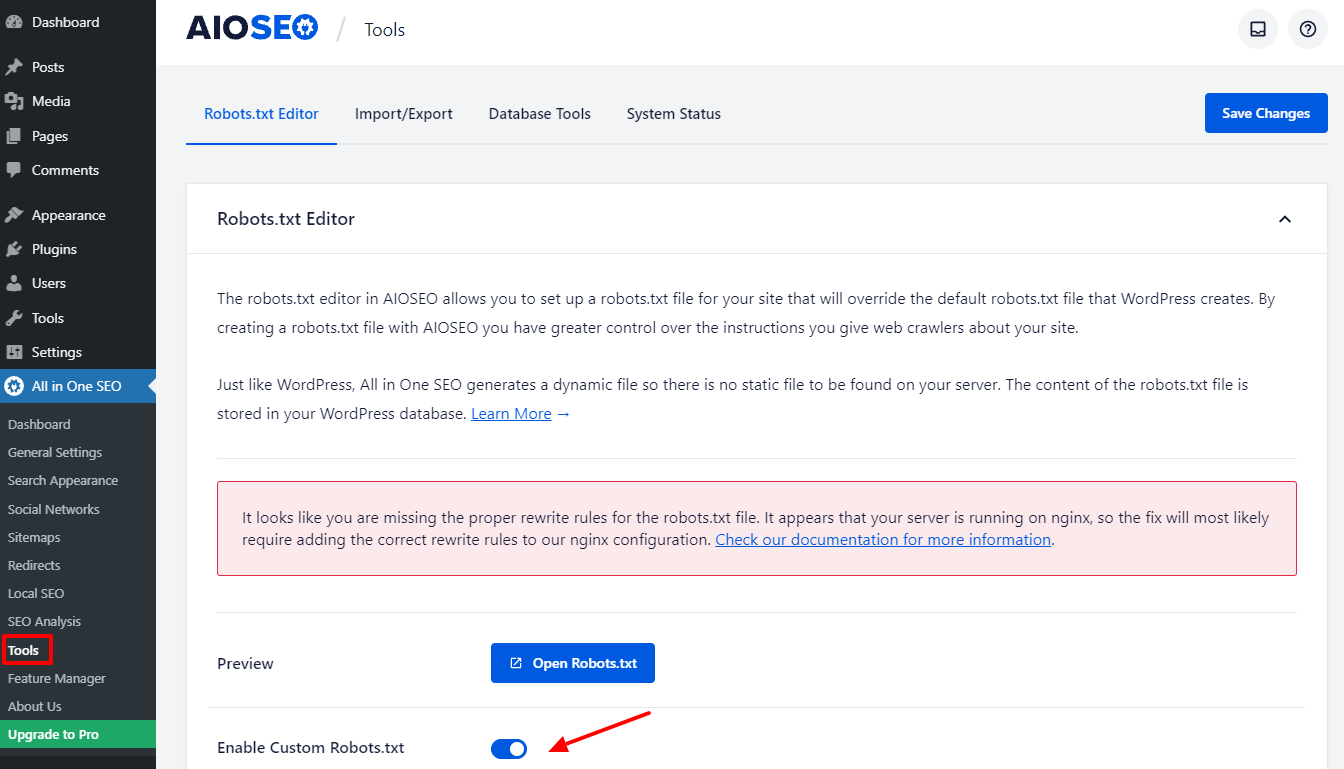

Tornerai alla dashboard di amministrazione dopo aver completato alcuni semplici passaggi. Vai subito su All in one SEO -> Strumenti .

Attiviamo il pulsante Abilita Custome Robots.txt nella sezione Editor Robots.txt per renderlo attivo. Dopo averlo acceso, puoi quindi modificare il file Robots.txt predefinito in WordPress.

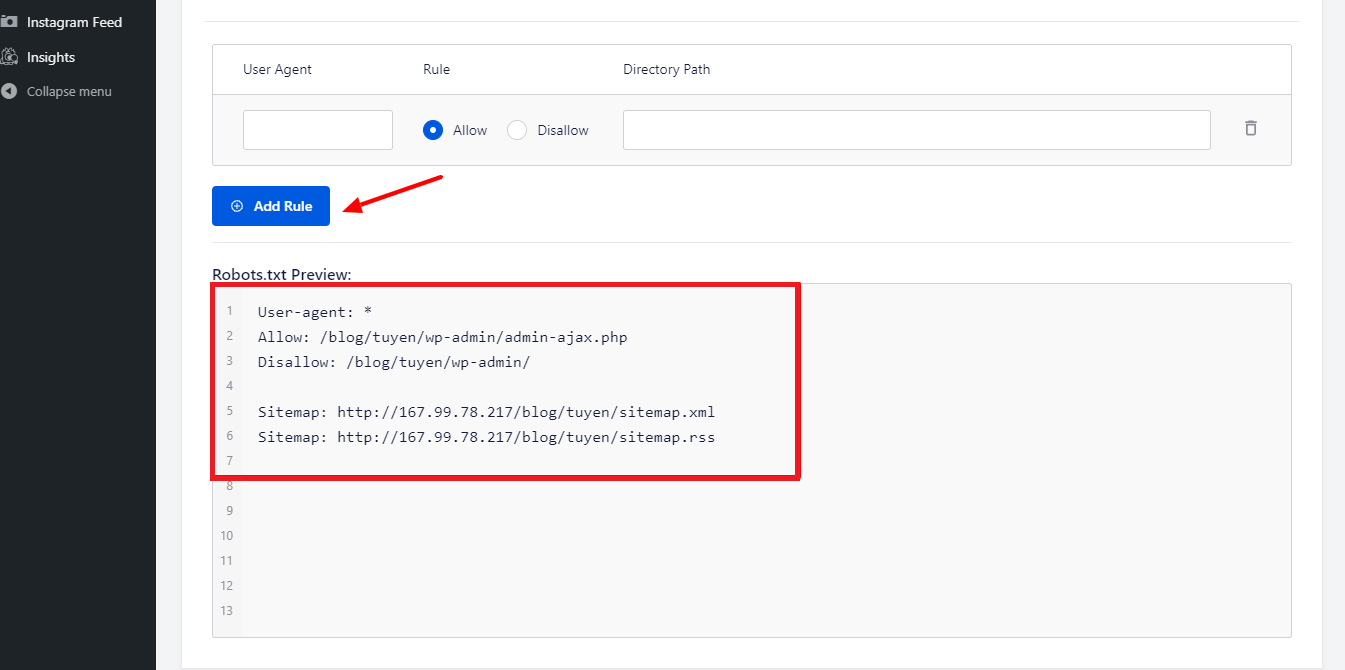

Quando scorriamo verso il basso, noterai che questo plugin mostra una casella con un'anteprima del file Robots.txt. Queste sono le regole predefinite di WordPress.

Selezionando il pulsante Aggiungi regola , puoi aggiungere altre regole specifiche per aiutare la SEO del tuo sito web.

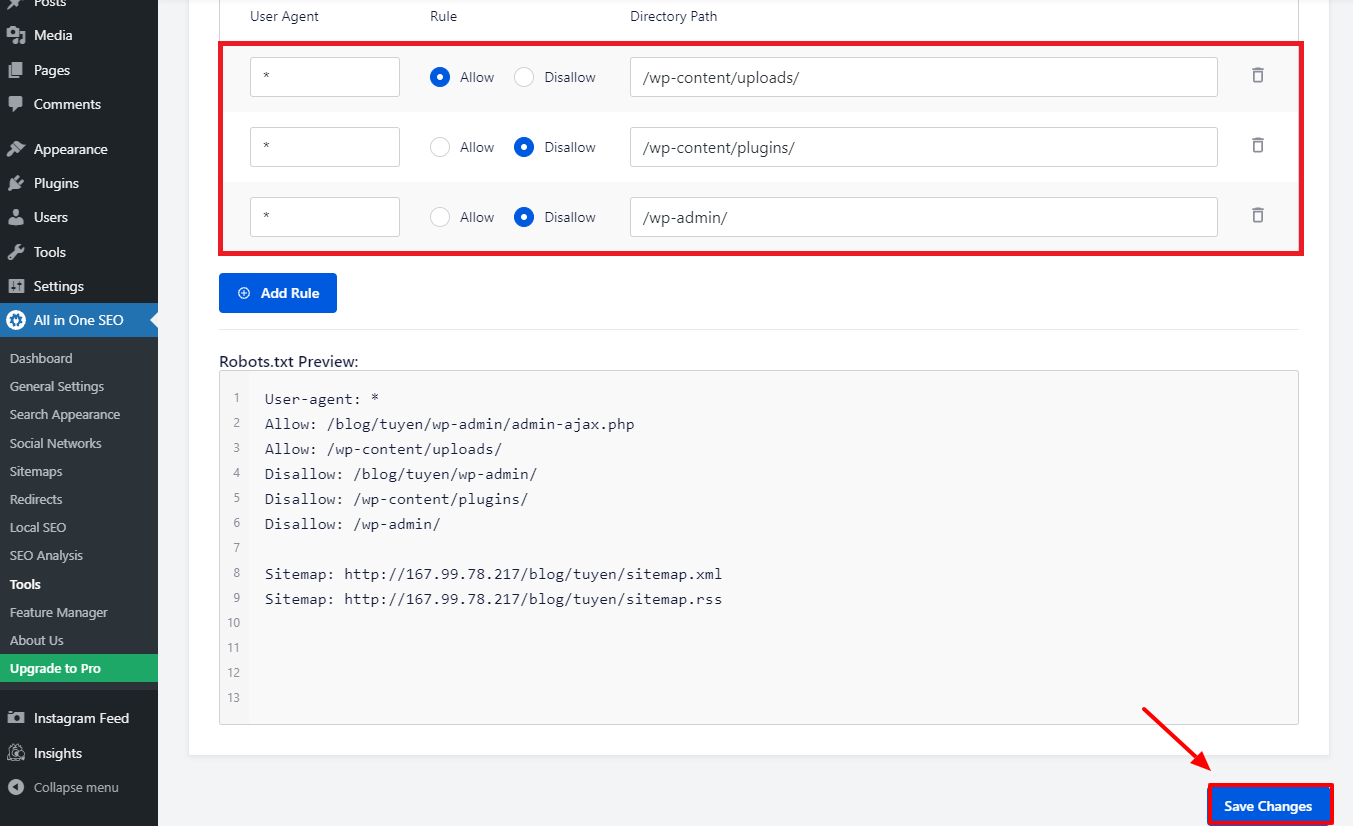

Inseriamo un * nel campo User-Agent per applicare la regola a tutti gli user agent in modo da aggiungere una nuova regola.

Devi solo selezionare Consenti o Non consentire affinché i robot di ricerca eseguano la scansione nella fase successiva.

Non dimenticare di inserire il nome file o il percorso della directory nel campo Percorso directory .

Quando hai finito con tutte le tue preferenze, premiamo il pulsante Salva modifiche .

Tutte le regole aggiuntive che hai già aggiunto verranno ora applicate immediatamente al file Robots.txt.

Modifica e ottimizza manualmente WordPress Robots.txt tramite FTP

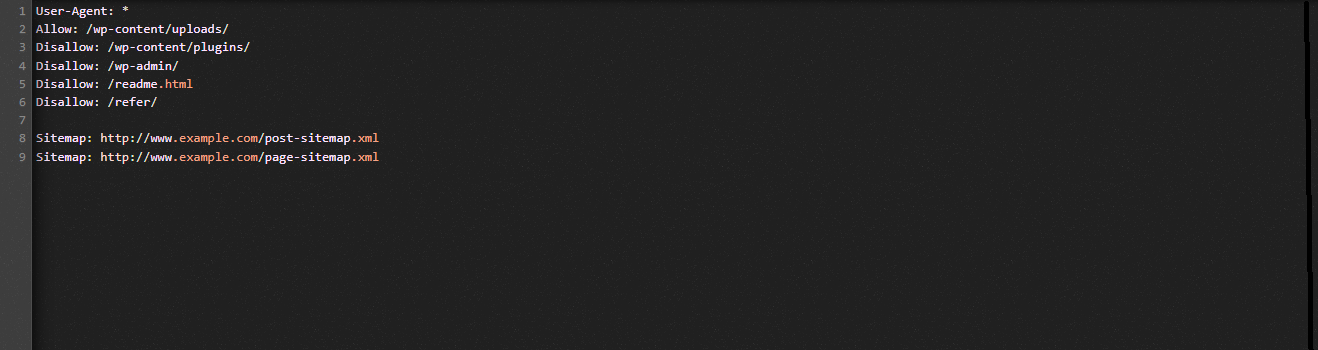

Questo è un approccio diverso all'ottimizzazione di WordPress Robots.txt che potrebbe piacerti. È necessario modificare il file Robots.txt utilizzando un client FTP per raggiungere questo obiettivo.

Per utilizzare comodamente il client FPT, stabiliamo prima una connessione al tuo account di hosting WordPress. Puoi facilmente notare il file Robots.txt nella cartella principale del tuo sito quando vi accedi. Selezioniamo Visualizza/Modifica facendo clic con il tasto destro del mouse.

D'altra parte, probabilmente non hai niente se non riesci a trovarlo. Quindi, prima creiamo un file Robots.txt per il tuo sito web selezionando Crea un nuovo file con il tasto destro del mouse.

Il file Robots.txt è un semplice file di testo, quindi puoi scaricarlo e modificarlo utilizzando un semplice editor di testo come Blocco note o TextEdit, tra gli altri. Devi semplicemente caricarlo di nuovo nella cartella principale del tuo sito web dopo. Sembra facile, non credi?

Assicurati che il file Robots.txt del tuo sito WordPress funzioni.

Il tuo file Robots.txt deve essere testato dopo averlo già preparato e configurato in modo che eventuali problemi possano essere identificati e segnalati. Di conseguenza, è necessario testarlo utilizzando uno strumento di test Robots.txt. Prova Google Search Console, poiché lo consigliamo vivamente.

Devi assicurarti che il tuo sito web sia collegato a Google Search Console se desideri utilizzare questo servizio. È quindi possibile utilizzare Robots Testing Tool selezionando la proprietà dall'elenco di selezione. Il file Robots.txt per il tuo sito Web verrà ora aggiunto automaticamente. Ti avviserà se c'è un errore.

Conclusione

Nel complesso, l'obiettivo principale dell'ottimizzazione del file Robots.txt è impedire ai robot di ricerca di accedere a pagine non richieste per il pubblico in generale, comprese le cartelle dei plug-in o le cartelle di amministrazione. Di conseguenza, bloccare i tag, le categorie o le pagine di archivio di WordPress non aiuterà il tuo SEO. In altre parole, per creare un file Robots.txt perfetto per il tuo sito WordPress, devi seguire lo schema qui sotto.

Ci auguriamo che il post del blog di oggi sia utile per ottimizzare WordPress Robots.txt. Ricordati di passarlo ai tuoi conoscenti e ad altri webmaster. Inoltre, si prega di lasciare un commento qui sotto se avete domande. Pertanto, ti risponderemo il prima possibile. È giunto il momento di ottimizzare WordPress Robots.txt. Fino ai futuri blog, abbi cura di te.

A proposito, abbiamo un sacco di temi WordPress contemporanei, accattivanti e gratuiti che supportano completamente questa utile funzionalità. Andiamo a trovarli e chiediamo a uno di loro di ridisegnare il tuo sito web