Come ottimizzare il file Robots.txt di WordPress per la SEO utilizzando Yoast SEO

Pubblicato: 2023-10-25L'ottimizzazione per i motori di ricerca (SEO) è una parte cruciale della creazione di un sito Web efficace e uno dei fattori più importanti per raggiungere il successo SEO è utilizzare gli strumenti giusti per ottimizzare il tuo sito. Uno di questi strumenti è il file Robots.txt, che controlla il modo in cui i crawler dei motori di ricerca accedono e indicizzano i tuoi contenuti.

L'ottimizzazione del file WordPress Robots.txt può aiutarti a ottenere un migliore posizionamento nei motori di ricerca, migliorare la visibilità del tuo sito web e aumentare il tuo traffico.

Tuttavia, nonostante la sua importanza, molti proprietari di siti web non hanno familiarità con la corretta configurazione del file Robots.txt. In questo post del blog ti guideremo attraverso tutto ciò che devi sapere per padroneggiare WordPress Robots.txt per la SEO e sbloccare tutto il potenziale della SEO per il tuo sito web.

Comprendere il ruolo di robots.txt nel SEO

Comprendere la funzione del file robots.txt nell'ottimizzazione dei motori di ricerca è essenziale per ottenere il massimo dagli sforzi di ottimizzazione del tuo sito Web WordPress e generare i migliori risultati possibili. Un file di testo chiamato Robots.txt, a cui ci si può riferire anche come Robots Exclusion Protocol, fornisce istruzioni ai crawler dei motori di ricerca su quali aree del tuo sito web dovrebbero scansionare e indicizzare.

Quando i bot dei motori di ricerca visitano il tuo sito web, la prima cosa che fanno è cercare nella directory principale un file chiamato robots.txt. Questo file funge da guida per i bot, informandoli sui siti e sui file che possono visitare e su quelli che non possono visitare.

Hai il controllo completo sul materiale che viene mostrato ai motori di ricerca e su ciò che viene loro nascosto se configuri correttamente il tuo file robots.txt.

L'efficacia della scansione del tuo sito web dovrebbe essere migliorata principalmente utilizzando il file robots.txt. Aiuta i bot dei motori di ricerca a concentrarsi sulla scansione e sull'indicizzazione delle parti più vitali del tuo sito web, evitando così di sprecare risorse su siti non essenziali o materiale sensibile che non dovrebbe essere reso disponibile al pubblico in generale.

Cos'è esattamente un file Robots.txt?

Un semplice file di testo noto come Robots.txt indirizza i web crawler utilizzati dai motori di ricerca verso determinate pagine web del tuo sito web. Inoltre, indica ai robot di non eseguire la scansione di determinati siti.

È essenziale comprendere il funzionamento di un motore di ricerca prima di procedere con l'analisi approfondita di questo articolo.

Scansione, indicizzazione e posizionamento sono le tre attività principali eseguite dai motori di ricerca.

La prima cosa che fanno i motori di ricerca è inviare i loro web crawler, conosciuti anche come spider o bot, in tutto il World Wide Web. Questi programmi, noti come bot, sono software intelligenti che esplorano l'intero Web alla ricerca di nuove connessioni, pagine e siti Web. Crawling è il termine dato al processo di ricerca nei contenuti sul web.

Le pagine del tuo sito web saranno organizzate in una struttura dati che potrà essere utilizzata dopo che i bot le avranno scoperte. Indicizzazione è il nome dato a questa procedura.

E alla fine tutto si riduce alla classifica. Quando un utente inserisce una query di ricerca, il motore di ricerca dovrebbe offrire all'utente le informazioni migliori e più pertinenti che può trovare a seconda di ciò che l'utente sta cercando.

Come appare il file Robots.txt?

Il file robots.txt è una componente vitale della struttura e della funzionalità di un sito web, ma ti sei mai chiesto come appare effettivamente?

Il file è applicabile a tutti i robot dei motori di ricerca che visitano il sito web, come indicato dall'asterisco che segue lo User-agent. Ogni motore di ricerca utilizza un agente utente diverso per esplorare Internet.

Ad esempio, Google utilizza Googlebot per indicizzare il contenuto del tuo sito web per la ricerca di Google. Questi user-agent si contano a centinaia. È possibile configurare istruzioni personalizzate per ogni user-agent. Ad esempio, la prima riga del file robots.txt dovrebbe essere: "Se desideri impostare istruzioni specifiche per Googlebot, sarà noto come User-agent: Googlebot.

Cos'è esattamente il budget di scansione?

Il crawl budget si riferisce al numero di pagine che un motore di ricerca è disposto a scansionare su un sito web entro un determinato periodo di tempo. È determinato da vari fattori come l'autorità del sito Web, la popolarità e la capacità del server di gestire le richieste di scansione. Inoltre, dovresti assicurarti che il budget di scansione venga utilizzato nel modo più efficiente possibile per il tuo sito web.

Le tue pagine più importanti dovrebbero sicuramente essere scansionate prima dal bot se il tuo sito web ha più pagine. È quindi fondamentale che tu lo indichi specificamente nel tuo file robots.txt.

Come individuare e modificare il file robots.txt in WordPress?

Individuare e modificare il file robots.txt in WordPress è un passaggio cruciale per ottimizzare il tuo sito web per i motori di ricerca. Configurando correttamente questo file, puoi controllare quali parti del tuo sito sono accessibili ai crawler dei motori di ricerca, assicurandoti che si concentrino sulle pagine e sui contenuti più importanti.

Per individuare e modificare il file robots.txt in WordPress, segui questi semplici passaggi:

1. Accedi alla dashboard di WordPress.

2. Passare alla scheda "Impostazioni" nel menu a sinistra.

3. Fare clic su "Lettura" per accedere alle impostazioni di lettura.

4. Scorri verso il basso fino a trovare la sezione "Visibilità sui motori di ricerca".

5. Qui vedrai un'opzione che dice "Scoraggia i motori di ricerca dall'indicizzare questo sito". Assicurati che questa opzione sia deselezionata, poiché genererà un file robots.txt di base che limita l'accesso del motore di ricerca all'intero sito.

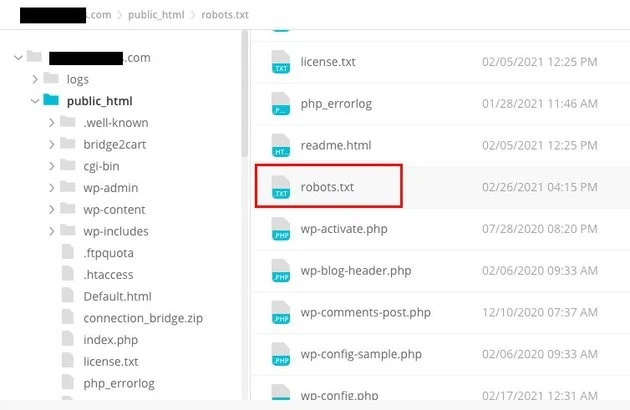

6. Se desideri personalizzare ulteriormente il tuo file robots.txt, puoi farlo accedendo alla directory principale del tuo sito web. Questo in genere può essere fatto tramite un client FTP o un file manager cPanel.

7. Una volta individuata la directory principale, cercare il file denominato "robots.txt".

8. Scarica una copia del file robots.txt esistente sul tuo computer come backup, nel caso in cui si verifichino problemi durante la modifica.

9. Apri il file robots.txt utilizzando un editor di testo.

10. Personalizza il file in base alle tue esigenze. Puoi aggiungere direttive specifiche per consentire o impedire l'accesso a determinate aree del tuo sito. Ad esempio, puoi impedire ai motori di ricerca di eseguire la scansione della tua area di amministrazione aggiungendo la seguente riga:

1. Non consentire: /wp-admin/

11. Salva le modifiche al file robots.txt e caricalo nuovamente nella directory principale del tuo sito web, sostituendo la versione precedente.

12. Infine, testa il tuo file robots.txt utilizzando lo strumento di test robots.txt di Google o altri strumenti simili per assicurarti che sia configurato correttamente.

Il controllo del modo in cui i crawler dei motori di ricerca interagiscono con il tuo sito web può essere effettuato in WordPress identificando e modificando il file robots.txt nella posizione corretta. Ciò ti consentirà di ottenere i migliori risultati possibili in termini di visibilità e posizionamento del tuo sito web. Se investi il tempo per conoscere e diventare un esperto in questo aspetto dell’ottimizzazione dei motori di ricerca (SEO), sarai sulla buona strada per sbloccare il successo del tuo sito WordPress.

Come creare un file Robots.txt in WordPress?

Andiamo avanti e creiamo un WordPress Robots.txt per la SEO ora che abbiamo discusso cos'è un file robots.txt e perché è così cruciale. WordPress ti offre due opzioni distinte per generare un file robots.txt. Il primo metodo prevede l'utilizzo di un plugin WordPress, mentre il secondo prevede il caricamento manuale del file nella cartella principale del tuo sito web.

Passaggio 1: utilizzare il plug-in Yoast SEO per creare un file Robots.txt

Puoi utilizzare plugin SEO per aiutarti a ottimizzare il tuo sito web basato su WordPress. La maggior parte di questi plugin fornisce il proprio generatore di file robots.txt all'interno del pacchetto di installazione.

Innanzitutto, scarica e installa il plugin.

Passare al menu Plugin e fare clic su “Aggiungi nuovo”. Il prossimo passo è cercare il plugin Yoast SEO, scaricarlo e attivarlo se non lo hai già.

Crea il file robots.txt come secondo passaggio

Crea un file robots txt utilizzando Yoast

Noterai il file creato con alcune direttive predefinite.

Il generatore di file robots.txt per Yoast SEO includerà automaticamente le seguenti direttive:

Agente utente: * Disallow: /wp-admin/ Consenti: /wp-admin/admin-ajax.php

Aggiungi ulteriori istruzioni a robots.txt. Dopo aver modificato il file robots.txt, fai clic su Salva.

Inserisci il nome del tuo dominio e "/robots.txt". Il tuo file robots.txt è completo se il browser visualizza le direttive predefinite, come mostrato di seguito.

file txt robots generato

Ti consigliamo inoltre di aggiungere l'URL della mappa del sito nel file robots.txt.

File txt dei robot predefiniti

Dopo che il plugin è stato abilitato, vai su Yoast SEO > Strumenti e scegli Editor di file dal menu a discesa. Procedi inserendo il nome del tuo dominio, quindi prosegui con "/robots.txt". Se guardi nel browser, noterai alcune direttive predefinite mostrate.

Passaggio 2: utilizzare FTP per creare manualmente il file Robots.txt

- Creare un file robots.txt sul tuo computer locale e caricarlo nella cartella principale del tuo sito WordPress è il passaggio successivo del processo.

- Oltre a questo, dovrai accedere al tuo hosting WordPress tramite l'utilizzo di un programma FTP come Filezilla. Se non possiedi già le credenziali necessarie per accedere, queste ti verranno rese accessibili tramite il pannello di controllo del tuo servizio hosting. Di conseguenza, puoi verificare se il file robots.txt è presente nella cartella principale del tuo sito web dopo aver effettuato l'accesso con il tuo programma FTP.

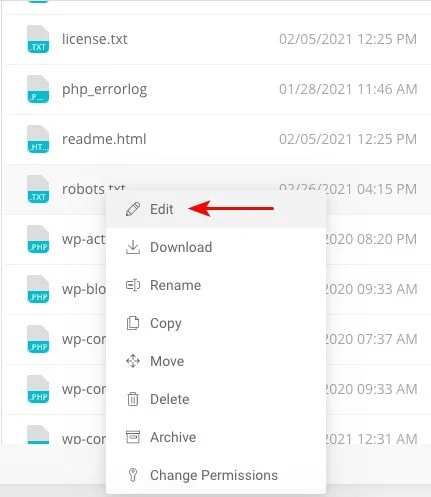

- Fare clic con il pulsante destro del mouse sul file e scegliere Modifica se esiste.

Pertanto, una volta effettuato l'accesso con il tuo client FTP, potrai verificare se il file robots.txt è presente nella cartella principale del tuo sito web. Inserire il nome del tuo dominio seguito da "/robots.txt" è il modo migliore per determinare se il tuo file è stato caricato o meno con successo.

Dopo aver apportato le modifiche, fai clic su "Salva".

Dovrai creare il file se non esiste già. Uno potrebbe essere realizzato aggiungendo le direttive a un file utilizzando un editor di testo di base come Blocco note. Ad esempio

Agente utente: * Disallow: /wp-admin/ Consenti: /wp-admin/admin-ajax.php

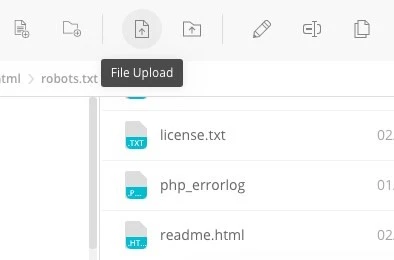

Fai clic su "Caricamento file" nel tuo client FTP per caricare il file nella cartella principale del sito web.

Digita il tuo nome di dominio e "/robots.txt" per vedere se il tuo file è stato caricato correttamente.

Questo è il metodo per caricare manualmente il file robots.txt sul tuo sito WordPress!

Robots.txt: conosce i suoi vantaggi e svantaggi

I vantaggi dell'utilizzo del file robots.txt

Indica al motore di ricerca di non dedicare tempo ai siti che non desideri vengano indicizzati, il che aiuta a ottimizzare i budget di scansione del motore di ricerca. In questo modo, aumenti la probabilità che i motori di ricerca eseguano la scansione dei siti che sono più essenziali per te.

Bloccare in questo modo i bot che causano lo spreco delle risorse del tuo server web contribuisce all'ottimizzazione del server.

È utile per nascondere pagine di ringraziamento, pagine di destinazione, pagine di accesso e altre pagine che non necessitano di essere indicizzate dai motori di ricerca.

Aspetti negativi del file robots.txt

Ora dovresti essere in grado di visualizzare il file robots.txt su qualsiasi sito web utilizzando le informazioni fornite qui. Non è troppo difficile da capire. Basta digitare il nome del dominio, seguito da "/robots.txt" e premere invio.

Tuttavia, in una certa misura anche questo comporta un pericolo. Esiste la possibilità che il file WordPress Robots.txt per SEO contenga URL ad alcune pagine interne del tuo sito web che vorresti non fossero indicizzate dai motori di ricerca.

Ad esempio, potrebbe esserci una pagina per l'accesso che non desideri venga indicizzata per qualsiasi motivo. Tuttavia, il fatto che venga menzionato nel file robots.txt consente agli aggressori di vedere il sito web. Se stai tentando di nascondere determinate informazioni sensibili, vale la stessa cosa.

Anche se commetti un singolo errore di battitura durante la scrittura del file robots.txt, annullerà tutti i tuoi sforzi di ottimizzazione dei motori di ricerca (SEO). Questo è vero anche se il file è facile da creare.

Dove inserire il file Robots.txt

Supponiamo che a questo punto tu abbia familiarità con la posizione in cui deve essere inserito il file robots.txt.

Il file robots.txt del tuo sito web dovrebbe sempre trovarsi nella directory principale del sito web. L'URL del file robots.txt sul tuo sito web sarà https://tuodominio.com/robots.txt se il tuo nome di dominio è tuodominio.com.

Oltre a posizionare il file robots.txt nella directory principale del tuo sito web, di seguito sono riportate alcune altre pratiche consigliate che dovrebbero essere rispettate:

- È assolutamente necessario dare al tuo file il nome robots.txt.

- È importante scrivere in maiuscolo il nome. Pertanto, è necessario ottenerlo correttamente, altrimenti non funzionerà.

- Ogni istruzione deve essere posizionata su una riga separata.

- Quando un URL è completo, dovrebbe essere contrassegnato con un segno "$".

- Dovrebbe essere utilizzata solo un'istanza di ciascun agente utente.

- Per fornire agli esseri umani una spiegazione del contenuto del tuo file robots.txt, utilizza i commenti iniziando ogni riga con un cancelletto (#).

Testare e convalidare il file robots.txt

Testare e convalidare il tuo file robots.txt è un passaggio cruciale per garantire che i motori di ricerca scansionino e indicizzino correttamente il tuo sito web. Un file robots.txt ben ottimizzato può impedire ai motori di ricerca di accedere a pagine sensibili o irrilevanti, migliorare l'efficienza della scansione e, in definitiva, migliorare le prestazioni generali del tuo sito web.

Per iniziare a testare il tuo file robots.txt, puoi utilizzare vari strumenti online appositamente progettati per questo scopo. Questi strumenti ti consentono di inserire le direttive del file robots.txt e di simulare il modo in cui i motori di ricerca le interpretano e le seguono.

Analizzando i risultati, puoi identificare eventuali problemi o configurazioni errate nel file. Monitorare e aggiornare regolarmente il tuo file robots.txt è fondamentale, soprattutto quando apporti modifiche alla struttura o al contenuto del tuo sito web.

Rimanendo vigili, puoi identificare e correggere rapidamente eventuali problemi che potrebbero sorgere. Questo approccio meticoloso contribuirà in definitiva alla visibilità, all'indicizzazione e al successo complessivo del tuo sito web nel panorama digitale.

Lo strumento che suggeriamo qui è Google Search Console

Puoi aggiungere il tuo sito web a Google Search Console accedendo al collegamento "Aggiungi proprietà ora" e seguendo le semplici istruzioni visualizzate sullo schermo. Una volta terminato, il menu a discesa denominato "Seleziona una proprietà" includerà il tuo sito web tra le opzioni.

Dopo aver selezionato il sito web, lo strumento otterrà automaticamente il file robots.txt associato al tuo sito web ed evidenzierà eventuali errori o avvisi, se presenti.

È necessario un file Robots.txt per il tuo sito Web WordPress?

In effetti, il tuo sito Web WordPress ha bisogno di un file robots.txt. Anche se il tuo sito web non ha un file robots.txt, i motori di ricerca lo scansioneranno e lo indicizzeranno comunque. Ora che abbiamo discusso lo scopo, il funzionamento e il budget di scansione del file robots.txt, perché dovresti ometterne uno?

I motori di ricerca vengono addestrati su cosa scansionare e, cosa più critica, cosa non scansionare tramite il file robots.txt.

Considerare le conseguenze negative del crawl budget è uno dei motivi principali per aggiungere il file robots.txt.

Come detto in precedenza, ogni sito web ha un budget di scansione. Tutto dipende dal numero di siti visitati da un bot in una singola sessione. Il bot tornerà e continuerà la scansione nella sessione successiva se non completa tutte le pagine del tuo sito web in quella sessione.

Inoltre, questo riduce il ritmo con cui il tuo sito web viene indicizzato.

Puoi risparmiare la quota di scansione risolvendo rapidamente questo problema impedendo ai bot di ricerca di scansionare risorse multimediali, directory di temi, plug-in e siti estranei.

Parole finali

Diamo priorità all'ottimizzazione dei contenuti, alla ricerca di parole chiave, alla creazione di backlink, alla creazione di una mappa del sito.xml e ad altre attività relative alla SEO mentre lavori sul tuo sito web. WordPress Robots.txt per la SEO è un aspetto che alcuni webmaster trascurano.

Il file robots.txt potrebbe non essere molto importante al primo avvio del tuo sito web. Detto questo, quando il tuo sito web diventerà più grande e avrà più pagine, ti ripagherà profumatamente se iniziamo a utilizzare il file robots.txt consigliato.