WordPress robots.txt を SEO 用に最適化する方法

公開: 2022-08-23このブログでは、robts.txt ファイルを最適化することで Web サイトの SEO を改善するためのヒントをいくつか紹介します。

実際、Robots.txt ファイルは SEO の観点から重要な役割を果たします。なぜなら、それはあなたの Web サイトがどのようにクロールされるかを検索エンジンに伝えるからです。 これが、Robot.txt ファイルが SEO の最も強力なツールの 1 つと見なされる理由です。

後で、SEO 用にWordPress Robots.txt を構築して最適化する方法についても学びます。

robots.txt ファイルとはどういう意味ですか?

Web サイトの所有者が作成するテキスト ファイルは、検索エンジン ボットに、Web サイトをクロールしてページをインデックスに登録する方法を伝えるために、Robots.txt として知られています。

実際には、ルート ディレクトリに、このファイルが格納されます。 このディレクトリは、Web サイトのメイン フォルダとも呼ばれます。 以下は、robots.txt ファイルのファイル形式です。

ユーザーエージェント: [ユーザーエージェント名] 許可しない: [クロールしない URL 文字列] ユーザーエージェント: [ユーザーエージェント名] 許可: [クロールする URL 文字列] サイトマップ: [XML サイトマップの URL]

特定の URL を許可または禁止するには、さまざまな手順を実行できます。 さらに、さまざまなサイトマップも追加できます。 検索エンジン ボットは、URL が許可されている場合、ページのクロールが許可されていると見なします。

robots.txt の例を以下に示します。

ユーザーエージェント: * 許可: /wp-content/uploads/ 許可しない: /wp-content/plugins/ 許可しない: /wp-admin/ サイトマップ: https://example.com/sitemap_index.xml

上記の例では、検索エンジンによるページのクロールと、WordPress アップロードのフォルダー内のインデックス ファイルの取得を許可しています。

この後、検索ボットが WordPress の管理フォルダーとプラグインをクロールしてインデックスに登録することを許可していません。

最後に、XML サイトマップの URL について説明しました。

WordPress ウェブサイトに Robots.txt ファイルが必要ですか?

検索エンジンは、Robots.txt などのテキスト ファイルがない場合でも、ページのクロールとインデックス作成を開始します。 しかし、残念ながら、どの特定のフォルダーまたはページをクロールする必要があるかを検索エンジンに通知することはできません。

コンテンツの少ないウェブサイトやブログを作成したばかりの場合、利益が得られなかったり、影響が残ったりすることはありません。

ただし、大量のコンテンツを含む Web サイトを設定し、それが成長し始めたら、Web サイトのクロールおよびインデックス登録されたページを制御する必要があります。

1つ目の理由は以下

すべての Web サイトについて、検索ボットにはクロールのクォータがあります。

これは明らかに、クロール セッション中に特定の数のページをクロールすることを意味します。 Web サイトのクロールが不完全なままで、もう一度戻ってきて、別のセッションでクロールを再開するとします。

このため、あなたのウェブサイトのウェブサイトのインデックス率は対決になります。

検索ボットが不要なページをクロールしないようにすることで、この問題を解決できます。 重要でないページには、プラグイン ファイル、WordPress 管理ページ、およびテーマ フォルダーが含まれる場合があります。

不要なページのクロールを許可しないことで、クロール クォータを節約できます。 検索エンジンが Web サイトのページをクロールし、できるだけ早くインデックスを作成できるようになるため、この手順はさらに役立ちます。

WordPress の Robots.txt ファイルを使用して最適化する必要があるもう 1 つの理由を以下に示します。

検索エンジンがサイトのページや投稿をインデックスに登録するのを止める必要があるときはいつでも、このファイルを使用できます。

実際、これはウェブサイトのコンテンツを一般大衆から隠す最も不適切な方法の 1 つですが、検索結果に表示されるように保護するための最良のサポートであることが証明されます。

Robots.txt ファイルはどのように表示されますか?

非常に単純な robots.txt ファイルが、最も人気のあるブログで使用されています。 コンテンツは、特定の Web サイトの要件とは異なる場合があります。

ユーザーエージェント: * 許可しない: サイトマップ: http://www.example.com/post-sitemap.xml サイトマップ: http://www.example.com/page-sitemap.xml すべてのボットは、すべてのコンテンツをインデックス化し、XML サイトマップの Web サイトへのリンクを提供することを robots.txt ファイルによって許可されます。 次の規則は、robots.txt ファイルに従う必要があると記載されています。 ユーザーエージェント: * 許可: /wp-content/uploads/ 許可しない: /wp-content/plugins/ 許可しない: /wp-admin/ 許可しない: /readme.html 許可しない: /refer/ サイトマップ: http://www.example.com/post-sitemap.xml サイトマップ: http://www.example.com/page-sitemap.xml

これは、ボットがすべての WordPress ファイルと画像をインデックス化することを示します。 これにより、検索ボットが WordPress 管理領域、WordPress プラグイン ファイル、アフィリエイト リンク、WordPress の readme ファイルをインデックス化できなくなります。

robots.txt ファイルに、Google ボットがウェブサイトのすべてのページを認識できるようにするサイトマップを追加できます。

これで、robots.txt ファイルがどのように見えるかがわかったので、WordPress で robots.txt ファイルを作成する方法を学びましょう。

WordPress で robots.txt ファイルを作成するにはどうすればよいですか?

WordPress で robots.txt ファイルを作成するには、さまざまな方法があります。 上位の方法のいくつかを以下にリストします。それらのいずれかを選択して、最適に機能させることができます.

方法 1: All in One SEO を使用して Robots.txt ファイルを変更する

All in One SEO は、100 万以上の Web サイトで使用されている、市場で最も有名な SEO 用の WordPress プラグインです。

All in One SEO プラグインは非常に使いやすく、robotx.txt ファイル ジェネレーターを提供します。 WordPress の Robots.txt を最適化することも役立ちます。

この SEO プラグインをまだ統合していない場合は、最初に WordPress ダッシュボードからインストールしてアクティブ化してください。 無料版は初心者ユーザーにも利用できるため、お金を投資することなくその機能を利用できます.

プラグインを有効にすると、WordPress 管理エリアから robots.txt ファイルを直接作成または変更するためにプラグインを使用できるようになります。

使用するには

- オールインワンSEOに行く

- robots.txt ファイルを編集するには、ツールをクリックします。

- [カスタム robots.txt を有効にする] をクリックすると、編集オプションが有効になります。

- WordPress では、このトグルを使用してカスタム robots.txt ファイルを作成することもできます。

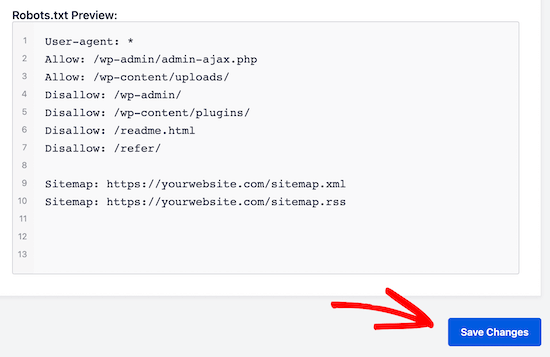

- これで、既存の robots.txt ファイルが「All in One SEO プラグイン」によって「robots.txt プレビュー」セクションに表示されます。 これは、Web 画面の下部に表示されます。

WordPress で、追加されたデフォルトルールがこのバージョンで表示されます。

デフォルトのルールは、WordPress のコア ファイルをクロールする必要がなく、XML サイトマップの Web サイトへのリンクを提供し、ボットがすべてのコンテンツをインデックスに登録できるようにする必要がないことを検索エンジンに示唆しているように見えます。

SEO 用に robots.txt を強化するために、新しい独自のカスタム ルールを追加できます。

[ユーザー エージェント] フィールドにユーザー エージェントを追加して、ルールを追加します。 ルールは、* を使用してすべてのユーザー エージェントに適用されます。

検索エンジンによるページのクロールを許可するかどうかを選択します。

ここで、ディレクトリ パス、ファイル名を [ディレクトリ パス] フィールドに追加します。

robots.txt に、ルールが自動的に適用されます。 [ルールを追加] ボタンをクリックして、新しいルールを追加します。

理想的な robotx.txt 形式を作成しない限り、新しいルールを追加することをお勧めします。

追加したカスタム ルールは次のようになります。

変更を保存するには、[変更を保存] をクリックするのをお忘れなく

方法 2: FTP を使用して Robots.txt ファイルを手動で変更する

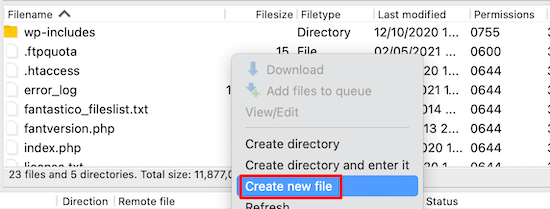

WordPress Robots.txt を最適化するもう 1 つの方法は、FTP クライアントの機能を利用して robots.txt ファイルの変更を開始することです。

FTP クライアントを使用して、WordPress ホスティング アカウントに接続するだけです。

ログイン後、ウェブサイトのルート フォルダで robots.txt ファイルを表示できます。

見つからない場合は、robots.txt ファイルがないことを意味します

このような状況では、robot.txt ファイルを作成する必要があります。

前述のように、robots.txt ファイルは通常、コンピューターにダウンロードできる単純なテキスト ファイルです。 ただし、TextEdit、メモ帳、ワードパッドなどのプレーン テキスト エディターを使用して変更することもできます。

すべての変更を実行したら、保存します。 このファイルを Web サイトのルート フォルダーにアップロードできます。

Robots.txt ファイルでテストを実行するにはどうすればよいですか?

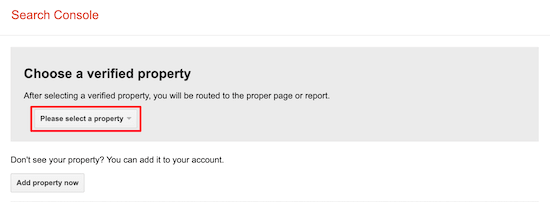

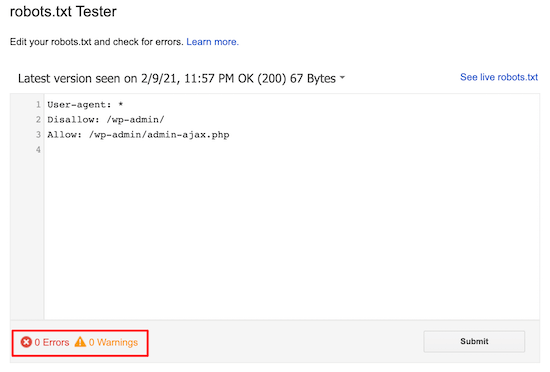

robots.txt テスター ツールを使用してテストを実行できます。

ウェブ上には、robots.txt テスター ツールがたくさんあります。 そのうちの 1 つが Google Search Console です。

このツールを使用するには、まず Google 検索コンソールに接続された Web サイトが必要です。 この後、その機能の利用を開始できます。

ドロップダウン リストから、プロパティを選択するだけです。

ただし、Web サイトの robots.txt ファイルが自動的に選択され、すべての警告とエラーが強調表示されます。 これは、WordPress Robots.txt ファイルを非常に簡単に最適化するのに役立つ最高のツールの 1 つです。

結論:

この robots.txt ファイルを最適化する主な目的は、ページがページをクロールしないようにすることです。 たとえば、WordPress 管理フォルダー内のページまたは wp-plugin フォルダー内のページです。

最も一般的な神話は、WordPress カテゴリ、アチーブメント ページ、およびタグをブロックすることで、クロール レートを改善してインデックスを高速化し、より高いランキングを取得できるというものです。

しかし、Google のウェブマスター ガイドラインに従って問題が発生するため、これは機能しません。

上記のすべての点を読んで検討することを強くお勧めします。

このブログが、ウェブサイトに適した形式を使用して robots.txt ファイルを作成するのに役立つことを願っています。 また、WordPress の Robots.txt を最適化するのにも役立ちます。