Yoast SEO を使用して WordPress Robots.txt を SEO 用に最適化する方法

公開: 2023-10-25検索エンジン最適化 (SEO) は、効果的な Web サイトを構築する上で重要な部分であり、SEO を成功させるための最も重要な要素の 1 つは、適切なツールを使用してサイトを最適化することです。 そのようなツールの 1 つが Robots.txt ファイルで、検索エンジン クローラーがコンテンツにアクセスしてインデックスを作成する方法を制御します。

WordPress Robots.txt ファイルを最適化すると、検索エンジンのランキングが向上し、Web サイトの可視性が向上し、トラフィックが増加します。

ただし、その重要性にもかかわらず、多くの Web サイト所有者は、Robots.txt ファイルを適切に構成する方法に慣れていません。 このブログ投稿では、SEO 用に WordPress Robots.txt をマスターし、Web サイトの SEO の可能性を最大限に引き出すために知っておくべきことをすべて説明します。

SEOにおけるrobots.txtの役割を理解する

検索エンジンの最適化における robots.txt ファイルの機能を理解することは、WordPress Web サイトの最適化の取り組みを最大限に活用し、可能な限り最高の結果を生み出すために不可欠です。 Robots.txt というテキスト ファイルは、ロボット除外プロトコルとも呼ばれ、Web サイトのどの領域をクロールしてインデックスを作成する必要があるかを検索エンジン クローラーに指示します。

検索エンジンからのボットが Web サイトにアクセスすると、最初にルート ディレクトリで robots.txt というファイルをチェックインします。 このファイルはボットのガイドとして機能し、ボットがアクセスを許可されているサイトとファイル、およびアクセスが許可されていないサイトとファイルについて通知します。

robots.txt ファイルを正しく構成すれば、検索エンジンに表示する内容と検索エンジンから隠蔽する内容を完全に制御できます。

Web サイトのスキャン効率は主に robots.txt ファイルを使用することで向上します。 これにより、検索エンジン ボットが Web サイトの最も重要な部分のクロールとインデックス作成に集中できるようになり、必須ではないサイトや一般公開すべきではない機密コンテンツでのリソースの無駄を回避できます。

Robots.txt ファイルとは何ですか?

Robots.txt として知られる単純なテキスト ファイルは、検索エンジンが使用する Web クローラーを Web サイト上の特定の Web ページに誘導します。 さらに、ロボットに特定のサイトをクロールしないよう指示します。

この記事の詳細な分析を進める前に、検索エンジンの動作を理解することが重要です。

クロール、インデックス作成、ランキングは、検索エンジンによって実行される 3 つの主要なアクティビティです。

検索エンジンが最初に行うことは、Web クローラー (スパイダーまたはボットとも呼ばれます) を World Wide Web 全体に派遣することです。 ボットとして知られるこれらのプログラムは、新しい接続、ページ、Web サイトを探して Web 全体を巡回するインテリジェントなソフトウェアです。 クロールとは、Web 上のコンテンツを検索するプロセスを表す用語です。

Web サイトのページは、ボットが検出した後に使用できるデータ構造に編成されます。 インデックス作成は、このプロシージャに付けられた名前です。

そして結局のところ、すべてはランキングに帰着します。 ユーザーが検索クエリを入力すると、検索エンジンは、ユーザーが探しているものに応じて、検索できる最適かつ最も関連性の高い情報をユーザーに提供する必要があります。

Robots.txt ファイルはどのように見えるのでしょうか?

robots.txt ファイルは Web サイトの構造と機能にとって重要なコンポーネントですが、実際にはどのように表示されるのか疑問に思ったことはありますか?

ユーザー エージェントに続くアスタリスクで示されているように、このファイルは Web サイトにアクセスするすべての検索エンジン ロボットに適用されます。 各検索エンジンは、異なるユーザー エージェントを使用してインターネットを探索します。

たとえば、Google は Googlebot を利用して、Google 検索用に Web サイトのコンテンツのインデックスを作成します。 これらのユーザー エージェントの数は数百に上ります。 カスタム命令は、すべてのユーザー エージェントに対して構成できます。 たとえば、robots.txt ファイルの最初の行は、「Googlebot に特定の命令を設定したい場合は、ユーザー エージェント: Googlebot として認識されます。

クロールの予算とは正確には何ですか?

クロール バジェットとは、検索エンジンが指定された期間内に Web サイト上でクロールできるページの数を指します。 これは、Web サイトの権威、人気、クロール リクエストを処理するサーバーの容量など、さまざまな要因によって決まります。 さらに、Web サイトに対してクロール バジェットが可能な限り効率的に使用されるようにする必要があります。

Web サイトに複数のページがある場合、最も重要なページが確実にボットによって最初にクロールされるはずです。 したがって、これを robots.txt ファイルに具体的に記述することが不可欠です。

WordPress で robots.txt ファイルを見つけて編集するにはどうすればよいですか?

WordPress で robots.txt ファイルを見つけて編集することは、Web サイトを検索エンジン用に最適化するための重要なステップです。 このファイルを適切に構成することで、検索エンジン クローラーがサイトのどの部分にアクセスできるかを制御し、最も重要なページとコンテンツに重点を置くことができます。

WordPress で robots.txt ファイルを見つけて編集するには、次の簡単な手順に従います。

1. WordPress ダッシュボードにログインします。

2. 左側のメニューの「設定」タブに移動します。

3. 「読み取り」をクリックして読み取り設定にアクセスします。

4. 「検索エンジンの可視性」セクションが見つかるまで下にスクロールします。

5. ここには、「検索エンジンによるこのサイトのインデックス作成を阻止する」というオプションが表示されます。 サイト全体への検索エンジンのアクセスを制限する基本的な robots.txt ファイルが生成されるため、このオプションがオフになっていることを確認してください。

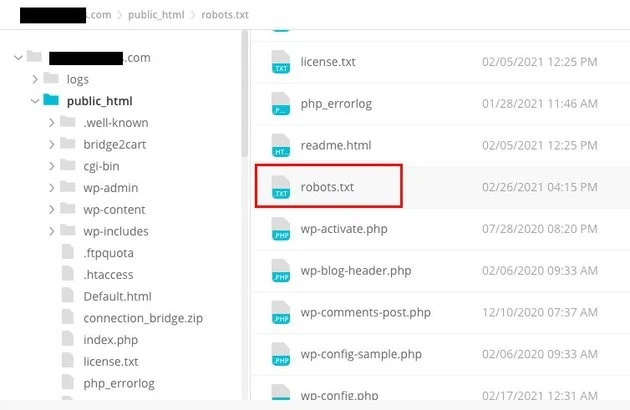

6. robots.txt ファイルをさらにカスタマイズしたい場合は、Web サイトのルート ディレクトリにアクセスして実行できます。 これは通常、FTP クライアントまたは cPanel ファイル マネージャーを通じて実行できます。

7. ルート ディレクトリを見つけたら、「robots.txt」という名前のファイルを探します。

8. 編集中に問題が発生した場合に備えて、既存の robots.txt ファイルのコピーをバックアップとしてコンピュータにダウンロードします。

9. テキスト エディタを使用して robots.txt ファイルを開きます。

10. 必要に応じてファイルをカスタマイズします。 特定のディレクティブを追加して、サイトの特定の領域へのアクセスを許可または禁止できます。 たとえば、次の行を追加することで、検索エンジンが管理領域をクロールするのを防ぐことができます。

1. /wp-admin/ を禁止します。

11. robots.txt ファイルへの変更を保存し、Web サイトのルート ディレクトリにアップロードして戻し、以前のバージョンを置き換えます。

12. 最後に、Google の robots.txt テスト ツールまたは他の同様のツールを使用して robots.txt ファイルをテストし、正しく構成されていることを確認します。

検索エンジン クローラーが Web サイトと対話する方法を制御するには、WordPress で適切な場所にある robots.txt ファイルを特定して変更します。 これにより、Web サイトの可視性とランキングの点で最高の結果を得ることができます。 検索エンジン最適化 (SEO) のこの側面について学び、専門家になるために時間を投資すれば、WordPress サイトの成功への道を順調に進んでいることになります。

WordPress で Robots.txt ファイルを作成するには?

robots.txt ファイルとは何か、そしてそれが非常に重要である理由について説明したので、SEO 用の WordPress Robots.txt を作成しましょう。 WordPress には、robots.txt ファイルを生成するための 2 つの異なるオプションが用意されています。 1 つ目の方法では WordPress プラグインを使用し、2 つ目の方法では Web サイトのルート フォルダーにファイルを手動でアップロードします。

ステップ 1: これは、Yoast SEO プラグインを使用して Robots.txt ファイルを作成します。

SEO プラグインを利用すると、WordPress で構築された Web サイトの最適化を支援できます。 これらのプラグインの大部分は、インストール パッケージ内に独自の robots.txt ファイル ジェネレーターを提供します。

まず、プラグインをダウンロードしてインストールします。

「プラグイン」メニューに移動し、「新規追加」をクリックします。 次のステップでは、Yoast SEO プラグインを探してダウンロードし、まだお持ちでない場合はオンにします。

2 番目のステップとして robots.txt ファイルを作成します。

Yoastを使用してロボットのtxtファイルを作成する

いくつかのデフォルトのディレクティブを使用してファイルが作成されたことがわかります。

Yoast SEO の robots.txt ファイル ジェネレーターには、次のディレクティブが自動的に含まれます。

ユーザーエージェント: * 禁止: /wp-admin/ 許可: /wp-admin/admin-ajax.php

robots.txt に追加の指示を追加します。 robots.txt を編集したら、[保存] をクリックします。

ドメイン名と「/robots.txt」を入力します。 以下に示すように、ブラウザーにデフォルトのディレクティブが表示されれば、robots.txt ファイルは完成です。

生成されたロボットのtxtファイル

また、robots.txt にサイトマップ URL を追加することをお勧めします。

デフォルトのロボット txt ファイル

プラグインが有効になったら、Yoast SEO > Tools に移動し、ドロップダウン メニューから File editor を選択します。 ドメイン名の入力に進み、その後に「/robots.txt」を入力します。 ブラウザを見ると、デフォルトのディレクティブがいくつか表示されていることに気づくでしょう。

ステップ 2: FTP を使用して Robots.txt ファイルを手動で作成する

- ローカル コンピューター上に robots.txt ファイルを作成し、それを WordPress Web サイトのルート フォルダーにアップロードするのが、プロセスの次のステップです。

- これに加えて、Filezilla などの FTP プログラムを使用して WordPress ホスティングにアクセスする必要があります。 ログインに必要な資格情報をまだ持っていない場合は、ホスティング サービスのコントロール パネルを介して資格情報にアクセスできるようになります。 したがって、FTP プログラムでログインした後、robots.txt ファイルが Web サイトのルート フォルダーに存在するかどうかを確認することができます。

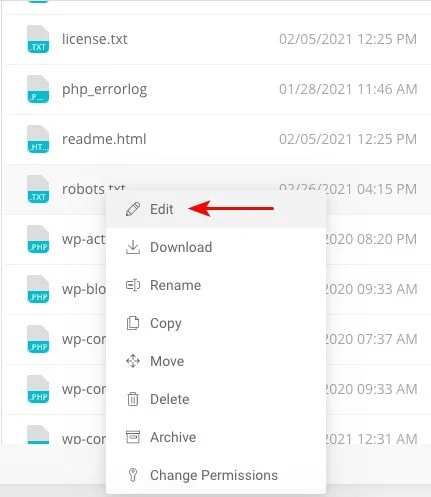

- ファイルが存在する場合は、ファイルを右クリックし、「編集」を選択します。

したがって、FTP クライアントで正常にサインインすると、robots.txt ファイルが Web サイトのルート フォルダーにあるかどうかを確認できます。 ファイルが正常にアップロードされたかどうかを判断するには、ドメイン名に続けて「/robots.txt」を入力するのが最善の方法です。

変更を加えた後、「保存」をクリックします。

ファイルがまだ存在しない場合は作成する必要があります。 メモ帳などの基本的なテキスト エディタを使用してファイルにディレクティブを追加することで作成することもできます。 のような

ユーザーエージェント: * 禁止: /wp-admin/ 許可: /wp-admin/admin-ajax.php

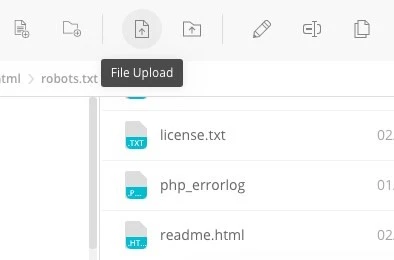

FTP クライアントで [ファイル アップロード] をクリックして、ファイルを Web サイトのルート フォルダーにアップロードします。

ドメイン名と「/robots.txt」を入力して、ファイルが正常にアップロードされたかどうかを確認します。

これは、robots.txt ファイルを WordPress ウェブサイトに手動でアップロードする方法です。

Robots.txt: 長所と短所を理解する

robots.txt ファイルを使用する利点

インデックスを作成したくないサイトに時間を費やさないように検索エンジンに指示します。これは、検索エンジンのクロール バジェットを最適化するのに役立ちます。 そうすることで、検索エンジンがあなたにとって最も重要なサイトをクロールする可能性が高まります。

このように Web サーバーのリソースを無駄にしているボットをブロックすると、サーバーの最適化に役立ちます。

サンキューページ、ランディングページ、ログインページ、および検索エンジンによってインデックスを作成する必要のないその他のページを非表示にするのに役立ちます。

robots.txt ファイルのマイナス面

ここで提供される情報を使用して、どの Web サイトでも robots.txt ファイルを表示できるようになります。 理解するのはそれほど難しいことではありません。 ドメイン名を入力し、その後に「/robots.txt」を入力して Enter キーを押します。

ただし、これにはある程度の危険も伴います。 SEO 用の WordPress Robots.txt ファイルには、検索エンジンによるインデックスを作成したくない Web サイトの内部ページの一部への URL が含まれている可能性があります。

たとえば、何らかの理由でインデックスを作成したくないログイン用のページがあるかもしれません。 ただし、robots.txt ファイルに記述されているため、攻撃者が Web サイトを閲覧できる可能性があります。 特定の機密情報を隠蔽しようとする場合にも、同じことが当てはまります。

robots.txt ファイルの作成中に 1 回タイプミスをしただけでも、検索エンジン最適化 (SEO) の取り組みがすべて台無しになってしまいます。 これは、ファイルの作成が簡単な場合でも当てはまります。

Robots.txt ファイルを置く場所

この時点で、robots.txt ファイルを挿入する必要がある場所がわかっていると仮定します。

Web サイトの robots.txt ファイルは、常に Web サイトのルート ディレクトリに配置する必要があります。 ドメイン名が yourdomain.com の場合、Web サイト上の robots.txt ファイルの URL は https://yourdomain.com/robots.txt になります。

robots.txt ファイルを Web サイトのルート ディレクトリに配置することに加えて、次のような他の推奨事項に従う必要があります。

- ファイルに robots.txt という名前を付けることが非常に重要です。

- 名前を大文字にすることが重要です。 したがって、適切に取得する必要があります。そうしないと機能しません。

- 各命令は別の行に配置する必要があります。

- URL が完成したら、「$」記号を付ける必要があります。

- 各ユーザー エージェントのインスタンスは 1 つだけ使用する必要があります。

- robots.txt ファイルの内容を人間に説明するには、各行をハッシュ (#) で始めてコメントを使用します。

robots.txt ファイルのテストと検証

robots.txt ファイルのテストと検証は、検索エンジンが Web サイトを適切にクロールし、インデックスを付けることを保証するための重要なステップです。 robots.txt ファイルが適切に最適化されていると、検索エンジンが機密ページや無関係なページにアクセスするのを防ぎ、クロール効率を向上させ、最終的に Web サイトの全体的なパフォーマンスを向上させることができます。

robots.txt ファイルのテストを開始するには、この目的のために特別に設計されたさまざまなオンライン ツールを利用できます。 これらのツールを使用すると、robots.txt ディレクティブを入力し、検索エンジンがディレクティブをどのように解釈して従うかをシミュレートできます。

結果を分析することで、ファイル内の潜在的な問題や構成ミスを特定できます。 robots.txt ファイルを定期的に監視して更新することは、特に Web サイトの構造やコンテンツに変更を加える場合には重要です。

常に警戒を続けることで、発生する可能性のある問題をすぐに特定して修正できます。 この細心の注意を払ったアプローチは、最終的には Web サイトの認知度、インデックス作成、デジタル環境における全体的な成功に貢献します。

ここで提案するツールはGoogle Search Consoleです

[今すぐプロパティを追加] リンクに移動し、表示される画面上の簡単な指示に従うことで、Web サイトを Google Search Console に追加できます。 完了すると、「プロパティを選択してください」というラベルのドロップダウン メニューに、オプションの中にあなたの Web サイトが含まれるようになります。

Web サイトを選択すると、ツールは Web サイトに関連付けられた robots.txt ファイルを自動的に取得し、間違いや警告がある場合は強調表示します。

Robots.txt ファイルは WordPress ウェブサイトに必要ですか?

実際、WordPress Web サイトには robots.txt ファイルが必要です。 Web サイトに robots.txt ファイルがない場合でも、検索エンジンはそれをクロールしてインデックスを作成します。 robots.txt の目的、仕組み、クロール バジェットについて説明しましたが、なぜ 1 つを省略したいのでしょうか?

検索エンジンは、robots.txt ファイルを介して、何をクロールするか、そしてより重要なことに、何をクロールしないかをトレーニングします。

クロール バジェットの悪影響を考慮することが、robots.txt を追加する主な理由の 1 つです。

前述したように、各 Web サイトにはクロール バジェットがあります。 すべては、ボットが 1 回のセッションで訪問するサイトの数によって決まります。 そのセッションで Web サイト上のすべてのページを完了しなかった場合、ボットは次のセッションに戻り、クロールを継続します。

また、これにより、Web サイトのインデックスが作成されるペースも遅くなります。

検索ボットがメディア アセット、テーマ ディレクトリ、プラグイン、無関係なサイトをスキャンしないようにすることで、この問題を迅速に修正することで、クロール クォータを節約できます。

最後の言葉

私たちは、Web サイトの作業中、コンテンツの最適化、キーワード調査、バックリンクの構築、sitemap.xml の作成、およびその他の SEO 関連のタスクを優先します。 SEO のための WordPress Robots.txt には、一部のウェブマスターが見落としている側面があります。

robots.txt ファイルは、Web サイトが最初に起動された時点ではそれほど重要ではない可能性があります。 そうは言っても、Web サイトが大きくなり、ページ数が増えた場合、推奨されている robots.txt ファイルを使用し始めると、かなりの効果が得られます。