14 typowych błędów w pliku WordPress Robots.txt, których należy unikać

Opublikowany: 2025-01-14Robots.txt to potężny plik serwerowy, który informuje roboty wyszukiwania i inne boty, jak mają się zachowywać w witrynie WordPress. Może to znacząco wpłynąć na optymalizację wyszukiwarek (SEO) Twojej witryny, zarówno pozytywnie, jak i negatywnie.

Z tego powodu powinieneś wiedzieć, czym jest ten plik i jak go używać. W przeciwnym razie możesz uszkodzić swoją witrynę lub przynajmniej pozostawić część jej potencjału na stole.

Aby pomóc Ci uniknąć tego scenariusza, w tym poście szczegółowo omówimy plik robots.txt. Określimy, co to jest, jaki jest jego cel, jak znaleźć i zarządzać Twoim plikiem oraz co powinien zawierać. Następnie omówimy najczęstsze błędy popełniane przez ludzi w pliku robots.txt WordPress, sposoby ich uniknięcia i sposoby naprawy, jeśli okaże się, że popełniłeś błąd.

Co to jest plik robots.txt WordPress?

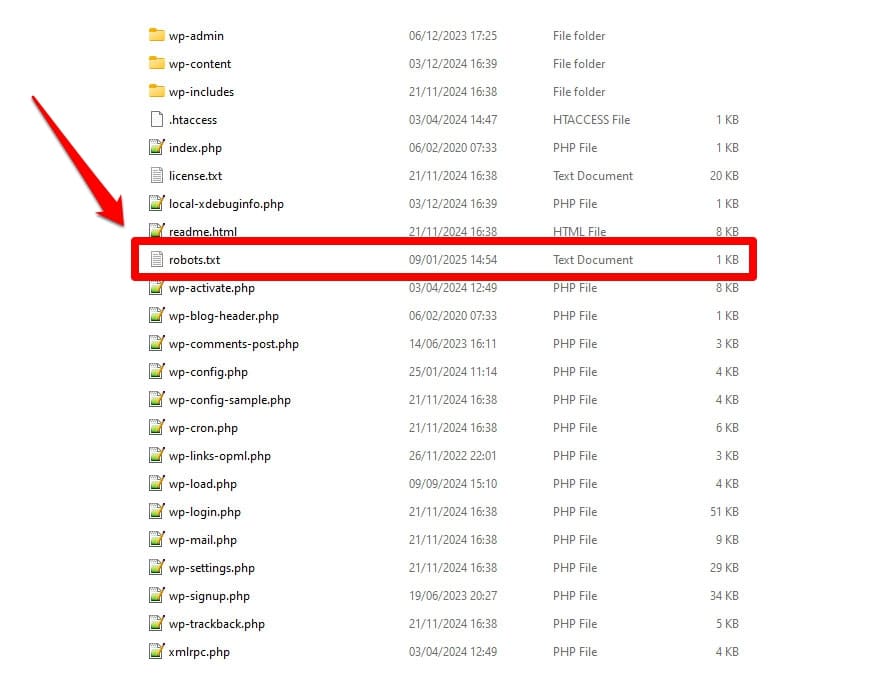

Jak wspomniano, plik robots.txt jest plikiem konfiguracyjnym serwera. Zwykle znajdziesz go w folderze głównym swojego serwera.

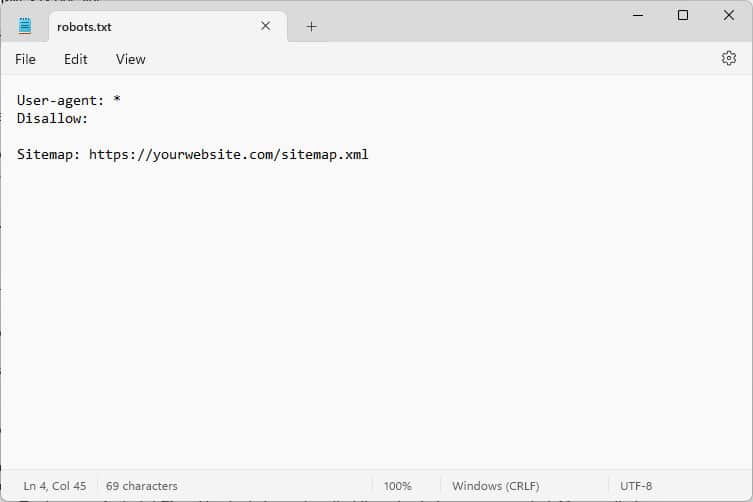

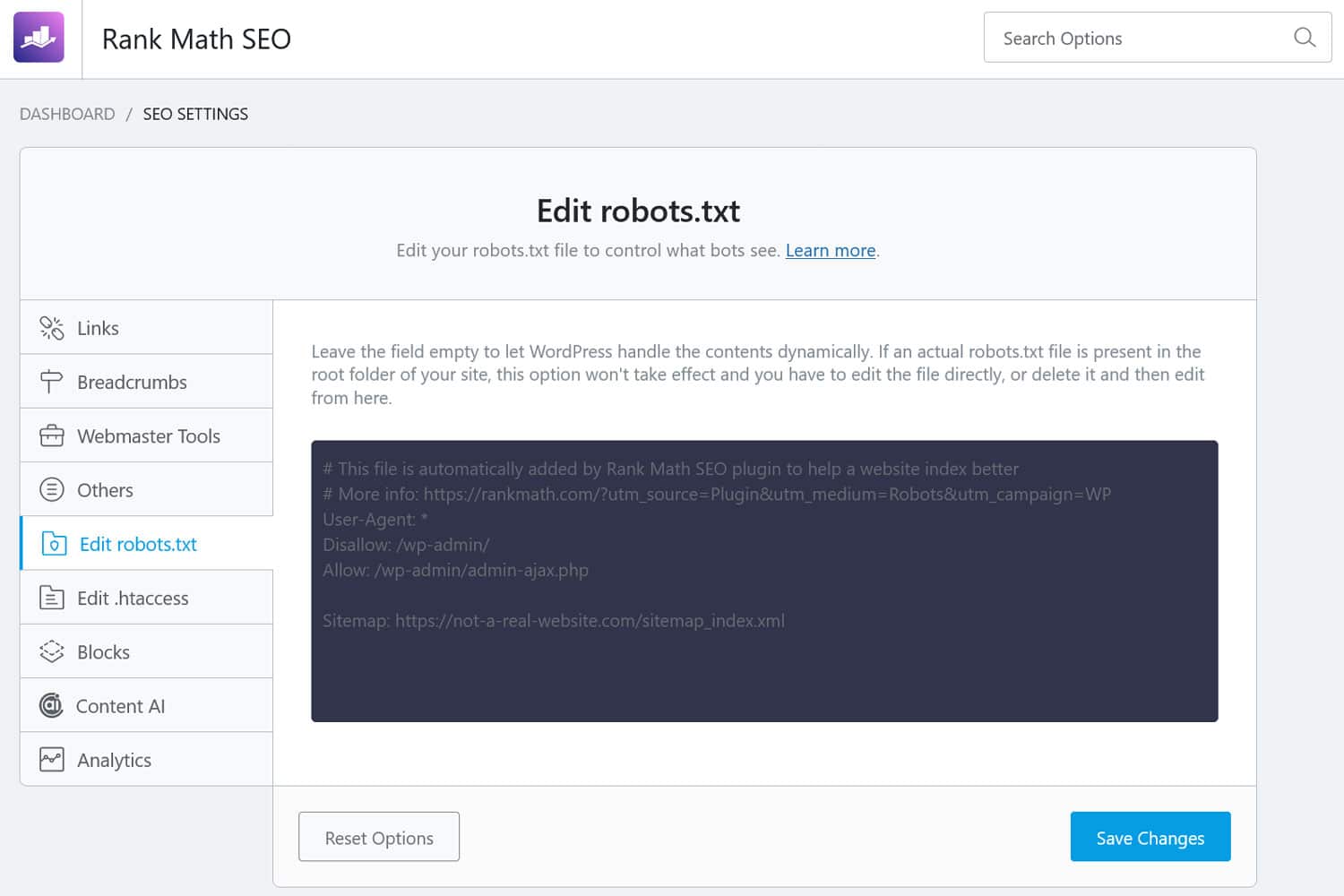

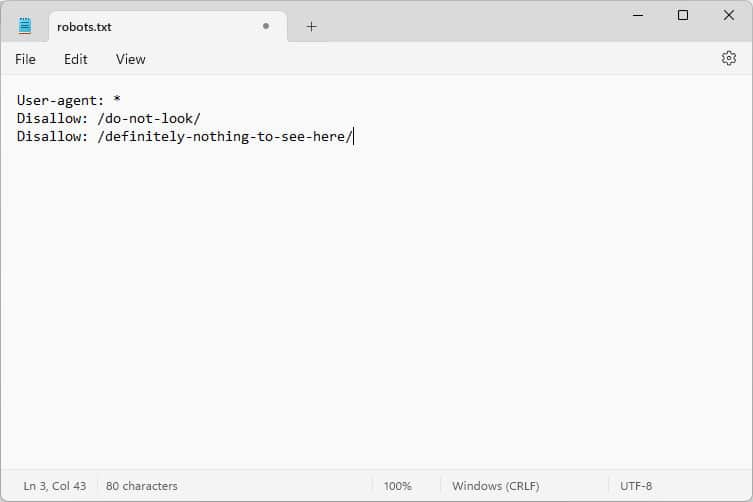

Po otwarciu zawartość wygląda mniej więcej tak:

Te fragmenty kodu to instrukcje, które mówią botom odwiedzającym Twoją witrynę, jak mają się zachować, gdy tam są — konkretnie, do których części witryny mają uzyskać dostęp, a do których nie.

Jakie boty, pytasz?

Najczęstszymi przykładami są automatyczne roboty indeksujące z wyszukiwarek poszukujące stron internetowych do indeksowania lub aktualizacji, ale także boty z modeli AI i inne zautomatyzowane narzędzia.

Jakie dyrektywy możesz przekazać za pomocą tego pliku?

Plik robots.txt zasadniczo zna cztery kluczowe dyrektywy:

- User-agent – określa dla kogo, czyli dla której grupy lub poszczególnych botów przeznaczone są poniższe reguły.

- Nie zezwalaj – określa katalogi, pliki lub zasoby, do których klient użytkownika nie ma dostępu.

- Zezwól – umożliwia ustawienie wyjątków, np. umożliwienie dostępu do poszczególnych folderów lub zasobów w katalogach, które w przeciwnym razie byłyby zabronione.

- Mapa witryny – wskazuje botom lokalizację adresu URL mapy witryny witryny.

Tylko User-agent i Disallow są obowiązkowe, aby plik mógł wykonać swoje zadanie; pozostałe dwie dyrektywy są opcjonalne. Na przykład w ten sposób blokujesz botom dostęp do Twojej witryny:

User-agent: * Disallow: /Gwiazdka oznacza, że poniższa reguła ma zastosowanie do wszystkich programów użytkownika. Ukośnik po Disallow oznacza, że wszystkie katalogi w tej witrynie są niedostępne. Jest to plik robots.txt, który zwykle można znaleźć w witrynach programistycznych, które nie powinny być indeksowane przez wyszukiwarki.

Możesz jednak także skonfigurować reguły dla poszczególnych botów:

User-agent: Googlebot Allow: /private/resources/Należy pamiętać, że plik robots.txt nie jest wiążący. Tylko boty z organizacji, które przestrzegają Protokołu wykluczania robotów, będą przestrzegać jego wskazówek. Złośliwe boty, na przykład te, które szukają luk w zabezpieczeniach Twojej witryny, mogą je ignorować i będą je ignorować, dlatego należy podjąć przeciwko nim dodatkowe środki.

Nawet organizacje przestrzegające tego standardu zignorują niektóre dyrektywy. O przykładach tego porozmawiamy poniżej.

Dlaczego plik robots.txt ma znaczenie?

Posiadanie pliku robots.txt w witrynie WordPress nie jest obowiązkowe. Twoja witryna będzie działać bez niej, a wyszukiwarki nie będą Cię karać za jej brak. Jednak włączenie jednego pozwala na:

- Trzymaj treści poza wynikami wyszukiwania, takimi jak strony logowania lub niektóre pliki multimedialne.

- Uniemożliwiaj robotom wyszukiwania marnowanie budżetu na nieistotne części witryny, co może skutkować ignorowaniem stron, które mają zaindeksować.

- Wskaż wyszukiwarkom mapę swojej witryny, aby mogły łatwiej przeglądać pozostałą część witryny.

- Chroń zasoby serwera, powstrzymując marnotrawne boty.

Wszystko to pomaga ulepszyć Twoją witrynę, szczególnie pod względem SEO, dlatego ważne jest, abyś wiedział, jak korzystać z pliku robots.txt.

Jak znaleźć, edytować i utworzyć plik robots.txt w WordPressie

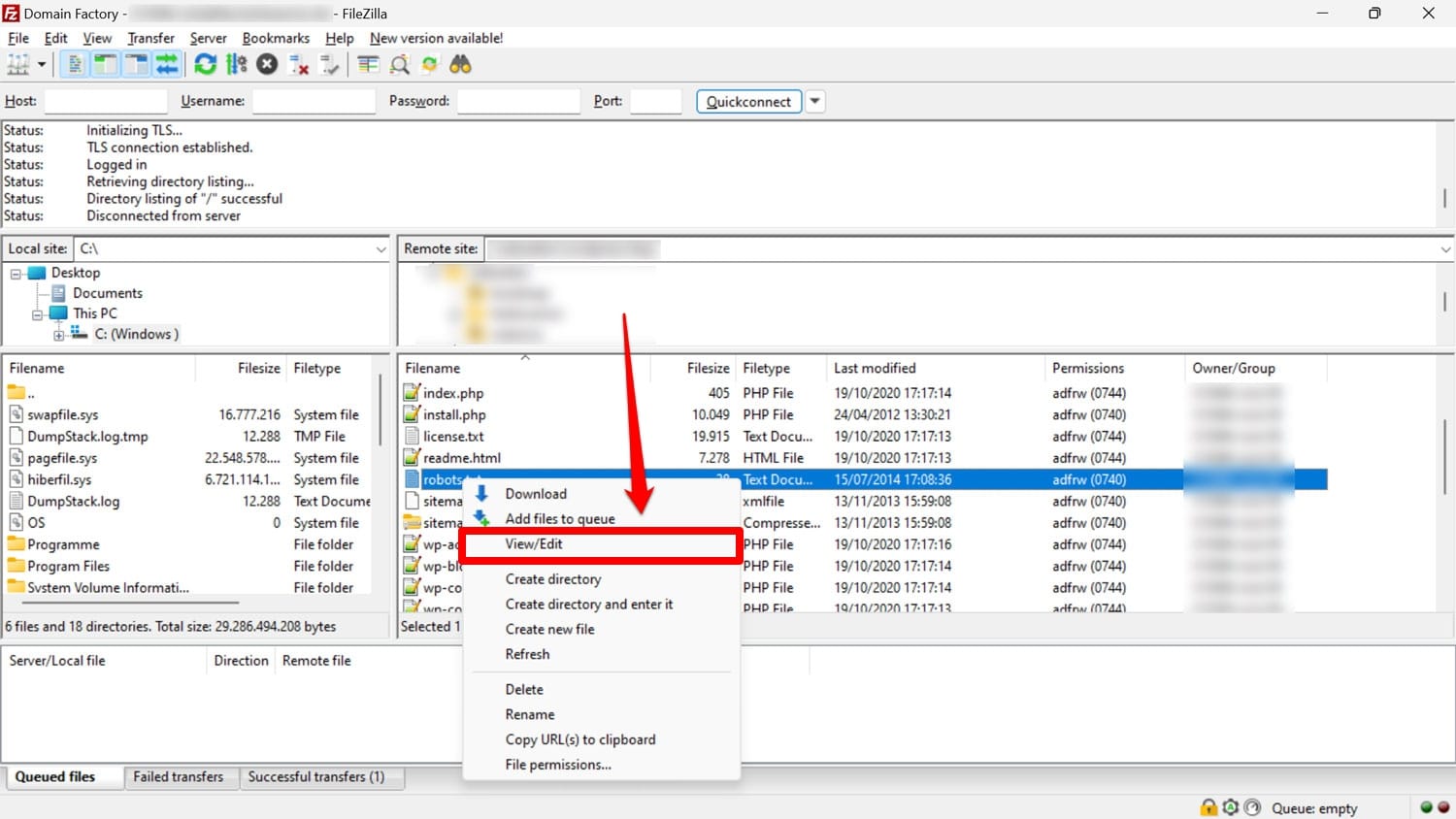

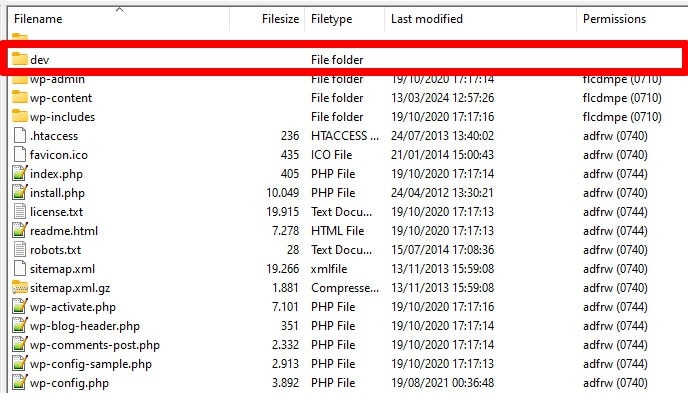

Jak wspomniano, plik robots.txt zwykle znajduje się w folderze głównym Twojej witryny na serwerze. Możesz uzyskać do niego dostęp za pomocą klienta FTP, takiego jak FileZilla, i edytować go za pomocą dowolnego edytora tekstu.

Jeśli go nie masz, możesz po prostu utworzyć pusty plik tekstowy, nadać mu nazwę „robots.txt”, wypełnić go dyrektywami i przesłać.

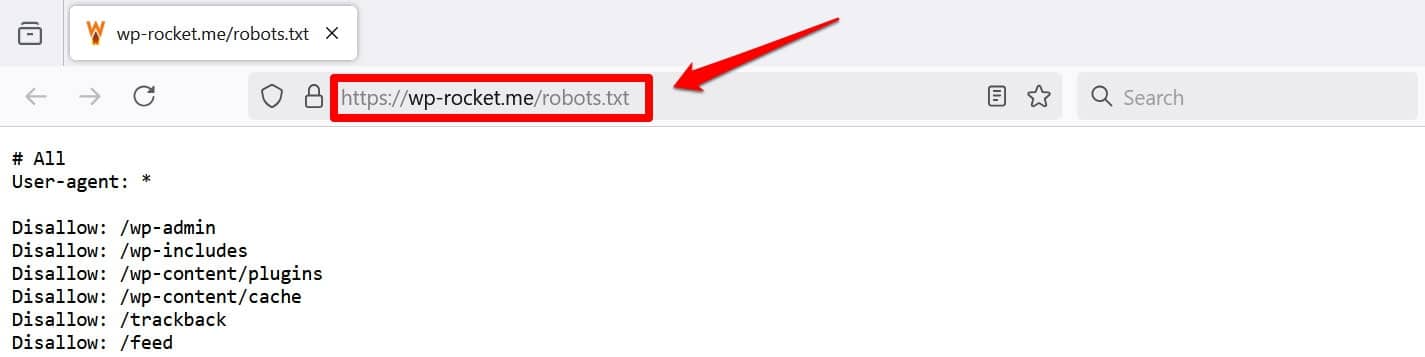

Innym sposobem, aby przynajmniej wyświetlić plik, jest dodanie /robots.txt do swojej domeny, np. https://wp-rocket.me/robots.txt.

Ponadto istnieją sposoby uzyskania dostępu do pliku z zaplecza WordPress. Wiele wtyczek SEO umożliwia przeglądanie i często wprowadzanie w nich zmian z poziomu interfejsu administracyjnego.

Alternatywnie możesz także użyć wtyczki takiej jak WPCode.

Jak wygląda dobry plik robots.txt WordPress?

Nie ma uniwersalnej odpowiedzi na pytanie, jakie dyrektywy powinny znajdować się w pliku Twojej witryny; to zależy od twojej konfiguracji. Oto przykład, który ma sens w przypadku wielu witryn WordPress:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php Sitemap: https://yourwebsite.com/sitemap.xmlW tym przykładzie można osiągnąć kilka wyników:

- Blokuje dostęp do obszaru administracyjnego

- Umożliwia dostęp do podstawowych funkcji administracyjnych

- Zapewnia lokalizację mapy witryny

Ta konfiguracja zapewnia równowagę pomiędzy bezpieczeństwem, wydajnością SEO i wydajnym indeksowaniem.

Nie popełniaj tych 14 błędów w pliku robots.txt WordPress

Jeśli Twoim celem jest konfiguracja i optymalizacja pliku robots.txt dla własnej witryny, pamiętaj, aby unikać następujących błędów.

1. Ignorowanie wewnętrznego pliku robots.txt WordPressa

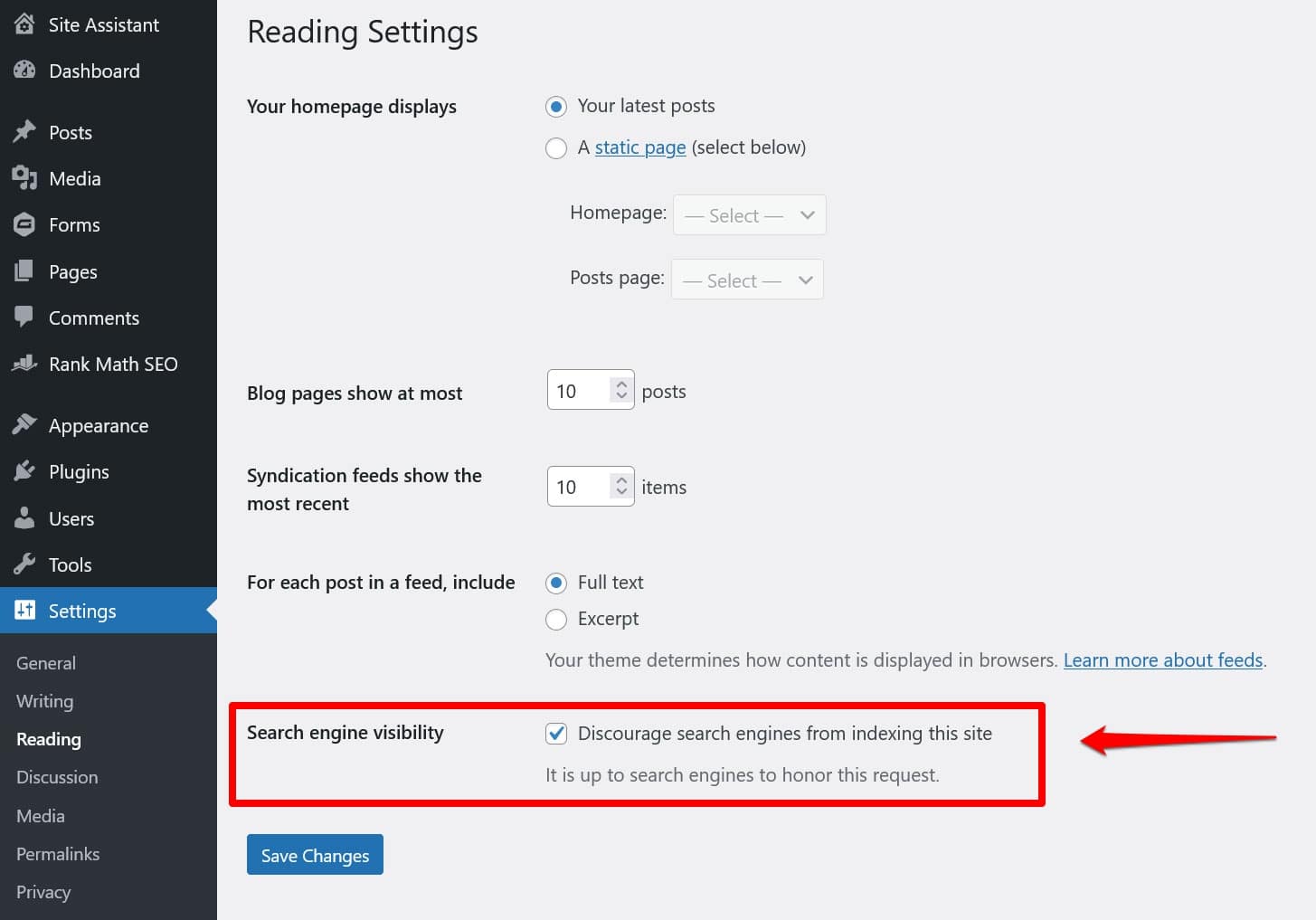

Nawet jeśli nie masz „fizycznego” pliku robots.txt w katalogu głównym swojej witryny, WordPress ma swój własny plik wirtualny. Jest to szczególnie ważne, jeśli zauważysz, że wyszukiwarki nie indeksują Twojej witryny.

W takim przypadku istnieje duża szansa, że włączyłeś opcję zniechęcającą ich do tego w Ustawieniach > Czytanie .

To nakłada dyrektywę, aby wszystkie roboty wyszukujące nie znajdowały się w wirtualnym pliku robots.txt. Aby ją wyłączyć, odznacz pole i zapisz je na dole.

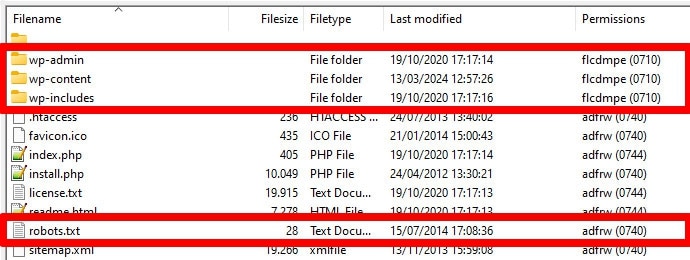

2. Umieszczenie go w złym miejscu

Boty, zwłaszcza roboty wyszukujące, szukają pliku robots.txt tylko w jednym miejscu — w katalogu głównym Twojej witryny. Jeśli umieścisz go gdziekolwiek indziej, na przykład w folderze, nie znajdą go i zignorują.

Twój katalog główny powinien znajdować się tam, gdzie wylądujesz, gdy uzyskasz dostęp do serwera przez FTP, chyba że umieściłeś WordPress w podkatalogu. Jeśli widzisz foldery wp-admin , wp-content i wp-includes , jesteś we właściwym miejscu.

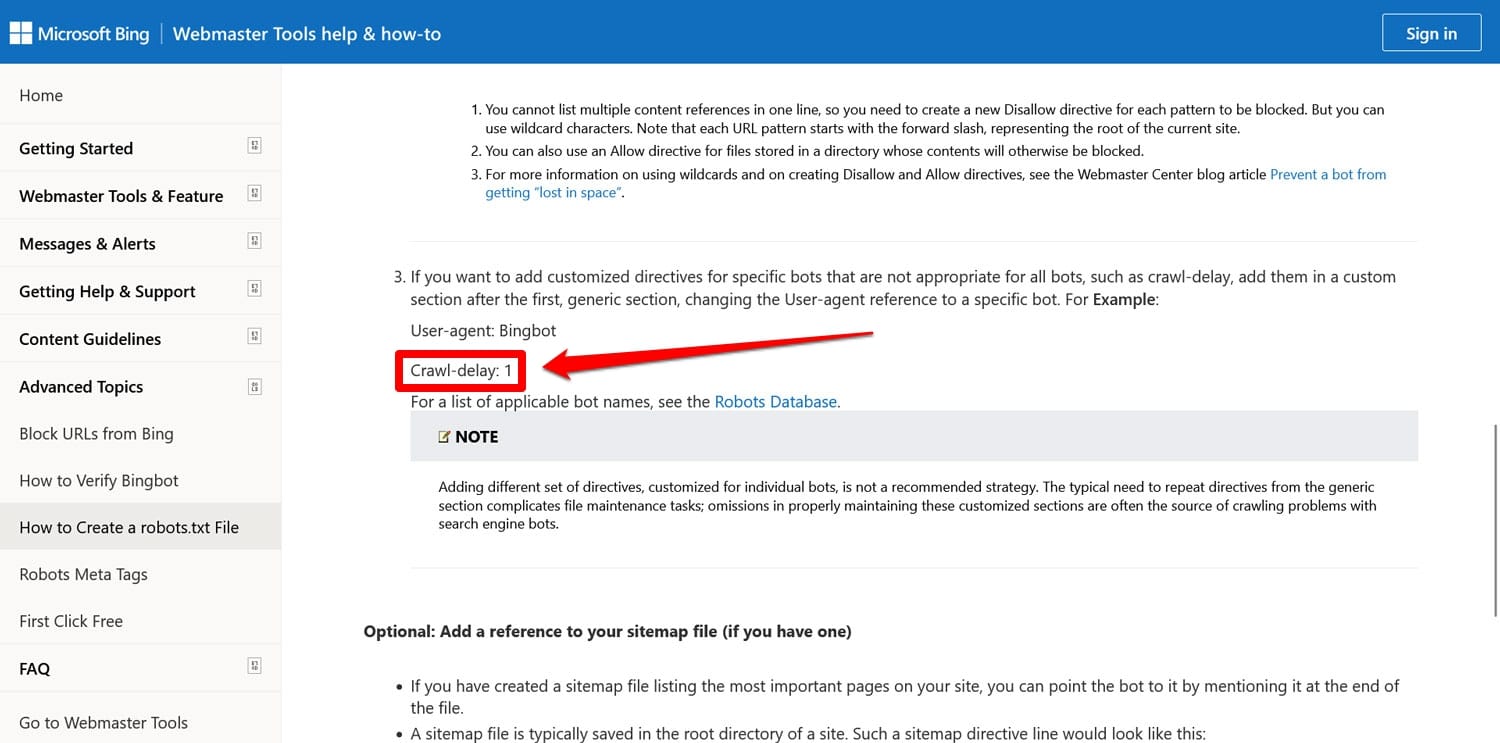

3. Uwzględnianie nieaktualnych znaczników

Oprócz dyrektyw wymienionych powyżej, w plikach robots.txt starszych witryn internetowych można jeszcze znaleźć dwie kolejne:

- Noindex – służy do określania adresów URL, których wyszukiwarki nie powinny indeksować w Twojej witrynie.

- Opóźnienie indeksowania – dyrektywa mająca na celu ograniczenie przeszukiwaczy, aby nie przeciążały zasobów serwera WWW.

Obie te dyrektywy są obecnie ignorowane, przynajmniej przez Google. Przynajmniej Bing nadal honoruje opóźnienie indeksowania.

W większości przypadków najlepiej nie używać tych dyrektyw. Pomaga to zachować przejrzystość pliku i zmniejsza ryzyko błędów.

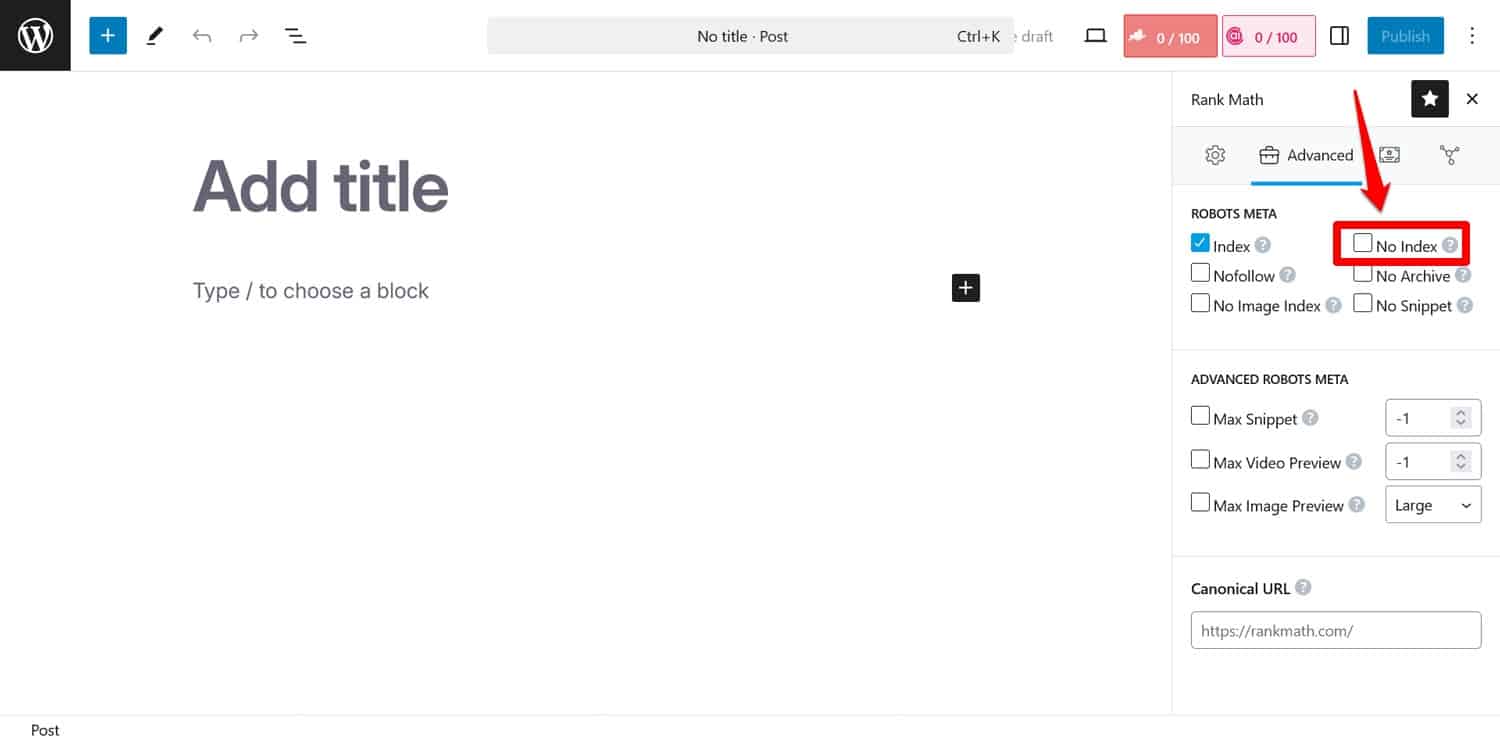

Wskazówka: jeśli Twoim celem jest uniemożliwienie wyszukiwarkom indeksowania określonych stron, użyj zamiast tego metatagu noindex . Możesz to zaimplementować za pomocą wtyczki SEO dla poszczególnych stron.

Jeśli zablokujesz strony za pomocą pliku robots.txt, roboty nie dotrą do części, w której widzą tag noindex . W ten sposób mogą nadal indeksować Twoją stronę, ale bez jej zawartości, co jest gorsze.

4. Blokowanie niezbędnych zasobów

Jednym z błędów popełnianych przez ludzi jest używanie pliku robots.txt do blokowania dostępu do wszystkich arkuszy stylów (plików CSS) i skryptów (plików JavaScript) w witrynie WordPress w celu oszczędzania budżetu indeksowania.

Jednak to nie jest dobry pomysł. Boty wyszukiwarek renderują strony, aby „zobaczyć” je w taki sam sposób, jak robią to odwiedzający. Pomaga im to zrozumieć treść i odpowiednio ją zaindeksować.

Blokując te zasoby, możesz dać wyszukiwarkom błędne wrażenie na temat swoich stron, co może spowodować, że nie będą one prawidłowo indeksowane lub zaszkodzić ich rankingowi.

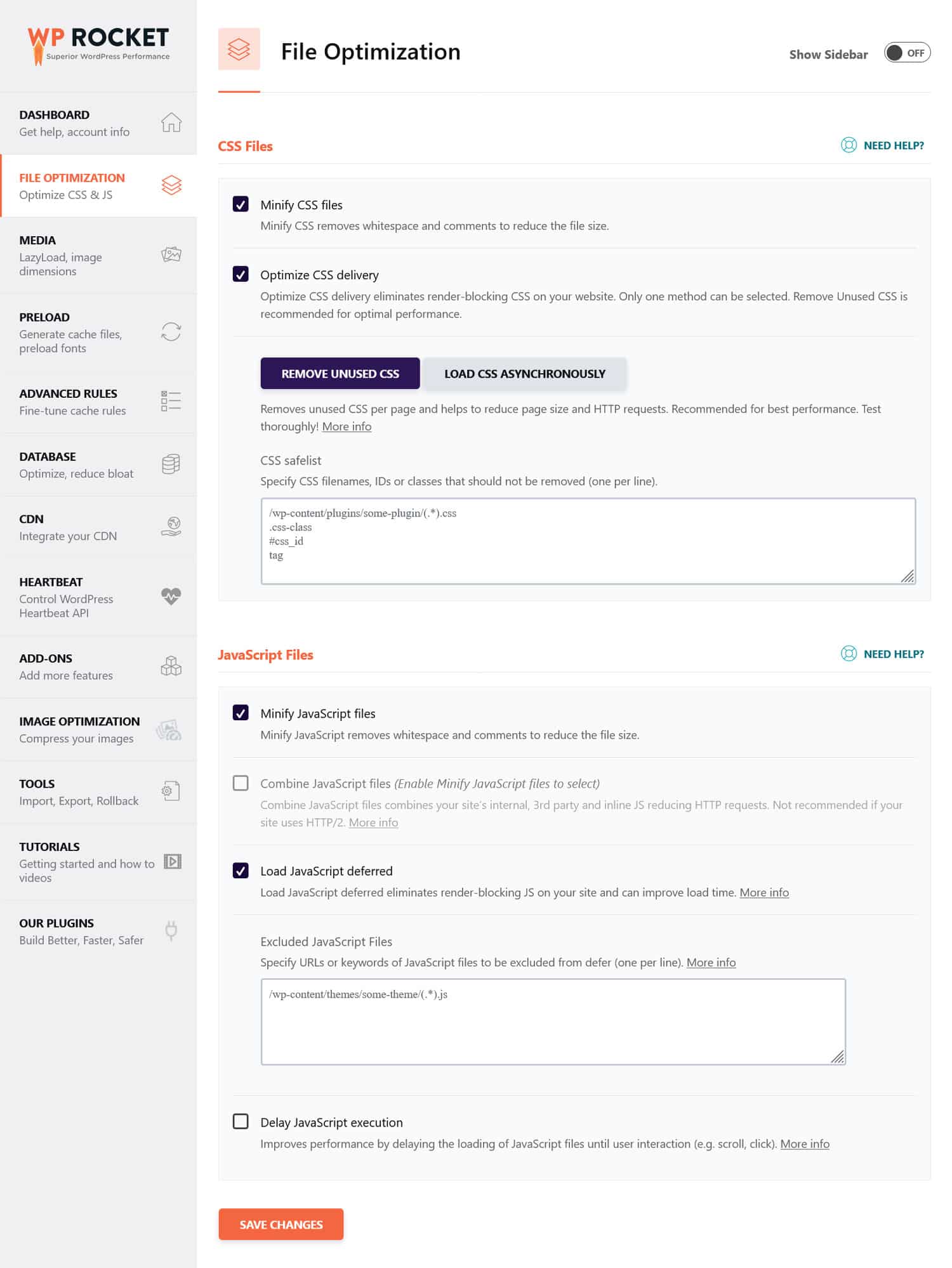

Jeśli uważasz, że pliki CSS i JavaScript mogą utrudniać działanie Twojej witryny, lepszym pomysłem jest ich zoptymalizowanie, aby szybko się ładowały, zarówno dla botów, jak i zwykłych gości. Możesz to zrobić, minimalizując kod i kompresując pliki witryny, aby były szybciej przesyłane. Ponadto możliwa jest optymalizacja ich dostarczania poprzez eliminację nieużywanego kodu i odroczenie zasobów blokujących renderowanie.

Wskazówka : możesz uprościć ten proces, używając wtyczki wydajnościowej, takiej jak WP Rocket. Przyjazny dla użytkownika interfejs umożliwia optymalizację dostarczania plików poprzez zaznaczenie kilku pól w menu Optymalizacja pliku .

WP Rocket zawiera również dodatkowe funkcje poprawiające wydajność witryny, w tym:

- Buforowanie z dedykowaną mobilną pamięcią podręczną

- Leniwe ładowanie zdjęć i filmów

- Wstępne ładowanie pamięci podręcznej, łączy, plików zewnętrznych i czcionek

- Optymalizacja bazy danych

Dodatkowo wtyczka automatycznie realizuje wiele kroków optymalizacyjnych. Przykłady obejmują buforowanie przeglądarki i serwera, kompresję GZIP i optymalizację obrazów na ekranie w celu poprawy LCP. W ten sposób Twoja witryna będzie działać szybciej, po prostu włączając WP Rocket.

Wtyczka oferuje również 14-dniową gwarancję zwrotu pieniędzy, dzięki czemu możesz ją przetestować bez ryzyka.

5. Niepowodzenie aktualizacji pliku robots.txt

Tworząc witrynę internetową, programiści zazwyczaj dołączają plik robots.txt, który zabrania wszystkim botom dostępu do niej. To ma sens; ostatnią rzeczą, jakiej chcesz, jest to, aby Twoja niedokończona witryna pojawiła się w wynikach wyszukiwania.

Problem pojawia się tylko wtedy, gdy przypadkowo przeniesiesz ten plik na serwer produkcyjny i zablokujesz wyszukiwarkom możliwość indeksowania również Twojej działającej witryny. Zdecydowanie sprawdź to, jeśli Twoje treści nie pojawiają się w wynikach wyszukiwania.

6. Brak łącza do mapy witryny

Link do mapy witryny w pliku robots.txt zapewnia robotom wyszukiwarek listę całej zawartości. Zwiększa to Twoje szanse, że zaindeksują nie tylko bieżącą stronę, na której wylądowali.

Wystarczy jedna linia:

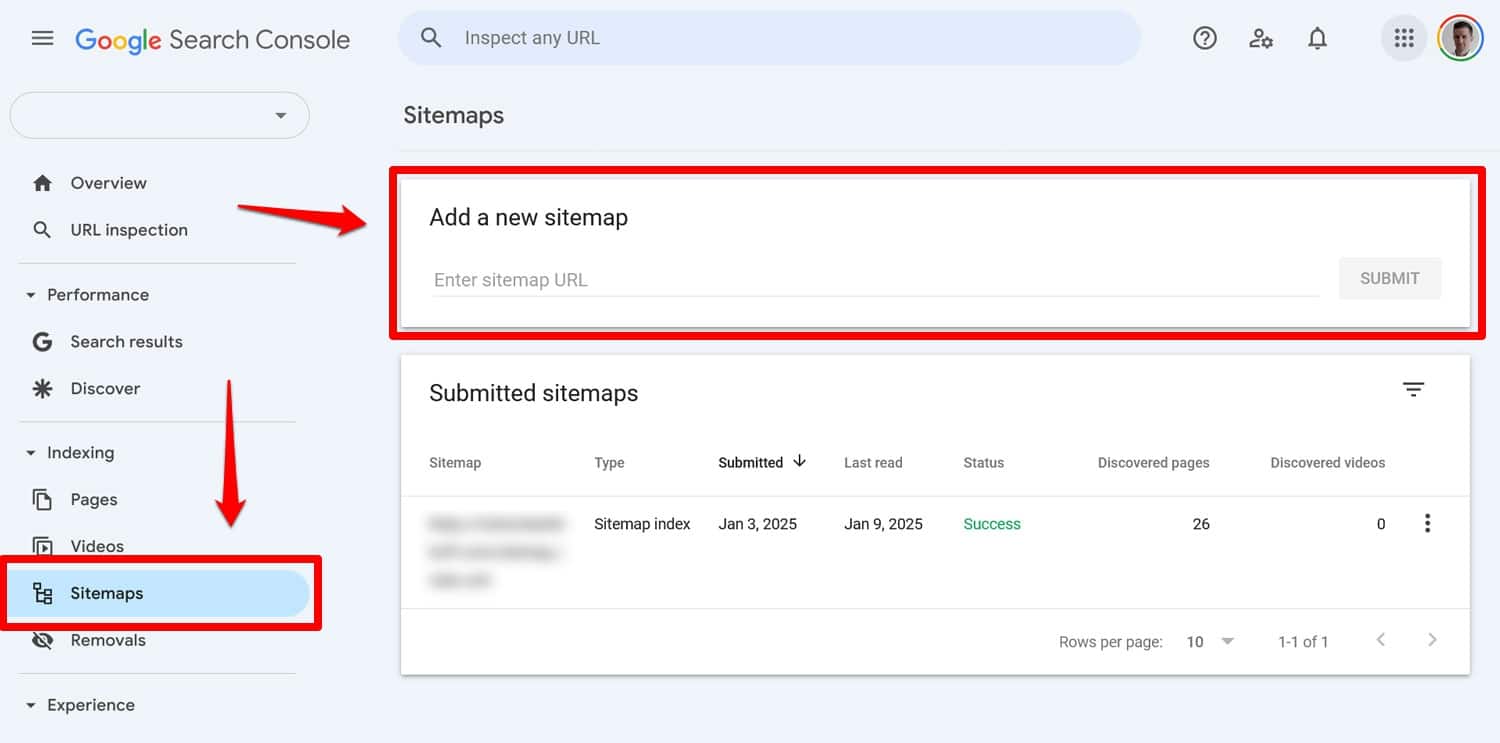

Sitemap: https://yourwebsite.com/sitemap.xmlTak, możesz także przesłać mapę witryny bezpośrednio w narzędziach takich jak Google Search Console.

Jednak umieszczenie go w pliku robots.txt jest nadal przydatne, szczególnie w przypadku wyszukiwarek, których narzędzi dla webmasterów nie używasz.

7. Używanie sprzecznych zasad

Częstym błędem przy tworzeniu pliku robots.txt jest dodanie sprzecznych ze sobą reguł, takich jak:

User-agent: * Disallow: /blog/ Allow: /blog/Powyższe dyrektywy pozostawiają wyszukiwarkom niejasność co do tego, czy powinny indeksować katalog /blog/, czy nie. Prowadzi to do nieprzewidywalnych wyników i może zaszkodzić Twojemu SEO.

| Zastanawiasz się, co jeszcze może mieć szkodliwy wpływ na rankingi Twojej witryny w wynikach wyszukiwania i jak tego uniknąć? O tym dowiesz się z naszego przewodnika po błędach SEO. |

Aby uniknąć konfliktów, postępuj zgodnie z poniższymi najlepszymi praktykami:

- Najpierw użyj szczegółowych zasad – umieść bardziej szczegółowe zasady przed szerszymi.

- Unikaj nadmiarowości — nie dołączaj przeciwstawnych dyrektyw dla tej samej ścieżki.

- Przetestuj plik robots.txt — użyj narzędzi, aby sprawdzić, czy reguły działają zgodnie z oczekiwaniami. Więcej na ten temat poniżej.

8. Próba ukrycia poufnych treści za pomocą pliku robots.txt

Jak wspomniano wcześniej, plik robots.txt nie jest narzędziem pozwalającym trzymać treść poza wynikami wyszukiwania. W rzeczywistości, ponieważ plik jest publicznie dostępny, użycie go do zablokowania poufnych treści może w sposób niezamierzony ujawnić dokładne położenie tej treści.

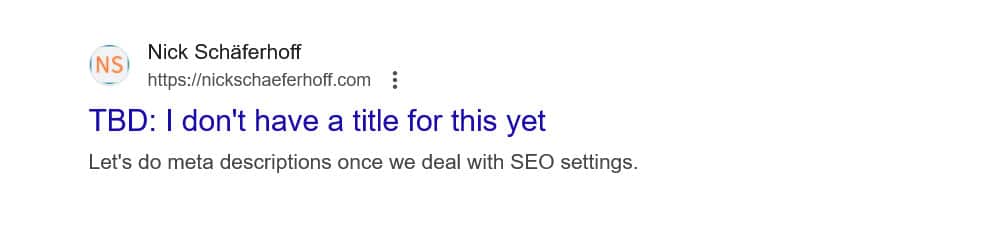

Wskazówka : użyj metatagu noindex , aby nie wyświetlać treści w wynikach wyszukiwania. Dodatkowo chroń hasłem wrażliwe obszary swojej witryny, aby chronić je zarówno przed robotami, jak i nieautoryzowanymi użytkownikami.

9. Niewłaściwe użycie symboli wieloznacznych

Symbole wieloznaczne pozwalają na dołączenie do dyrektyw dużych grup ścieżek lub plików. Spotkaliśmy już jeden wcześniej, symbol *. Oznacza „każdą instancję” i jest najczęściej używany do konfigurowania reguł mających zastosowanie do wszystkich programów użytkownika.

Innym symbolem wieloznacznym jest $, który stosuje reguły do końcowej części adresu URL. Możesz go użyć, na przykład, jeśli chcesz uniemożliwić robotom dostęp do wszystkich plików PDF w Twojej witrynie:

Disallow: /*.pdf$Chociaż symbole wieloznaczne są przydatne, mogą mieć daleko idące konsekwencje. Używaj ich ostrożnie i zawsze testuj plik robots.txt, aby upewnić się, że nie popełniłeś żadnych błędów.

10. Mylenie bezwzględnych i względnych adresów URL

Oto różnica między bezwzględnymi i względnymi adresami URL:

- Bezwzględny adres URL – https://yourwebsite.com/private/

- Względny adres URL – /prywatny/

Zaleca się używanie względnych adresów URL w dyrektywach pliku robots.txt, na przykład:

Disallow: /private/Bezwzględne adresy URL mogą powodować problemy, w przypadku których boty mogą zignorować lub błędnie zinterpretować dyrektywę. Jedynym wyjątkiem jest ścieżka do mapy witryny, która musi być bezwzględnym adresem URL.

11. Ignorowanie rozróżniania wielkości liter

W dyrektywach w pliku robots.txt rozróżniana jest wielkość liter. Oznacza to, że poniższe dwie dyrektywy nie są zamienne:

Disallow: /Private/ Disallow: /private/Jeśli zauważysz, że plik robots.txt nie zachowuje się zgodnie z oczekiwaniami, sprawdź, czy przyczyną może być nieprawidłowe użycie wielkich liter.

12. Nieprawidłowe użycie końcowych ukośników

Ukośnik końcowy to ukośnik na końcu adresu URL:

- Bez końcowego ukośnika : /directory

- Z końcowym ukośnikiem : /katalog/

W pliku robots.txt decyduje, które zasoby witryny są dozwolone, a które niedozwolone. Oto przykład:

Disallow: /private/Powyższa reguła blokuje robotom dostęp do „prywatnego” katalogu w Twojej witrynie i wszystkiego, co się w niej znajduje. Z drugiej strony, powiedzmy, że pomijasz końcowy ukośnik, w ten sposób:

Disallow: /privateW takim przypadku reguła blokuje także inne wystąpienia w Twojej witrynie rozpoczynające się od „prywatnego”, takie jak:

- https://twojastrona.com/private.html

- https://twojastrona internetowa.com/privateer

Dlatego ważne jest, aby zachować precyzję. W razie wątpliwości przetestuj swój plik.

13. Brak pliku robots.txt dla subdomen

Każda subdomena w Twojej witrynie (np. dev.yourwebsite.com) potrzebuje własnego pliku robots.txt, ponieważ wyszukiwarki traktują je jako osobne podmioty internetowe. Bez pliku istnieje ryzyko, że roboty indeksujące zaindeksują części Twojej witryny, które zamierzałeś ukryć.

Na przykład, jeśli Twoja wersja rozwojowa znajduje się w folderze o nazwie „dev” i korzysta z subdomeny, upewnij się, że zawiera ona dedykowany plik robots.txt, który blokuje roboty wyszukiwania.

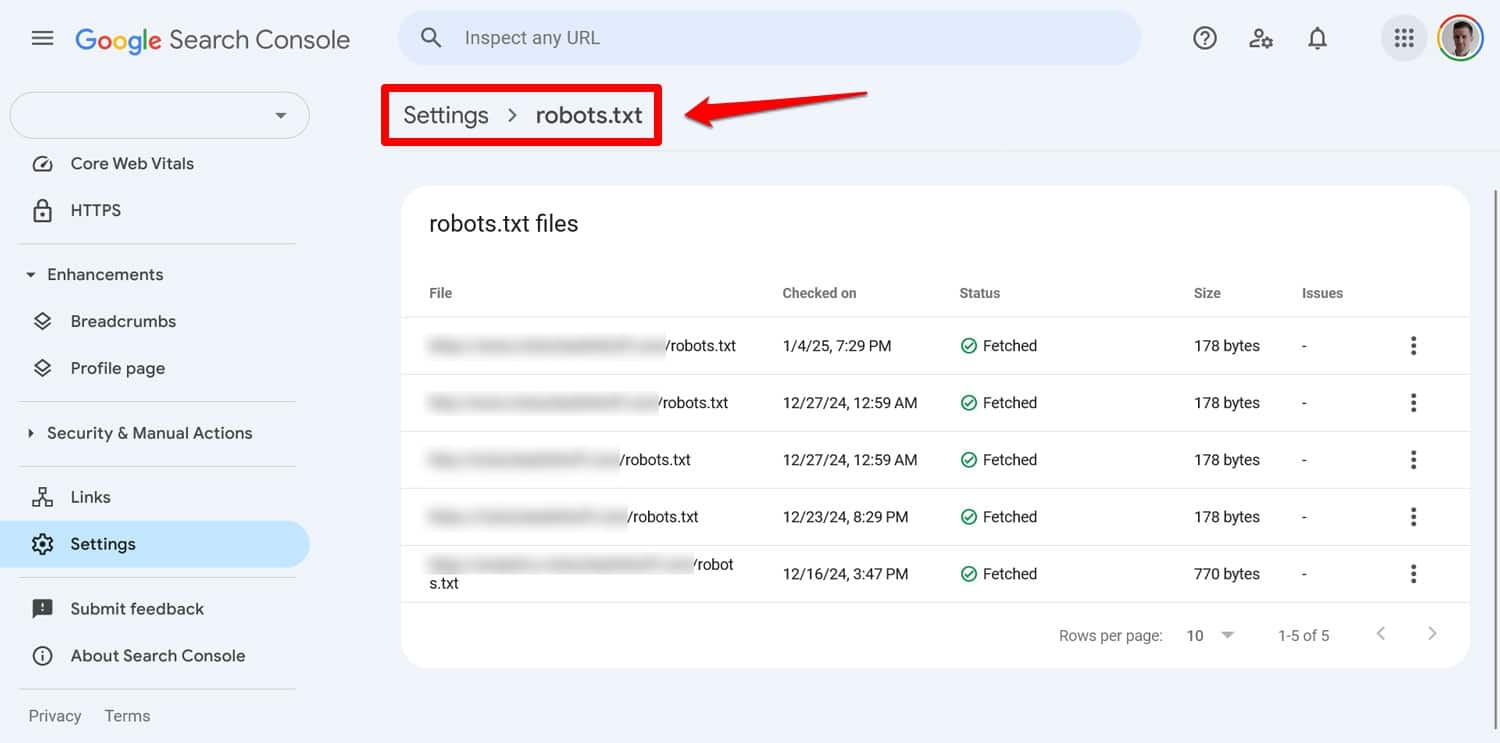

14. Brak testowania pliku robots.txt

Jednym z największych błędów podczas konfigurowania pliku robots.txt WordPress jest brak jego przetestowania, szczególnie po wprowadzeniu zmian.

Jak widzieliśmy, nawet małe błędy w składni lub logice mogą powodować poważne problemy SEO. Dlatego zawsze testuj plik robots.txt.

Wszelkie problemy z plikiem możesz sprawdzić w Google Search Console w obszarze Ustawienia > robots.txt .

Innym sposobem jest symulacja zachowania pełzającego za pomocą narzędzia takiego jak Screaming Frog. Ponadto użyj środowiska testowego, aby sprawdzić wpływ nowych reguł przed zastosowaniem ich w działającej witrynie.

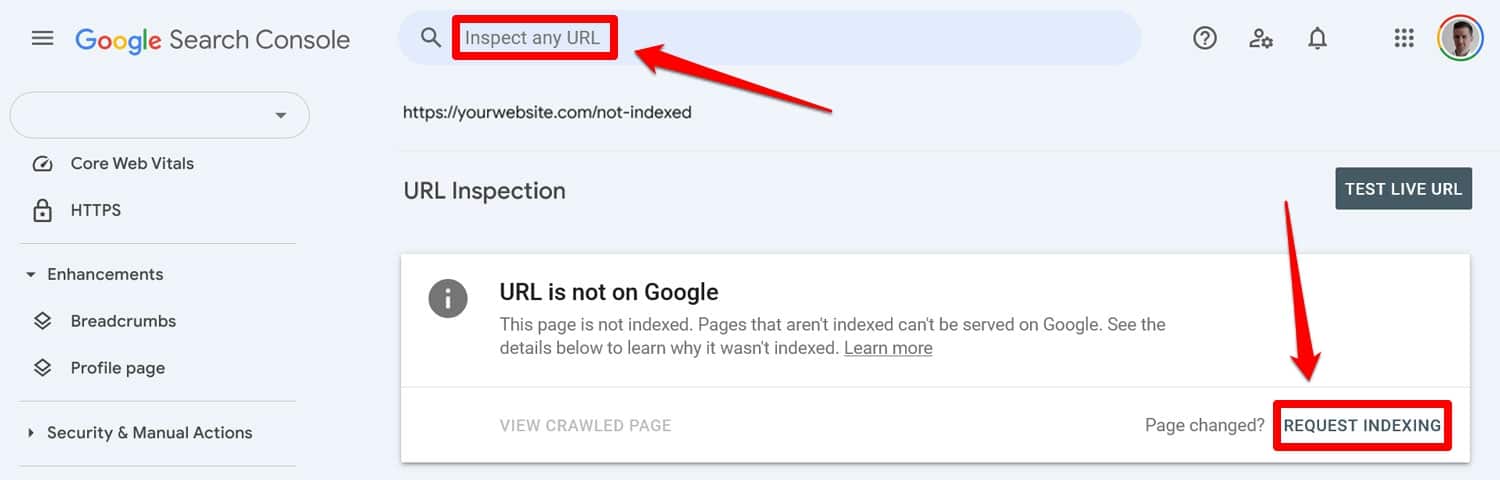

Jak naprawić błąd po błędzie pliku robots.txt

Błędy w pliku robots.txt są łatwe do popełnienia, ale na szczęście zwykle można je łatwo naprawić, gdy tylko je wykryjesz.

Zacznij od uruchomienia zaktualizowanego pliku robots.txt za pomocą narzędzia testowego. Następnie, jeśli strony były wcześniej blokowane przez dyrektywy robots.txt, wprowadź je ręcznie w Google Search Console lub Bing Webmaster Tools, aby poprosić o zaindeksowanie.

Dodatkowo prześlij ponownie aktualną wersję mapy witryny.

Potem to już tylko gra na czekanie. Wyszukiwarki ponownie odwiedzą Twoją witrynę i, miejmy nadzieję, szybko przywrócą Twoje miejsce w rankingach.

Przejmij kontrolę nad swoim plikiem robots.txt w WordPressie

W przypadku plików robots.txt uncja zapobiegania jest lepsza niż funt leczenia. Szczególnie w przypadku większych witryn internetowych wadliwy plik może siać spustoszenie w rankingach, ruchu i przychodach.

Z tego powodu wszelkie zmiany w pliku robots.txt witryny należy wprowadzać ostrożnie i po dokładnych testach. Świadomość błędów, które możesz popełnić, jest pierwszym krokiem, aby im zapobiec.

Kiedy popełnisz błąd, staraj się nie panikować. Zdiagnozuj, co jest nie tak, popraw wszelkie błędy i prześlij ponownie mapę witryny, aby umożliwić jej ponowne zaindeksowanie.

Na koniec upewnij się, że wydajność nie jest powodem, dla którego wyszukiwarki nie indeksują prawidłowo Twojej witryny. Wypróbuj WP Rocket teraz, aby natychmiast przyspieszyć swoją witrynę!