Lista robotów indeksujących strony internetowe: 10 najczęstszych, które wyprzedzą konkurencję w 2024 r

Opublikowany: 2023-12-09Czy kiedykolwiek miałeś problem z utrzymaniem dynamiki i przyjazności dla SEO witryny dzięki ciągłym aktualizacjom? W przypadku setek lub tysięcy stron ręczne przesyłanie aktualizacji do wyszukiwarek staje się wyzwaniem. Kluczowe pytanie brzmi: jak zapewnić, że częste aktualizacje treści będą miały pozytywny wpływ na rankingi SEO? Rozwiązaniem są boty indeksujące. Te boty przeglądają mapę witryny, indeksują nowe aktualizacje i odgrywają kluczową rolę w ulepszaniu SEO. Na tym blogu przygotowaliśmy listę robotów indeksujących, dzięki którym Twoja praca będzie łatwa i płynna.

Co to jest przeszukiwacz sieci i jak działa?

Robot sieciowy to zautomatyzowany program komputerowy przeznaczony do powtarzalnych czynności, w szczególności nawigacji i indeksowania dokumentów online. Wyszukiwarki takie jak Google często używają go do automatyzacji przeglądania i tworzenia indeksu treści internetowych. Termin „robot” jest synonimem „Bota” lub „Pająka”, a Googlebot jest dobrze znanym przykładem.

Teraz pojawia się pytanie, jak działają roboty indeksujące?

Roboty indeksujące rozpoczynają od pobrania pliku robot.txt witryny internetowej, który zawiera mapy witryn zawierające adresy URL kwalifikujące się do przeszukiwania. Podczas nawigacji po stronach roboty indeksujące identyfikują nowe adresy URL za pomocą hiperłączy i dodają je do kolejki indeksowania w celu późniejszej potencjalnej eksploracji.

Różne typy robotów indeksujących: w pigułce

Tworzenie kompilacji kategorii przeszukiwaczy sieciowych obejmuje rozpoznanie trzech głównych klasyfikacji: wewnętrzne przeszukiwacze sieciowe , komercyjne przeszukiwacze sieciowe i przeszukiwacze sieciowe typu open source . Zanim zagłębimy się w ostateczną listę robotów sieciowych, zapoznajmy się z tymi robotami indeksującymi.

Wewnętrzny moduł przeszukiwania sieci: te narzędzia przeszukiwacza sieci są tworzone wewnętrznie przez organizacje w celu poruszania się po określonych witrynach internetowych i służą różnym celom, takim jak generowanie map witryn i skanowanie w poszukiwaniu uszkodzonych łączy .

Komercyjne narzędzia do przeszukiwania sieci: Komercyjne narzędzia do przeszukiwania sieci to narzędzia dostępne na rynku w sprzedaży i są zazwyczaj opracowywane przez firmy specjalizujące się w takim oprogramowaniu. Ponadto niektóre czołowe korporacje mogą wykorzystywać specjalnie zaprojektowane pająki, dostosowane do ich unikalnych wymagań dotyczących indeksowania witryn internetowych.

Robot indeksujący o otwartym kodzie źródłowym: Z drugiej strony roboty przeszukiwające o otwartym kodzie źródłowym są publicznie dostępne w ramach licencji wolnych/otwartych, co pozwala użytkownikom na ich wykorzystanie i dostosowywanie zgodnie z ich preferencjami.

Chociaż mogą brakować im pewnych zaawansowanych funkcji dostępnych w ich komercyjnych odpowiednikach, dają użytkownikom możliwość zagłębienia się w kod źródłowy i uzyskania wglądu w mechanikę przeszukiwania sieci.

Skompilowana lista robotów indeksujących strony internetowe: najpopularniejsze w 2024 r

Żaden pojedynczy robot nie jest zaprojektowany do obsługi całego obciążenia każdej wyszukiwarki. Zamiast tego istnieje różnorodny wachlarz robotów indeksujących, które oceniają zawartość Twoich stron internetowych, skanują je z korzyścią dla użytkowników na całym świecie i spełniają różne wymagania różnych wyszukiwarek. Przyjrzyjmy się teraz listom robotów sieciowych, które są obecnie używane.

Googlebota

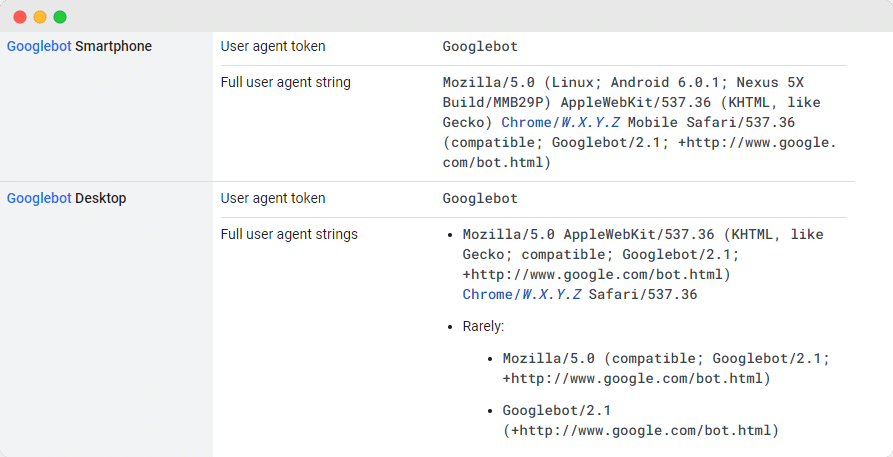

Googlebot , ogólne narzędzie Google do przeszukiwania sieci, odgrywa kluczową rolę w skanowaniu stron internetowych w celu umieszczenia ich w wyszukiwarce Google. Chociaż technicznie istnieją dwie wersje – Googlebot Desktop i Googlebot Smartphone (mobile) – wielu ekspertów traktuje je jako jeden robot.

Jedność ta jest utrzymywana dzięki wspólnemu, unikalnemu tokenowi produktu (nazywanemu tokenem agenta użytkownika) określonemu w pliku robots.txt każdej witryny, przy czym agentem użytkownika jest po prostu „Googlebot”.

Googlebot regularnie uzyskuje dostęp do Twojej witryny, zazwyczaj co kilka sekund, chyba że zostanie celowo zablokowany w pliku robots.txt witryny. Zeskanowane strony są przechowywane w scentralizowanej bazie danych zwanej Google Cache, co pozwala na przeglądanie historycznych wersji Twojej witryny.

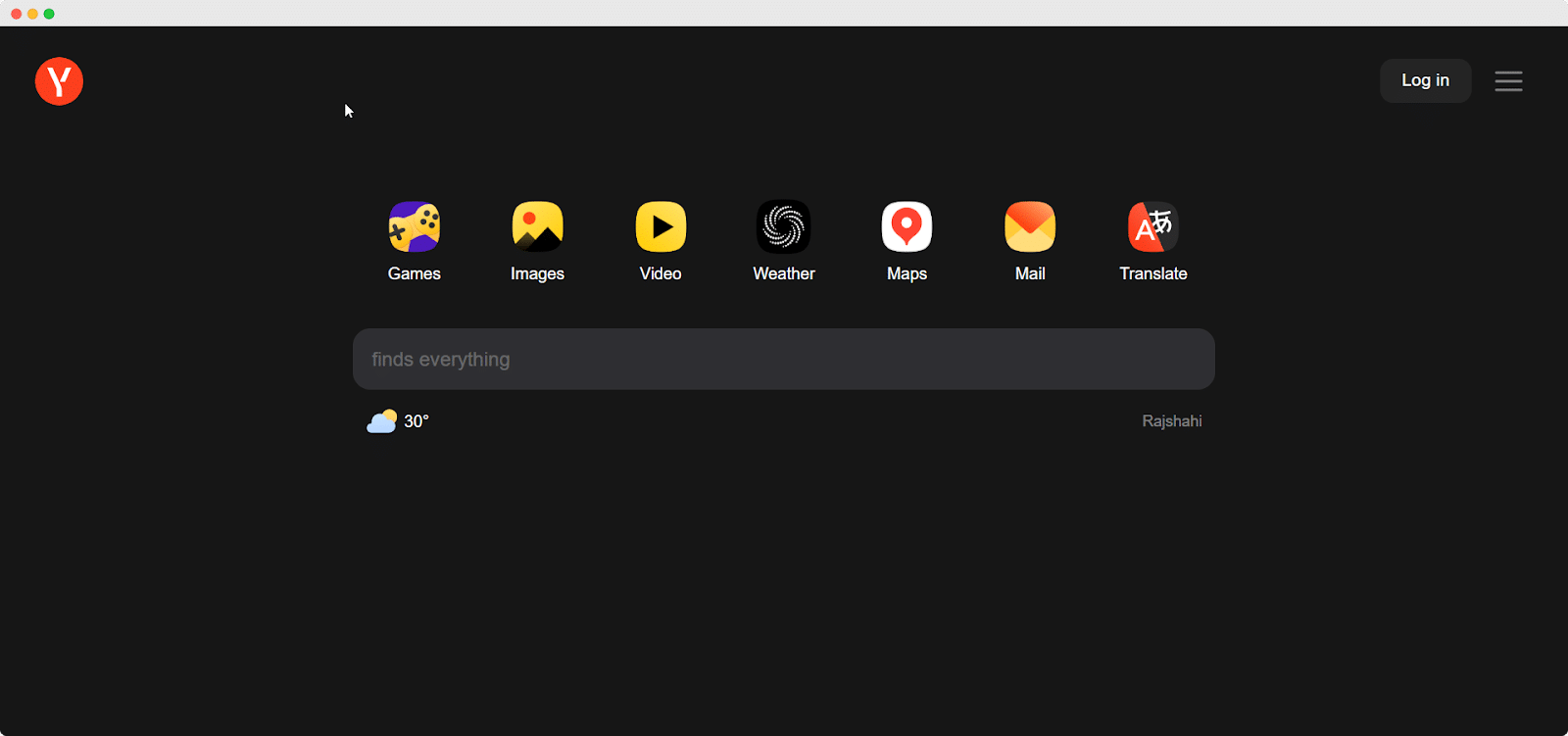

Yandexbot

Yandex Spider to jedno z najlepszych narzędzi do przeszukiwania sieci, zaprojektowane wyłącznie dla rosyjskiej platformy wyszukiwania Yandex , która jest jedną z głównych i powszechnie używanych wyszukiwarek w Rosji. Administratorzy witryn mają możliwość udzielenia dostępu Yandex Spider poprzez konfigurację stron swojej witryny w pliku robots.txt.

Co więcej, mogą zwiększyć dostępność poprzez dodanie tagu Yandex.Metrica do wybranych stron, aktualizację indeksowania stron za pomocą narzędzi Yandex dla webmasterów lub wykorzystanie protokołu IndexNow — ekskluzywnego raportu identyfikującego nowe, zmienione lub dezaktywowane strony.

Bot Kaczka

DuckDuckBot działa jako robot wyszukiwarki DuckDuckGo, zapewniając prywatność w Twojej przeglądarce internetowej. Właściciele witryn mogą uzyskać dostęp do interfejsu API DuckDuckBot, aby sprawdzić, czy ich witryna została zaindeksowana.

Podczas tego procesu DuckDuckBot aktualizuje swoją bazę danych API o nowe adresy IP i programy klienckie, pomagając webmasterom w wykrywaniu potencjalnych oszustów lub szkodliwych botów próbujących połączyć się z DuckDuckBot.

Bingbot

W 2010 roku firma Microsoft opracowała Bingbota do analizowania i katalogowania adresów URL, zapewniając, że Bing dostarcza trafne i aktualne wyniki wyszukiwania. Podobnie jak w przypadku Googlebota, właściciele witryn mogą określić w pliku robots.txt, czy zezwalają, czy nie zezwalają „ bingbotowi ” na skanowanie ich witryny.

Co więcej, programiści mogą rozróżnić roboty indeksujące przeznaczone przede wszystkim na urządzenia mobilne i roboty przeznaczone na komputery stacjonarne, ponieważ Bingbot przyjął niedawno nowy typ agenta. To, w połączeniu z narzędziami Bing dla webmasterów, zapewnia webmasterom większą elastyczność w prezentowaniu sposobu, w jaki ich witryna jest znajdowana i wyświetlana w wynikach wyszukiwania.

AppleBot

Firma Apple zainicjowała rozwój Apple Bota do skanowania i katalogowania stron internetowych w celu integracji z sugestiami Siri i Spotlight firmy Apple. Apple Bot ocenia różne kryteria w celu określenia treści, którym należy nadać priorytet w sugestiach Siri i Spotlight.

Kryteria te obejmują interakcję użytkownika, znaczenie wyszukiwanych haseł, ilość i jakość linków, sygnały oparte na lokalizacji oraz ogólny projekt stron internetowych.

Pająk Sogou

Sogou , chińska wyszukiwarka, jest uznawana za pierwszą platformę wyszukiwania indeksującą 10 miliardów chińskich stron. Dla osób zaangażowanych w działalność na rynku chińskim znajomość tego powszechnie używanego robota wyszukiwania, Sogou Spider, jest niezbędna. Przestrzega tekstu o wykluczeniu robotów i ustawień opóźnienia indeksowania.

Podobnie jak w przypadku Baidu Spider, jeśli Twoja firma nie jest skierowana na rynek chiński, sugerujemy dezaktywację tego pająka, aby uniknąć powolnego ładowania witryny.

Pająk Baidu

Główną wyszukiwarką w Chinach jest Baidu, a jej wyłącznym robotem jest Baidu Spider . Ze względu na brak Google w Chinach, zezwolenie Baidu Spider na indeksowanie Twojej witryny staje się kluczowe, jeśli zamierzasz kierować reklamy na rynek chiński. Aby rozpoznać aktywność Baidu Spider na swojej stronie, sprawdź programy użytkownika, takie jak baiduspider, baiduspider-image, baiduspider-video i inne.

Dla osób niezaangażowanych w działalność biznesową w Chinach rozsądne może być zablokowanie Baidu Spider za pomocą skryptu robots.txt. W ten sposób możesz uniemożliwić Baidu Spider skanowanie Twojej witryny, eliminując możliwość pojawienia się Twoich stron na stronach wyników wyszukiwania Baidu (SERP).

Siorbnięty Bot

Robot wyszukiwania Yahoo, Slurp Bot , odgrywa kluczową rolę w przeszukiwaniu i indeksowaniu stron nie tylko witryny Yahoo.com, ale także powiązanych z nią platform, takich jak Yahoo News, Yahoo Finance i Yahoo Sports.

Brak tego indeksowania spowoduje brak odpowiednich wykazów witryn. Spersonalizowane korzystanie z Internetu przez użytkowników i dostarczanie trafniejszych wyników jest możliwe dzięki indeksowanej treści.

Zewnętrzny hit Facebooka

Narzędzie Facebook Crawler , zwane także Facebook Zewnętrznym Hitem, sprawdza kod HTML witryny lub aplikacji udostępnianej na Facebooku. Odpowiada za utworzenie podglądu udostępnionych linków na platformie, wyświetlenie tytułu, opisu i miniatury.

Indeksowanie musi nastąpić niezwłocznie, ponieważ jakiekolwiek opóźnienie może spowodować, że fragment niestandardowy nie zostanie wyświetlony podczas udostępniania treści na Facebooku.

Szybki robot

Spersonalizowana wyszukiwarka Swiftype zwiększa funkcjonalność wyszukiwania w Twojej witrynie, integrując najwyższej klasy technologię, algorytmy, platformę przetwarzania treści, klientów i narzędzia analityczne. Szczególnie korzystny w przypadku witryn zawierających wiele stron, Swiftype zapewnia przyjazny dla użytkownika interfejs umożliwiający efektywne katalogowanie i indeksowanie wszystkich stron.

Istotną rolę w tym procesie odgrywa Swiftbot, robot indeksujący Swiftype . Warto zauważyć, że Swiftbot wyróżnia się wyłącznie indeksowaniem witryn w oparciu o żądania klientów, co odróżnia go od innych botów.

Lista najlepszych robotów indeksujących, które pozwolą opanować SEO w 2024 r

Wyselekcjonowana lista robotów indeksujących przedstawiona na tym blogu stanowi cenne źródło usprawnienia procesu utrzymywania dynamiki witryny i jej przyjazności dla SEO. Zbliżając się do roku 2024, musisz włączyć te najlepsze narzędzia do przeszukiwania sieci do swojej strategii, aby mieć pewność, że Twoja witryna pozostanie na czele rankingów wyszukiwarek, umożliwiając zespołom skupienie się na tworzeniu wysokiej jakości treści, podczas gdy roboty zajmą się zawiłościami optymalizacji.

Jeśli uważasz, że ten artykuł był wartościowy, udostępnij go innym. Nie zapomnij także zasubskrybować naszego bloga i znajdź więcej takich spostrzeżeń, aby wyróżnić się w rankingu wyszukiwania.