Jak zoptymalizować WordPress Robots.txt pod kątem SEO

Opublikowany: 2022-08-23Na tym blogu dowiemy się kilku wskazówek, jak poprawić pozycjonowanie swojej witryny poprzez optymalizację pliku robts.txt.

W rzeczywistości plik Robots.txt odgrywa ważną rolę pod względem SEO, ponieważ informuje wyszukiwarki, w jaki sposób można indeksować witrynę. To jest powód, dla którego pliki Robot.txt są uważane za jedno z najpotężniejszych narzędzi SEO.

Później dowiesz się również, jak zbudować i zoptymalizować WordPress Robots.txt pod kątem SEO.

Co rozumiesz przez plik robots.txt?

Plik tekstowy utworzony przez właścicieli witryn w celu poinformowania robotów wyszukiwarek, że mogą indeksować w ich witrynie i indeksować strony, jest znany jako Robots.txt

W rzeczywistości ten plik jest przechowywany w katalogu głównym. Ten katalog jest również nazywany głównym folderem Twojej witryny. Poniżej wymieniono format pliku robots.txt

Klient użytkownika: [nazwa klienta użytkownika] Disallow: [ciąg adresu URL, którego nie należy indeksować] Klient użytkownika: [nazwa klienta użytkownika] Zezwól: [ciąg adresu URL do zindeksowania] Mapa witryny: [URL Twojej mapy witryny XML]

Aby zezwolić lub zabronić określonych adresów URL, możesz mieć różne wiersze instrukcji. Dodatkowo możesz też dodawać różne mapy witryn. Boty wyszukiwarek uznają, że mogą indeksować strony, jeśli zezwalają na adres URL.

Przykład pliku robots.txt znajduje się poniżej

Agent użytkownika: * Zezwól: /wp-content/uploads/ Nie zezwalaj: /wp-content/plugins/ Nie zezwalaj: /wp-admin/ Mapa witryny: https://example.com/sitemap_index.xml

W powyższym przykładzie zezwoliliśmy na indeksowanie stron przez wyszukiwarki i pobieranie plików indeksu w folderze przesłanych do WordPressa.

Następnie nie pozwoliliśmy botom wyszukiwania na indeksowanie i indeksowanie folderów i wtyczek administracyjnych WordPress.

Na koniec wspomnieliśmy o adresie URL mapy witryny XML.

Czy potrzebujesz pliku Robots.txt do swojej witryny WordPress?

Wyszukiwarka zacznie przeszukiwać i indeksować Twoje strony, nawet jeśli nie masz pliku tekstowego, tj. Robots.txt. Niestety, nie możesz poinformować swojej wyszukiwarki, który konkretny folder lub strona ma zaindeksować.

Nie przyniesie korzyści ani nie pozostawi żadnego wpływu, jeśli właśnie stworzyłeś stronę internetową lub blog z mniejszą zawartością.

Jednak po skonfigurowaniu witryny z dużą ilością treści i gdy zacznie się ona rozwijać, będziesz potrzebować kontroli nad zindeksowanymi i zindeksowanymi stronami witryny.

Pierwszy powód podano poniżej

Dla każdej witryny boty wyszukiwania mają limit indeksowania.

Oznacza to wyraźnie, że podczas sesji indeksowania zindeksuje określoną liczbę stron. Załóżmy, że indeksowanie w Twojej witrynie pozostaje niekompletne, po czym wróci ona jeszcze raz i wznowi indeksowanie w kolejnej sesji.

Z tego powodu wskaźnik indeksowania witryny w Twojej witrynie będzie ostateczną rozgrywką.

Możesz rozwiązać ten problem, uniemożliwiając botom wyszukiwania nie indeksowanie takich stron, które nie są konieczne. Niektóre nieważne strony mogą zawierać pliki wtyczek, strony administracyjne WordPress i foldery motywów.

Limit indeksowania można zapisać, uniemożliwiając indeksowanie niechcianych stron. Ten krok będzie bardziej pomocny, ponieważ wyszukiwarki będą teraz indeksować strony witryny i będą mogły je zaindeksować tak szybko, jak to możliwe.

Kolejny powód, dla którego powinieneś wykorzystać i zoptymalizować plik WordPress Robots.txt, podano poniżej

Zawsze, gdy musisz powstrzymać wyszukiwarki przed indeksowaniem stron lub postów w Twojej witrynie, możesz użyć tego pliku.

W rzeczywistości jest to jeden z najbardziej niewłaściwych sposobów ukrywania treści witryny przed opinią publiczną, ale okaże się najlepszym wsparciem, aby zabezpieczyć je przed pojawianiem się w wynikach wyszukiwania.

Jak wygląda plik Robots.txt?

Najpopularniejsze blogi używają bardzo prostego pliku robots.txt. Treść może różnić się w zależności od wymagań konkretnej witryny.

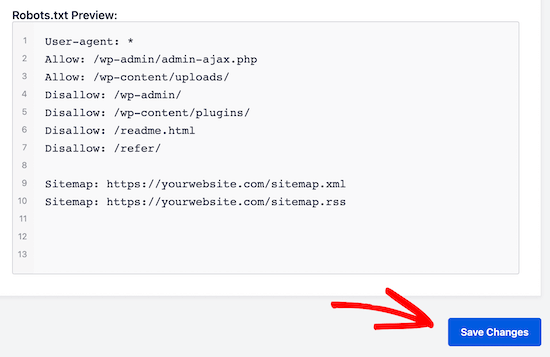

Agent użytkownika: * Uniemożliwić: Mapa witryny: http://www.example.com/post-sitemap.xml Mapa witryny: http://www.example.com/page-sitemap.xml Plik robots.txt umożliwi wszystkim botom indeksowanie wszystkich treści i oferowanie linków do witryny mapy witryny XML. W plikach robots.txt wymienione są następujące zasady Agent użytkownika: * Zezwól: /wp-content/uploads/ Nie zezwalaj: /wp-content/plugins/ Nie zezwalaj: /wp-admin/ Zabroń: /readme.html Nie zezwalaj: /odsyłaj/ Mapa witryny: http://www.example.com/post-sitemap.xml Mapa witryny: http://www.example.com/page-sitemap.xml

To wskaże botowi indeksowanie wszystkich plików i obrazów WordPress. Nie pozwoli to botom wyszukiwania na indeksowanie obszaru administracyjnego WordPress, plików wtyczek WordPress, linków partnerskich i pliku readme WordPress.

Do plików robots.txt możesz dodać mapy witryn, które pomogą botom Google rozpoznawać wszystkie strony w Twojej witrynie.

Teraz już wiesz, jak wygląda plik robots.txt, teraz dowiemy się, jak plik robots.txt można utworzyć w WordPressie.

Jak w WordPressie zbudować plik robots.txt?

Istnieje wiele sposobów na utworzenie pliku robots.txt w WordPressie. Niektóre z najlepszych metod są wymienione poniżej, możesz wybrać dowolną z nich, która będzie dla Ciebie najlepsza.

Metoda 1: Korzystanie z SEO All in One, modyfikowanie pliku Robots.txt

All in One SEO to najbardziej znana wtyczka WordPress do SEO na rynku, z której korzysta ponad 1 milion stron internetowych.

Wtyczka All in One SEO jest bardzo prosta w użyciu i dlatego oferuje generator plików robotx.txt. Pomocna jest również optymalizacja WordPress Robots.txt

Jeśli jeszcze nie zintegrowałeś tej wtyczki SEO, zainstaluj ją i aktywuj najpierw z pulpitu WordPress. Darmowa wersja jest również dostępna dla początkujących użytkowników, dzięki czemu mogą korzystać z jej funkcji bez inwestowania pieniędzy.

Po aktywacji wtyczki możesz zacząć używać jej do budowania lub modyfikowania pliku robots.txt bezpośrednio z obszaru administracyjnego WordPress.

Aby go użyć

- Przejdź do SEO „wszystko w jednym”

- Teraz, aby edytować plik robots.txt, kliknij narzędzia

- Teraz, klikając „włącz niestandardowy plik robots.txt”, włączysz opcję edycji

- W WordPressie możesz także zbudować niestandardowy plik robots.txt za pomocą tego przełącznika.

- Teraz Twój istniejący plik robots.txt będzie wyświetlany przez wtyczkę „Wszystko w jednym SEO” w sekcji „Podgląd robots.txt”. Jest to widoczne na dole ekranu internetowego.

Według WordPress, domyślna reguła, która została dodana, będzie wyświetlana w tej wersji

Domyślne reguły, które wydają się sugerować Twojej wyszukiwarce, że nie muszą indeksować podstawowych plików WordPress, oferują łącze do witryny mapy witryny XML i zezwalają botom na indeksowanie całej jej zawartości.

Aby ulepszyć plik robots.txt pod kątem SEO, można dodać nowe własne reguły niestandardowe.

Dodaj agenta użytkownika w polu „Agent użytkownika”, aby dodać regułę. Reguła zostanie zastosowana do wszystkich programów użytkownika przy użyciu *.

Teraz wybierz, czy chcesz zezwolić wyszukiwarce na indeksowanie stron, czy nie.

Teraz dodaj ścieżkę katalogu, nazwę pliku w polu „Ścieżka katalogu”.

W pliku robots.txt reguła zostanie zastosowana automatycznie. Kliknij przycisk „dodaj regułę”, aby dodać nową regułę.

Jeśli nie stworzysz idealnego formatu robotx.txt, sugerujemy dodanie nowych reguł.

Dodane przez Ciebie reguły niestandardowe będą wyglądać

Aby zapisać zmiany, nie przegap, aby kliknąć „zapisz zmiany”

Metoda 2: Ręczna modyfikacja pliku Robots.txt za pomocą FTP

Inną metodą optymalizacji WordPress Robots.txt jest wykorzystanie funkcji klientów FTP do rozpoczęcia modyfikacji pliku robots.txt

Wystarczy połączyć się z kontem hostingowym WordPress za pomocą klienta FTP

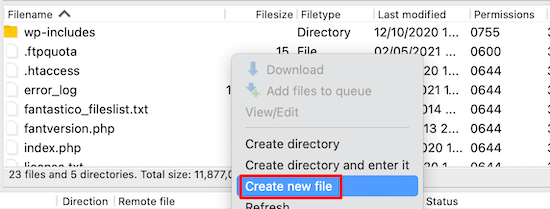

Po zalogowaniu, w głównym folderze witryny, będziesz mógł wyświetlić plik robots.txt.

Jeśli nie możesz go znaleźć, oznacza to, że nie masz pliku robots.txt

W takiej sytuacji musisz stworzyć plik robot.txt.

Jak wspomniano wcześniej, plik robots.txt jest zwykle prostym plikiem tekstowym, który można pobrać na komputer. Możesz go jednak nawet zmodyfikować za pomocą zwykłego edytora tekstu, takiego jak TextEdit, Notatnik lub WordPad.

Po wykonaniu wszystkich zmian nadszedł czas, aby je zapisać. Możesz przesłać ten plik do folderu głównego swojej witryny.

Jak przeprowadzić testowanie pliku Robots.txt?

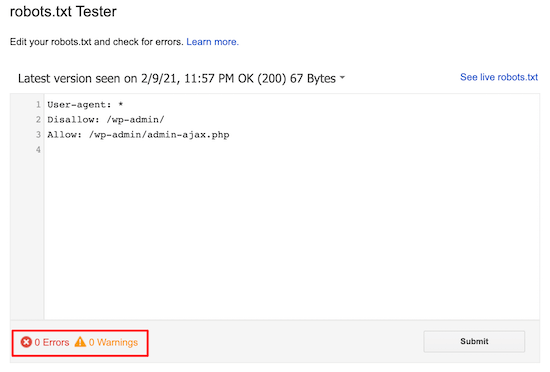

Możesz przeprowadzić testy za pomocą narzędzia testowego robots.txt.

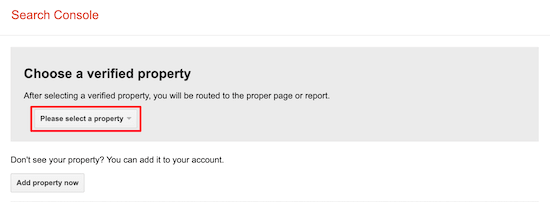

W sieci znajdziesz wiele narzędzi testujących robots.txt. Jednym z najlepszych jest Google Search Console.

Aby pracować z tym narzędziem, musisz najpierw mieć stronę internetową połączoną z konsolą wyszukiwania Google. Następnie możesz zacząć korzystać z jego funkcji.

Z rozwijanej listy wystarczy wybrać swoją nieruchomość.

Jednak automatycznie wybierze plik robots.txt Twojej witryny i podświetli wszystkie ostrzeżenia i błędy. Jest to jedno z najlepszych narzędzi, które pomagają bardzo łatwo zoptymalizować plik WordPress Robots.txt.

Wniosek:

Głównym mottem optymalizacji tego pliku robots.txt jest zabezpieczenie stron przed ich indeksowaniem. Na przykład strony w folderze administratora WordPress lub strony w folderze wp-plugin.

Najczęstszym mitem jest to, że możesz poprawić szybkość indeksowania i przyspieszyć indeksowanie oraz uzyskać wyższą pozycję w rankingu, blokując kategorię WordPress, osiągając strony i tagi.

Ale to nie zadziała, ponieważ będzie działać źle zgodnie ze wskazówkami dla webmasterów Google.

Sugerujemy przeczytanie i rozważenie wszystkich punktów wymienionych powyżej.

Mamy nadzieję, że ten blog pomoże Ci utworzyć plik robots.txt w formacie odpowiednim dla Twojej witryny. Pomoże Ci to zoptymalizować WordPress Robots.txt.