Jak zoptymalizować plik WordPress Robots.txt pod kątem SEO za pomocą Yoast SEO

Opublikowany: 2023-10-25Optymalizacja wyszukiwarek (SEO) jest kluczową częścią budowania skutecznej witryny internetowej, a jednym z najważniejszych czynników osiągnięcia sukcesu SEO jest użycie odpowiednich narzędzi do optymalizacji witryny. Jednym z takich narzędzi jest plik Robots.txt, który kontroluje sposób, w jaki roboty wyszukiwarek uzyskują dostęp do treści i ją indeksują.

Optymalizacja pliku WordPress Robots.txt może pomóc Ci osiągnąć lepsze rankingi w wyszukiwarkach, poprawić widoczność Twojej witryny i zwiększyć ruch.

Jednak pomimo jego znaczenia wielu właścicieli witryn nie wie, jak poprawnie skonfigurować plik Robots.txt. W tym poście na blogu przeprowadzimy Cię przez wszystko, co musisz wiedzieć, aby opanować WordPress Robots.txt pod kątem SEO i odblokować pełny potencjał SEO dla swojej witryny.

Zrozumienie roli pliku robots.txt w SEO

Zrozumienie funkcji pliku robots.txt w optymalizacji wyszukiwarek jest niezbędne, aby w pełni wykorzystać wysiłki związane z optymalizacją witryny WordPress i wygenerować najlepsze możliwe wyniki. Plik tekstowy o nazwie Robots.txt, który może być również nazywany protokołem wykluczania robotów, zawiera instrukcje dla robotów wyszukiwarek, które obszary witryny internetowej powinny przeszukiwać i indeksować.

Kiedy boty wyszukiwarek odwiedzają Twoją witrynę, pierwszą rzeczą, którą robią, jest sprawdzenie w katalogu głównym pliku o nazwie robots.txt. Plik ten służy jako przewodnik dla botów, informując je o witrynach i plikach, które mogą odwiedzać, a także o tych, do których nie mogą.

Masz pełną kontrolę nad materiałami wyświetlanymi wyszukiwarkom i tym, co jest przed nimi ukryte, jeśli poprawnie skonfigurujesz plik robots.txt.

Efektywność skanowania Twojej witryny warto przede wszystkim poprawić wykorzystując plik robots.txt. Pomaga botom wyszukiwarek skoncentrować się na przeszukiwaniu i indeksowaniu najważniejszych części Twojej witryny, unikając w ten sposób marnowania zasobów na nieistotnych stronach lub wrażliwych materiałach, które nie powinny być udostępniane ogółowi społeczeństwa.

Czym dokładnie jest plik Robots.txt?

Prosty plik tekstowy znany jako Robots.txt kieruje roboty indeksujące używane przez wyszukiwarki do określonych stron internetowych w Twojej witrynie. Dodatkowo instruuje roboty, aby nie przeszukiwały niektórych witryn.

Zanim przystąpimy do szczegółowej analizy tego artykułu, istotne jest zrozumienie działania wyszukiwarki.

Indeksowanie, indeksowanie i ranking to trzy główne działania wykonywane przez wyszukiwarki.

Pierwszą rzeczą, jaką robią wyszukiwarki, jest wysyłanie swoich robotów indeksujących, znanych również jako pająki lub boty, do całej sieci WWW. Programy te, zwane botami, to inteligentne programy, które przeszukują całą sieć w poszukiwaniu nowych połączeń, stron i witryn internetowych. Indeksowanie to termin określający proces przeszukiwania treści w sieci.

Strony Twojej witryny zostaną zorganizowane w strukturę danych, z której będzie można skorzystać po ich wykryciu przez boty. Indeksowanie to nazwa nadana tej procedurze.

A wszystko ostatecznie sprowadza się do rankingów. Kiedy użytkownik wprowadza zapytanie, wyszukiwarka powinna oferować mu najlepsze i najbardziej odpowiednie informacje, jakie może znaleźć, w zależności od tego, czego szuka użytkownik.

Jak wygląda plik Robots.txt?

Plik robots.txt jest istotnym elementem struktury i funkcjonalności witryny internetowej, ale czy zastanawiałeś się kiedyś, jak on właściwie wygląda?

Plik ma zastosowanie do wszystkich robotów wyszukiwarek, które odwiedzają witrynę, jak wskazuje gwiazdka znajdująca się za agentem użytkownika. Każda wyszukiwarka korzysta z innego klienta użytkownika do przeglądania Internetu.

Na przykład Google wykorzystuje Googlebota do indeksowania treści Twojej witryny w wyszukiwarce Google. Liczba tych agentów użytkownika jest liczona w setkach. Instrukcje niestandardowe można skonfigurować dla każdego klienta użytkownika. Na przykład pierwsza linia pliku robots.txt powinna brzmieć: „Jeśli chcesz ustawić szczegółowe instrukcje dla Googlebota, będzie on znany jako User-agent: Googlebot.

Jaki dokładnie jest budżet Crawl?

Budżet indeksowania odnosi się do liczby stron, które wyszukiwarka jest skłonna przeszukać w witrynie w określonym przedziale czasu. Zależy to od różnych czynników, takich jak autorytet witryny, popularność i zdolność serwera do obsługi żądań indeksowania. Ponadto powinieneś upewnić się, że budżet indeksowania jest wykorzystywany w Twojej witrynie tak efektywnie, jak to możliwe.

Jeśli Twoja witryna ma kilka stron, z pewnością bot powinien najpierw zaindeksować najważniejsze strony. Dlatego konieczne jest wyraźne określenie tego w pliku robots.txt.

Jak zlokalizować i edytować plik robots.txt w WordPress?

Znalezienie i edycja pliku robots.txt w WordPressie to kluczowy krok w optymalizacji Twojej witryny pod kątem wyszukiwarek. Odpowiednio konfigurując ten plik, możesz kontrolować, które części Twojej witryny są dostępne dla robotów wyszukiwarek, upewniając się, że skupiają się one na najważniejszych stronach i treści.

Aby zlokalizować i edytować plik robots.txt w WordPressie, wykonaj następujące proste kroki:

1. Zaloguj się do panelu WordPress.

2. Przejdź do zakładki „Ustawienia” w menu po lewej stronie.

3. Kliknij „Czytanie”, aby uzyskać dostęp do ustawień czytania.

4. Przewiń w dół, aż znajdziesz sekcję „Widoczność w wyszukiwarkach”.

5. Tutaj zobaczysz opcję „Zniechęcaj wyszukiwarki do indeksowania tej witryny”. Upewnij się, że ta opcja jest odznaczona, ponieważ wygeneruje podstawowy plik robots.txt, który ogranicza dostęp wyszukiwarki do całej Twojej witryny.

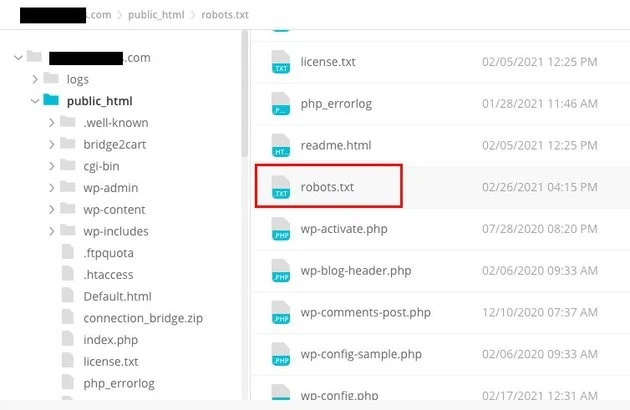

6. Jeśli chcesz bardziej dostosować plik robots.txt, możesz to zrobić, uzyskując dostęp do katalogu głównego swojej witryny. Zwykle można to zrobić za pomocą klienta FTP lub menedżera plików cPanel.

7. Po zlokalizowaniu katalogu głównego poszukaj pliku o nazwie „robots.txt”.

8. Pobierz kopię istniejącego pliku robots.txt na swój komputer jako kopię zapasową, na wypadek problemów podczas edycji.

9. Otwórz plik robots.txt za pomocą edytora tekstu.

10. Dostosuj plik do swoich potrzeb. Możesz dodać określone dyrektywy, aby zezwolić lub zabronić dostępu do niektórych obszarów Twojej witryny. Na przykład możesz uniemożliwić wyszukiwarkom indeksowanie obszaru administracyjnego, dodając następujący wiersz:

1. Zabroń: /wp-admin/

11. Zapisz zmiany w pliku robots.txt i prześlij go z powrotem do katalogu głównego swojej witryny, zastępując poprzednią wersję.

12. Na koniec przetestuj plik robots.txt za pomocą narzędzia Google do testowania pliku robots.txt lub innego podobnego narzędzia, aby upewnić się, że jest on poprawnie skonfigurowany.

Kontrolowanie sposobu, w jaki roboty wyszukiwarek wchodzą w interakcję z Twoją witryną, można zrealizować w WordPressie, identyfikując i modyfikując plik robots.txt we właściwej lokalizacji. Dzięki temu uzyskasz najlepsze możliwe wyniki pod względem widoczności i rankingu Twojej witryny. Jeśli zainwestujesz czas, aby poznać ten aspekt optymalizacji wyszukiwarek (SEO) i stać się ekspertem w tej dziedzinie, będziesz na dobrej drodze do odblokowania sukcesu swojej witryny WordPress.

Jak utworzyć plik Robots.txt w WordPress?

Przejdźmy dalej i utwórzmy WordPress Robots.txt dla SEO, skoro omówiliśmy, czym jest plik robots.txt i dlaczego jest tak ważny. WordPress udostępnia dwie różne opcje generowania pliku robots.txt. Pierwsza metoda polega na użyciu wtyczki WordPress, natomiast druga polega na ręcznym przesłaniu pliku do folderu głównego Twojej witryny.

Krok 1: Ma to na celu użycie wtyczki Yoast SEO do utworzenia pliku Robots.txt

Możesz używać wtyczek SEO, które pomogą Ci zoptymalizować witrynę zbudowaną na WordPress. Większość tych wtyczek zawiera własny generator plików robots.txt w pakiecie instalacyjnym.

Najpierw pobierz i zainstaluj wtyczkę.

Przejdź do menu Wtyczki i kliknij „Dodaj nową”. Następnym krokiem jest wyszukanie wtyczki Yoast SEO, pobranie jej i włączenie, jeśli jeszcze jej nie masz.

W drugim kroku utwórz plik robots.txt

Utwórz plik txt robots za pomocą Yoast

Zauważysz plik utworzony z niektórymi domyślnymi dyrektywami.

Generator plików robots.txt dla Yoast SEO automatycznie uwzględni następujące dyrektywy:

Agent użytkownika: * Disallow: /wp-admin/ Zezwól: /wp-admin/admin-ajax.php

Dodaj dodatkowe instrukcje do pliku robots.txt. Po edycji pliku robots.txt kliknij Zapisz.

Wpisz nazwę swojej domeny i plik „/robots.txt”. Twój plik robots.txt jest kompletny, jeśli przeglądarka wyświetla domyślne dyrektywy, jak pokazano poniżej.

wygenerowany plik robots txt

Zalecamy również dodanie adresu URL mapy witryny do pliku robots.txt.

Domyślny plik txt robots

Po włączeniu wtyczki przejdź do Yoast SEO > Narzędzia i z rozwijanego menu wybierz Edytor plików. Kontynuuj wpisywanie nazwy domeny, a następnie wpisz „/robots.txt”. Jeśli spojrzysz na przeglądarkę, zauważysz, że pokazane są niektóre domyślne dyrektywy.

Krok 2: Użycie protokołu FTP do ręcznego utworzenia pliku Robots.txt

- Utworzenie pliku robots.txt na komputerze lokalnym, a następnie przesłanie go do folderu głównego witryny WordPress to kolejny krok w tym procesie.

- Oprócz tego będziesz potrzebować dostępu do hostingu WordPress za pomocą programu FTP, takiego jak Filezilla. Jeśli nie posiadasz jeszcze danych uwierzytelniających niezbędnych do zalogowania się, zostaną one udostępnione Ci za pośrednictwem panelu administracyjnego Twojej usługi hostingowej. W związku z tym możesz sprawdzić, czy plik robots.txt znajduje się w folderze głównym Twojej witryny po zalogowaniu się za pomocą programu FTP.

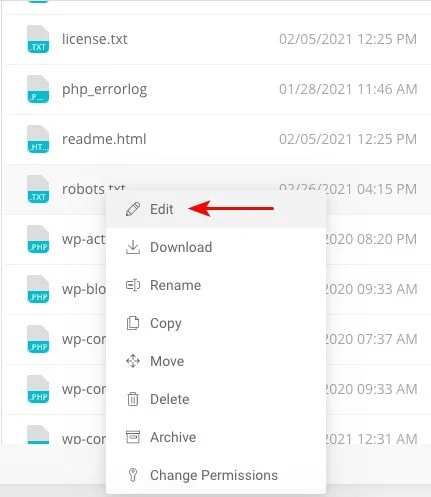

- Kliknij plik prawym przyciskiem myszy i wybierz opcję edycji, jeśli istnieje.

Dlatego po pomyślnym zalogowaniu się za pomocą klienta FTP będziesz mógł sprawdzić, czy plik robots.txt znajduje się w folderze głównym Twojej witryny. Wpisanie nazwy domeny, po której następuje ciąg „/robots.txt”, to najlepszy sposób sprawdzenia, czy plik został pomyślnie przesłany.

Po wprowadzeniu zmian kliknij „Zapisz”.

Będziesz musiał utworzyć plik, jeśli jeszcze nie istnieje. Można to zrobić, dodając dyrektywy do pliku przy użyciu podstawowego edytora tekstu, takiego jak Notatnik. Jak na przykład

Agent użytkownika: * Disallow: /wp-admin/ Zezwól: /wp-admin/admin-ajax.php

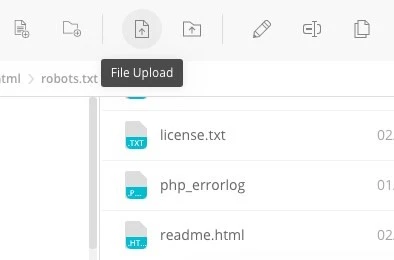

Kliknij opcję „Prześlij plik” w kliencie FTP, aby przesłać plik do folderu głównego witryny.

Wpisz nazwę swojej domeny i „/robots.txt”, aby sprawdzić, czy plik został pomyślnie przesłany.

Jest to metoda ręcznego przesyłania pliku robots.txt na witrynę WordPress!

Robots.txt: Zna swoje zalety i wady

Korzyści ze stosowania pliku robots.txt

Instruuje wyszukiwarkę, aby nie spędzała czasu na witrynach, których nie chcesz indeksować, co pomaga zoptymalizować budżety indeksowania wyszukiwarki. W ten sposób zwiększasz prawdopodobieństwo, że wyszukiwarki będą indeksować witryny, które są dla Ciebie najważniejsze.

Blokowanie botów powodujących marnowanie zasobów Twojego serwera WWW przyczynia się do optymalizacji serwera.

Przydaje się do ukrywania stron z podziękowaniami, stron docelowych, stron logowania i innych stron, które nie muszą być indeksowane przez wyszukiwarki.

Negatywne aspekty pliku robots.txt

Teraz powinno być możliwe wyświetlenie pliku robots.txt w dowolnej witrynie internetowej, korzystając z podanych tutaj informacji. Nie jest to zbyt trudne do zrozumienia. Po prostu wpisz nazwę domeny, a następnie „/robots.txt” i naciśnij Enter.

Jednak w pewnym stopniu wiąże się to z niebezpieczeństwem. Istnieje możliwość, że plik WordPress Robots.txt dla SEO zawiera adresy URL niektórych wewnętrznych stron Twojej witryny, które nie powinny być indeksowane przez wyszukiwarki.

Na przykład może istnieć strona do logowania, której z jakiegoś powodu nie chcesz indeksować. Jednak fakt, że jest on wymieniony w pliku robots.txt, umożliwia atakującym zobaczenie witryny. To samo dotyczy sytuacji, w której próbujesz ukryć pewne poufne informacje.

Nawet jeśli popełnisz jedną literówkę podczas pisania pliku robots.txt, zniweczy to wszystkie wysiłki związane z optymalizacją wyszukiwarek (SEO). Dzieje się tak nawet wtedy, gdy plik jest łatwy do utworzenia.

Gdzie umieścić plik Robots.txt

Załóżmy, że w tym momencie znasz lokalizację, w której należy wstawić plik robots.txt.

Plik robots.txt Twojej witryny powinien zawsze znajdować się w katalogu głównym witryny. Adres URL pliku robots.txt w Twojej witrynie będzie brzmiał https://twojadomena.com/robots.txt, jeśli nazwa Twojej domeny to twojadomena.com.

Oprócz umieszczenia pliku robots.txt w katalogu głównym witryny internetowej należy zastosować się do następujących innych zalecanych praktyk:

- Bardzo konieczne jest nadanie plikowi nazwy robots.txt.

- Ważne jest, aby nazwę pisać wielką literą. Dlatego musisz go poprawnie zdobyć, w przeciwnym razie nie będzie działać.

- Każdą instrukcję należy umieścić w osobnej linii.

- Gdy adres URL jest już kompletny, należy go oznaczyć znakiem „$”.

- Należy używać tylko jednej instancji każdego klienta użytkownika.

- Aby umożliwić ludziom wyjaśnienie zawartości pliku robots.txt, użyj komentarzy, rozpoczynając każdą linię hashem (#).

Testowanie i sprawdzanie poprawności pliku robots.txt

Testowanie i sprawdzanie poprawności pliku robots.txt to kluczowy krok zapewniający prawidłowe indeksowanie Twojej witryny przez wyszukiwarki. Dobrze zoptymalizowany plik robots.txt może uniemożliwić wyszukiwarkom dostęp do wrażliwych lub nieistotnych stron, poprawić wydajność indeksowania, a ostatecznie poprawić ogólną wydajność Twojej witryny.

Aby rozpocząć testowanie pliku robots.txt, możesz skorzystać z różnych narzędzi online zaprojektowanych specjalnie do tego celu. Narzędzia te umożliwiają wprowadzanie dyrektyw dotyczących pliku robots.txt oraz symulowanie sposobu, w jaki wyszukiwarki je interpretują i stosują.

Analizując wyniki, możesz zidentyfikować potencjalne problemy lub błędne konfiguracje w swoim pliku. Regularne monitorowanie i aktualizacja pliku robots.txt ma kluczowe znaczenie, szczególnie przy wprowadzaniu zmian w strukturze lub treści witryny.

Zachowując czujność, możesz szybko zidentyfikować i naprawić wszelkie problemy, które mogą się pojawić. To skrupulatne podejście ostatecznie przyczyni się do widoczności Twojej witryny, jej indeksowania i ogólnego sukcesu w środowisku cyfrowym.

Narzędziem, które tutaj proponujemy jest Google Search Console

Możesz dodać swoją witrynę do Google Search Console, klikając link „Dodaj usługę teraz” i postępując zgodnie z prostymi instrukcjami wyświetlanymi na ekranie. Po zakończeniu menu rozwijane „Wybierz nieruchomość” wyświetli Twoją witrynę wśród opcji.

Po wybraniu witryny narzędzie automatycznie pobierze plik robots.txt powiązany z Twoją witryną i zaznaczy wszelkie błędy lub ostrzeżenia, jeśli takie wystąpią.

Czy plik Robots.txt jest niezbędny dla Twojej witryny WordPress?

Rzeczywiście, Twoja witryna WordPress potrzebuje pliku robots.txt. Nawet jeśli Twoja witryna nie zawiera pliku robots.txt, wyszukiwarki mimo wszystko będą go indeksować. Skoro omówiliśmy już cel, działanie i budżet indeksowania pliku robots.txt, dlaczego miałbyś chcieć go pominąć?

Wyszukiwarki są szkolone, co należy indeksować, a co ważniejsze, czego nie indeksować, za pośrednictwem pliku robots.txt.

Uwzględnienie negatywnych konsekwencji budżetu indeksowania jest jednym z głównych powodów dodania pliku robots.txt.

Jak wspomniano wcześniej, każda witryna internetowa ma budżet indeksowania. Wszystko sprowadza się do tego, ile stron bot odwiedzi w trakcie jednej sesji. Bot powróci i będzie kontynuował indeksowanie w kolejnej sesji, jeśli w tej sesji nie zakończy przeglądania wszystkich stron Twojej witryny.

Zmniejsza to również tempo indeksowania Twojej witryny.

Możesz zaoszczędzić swój limit indeksowania, szybko naprawiając ten problem, uniemożliwiając botom wyszukiwania skanowanie zasobów multimedialnych, katalogów motywów, wtyczek i obcych witryn.

Ostatnie słowa

Podczas pracy nad Twoją witryną priorytetowo traktujemy optymalizację treści, badanie słów kluczowych, budowanie linków zwrotnych, tworzenie mapy witryny.xml i inne zadania związane z SEO. WordPress Robots.txt dla SEO to jeden aspekt, który niektórzy webmasterzy przeoczają.

Plik robots.txt może nie być bardzo ważny przy pierwszym uruchomieniu Twojej witryny. Biorąc to pod uwagę, gdy Twoja witryna stanie się większa i będzie miała więcej stron, bardzo się opłaci, jeśli zaczniemy używać zalecanego pliku robots.txt.