14 erros comuns do WordPress Robots.txt a serem evitados

Publicados: 2025-01-14Robots.txt é um arquivo de servidor poderoso que informa aos rastreadores de pesquisa e outros bots como se comportar em seu site WordPress. Pode influenciar muito a otimização do mecanismo de pesquisa (SEO) do seu site, tanto positiva quanto negativamente.

Por esse motivo, você deve saber o que é esse arquivo e como utilizá-lo. Caso contrário, você poderá danificar seu site ou, pelo menos, deixar parte de seu potencial de lado.

Para ajudá-lo a evitar esse cenário, nesta postagem abordaremos detalhadamente o arquivo robots.txt. Definiremos o que é, sua finalidade, como encontrar e gerenciar seu arquivo e o que ele deve conter. Depois disso, veremos os erros mais comuns que as pessoas cometem com o robots.txt do WordPress, maneiras de evitá-los e como se recuperar caso descubra que cometeu um erro.

O que é o robots.txt do WordPress?

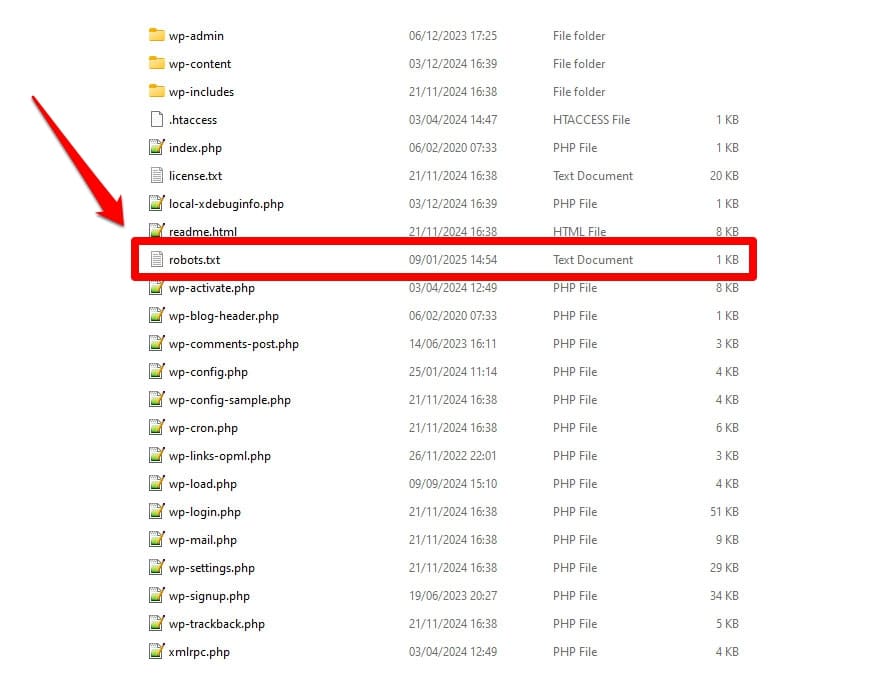

Conforme mencionado, robots.txt é um arquivo de configuração do servidor. Você geralmente o encontra na pasta raiz do seu servidor.

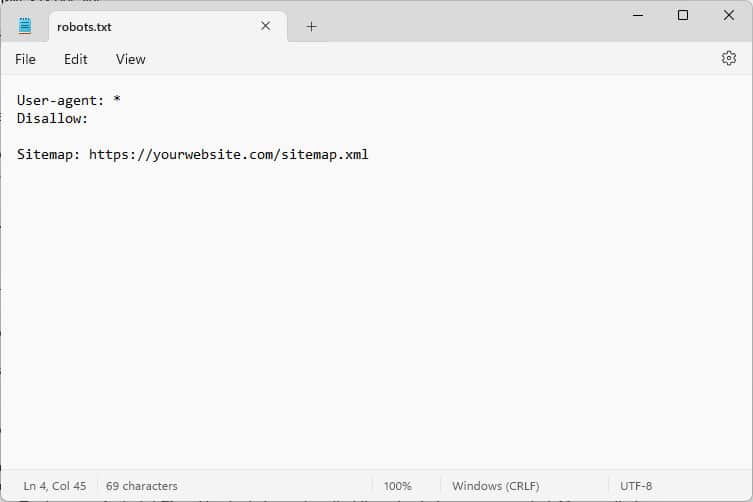

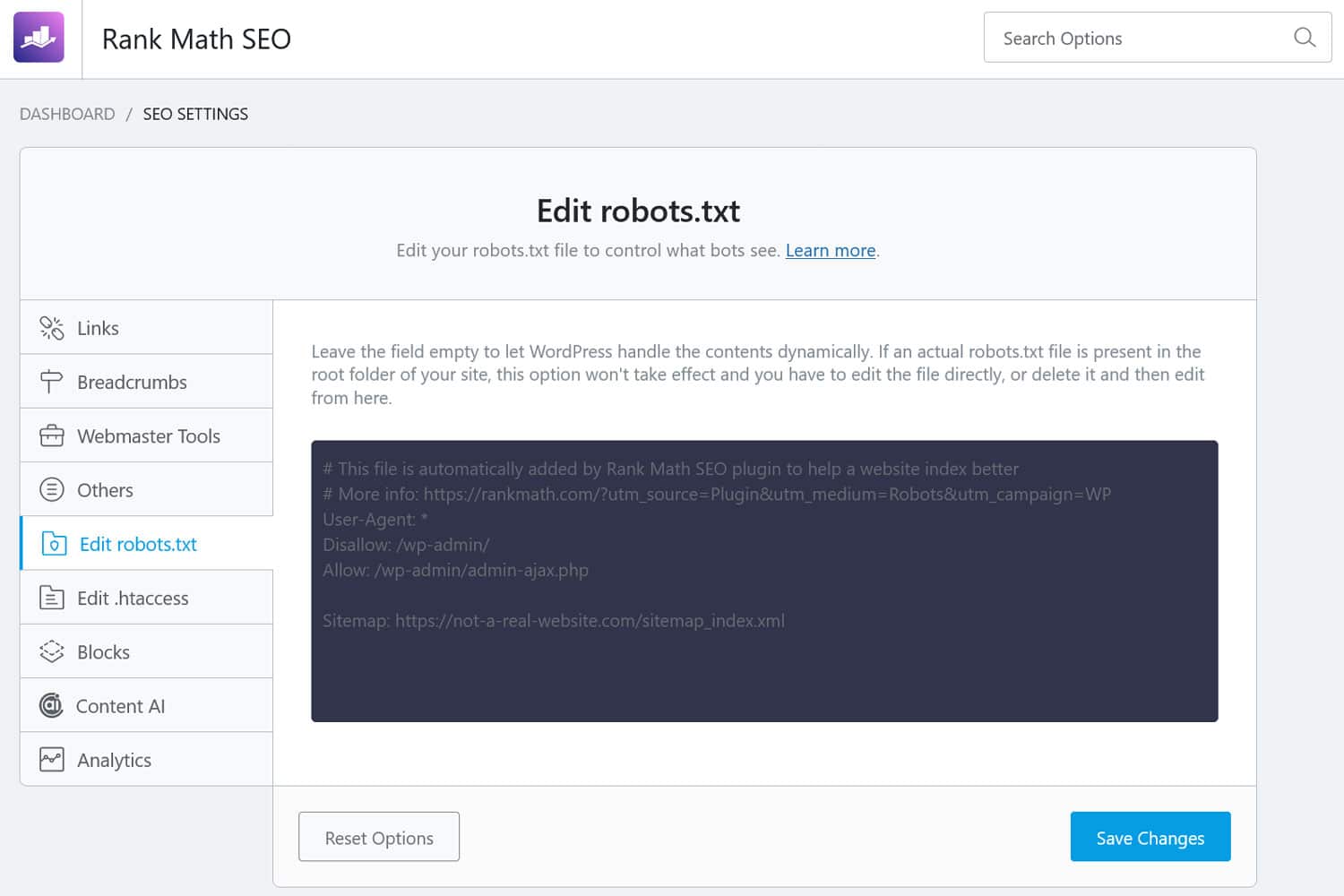

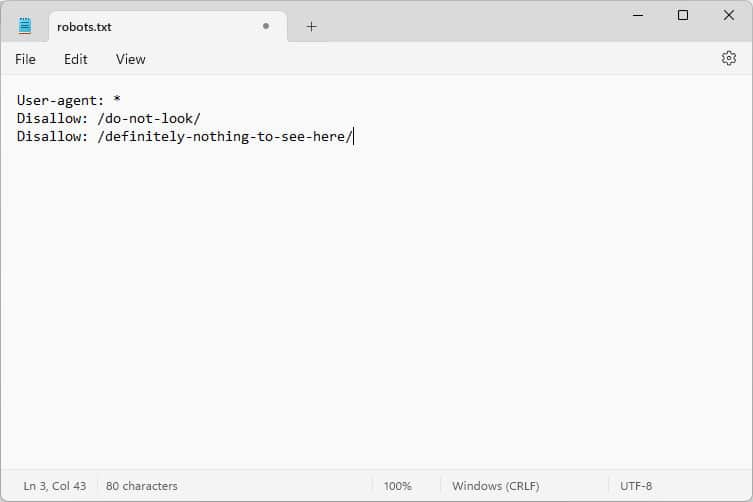

Ao abri-lo, o conteúdo se parece com isto:

Esses trechos de código são instruções que informam aos bots que chegam ao seu site como se comportar enquanto estiverem lá – especificamente, quais partes do seu site devem ser acessadas e quais não.

Que bots, você pergunta?

Os exemplos mais comuns são rastreadores automáticos de motores de busca que procuram páginas da web para indexar ou atualizar, mas também bots de modelos de IA e outras ferramentas automatizadas.

Que diretrizes você pode fornecer com este arquivo?

Robots.txt conhece basicamente quatro diretivas principais:

- Agente do usuário – Define quem, ou seja, para qual grupo de bots ou bots individuais as regras a seguir se destinam.

- Proibir – Indica os diretórios, arquivos ou recursos que o agente do usuário está proibido de acessar.

- Permitir – Pode ser usado para configurar exceções, por exemplo, para permitir acesso a pastas ou recursos individuais em diretórios que de outra forma seriam proibidos.

- Mapa do site – aponta os bots para a localização da URL do mapa do site de um site.

Apenas User-agent e Disallow são obrigatórios para que o arquivo faça seu trabalho; as outras duas directivas são opcionais. Por exemplo, é assim que você bloqueia o acesso de qualquer bot ao seu site:

User-agent: * Disallow: /O asterisco indica que a seguinte regra se aplica a todos os agentes de usuário. A barra após Disallow indica que todos os diretórios deste site estão fora dos limites. Este é o arquivo robots.txt que você normalmente encontra em sites de desenvolvimento, que não devem ser indexados pelos mecanismos de busca.

No entanto, você também pode configurar regras para bots individuais:

User-agent: Googlebot Allow: /private/resources/É importante observar que o robots.txt não é vinculativo. Somente bots de organizações que aderem ao Protocolo de Exclusão de Robôs obedecerão às suas instruções. Bots maliciosos, como aqueles que procuram falhas de segurança em seu site, podem e irão ignorá-las, e você precisa tomar medidas adicionais contra eles.

Mesmo as organizações que aderem ao padrão irão ignorar algumas diretrizes. Falaremos sobre exemplos disso mais abaixo.

Por que o robots.txt é importante?

Não é obrigatório que o seu site WordPress tenha um arquivo robots.txt. Seu site funcionará sem ele e os motores de busca não irão penalizá-lo por não tê-lo. No entanto, incluir um permite que você:

- Mantenha o conteúdo fora dos resultados da pesquisa, como páginas de login ou determinados arquivos de mídia.

- Evite que os rastreadores de pesquisa desperdicem seu orçamento de rastreamento em partes sem importância do seu site, possivelmente ignorando as páginas que você deseja que eles indexem.

- Aponte os mecanismos de pesquisa para o mapa do seu site para que eles possam explorar mais facilmente o resto do seu site.

- Preserve os recursos do servidor, mantendo afastados os bots inúteis.

Tudo isso ajuda a melhorar o seu site, principalmente o SEO, por isso é importante que você entenda como usar o robots.txt.

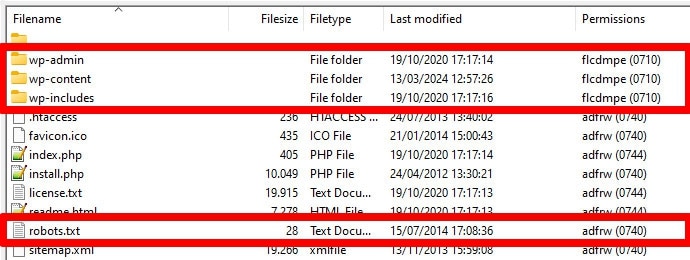

Como encontrar, editar e criar seu robots.txt WordPress

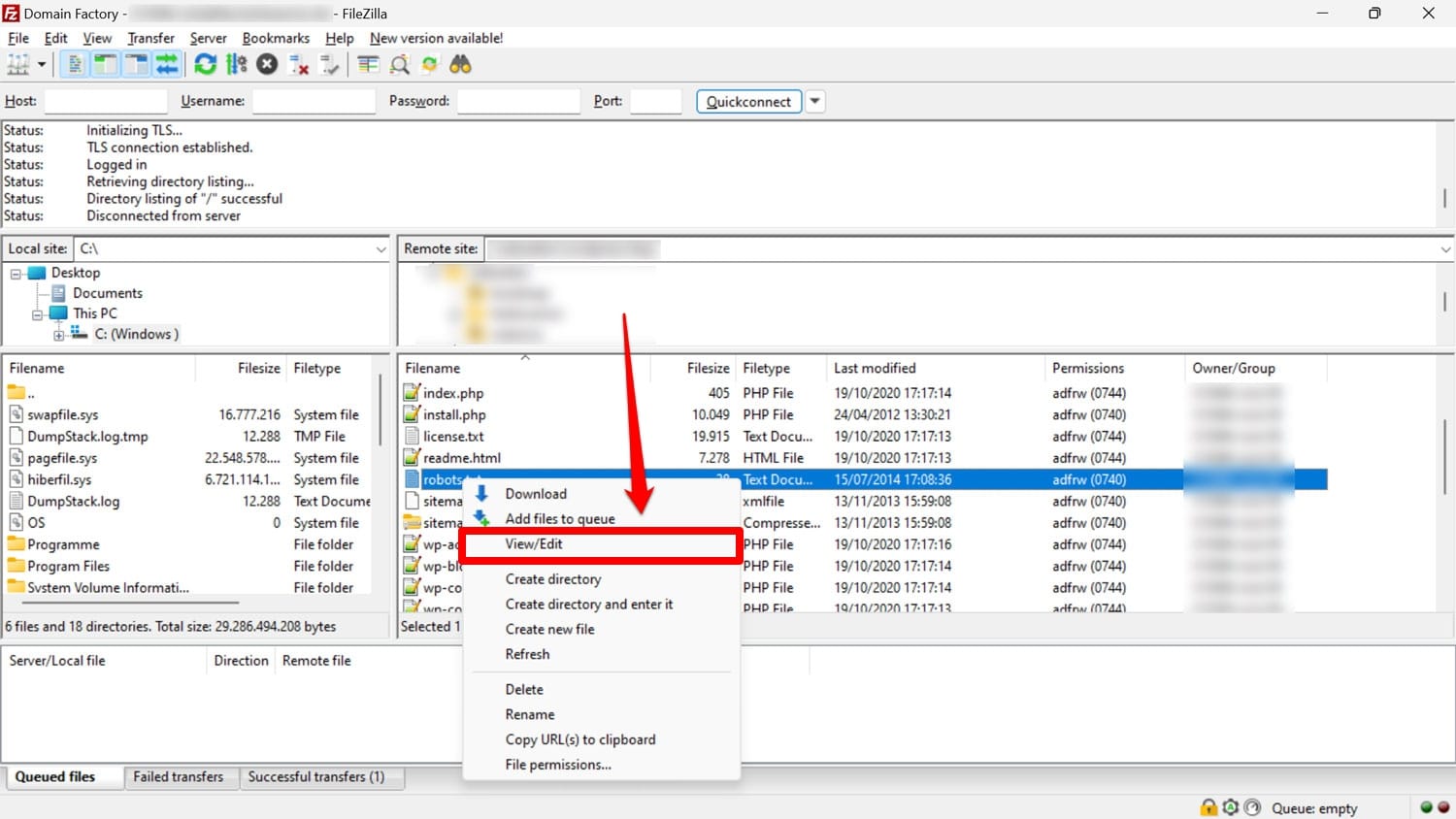

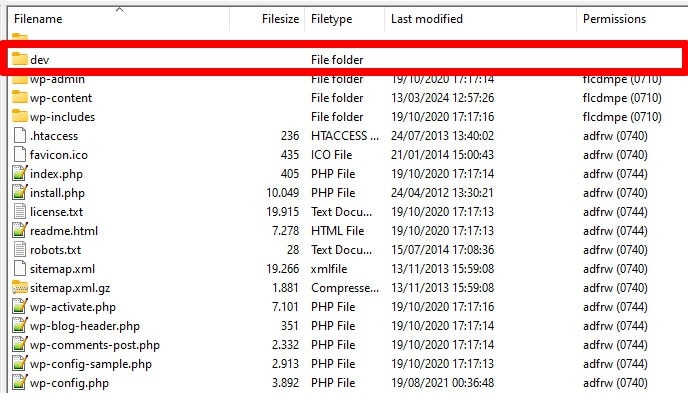

Conforme mencionado, o robots.txt geralmente está na pasta raiz do seu site no servidor. Você pode acessá-lo com um cliente FTP como o FileZilla e editá-lo com qualquer editor de texto.

Se você não tiver um, é possível simplesmente criar um arquivo de texto vazio, nomeá-lo “robots.txt”, preenchê-lo com diretivas e carregá-lo.

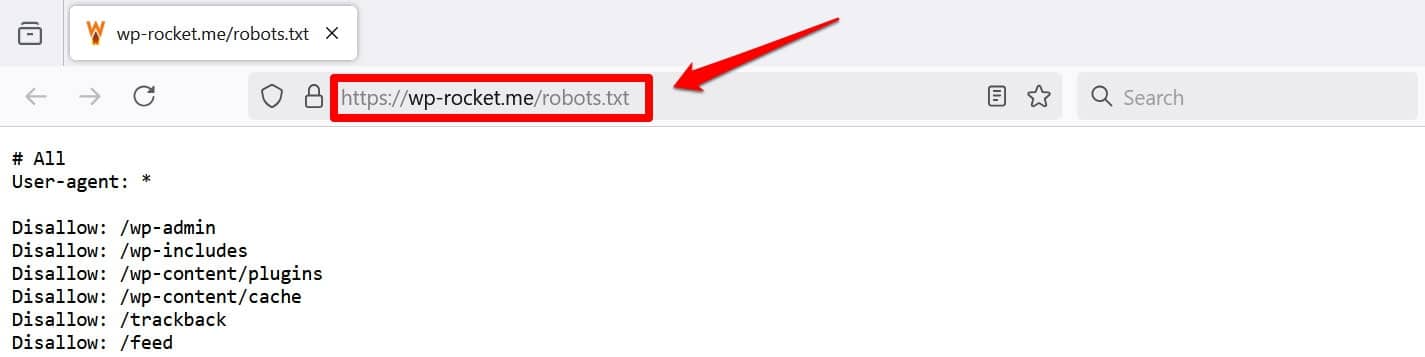

Outra maneira de pelo menos visualizar seu arquivo é adicionar /robots.txt ao seu domínio, por exemplo, https://wp-rocket.me/robots.txt.

Além disso, existem maneiras de acessar o arquivo no back-end do WordPress. Muitos plug-ins de SEO permitem que você veja e frequentemente faça alterações na interface de administração.

Alternativamente, você também pode usar um plugin como WPCode.

Qual é a aparência de um bom arquivo robots.txt do WordPress?

Não existe uma resposta única para quais diretivas devem estar no arquivo do seu site; depende da sua configuração. Aqui está um exemplo que faz sentido para muitos sites WordPress:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php Sitemap: https://yourwebsite.com/sitemap.xmlEste exemplo alcança vários resultados:

- Bloqueia o acesso à área administrativa

- Permite acesso a funcionalidades administrativas essenciais

- Fornece uma localização do mapa do site

Essa configuração atinge um equilíbrio entre segurança, desempenho de SEO e rastreamento eficiente.

Não cometa esses 14 erros do robots.txt do WordPress

Se seu objetivo é configurar e otimizar o robots.txt para seu próprio site, evite os seguintes erros.

1. Ignorando o robots.txt interno do WordPress

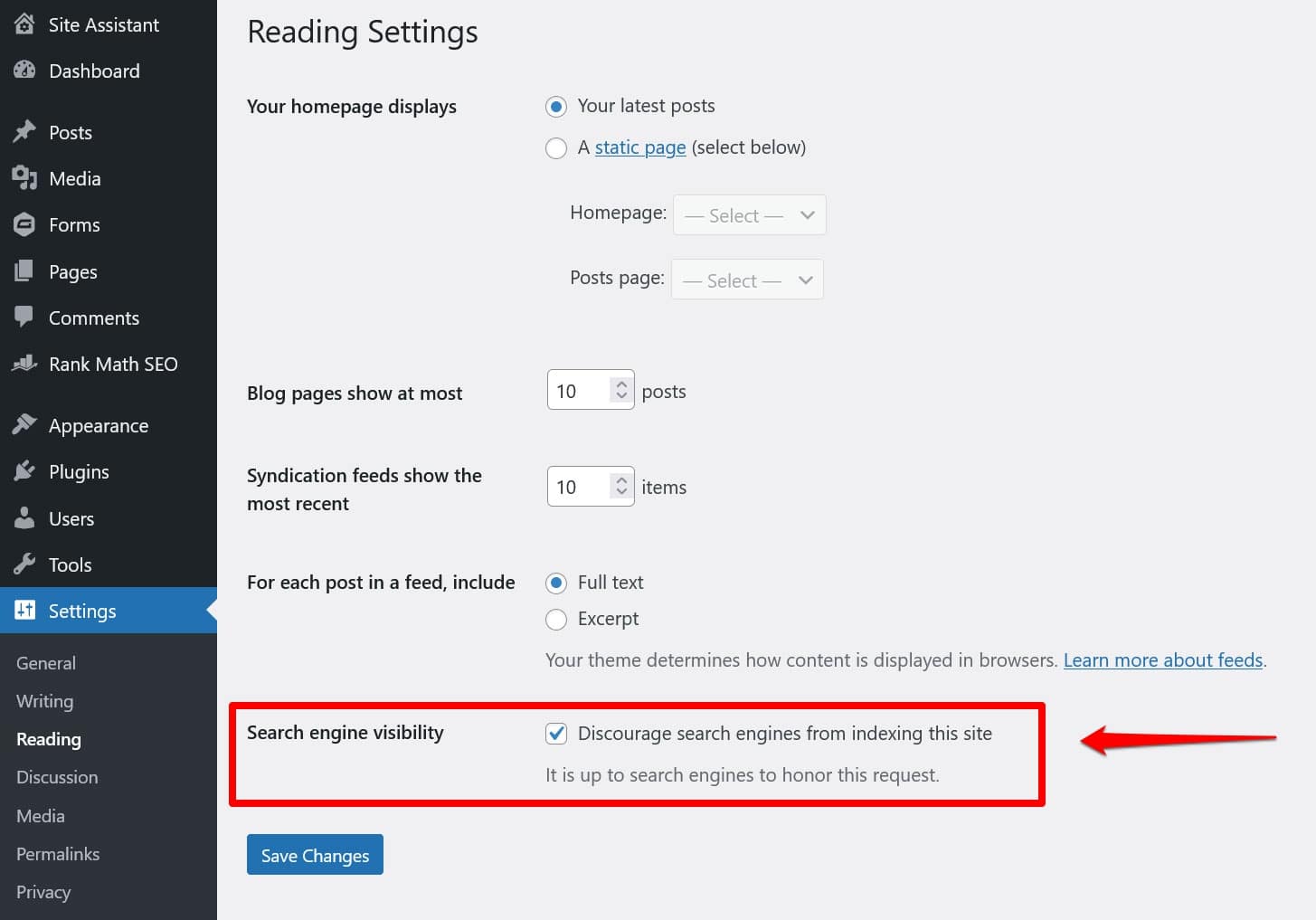

Mesmo que você não tenha um arquivo robots.txt “físico” no diretório raiz do seu site, o WordPress vem com seu próprio arquivo virtual. É especialmente importante lembrar disso se você descobrir que os mecanismos de pesquisa não estão indexando seu site.

Nesse caso, há uma boa chance de você ter ativado a opção de desencorajá-los de fazer isso em Configurações > Leitura .

Isso coloca uma diretiva para manter todos os rastreadores de pesquisa fora do robots.txt virtual. Para desativá-lo, desmarque a caixa e salve-a na parte inferior.

2. Colocando no local errado

Os bots, principalmente os rastreadores de pesquisa, procuram seu arquivo robots.txt apenas em um local: o diretório raiz do seu site. Se você colocá-lo em qualquer outro lugar, como em uma pasta, eles não o encontrarão e irão ignorá-lo.

Seu diretório raiz deve ser o local onde você acessa o servidor via FTP, a menos que você tenha colocado o WordPress em um subdiretório. Se você vir as pastas wp-admin , wp-content e wp-includes , você está no lugar certo.

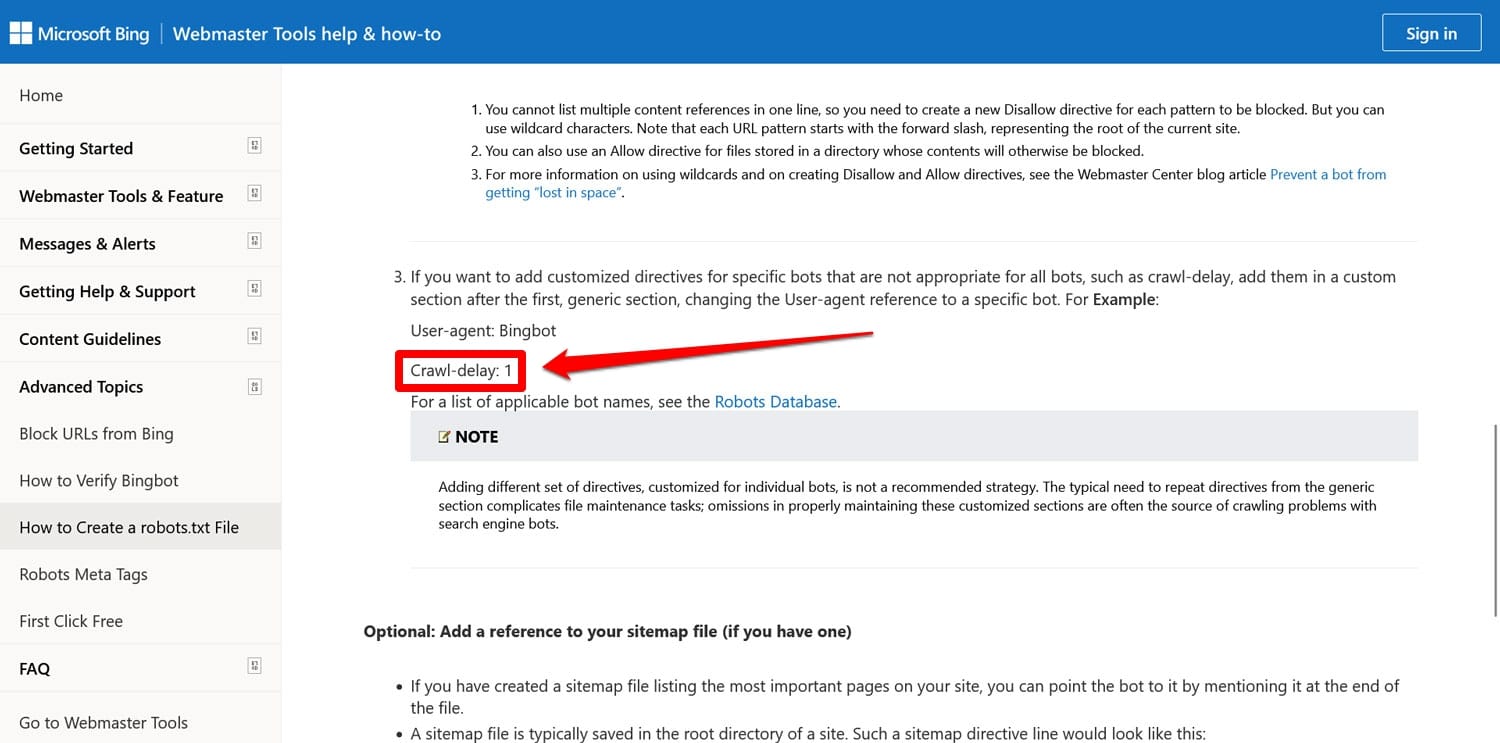

3. Incluindo marcação desatualizada

Além das diretivas mencionadas acima, há mais duas que você ainda pode encontrar em arquivos robots.txt de sites mais antigos:

- Noindex – Usado para especificar URLs que os mecanismos de pesquisa não devem indexar em seu site.

- Crawl-delay – Uma diretiva destinada a limitar os rastreadores para que não sobrecarreguem os recursos do servidor web.

Ambas as diretivas são agora ignoradas, pelo menos pelo Google. O Bing, pelo menos, ainda respeita o atraso no rastreamento.

Na maioria das vezes, é melhor não usar essas diretivas. Isso ajuda a manter seu arquivo simples e reduz o risco de erros.

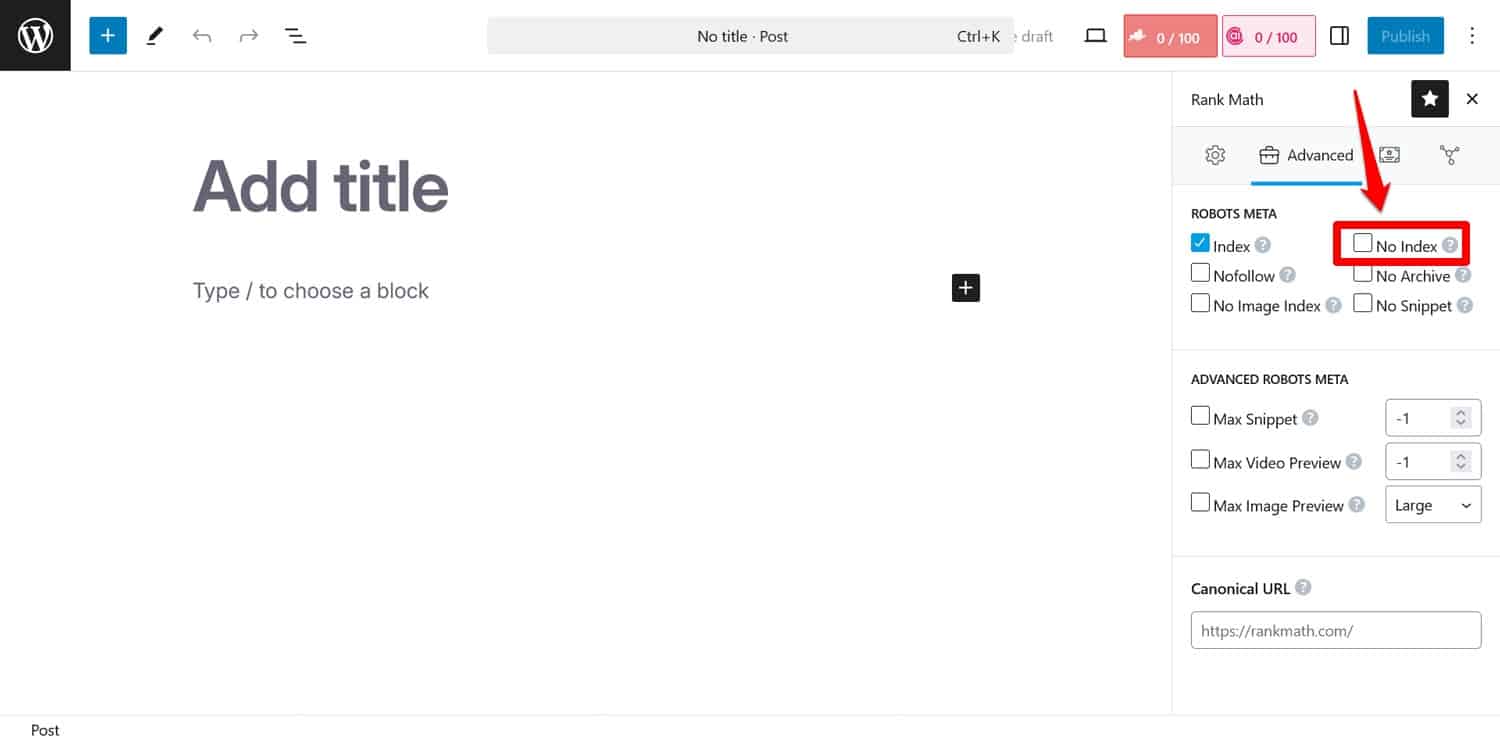

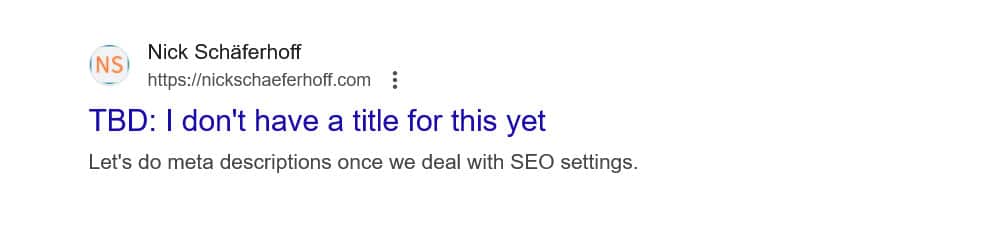

Dica: se o seu objetivo é impedir que os mecanismos de pesquisa indexem determinadas páginas, use a meta tag noindex . Você pode implementá-lo com um plugin de SEO por página.

Se você bloquear páginas por meio do robots.txt, os rastreadores não chegarão à parte onde veem a tag noindex . Dessa forma, eles ainda poderão indexar sua página, mas sem o conteúdo, o que é pior.

4. Bloqueio de recursos essenciais

Um dos erros que as pessoas cometem é usar o robots.txt para bloquear o acesso a todas as folhas de estilo (arquivos CSS) e scripts (arquivos JavaScript) em seu site WordPress para preservar o orçamento de rastreamento.

No entanto, isso não é uma boa ideia. Os bots dos mecanismos de pesquisa renderizam as páginas para “vê-las” da mesma forma que os visitantes. Isso os ajuda a compreender o conteúdo para que possam indexá-lo de acordo.

Ao bloquear esses recursos, você pode dar aos mecanismos de busca uma impressão errada de suas páginas, potencialmente levando-as a não serem indexadas adequadamente ou prejudicando sua classificação.

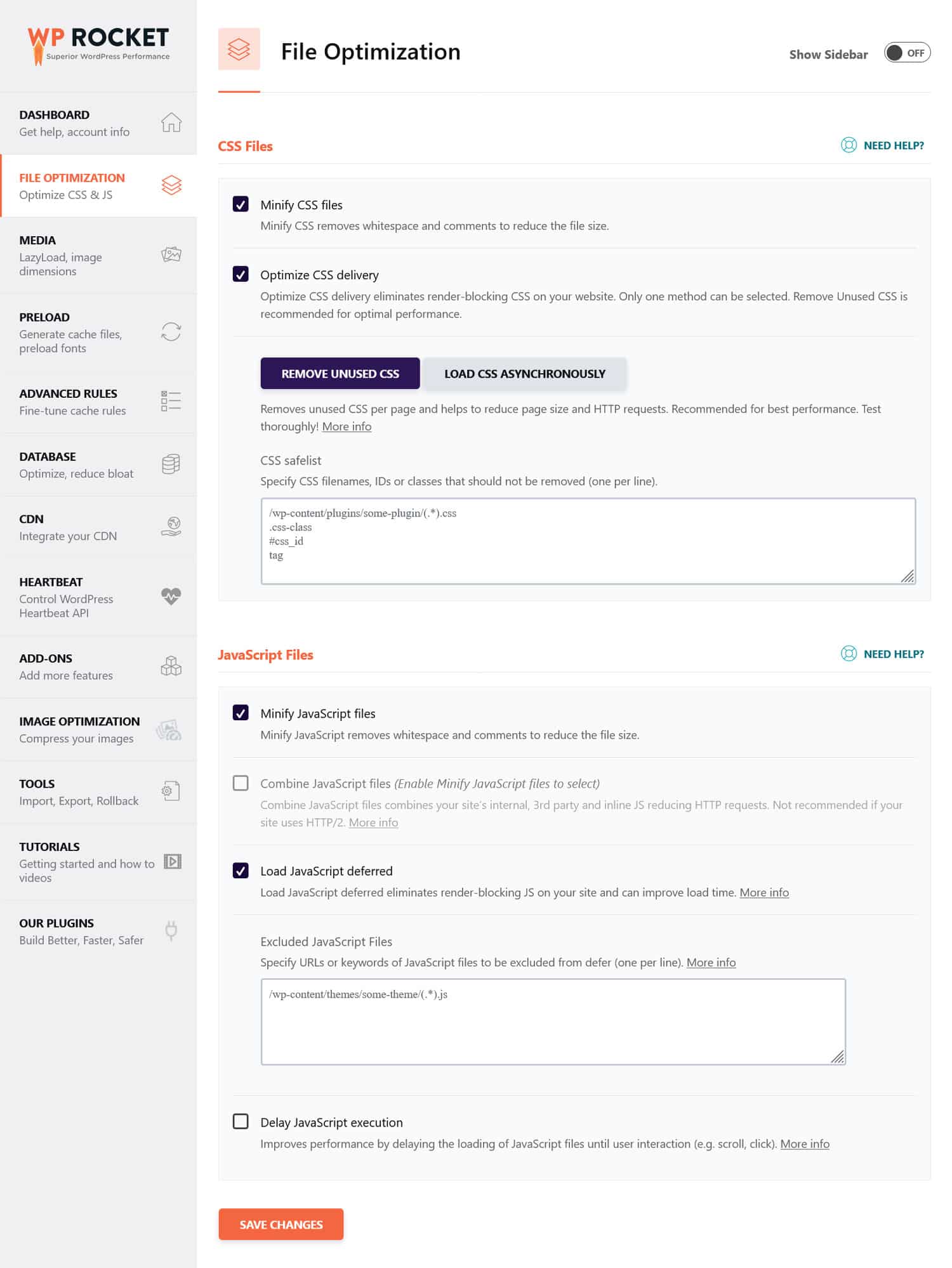

Se você acha que os arquivos CSS e JavaScript podem prejudicar o desempenho do seu site, é melhor otimizá-los para carregar rapidamente, tanto para bots quanto para visitantes regulares. Você pode fazer isso minimizando o código e compactando os arquivos do site para que sejam transmitidos mais rapidamente. Além disso, é possível otimizar a entrega eliminando código não utilizado e adiando recursos de bloqueio de renderização.

Dica : você pode simplificar esse processo usando um plugin de desempenho como o WP Rocket. Sua interface amigável permite otimizar a entrega de arquivos marcando algumas caixas no menu Otimização de Arquivos .

WP Rocket também vem com recursos adicionais para melhorar o desempenho do site, incluindo:

- Cache, com cache móvel dedicado

- Carregamento lento para imagens e vídeos

- Pré-carregamento de cache, links, arquivos externos e fontes

- Otimização de banco de dados

Além disso, o plugin implementa muitas etapas de otimização automaticamente. Os exemplos incluem cache de navegador e servidor, compactação GZIP e otimização de imagens acima da dobra para melhorar o LCP. Dessa forma, seu site ficará mais rápido simplesmente ligando o WP Rocket.

O plugin também oferece garantia de devolução do dinheiro em 14 dias, para que você possa testá-lo sem riscos.

5. Falha ao atualizar seu robots.txt de desenvolvimento

Ao construir um site, os desenvolvedores geralmente incluem um arquivo robots.txt que proíbe o acesso de todos os bots. Isso faz sentido; a última coisa que você deseja é que seu site inacabado apareça nos resultados de pesquisa.

Um problema só ocorre quando você transfere acidentalmente esse arquivo para o servidor de produção e impede que os mecanismos de pesquisa indexem também o seu site ativo. Definitivamente, verifique isso se o seu conteúdo se recusar a aparecer nos resultados de pesquisa.

6. Não incluindo um link para o seu sitemap

O link para o mapa do seu site a partir do robots.txt fornece aos rastreadores dos mecanismos de pesquisa uma lista de todo o seu conteúdo. Isso aumenta suas chances de indexarem mais do que apenas a página atual que acessaram.

Basta uma linha:

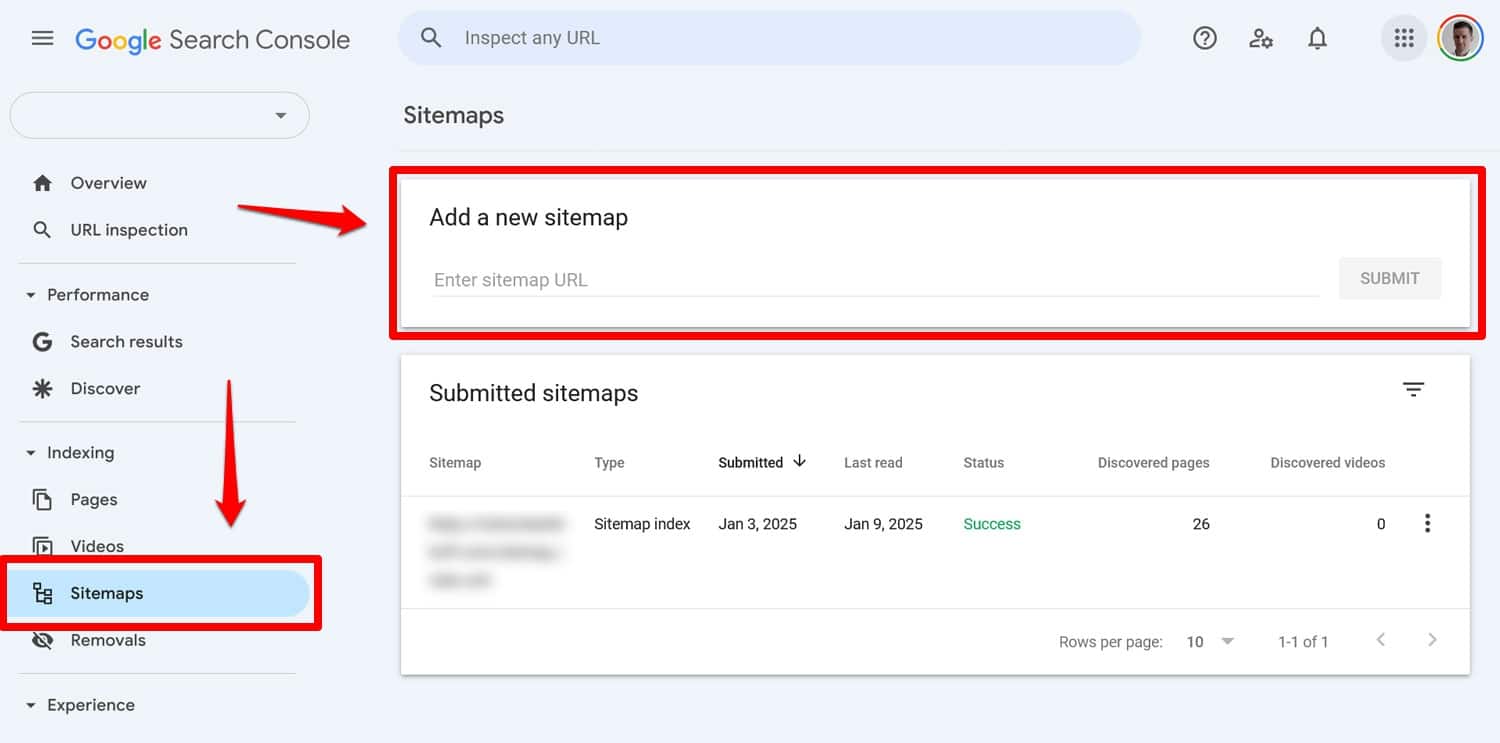

Sitemap: https://yourwebsite.com/sitemap.xmlSim, você também pode enviar seu sitemap diretamente em ferramentas como o Google Search Console.

No entanto, incluí-lo em seu arquivo robots.txt ainda é útil, especialmente para mecanismos de pesquisa cujas ferramentas para webmasters você não está usando.

7. Usando regras conflitantes

Um erro comum na criação de um arquivo robots.txt é adicionar regras que se contradizem, como:

User-agent: * Disallow: /blog/ Allow: /blog/As diretivas acima não deixam claro aos mecanismos de pesquisa se devem rastrear o diretório /blog/ ou não. Isso leva a resultados imprevisíveis e pode prejudicar o seu SEO.

| Curioso para saber o que mais pode ser prejudicial às classificações de pesquisa do seu site e como evitá-lo? Aprenda sobre isso em nosso guia sobre erros de SEO. |

Para evitar conflitos, siga estas práticas recomendadas:

- Use regras específicas primeiro – Coloque regras mais específicas antes das mais amplas.

- Evite redundância – Não inclua diretivas opostas para o mesmo caminho.

- Teste seu arquivo robots.txt – Use ferramentas para confirmar se as regras se comportam conforme o esperado. Mais sobre isso abaixo.

8. Tentando ocultar conteúdo confidencial com robots.txt

Conforme mencionado anteriormente, o robots.txt não é uma ferramenta para manter o conteúdo fora dos resultados de pesquisa. Na verdade, como o arquivo é acessível publicamente, usá-lo para bloquear conteúdo confidencial pode revelar inadvertidamente exatamente onde esse conteúdo está localizado.

Dica : use a meta tag noindex para manter o conteúdo fora dos resultados da pesquisa. Além disso, proteja com senha áreas confidenciais do seu site para mantê-las protegidas contra robôs e usuários não autorizados.

9. Emprego indevido de curingas

Os curingas permitem incluir grandes grupos de caminhos ou arquivos em suas diretivas. Já conhecemos um antes, o símbolo *. Significa “cada instância de” e é usado com mais frequência para definir regras que se aplicam a todos os agentes de usuário.

Outro símbolo curinga é $, que aplica regras à parte final de uma URL. Você pode usá-lo, por exemplo, se quiser impedir que rastreadores acessem todos os arquivos PDF do seu site:

Disallow: /*.pdf$Embora os curingas sejam úteis, eles podem ter consequências de amplo alcance. Use-os com cuidado e sempre teste seu arquivo robots.txt para garantir que não cometeu nenhum erro.

10. URLs absolutos e relativos confusos

Aqui está a diferença entre URLs absolutos e relativos:

- URL absoluto – https://yourwebsite.com/private/

- URL relativo – /privado/

É recomendado que você use URLs relativos em suas diretivas robots.txt, por exemplo:

Disallow: /private/URLs absolutos podem causar problemas em que os bots podem ignorar ou interpretar mal a diretiva. A única exceção é o caminho para o mapa do site, que precisa ser um URL absoluto.

11. Ignorando a distinção entre maiúsculas e minúsculas

As diretivas Robots.txt diferenciam maiúsculas de minúsculas. Isso significa que as duas diretivas a seguir não são intercambiáveis:

Disallow: /Private/ Disallow: /private/Se você descobrir que seu arquivo robots.txt não está se comportando conforme o esperado, verifique se o problema pode ser a utilização incorreta de letras maiúsculas.

12. Usando barras finais incorretamente

Uma barra final é uma barra no final de um URL:

- Sem uma barra final : /directory

- Com uma barra final : /directory/

No robots.txt ele decide quais recursos do site são permitidos e não permitidos. Aqui está um exemplo:

Disallow: /private/A regra acima impede que os rastreadores acessem o diretório “privado” do seu site e tudo o que ele contém. Por outro lado, digamos que você deixe de fora a barra final, assim:

Disallow: /privateNesse caso, a regra também bloquearia outras instâncias começando com “privadas” no seu site, como:

- https://seusite.com/private.html

- https://seusite.com/privateer

Portanto, é importante ser preciso. Em caso de dúvida, teste seu arquivo.

13. Robots.txt ausente para subdomínios

Cada subdomínio do seu site (por exemplo, dev.seuwebsite.com) precisa de seu próprio arquivo robots.txt porque os mecanismos de pesquisa os tratam como entidades da web separadas. Sem um arquivo instalado, você corre o risco de os rastreadores indexarem partes do seu site que você pretendia manter ocultas.

Por exemplo, se sua versão de desenvolvimento estiver em uma pasta chamada “dev” e usar um subdomínio, certifique-se de que ela tenha um arquivo robots.txt dedicado para bloquear rastreadores de pesquisa.

14. Não testando seu arquivo robots.txt

Um dos maiores erros ao configurar seu arquivo robots.txt do WordPress é não testá-lo, especialmente depois de fazer alterações.

Como vimos, mesmo pequenos erros de sintaxe ou lógica podem causar problemas significativos de SEO. Portanto, sempre teste seu arquivo robots.txt.

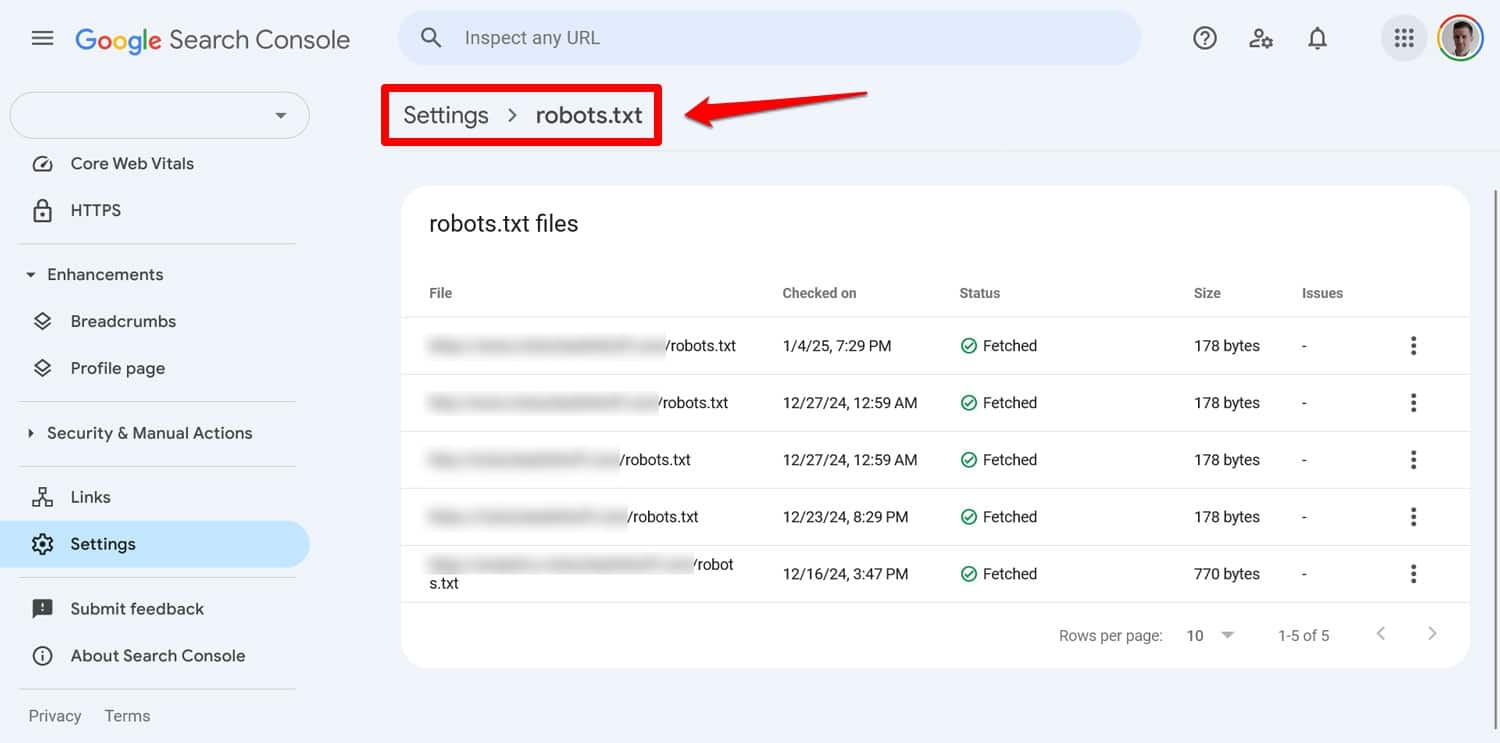

Você pode ver quaisquer problemas com seu arquivo no Google Search Console em Configurações > robots.txt .

Outra maneira é simular o comportamento de rastreamento com uma ferramenta como o Screaming Frog. Além disso, use um ambiente de teste para verificar o impacto das novas regras antes de aplicá-las ao seu site ativo.

Como se recuperar de um erro robots.txt

Erros em seu arquivo robots.txt são fáceis de cometer, mas, felizmente, também costumam ser simples de corrigir quando você os descobre.

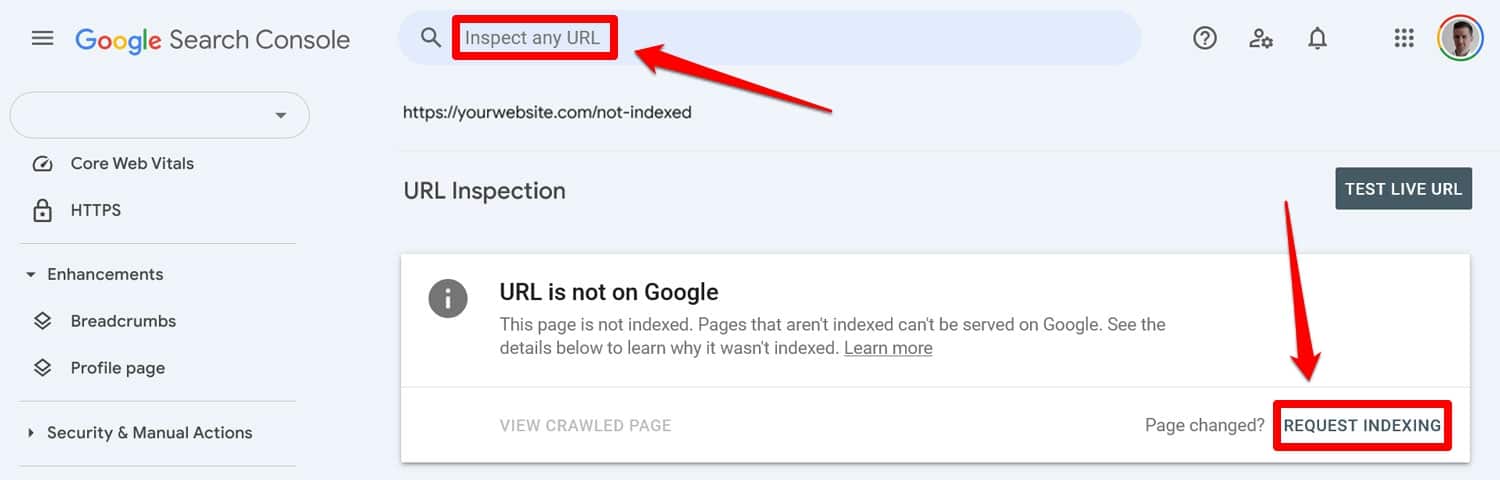

Comece executando seu arquivo robots.txt atualizado por meio de uma ferramenta de teste. Então, se as páginas foram bloqueadas anteriormente pelas diretivas robots.txt, insira-as manualmente no Google Search Console ou nas Ferramentas do Google para webmasters para solicitar a indexação.

Além disso, reenvie uma versão atualizada do seu mapa do site.

Depois disso, é apenas um jogo de espera. Os mecanismos de pesquisa revisitarão seu site e, com sorte, restaurarão rapidamente sua posição no ranking.

Assuma o controle do seu robots.txt WordPress

Com arquivos robots.txt, um grama de prevenção é melhor do que meio quilo de cura. Especialmente em sites maiores, um arquivo defeituoso pode causar estragos nas classificações, no tráfego e na receita.

Por esse motivo, quaisquer alterações no robots.txt do seu site devem ser feitas com cuidado e com testes extensivos. Conscientizar-se dos erros que você pode cometer é o primeiro passo para evitá-los.

Quando você cometer um erro, tente não entrar em pânico. Diagnostique o que há de errado, corrija quaisquer erros e reenvie o mapa do site para que ele seja rastreado novamente.

Por fim, certifique-se de que o desempenho não seja o motivo pelo qual os mecanismos de pesquisa não rastreiam seu site adequadamente. Experimente o WP Rocket agora para tornar seu site mais rápido instantaneamente!