Como otimizar facilmente o WordPress Robots.txt?

Publicados: 2023-02-28Introdução

Existem inúmeras técnicas para aumentar o SEO do seu site. Otimizar o WordPress Robots.txt é um dos melhores métodos. Como permite que os mecanismos de pesquisa verifiquem seu site, o arquivo Robots.txt é conhecido como uma poderosa ferramenta de SEO. Como resultado, você pode melhorar livremente o SEO do seu site ajustando o arquivo Robots.txt. Apresentaremos claramente algumas abordagens para otimizar o WordPress Robots.txt neste tópico nesta postagem do blog hoje.

A definição do arquivo Robots.txt

Abaixo está um resumo do arquivo Robots.txt do WordPress.

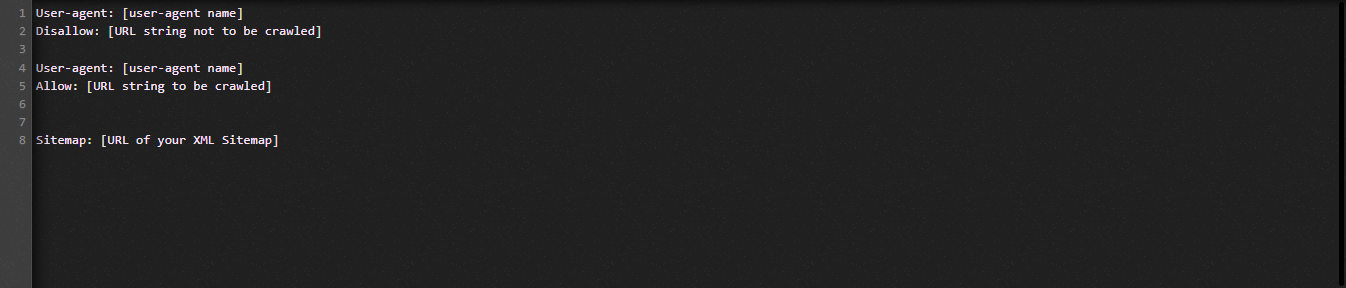

Vamos agora dar uma olhada na estrutura fundamental do arquivo Robot.txt:

Deixe-nos definir os termos usados no arquivo Robots.txt para você:

- User-agent: o nome do rastreador

- Proibir: impede que as páginas, pastas ou arquivos de um site sejam rastreados.

- Permitir: ativar rastreamento de diretório, arquivo e página

- Mapa do site, se fornecido: Mostra a localização do mapa do site: representa um número ou uma letra.

- *: Representa número ou caractere

- $: Você pode usá-lo para restringir as páginas da web que incluem uma extensão específica, ficando até o final da linha.

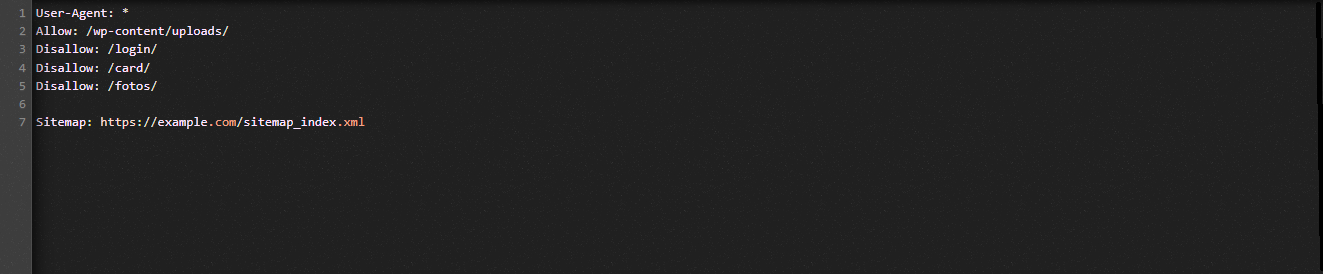

Vejamos a ilustração a seguir para ajudá-lo a compreender:

Permitimos que os mecanismos de pesquisa rastreiem os arquivos na pasta de uploads do WordPress no exemplo Robot.txt.

No entanto, restringimos o acesso dos mecanismos de pesquisa às pastas de login, cartão e fotos.

Por fim, fornecemos a URL do mapa do site.

Por que um arquivo Robots.txt deve ser criado para o seu site WordPress?

Sem um arquivo Robots.txt, os mecanismos de pesquisa ainda rastrearão e indexarão todas as páginas de um site. No entanto, eles rastrearão todo o material do seu site, e não apenas as pastas ou páginas que você especificar.

Você deve criar um arquivo Robots.txt para o seu site por dois motivos principais. Em primeiro lugar, você pode facilmente gerenciar todas as informações em seu site com sua ajuda. Se as páginas ou diretórios devem ser rastreados ou indexados, depende de você. Isso significa que páginas como arquivos de plug-in, páginas de administração ou diretórios de temas não serão rastreadas pelos mecanismos de pesquisa. Como resultado, ajudará na velocidade de carregamento do índice do seu site.

A exigência de impedir que postagens ou páginas desnecessárias sejam indexadas pelos mecanismos de pesquisa é outra justificativa. Portanto, você pode impedir que uma página ou postagem do WordPress apareça nos resultados de pesquisa de maneira fácil e conveniente.

Como otimizar o WordPress Robots.txt de forma mais eficiente

Neste blog instrutivo, mostraremos como criar e melhorar o arquivo Robots.txt em seu site WordPress usando dois métodos diferentes:

- Fazendo alterações no arquivo Robots.txt usando um plugin: All in One SEO

- Editando manualmente o arquivo Robots.txt com FTP

Para tornar o arquivo Robots.txt mais eficaz, use o plug-in All in One SEO.

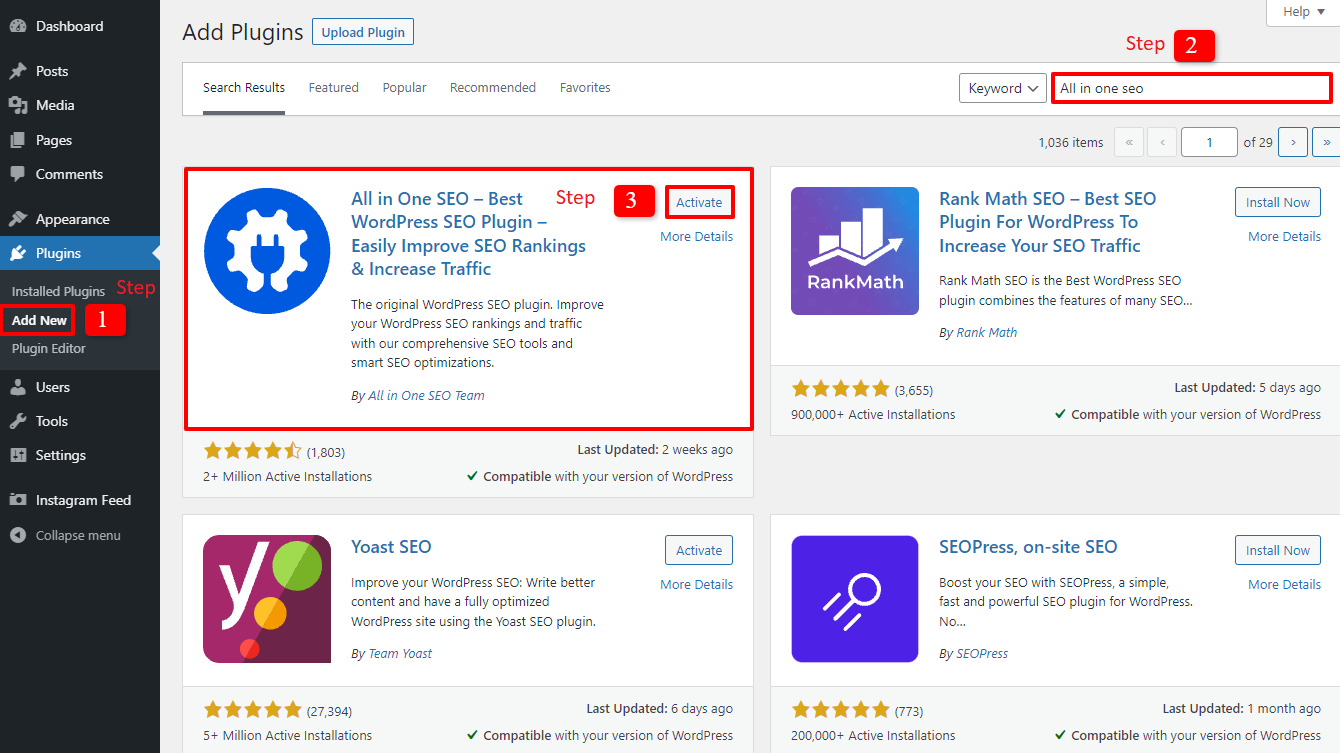

Vários plugins de SEO para WordPress estão disponíveis para ajudá-lo com esse problema no mercado WordPress. Mas neste artigo, optamos por empregar o All in One SEO, um plug-in popular com mais de 2 milhões de usuários, para ajudá-lo.

Vamos instalá-lo primeiro selecionando Plugins -> Adicionar novo . em seguida, procure o nome do plug-in, instale- o e ative- o.

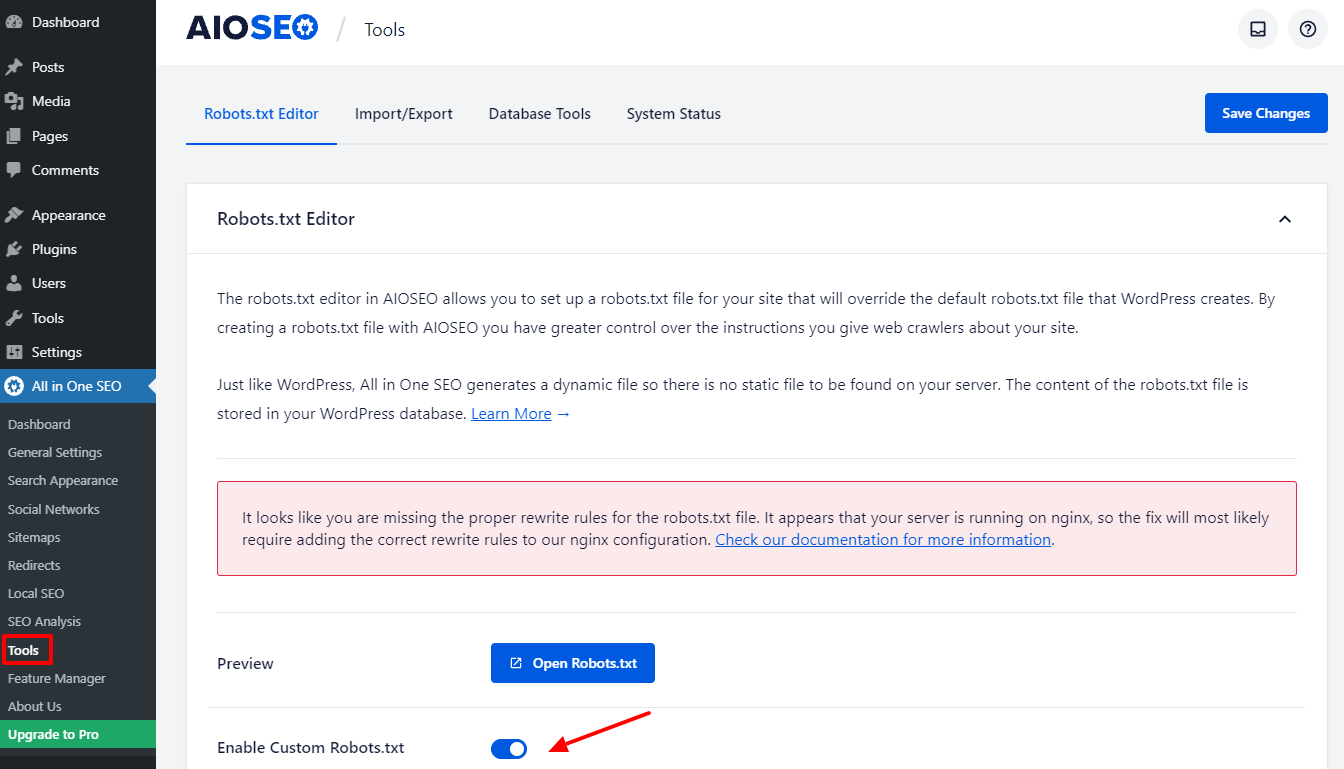

Você retornará ao painel de administração após concluir algumas etapas fáceis. Vá para Tudo em um SEO -> Ferramentas agora mesmo.

Vamos alternar o botão Enable Custome Robots.txt na seção Robots.txt Editor para torná-lo ativo. Depois de ligá-lo, você pode editar o arquivo Robots.txt padrão no WordPress.

Ao rolar para baixo, você notará que este plug-in exibe uma caixa com uma visualização do arquivo Robots.txt. Estas são as regras padrão do WordPress.

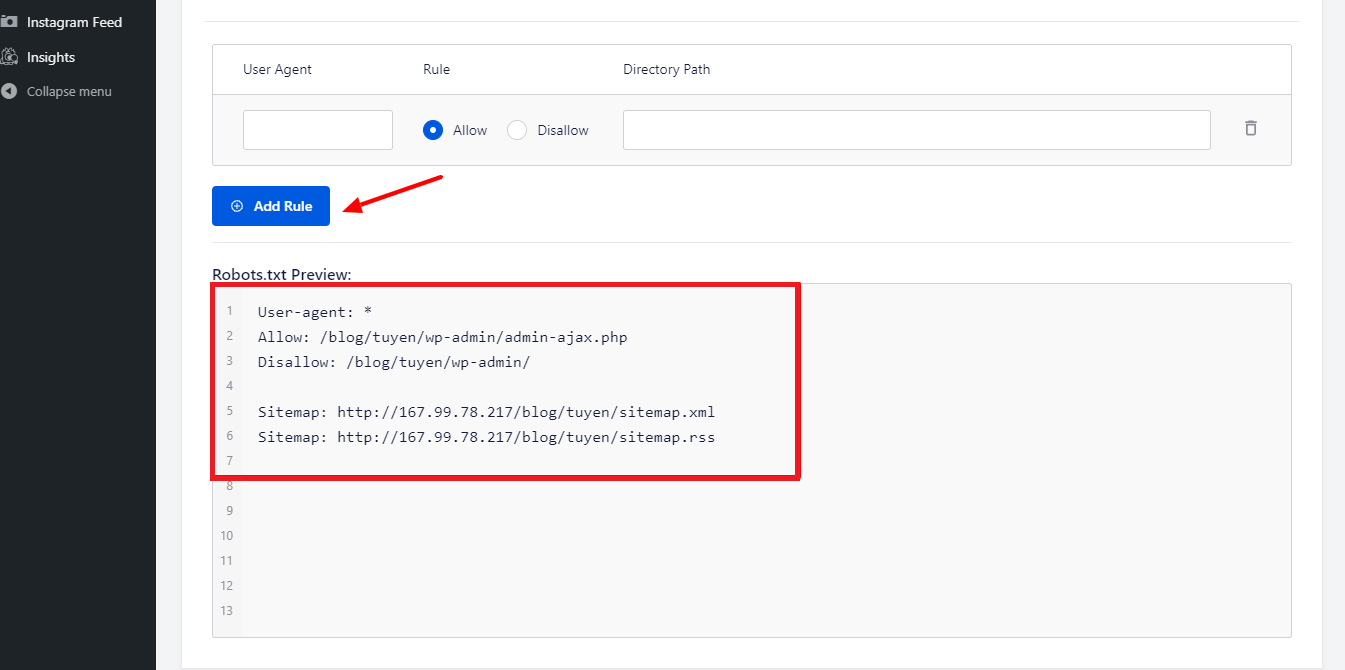

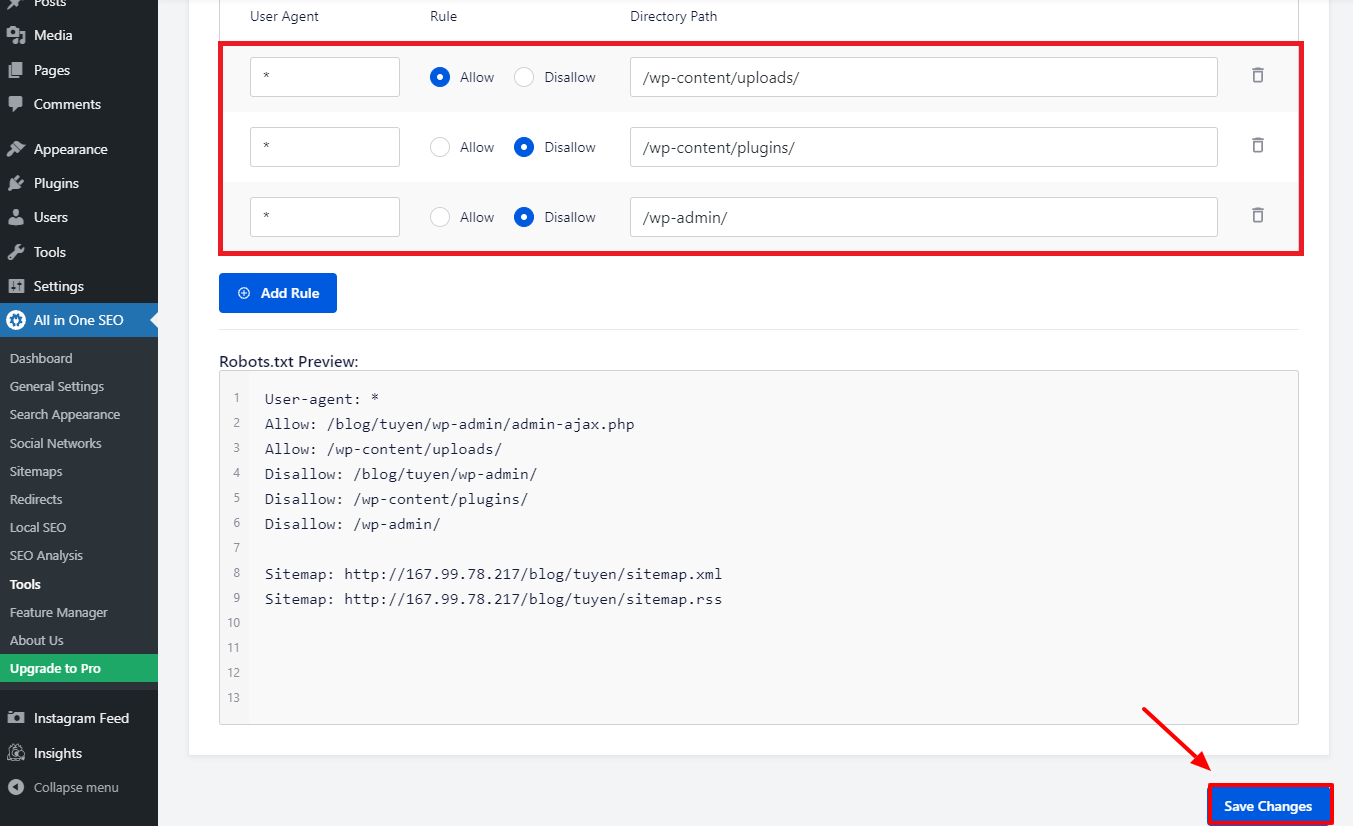

Ao selecionar o botão Adicionar regra , você pode adicionar mais regras específicas para ajudar o SEO do seu site.

Vamos inserir um * no campo User-Agent para aplicar a regra a todos os agentes do usuário para adicionar uma nova regra.

Você só precisa selecionar Permitir ou Proibir para que os bots de pesquisa rastreiem no estágio seguinte.

Não se esqueça de inserir o nome do arquivo ou o caminho do diretório no campo Directory Path depois disso.

Quando terminar com todas as suas preferências, vamos pressionar o botão Salvar alterações .

Todas as regras adicionais que você já adicionou serão imediatamente aplicadas ao arquivo Robots.txt.

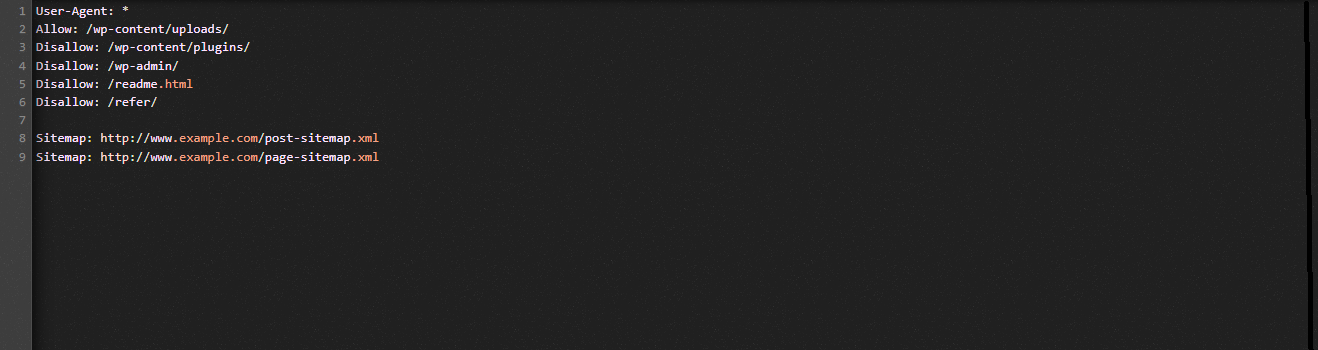

Modifique e otimize manualmente o WordPress Robots.txt usando FTP

Esta é uma abordagem diferente para a otimização do WordPress Robots.txt que você pode gostar. Você deve editar o arquivo Robots.txt usando um cliente FTP para conseguir isso.

Para utilizar o cliente FPT de forma conveniente, vamos primeiro estabelecer uma conexão com sua conta de hospedagem WordPress. Você pode notar facilmente o arquivo Robots.txt na pasta raiz do seu site ao acessá-lo. Vamos escolher Exibir/Editar clicando com o botão direito do mouse.

Por outro lado, você provavelmente não tem nada se não conseguir encontrar. Então, vamos primeiro criar um arquivo Robots.txt para o seu site selecionando Criar um novo arquivo com o botão direito do mouse.

O arquivo Robots.txt é um arquivo de texto simples, então você pode baixá-lo e editá-lo usando um editor de texto simples como Bloco de Notas ou TextEdit, entre outros. Você simplesmente precisa carregá-lo de volta para a pasta raiz do seu site depois disso. Parece fácil, você não acha?

Verifique se o arquivo Robots.txt do seu site WordPress está funcionando.

Seu arquivo Robots.txt deve ser testado uma vez que você já o preparou e configurou para que quaisquer problemas possam ser identificados e relatados. Como resultado, você deve testá-lo usando uma ferramenta de teste do Robots.txt. Experimente o Google Search Console, pois é altamente recomendável.

Você deve garantir que seu site esteja vinculado ao Google Search Console se desejar usar este serviço. Você pode então usar a Ferramenta de Teste de Robôs selecionando a propriedade na lista de seleção. O arquivo Robots.txt para seu site agora será adicionado automaticamente. Ele irá alertá-lo se houver um erro.

Conclusão

No geral, o principal objetivo de otimizar o arquivo Robots.txt é impedir que os bots de pesquisa acessem páginas que não são necessárias para o público em geral, incluindo pastas de plugins ou pastas administrativas. Como resultado, bloquear tags, categorias ou páginas de arquivo do WordPress não ajudará seu SEO. Em outras palavras, para criar um arquivo Robots.txt perfeito para o seu site WordPress, você deve aderir ao padrão abaixo.

Esperamos que você ache a postagem do blog hoje útil para otimizar o WordPress Robots.txt. Lembre-se de passá-lo adiante para seus conhecidos e outros webmasters. Além disso, deixe um comentário abaixo se tiver alguma dúvida. Assim, responderemos a você o mais breve possível. É hora de você otimizar o WordPress Robots.txt. Até os próximos blogs, cuidem-se.

A propósito, temos uma tonelada de temas WordPress contemporâneos, atraentes e gratuitos que oferecem suporte total a esse recurso útil. Vamos vê-los e pedir a um deles para redesenhar seu site