Como otimizar seu WordPress Robots.txt para SEO

Publicados: 2022-08-23Neste blog, vamos aprender algumas dicas de como você pode melhorar o SEO do seu site otimizando o arquivo robts.txt.

Na verdade, o arquivo Robots.txt desempenha um papel importante em termos de SEO, pois informa aos mecanismos de pesquisa como seu site pode ser rastreado. Esta é a razão pela qual os arquivos Robot.txt são considerados uma das ferramentas mais poderosas de SEO.

Mais tarde, você também aprenderá como criar e otimizar o WordPress Robots.txt para SEO.

O que você quer dizer com arquivo robots.txt?

O arquivo de texto criado pelos proprietários de sites para informar aos bots de mecanismos de pesquisa como eles podem rastrear em seu site e indexar páginas é conhecido como Robots.txt

Na verdade, no diretório raiz, esse arquivo é armazenado. Esse diretório também é chamado de pasta principal do seu site. Mencionado abaixo é o formato de arquivo para o arquivo robots.txt

Agente do usuário: [nome do agente do usuário] Não permitir: [string de URL a não ser rastreada] Agente do usuário: [nome do agente do usuário] Permitir: [string de URL a ser rastreada] Sitemap: [URL do seu Sitemap XML]

Para permitir ou proibir URLs específicos, você pode ter diferentes linhas de instruções. Além disso, você também pode adicionar diferentes sitemaps. Os bots do mecanismo de pesquisa considerarão que têm permissão para rastrear as páginas se permitirem um URL.

Exemplo de robots.txt é dado abaixo

Agente de usuário: * Permitir: /wp-content/uploads/ Não permitir: /wp-content/plugins/ Não permitir: /wp-admin/ Mapa do site: https://example.com/sitemap_index.xml

No exemplo acima, permitimos rastrear as páginas pelos mecanismos de pesquisa e obter arquivos de índice na pasta de uploads do WordPress.

Depois disso, não permitimos que os bots de pesquisa rastreiem e indexem pastas e plugins de administração do WordPress.

Por último, mencionamos a URL do sitemap XML.

Para o seu site WordPress, você precisa de um arquivo Robots.txt?

O mecanismo de pesquisa começará a rastrear e indexar suas páginas mesmo se você não tiver o arquivo de texto, ou seja, Robots.txt. Mas, infelizmente, você não pode informar ao seu mecanismo de pesquisa qual pasta ou página específica ele deve rastrear.

Não vai lucrar ou não vai deixar nenhum impacto se você acabou de criar um site ou blog com menos conteúdo.

No entanto, depois de configurar seu site com muito conteúdo e quando ele começar a crescer, você precisará controlar as páginas rastreadas e indexadas do seu site.

A primeira razão é dada abaixo

Para cada site, os bots de pesquisa têm uma cota de rastreamento.

Isso significa claramente que, durante a sessão de rastreamento, ele rastreará o número específico de páginas. Suponha que o rastreamento em seu site permaneça incompleto, então ele voltará mais uma vez e retomará o rastreamento em outra sessão.

Por causa disso, a taxa de indexação do seu site será um confronto.

Você pode corrigir esse problema não permitindo que os bots de pesquisa não rastreiem essas páginas que não são necessárias. Algumas páginas sem importância podem incluir arquivos de plugins, páginas de administração do WordPress e pastas de temas.

A cota de rastreamento pode ser salva ao não permitir que páginas indesejadas sejam rastreadas. Esta etapa será mais útil porque os mecanismos de pesquisa agora rastrearão as páginas do site e poderão indexá-las o mais rápido possível.

Outra razão pela qual você deve usar e otimizar o arquivo WordPress Robots.txt é dado abaixo

Sempre que você precisar impedir que os mecanismos de pesquisa indexem páginas ou postagens em seu site, poderá usar esse arquivo.

Na verdade, é uma das maneiras mais impróprias de cobrir o conteúdo do seu site do público em geral, mas será o melhor suporte para protegê-los para aparecer nos resultados de pesquisa.

Como o arquivo Robots.txt aparece?

Um arquivo robots.txt muito simples é usado pelos blogs mais populares. O conteúdo pode diferir em comparação com a exigência do site específico.

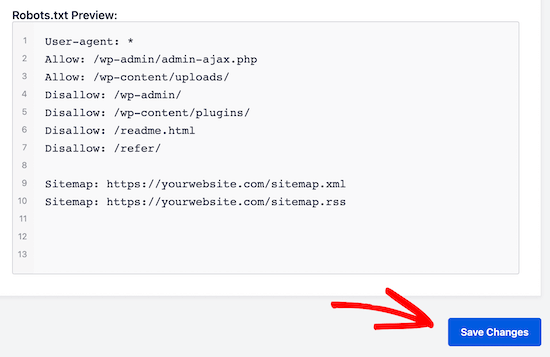

Agente de usuário: * Não permitir: Mapa do site: http://www.example.com/post-sitemap.xml Mapa do site: http://www.example.com/page-sitemap.xml Todos os bots serão permitidos pelo arquivo robots.txt para indexar todo o conteúdo e oferecer links para o site do sitemap XML. São mencionadas as seguintes regras que precisam ser seguidas nos arquivos robots.txt Agente de usuário: * Permitir: /wp-content/uploads/ Não permitir: /wp-content/plugins/ Não permitir: /wp-admin/ Não permitir: /readme.html Não permitir: /refer/ Mapa do site: http://www.example.com/post-sitemap.xml Mapa do site: http://www.example.com/page-sitemap.xml

Isso indicará o bot para indexar todos os arquivos e imagens do WordPress. Isso não permitirá que os bots de pesquisa indexem a área de administração do WordPress, os arquivos de plug-in do WordPress, os links de afiliados e o arquivo leia-me do WordPress.

Para arquivos robots.txt, você pode adicionar sitemaps que ajudarão os bots do Google a reconhecer todas as páginas do seu site.

Agora que você já sabe como é o arquivo robots.txt, agora vamos aprender como o arquivo robots.txt pode ser criado no WordPress.

No WordPress, como construir um arquivo robots.txt?

Para criar um arquivo robots.txt no WordPress existem muitas maneiras. Alguns dos principais métodos estão listados abaixo, você pode escolher qualquer um deles para funcionar melhor para você.

Método 1: Usando All in One SEO, modificando o arquivo Robots.txt

O All in One SEO é o plugin WordPress para SEO mais conhecido no mercado, usado por mais de 1 milhão de sites.

O plugin All in One SEO é muito simples de usar e, portanto, oferece o gerador de arquivos robotx.txt. Também é útil otimizar o WordPress Robots.txt

Se você ainda não integrou este plugin de SEO, instale e ative-o primeiro no painel do WordPress. A versão gratuita também está disponível para usuários iniciantes, para que possam utilizar seus recursos sem investir dinheiro.

Depois de ativar o plugin, você pode começar a usá-lo para construir ou modificar o arquivo robots.txt diretamente da sua área de administração do WordPress.

Para usá-lo

- Vá para o SEO tudo em um

- Agora para editar o arquivo robots.txt, clique nas ferramentas

- Agora clicando em 'habilitar custom robots.txt' você vai ativar a opção de edição

- No WordPress, você também pode criar um arquivo robots.txt personalizado com essa alternância.

- Agora seu arquivo robots.txt existente será mostrado pelo 'All in One SEO plugin' na seção 'visualização do robots.txt'. Isso pode ser visualizado na parte inferior da tela da web.

Por WordPress, a regra padrão que foi adicionada será mostrada por esta versão

As regras padrão que parecem sugerir ao seu mecanismo de pesquisa que eles não precisam rastrear os arquivos principais do WordPress, oferecem um link para o site do sitemap XML e permitem que os bots indexem todo o seu conteúdo.

Para aprimorar seu robots.txt para SEO, novas regras personalizadas podem ser adicionadas.

Adicione o agente do usuário no campo 'Agente do usuário' para adicionar uma regra. A regra será aplicada a todos os agentes do usuário usando um arquivo *.

Agora escolha se você deseja permitir ou não permitir que o mecanismo de pesquisa rastreie as páginas.

Agora adicione o caminho do diretório, o nome do arquivo no campo 'Caminho do diretório'.

Ao seu robots.txt, a regra será aplicada automaticamente. Clique no botão 'adicionar regra' para adicionar uma nova regra.

A menos que você crie um formato robotx.txt ideal, sugerimos que você adicione novas regras.

As regras personalizadas adicionadas por você se parecerão com

Para armazenar suas alterações não deixe de clicar em 'salvar alterações'

Método 2: Modifique o arquivo Robots.txt manualmente com a ajuda do FTP

Outro método para otimizar o WordPress Robots.txt é utilizar os recursos dos clientes FTP para começar a modificar o arquivo robots.txt

Você só precisa se conectar à sua conta de hospedagem WordPress com a ajuda de um cliente FTP

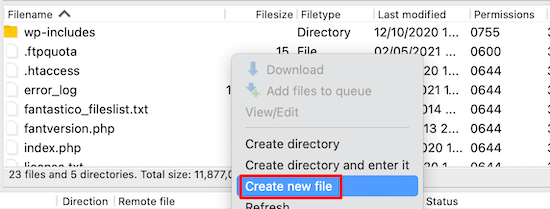

Após o login, na pasta raiz do site, você poderá visualizar o arquivo robots.txt.

Se você não conseguir encontrá-lo, significa que você não possui o arquivo robots.txt

Em tal situação, você precisa criar o arquivo robot.txt.

Como mencionado anteriormente, o arquivo robots.txt geralmente é um arquivo de texto simples que pode ser baixado em seu computador. No entanto, você pode até modificá-lo com a ajuda de um editor de texto simples, como TextEdit, Notepad ou WordPad.

Depois de ter realizado todas as alterações agora é hora de salvá-lo. Você pode enviar este arquivo para a pasta raiz do seu site.

Como você pode realizar testes em seu arquivo Robots.txt?

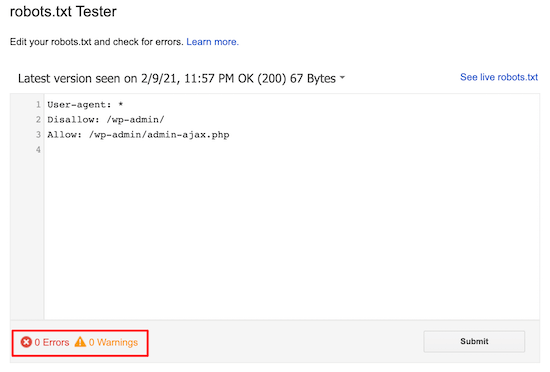

Você pode realizar testes com a ajuda da ferramenta de teste robots.txt.

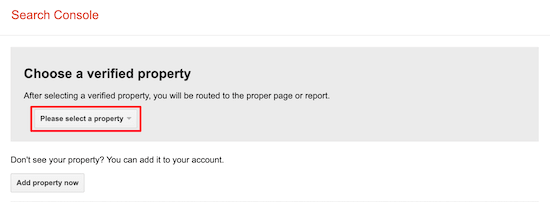

Na web, você encontrará muitas ferramentas de teste de robots.txt. Um dos melhores é o Google Search Console.

Para trabalhar com esta ferramenta, primeiro você precisa ter um site conectado ao console de pesquisa do Google. Depois disso, você pode começar a utilizar seus recursos.

Na lista suspensa, você só precisa selecionar sua propriedade.

No entanto, ele selecionará o arquivo robots.txt do seu site automaticamente e destacará todos os avisos e erros. Esta é uma das melhores ferramentas que ajudam você a otimizar o arquivo WordPress Robots.txt com muita facilidade.

Conclusão:

O principal lema da otimização desse arquivo robots.txt é proteger as páginas do rastreamento das páginas. Por exemplo, páginas na pasta de administração do WordPress ou páginas na pasta wp-plugin.

O mito mais comum é que você pode melhorar a taxa de rastreamento e torná-la indexada mais rapidamente e obter uma classificação mais alta bloqueando a categoria do WordPress, alcançar páginas e tags.

Mas isso não funcionará, pois dará errado de acordo com as diretrizes para webmasters do Google.

Recomendamos que você leia e considere todos os pontos mencionados acima.

Esperamos que este blog o ajude a criar um arquivo robots.txt usando o formato certo para seu site. E irá ajudá-lo a otimizar o WordPress Robots.txt.