Como otimizar seu WordPress Robots.txt para SEO usando Yoast SEO

Publicados: 2023-10-25A otimização de mecanismos de pesquisa (SEO) é uma parte crucial da construção de um site eficaz, e um dos fatores mais importantes para alcançar o sucesso de SEO é usar as ferramentas certas para otimizar seu site. Uma dessas ferramentas é o arquivo Robots.txt, que controla como os rastreadores dos mecanismos de pesquisa acessam e indexam seu conteúdo.

Otimizar o arquivo WordPress Robots.txt pode ajudá-lo a obter melhores classificações nos mecanismos de pesquisa, melhorar a visibilidade do seu site e aumentar o tráfego.

No entanto, apesar de sua importância, muitos proprietários de sites não estão familiarizados com a configuração adequada do arquivo Robots.txt. Nesta postagem do blog, orientaremos você em tudo o que você precisa saber para dominar seu WordPress Robots.txt para SEO e desbloquear todo o potencial de SEO para seu site.

Compreendendo o papel do robots.txt no SEO

Compreender a função do arquivo robots.txt na otimização de mecanismos de pesquisa é essencial para obter o máximo dos esforços de otimização de seu site WordPress e gerar os melhores resultados possíveis. Um arquivo de texto chamado Robots.txt, que também pode ser chamado de Protocolo de Exclusão de Robôs, fornece instruções aos rastreadores dos mecanismos de pesquisa sobre quais áreas do seu site eles devem rastrear e indexar.

Quando bots de mecanismos de pesquisa visitam seu site, a primeira coisa que fazem é verificar no diretório raiz um arquivo chamado robots.txt. Este arquivo serve como um guia para os bots, informando-os sobre os sites e arquivos que eles têm permissão para visitar e também aqueles que não têm.

Você tem controle total sobre o material que é mostrado aos mecanismos de pesquisa e o que é ocultado deles se configurar seu arquivo robots.txt corretamente.

A eficácia da verificação do seu site deve ser melhorada principalmente com o uso do arquivo robots.txt. Ajuda os bots dos mecanismos de busca a se concentrarem no rastreamento e indexação das partes mais vitais do seu site, evitando assim o desperdício de recursos em sites não essenciais ou materiais confidenciais que não deveriam ser disponibilizados ao público em geral.

O que exatamente é um arquivo Robots.txt?

Um arquivo de texto simples conhecido como Robots.txt direciona os rastreadores da web usados pelos mecanismos de pesquisa para determinadas páginas do seu site. Além disso, instrui os robôs a não rastrear determinados sites.

É essencial que você compreenda o funcionamento de um mecanismo de busca antes de prosseguirmos com a análise aprofundada deste artigo.

Rastreamento, indexação e classificação são as três principais atividades realizadas pelos mecanismos de pesquisa.

A primeira coisa que os motores de busca fazem é enviar seus rastreadores da web, também conhecidos como spiders ou bots, por toda a World Wide Web. Esses programas, conhecidos como bots, são softwares inteligentes que rastreiam toda a web em busca de novas conexões, páginas e sites. Rastreamento é o termo dado ao processo de busca de conteúdo na web.

As páginas do seu site serão organizadas em uma estrutura de dados que poderá ser usada após os bots as descobrirem. Indexação é o nome dado a este procedimento.

E no final tudo se resume ao ranking. Quando um usuário insere uma consulta de pesquisa, o mecanismo de pesquisa deve oferecer ao usuário as melhores e mais relevantes informações que ele pode encontrar, dependendo do que o usuário está procurando.

Como é o arquivo Robots.txt?

O arquivo robots.txt é um componente vital da estrutura e funcionalidade de um site, mas você já se perguntou como ele realmente aparece?

O arquivo é aplicável a todos os robôs de mecanismos de busca que visitam o site, conforme indicado pelo asterisco que segue o User-agent. Cada mecanismo de pesquisa usa um agente de usuário diferente para explorar a Internet.

Por exemplo, o Google utiliza o Googlebot para indexar o conteúdo do seu site para pesquisa do Google. Esses agentes de usuários chegam a centenas. Instruções personalizadas podem ser configuradas para cada agente de usuário. Por exemplo, a primeira linha do seu arquivo robots.txt deve ser: “Se você quiser definir instruções específicas para o Googlebot, ele será conhecido como User-agent: Googlebot.

O que exatamente é o orçamento de rastreamento?

O orçamento de rastreamento refere-se ao número de páginas que um mecanismo de pesquisa deseja rastrear em um site dentro de um determinado período. É determinado por vários fatores, como autoridade do site, popularidade e capacidade do servidor para lidar com solicitações de rastreamento. Além disso, você deve certificar-se de que o orçamento de rastreamento seja usado da forma mais eficiente possível para o seu site.

Suas páginas mais importantes certamente devem ser rastreadas primeiro pelo bot se o seu site tiver várias páginas. Portanto, é imperativo que você declare isso especificamente em seu arquivo robots.txt.

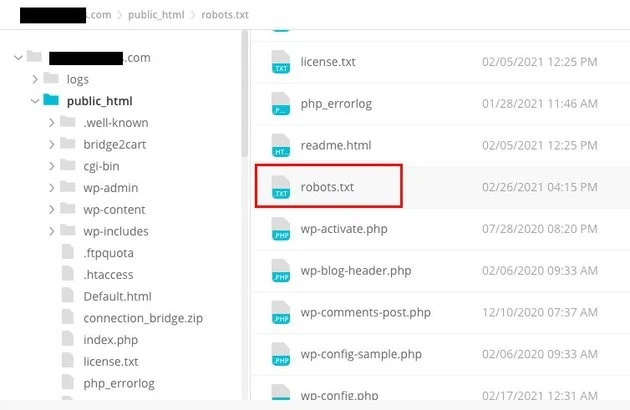

Como localizar e editar o arquivo robots.txt no WordPress?

Localizar e editar o arquivo robots.txt no WordPress é uma etapa crucial na otimização do seu site para mecanismos de pesquisa. Ao configurar corretamente esse arquivo, você pode controlar quais partes do seu site são acessíveis aos rastreadores dos mecanismos de pesquisa, garantindo que eles se concentrem nas páginas e no conteúdo mais importantes.

Para localizar e editar o arquivo robots.txt no WordPress, siga estas etapas simples:

1. Faça login no painel do WordPress.

2. Navegue até a guia “Configurações” no menu do lado esquerdo.

3. Clique em “Leitura” para acessar as configurações de leitura.

4. Role para baixo até encontrar a seção “Visibilidade do mecanismo de pesquisa”.

5. Aqui, você verá uma opção que diz “Desencorajar mecanismos de pesquisa de indexar este site”. Certifique-se de que esta opção esteja desmarcada, pois ela gerará um arquivo robots.txt básico que limita o acesso do mecanismo de pesquisa a todo o seu site.

6. Se quiser personalizar ainda mais seu arquivo robots.txt, você pode fazer isso acessando o diretório raiz do seu site. Normalmente, isso pode ser feito através de um cliente FTP ou gerenciador de arquivos cPanel.

7. Depois de localizar o diretório raiz, procure o arquivo chamado “robots.txt”.

8. Baixe uma cópia do arquivo robots.txt existente para o seu computador como backup, caso surja algum problema durante a edição.

9. Abra o arquivo robots.txt usando um editor de texto.

10. Personalize o arquivo de acordo com suas necessidades. Você pode adicionar diretivas específicas para permitir ou proibir o acesso a determinadas áreas do seu site. Por exemplo, você pode impedir que mecanismos de pesquisa rastreiem sua área administrativa adicionando a seguinte linha:

1. Proibir: /wp-admin/

11. Salve as alterações no arquivo robots.txt e carregue-o de volta no diretório raiz do seu site, substituindo a versão anterior.

12. Por fim, teste seu arquivo robots.txt usando a ferramenta de teste robots.txt do Google ou outras ferramentas semelhantes para garantir que esteja configurado corretamente.

O controle de como os rastreadores do mecanismo de pesquisa interagem com o seu site pode ser realizado no WordPress, identificando e modificando o arquivo robots.txt no local apropriado. Isso permitirá que você obtenha os melhores resultados possíveis em termos de visibilidade e classificação do seu site. Se você investir tempo para aprender e se tornar um especialista nesta faceta da otimização de mecanismos de pesquisa (SEO), estará no caminho certo para desbloquear o sucesso para seu site WordPress.

Como criar um arquivo Robots.txt no WordPress?

Vamos em frente e criar um Robots.txt WordPress para SEO, agora que discutimos o que é um arquivo robots.txt e por que ele é tão importante. O WordPress oferece duas opções distintas para gerar um arquivo robots.txt. O primeiro método envolve o uso de um plugin WordPress, enquanto o segundo envolve o upload manual do arquivo para a pasta raiz do seu site.

Etapa 1: use o plugin Yoast SEO para criar um arquivo Robots.txt

Você pode utilizar plug-ins de SEO para ajudá-lo a otimizar seu site desenvolvido em WordPress. A maioria desses plug-ins fornece seu próprio gerador de arquivo robots.txt dentro do pacote de instalação.

Primeiro, baixe e instale o plugin.

Navegue até o menu Plugins e clique em “Adicionar Novo”. O próximo passo é procurar o plugin Yoast SEO, baixá-lo e ativá-lo, caso ainda não o tenha.

Crie o arquivo robots.txt como segunda etapa

Crie um arquivo robots txt usando Yoast

Você notará o arquivo criado com algumas diretivas padrão.

O gerador de arquivo robots.txt para Yoast SEO incluirá automaticamente as seguintes diretivas:

Agente do usuário: * Proibir: /wp-admin/ Permitir: /wp-admin/admin-ajax.php

Adicione instruções extras ao robots.txt. Após editar o robots.txt, clique em Salvar.

Digite seu nome de domínio e '/robots.txt'. Seu arquivo robots.txt estará completo se o navegador exibir as diretivas padrão, conforme visto abaixo.

arquivo txt de robôs gerado

Também recomendamos que você adicione o URL do mapa do site em seu robots.txt.

Arquivo txt de robôs padrão

Depois que o plugin for habilitado, vá para Yoast SEO > Ferramentas e escolha Editor de arquivos no menu suspenso. Prossiga preenchendo seu nome de domínio e, em seguida, digite '/robots.txt'. Se você olhar no navegador, notará algumas diretivas padrão mostradas.

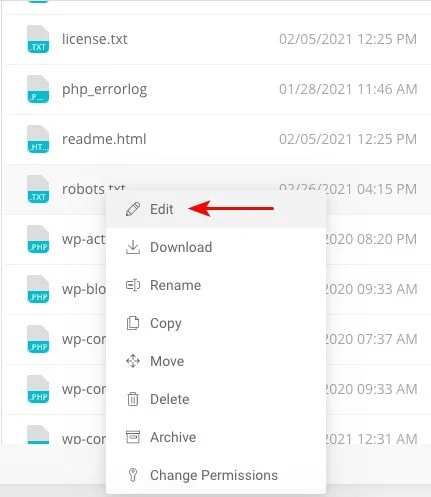

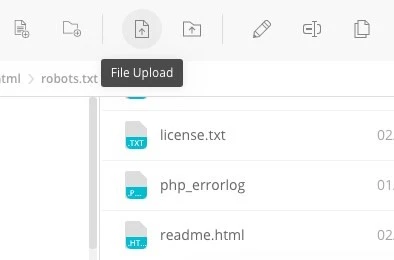

Etapa 2: usando FTP para criar manualmente o arquivo Robots.txt

- Criar um arquivo robots.txt em seu computador local e carregá-lo na pasta raiz do seu site WordPress é a próxima etapa do processo.

- Além disso, você precisará acessar sua hospedagem WordPress por meio de um programa FTP como o Filezilla. Se você ainda não possui as credenciais necessárias para fazer login, elas serão disponibilizadas para você através do painel de controle do seu serviço de hospedagem. Conseqüentemente, você pode verificar se o arquivo robots.txt está presente na pasta raiz do seu site após fazer login com seu programa FTP.

- Clique com o botão direito no arquivo e escolha editar, se existir.

Portanto, quando você tiver feito login com sucesso com seu cliente FTP, você poderá verificar se o arquivo robots.txt está na pasta raiz do seu site. Inserir seu nome de domínio seguido de '/robots.txt' é a melhor maneira de determinar se seu arquivo foi carregado com sucesso ou não.

Depois de fazer suas alterações, clique em “Salvar”.

Você terá que criar o arquivo se ele ainda não existir. Isso pode ser feito adicionando as diretivas a um arquivo usando um editor de texto básico como o Bloco de Notas. Como

Agente do usuário: * Proibir: /wp-admin/ Permitir: /wp-admin/admin-ajax.php

Clique em 'Upload de arquivo' em seu cliente FTP para enviar o arquivo para a pasta raiz do site.

Digite seu nome de domínio e “/robots.txt” para ver se o upload do seu arquivo foi feito com sucesso.

Este é o método para enviar manualmente o arquivo robots.txt para o seu site WordPress!

Robots.txt: conhece suas vantagens e desvantagens

Os benefícios de usar o arquivo robots.txt

Ele instrui o mecanismo de busca a não perder tempo em sites que você não deseja indexar, o que ajuda a otimizar os orçamentos de rastreamento do mecanismo de busca. Ao fazer isso, você aumenta a probabilidade de os mecanismos de pesquisa rastrearem os sites que são mais essenciais para você.

Bloquear os bots que estão causando o desperdício de recursos do seu servidor web desta forma contribui para a otimização do servidor.

É útil para ocultar páginas de agradecimento, landing pages, páginas de login e outras páginas que não precisam ser indexadas pelos mecanismos de busca.

Aspectos negativos do arquivo robots.txt

Agora você deve conseguir visualizar o arquivo robots.txt em qualquer site usando as informações fornecidas aqui. Não é muito difícil de entender. Basta digitar o nome do domínio, seguido de “/robots.txt” e pressionar Enter.

No entanto, também existe um perigo envolvido nisso até certo ponto. Existe a possibilidade de que o arquivo WordPress Robots.txt para SEO contenha URLs para algumas das páginas internas do seu site que você gostaria que não fossem indexadas pelos mecanismos de pesquisa.

Por exemplo, pode haver uma página de login que você não deseja indexar por qualquer motivo. No entanto, o fato de ser mencionado no arquivo robots.txt possibilita que invasores vejam o site. Se você estiver tentando ocultar certas informações confidenciais, o mesmo se aplica.

Mesmo se você cometer um único erro de digitação ao escrever o arquivo robots.txt, isso prejudicará todos os seus esforços de otimização de mecanismo de pesquisa (SEO). Isso é verdade mesmo que o arquivo seja fácil de criar.

Onde colocar o arquivo Robots.txt

Suponha que neste ponto você esteja familiarizado com o local onde o arquivo robots.txt deve ser inserido.

O arquivo robots.txt do seu site deve estar sempre localizado no diretório raiz do site. O URL do arquivo robots.txt em seu site será https://seudominio.com/robots.txt se o seu nome de domínio for seudominio.com.

Além de colocar seu arquivo robots.txt no diretório raiz do seu site, a seguir estão algumas outras práticas recomendadas que devem ser seguidas:

- É muito necessário dar ao seu arquivo o nome robots.txt.

- É importante colocar o nome em maiúscula. Portanto, você precisa obtê-lo corretamente, caso contrário ele não funcionará.

- Cada instrução precisa ser colocada em uma linha separada.

- Quando um URL estiver completo, ele deverá ser marcado com um sinal “$”.

- Apenas uma instância de cada agente de usuário deve ser usada.

- Para fornecer aos humanos uma explicação do conteúdo do seu arquivo robots.txt, use comentários começando cada linha com um hash (#).

Testando e validando seu arquivo robots.txt

Testar e validar seu arquivo robots.txt é uma etapa crucial para garantir que os mecanismos de pesquisa rastreiem e indexem seu site de maneira adequada. Um arquivo robots.txt bem otimizado pode impedir que mecanismos de pesquisa acessem páginas confidenciais ou irrelevantes, melhorar a eficiência do rastreamento e, em última análise, melhorar o desempenho geral do seu site.

Para começar a testar seu arquivo robots.txt, você pode utilizar várias ferramentas online projetadas especificamente para essa finalidade. Essas ferramentas permitem que você insira suas diretivas robots.txt e simule como os mecanismos de pesquisa as interpretam e seguem.

Ao analisar os resultados, você pode identificar possíveis problemas ou configurações incorretas em seu arquivo. Monitorar e atualizar regularmente seu arquivo robots.txt é crucial, especialmente ao fazer alterações na estrutura ou no conteúdo do seu site.

Ao permanecer vigilante, você pode identificar e corrigir rapidamente quaisquer problemas que possam surgir. Essa abordagem meticulosa contribuirá, em última análise, para a perceptibilidade, indexação e sucesso geral do seu site no cenário digital.

A ferramenta que sugerimos aqui é o Google Search Console

Você pode adicionar seu site ao Google Search Console acessando o link ‘Adicionar propriedade agora’ e seguindo as instruções simples que aparecem na tela. Depois de terminar, o menu suspenso denominado “Selecione uma propriedade” incluirá seu site entre as opções.

Após selecionar o site, a ferramenta irá obter automaticamente o arquivo robots.txt associado ao seu site e destacar quaisquer erros ou avisos, se houver.

É necessário um arquivo Robots.txt para o seu site WordPress?

Na verdade, o seu site WordPress precisa de um arquivo robots.txt. Mesmo que o seu site não tenha um arquivo robots.txt, os mecanismos de pesquisa irão rastreá-lo e indexá-lo. Agora que discutimos o propósito, o funcionamento e o orçamento de rastreamento do robots.txt, por que você desejaria omitir um?

Os mecanismos de pesquisa são treinados sobre o que rastrear e, mais importante, o que não rastrear por meio do arquivo robots.txt.

Considerar as consequências negativas do orçamento de rastreamento é um dos principais motivos para adicionar o robots.txt.

Como dito anteriormente, cada site possui um orçamento de rastreamento. Tudo se resume a quantos sites um bot visita em uma única sessão. O bot retornará e continuará seu rastreamento na sessão subsequente se não concluir todas as páginas do seu site nessa sessão.

Além disso, isso diminui o ritmo de indexação do seu site.

Você pode economizar sua cota de rastreamento corrigindo isso rapidamente, evitando que bots de pesquisa verifiquem ativos de mídia, diretórios de temas, plug-ins e sites estranhos.

Palavras finais

Priorizamos a otimização de conteúdo, pesquisa de palavras-chave, construção de backlinks, criação de sitemap.xml e outras tarefas relacionadas a SEO enquanto trabalhamos em seu site. WordPress Robots.txt para SEO é um aspecto que alguns webmasters ignoram.

O arquivo robots.txt pode não ser muito importante quando o seu site é lançado pela primeira vez. Dito isso, quando o seu site ficar maior e tiver mais páginas, terá uma boa recompensa se começarmos a usar o arquivo robots.txt recomendado.