14 greșeli comune WordPress Robots.txt de evitat

Publicat: 2025-01-14Robots.txt este un fișier server puternic care le spune crawlerilor de căutare și altor roboți cum să se comporte pe site-ul dvs. WordPress. Poate influența foarte mult optimizarea pentru motoarele de căutare (SEO) a site-ului dvs., atât pozitiv, cât și negativ.

Din acest motiv, ar trebui să știți ce este acest fișier și cum să îl utilizați. În caz contrar, ți-ai putea deteriora site-ul web sau, cel puțin, poți lăsa o parte din potențialul său pe masă.

Pentru a vă ajuta să evitați acest scenariu, în această postare, vom trata fișierul robots.txt în detaliu. Vom defini ce este, scopul său, cum să găsiți și să gestionați fișierul dvs. și ce ar trebui să conțină. După aceea, vom trece peste cele mai frecvente greșeli pe care le fac oamenii cu robots.txt lor WordPress, modalități de a le evita și cum să le recuperăm dacă descoperiți că ați făcut o eroare.

Ce este WordPress robots.txt?

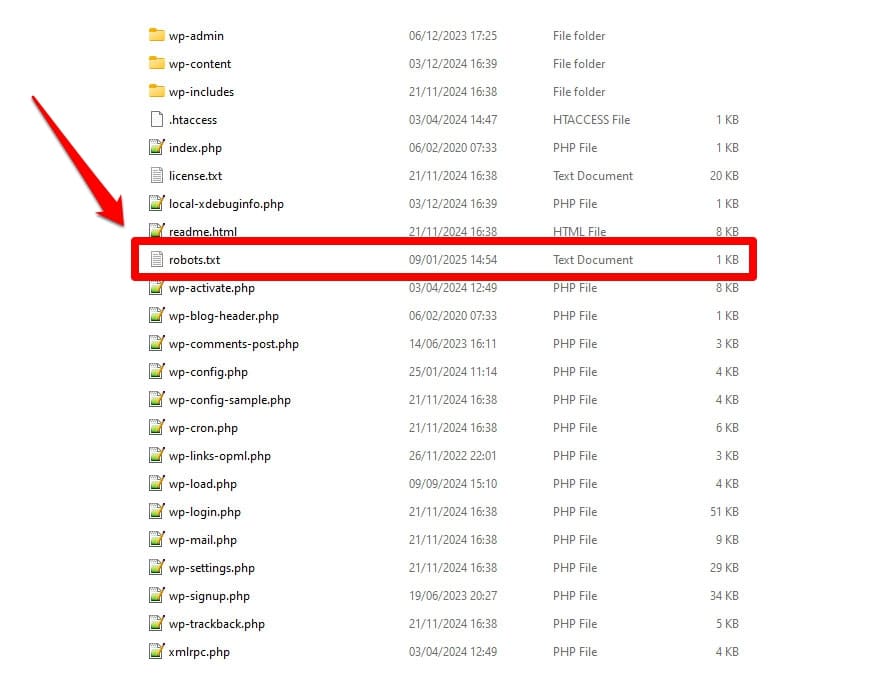

După cum sa menționat, robots.txt este un fișier de configurare a serverului. De obicei, îl găsiți în folderul rădăcină al serverului dvs.

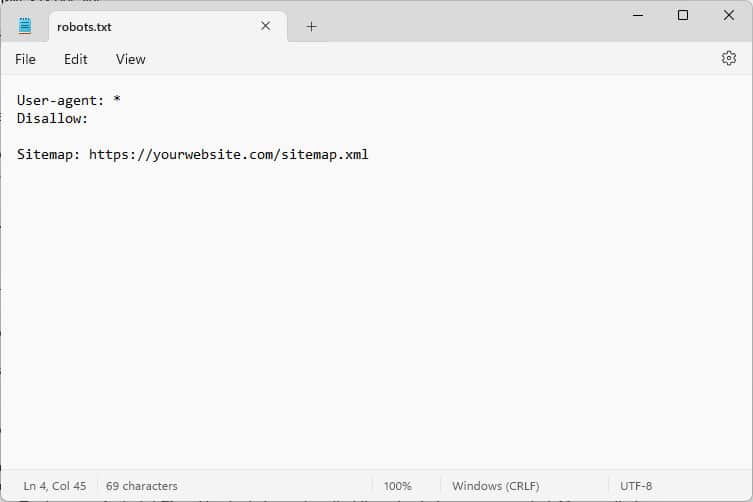

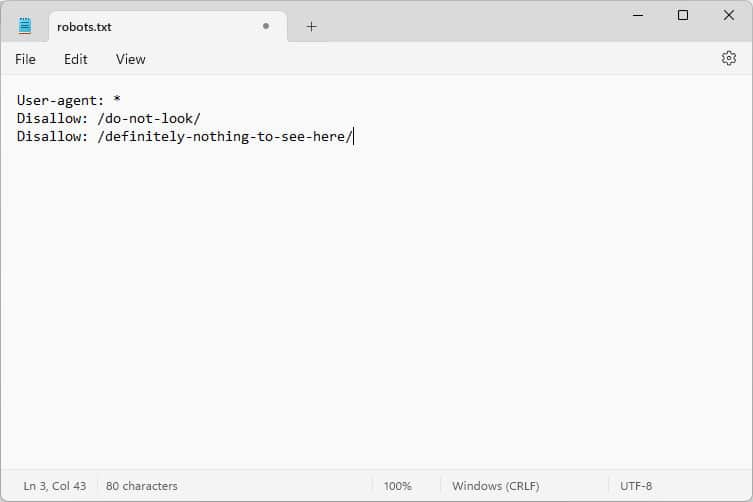

Când îl deschideți, conținutul arată cam așa:

Aceste bucăți de cod sunt instrucțiuni care le spun roboților care vin pe site-ul dvs. cum să se comporte în timp ce sunt acolo - în special, ce părți ale site-ului dvs. să acceseze și care nu.

Ce roboți, întrebați?

Cele mai comune exemple sunt crawlerele automate de la motoarele de căutare care caută pagini web pe care să le indexeze sau să le actualizeze, dar și roboții din modele AI și alte instrumente automate.

Ce directive puteți da cu acest fișier?

Robots.txt cunoaște practic patru directive cheie:

- User-agent – Definește cui, adică pentru ce grup de roboți sau individuali sunt destinate regulile care urmează.

- Disallow – Afirmă directoarele, fișierele sau resursele pe care utilizatorul-agent îi este interzis să le acceseze.

- Permite – Poate fi folosit pentru a seta excepții, de exemplu, pentru a permite accesul la foldere sau resurse individuale în directoare altfel interzise.

- Harta site-ului – indică roboții către locația URL a hărții site-ului web.

Numai User-agent și Disallow sunt obligatorii pentru ca fișierul să-și facă treaba; celelalte două directive sunt opționale. De exemplu, acesta este modul în care blocați orice roboți să acceseze site-ul dvs.:

User-agent: * Disallow: /Asteriscul indică faptul că următoarea regulă se aplică tuturor agenților utilizator. Bara oblică după Disallow afirmă că toate directoarele de pe acest site sunt interzise. Acesta este fișierul robots.txt pe care îl găsiți de obicei pe site-urile de dezvoltare, care nu ar trebui să fie indexate de motoarele de căutare.

Cu toate acestea, puteți configura și reguli pentru roboții individuali:

User-agent: Googlebot Allow: /private/resources/Este important să rețineți că robots.txt nu este obligatoriu. Doar roboții din organizațiile care aderă la Protocolul de excludere a roboților vor respecta instrucțiunile acestuia. Boții rău intenționați, cum ar fi cei care caută defecte de securitate pe site-ul dvs., îi pot ignora și îi vor ignora și trebuie să luați măsuri suplimentare împotriva lor.

Chiar și organizațiile care aderă la standard vor ignora unele directive. Despre exemple vom vorbi mai jos.

De ce contează robots.txt?

Nu este obligatoriu ca site-ul dvs. WordPress să aibă un fișier robots.txt. Site-ul dvs. va funcționa fără unul, iar motoarele de căutare nu vă vor penaliza pentru că nu îl aveți. Cu toate acestea, includerea uneia vă permite să:

- Păstrați conținut în afara rezultatelor căutării, cum ar fi paginile de conectare sau anumite fișiere media.

- Împiedicați crawlerele de căutare să irosească bugetul pentru accesare cu crawlere în părți neimportante ale site-ului dvs., ignorând posibil paginile pe care doriți să le indexeze.

- Orientați motoarele de căutare către harta site-ului dvs., astfel încât acestea să poată explora mai ușor restul site-ului dvs.

- Păstrați resursele serverului ținând departe roboții risipitori.

Toate acestea vă ajută să vă îmbunătățiți site-ul, în special SEO, de aceea este important să înțelegeți cum să utilizați robots.txt.

Cum să găsiți, să editați și să vă creați robots.txt WordPress

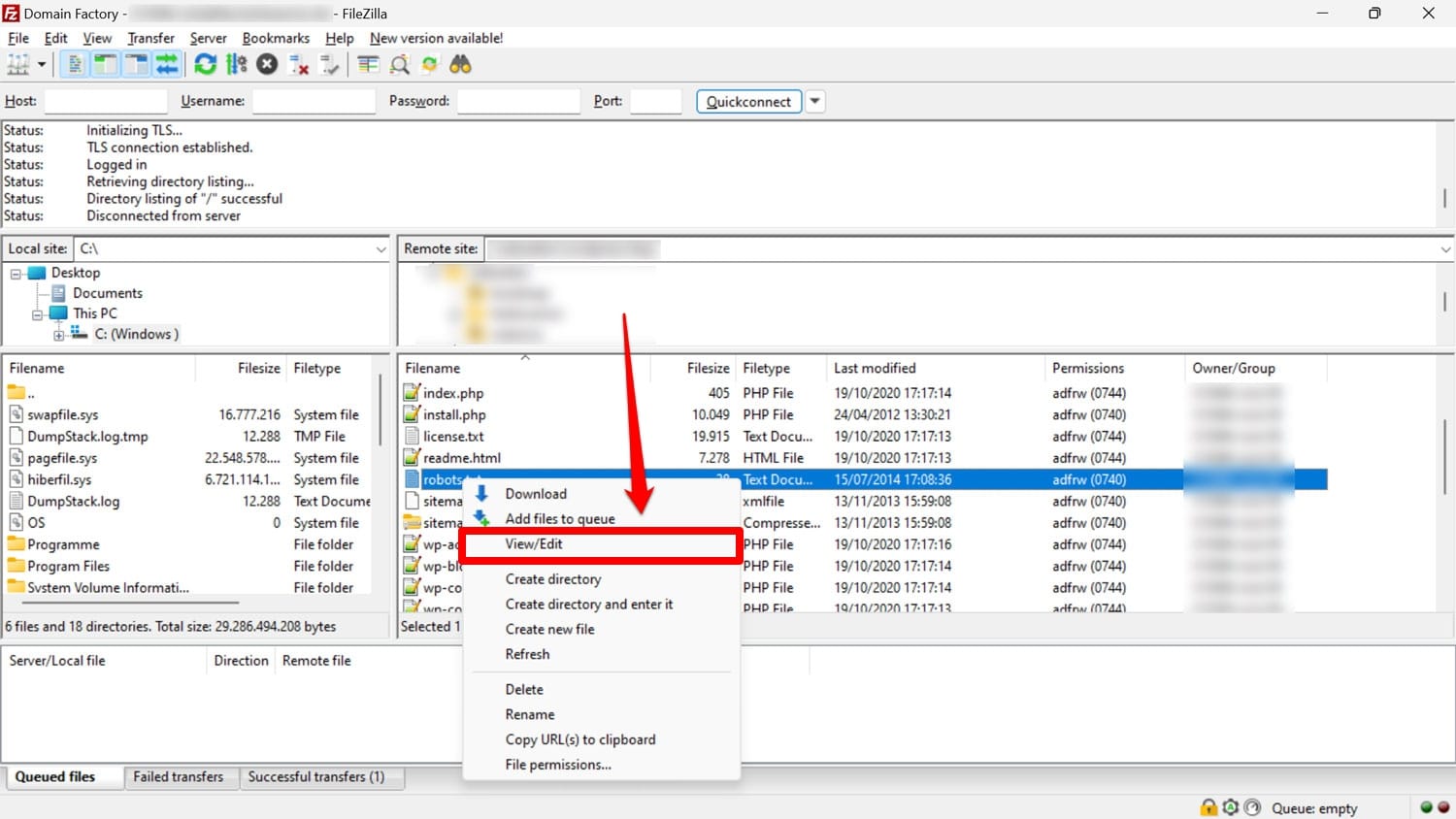

După cum am menționat, robots.txt se află de obicei în folderul rădăcină al site-ului dvs. de pe server. Îl puteți accesa acolo cu un client FTP precum FileZilla și îl puteți edita cu orice editor de text.

Dacă nu aveți unul, este posibil să creați pur și simplu un fișier text gol, să îl denumiți „robots.txt”, să îl completați cu directive și să îl încărcați.

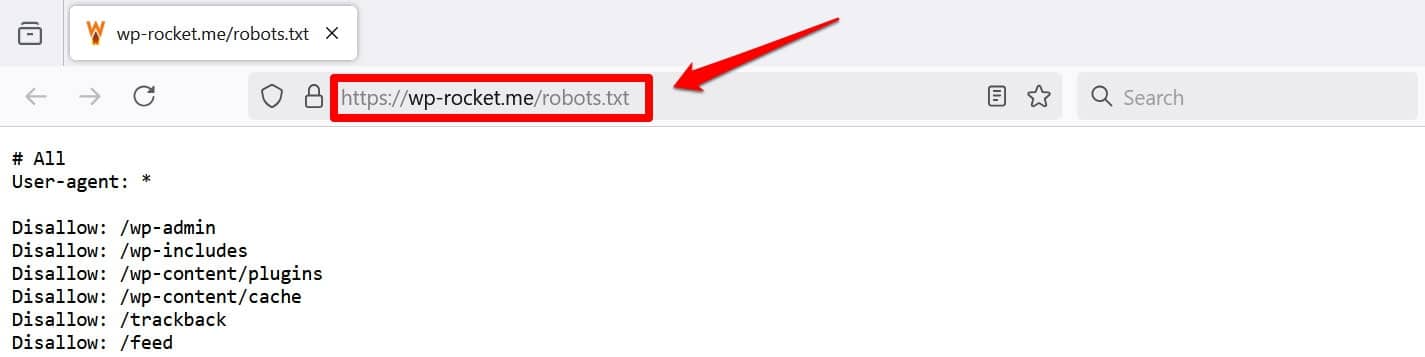

O altă modalitate de a vă vizualiza cel puțin fișierul este să adăugați /robots.txt la domeniul dvs., de exemplu, https://wp-rocket.me/robots.txt.

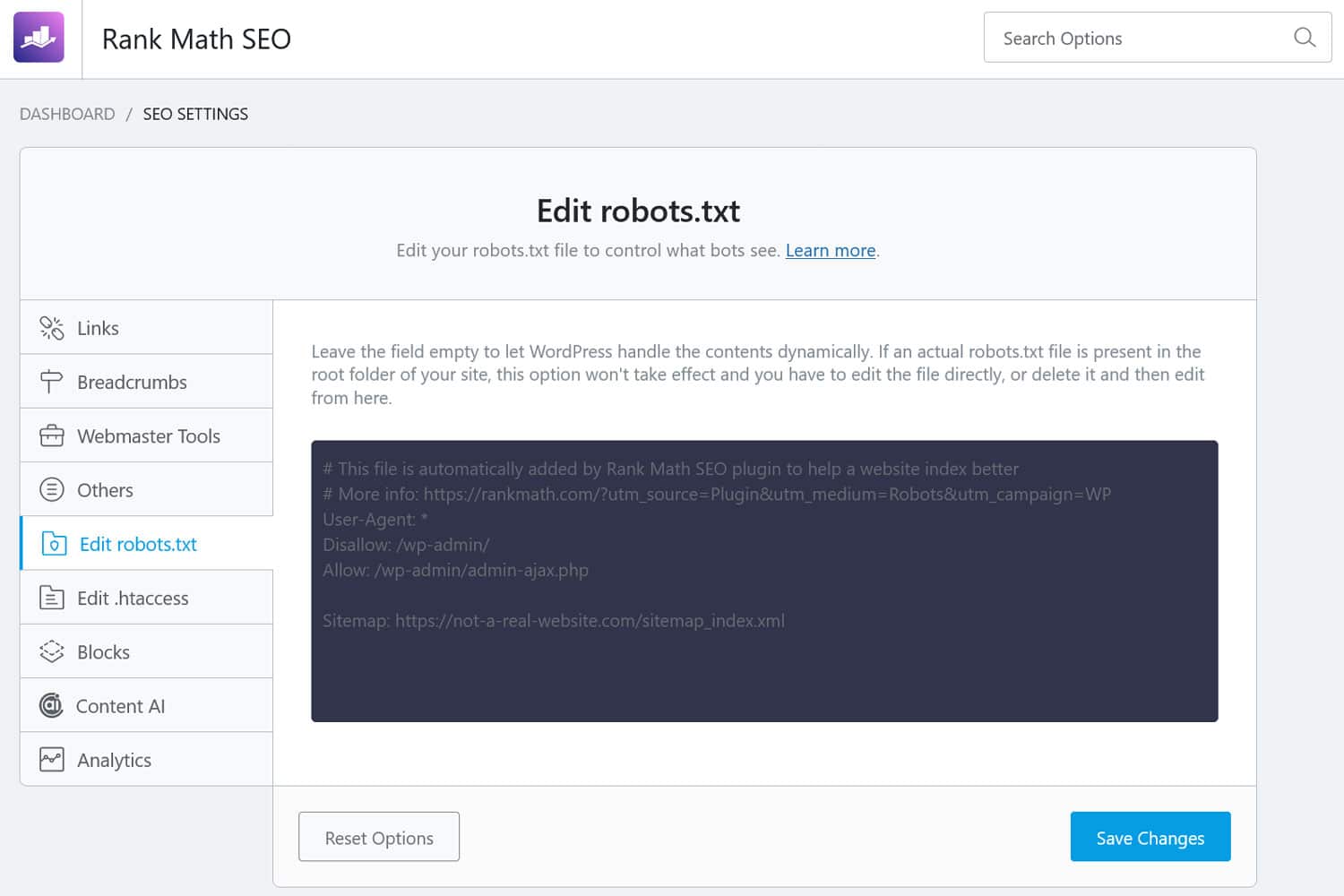

În plus, există modalități de a accesa fișierul din back-end-ul WordPress. Multe plugin-uri SEO vă permit să vedeți și să faceți adesea modificări din interfața de administrare.

Alternativ, puteți utiliza și un plugin precum WPCode.

Cum arată un fișier WordPress robots.txt bun?

Nu există un răspuns universal la ce directive ar trebui să fie în fișierul site-ului dvs.; depinde de configurația ta. Iată un exemplu care are sens pentru multe site-uri WordPress:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php Sitemap: https://yourwebsite.com/sitemap.xmlAcest exemplu realizează mai multe rezultate:

- Acesta blochează accesul la zona de administrare

- Permite accesul la funcționalitățile esențiale de administrare

- Oferă o locație pe harta site-ului

Această configurare atinge un echilibru între securitate, performanță SEO și accesare eficientă cu crawlere.

Nu face aceste 14 greșeli WordPress robots.txt

Dacă scopul dvs. este să configurați și să optimizați fișierul robots.txt pentru propriul site, asigurați-vă că evitați următoarele erori.

1. Ignorarea fișierului WordPress intern robots.txt

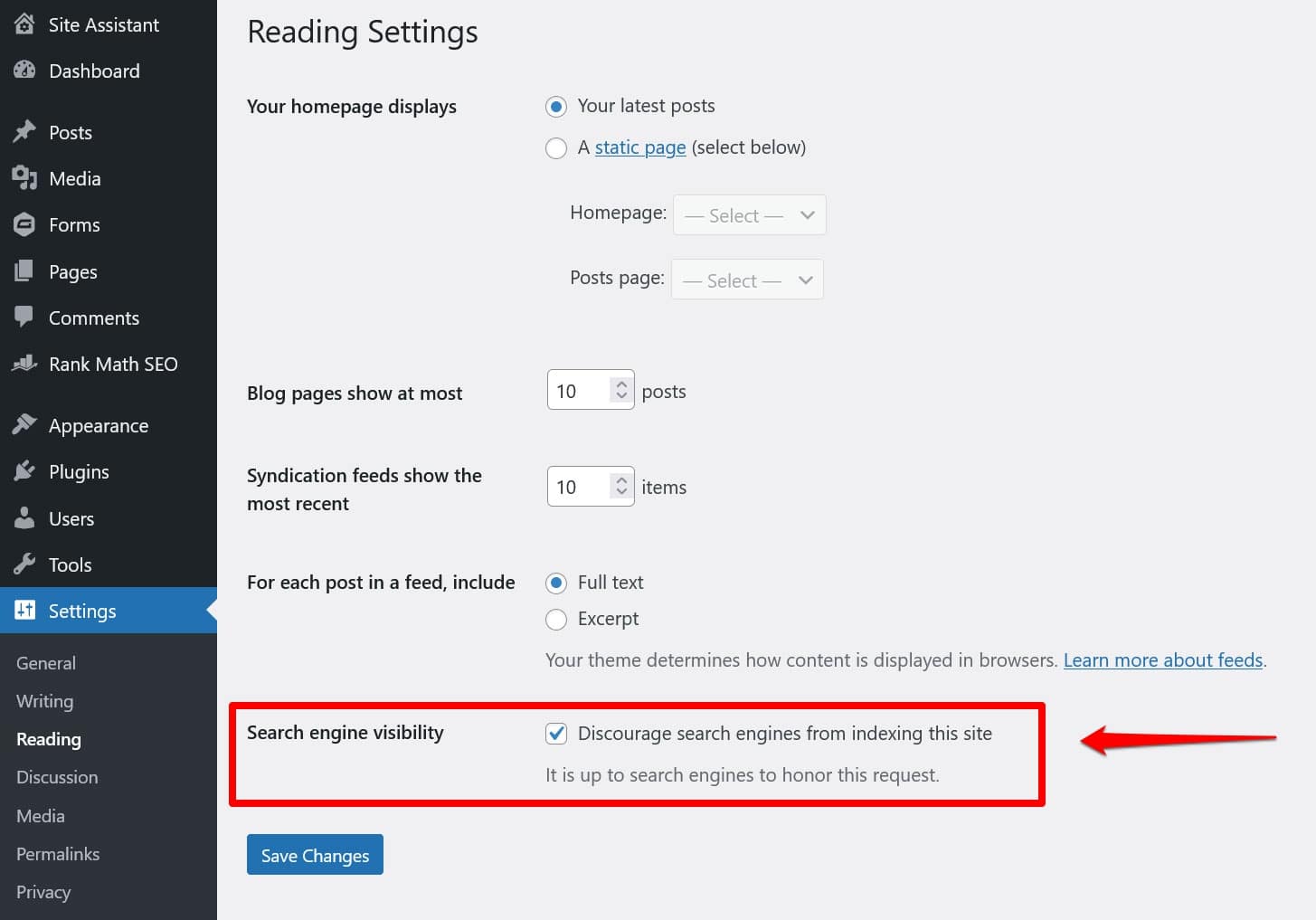

Chiar dacă nu aveți un fișier robots.txt „fizic” în directorul rădăcină al site-ului dvs., WordPress vine cu propriul fișier virtual. Acest lucru este deosebit de important de reținut dacă descoperiți că motoarele de căutare nu vă indexează site-ul.

În acest caz, există șanse mari să fi activat opțiunea de a-i descuraja să facă acest lucru în Setări > Citire .

Acest lucru pune o directivă pentru a menține toate crawlerele de căutare în robots.txt virtual. Pentru a o dezactiva, debifați caseta și salvați-o în partea de jos.

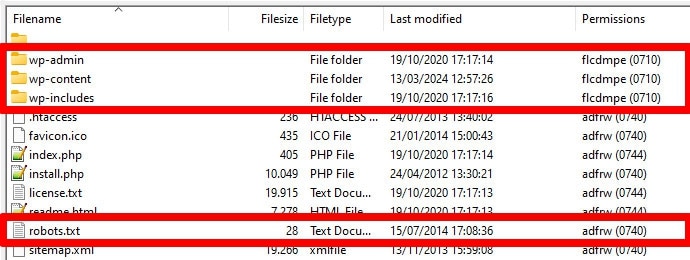

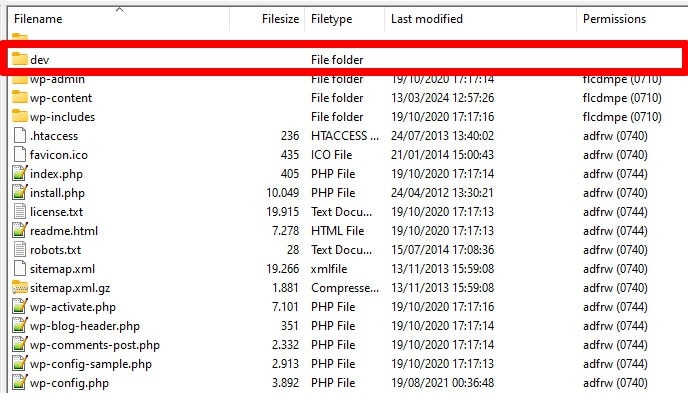

2. Plasarea lui într-o locație greșită

Boții, în special crawlerele de căutare, caută fișierul dvs. robots.txt într-o singură locație - directorul rădăcină al site-ului dvs. web. Dacă îl plasați oriunde altundeva, cum ar fi într-un folder, ei nu îl vor găsi și îl vor ignora.

Directorul rădăcină ar trebui să fie locul în care aterizați atunci când accesați serverul prin FTP, cu excepția cazului în care ați plasat WordPress într-un subdirector. Dacă vedeți folderele wp-admin , wp-content și wp-includes , vă aflați în locul potrivit.

3. Inclusiv markup învechit

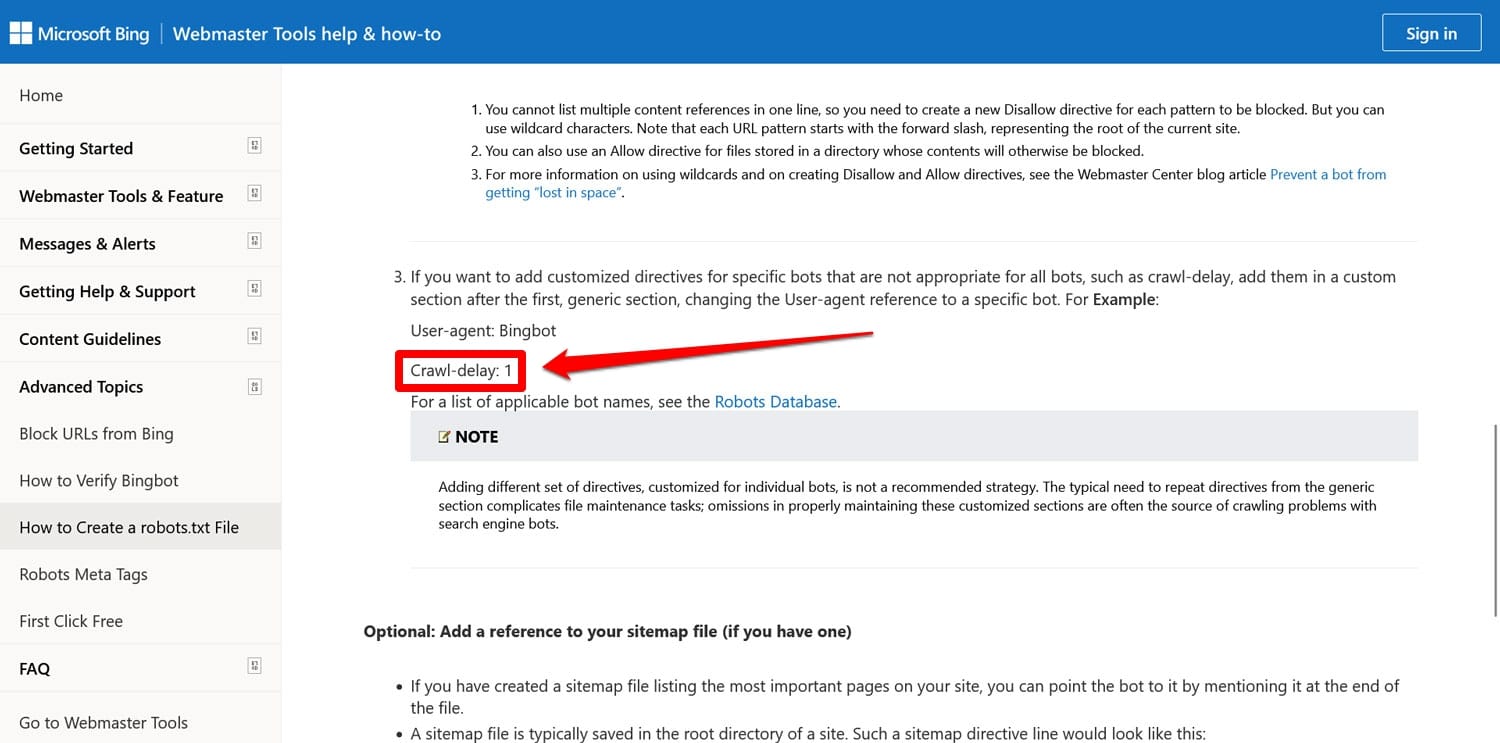

Pe lângă directivele menționate mai sus, mai sunt două pe care le puteți găsi încă în fișierele robots.txt ale site-urilor web mai vechi:

- Noindex – Folosit pentru a specifica adrese URL pe care motoarele de căutare nu ar trebui să le indexeze pe site-ul dvs.

- Crawl-delay – O directivă menită să limiteze crawlerele, astfel încât acestea să nu supraîncărceze resursele serverului web.

Ambele directive sunt acum ignorate, cel puțin de Google. Bing, cel puțin, încă onorează întârzierea cu crawl.

În cea mai mare parte, este mai bine să nu folosiți aceste directive. Acest lucru vă ajută să vă mențineți fișierul slab și reduce riscul de erori.

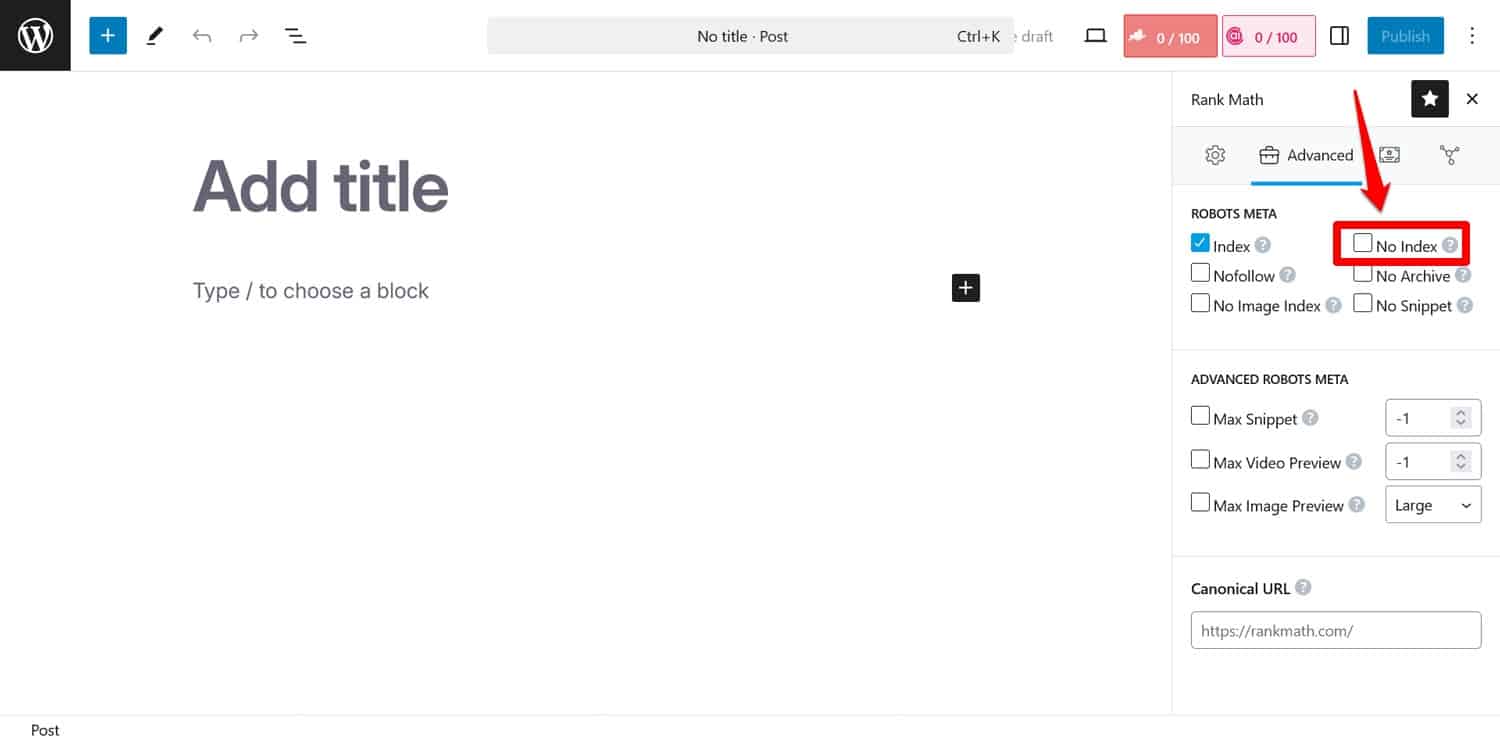

Sfat: dacă scopul dvs. este să împiedicați motoarele de căutare să indexeze anumite pagini, utilizați în schimb metaeticheta noindex . Îl puteți implementa cu un plugin SEO pe pagină.

Dacă blocați pagini prin robots.txt, crawlerele nu vor ajunge în partea în care văd eticheta noindex . În acest fel, îți pot indexa pagina, dar fără conținutul acesteia, ceea ce este mai rău.

4. Blocarea resurselor esențiale

Una dintre greșelile pe care le fac oamenii este utilizarea robots.txt pentru a bloca accesul la toate foile de stil (fișiere CSS) și scripturile (fișiere JavaScript) de pe site-ul lor WordPress pentru a păstra bugetul de accesare cu crawlere.

Cu toate acestea, aceasta nu este o idee bună. Boții motoarelor de căutare redă pagini pentru a le „vedea” în același mod în care o fac vizitatorii. Acest lucru îi ajută să înțeleagă conținutul, astfel încât să îl poată indexa în consecință.

Prin blocarea acestor resurse, le-ați putea oferi motoarelor de căutare o impresie greșită a paginilor dvs., ducându-le potențial să nu fie indexate corect sau să le afecteze clasamentul.

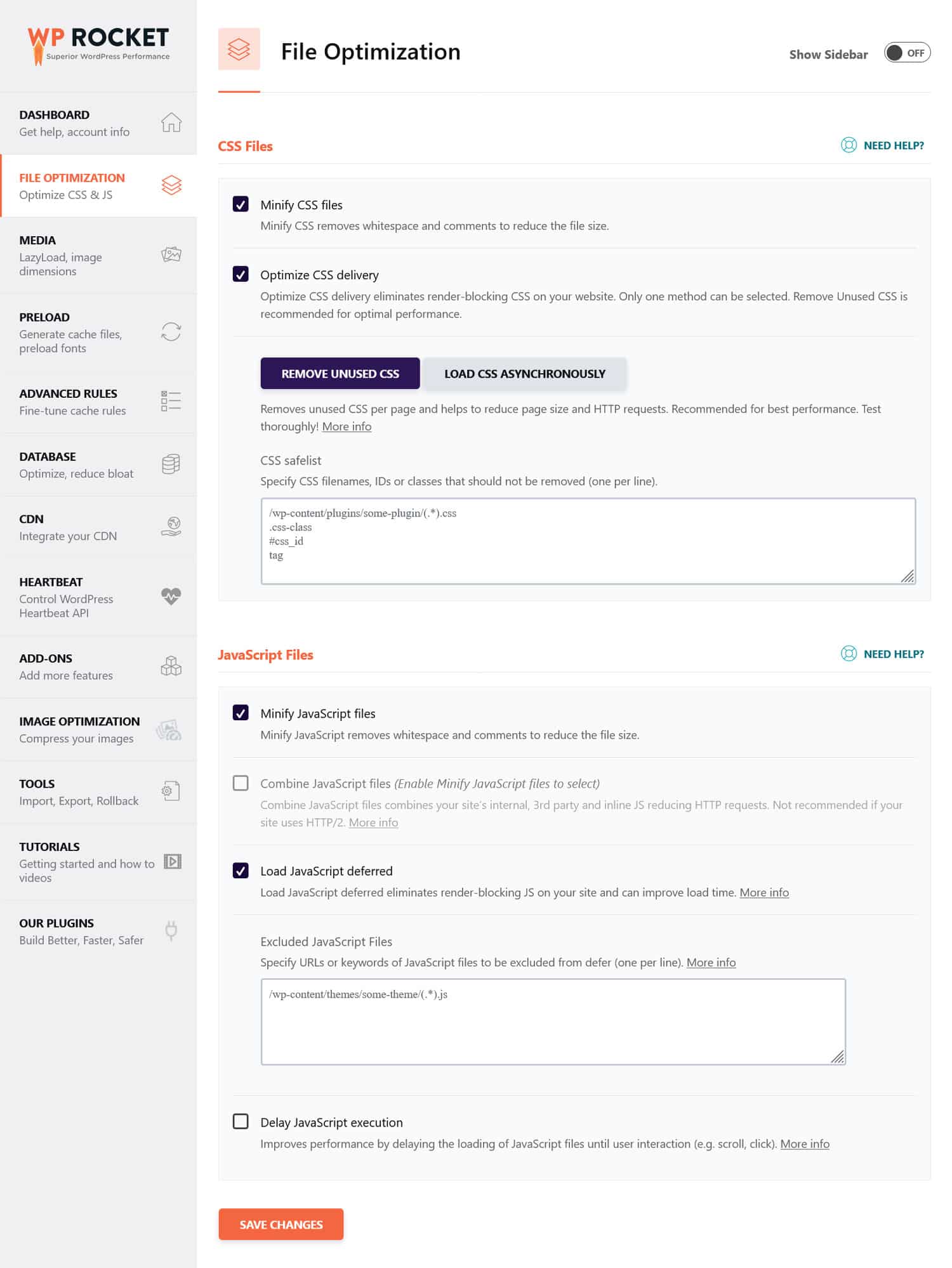

Dacă credeți că fișierele CSS și JavaScript ar putea împiedica performanța site-ului dvs., este o idee mai bună să le optimizați pentru a se încărca rapid, atât pentru roboți, cât și pentru vizitatorii obișnuiți. Puteți face acest lucru reducând codul și comprimând fișierele site-ului web, astfel încât acestea să transmită mai rapid. În plus, este posibil să optimizați livrarea acestora prin eliminarea codului neutilizat și amânarea resurselor de blocare a redării.

Sfat : Puteți simplifica acest proces utilizând un plugin de performanță precum WP Rocket. Interfața sa ușor de utilizat vă permite să optimizați livrarea fișierelor bifând câteva casete din meniul Optimizare fișier .

WP Rocket vine, de asemenea, cu funcții suplimentare pentru a îmbunătăți performanța site-ului, inclusiv:

- Memorarea în cache, cu un cache mobil dedicat

- Încărcare leneșă pentru imagini și videoclipuri

- Preîncărcarea memoriei cache, a linkurilor, a fișierelor externe și a fonturilor

- Optimizarea bazei de date

În plus, pluginul implementează automat mulți pași de optimizare. Exemplele includ memorarea în cache a browserului și a serverului, compresia GZIP și optimizarea imaginilor deasupra pliului pentru a îmbunătăți LCP. În acest fel, site-ul dvs. va deveni mai rapid pur și simplu pornind WP Rocket.

Pluginul oferă, de asemenea, o garanție de rambursare a banilor de 14 zile, astfel încât să îl puteți testa fără riscuri.

5. Eșecul de a actualiza robots.txt de dezvoltare

Când construiesc un site web, dezvoltatorii includ de obicei un fișier robots.txt care interzice accesul tuturor roboților. Acest lucru are sens; ultimul lucru pe care îl doriți este ca site-ul dvs. neterminat să apară în rezultatele căutării.

O problemă apare doar atunci când transferați accidental acest fișier pe serverul dvs. de producție și blocați motoarele de căutare de la indexarea site-ului dvs. live. Verificați cu siguranță acest lucru dacă conținutul dvs. refuză să apară în rezultatele căutării.

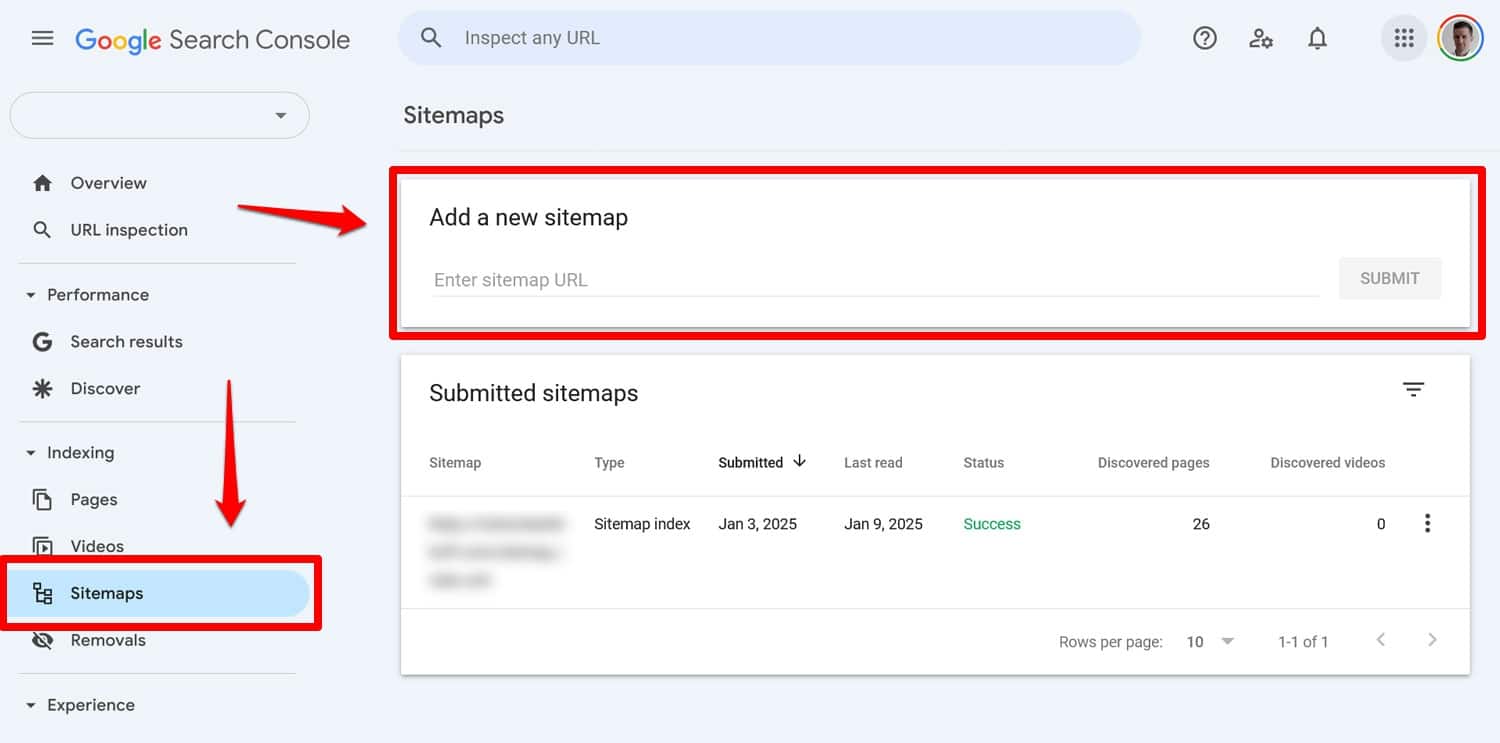

6. Nu includerea unui link către sitemap-ul dvs

Conectarea la harta site-ului dvs. de pe robots.txt oferă crawlerilor motoarelor de căutare o listă a întregului conținut. Acest lucru vă crește șansele ca acestea să indexeze mai mult decât pagina curentă pe care au aterizat.

Este nevoie doar de o singură linie:

Sitemap: https://yourwebsite.com/sitemap.xmlDa, puteți trimite sitemap-ul dvs. direct în instrumente precum Google Search Console.

Cu toate acestea, includerea acestuia în fișierul robots.txt este încă utilă, în special pentru motoarele de căutare ale căror instrumente pentru webmaster nu le utilizați.

7. Utilizarea regulilor conflictuale

O greșeală comună în crearea unui fișier robots.txt este adăugarea de reguli care se contrazic, cum ar fi:

User-agent: * Disallow: /blog/ Allow: /blog/Directivele de mai sus lasă motoarele de căutare neclar dacă ar trebui să acceseze cu crawlere directorul /blog/ sau nu. Acest lucru duce la rezultate imprevizibile și vă poate deteriora SEO.

| Sunteți curios ce altceva poate fi dăunător pentru clasamentul de căutare a site-ului dvs. și cum să îl evitați? Aflați despre asta în ghidul nostru pentru greșelile SEO. |

Pentru a evita conflictele, urmați aceste bune practici:

- Folosește mai întâi reguli specifice – Plasează reguli mai specifice înaintea celor mai ample.

- Evitați redundanța – Nu includeți directive opuse pentru aceeași cale.

- Testați fișierul robots.txt – Folosiți instrumente pentru a confirma că regulile se comportă conform așteptărilor. Mai multe despre asta mai jos.

8. Încercarea de a ascunde conținutul sensibil cu robots.txt

După cum sa menționat anterior, robots.txt nu este un instrument care să țină conținutul în afara rezultatelor căutării. De fapt, deoarece fișierul este accesibil public, utilizarea acestuia pentru a bloca conținut sensibil poate dezvălui, din neatenție, exact locul în care se află acel conținut.

Sfat : utilizați metaeticheta noindex pentru a menține conținutul în afara rezultatelor căutării. În plus, protejați cu parolă zonele sensibile ale site-ului dvs. pentru a le proteja atât de roboți, cât și de utilizatorii neautorizați.

9. Folosirea incorectă a wildcard-urilor

Wildcard-urile vă permit să includeți grupuri mari de căi sau fișiere în directive. Am întâlnit deja unul mai devreme, simbolul *. Înseamnă „fiecare instanță de” și este folosit cel mai frecvent pentru a stabili reguli care se aplică tuturor agenților utilizator.

Un alt simbol wildcard este $, care aplică reguli la sfârșitul unei adrese URL. Îl puteți folosi, de exemplu, dacă doriți să blocați accesul crawlerelor la toate fișierele PDF de pe site-ul dvs.:

Disallow: /*.pdf$Deși metacaracterele sunt utile, ele pot avea consecințe de anvergură. Folosiți-le cu atenție și testați întotdeauna fișierul robots.txt pentru a vă asigura că nu ați făcut nicio greșeală.

10. Confuzia URL-urilor absolute și relative

Iată diferența dintre adresele URL absolute și relative:

- Adresa URL absolută – https://yourwebsite.com/private/

- Adresă URL relativă – /private/

Este recomandat să utilizați adrese URL relative în directivele robots.txt, de exemplu:

Disallow: /private/Adresele URL absolute pot cauza probleme în care roboții pot ignora sau interpreta greșit directiva. Singura excepție este calea către harta site-ului, care trebuie să fie o adresă URL absolută.

11. Ignorarea sensibilității majusculelor

Directivele Robots.txt sunt sensibile la majuscule. Aceasta înseamnă că următoarele două directive nu sunt interschimbabile:

Disallow: /Private/ Disallow: /private/Dacă descoperiți că fișierul dvs. robots.txt nu se comportă conform așteptărilor, verificați dacă problema ar putea fi scrierea incorectă cu majuscule.

12. Folosirea incorect a barelor oblice

O bară oblică finală este o bară oblică la sfârșitul unei adrese URL:

- Fără o bară oblică : /directory

- Cu o bară oblică : /directory/

În robots.txt, acesta decide ce resurse ale site-ului sunt permise și interzise. Iată un exemplu:

Disallow: /private/Regula de mai sus împiedică crawler-urile să acceseze directorul „privat” de pe site-ul dvs. și tot ce se află în acesta. Pe de altă parte, să presupunem că omiteți slash-ul final, așa:

Disallow: /privateÎn acest caz, regula ar bloca și alte instanțe care încep cu „privat” pe site-ul dvs., cum ar fi:

- https://yourwebsite.com/private.html

- https://yourwebsite.com/privateer

Prin urmare, este important să fii precis. Dacă aveți îndoieli, testați fișierul.

13. Lipsește robots.txt pentru subdomenii

Fiecare subdomeniu de pe site-ul dvs. web (de exemplu, dev.yourwebsite.com) are nevoie de propriul fișier robots.txt, deoarece motoarele de căutare le tratează ca entități web separate. Fără un fișier la loc, riscați ca crawlerele să indexeze părți ale site-ului dvs. pe care intenționați să le păstrați ascunse.

De exemplu, dacă versiunea dvs. de dezvoltare se află într-un folder numit „dev” și folosește un subdomeniu, asigurați-vă că are un fișier robots.txt dedicat pentru a bloca crawlerele de căutare.

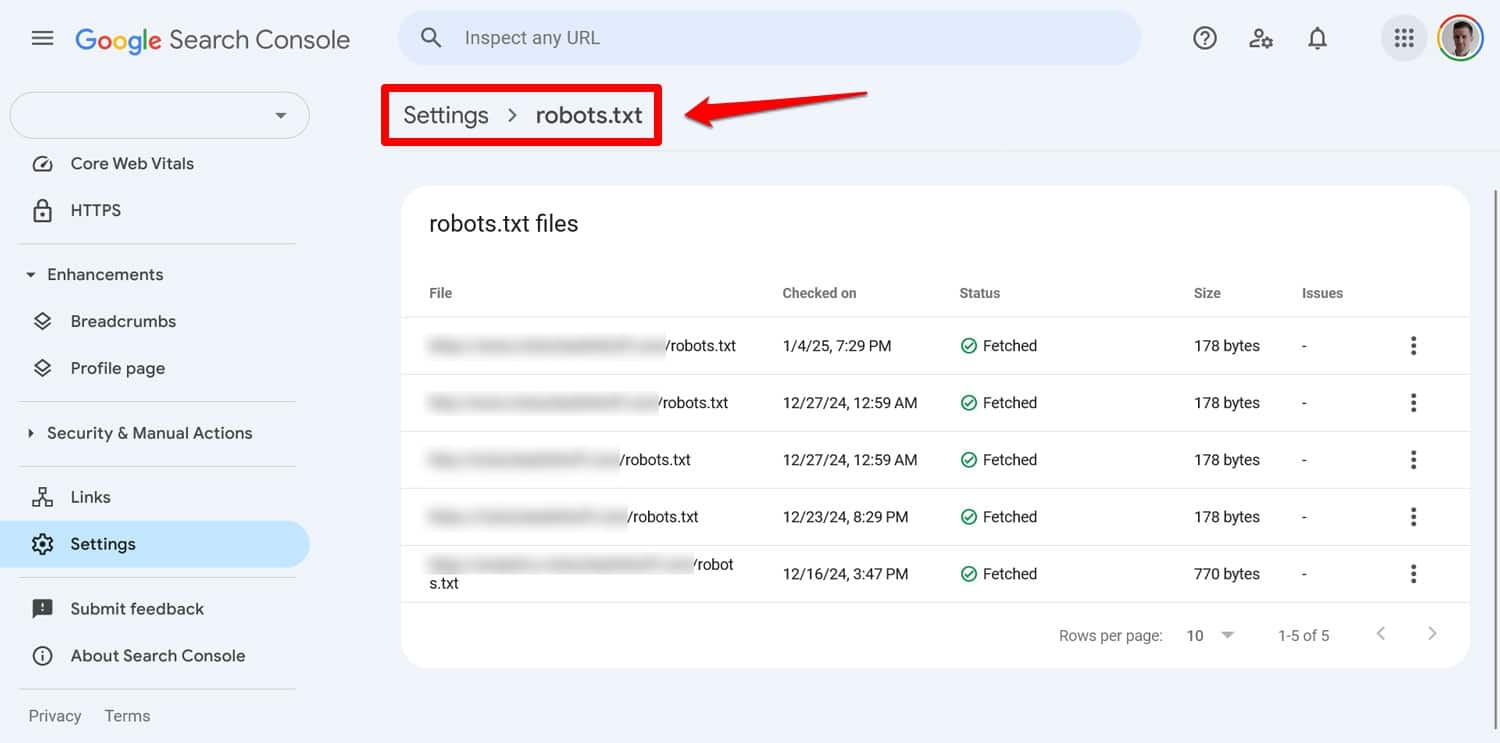

14. Nu se testează fișierul robots.txt

Una dintre cele mai mari greșeli atunci când vă configurați fișierul WordPress robots.txt este că nu îl testați, mai ales după efectuarea modificărilor.

După cum am văzut, chiar și erorile mici în sintaxă sau logică pot cauza probleme semnificative de SEO. Prin urmare, testați întotdeauna fișierul robots.txt.

Puteți vedea orice probleme cu fișierul dvs. în Google Search Console, sub Setări > robots.txt .

O altă modalitate este de a simula comportamentul de crawling cu un instrument precum Screaming Frog. În plus, utilizați un mediu de pregătire pentru a verifica impactul noilor reguli înainte de a le aplica pe site-ul dvs. live.

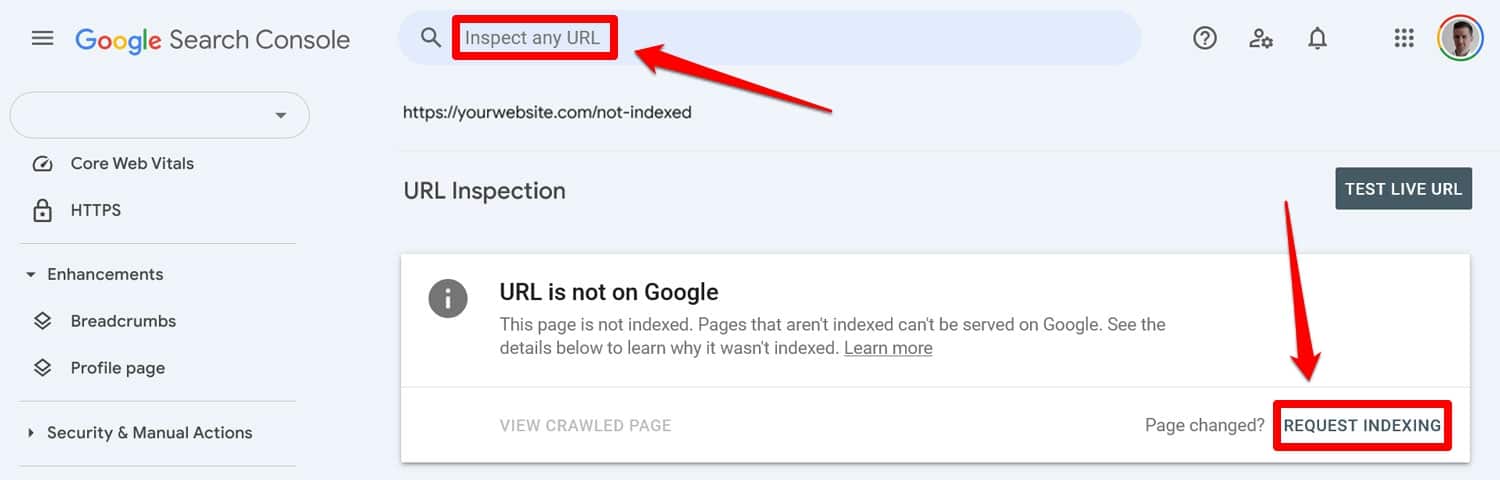

Cum să vă recuperați de la o eroare robots.txt

Greșelile din fișierul robots.txt sunt ușor de făcut, dar, din fericire, sunt de obicei ușor de remediat odată ce le descoperi.

Începeți prin a rula fișierul robots.txt actualizat printr-un instrument de testare. Apoi, dacă paginile au fost blocate anterior de directivele robots.txt, introduceți-le manual în Google Search Console sau Bing Webmaster Tools pentru a solicita indexarea.

În plus, retrimiteți o versiune actualizată a sitemapului dvs.

După aceea, este doar un joc de așteptare. Motoarele de căutare îți vor revedea site-ul și, sperăm, îți vor restabili rapid locul în clasament.

Preluați controlul asupra robots.txt dvs. WordPress

Cu fișierele robots.txt, un gram de prevenire este mai bine decât un kilogram de vindecare. În special pe site-urile web mai mari, un fișier defect poate face ravagii în clasamente, trafic și venituri.

Din acest motiv, orice modificare a site-ului dvs. robots.txt trebuie făcută cu atenție și cu teste ample. Conștientizarea greșelilor pe care le poți face este un prim pas în prevenirea lor.

Când faci o greșeală, încearcă să nu intri în panică. Diagnosticați ce nu este în regulă, corectați orice erori și trimiteți din nou harta site-ului pentru a vă accesa din nou site-ul.

În cele din urmă, asigurați-vă că performanța nu este motivul pentru care motoarele de căutare nu accesează corect site-ul dvs. Încercați acum WP Rocket pentru a vă face site-ul mai rapid instantaneu!