Lista cu crawlerele web: 10 cele mai frecvente care să rămână în frunte în 2024

Publicat: 2023-12-09V-ați luptat vreodată să vă mențineți site-ul dinamic și prietenos cu SEO, cu actualizări constante? Când aveți de-a face cu sute sau mii de pagini, împingerea manuală a actualizărilor către motoarele de căutare devine o provocare. Întrebarea cheie este: Cum vă puteți asigura că actualizările frecvente de conținut au un impact pozitiv în clasamentul SEO? Soluția constă în robotii crawler. Acești roboți vă răzuiesc harta site-ului, indexează noi actualizări și joacă un rol crucial în îmbunătățirea SEO. În acest blog, am compilat o listă de crawler-uri web care vă va face munca mai ușoară și ușoară.

Ce este web crawler și cum funcționează?

Un web crawler este un program de calculator automat conceput pentru acțiuni repetitive, în special navigarea și indexarea documentelor online. Motoarele de căutare precum Google îl folosesc în mod obișnuit pentru a automatiza navigarea și pentru a construi un index al conținutului web. Termenul „crawler” este sinonim cu „Bot” sau „Spider”, iar Googlebot este un exemplu binecunoscut.

Acum vine întrebarea, cum funcționează crawlerele web?

Crawlerele web încep prin a descărca fișierul robot.txt al unui site web, care conține hărți de site care listează adrese URL eligibile pentru accesare cu crawlere. Pe măsură ce navighează prin pagini, crawlerele identifică noi adrese URL prin hyperlinkuri și le adaugă la o coadă de accesare cu crawlere pentru a putea fi explorate ulterior.

Diferite tipuri de crawler-uri web: Pe scurt

Crearea unei compilații de categorii de crawler-uri web implică recunoașterea celor trei clasificări principale: crawler-uri web interne , crawler-uri web comerciale și crawler-uri web open-source . Să facem cunoștință cu aceste crawler-uri web înainte de a ne scufunda în lista finală de crawler-uri web.

Web crawler intern: aceste instrumente de crawler web sunt create intern de organizații pentru a naviga prin site-urile lor web specifice, servind diverse scopuri, cum ar fi generarea de hărți de site și scanarea pentru link-uri întrerupte .

Crawler web comercial: instrumentele web crawler comerciale sunt cele accesibile pe piață pentru cumpărare și sunt de obicei dezvoltate de companii specializate în astfel de software. În plus, unele corporații importante ar putea folosi păianjeni personalizați, adaptați cerințelor lor unice de accesare cu crawlere a site-urilor.

Crawler Web cu sursă deschisă: Crawlerele cu sursă deschisă, pe de altă parte, sunt disponibile publicului sub licențe gratuite/deschise, permițând utilizatorilor să le utilizeze și să le adapteze în funcție de preferințele lor.

Deși le pot lipsi anumite funcții avansate prezente în omologii lor comerciali, ele oferă utilizatorilor o oportunitate de a explora codul sursă, obținând informații despre mecanica crawling-ului web.

O listă de crawler web compilată: cele mai comune în 2024

Niciun crawler nu este conceput pentru a gestiona întreaga sarcină de lucru pentru fiecare motor de căutare. În schimb, există o gamă diversă de crawlere web pentru a evalua conținutul paginilor dvs. web, scanându-le în beneficiul utilizatorilor de pe tot globul și oferind diferite cerințe ale diferitelor motoare de căutare. Acum, să ne aprofundăm în listele de crawler-uri web care sunt folosite astăzi.

Googlebot

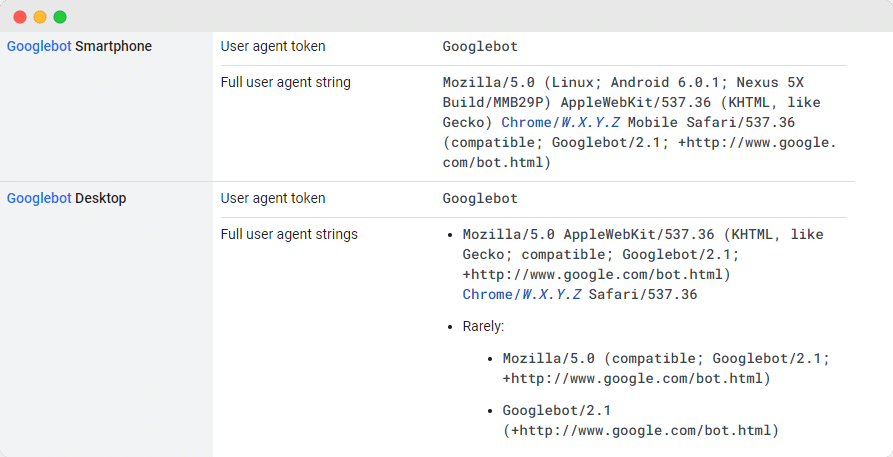

Googlebot , instrumentul generic de crawler web de la Google, joacă un rol vital în scanarea site-urilor web pentru a fi incluse în motorul de căutare Google. Deși din punct de vedere tehnic există două versiuni — Googlebot Desktop și Googlebot Smartphone (Mobil) — mulți experți le tratează ca pe un singur crawler.

Această unitate este menținută printr-un simbol de produs unic partajat (denumit simbol de agent de utilizator) specificat în robots.txt al fiecărui site, agentul utilizator fiind pur și simplu „Googlebot”.

Googlebot accesează în mod obișnuit site-ul dvs., de obicei la fiecare câteva secunde, cu excepția cazului în care este blocat în mod intenționat în robots.txt al site-ului. Paginile scanate sunt stocate într-o bază de date centralizată cunoscută sub numele de Google Cache, permițându-vă să revizuiți versiunile istorice ale site-ului dvs.

Yandex Bot

Yandex Spider este unul dintre cele mai bune instrumente de crawler web concepute exclusiv pentru platforma de căutare rusă, Yandex , care este unul dintre motoarele de căutare majore și utilizate pe scară largă din Rusia. Administratorii site-urilor web au opțiunea de a acorda acces la Yandex Spider configurând paginile site-ului lor în fișierul robots.txt.

În plus, pot îmbunătăți accesibilitatea prin încorporarea unei etichete Yandex.Metrica pe paginile selectate, pot actualiza indexarea paginilor prin instrumentele Yandex Webmaster sau pot utiliza protocolul IndexNow - un raport exclusiv care identifică paginile noi, modificate sau dezactivate.

DuckDuck Bot

DuckDuckBot funcționează ca crawler al motorului de căutare pentru DuckDuckGo, asigurând confidențialitatea browserului dvs. de internet. Proprietarii de site-uri web pot accesa API-ul DuckDuckBot pentru a verifica dacă site-ul lor a fost accesat cu crawlere.

În timpul acestui proces, DuckDuckBot își actualizează baza de date API cu noi adrese IP și agenți de utilizator, ajutând webmasterii să detecteze potențiali impostori sau roboți dăunători care încearcă să se conecteze cu DuckDuckBot.

Bingbot

În 2010, Microsoft a dezvoltat Bingbot pentru a analiza și cataloga adresele URL, asigurându-se că Bing oferă rezultate de căutare relevante și actuale. Similar cu Googlebot, proprietarii de site-uri web pot specifica în robots.txt dacă permit sau interzice „ bingbot ” să-și scaneze site-ul.

În plus, dezvoltatorii pot face diferența între crawlerele de indexare mobile-first și crawlerele desktop, deoarece Bingbot a adoptat recent un nou tip de agent. Acest lucru, combinat cu Bing Webmaster Tools, oferă webmasterilor o flexibilitate sporită în prezentarea modului în care este găsit și afișat site-ul lor în rezultatele căutării.

Apple Bot

Apple a inițiat dezvoltarea Apple Bot pentru a scana și cataloga pagini web pentru integrarea cu Siri și Spotlight Suggestions de la Apple. Apple Bot evaluează diferite criterii pentru a determina conținutul pe care să-l acorde prioritate în Sugestiile Siri și Spotlight.

Aceste criterii implică interacțiunea utilizatorului, semnificația termenilor de căutare, cantitatea și calitatea linkurilor, semnalele bazate pe locație și designul general al paginilor web.

Păianjen Sogou

Sogou , un motor de căutare chinezesc, este recunoscut ca platformă inițială de căutare care indexează 10 miliarde de pagini chineze. Pentru cei implicați în activitățile de pe piața chineză, cunoașterea acestui crawler utilizat pe scară largă pentru motorul de căutare, Sogou Spider, este esențială. Respectă textul de excludere a roboților și setările de întârziere pentru accesare cu crawlere.

Similar cu Baidu Spider, dacă afacerea dvs. nu vizează piața chineză, vă sugerăm să dezactivați acest spider pentru a evita încărcarea lentă a site-ului.

Păianjen Baidu

Motorul de căutare principal din China este Baidu, iar crawler-ul său exclusiv este Baidu Spider . Datorită absenței Google în China, devine crucial să îi permiteți lui Baidu Spider să acceseze cu crawlere site-ul dvs. dacă doriți să vizați piața chineză. Pentru a recunoaște activitatea Baidu Spider pe site-ul dvs., verificați dacă există agenți de utilizator precum baiduspider, baiduspider-image, baiduspider-video și alții.

Pentru cei care nu sunt implicați în activități comerciale chinezești, ar putea fi rezonabil să blochezi Baidu Spider folosind scriptul robots.txt. Procedând astfel, puteți împiedica Baidu Spider să vă scaneze site-ul, eliminând orice posibilitate ca paginile dvs. să apară pe paginile cu rezultate ale motorului de căutare (SERPs) Baidu.

Slurp Bot

Robotul de căutare Yahoo, Slurp Bot , joacă un rol crucial în accesarea cu crawlere și indexarea paginilor nu numai pentru Yahoo.com, ci și pentru platformele sale afiliate precum Yahoo News, Yahoo Finance și Yahoo Sports.

Absența acestei accesări cu crawlere ar duce la absența înregistrărilor relevante de site-uri. Experiența web personalizată pentru utilizatori, cu rezultate mai pertinente, este posibilă prin contribuția conținutului indexat.

Hit extern Facebook

Facebook Crawler , denumit și Facebook External Hit, examinează HTML-ul unui site web sau al unei aplicații partajate pe Facebook. Acesta este responsabil pentru crearea unei previzualizări a linkurilor partajate pe platformă, afișând titlul, descrierea și imaginea în miniatură.

Accesarea cu crawlere trebuie să aibă loc prompt, deoarece orice întârziere poate duce la neafișarea fragmentului personalizat atunci când conținutul este partajat pe Facebook.

Swiftbot

Un motor de căutare personalizat, Swiftype, îmbunătățește funcționalitatea de căutare a site-ului dvs. prin integrarea tehnologiei de vârf, algoritmi, cadru de introducere a conținutului, clienți și instrumente de analiză. Deosebit de benefic pentru site-urile web cu numeroase pagini, Swiftype oferă o interfață ușor de utilizat pentru a cataloga și indexa eficient toate paginile.

Swiftbot, crawler-ul web al Swiftype, joacă un rol vital în acest proces. În special, Swiftbot se distinge prin accesarea cu crawlere exclusivă a site-urilor pe baza solicitărilor clienților, deosebindu-l de alți roboți.

Topul cu crawlerele web pentru a stăpâni SEO în 2024

Lista de crawler web organizată prezentată în acest blog servește ca o resursă valoroasă pentru eficientizarea procesului de menținere a site-ului dvs. dinamic și prietenos cu SEO. Pe măsură ce vă apropiați de 2024, trebuie să încorporați aceste cele mai bune instrumente de crawler web în strategia dvs. pentru a vă asigura că site-ul dvs. rămâne în fruntea clasamentelor motoarelor de căutare, permițând echipelor să se concentreze pe crearea de conținut de calitate, în timp ce crawlerele se ocupă de complexitățile optimizării.

Dacă ați găsit acest articol plin de resurse, atunci împărtășiți-l și altora. De asemenea, nu uitați să vă abonați la blogul nostru și să găsiți mai multe informații ca acestea pentru a ieși în evidență în clasamentul căutărilor.