Cum să vă optimizați WordPress Robots.txt pentru SEO

Publicat: 2022-08-23În acest blog, vom afla câteva sfaturi despre cum puteți îmbunătăți SEO site-ului dvs. prin optimizarea fișierului robts.txt.

De fapt, fișierul Robots.txt joacă un rol important în ceea ce privește SEO, deoarece le spune motoarelor de căutare cum poate fi accesat cu crawlere site-ul dvs. Acesta este motivul pentru care fișierele Robot.txt sunt considerate unul dintre cele mai puternice instrumente ale SEO.

Mai târziu, veți afla și cum puteți construi și optimiza WordPress Robots.txt pentru SEO.

Ce vrei să spui prin fișier robots.txt?

Fișierul text creat de proprietarii de site-uri web pentru a le spune roboților motoarelor de căutare că modul în care pot accesa cu crawlere pe site-ul lor și pot indexa paginile este cunoscut sub numele de Robots.txt

De fapt, în directorul rădăcină, acest fișier este stocat. Acest director se mai numește și folderul principal al site-ului dvs. web. Mai jos este menționat formatul de fișier pentru fișierul robots.txt

Agent utilizator: [nume agent utilizator] Nu permiteți: [Șirul URL nu trebuie accesat cu crawlere] Agent utilizator: [nume agent utilizator] Permiteți: [șirul URL să fie accesat cu crawlere] Harta site-ului: [URL-ul sitemapului dvs. XML]

Pentru a permite sau a interzice anumite adrese URL, puteți avea rânduri diferite de instrucțiuni. În plus, puteți adăuga și diferite sitemap-uri. Boții motoarelor de căutare vor considera că li se permite să acceseze cu crawlere paginile dacă permite o adresă URL.

Un exemplu de robots.txt este dat mai jos

Agent utilizator: * Permite: /wp-content/uploads/ Nu permiteți: /wp-content/plugins/ Nu permiteți: /wp-admin/ Harta site-ului: https://example.com/sitemap_index.xml

În exemplul de mai sus, am permis să accesăm cu crawlere paginile de către motoarele de căutare și să le obținem fișiere indexate în folderul de încărcări WordPress.

După aceasta, nu am permis roboților de căutare să acceseze cu crawlere și să indexeze folderele și pluginurile de administrare WordPress.

În cele din urmă, am menționat adresa URL a sitemap-ului XML.

Pentru site-ul dvs. WordPress aveți nevoie de un fișier Robots.txt?

Motorul de căutare va începe să acceseze cu crawlere și să indexeze paginile dvs. chiar dacă nu aveți fișierul text, adică Robots.txt. Dar, din păcate, nu puteți informa motorul de căutare care anume folder sau pagină ar trebui să acceseze cu crawlere.

Nu va profita sau nu va lăsa niciun impact dacă tocmai ați creat un site web sau un blog cu mai puțin conținut.

Cu toate acestea, odată ce v-ați configurat site-ul web cu mult conținut și când a început să crească, veți avea nevoie de control asupra paginilor accesate cu crawlere și indexate ale site-ului dvs.

Primul motiv este prezentat mai jos

Pentru fiecare site web, roboții de căutare au o cotă de accesare cu crawlere.

Acest lucru înseamnă în mod clar că, în timpul sesiunii de accesare cu crawlere, va accesa cu crawlere numărul specific de pagini. Să presupunem că accesarea cu crawlere pe site-ul dvs. web rămâne incompletă, atunci va reveni încă o dată și va relua accesarea cu crawlere într-o altă sesiune.

Din acest motiv, rata de indexare a site-ului dvs. web va fi o confruntare.

Puteți remedia această problemă nepermițând roboților de căutare să nu acceseze cu crawlere astfel de pagini care nu sunt necesare. Unele pagini neimportante pot include fișiere plugin, pagini de administrare WordPress și foldere cu teme.

Cota de accesare cu crawlere poate fi salvată prin interzicerea accesării cu crawlere a paginilor nedorite. Acest pas va fi mai util deoarece motoarele de căutare vor accesa cu crawlere paginile site-ului web și le vor putea indexa cât mai curând posibil.

Un alt motiv pentru care ar trebui să utilizați și să optimizați fișierul WordPress Robots.txt este prezentat mai jos

Ori de câte ori trebuie să opriți motoarele de căutare de la indexarea paginilor sau postărilor de pe site-ul dvs., atunci puteți utiliza acest fișier.

De fapt, este una dintre cele mai nepotrivite modalități de a acoperi conținutul site-ului dvs. de la publicul larg, dar se va dovedi a fi cel mai bun suport pentru a le proteja pentru a fi afișate în rezultatele căutării.

Cum apare fișierul Robots.txt?

Un fișier robots.txt foarte simplu este folosit de cele mai populare bloguri. Conținutul poate diferi în comparație cu cerințele anumitor site-uri web.

Agent utilizator: * Nu permiteți: Harta site-ului: http://www.example.com/post-sitemap.xml Harta site-ului: http://www.example.com/page-sitemap.xml Fișierul robots.txt va permite tuturor roboților să indexeze fiecare conținut și să ofere link-uri către site-ul web al site-ului XML. Sunt menționate următoarele reguli care trebuie respectate în fișierele robots.txt Agent utilizator: * Permite: /wp-content/uploads/ Nu permiteți: /wp-content/plugins/ Nu permiteți: /wp-admin/ Nu permiteți: /readme.html Nu permiteți: /refer/ Harta site-ului: http://www.example.com/post-sitemap.xml Harta site-ului: http://www.example.com/page-sitemap.xml

Acest lucru va indica botul să indexeze toate fișierele și imaginile WordPress. Acest lucru nu va permite roboților de căutare să indexeze zona de administrare WordPress, fișierele plugin WordPress, linkurile afiliate și fișierul readme WordPress.

În fișierele robots.txt, puteți adăuga sitemap-uri care vor ajuta roboții Google să recunoască toate paginile de pe site-ul dvs.

Acum știți cum arată fișierul robots.txt, acum vom afla cum poate fi creat fișierul robots.txt în WordPress.

În WordPress, cum să construiți un fișier robots.txt?

Pentru a crea un fișier robots.txt în WordPress există atât de multe moduri. Unele dintre metodele de top sunt enumerate mai jos, puteți alege oricare dintre ele să funcționeze cel mai bine pentru dvs.

Metoda 1: Utilizarea All in One SEO, modificarea fișierului Robots.txt

All in One SEO este cel mai cunoscut plugin WordPress pentru SEO de pe piață, care este folosit de peste 1 milion de site-uri web.

Pluginul All in One SEO este foarte simplu de utilizat și, prin urmare, oferă generatorul de fișiere robotx.txt. De asemenea, este util să optimizați WordPress Robots.txt

Dacă nu ai integrat încă acest plugin SEO, atunci instalează-l și activează-l mai întâi din tabloul de bord WordPress. Versiunea gratuită este disponibilă și pentru utilizatorii începători, astfel încât aceștia să își poată utiliza funcțiile fără a investi bani.

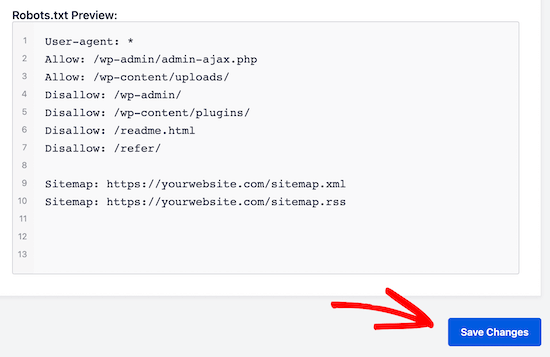

După activarea pluginului, puteți începe să îl utilizați pentru a construi sau modifica fișierul robots.txt direct din zona dvs. de administrare WordPress.

Pentru a-l folosi

- Accesați All in One SEO

- Acum, pentru a edita fișierul robots.txt, faceți clic pe instrumente

- Acum, făcând clic pe „activați robots.txt personalizat”, veți activa opțiunea de editare

- În WordPress, puteți crea și un fișier robots.txt personalizat cu această comutare.

- Acum fișierul dvs. robots.txt existent va fi afișat de „Plugin-ul SEO All in One” din secțiunea „previzualizare robots.txt”. Acesta este vizibil în partea de jos a ecranului dvs. web.

Prin WordPress, regula implicită care a fost adăugată va fi afișată de această versiune

Regulile implicite care par să sugereze motorului dvs. de căutare că nu trebuie să acceseze cu crawlere fișierele principale WordPress, să ofere un link către site-ul web al sitemap-ului XML și să permită roboților să indexeze tot conținutul acestuia.

Pentru a vă îmbunătăți robots.txt pentru SEO, pot fi adăugate noi reguli personalizate.

Adăugați agent utilizator în câmpul „Agent utilizator”, pentru a adăuga o regulă. Regula va fi aplicată tuturor agenților utilizatori prin utilizarea unui *.

Acum alegeți dacă doriți să permiteți sau nu să permiteți motorului de căutare să acceseze cu crawlere paginile.

Acum adăugați calea directorului, numele fișierului în câmpul „Calea directorului”.

În robots.txt-ul dvs., regula va fi aplicată automat. Faceți clic pe butonul „Adăugați o regulă” pentru a adăuga o nouă regulă.

Dacă nu creați un format robotx.txt ideal, vă sugerăm să adăugați reguli noi.

Regulile personalizate adăugate de dvs. vor arăta ca

Pentru a stoca modificările, nu ratați să faceți clic pe „salvați modificările”

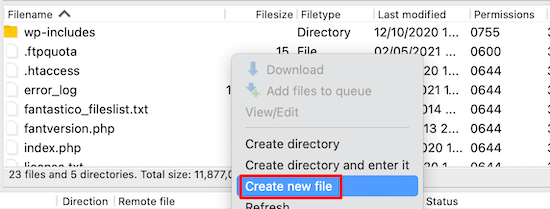

Metoda 2: Modificați manual fișierul Robots.txt cu ajutorul FTP

O altă metodă de a optimiza WordPress Robots.txt este de a utiliza funcțiile clienților FTP pentru a începe modificarea fișierului robots.txt

Trebuie doar să vă conectați la contul dvs. de găzduire WordPress cu ajutorul unui client FTP

După autentificare, în folderul rădăcină al site-ului web, veți putea vizualiza fișierul robots.txt.

Dacă nu îl puteți găsi, înseamnă că nu aveți fișierul robots.txt

Într-o astfel de situație, trebuie să creați fișierul robot.txt.

După cum am menționat mai devreme, fișierul robots.txt este de obicei un fișier text simplu care poate fi descărcat pe computer. Cu toate acestea, îl puteți modifica chiar și cu ajutorul unui editor de text simplu, cum ar fi TextEdit, Notepad sau WordPad.

Odată ce ați efectuat toate modificările, acum este timpul să le salvați. Puteți încărca acest fișier în folderul rădăcină al site-ului dvs. web.

Cum puteți efectua testarea fișierului dvs. Robots.txt?

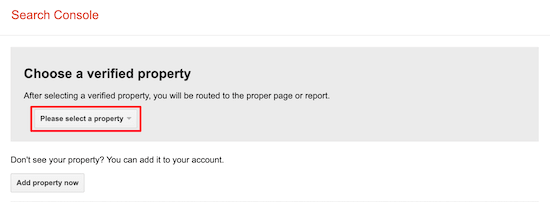

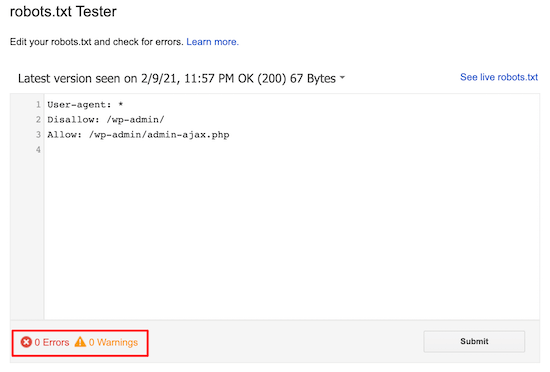

Puteți efectua testarea cu ajutorul instrumentului de testare robots.txt.

Pe web, veți găsi o mulțime de instrumente de testare robots.txt. Una dintre cele mai bune este Google Search Console.

Pentru a lucra cu acest instrument, trebuie mai întâi să aveți un site web conectat la consola de căutare Google. După aceasta, puteți începe să utilizați caracteristicile sale.

Din lista derulantă, trebuie doar să vă selectați proprietatea.

Cu toate acestea, va alege automat fișierul robots.txt al site-ului dvs. și va evidenția toate avertismentele și erorile. Acesta este unul dintre cele mai bune instrumente care vă ajută să optimizați fișierul WordPress Robots.txt foarte ușor.

Concluzie:

Motto-ul principal al optimizării acestui fișier robots.txt este de a proteja paginile de accesarea cu crawlere. De exemplu pagini din folderul admin WordPress sau pagini din folderul wp-plugin.

Cel mai des întâlnit mit este că puteți îmbunătăți rata de accesare cu crawlere și o puteți indexa mai rapid și obține un clasament mai ridicat prin blocarea categoriei WordPress, realizarea paginilor și etichetelor.

Dar acest lucru nu va funcționa, deoarece va merge prost conform instrucțiunilor Google pentru webmasteri.

Vă recomandăm să citiți și să luați în considerare toate punctele menționate mai sus.

Sperăm că acest blog vă va ajuta să creați un fișier robots.txt folosind formatul potrivit pentru site-ul dvs. Și vă va ajuta să optimizați WordPress Robots.txt.