Cum să vă optimizați WordPress Robots.txt pentru SEO folosind Yoast SEO

Publicat: 2023-10-25Optimizarea pentru motoarele de căutare (SEO) este o parte crucială a construirii unui site web eficient, iar unul dintre cei mai importanți factori în obținerea succesului SEO este utilizarea instrumentelor potrivite pentru a vă optimiza site-ul. Un astfel de instrument este fișierul Robots.txt, care controlează modul în care crawlerele motoarelor de căutare accesează și indexează conținutul dvs.

Optimizarea fișierului WordPress Robots.txt vă poate ajuta să obțineți o poziție mai bună în motoarele de căutare, să vă îmbunătățiți vizibilitatea site-ului și să vă creșteți traficul.

Cu toate acestea, în ciuda importanței sale, mulți proprietari de site-uri web nu sunt familiarizați cu cum să-și configureze corect fișierul Robots.txt. În această postare pe blog, vă vom ghida prin tot ce trebuie să știți pentru a vă stăpâni WordPress Robots.txt pentru SEO și a debloca întregul potențial SEO pentru site-ul dvs.

Înțelegerea rolului robots.txt în SEO

Înțelegerea funcției fișierului robots.txt în optimizarea motoarelor de căutare este esențială pentru a profita la maximum de eforturile dvs. de optimizare a site-ului WordPress și pentru a genera cele mai bune rezultate posibile. Un fișier text numit Robots.txt, care poate fi denumit și Protocolul de excludere a roboților, oferă instrucțiuni crawlerilor motoarelor de căutare în ce zone ale site-ului dvs. ar trebui să acceseze cu crawlere și să le indexeze.

Când roboții de la motoarele de căutare vă vizitează site-ul web, primul lucru pe care îl fac este să verifice în directorul rădăcină un fișier numit robots.txt. Acest fișier servește drept ghid pentru roboți, sfătuindu-i despre site-urile și fișierele pe care le este permis să le viziteze, precum și despre cele pe care nu le sunt.

Aveți control complet asupra materialului care este afișat motoarele de căutare și asupra lucrurilor care sunt ascunse de acestea dacă configurați corect fișierul robots.txt.

Eficacitatea scanării site-ului dvs. ar trebui în primul rând îmbunătățită prin utilizarea fișierului robots.txt. Ajută roboții motoarelor de căutare să se concentreze pe accesarea cu crawlere și indexarea celor mai vitale părți ale site-ului dvs., evitând astfel risipa de resurse pe site-uri neesențiale sau materiale sensibile care nu ar trebui puse la dispoziția publicului larg.

Ce este exact un fișier Robots.txt?

Un fișier text simplu cunoscut sub numele de Robots.txt direcționează crawlerele web utilizate de motoarele de căutare către anumite pagini web de pe site-ul dvs. În plus, le instruiește roboților să nu acceseze cu crawlere anumite site-uri.

Este esențial să înțelegeți funcționarea unui motor de căutare înainte de a continua cu analiza aprofundată a acestui articol.

Crawlingul, indexarea și clasarea sunt cele trei activități majore care sunt efectuate de motoarele de căutare.

Primul lucru pe care îl fac motoarele de căutare este să-și trimită crawlerele web, cunoscute și sub numele de păianjeni sau roboți, pe tot cuprinsul World Wide Web. Aceste programe, cunoscute sub denumirea de boți, sunt piese inteligente de software care se accesează cu crawlere pe întregul web în căutarea de noi conexiuni, pagini și site-uri web. Crawling este termenul dat procesului de căutare prin conținut pe web.

Paginile site-ului dvs. vor fi organizate într-o structură de date care poate fi utilizată după ce boții le-au descoperit. Indexarea este numele dat acestei proceduri.

Și până la urmă totul se rezumă la clasamente. Când un utilizator introduce o interogare de căutare, motorul de căutare ar trebui să ofere utilizatorului cele mai bune și mai relevante informații pe care le poate găsi în funcție de ceea ce caută utilizatorul.

Cum arată fișierul Robots.txt?

Fișierul robots.txt este o componentă vitală a structurii și funcționalității unui site web, dar v-ați întrebat vreodată cum apare de fapt?

Fișierul este aplicabil tuturor roboților motoarelor de căutare care vizitează site-ul web, așa cum este indicat de asteriscul care urmează User-agent. Fiecare motor de căutare folosește un user-agent diferit pentru a explora internetul.

De exemplu, Google utilizează Googlebot pentru a indexa conținutul site-ului dvs. web pentru căutarea Google. Acești user-agenti se numără în sute. Instrucțiuni personalizate pot fi configurate pentru fiecare user-agent. De exemplu, prima linie a fișierului dvs. robots.txt ar trebui să fie „Dacă doriți să setați instrucțiuni specifice pentru Googlebot, acesta va fi cunoscut sub numele de User-agent: Googlebot.

Care este mai exact bugetul Crawl?

Bugetul de accesare cu crawlere se referă la numărul de pagini pe care un motor de căutare este dispus să acceseze cu crawlere pe un site web într-un interval de timp dat. Este determinat de diverși factori, cum ar fi autoritatea site-ului web, popularitatea și capacitatea serverului de a gestiona solicitările de accesare cu crawlere. În plus, ar trebui să vă asigurați că bugetul de accesare cu crawlere este utilizat cât mai eficient posibil pentru site-ul dvs. web.

Cele mai importante pagini ar trebui cu siguranță să fie accesate cu crawlere mai întâi de bot dacă site-ul dvs. are mai multe pagini. Prin urmare, este imperativ să precizați acest lucru în mod specific în fișierul robots.txt.

Cum să localizați și să editați fișierul robots.txt în WordPress?

Localizarea și editarea fișierului robots.txt în WordPress este un pas crucial în optimizarea site-ului dvs. web pentru motoarele de căutare. Prin configurarea corectă a acestui fișier, puteți controla ce părți ale site-ului dvs. sunt accesibile crawlerelor motoarelor de căutare, asigurându-vă că aceștia se concentrează pe cele mai importante pagini și conținut.

Pentru a localiza și edita fișierul robots.txt în WordPress, urmați acești pași simpli:

1. Conectați-vă la tabloul de bord WordPress.

2. Navigați la fila „Setări” din meniul din partea stângă.

3. Faceți clic pe „Reading” pentru a accesa setările de citire.

4. Derulați în jos până când găsiți secțiunea „Vizibilitatea motorului de căutare”.

5. Aici, veți vedea o opțiune care spune „Descurajați motoarele de căutare de la indexarea acestui site”. Asigurați-vă că această opțiune este debifată, deoarece va genera un fișier robots.txt de bază care limitează accesul motorului de căutare la întregul site.

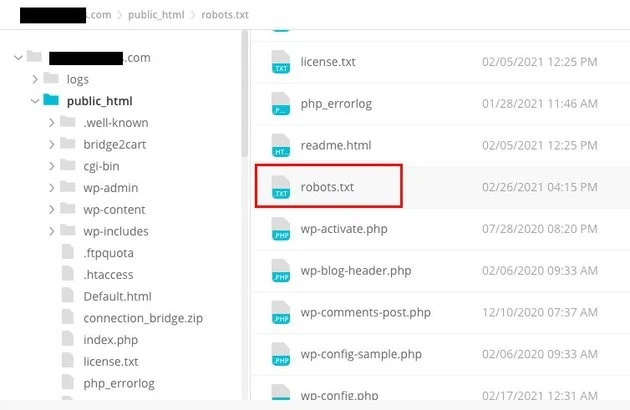

6. Dacă doriți să personalizați în continuare fișierul robots.txt, puteți face acest lucru accesând directorul rădăcină al site-ului dvs. web. Acest lucru se poate face de obicei printr-un client FTP sau un manager de fișiere cPanel.

7. După ce ați localizat directorul rădăcină, căutați fișierul numit „robots.txt”.

8. Descărcați o copie a fișierului robots.txt existent pe computer ca rezervă, în cazul în care apar probleme în timpul editării.

9. Deschideți fișierul robots.txt folosind un editor de text.

10. Personalizați fișierul în funcție de nevoile dvs. Puteți adăuga anumite directive pentru a permite sau a interzice accesul la anumite zone ale site-ului dvs. De exemplu, puteți împiedica motoarele de căutare să acceseze cu crawlere zona dvs. de administrare adăugând următoarea linie:

1. Nu permiteți: /wp-admin/

11. Salvați modificările aduse fișierului robots.txt și încărcați-l înapoi în directorul rădăcină al site-ului dvs. web, înlocuind versiunea anterioară.

12. În cele din urmă, testați fișierul robots.txt folosind instrumentul de testare robots.txt de la Google sau alte instrumente similare pentru a vă asigura că este configurat corect.

Controlul modului în care crawlerele motoarelor de căutare interacționează cu site-ul dvs. web poate fi realizat în WordPress prin identificarea și modificarea fișierului robots.txt în locația potrivită. Acest lucru vă va permite să obțineți cele mai bune rezultate posibile în ceea ce privește vizibilitatea și clasarea site-ului dvs. Dacă investiți timp pentru a învăța și pentru a deveni un expert în această fațetă a optimizării pentru motoarele de căutare (SEO), veți fi pe drumul cel bun pentru a debloca succesul site-ului dvs. WordPress.

Cum se creează un fișier Robots.txt în WordPress?

Să mergem mai departe și să creăm un WordPress Robots.txt pentru SEO acum că am discutat despre ce este un fișier robots.txt și de ce este atât de important. WordPress vă oferă două opțiuni distincte pentru generarea unui fișier robots.txt. Prima metodă implică utilizarea unui plugin WordPress, în timp ce a doua implică încărcarea manuală a fișierului în folderul rădăcină al site-ului dvs.

Pasul 1: Utilizați pluginul Yoast SEO pentru a crea un fișier Robots.txt

Puteți utiliza pluginuri SEO pentru a vă ajuta să vă optimizați site-ul web care este construit pe WordPress. Majoritatea acestor plugin-uri oferă propriul lor generator de fișiere robots.txt în pachetul lor de instalare.

Mai întâi, descărcați și instalați pluginul.

Navigați la meniul Plugin-uri și faceți clic pe „Adăugați nou”. Următorul pas este să căutați pluginul Yoast SEO, să îl descărcați și să îl porniți dacă nu îl aveți deja.

Creați fișierul robots.txt ca al doilea pas

Creați fișierul txt roboți folosind Yoast

Veți observa fișierul creat cu câteva directive implicite.

Generatorul de fișiere robots.txt pentru Yoast SEO va include automat următoarele directive:

Agent de utilizator: * Nu permiteți: /wp-admin/ Permiteți: /wp-admin/admin-ajax.php

Adăugați instrucțiuni suplimentare la robots.txt. După ce editați robots.txt, faceți clic pe Salvați.

Introduceți numele de domeniu și „/robots.txt”. Fișierul dvs. robots.txt este complet dacă browserul afișează directivele implicite, așa cum se vede mai jos.

fișierul robots txt generat

De asemenea, vă recomandăm să adăugați adresa URL a sitemapului în robots.txt.

Fișierul robots txt implicit

După ce pluginul a fost activat, accesați Yoast SEO > Instrumente și alegeți Editor de fișiere din meniul drop-down. Continuați să completați numele dvs. de domeniu, apoi continuați cu „/robots.txt”. Dacă te uiți în browser, vei observa câteva directive implicite afișate.

Pasul 2: Utilizarea FTP pentru a crea manual fișierul Robots.txt

- Crearea unui fișier robots.txt pe computerul dvs. local și apoi încărcarea acestuia în folderul rădăcină al site-ului dvs. WordPress este următorul pas al procesului.

- În plus, veți avea nevoie de acces la găzduirea dvs. WordPress prin utilizarea unui program FTP, cum ar fi Filezilla. Dacă nu aveți deja acreditările necesare pentru a vă conecta, acestea vă vor fi accesibile prin intermediul panoului de control al serviciului dvs. de găzduire. În consecință, puteți verifica dacă fișierul robots.txt este prezent în folderul rădăcină al site-ului dvs. web după ce vă conectați cu programul dvs. FTP.

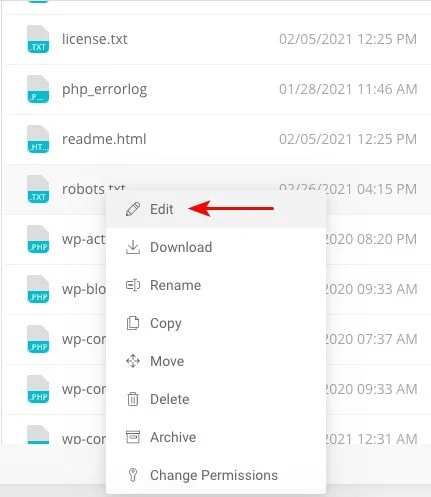

- Faceți clic dreapta pe fișier și alegeți editați dacă acesta există.

Prin urmare, când te-ai conectat cu succes cu clientul FTP, vei putea verifica dacă fișierul robots.txt se află acolo în folderul rădăcină al site-ului tău web. Introducerea numelui de domeniu urmat de „/robots.txt” este cea mai bună modalitate de a determina dacă fișierul dvs. a fost încărcat cu succes sau nu.

După ce ați făcut modificările, faceți clic pe „Salvați”.

Va trebui să creați fișierul dacă nu există deja. Se poate realiza prin adăugarea directivelor la un fișier folosind un editor de text de bază, cum ar fi Notepad. Ca

Agent de utilizator: * Nu permiteți: /wp-admin/ Permiteți: /wp-admin/admin-ajax.php

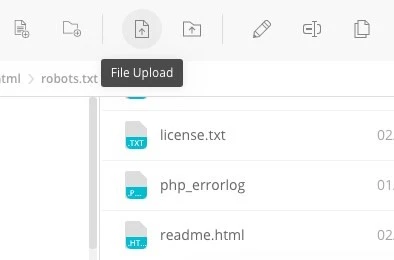

Faceți clic pe „Încărcare fișier” în clientul dvs. FTP pentru a încărca fișierul în folderul rădăcină al site-ului web.

Introdu numele domeniului și „/robots.txt” pentru a vedea dacă fișierul a fost încărcat cu succes.

Aceasta este metoda de încărcare manuală a fișierului robots.txt pe site-ul dvs. WordPress!

Robots.txt: Își cunoaște avantajele și dezavantajele

Beneficiile utilizării fișierului robots.txt

Acesta indică motorului de căutare să nu petreacă timp pe site-uri pe care nu doriți să fie indexate, ceea ce ajută la optimizarea bugetelor de accesare cu crawlere ale motorului de căutare. Procedând astfel, creșteți probabilitatea ca motoarele de căutare să acceseze cu crawlere site-urile care sunt cele mai esențiale pentru dvs.

Blocarea roboților care provoacă irosirea resurselor serverului dvs. web în acest fel contribuie la optimizarea serverului.

Este util pentru ascunderea paginilor de mulțumire, a paginilor de destinație, a paginilor de conectare și a altor pagini care nu trebuie să fie indexate de motoarele de căutare.

Aspecte negative ale fișierului robots.txt

Acum ar trebui să puteți vizualiza fișierul robots.txt pe orice site web folosind informațiile furnizate aici. Nu este prea greu de înțeles. Pur și simplu introduceți numele domeniului, urmat de „/robots.txt” și apăsați Enter.

Cu toate acestea, există și un pericol implicat într-o anumită măsură. Există posibilitatea ca fișierul WordPress Robots.txt pentru SEO să conțină URL-uri către unele dintre paginile interne ale site-ului dvs. pe care ați dori să nu fie indexate de motoarele de căutare.

De exemplu, poate exista o pagină pentru autentificare pe care nu doriți să fie indexată din orice motiv. Cu toate acestea, faptul că este menționat în fișierul robots.txt face posibil ca atacatorii să vadă site-ul. Dacă încercați să ascundeți anumite informații sensibile, se aplică același lucru.

Chiar dacă faceți o singură greșeală de scriere în timp ce scrieți fișierul robots.txt, aceasta va elimina toate eforturile dvs. de optimizare pentru motoarele de căutare (SEO). Acest lucru este adevărat chiar dacă fișierul este ușor de creat.

Unde să puneți fișierul Robots.txt

Să presupunem că în acest moment sunteți familiarizat cu locația în care trebuie inserat fișierul robots.txt.

Fișierul robots.txt al site-ului dvs. web ar trebui să fie întotdeauna localizat în directorul rădăcină al site-ului. Adresa URL a fișierului robots.txt de pe site-ul dvs. web va fi https://yourdomain.com/robots.txt dacă numele dvs. de domeniu este yourdomain.com.

Pe lângă plasarea fișierului robots.txt în directorul rădăcină al site-ului dvs. web, următoarele sunt câteva alte practici recomandate care ar trebui să fie respectate:

- Este foarte necesar să dați fișierului dumneavoastră numele robots.txt.

- Este important să scrieți cu majuscule numele. Prin urmare, trebuie să-l obțineți corect, altfel nu va funcționa.

- Fiecare instrucțiune trebuie plasată pe o linie separată.

- Când o adresă URL este completă, aceasta ar trebui să fie marcată cu semnul „$”.

- Trebuie folosită doar o singură instanță a fiecărui user-agent.

- Pentru a oferi oamenilor o explicație a conținutului fișierului dvs. robots.txt, utilizați comentarii începând fiecare rând cu un simbol (#).

Testarea și validarea fișierului dvs. robots.txt

Testarea și validarea fișierului dvs. robots.txt este un pas crucial pentru a vă asigura că motoarele de căutare accesează și indexează site-ul dvs. Un fișier robots.txt bine optimizat poate împiedica motoarele de căutare să acceseze pagini sensibile sau irelevante, poate îmbunătăți eficiența accesării cu crawlere și, în cele din urmă, poate îmbunătăți performanța generală a site-ului dvs.

Pentru a începe testarea fișierului robots.txt, puteți utiliza diverse instrumente online concepute special pentru acest scop. Aceste instrumente vă permit să introduceți directivele robots.txt și să simulați modul în care motoarele de căutare le interpretează și le urmăresc.

Analizând rezultatele, puteți identifica eventualele probleme sau configurări greșite din fișierul dvs. Monitorizarea și actualizarea regulată a fișierului dvs. robots.txt este crucială, mai ales atunci când faceți modificări structurii sau conținutului site-ului dvs. web.

Fiind vigilent, puteți identifica și remedia rapid orice probleme care pot apărea. Această abordare meticuloasă va contribui în cele din urmă la perceptibilitatea site-ului dvs., la indexarea și la succesul general în peisajul digital.

Instrumentul pe care îl sugerăm aici este Google Search Console

Puteți adăuga site-ul dvs. la Google Search Console accesând linkul „Adăugați proprietate acum” și urmând instrucțiunile simple de pe ecran care apar. După ce ați terminat, meniul drop-down etichetat „Vă rugăm să selectați o proprietate” va include site-ul dvs. web printre opțiuni.

După selectarea site-ului web, instrumentul va primi automat fișierul robots.txt asociat site-ului dvs. și va evidenția eventualele greșeli sau avertismente, dacă există.

Este un fișier Robots.txt necesar pentru site-ul dvs. WordPress?

Într-adevăr, site-ul dvs. WordPress are nevoie de un fișier robots.txt. Chiar dacă site-ul dvs. nu are un fișier robots.txt, motoarele de căutare îl vor accesa cu crawlere și îl vor indexa. Acum că am discutat despre scopul, funcționarea și bugetul de accesare cu crawlere al robots.txt, de ce ați dori să omiteți unul?

Motoarele de căutare sunt instruite ce să acceseze cu crawlere și, mai important, ce să nu acceseze cu crawlere prin fișierul robots.txt.

Luarea în considerare a consecințelor negative ale bugetului de crawl este unul dintre motivele principale pentru a adăuga fișierul robots.txt.

După cum sa spus anterior, fiecare site are un buget de accesare cu crawlere. Totul se reduce la câte site-uri vizitează un bot într-o singură sesiune. Botul va reveni și va continua accesarea cu crawlere în sesiunea ulterioară dacă nu termină toate paginile de pe site-ul dvs. în acea sesiune.

De asemenea, acest lucru scade ritmul în care site-ul dvs. este indexat.

Puteți salva cota de accesare cu crawlere reparând rapid acest lucru, împiedicând roboții de căutare să scaneze activele media, directoarele cu teme, pluginurile și site-urile străine.

Cuvinte finale

Prioritizează optimizarea conținutului, cercetarea cuvintelor cheie, construirea de backlink, crearea unui sitemap.xml și alte sarcini legate de SEO în timp ce lucrăm pe site-ul dvs. WordPress Robots.txt pentru SEO un aspect pe care unii webmasteri îl trec cu vederea.

Este posibil ca fișierul robots.txt să nu fie foarte important atunci când site-ul dvs. este lansat pentru prima dată. Acestea fiind spuse, atunci când site-ul dvs. web devine mai mare și are mai multe pagini, va fi profitabil dacă începem să folosim fișierul robots.txt recomandat.