14 распространенных ошибок в WordPress Robots.txt, которых следует избегать

Опубликовано: 2025-01-14Robots.txt — это мощный серверный файл, который сообщает поисковым роботам и другим ботам, как вести себя на вашем веб-сайте WordPress. Это может сильно повлиять на поисковую оптимизацию вашего сайта (SEO), как положительно, так и отрицательно.

По этой причине вы должны знать, что это за файл и как его использовать. В противном случае вы можете повредить свой сайт или, по крайней мере, потерять часть его потенциала.

Чтобы помочь вам избежать этого сценария, в этом посте мы подробно рассмотрим файл robots.txt. Мы определим, что это такое, какова его цель, как найти файл и управлять им, а также что он должен содержать. После этого мы рассмотрим наиболее распространенные ошибки, которые люди допускают при использовании файла robots.txt в WordPress, способы их избежать и способы исправления, если вы обнаружите, что допустили ошибку.

Что такое robots.txt в WordPress?

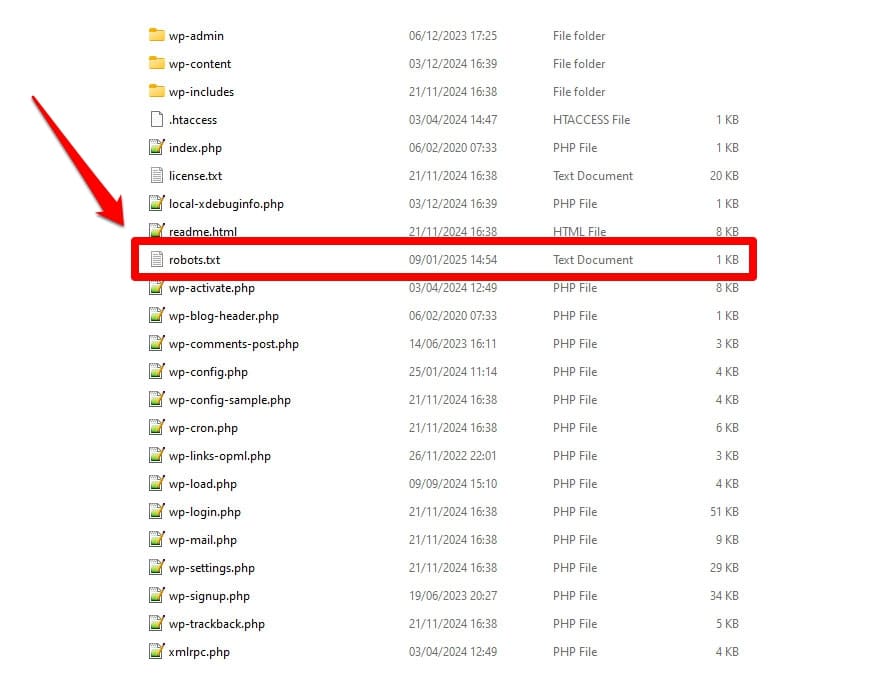

Как уже упоминалось, robots.txt — это файл конфигурации сервера. Обычно вы найдете его в корневой папке вашего сервера.

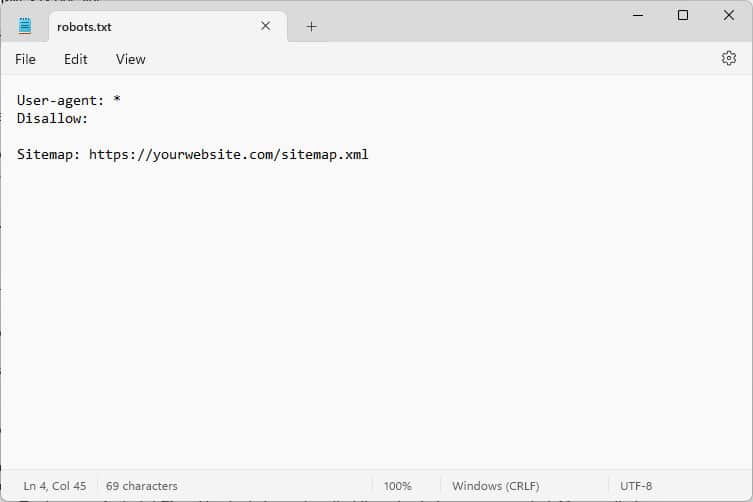

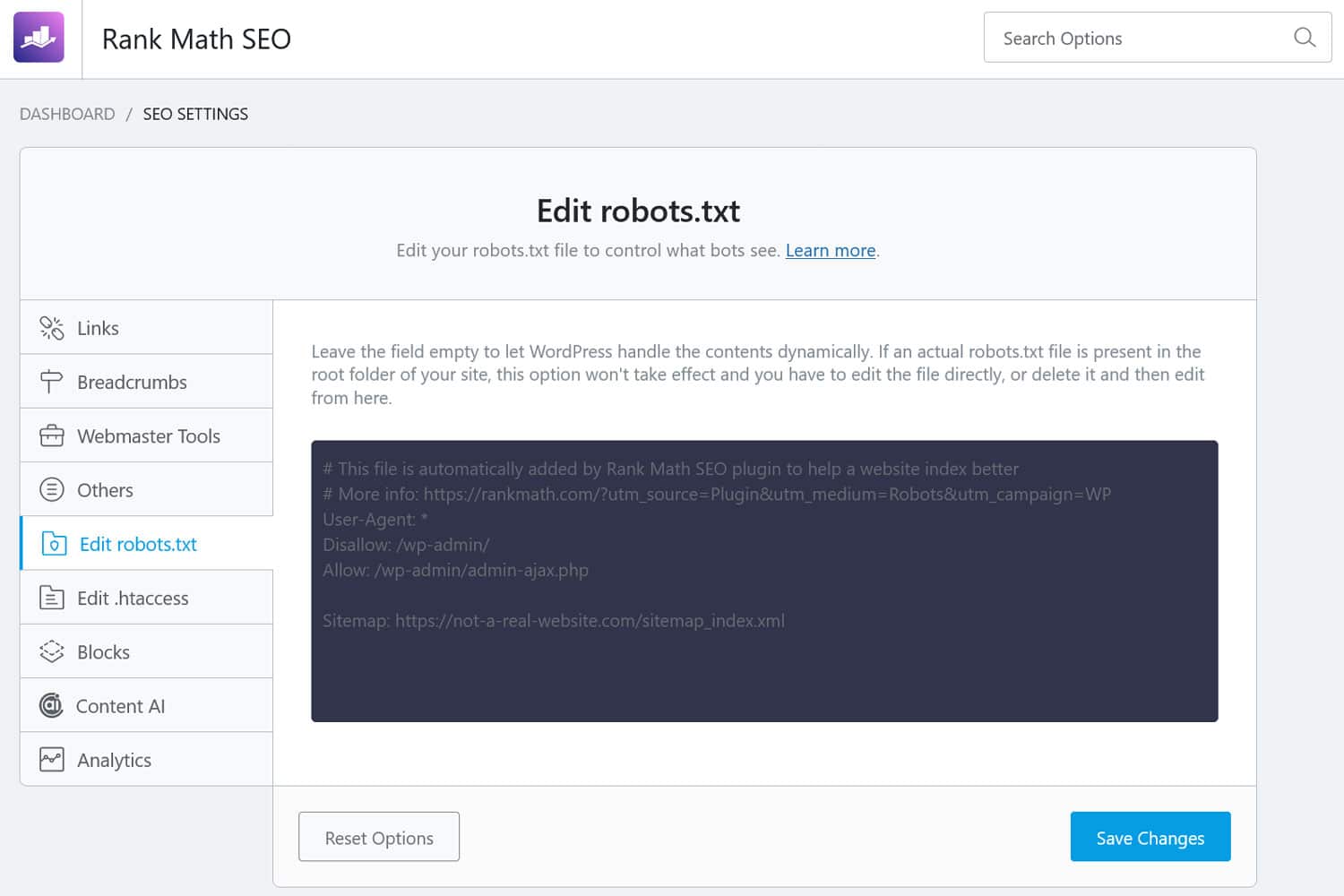

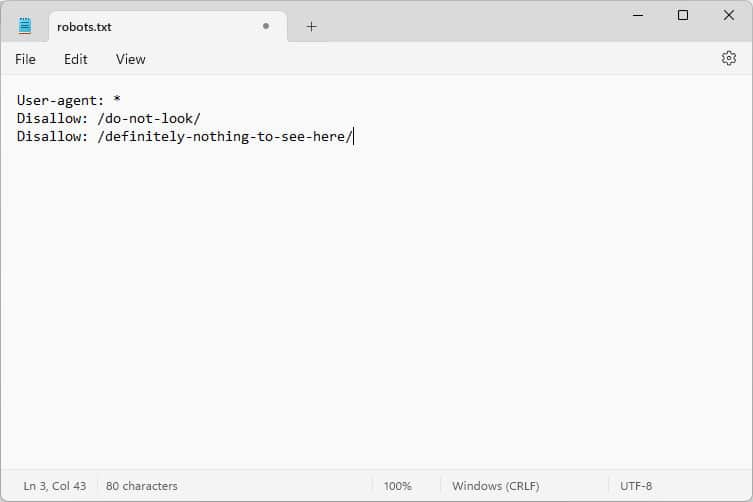

Когда вы его откроете, содержимое будет выглядеть примерно так:

Эти фрагменты кода представляют собой инструкции, которые сообщают ботам, которые заходят на ваш сайт, как вести себя, пока они там находятся, в частности, к каким частям вашего сайта иметь доступ, а к каким нет.

Какие боты, спросите вы?

Наиболее распространенными примерами являются автоматические сканеры поисковых систем, которые ищут веб-страницы для индексации или обновления, а также боты из моделей искусственного интеллекта и другие автоматизированные инструменты.

Какие указания вы можете дать с помощью этого файла?

Robots.txt в основном знает четыре ключевые директивы:

- Пользовательский агент — определяет, кто, то есть для какой группы или отдельных ботов предназначены следующие правила.

- Disallow – указывает каталоги, файлы или ресурсы, к которым пользовательскому агенту запрещен доступ.

- Разрешить — может использоваться для настройки исключений, например, для разрешения доступа к отдельным папкам или ресурсам в каталогах, запрещенных в противном случае.

- Карта сайта . Указывает ботам на URL-адрес карты сайта веб-сайта.

Только User-agent и Disallow являются обязательными для того, чтобы файл выполнял свою работу; две другие директивы являются необязательными. Например, вот как вы блокируете доступ ботов к вашему сайту:

User-agent: * Disallow: /Звездочка означает, что следующее правило применяется ко всем пользовательским агентам. Косая черта после Disallow означает, что все каталоги на этом сайте запрещены. Это файл robots.txt, который вы обычно найдете на сайтах разработчиков, которые не должны индексироваться поисковыми системами.

Однако вы также можете настроить правила для отдельных ботов:

User-agent: Googlebot Allow: /private/resources/Важно отметить, что файл robots.txt не является обязательным. Только боты из организаций, которые придерживаются Протокола исключения роботов, будут подчиняться его указаниям. Вредоносные боты, например те, которые ищут недостатки безопасности на вашем сайте, могут и будут игнорировать их, и вам необходимо принять против них дополнительные меры.

Даже организации, которые придерживаются стандарта, игнорируют некоторые директивы. О примерах этого мы поговорим ниже.

Почему файл robots.txt имеет значение?

На вашем сайте WordPress не обязательно иметь файл robots.txt. Ваш сайт будет работать без него, и поисковые системы не будут наказывать вас за его отсутствие. Однако включение одного из них позволяет:

- Не допускайте попадания контента в результаты поиска, например страниц входа или определенных медиафайлов.

- Не позволяйте поисковым роботам тратить ваш краулинговый бюджет на неважные части вашего сайта, возможно, игнорируя страницы, которые вы хотите, чтобы они проиндексировали.

- Направьте поисковые системы на вашу карту сайта, чтобы им было легче исследовать остальную часть вашего сайта.

- Сохраняйте ресурсы сервера, не допуская ненужных ботов.

Все это помогает улучшить ваш сайт, особенно его SEO, поэтому важно, чтобы вы понимали, как использовать robots.txt.

Как найти, отредактировать и создать файл robots.txt в WordPress

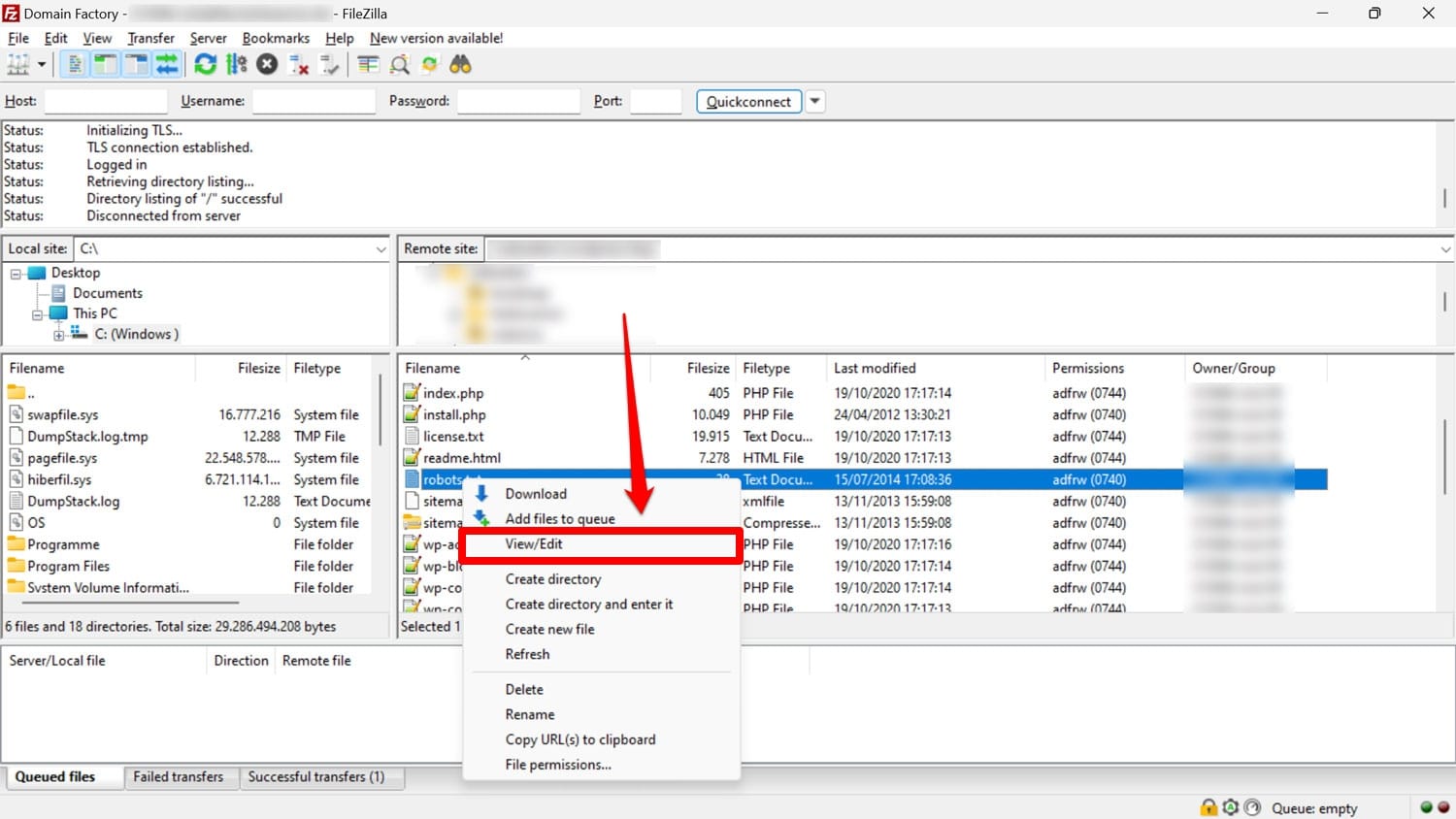

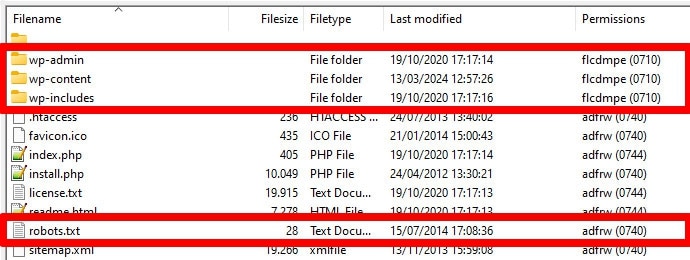

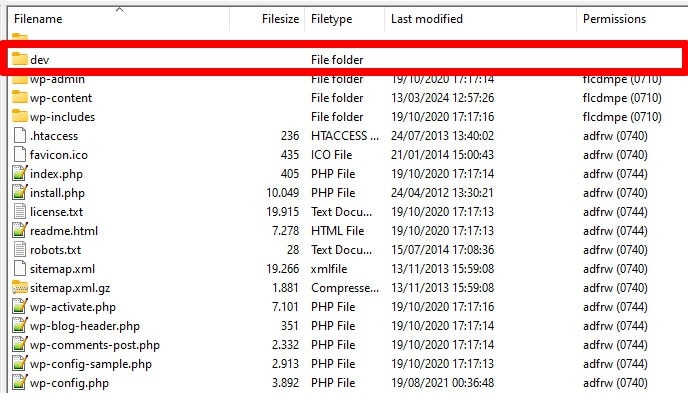

Как уже упоминалось, файл robots.txt обычно находится в корневой папке вашего сайта на сервере. Вы можете получить к нему доступ с помощью FTP-клиента, такого как FileZilla, и отредактировать его в любом текстовом редакторе.

Если у вас его нет, можно просто создать пустой текстовый файл, назвать его «robots.txt», заполнить его директивами и загрузить.

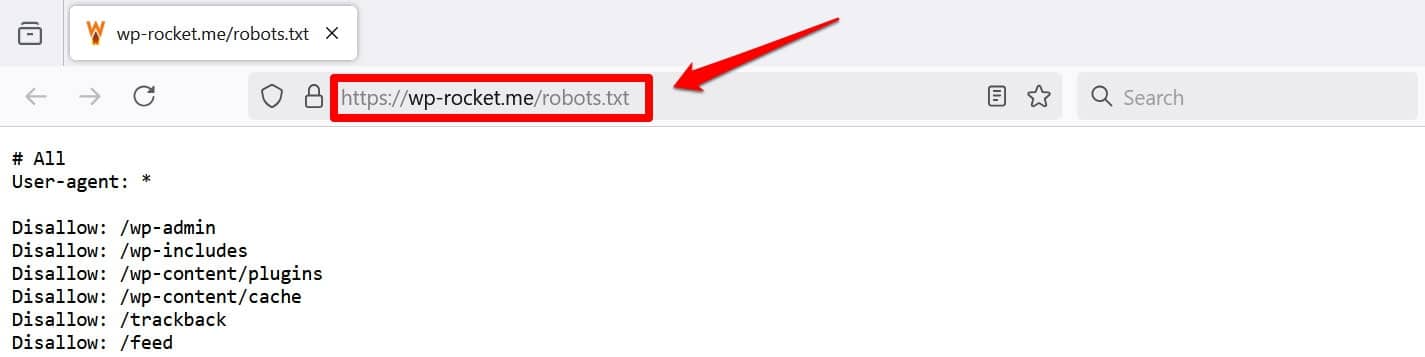

Другой способ хотя бы просмотреть ваш файл — добавить /robots.txt в свой домен, например https://wp-rocket.me/robots.txt.

Кроме того, есть способы получить доступ к файлу из серверной части WordPress. Многие SEO-плагины позволяют видеть и часто вносить в него изменения из интерфейса администрирования.

Альтернативно вы также можете использовать плагин, например WPCode.

Как выглядит хороший файл robots.txt в WordPress?

Не существует универсального ответа на вопрос, какие директивы должны быть в файле вашего веб-сайта; это зависит от вашей настройки. Вот пример, который имеет смысл для многих веб-сайтов WordPress:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php Sitemap: https://yourwebsite.com/sitemap.xmlЭтот пример позволяет достичь нескольких результатов:

- Блокирует доступ в админку

- Предоставляет доступ к основным функциям администратора.

- Предоставляет местоположение карты сайта

Эта настройка обеспечивает баланс между безопасностью, производительностью SEO и эффективным сканированием.

Не делайте эти 14 ошибок в WordPress robots.txt

Если ваша цель — настроить и оптимизировать файл robots.txt для собственного сайта, избегайте следующих ошибок.

1. Игнорирование внутреннего файла robots.txt WordPress.

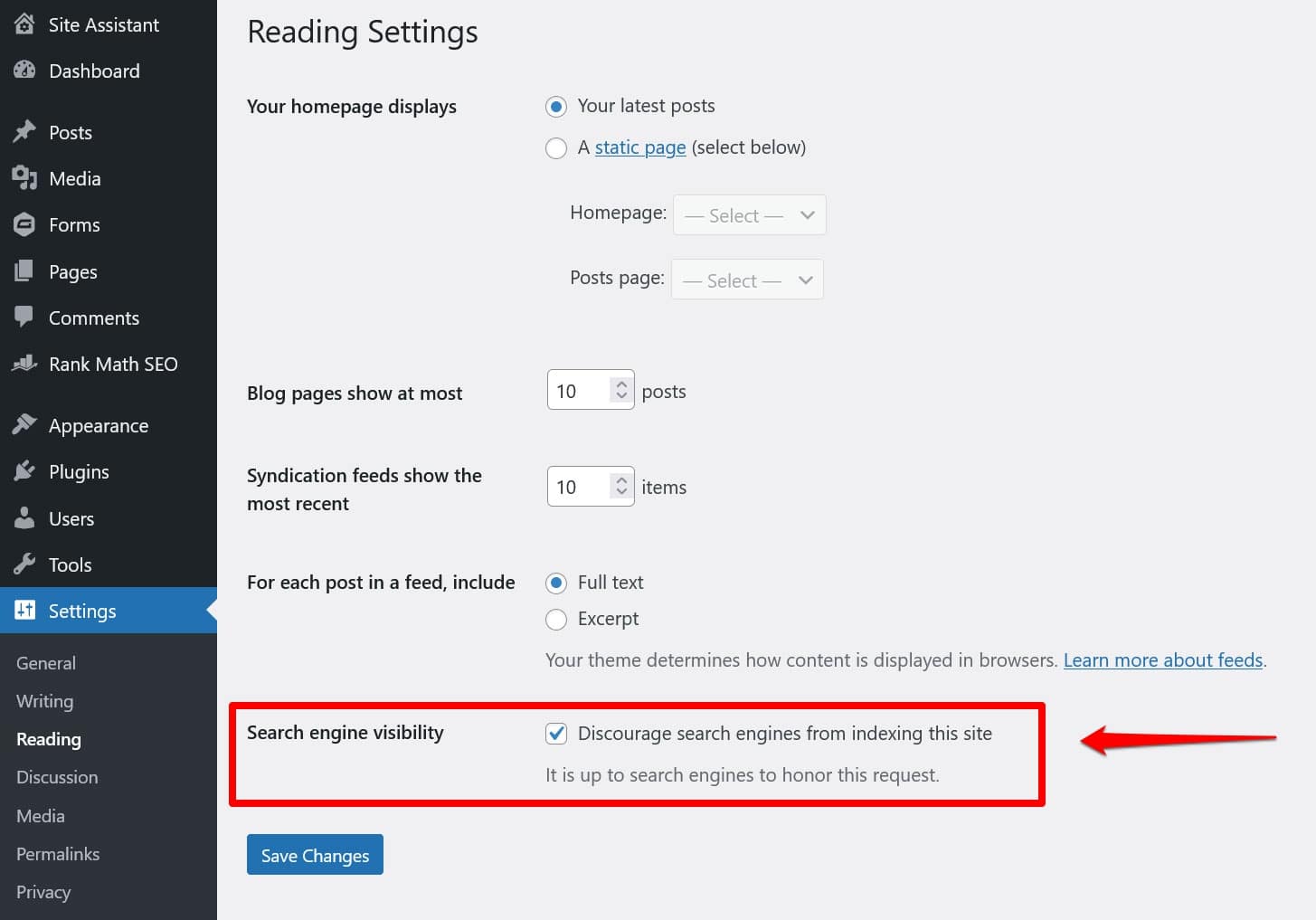

Даже если у вас нет «физического» файла robots.txt в корневом каталоге вашего сайта, WordPress поставляется с собственным виртуальным файлом. Это особенно важно помнить, если вы обнаружите, что поисковые системы не индексируют ваш сайт.

В этом случае есть большая вероятность, что вы включили опцию, запрещающую им это делать, в разделе «Настройки» > «Чтение» .

Это устанавливает директиву, запрещающую всем поисковым роботам помещаться в виртуальный файл robots.txt. Чтобы отключить его, снимите флажок и сохраните его внизу.

2. Размещение в неправильном месте

Боты, особенно поисковые роботы, ищут ваш файл robots.txt только в одном месте — корневом каталоге вашего веб-сайта. Если вы поместите его где-нибудь еще, например в папке, они его не найдут и проигнорируют.

Ваш корневой каталог должен находиться в том месте, куда вы попадаете при доступе к серверу через FTP, если только вы не поместили WordPress в подкаталог. Если вы видите папки wp-admin , wp-content и wp-includes , вы попали по адресу.

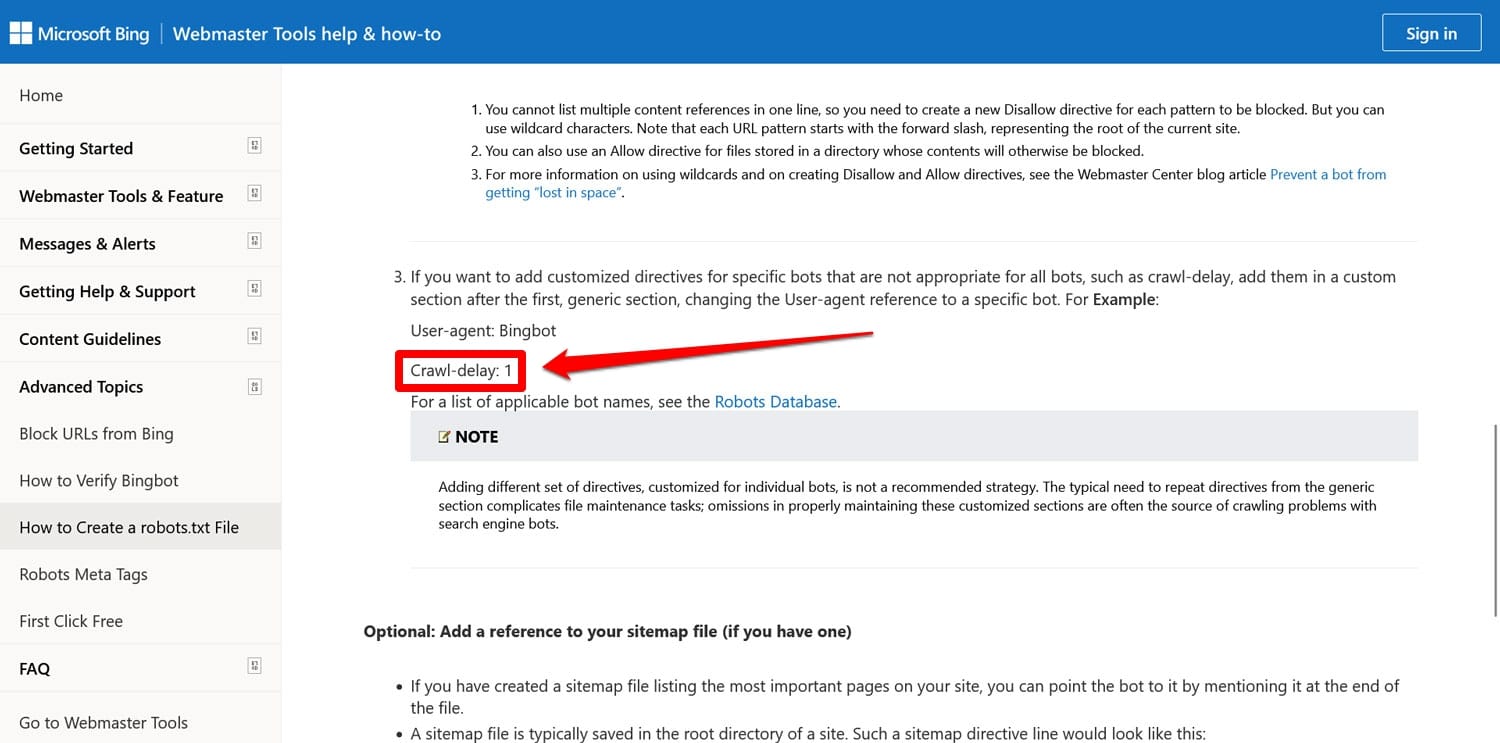

3. Включение устаревшей разметки

Помимо упомянутых выше директив, есть еще две, которые вы все еще можете найти в файлах robots.txt старых веб-сайтов:

- Noindex – используется для указания URL-адресов, которые поисковые системы не должны индексировать на вашем сайте.

- Crawl-delay – директива, предназначенная для регулирования сканеров, чтобы они не перегружали ресурсы веб-сервера.

Обе эти директивы теперь игнорируются, по крайней мере, Google. По крайней мере, Bing по-прежнему учитывает задержку сканирования.

По большей части лучше не использовать эти директивы. Это помогает сохранить ваш файл компактным и снижает риск ошибок.

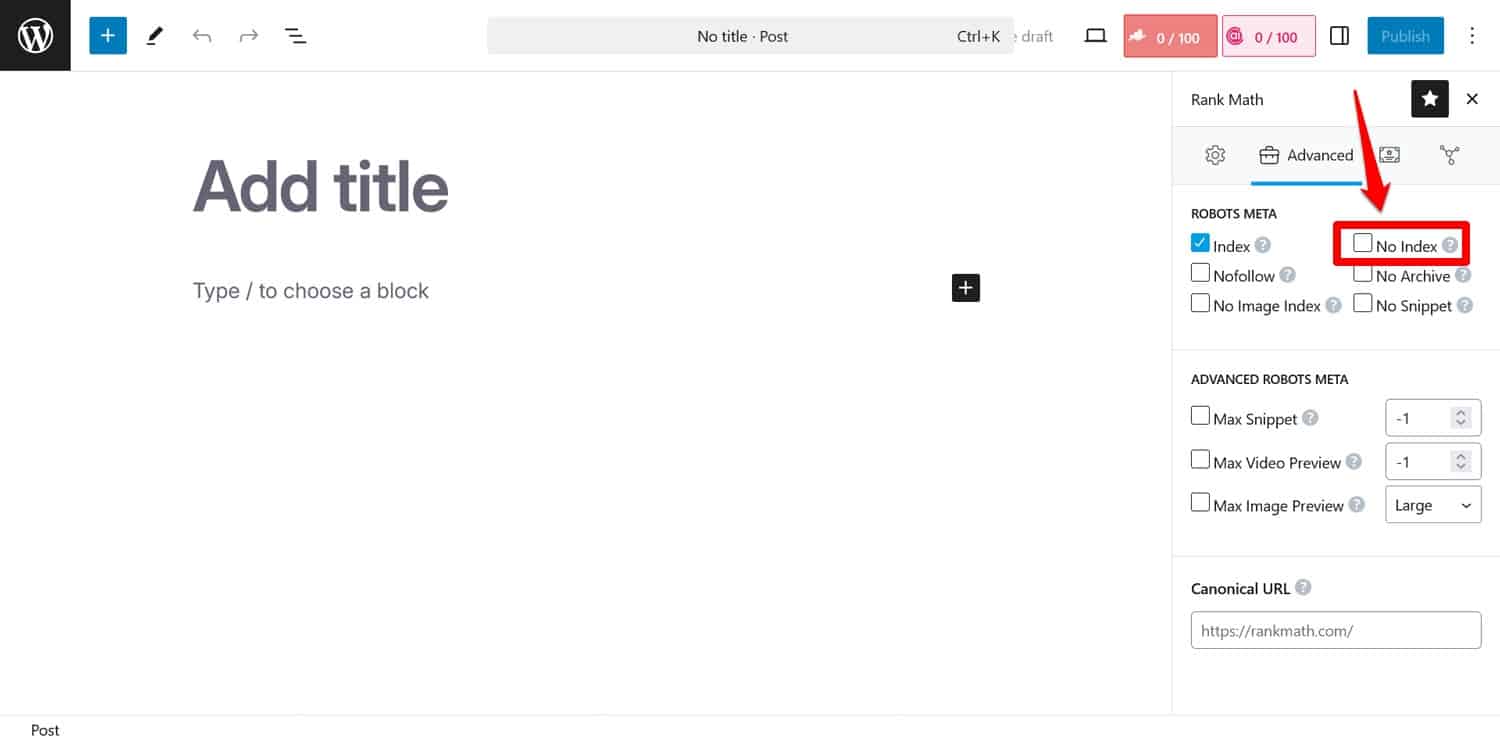

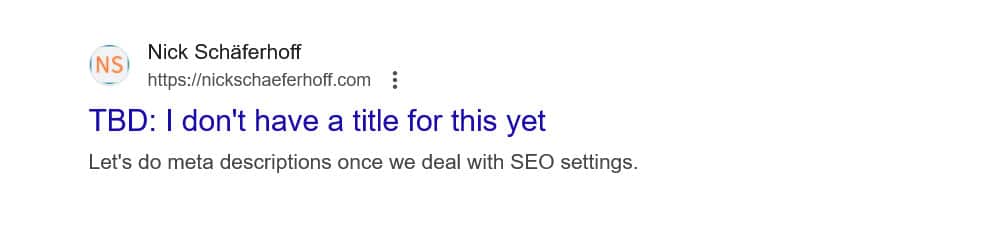

Совет: Если ваша цель — запретить поисковым системам индексировать определенные страницы, используйте вместо этого метатег noindex . Вы можете реализовать это с помощью плагина SEO для каждой страницы.

Если вы заблокируете страницы через robots.txt, сканеры не доберутся до той части, где они видят тег noindex . Таким образом, они все равно могут проиндексировать вашу страницу, но без ее содержания, что еще хуже.

4. Блокировка основных ресурсов

Одна из ошибок, которые допускают люди, — это использование файла robots.txt для блокировки доступа ко всем таблицам стилей (файлам CSS) и скриптам (файлам JavaScript) на их сайте WordPress, чтобы сохранить бюджет сканирования.

Однако это не очень хорошая идея. Боты поисковых систем отображают страницы так, чтобы «видеть» их так же, как это делают посетители. Это помогает им понять контент и соответственно проиндексировать его.

Блокируя эти ресурсы, вы можете создать у поисковых систем неправильное впечатление о ваших страницах, что может привести к тому, что они не будут правильно индексироваться или ухудшится их рейтинг.

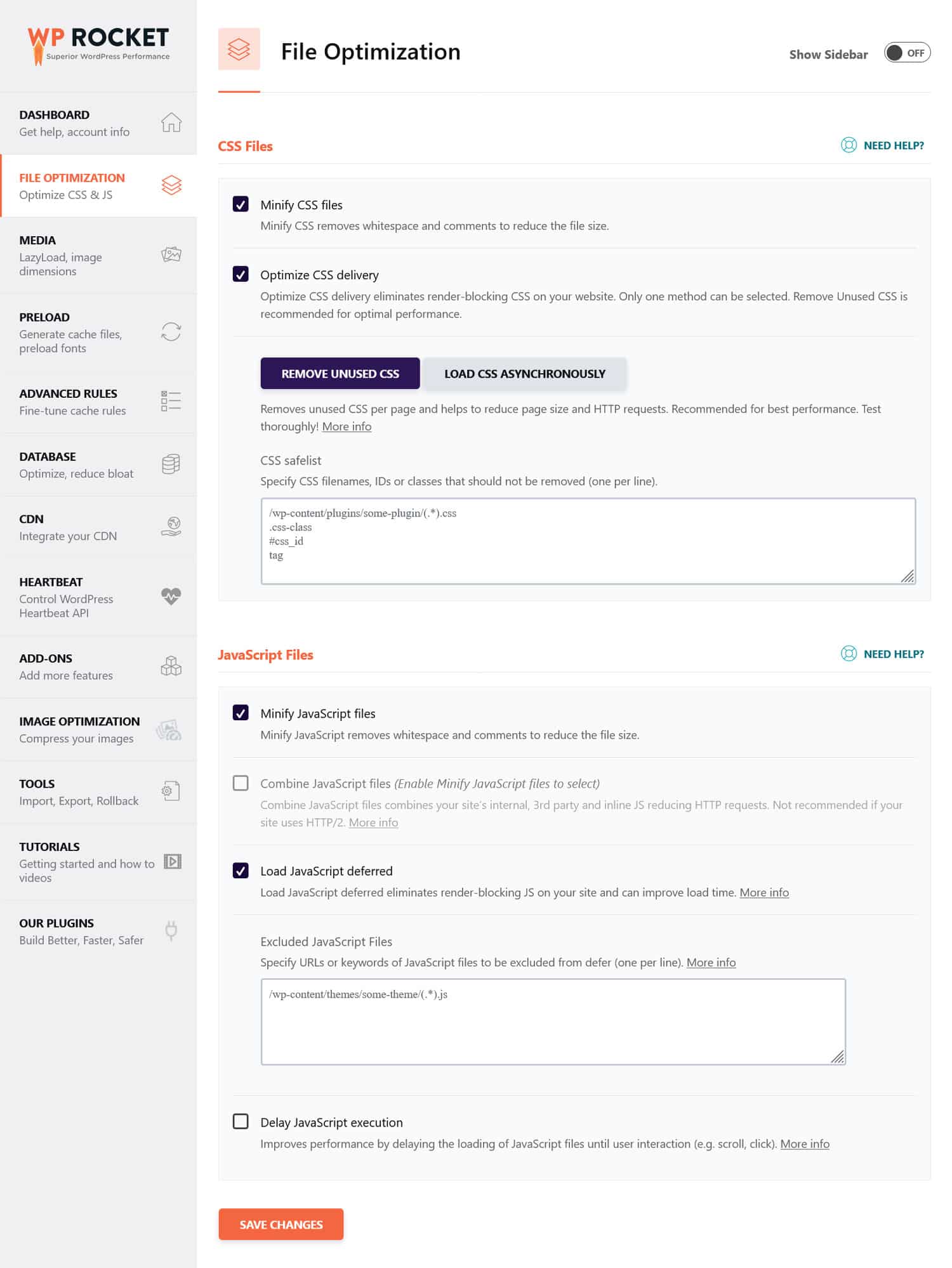

Если вы считаете, что файлы CSS и JavaScript могут снизить производительность вашего сайта, лучше оптимизировать их для быстрой загрузки как для ботов, так и для обычных посетителей. Вы можете сделать это, минимизировав код и сжимая файлы веб-сайта, чтобы они передавались быстрее. Кроме того, можно оптимизировать их доставку, исключив неиспользуемый код и отложив ресурсы, блокирующие рендеринг.

Совет : вы можете упростить этот процесс, используя плагин производительности, например WP Rocket. Его удобный интерфейс позволяет оптимизировать доставку файлов, установив несколько флажков в меню «Оптимизация файлов» .

WP Rocket также предлагает дополнительные функции для улучшения производительности веб-сайта, в том числе:

- Кэширование с помощью специального мобильного кеша

- Ленивая загрузка изображений и видео

- Предварительная загрузка кеша, ссылок, внешних файлов и шрифтов

- Оптимизация базы данных

Кроме того, плагин автоматически реализует многие шаги по оптимизации. Примеры включают кэширование браузера и сервера, сжатие GZIP и оптимизацию изображений над сгибом для улучшения LCP. Таким образом, ваш сайт станет быстрее, просто включив WP Rocket.

Плагин также предлагает 14-дневную гарантию возврата денег, поэтому вы можете протестировать его без риска.

5. Невозможно обновить файл robots.txt вашей разработки.

При создании веб-сайта разработчики обычно включают файл robots.txt, который запрещает доступ к нему всем ботам. Это имеет смысл; Меньше всего вам нужно, чтобы ваш незаконченный сайт появлялся в результатах поиска.

Проблема возникает только тогда, когда вы случайно переносите этот файл на свой рабочий сервер и блокируете поисковые системы от индексации вашего действующего веб-сайта. Обязательно проверьте это, если ваш контент отказывается появляться в результатах поиска.

6. Отсутствие ссылки на карту сайта

Ссылка на карту сайта из файла robots.txt предоставляет сканерам поисковых систем список всего вашего контента. Это увеличивает ваши шансы на то, что они проиндексируют не только текущую страницу, на которую они попали.

Все, что требуется, это одна строка:

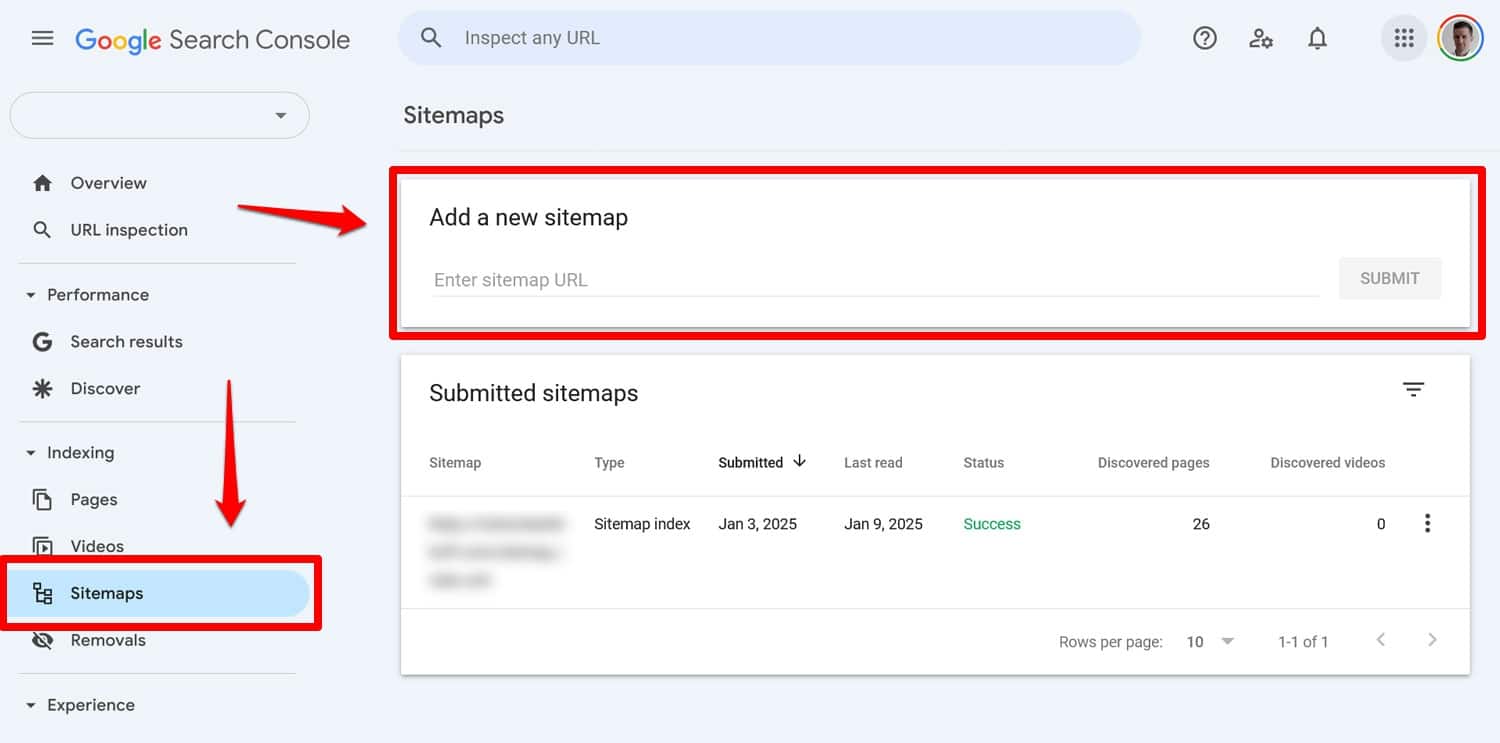

Sitemap: https://yourwebsite.com/sitemap.xmlДа, вы также можете отправить карту сайта непосредственно с помощью таких инструментов, как Google Search Console.

Однако включение его в файл robots.txt по-прежнему полезно, особенно для поисковых систем, чьи инструменты для веб-мастеров вы не используете.

7. Использование противоречивых правил

Одной из распространенных ошибок при создании файла robots.txt является добавление противоречащих друг другу правил, например:

User-agent: * Disallow: /blog/ Allow: /blog/Вышеуказанные директивы оставляют поисковым системам неясность относительно того, следует ли им сканировать каталог /blog/ или нет. Это приводит к непредсказуемым результатам и может повредить вашему SEO.

| Любопытно, что еще может отрицательно сказаться на рейтинге вашего сайта в поисковых системах и как этого избежать? Узнайте об этом в нашем руководстве по ошибкам SEO. |

Чтобы избежать конфликтов, следуйте следующим рекомендациям:

- Сначала используйте конкретные правила . Поместите более конкретные правила перед более широкими.

- Избегайте избыточности . Не включайте противоположные директивы для одного и того же пути.

- Проверьте файл robots.txt . Используйте инструменты, чтобы убедиться, что правила работают должным образом. Подробнее об этом ниже.

8. Попытка скрыть конфиденциальный контент с помощью robots.txt

Как упоминалось ранее, robots.txt не является инструментом для исключения контента из результатов поиска. Фактически, поскольку файл общедоступен, его использование для блокировки конфиденциального контента может непреднамеренно выявить, где именно находится этот контент.

Совет . Используйте метатег noindex , чтобы контент не попадал в результаты поиска. Кроме того, защитите паролем конфиденциальные области вашего сайта, чтобы защитить их как от роботов, так и от неавторизованных пользователей.

9. Неправильное использование подстановочных знаков

Подстановочные знаки позволяют включать в директивы большие группы путей или файлов. Мы уже встречали один из них ранее — символ *. Это означает «каждый экземпляр» и чаще всего используется для установки правил, применимых ко всем пользовательским агентам.

Еще один подстановочный знак — $, который применяет правила к конечной части URL-адреса. Вы можете использовать его, например, если хотите заблокировать сканерам доступ ко всем PDF-файлам на вашем сайте:

Disallow: /*.pdf$Хотя подстановочные знаки полезны, они могут иметь далеко идущие последствия. Используйте их осторожно и всегда проверяйте файл robots.txt, чтобы убедиться, что вы не допустили ошибок.

10. Путаница абсолютных и относительных URL-адресов

Вот разница между абсолютными и относительными URL-адресами:

- Абсолютный URL – https://yourwebsite.com/private/.

- Относительный URL – /частный/

Рекомендуется использовать относительные URL-адреса в директивах robots.txt, например:

Disallow: /private/Абсолютные URL-адреса могут вызвать проблемы, из-за которых боты могут игнорировать или неправильно интерпретировать директиву. Единственным исключением является путь к вашей карте сайта, который должен быть абсолютным URL-адресом.

11. Игнорирование учета регистра

Директивы файла robots.txt чувствительны к регистру. Это означает, что следующие две директивы не являются взаимозаменяемыми:

Disallow: /Private/ Disallow: /private/Если вы обнаружите, что ваш файл robots.txt ведет себя не так, как ожидалось, проверьте, не является ли проблема неправильной регистрацией заглавных букв.

12. Неправильное использование завершающих косых черт

Завершающая косая черта — это косая черта в конце URL-адреса:

- Без косой черты : /directory

- С косой чертой в конце : /directory/

В robots.txt он решает, какие ресурсы сайта разрешены, а какие запрещены. Вот пример:

Disallow: /private/Вышеупомянутое правило блокирует доступ сканеров к «частному» каталогу вашего сайта и всему, что в нем. С другой стороны, предположим, что вы опустили косую черту, например:

Disallow: /privateВ этом случае правило также заблокирует другие экземпляры на вашем сайте, начинающиеся со слова «частный», например:

- https://yourwebsite.com/private.html

- https://yourwebsite.com/privateer

Поэтому важно быть точным. Если у вас есть сомнения, проверьте свой файл.

13. Отсутствует файл robots.txt для поддоменов.

Каждому поддомену вашего веб-сайта (например, dev.yourwebsite.com) необходим собственный файл robots.txt, поскольку поисковые системы рассматривают их как отдельные веб-объекты. Без файла вы рискуете, что сканеры проиндексируют части вашего сайта, которые вы намеревались скрыть.

Например, если ваша разрабатываемая версия находится в папке «dev» и использует субдомен, убедитесь, что у нее есть специальный файл robots.txt для блокировки поисковых роботов.

14. Не тестировать файл robots.txt

Одна из самых больших ошибок при настройке файла robots.txt в WordPress — это неспособность протестировать его, особенно после внесения изменений.

Как мы видели, даже небольшие ошибки в синтаксисе или логике могут вызвать серьезные проблемы с SEO. Поэтому всегда проверяйте файл robots.txt.

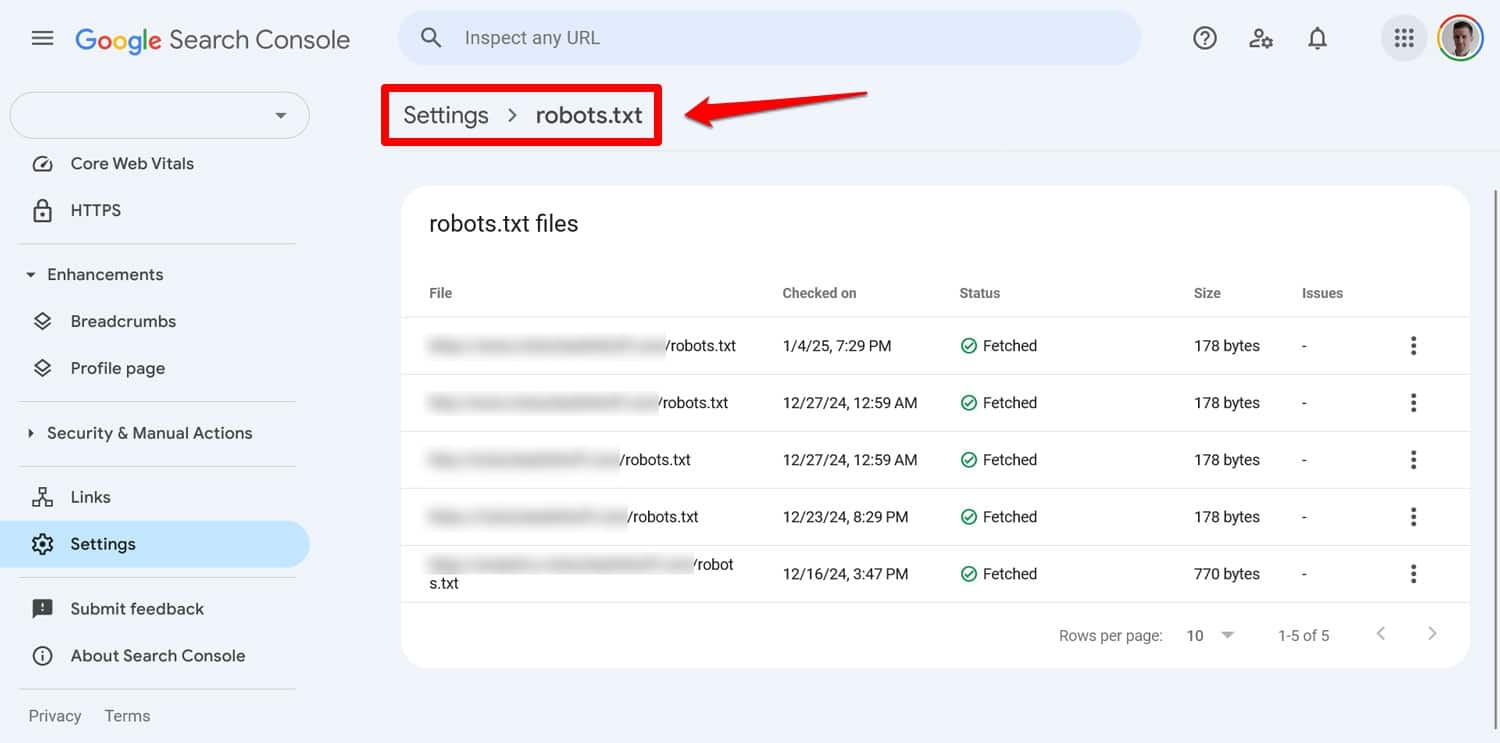

Вы можете увидеть любые проблемы с вашим файлом в консоли поиска Google в разделе «Настройки» > «robots.txt» .

Другой способ — смоделировать поведение ползания с помощью такого инструмента, как Screaming Frog. Кроме того, используйте промежуточную среду, чтобы проверить влияние новых правил, прежде чем применять их к действующему сайту.

Как исправить ошибку robots.txt

Ошибки в файле robots.txt легко допустить, но, к счастью, их обычно легко исправить, как только вы их обнаружите.

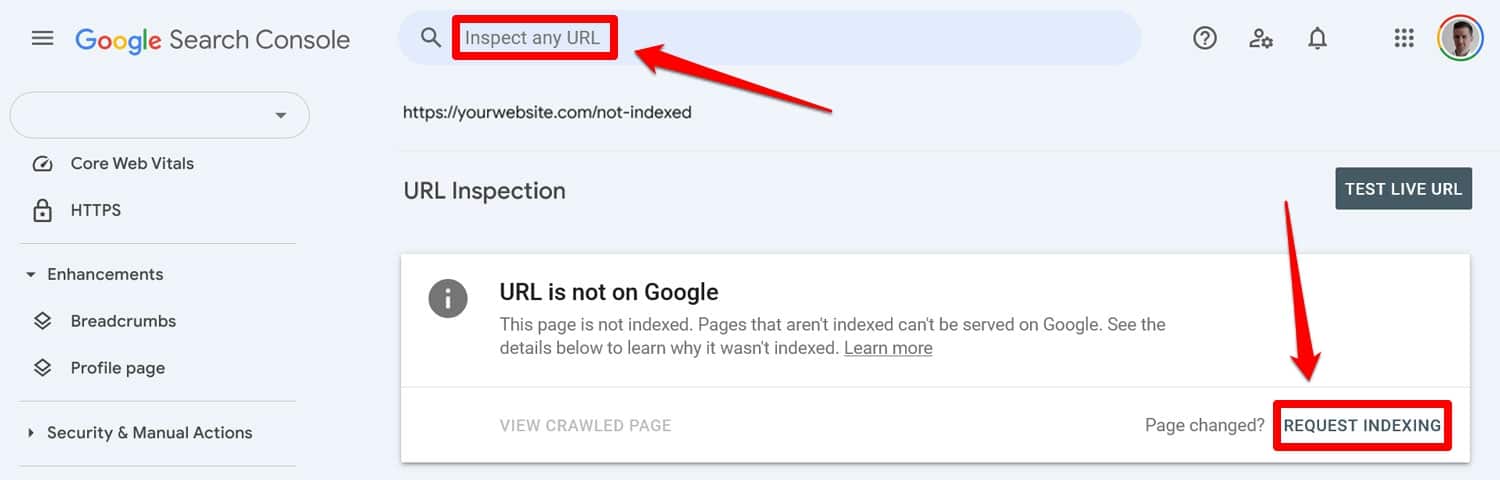

Начните с запуска обновленного файла robots.txt с помощью инструмента тестирования. Затем, если страницы ранее были заблокированы директивами robots.txt, вручную введите их в консоль поиска Google или инструменты Bing для веб-мастеров, чтобы запросить индексацию.

Кроме того, повторно отправьте обновленную версию карты сайта.

После этого это просто игра ожидания. Поисковые системы повторно посещают ваш сайт и, надеюсь, быстро восстановят ваше место в рейтинге.

Возьмите под свой контроль файл robots.txt в WordPress

С файлами robots.txt грамм профилактики лучше, чем фунт лечения. Особенно на крупных веб-сайтах ошибочный файл может нанести ущерб рейтингу, трафику и доходам.

По этой причине любые изменения в файле robots.txt вашего сайта следует вносить осторожно и после тщательного тестирования. Осознание ошибок, которые вы можете совершить, — это первый шаг к их предотвращению.

Если вы все-таки допустили ошибку, постарайтесь не паниковать. Выясните, что не так, исправьте все ошибки и повторно отправьте карту сайта, чтобы ваш сайт был просканирован повторно.

Наконец, убедитесь, что производительность не является причиной того, что поисковые системы неправильно сканируют ваш сайт. Попробуйте WP Rocket прямо сейчас, чтобы мгновенно сделать ваш сайт быстрее!