Как легко оптимизировать WordPress Robots.txt?

Опубликовано: 2023-02-28Введение

Существует множество методов повышения SEO вашего сайта. Оптимизация WordPress Robots.txt — один из лучших методов. Поскольку он позволяет поисковым системам сканировать ваш веб-сайт, файл Robots.txt хорошо известен как мощный инструмент SEO. В результате вы можете свободно улучшать SEO своего сайта, настраивая файл Robots.txt. Мы четко представим некоторые подходы к оптимизации WordPress Robots.txt по этой теме сегодня в этом сообщении блога.

Определение файла Robots.txt

Ниже приведен краткий обзор файла Robots.txt WordPress.

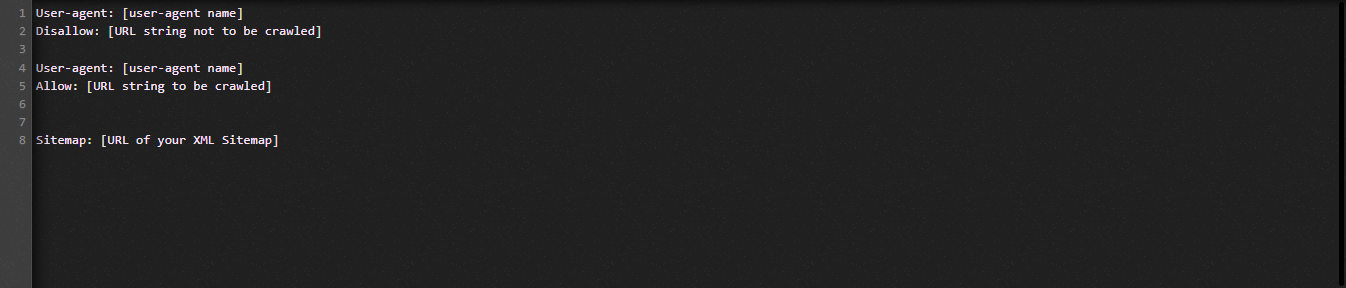

Давайте теперь посмотрим на основную структуру файла Robot.txt:

Давайте определим для вас термины, используемые в файле Robots.txt:

- User-agent: Имя сканера

- Запретить: запрещает сканирование страниц, папок или файлов веб-сайта.

- Разрешить: включение сканирования каталогов, файлов и страниц.

- Карта сайта, если она предоставлена: Показать местоположение карты сайта: представить число или букву.

- *: Подставка для цифры или символа

- $: вы можете использовать его, чтобы ограничить веб-страницы, которые включают определенное расширение, стоя до конца строки.

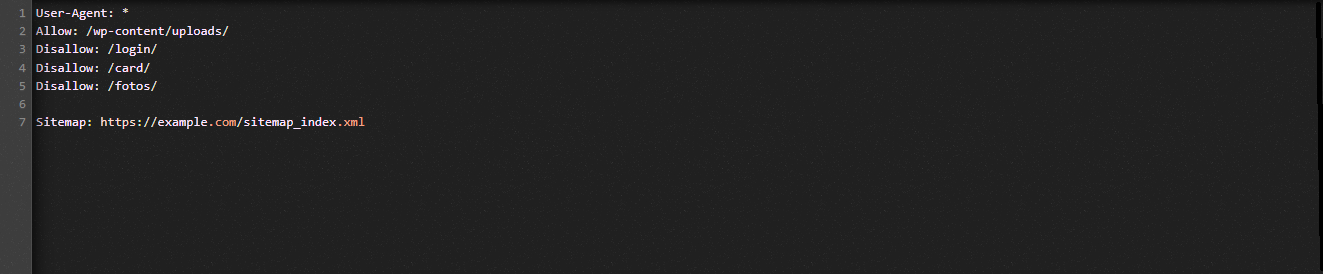

Давайте посмотрим на следующую иллюстрацию, чтобы помочь вам понять:

Мы разрешаем поисковым системам сканировать файлы в папке загрузки WordPress в примере Robot.txt.

Однако мы ограничиваем доступ поисковых систем к логину, карточке и папкам с фотографиями.

Наконец, мы предоставляем ему URL-адрес карты сайта.

Почему для вашего сайта WordPress должен быть создан файл Robots.txt?

Без файла Robots.txt поисковые системы все равно будут сканировать и индексировать каждую страницу веб-сайта. Тем не менее, они будут сканировать все материалы на вашем веб-сайте, а не только указанные вами папки или страницы.

Вы должны создать файл Robots.txt для своего веб-сайта по двум основным причинам. Во-первых, с его помощью вы можете легко управлять всей информацией на своем сайте. Вам решать, должны ли страницы или каталоги сканироваться или индексироваться. Это означает, что такие страницы, как файлы плагинов, административные страницы или каталоги тем, не будут сканироваться поисковыми системами. В результате это поможет увеличить скорость загрузки индекса вашего сайта.

Другим оправданием является требование предотвратить индексацию ненужных сообщений или страниц поисковыми системами. Таким образом, вы можете легко и удобно предотвратить отображение страницы или публикации WordPress в результатах поиска.

Как оптимизировать WordPress Robots.txt более эффективно

В этом учебном блоге мы покажем вам, как создать и улучшить файл Robots.txt на вашем веб-сайте WordPress, используя два разных метода:

- Внесение изменений в файл Robots.txt с помощью плагина: All in One SEO

- Редактирование файла Robots.txt вручную с помощью FTP

Чтобы сделать файл Robots.txt более эффективным, используйте плагин All in One SEO.

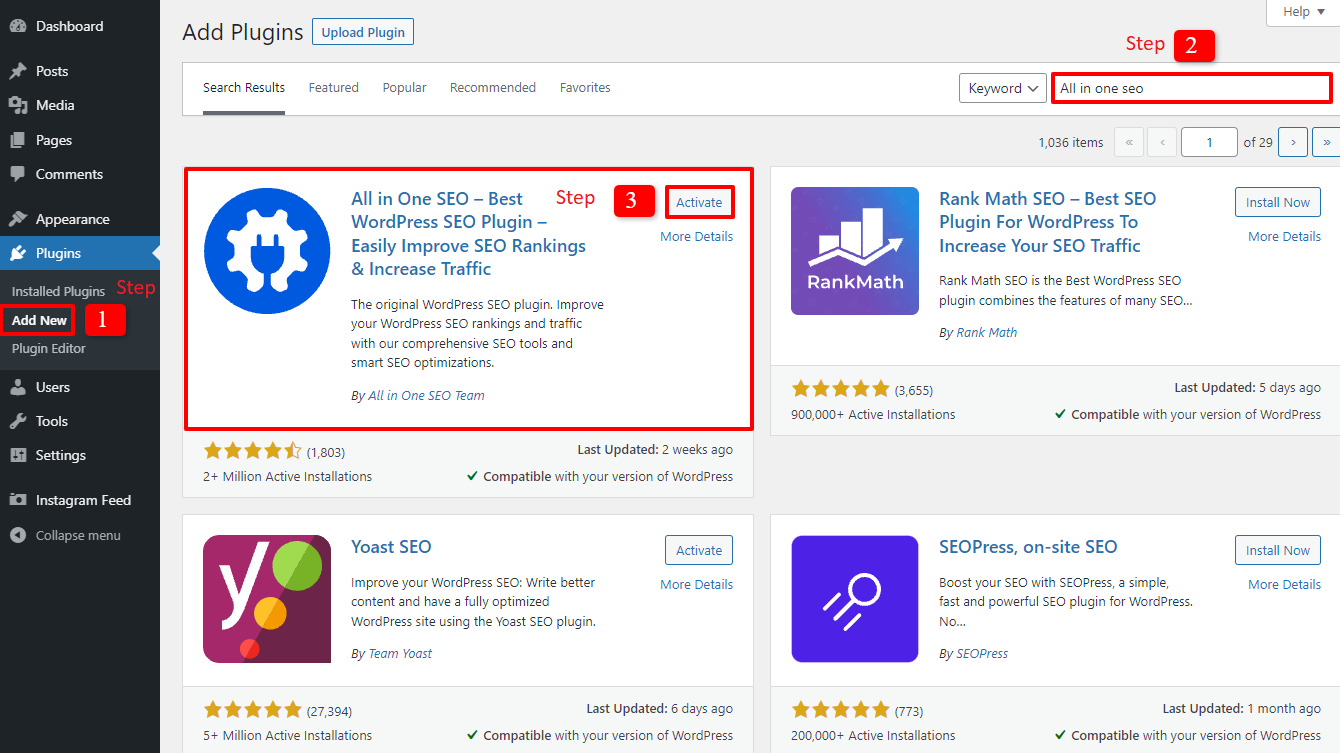

Несколько плагинов WordPress SEO доступны, чтобы помочь вам с этой проблемой на рынке WordPress. Но в этой статье мы решили использовать All in One SEO, популярный плагин с более чем 2 миллионами пользователей, чтобы помочь вам.

Давайте сначала установим его, выбрав «Плагины» -> «Добавить новый» . затем найдите название плагина, установите его, а затем активируйте .

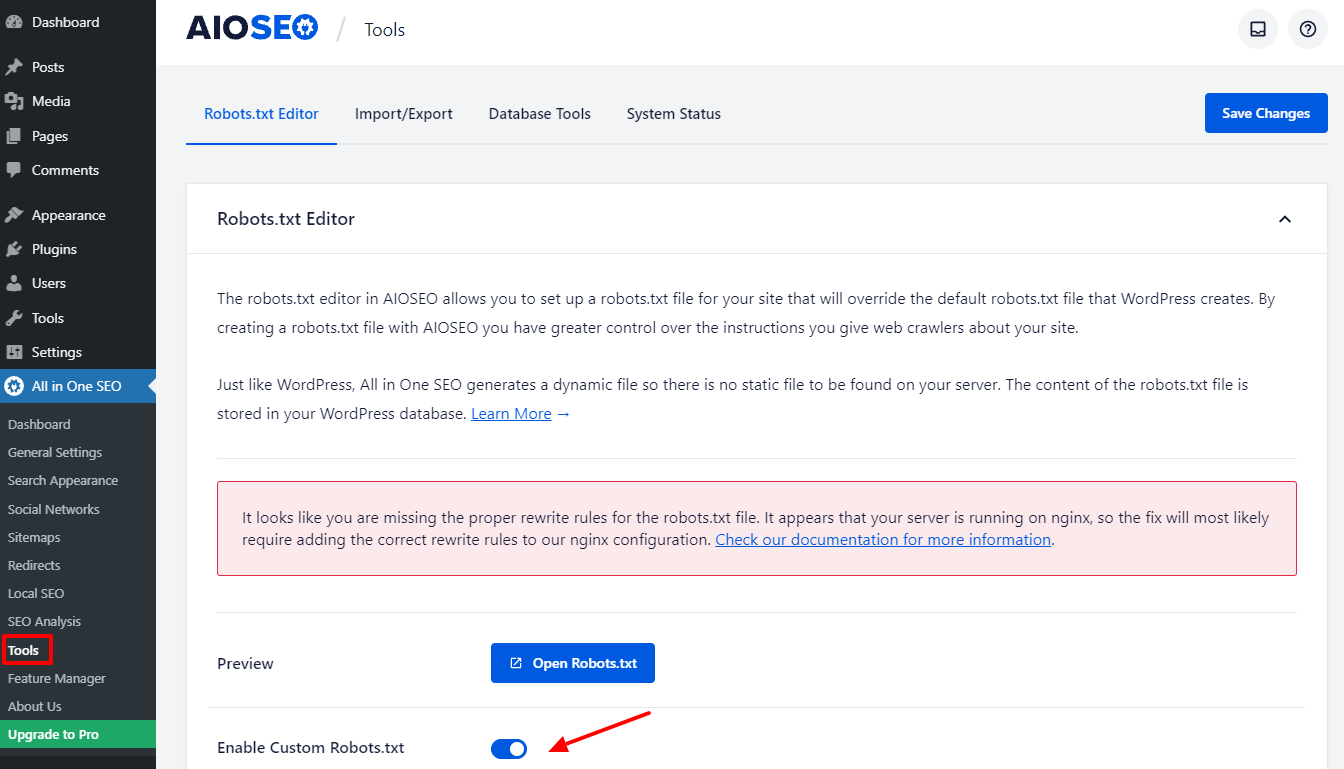

Вы вернетесь в панель администратора после выполнения нескольких простых шагов. Перейдите на Все в одном SEO -> Инструменты прямо сейчас.

Давайте переключим кнопку Enable Custome Robots.txt в разделе редактора Robots.txt, чтобы сделать ее активной. Таким образом, после его включения вы можете редактировать файл Robots.txt по умолчанию в WordPress.

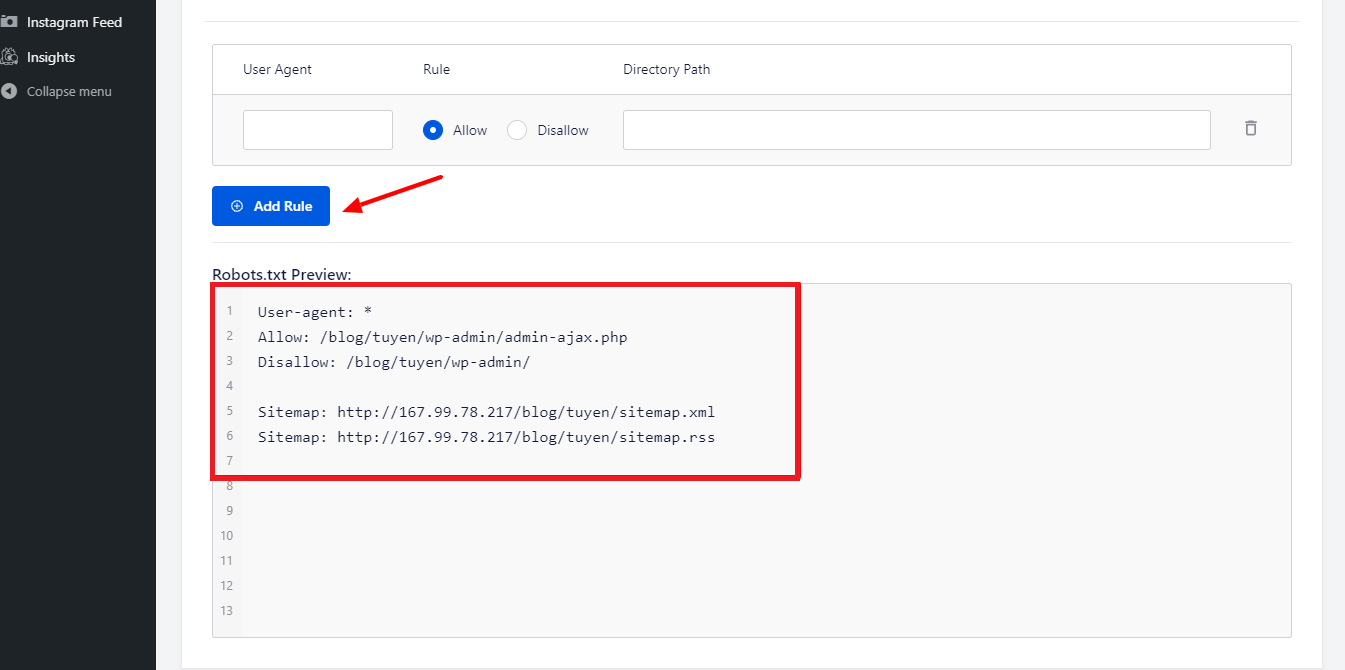

Когда мы прокрутим вниз, вы заметите, что этот плагин отображает окно с предварительным просмотром файла Robots.txt. Это правила WordPress по умолчанию.

Нажав кнопку «Добавить правило» , вы можете добавить больше своих собственных правил, чтобы помочь SEO вашего сайта.

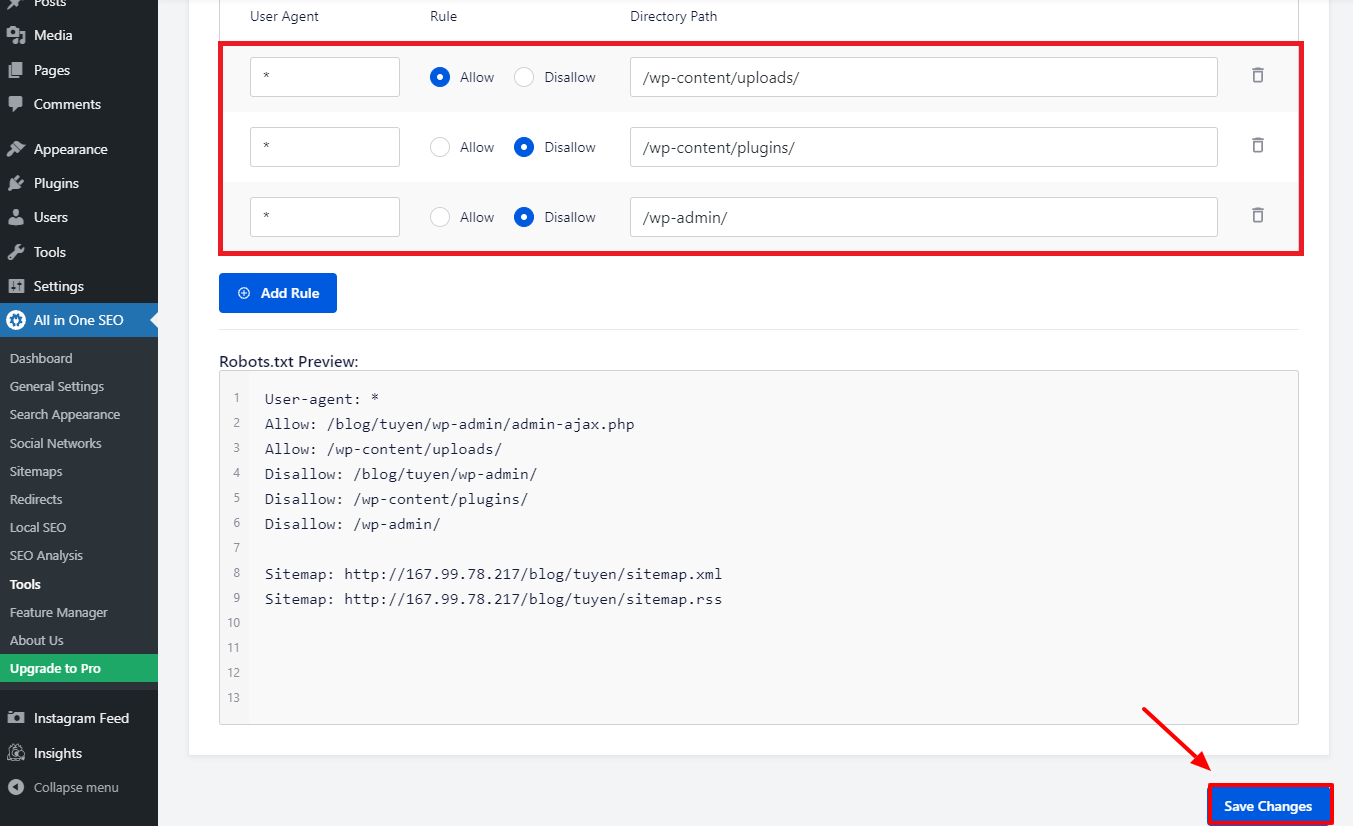

Давайте введем * в поле User-Agent , чтобы применить правило ко всем пользовательским агентам, чтобы добавить новое правило.

Вам нужно только выбрать «Разрешить» или «Запретить» , чтобы поисковые роботы могли сканировать на следующем этапе.

После этого не забудьте ввести имя файла или путь к каталогу в поле «Путь к каталогу» .

Когда вы закончите со всеми вашими предпочтениями, давайте нажмем кнопку Сохранить изменения .

Все дополнительные правила, которые вы уже добавили, будут немедленно применены к файлу Robots.txt.

Вручную измените и оптимизируйте файл WordPress Robots.txt с помощью FTP.

Это другой подход к оптимизации WordPress Robots.txt, который может вам понравиться. Для этого необходимо отредактировать файл Robots.txt с помощью FTP-клиента.

Чтобы удобно использовать клиент FPT, давайте сначала установим соединение с вашей учетной записью хостинга WordPress. Вы можете легко заметить файл Robots.txt в корневой папке вашего сайта при доступе к нему. Давайте выберем View/Edit, щелкнув правой кнопкой мыши.

С другой стороны, у вас, вероятно, ничего нет, если вы не можете это найти. Итак, давайте сначала создадим файл Robots.txt для вашего веб-сайта, выбрав Создать новый файл правой кнопкой мыши.

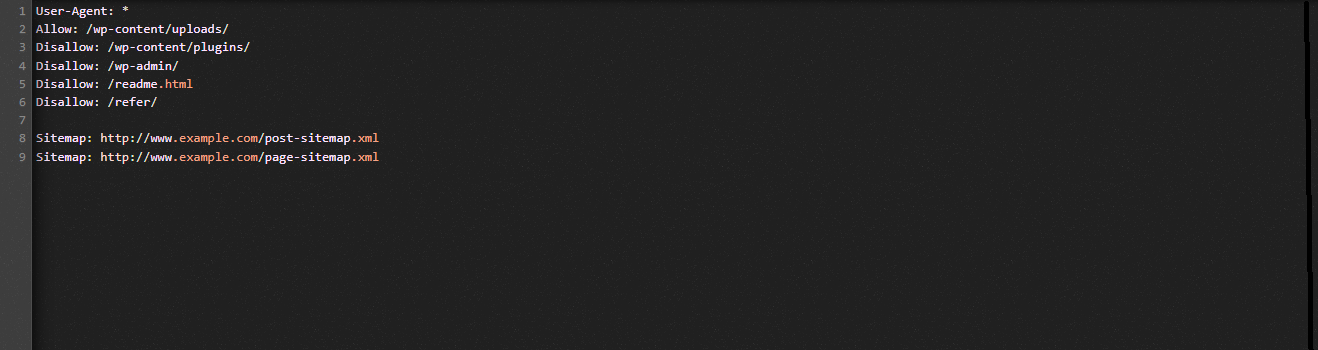

Файл Robots.txt представляет собой обычный текстовый файл, поэтому вы можете загрузить его и редактировать с помощью текстового редактора, например Блокнота или TextEdit. После этого вам просто нужно загрузить его обратно в корневую папку вашего сайта. Кажется легким, не так ли?

Убедитесь, что файл Robots.txt вашего сайта WordPress работает.

Ваш файл Robots.txt необходимо протестировать после того, как вы уже подготовили и настроили его, чтобы можно было выявить любые проблемы и сообщить о них. В результате вы должны протестировать его с помощью инструмента для тестирования Robots.txt. Попробуйте Google Search Console, мы настоятельно рекомендуем ее.

Вы должны убедиться, что ваш сайт связан с Google Search Console, если вы хотите использовать эту услугу. Затем вы можете использовать инструмент тестирования роботов, выбрав свойство из списка выбора. Теперь файл Robots.txt для вашего веб-сайта будет добавлен автоматически. Он предупредит вас, если есть ошибка.

Заключение

В целом, основная цель оптимизации файла Robots.txt — запретить поисковым роботам доступ к страницам, которые не требуются для широкой публики, включая папки плагинов или папки администратора. В результате блокировка тегов, категорий или архивных страниц WordPress не поможет вашему SEO. Другими словами, чтобы создать идеальный файл Robots.txt для вашего сайта WordPress, вы должны придерживаться приведенного ниже шаблона.

Мы надеемся, что сегодняшний пост в блоге поможет вам оптимизировать WordPress Robots.txt. Не забудьте передать его своим знакомым и другим веб-мастерам. Кроме того, пожалуйста, оставьте комментарий ниже, если у вас есть какие-либо вопросы. Таким образом, мы ответим вам, как только сможем. Пришло время оптимизировать WordPress Robots.txt. До будущих блогов берегите себя.

Кстати, у нас есть множество современных, привлекательных и бесплатных тем WordPress , которые полностью поддерживают эту полезную функцию. Давайте встретимся с ними и попросим одного из них изменить дизайн вашего сайта.