Как оптимизировать ваш WordPress Robots.txt для SEO

Опубликовано: 2022-08-23В этом блоге мы узнаем несколько советов о том, как улучшить SEO вашего сайта, оптимизировав файл robts.txt.

На самом деле файл Robots.txt играет важную роль с точки зрения SEO, потому что он сообщает поисковым системам, как можно сканировать ваш сайт. Именно по этой причине файлы Robot.txt считаются одним из самых мощных инструментов SEO.

Позже вы также узнаете, как создавать и оптимизировать WordPress Robots.txt для SEO.

Что вы подразумеваете под файлом robots.txt?

Текстовый файл, созданный владельцами веб-сайтов, чтобы сообщить роботам поисковых систем, как они могут сканировать свой веб-сайт и индексировать страницы, известен как Robots.txt.

Собственно, в корневом каталоге и хранится этот файл. Этот каталог также называется основной папкой вашего сайта. Ниже указан формат файла robots.txt.

Агент пользователя: [имя агента пользователя] Запретить: [строка URL не должна сканироваться] Агент пользователя: [имя агента пользователя] Разрешить: [строка URL для сканирования] Карта сайта: [URL вашего файла Sitemap в формате XML]

Чтобы разрешить или запретить определенные URL-адреса, у вас могут быть разные строки инструкций. Кроме того, вы также можете добавлять различные карты сайта. Боты поисковых систем будут считать, что им разрешено сканировать страницы, если разрешен URL-адрес.

Пример файла robots.txt приведен ниже.

Пользовательский агент: * Разрешить: /wp-content/uploads/ Запретить: /wp-content/plugins/ Запретить: /wp-admin/ Карта сайта: https://example.com/sitemap_index.xml

В приведенном выше примере мы разрешили сканировать страницы поисковыми системами и получать индексные файлы в папке загрузок WordPress.

После этого мы запретили поисковым ботам сканировать и индексировать административные папки и плагины WordPress.

Наконец, мы упомянули URL-адрес карты сайта XML.

Требуется ли для вашего веб-сайта WordPress файл Robots.txt?

Поисковая система начнет сканировать и индексировать ваши страницы, даже если у вас нет текстового файла, т.е. Robots.txt. Но, к сожалению, вы не можете сообщить своей поисковой системе, какую именно папку или страницу она должна сканировать.

Это не принесет пользы или не окажет никакого влияния, если вы только что создали веб-сайт или блог с меньшим содержанием.

Однако, как только вы настроите свой веб-сайт с большим количеством контента и когда он начнет расти, вам потребуется контроль над просканированными и проиндексированными страницами вашего веб-сайта.

Первая причина указана ниже

Для каждого веб-сайта поисковые роботы имеют свою квоту сканирования.

Это явно означает, что во время сеанса обхода будет просканировано определенное количество страниц. Предположим, что сканирование на вашем веб-сайте осталось незавершенным, тогда оно вернется еще раз и возобновит сканирование в другом сеансе.

Из-за этого скорость индексации вашего веб-сайта будет резкой.

Вы можете решить эту проблему, запретив поисковым роботам сканировать такие страницы, которые не нужны. Некоторые неважные страницы могут включать в себя файлы плагинов, страницы администрирования WordPress и папки тем.

Квоту сканирования можно сохранить, запретив сканирование нежелательных страниц. Этот шаг будет более полезным, поскольку поисковые системы теперь будут сканировать страницы веб-сайта и смогут проиндексировать их как можно скорее.

Еще одна причина, по которой вам следует использовать и оптимизировать файл WordPress Robots.txt, приведена ниже.

Всякий раз, когда вам нужно запретить поисковым системам индексировать страницы или сообщения на вашем сайте, вы можете использовать этот файл.

На самом деле, это один из самых неправильных способов скрыть содержимое вашего веб-сайта от широкой публики, но он окажется лучшей поддержкой для защиты их от появления в результатах поиска.

Как появляется файл robots.txt?

Очень простой файл robots.txt используется большинством популярных блогов. Содержание может отличаться от требований конкретного веб-сайта.

Пользовательский агент: * Запретить: Карта сайта: http://www.example.com/post-sitemap.xml Карта сайта: http://www.example.com/page-sitemap.xml Файл robots.txt разрешает всем ботам индексировать любой контент и предлагать ссылки на веб-сайт карты сайта в формате XML. В файлах robots.txt упоминаются следующие правила, которым необходимо следовать. Пользовательский агент: * Разрешить: /wp-content/uploads/ Запретить: /wp-content/plugins/ Запретить: /wp-admin/ Запретить: /readme.html Запретить: /см./ Карта сайта: http://www.example.com/post-sitemap.xml Карта сайта: http://www.example.com/page-sitemap.xml

Это укажет боту на индексацию всех файлов и изображений WordPress. Это не позволит поисковым ботам индексировать область администрирования WordPress, файлы плагинов WordPress, партнерские ссылки и файл readme WordPress.

В файлы robots.txt можно добавить карты сайта, которые помогут роботам Google распознавать все страницы вашего сайта.

Теперь вы знаете, как выглядит файл robots.txt, теперь мы узнаем, как можно создать файл robots.txt в WordPress.

Как создать файл robots.txt в WordPress?

Существует множество способов создать файл robots.txt в WordPress. Некоторые из лучших методов перечислены ниже, вы можете выбрать любой из них, который лучше всего подходит для вас.

Способ 1: Использование All-in-One SEO, изменение файла Robots.txt

All in One SEO — самый известный плагин WordPress для SEO на рынке, который используется более чем на 1 миллионе веб-сайтов.

Плагин All in One SEO очень прост в использовании и поэтому предлагает генератор файлов robotx.txt. Также полезно оптимизировать WordPress Robots.txt.

Если вы еще не интегрировали этот SEO-плагин, сначала установите и активируйте его с панели управления WordPress. Бесплатная версия также доступна для начинающих пользователей, чтобы они могли использовать ее функции, не вкладывая денег.

После активации плагина вы можете начать использовать его для создания или изменения файла robots.txt непосредственно из области администрирования WordPress.

Чтобы использовать это

- Перейти на все в одном SEO

- Теперь, чтобы отредактировать файл robots.txt, нажмите на инструменты

- Теперь, нажав «включить пользовательский файл robots.txt», вы включите опцию редактирования.

- В WordPress вы также можете создать собственный файл robots.txt с помощью этого переключателя.

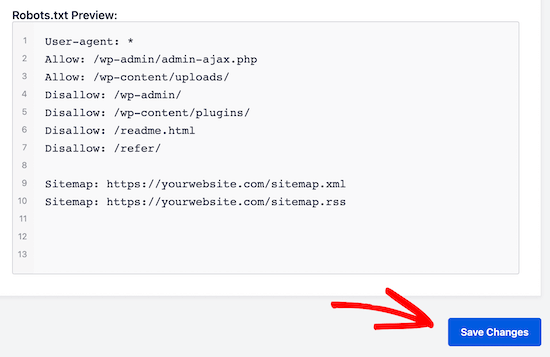

- Теперь ваш существующий файл robots.txt будет отображаться плагином All in One SEO в разделе «предварительный просмотр robots.txt». Это можно просмотреть в нижней части веб-экрана.

В WordPress правило по умолчанию, которое было добавлено, будет отображаться в этой версии.

Правила по умолчанию, которые получаются, предлагают вашей поисковой системе, что им не нужно сканировать основные файлы WordPress, предлагают ссылку на веб-сайт XML-карты сайта и разрешают ботам индексировать весь его контент.

Чтобы улучшить файл robots.txt для SEO, можно добавить новые собственные правила.

Добавьте пользовательский агент в поле «Пользовательский агент», чтобы добавить правило. Правило будет применяться ко всем пользовательским агентам с помощью файла *.

Теперь выберите, хотите ли вы разрешить или запретить поисковой системе сканировать страницы.

Теперь добавьте путь к каталогу, имя файла в поле «Путь к каталогу».

К вашему файлу robots.txt правило будет применено автоматически. Нажмите кнопку «Добавить правило», чтобы добавить новое правило.

Если вы не создали идеальный формат robotx.txt, мы предлагаем вам добавить новые правила.

Пользовательские правила, добавленные вами, будут выглядеть так:

Чтобы сохранить изменения, не упустите возможность нажать «сохранить изменения».

Способ 2: изменить файл Robots.txt вручную с помощью FTP

Другой метод оптимизации WordPress Robots.txt — использовать функции FTP-клиентов, чтобы начать изменять файл robots.txt.

Вам просто нужно подключиться к вашей учетной записи хостинга WordPress с помощью FTP-клиента.

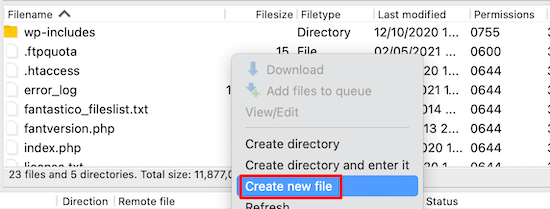

После входа в корневую папку сайта вы сможете просмотреть файл robots.txt.

Если вы не можете его найти, значит, у вас нет файла robots.txt.

В такой ситуации необходимо создать файл robot.txt.

Как упоминалось ранее, файл robots.txt обычно представляет собой простой текстовый файл, который можно загрузить на свой компьютер. Однако вы даже можете изменить его с помощью простого текстового редактора, такого как TextEdit, Блокнот или WordPad.

После того, как вы выполнили все изменения, пришло время сохранить его. Вы можете загрузить этот файл в корневую папку вашего сайта.

Как вы можете выполнить тестирование файла Robots.txt?

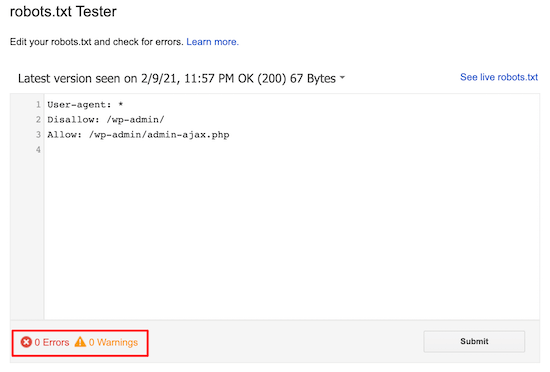

Вы можете выполнить тестирование с помощью инструмента для тестирования robots.txt.

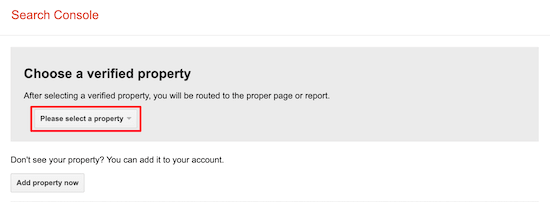

В Интернете вы найдете множество инструментов для тестирования robots.txt. Одним из лучших является Google Search Console.

Для работы с этим инструментом вам сначала нужно иметь веб-сайт, который подключен к консоли поиска Google. После этого вы можете начать использовать его функции.

Из выпадающего списка вам просто нужно выбрать свой объект.

Однако он автоматически выберет файл robots.txt вашего веб-сайта и выделит все предупреждения и ошибки. Это один из лучших инструментов, который поможет вам очень легко оптимизировать файл WordPress Robots.txt.

Вывод:

Основной девиз оптимизации этого файла robots.txt — защитить страницы от сканирования страниц. Например, страницы в папке администратора WordPress или страницы в папке wp-plugin.

Самый распространенный миф заключается в том, что вы можете улучшить скорость сканирования, ускорить его индексацию и получить более высокий рейтинг, заблокировав категорию WordPress, страницы достижения и теги.

Но это не сработает, так как в соответствии с рекомендациями Google для веб-мастеров что-то пойдет не так.

Мы настоятельно рекомендуем вам прочитать и учесть все пункты, упомянутые выше.

Мы надеемся, что этот блог поможет вам создать файл robots.txt, используя правильный формат для вашего веб-сайта. И это поможет вам оптимизировать WordPress Robots.txt.