Как оптимизировать WordPress Robots.txt для SEO с помощью Yoast SEO

Опубликовано: 2023-10-25Поисковая оптимизация (SEO) является важной частью создания эффективного веб-сайта, и одним из наиболее важных факторов достижения успеха в SEO является использование правильных инструментов для оптимизации вашего сайта. Одним из таких инструментов является файл Robots.txt, который контролирует, как сканеры поисковых систем получают доступ к вашему контенту и индексируют его.

Оптимизация файла WordPress Robots.txt может помочь вам повысить рейтинг в поисковых системах, улучшить видимость вашего веб-сайта и увеличить трафик.

Однако, несмотря на его важность, многие владельцы веб-сайтов не знают, как правильно настроить файл Robots.txt. В этом сообщении блога мы расскажем вам все, что вам нужно знать, чтобы освоить WordPress Robots.txt для SEO и раскрыть весь потенциал SEO для вашего веб-сайта.

Понимание роли robots.txt в SEO

Понимание функции файла robots.txt в поисковой оптимизации необходимо для получения максимальной отдачи от оптимизации веб-сайта WordPress и получения наилучших возможных результатов. Текстовый файл Robots.txt, который также может называться протоколом исключения роботов, дает сканерам поисковых систем инструкции, какие области вашего веб-сайта им следует сканировать и индексировать.

Когда боты поисковых систем посещают ваш сайт, первое, что они делают, — это проверяют в корневом каталоге файл robots.txt. Этот файл служит руководством для ботов, сообщая им о сайтах и файлах, которые им разрешено посещать, а также о тех, которые им запрещены.

Вы имеете полный контроль над материалом, который отображается поисковым системам, и над тем, что от них скрыто, если вы правильно настроите файл robots.txt.

Эффективность сканирования вашего веб-сайта в первую очередь следует повысить с помощью файла robots.txt. Это помогает ботам поисковых систем сконцентрироваться на сканировании и индексировании наиболее важных частей вашего веб-сайта, избегая траты ресурсов на второстепенные сайты или конфиденциальные материалы, которые не должны быть доступны широкой публике.

Что такое файл robots.txt?

Простой текстовый файл, известный как Robots.txt, направляет сканеров, используемых поисковыми системами, на определенные веб-страницы вашего сайта. Кроме того, он предписывает роботам не сканировать определенные сайты.

Очень важно, чтобы вы поняли работу поисковой системы, прежде чем мы приступим к углубленному анализу этой статьи.

Сканирование, индексирование и ранжирование — три основных действия, выполняемые поисковыми системами.

Первое, что делают поисковые системы, — это отправляют своих веб-сканеров, также известных как пауки или боты, по всей Всемирной паутине. Эти программы, известные как боты, представляют собой интеллектуальные программы, которые сканируют всю сеть в поисках новых связей, страниц и веб-сайтов. Сканирование — это термин, обозначающий процесс поиска контента в Интернете.

Страницы вашего веб-сайта будут организованы в структуру данных, которую можно будет использовать после того, как их обнаружат боты. Индексация — это имя, данное этой процедуре.

И, в конце концов, все сводится к рейтингу. Когда пользователь вводит поисковый запрос, поисковая система должна предлагать пользователю лучшую и наиболее релевантную информацию, которую она может найти, в зависимости от того, что ищет пользователь.

Как выглядит файл Robots.txt?

Файл robots.txt является жизненно важным компонентом структуры и функциональности веб-сайта, но задумывались ли вы когда-нибудь, как он на самом деле выглядит?

Файл применим ко всем роботам поисковых систем, посещающим веб-сайт, на что указывает звездочка после User-agent. Каждая поисковая система использует свой пользовательский агент для изучения Интернета.

Например, Google использует Googlebot для индексации содержимого вашего веб-сайта для поиска Google. Эти пользовательские агенты исчисляются сотнями. Пользовательские инструкции могут быть настроены для каждого пользовательского агента. Например, первая строка вашего файла robots.txt должна быть такой: «Если вы хотите задать конкретные инструкции для робота Googlebot, он будет называться User-agent: Googlebot.

Что такое бюджет сканирования?

Бюджет сканирования — это количество страниц, которые поисковая система готова просканировать на веб-сайте в течение определенного периода времени. Это определяется различными факторами, такими как авторитет веб-сайта, популярность и способность сервера обрабатывать запросы на сканирование. Кроме того, вы должны убедиться, что краулинговый бюджет вашего сайта используется максимально эффективно.

Ваши наиболее важные страницы обязательно должны быть просканированы ботом в первую очередь, если на вашем сайте несколько страниц. Поэтому крайне важно указать это в файле robots.txt.

Как найти и отредактировать файл robots.txt в WordPress?

Поиск и редактирование файла robots.txt в WordPress — важный шаг в оптимизации вашего сайта для поисковых систем. Правильно настроив этот файл, вы можете контролировать, какие части вашего сайта доступны для сканеров поисковых систем, гарантируя, что они сосредоточатся на наиболее важных страницах и контенте.

Чтобы найти и отредактировать файл robots.txt в WordPress, выполните следующие простые шаги:

1. Войдите в свою панель управления WordPress.

2. Перейдите на вкладку «Настройки» в меню слева.

3. Нажмите «Чтение», чтобы получить доступ к настройкам чтения.

4. Прокрутите вниз, пока не найдете раздел «Видимость для поисковых систем».

5. Здесь вы увидите опцию «Запретить поисковым системам индексировать этот сайт». Убедитесь, что этот параметр снят, так как при этом будет создан базовый файл robots.txt, ограничивающий доступ поисковых систем ко всему вашему сайту.

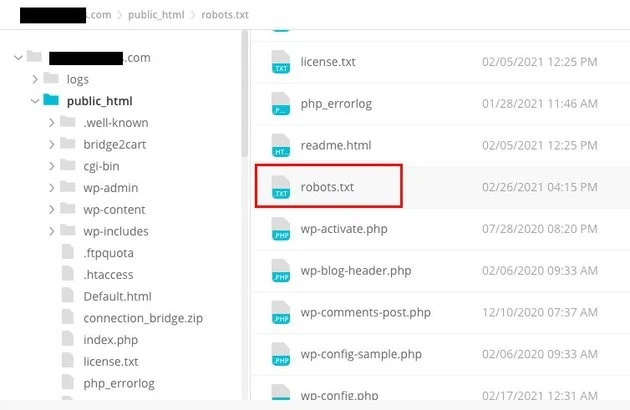

6. Если вы хотите дополнительно настроить файл robots.txt, вы можете сделать это, открыв корневой каталог вашего веб-сайта. Обычно это можно сделать через FTP-клиент или файловый менеджер cPanel.

7. Найдя корневой каталог, найдите файл с именем «robots.txt».

8. Загрузите копию существующего файла robots.txt на свой компьютер в качестве резервной копии на случай, если при редактировании возникнут какие-либо проблемы.

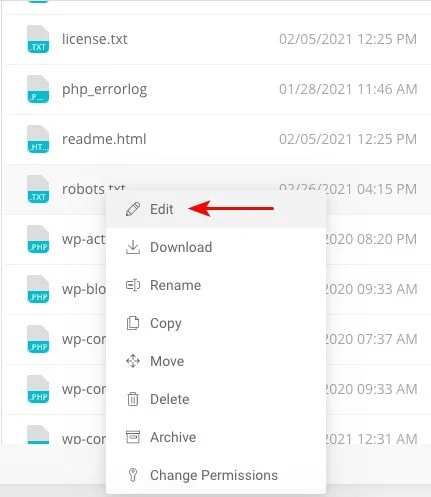

9. Откройте файл robots.txt с помощью текстового редактора.

10. Настройте файл в соответствии со своими потребностями. Вы можете добавить специальные директивы, разрешающие или запрещающие доступ к определенным областям вашего сайта. Например, вы можете запретить поисковым системам сканировать вашу административную область, добавив следующую строку:

1. Запретить: /wp-admin/

11. Сохраните изменения в файле robots.txt и загрузите его обратно в корневой каталог вашего сайта, заменив предыдущую версию.

12. Наконец, проверьте файл robots.txt с помощью инструмента тестирования robots.txt от Google или других подобных инструментов, чтобы убедиться, что он настроен правильно.

Контролировать взаимодействие сканеров поисковых систем с вашим веб-сайтом можно в WordPress, определив и изменив файл robots.txt в нужном месте. Это позволит вам получить наилучшие результаты с точки зрения видимости и рейтинга вашего сайта. Если вы потратите время на то, чтобы узнать и стать экспертом в этом аспекте поисковой оптимизации (SEO), вы будете на верном пути к успеху своего сайта WordPress.

Как создать файл Robots.txt в WordPress?

Давайте продолжим и создадим WordPress Robots.txt для SEO теперь, когда мы обсудили, что такое файл robots.txt и почему он так важен. WordPress предоставляет вам два различных варианта создания файла robots.txt. Первый метод предполагает использование плагина WordPress, а второй предполагает загрузку файла вручную в корневую папку вашего сайта.

Шаг 1. Используйте плагин Yoast SEO для создания файла Robots.txt.

Вы можете использовать плагины SEO, которые помогут вам оптимизировать ваш веб-сайт, созданный на WordPress. Большинство этих плагинов имеют собственный генератор файлов robots.txt внутри установочного пакета.

Сначала скачайте и установите плагин.

Перейдите в меню «Плагины» и нажмите «Добавить новый». Следующий шаг — найти плагин Yoast SEO, загрузить его и включить, если у вас его еще нет.

Создайте файл robots.txt в качестве второго шага.

Создайте текстовый файл роботов с помощью Yoast.

Вы заметите файл, созданный с использованием некоторых директив по умолчанию.

Генератор файла robots.txt для Yoast SEO автоматически включает следующие директивы:

Пользовательский агент: * Запретить: /wp-admin/ Разрешить: /wp-admin/admin-ajax.php

Добавьте дополнительные инструкции в robots.txt. После редактирования файла robots.txt нажмите «Сохранить».

Введите свое доменное имя и файл «/robots.txt». Ваш файл robots.txt завершен, если браузер отображает директивы по умолчанию, как показано ниже.

сгенерированный текстовый файл роботов

Мы также рекомендуем вам добавить URL-адрес карты сайта в файл robots.txt.

TXT-файл роботов по умолчанию

После включения плагина перейдите в Yoast SEO > Инструменты и выберите «Редактор файлов» в раскрывающемся меню. Продолжайте указывать свое доменное имя, а затем добавьте «/robots.txt». Если вы посмотрите в браузере, вы заметите некоторые директивы по умолчанию.

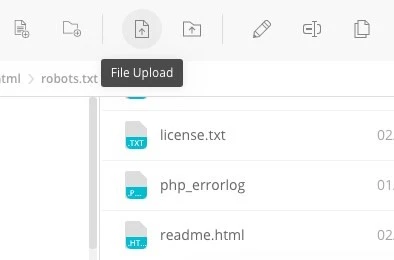

Шаг 2. Использование FTP для создания файла Robots.txt вручную

- Следующим шагом в этом процессе является создание файла robots.txt на локальном компьютере и его последующая загрузка в корневую папку вашего веб-сайта WordPress.

- В дополнение к этому вам понадобится доступ к вашему хостингу WordPress с помощью FTP-программы, такой как Filezilla. Если у вас еще нет учетных данных, необходимых для входа в систему, они будут доступны вам через панель управления вашей службой хостинга. Следовательно, вы можете проверить, присутствует ли файл robots.txt в корневой папке вашего веб-сайта после входа в систему с помощью FTP-программы.

- Щелкните файл правой кнопкой мыши и выберите «Редактировать», если он существует.

Таким образом, после успешного входа в систему с помощью FTP-клиента вы сможете проверить, находится ли файл robots.txt в корневой папке вашего веб-сайта. Ввод имени вашего домена и затем «/robots.txt» — лучший способ определить, был ли ваш файл успешно загружен.

После внесения изменений нажмите «Сохранить».

Вам придется создать файл, если он еще не существует. Один из них можно сделать, добавив директивы в файл с помощью простого текстового редактора, такого как Блокнот. Такой как

Пользовательский агент: * Запретить: /wp-admin/ Разрешить: /wp-admin/admin-ajax.php

Нажмите «Загрузить файл» в своем FTP-клиенте, чтобы загрузить файл в корневую папку веб-сайта.

Введите свое доменное имя и «/robots.txt», чтобы увидеть, был ли ваш файл успешно загружен.

Это метод ручной загрузки файла robots.txt на ваш сайт WordPress!

Robots.txt: знает свои преимущества и недостатки.

Преимущества использования файла robots.txt

Он дает поисковой системе указание не тратить время на сайты, которые вы не хотите индексировать, что помогает оптимизировать бюджеты сканирования поисковой системы. Поступая так, вы увеличиваете вероятность того, что поисковые системы будут сканировать наиболее важные для вас сайты.

Блокировка ботов, которые таким образом приводят к пустой трате ресурсов вашего веб-сервера, способствует оптимизации сервера.

Это полезно для сокрытия страниц благодарности, целевых страниц, страниц входа в систему и других страниц, которые не нуждаются в индексации поисковыми системами.

Отрицательные стороны файла robots.txt

Теперь вы сможете просмотреть файл robots.txt на любом веб-сайте, используя информацию, представленную здесь. Это не так уж сложно понять. Просто введите имя домена, затем «/robots.txt» и нажмите Enter.

Однако в некоторой степени с этим связана и опасность. Существует вероятность того, что файл WordPress Robots.txt для SEO содержит URL-адреса некоторых внутренних страниц вашего веб-сайта, которые вы не хотите индексировать поисковыми системами.

Например, может существовать страница для входа в систему, которую вы по какой-либо причине не хотите индексировать. Однако тот факт, что он упоминается в файле robots.txt, позволяет злоумышленникам увидеть сайт. Если вы пытаетесь скрыть определенную конфиденциальную информацию, применяется то же самое.

Даже если вы допустите одну опечатку при написании файла robots.txt, это сведет на нет все ваши усилия по поисковой оптимизации (SEO). Это верно, даже если файл легко создать.

Куда поместить файл robots.txt

Предположим, что на данный момент вы знаете место, куда необходимо вставить файл robots.txt.

Файл robots.txt вашего веб-сайта всегда должен находиться в корневом каталоге веб-сайта. URL-адрес файла robots.txt на вашем веб-сайте будет https://yourdomain.com/robots.txt, если ваше доменное имя — yourdomain.com.

Помимо размещения файла robots.txt в корневом каталоге вашего веб-сайта, следует соблюдать некоторые другие рекомендации:

- Очень важно дать вашему файлу имя robots.txt.

- Важно писать имя с большой буквы. Поэтому вам нужно получить его правильно, иначе он не будет работать.

- Каждую инструкцию необходимо размещать на отдельной строке.

- Когда URL-адрес завершен, его следует пометить знаком «$».

- Следует использовать только один экземпляр каждого пользовательского агента.

- Чтобы предоставить людям объяснение содержимого вашего файла robots.txt, используйте комментарии, начиная каждую строку с решетки (#).

Тестирование и проверка файла robots.txt

Тестирование и проверка файла robots.txt — это важный шаг в обеспечении правильного сканирования и индексации вашего веб-сайта поисковыми системами. Хорошо оптимизированный файл robots.txt может предотвратить доступ поисковых систем к конфиденциальным или нерелевантным страницам, повысить эффективность сканирования и, в конечном итоге, повысить общую производительность вашего веб-сайта.

Чтобы начать тестирование файла robots.txt, вы можете использовать различные онлайн-инструменты, специально предназначенные для этой цели. Эти инструменты позволяют вам вводить директивы robots.txt и моделировать, как поисковые системы интерпретируют их и следуют им.

Анализируя результаты, вы можете выявить любые потенциальные проблемы или неправильные конфигурации в вашем файле. Регулярный мониторинг и обновление файла robots.txt имеет решающее значение, особенно при внесении изменений в структуру или содержимое вашего веб-сайта.

Сохраняя бдительность, вы сможете быстро обнаружить и устранить любые проблемы, которые могут возникнуть. Такой тщательный подход в конечном итоге будет способствовать заметности, индексации и общему успеху вашего веб-сайта в цифровой среде.

Мы предлагаем здесь инструмент Google Search Console.

Вы можете добавить свой веб-сайт в консоль поиска Google, перейдя по ссылке «Добавить ресурс сейчас» и следуя простым инструкциям на экране. После того, как вы закончите, в раскрывающемся меню с надписью «Пожалуйста, выберите недвижимость» ваш веб-сайт будет включен в число вариантов.

После выбора веб-сайта инструмент автоматически получит файл robots.txt, связанный с вашим веб-сайтом, и выделит все ошибки или предупреждения, если таковые имеются.

Необходим ли файл Robots.txt для вашего веб-сайта WordPress?

Действительно, вашему веб-сайту WordPress необходим файл robots.txt. Даже если на вашем веб-сайте нет файла robots.txt, поисковые системы все равно будут сканировать и индексировать его. Теперь, когда мы обсудили цель, работу и бюджет сканирования robots.txt, почему вы хотите опустить один из них?

Поисковые системы обучаются тому, что сканировать, а что не сканировать, с помощью файла robots.txt.

Принятие во внимание негативных последствий краулингового бюджета является одной из основных причин добавления файла robots.txt.

Как уже говорилось ранее, у каждого веб-сайта есть краулинговый бюджет. Все зависит от того, сколько сайтов посещает бот за один сеанс. Бот вернется и продолжит сканирование в следующем сеансе, если он не завершит все страницы вашего веб-сайта за этот сеанс.

Кроме того, это снижает скорость индексации вашего сайта.

Вы можете сэкономить свою квоту сканирования, быстро исправив эту проблему, запретив поисковым ботам сканировать медиаресурсы, каталоги тем, плагины и посторонние сайты.

Заключительные слова

При работе над вашим веб-сайтом мы уделяем приоритетное внимание оптимизации контента, исследованию ключевых слов, созданию обратных ссылок, созданию файла Sitemap.xml и другим задачам, связанным с SEO. WordPress Robots.txt для SEO — один из аспектов, который упускают из виду некоторые веб-мастера.

Файл robots.txt может не иметь большого значения при первом запуске вашего веб-сайта. При этом, когда ваш веб-сайт станет больше и на нем будет больше страниц, мы сторицей окупимся, если мы начнем использовать рекомендуемый файл robots.txt.