14 ข้อผิดพลาดทั่วไปของ WordPress Robots.txt ที่ควรหลีกเลี่ยง

เผยแพร่แล้ว: 2025-01-14Robots.txt เป็นไฟล์เซิร์ฟเวอร์ที่มีประสิทธิภาพซึ่งจะบอกโปรแกรมรวบรวมข้อมูลการค้นหาและบอทอื่นๆ ว่าควรปฏิบัติตนอย่างไรบนเว็บไซต์ WordPress ของคุณ มันสามารถมีอิทธิพลอย่างมากต่อการปรับแต่งเว็บไซต์ให้ติดอันดับบนเครื่องมือการค้นหา (SEO) ของเว็บไซต์ของคุณทั้งเชิงบวกและเชิงลบ

ด้วยเหตุนี้ คุณจึงควรรู้ว่าไฟล์นี้คืออะไรและใช้งานอย่างไร มิฉะนั้น คุณอาจสร้างความเสียหายให้กับเว็บไซต์ของคุณ หรืออย่างน้อยก็ทิ้งศักยภาพบางส่วนไว้บนโต๊ะ

เพื่อช่วยคุณหลีกเลี่ยงสถานการณ์นี้ ในโพสต์นี้ เราจะกล่าวถึงรายละเอียดไฟล์ robots.txt เราจะกำหนดว่ามันคืออะไร วัตถุประสงค์ วิธีค้นหาและจัดการไฟล์ของคุณ และสิ่งที่ควรมี หลังจากนั้น เราจะพูดถึงข้อผิดพลาดทั่วไปที่ผู้คนมักทำกับ WordPress robots.txt วิธีหลีกเลี่ยง และวิธีกู้คืนหากคุณพบว่าคุณทำข้อผิดพลาด

WordPress robots.txt คืออะไร?

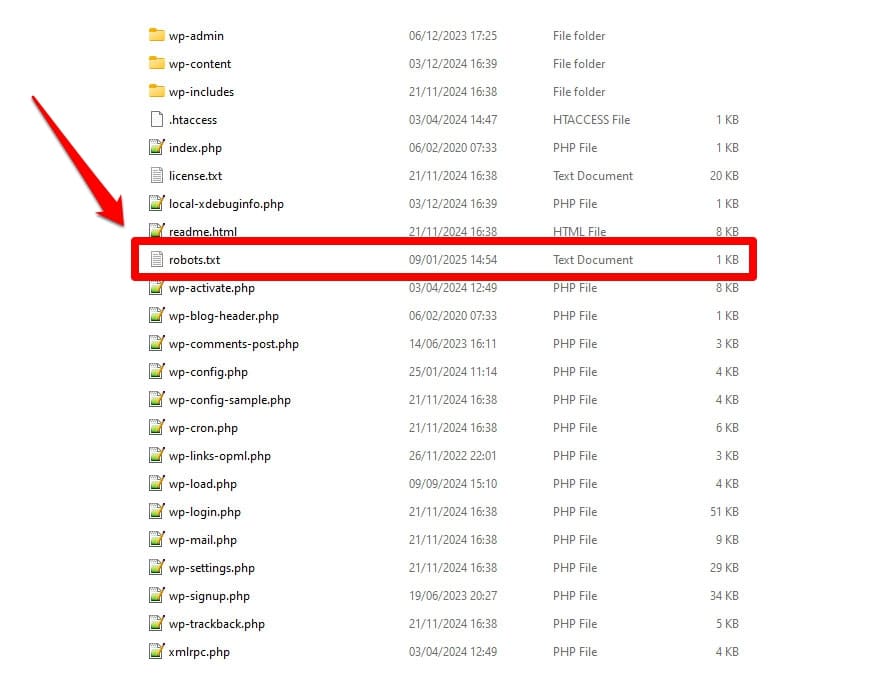

ตามที่กล่าวไว้ robots.txt เป็นไฟล์การกำหนดค่าเซิร์ฟเวอร์ โดยปกติคุณจะพบมันในโฟลเดอร์รูทของเซิร์ฟเวอร์ของคุณ

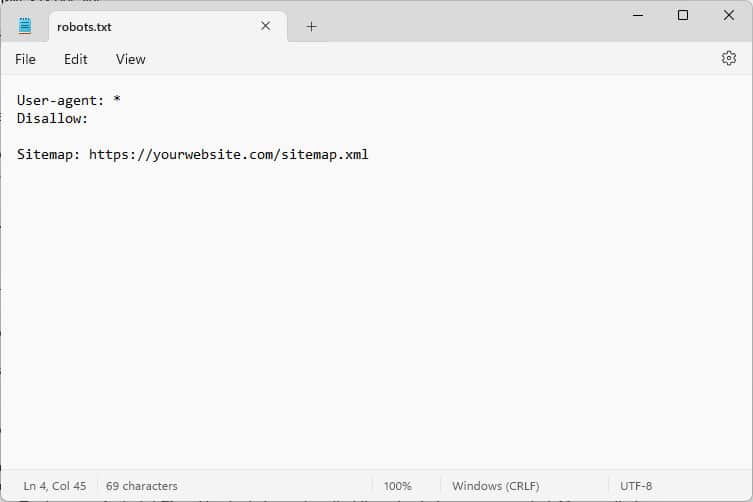

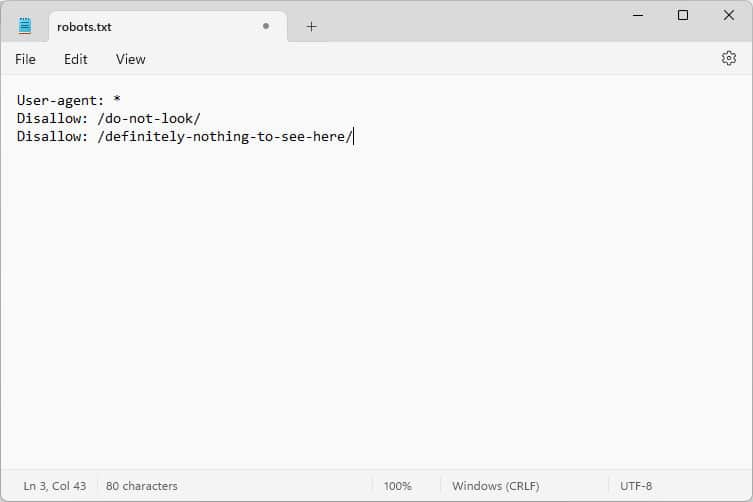

เมื่อคุณเปิดมัน เนื้อหาจะมีลักษณะดังนี้:

โค้ดเหล่านี้เป็นคำแนะนำที่จะบอกบอทที่มาที่เว็บไซต์ของคุณว่าควรปฏิบัติตัวอย่างไรในขณะที่พวกเขาอยู่ที่นั่น โดยเฉพาะส่วนใดของเว็บไซต์ของคุณที่จะเข้าถึงและส่วนไหนที่ไม่สามารถเข้าถึงได้

คุณถามบอทอะไร?

ตัวอย่างที่พบบ่อยที่สุดคือซอฟต์แวร์รวบรวมข้อมูลอัตโนมัติจากเครื่องมือค้นหาที่กำลังมองหาหน้าเว็บเพื่อจัดทำดัชนีหรืออัปเดต แต่ยังรวมไปถึงบอทจากโมเดล AI และเครื่องมืออัตโนมัติอื่นๆ

คุณสามารถให้คำสั่งอะไรกับไฟล์นี้ได้?

โดยพื้นฐานแล้ว Robots.txt รู้คำสั่งหลักสี่ประการ:

- User-agent – กำหนดว่าใคร ซึ่งหมายถึงกลุ่มของบอทหรือแต่ละบอทที่กฎที่ตามมามีไว้สำหรับ

- ไม่อนุญาต – ระบุไดเรกทอรี ไฟล์ หรือทรัพยากรที่ตัวแทนผู้ใช้ไม่ได้รับอนุญาตให้เข้าถึง

- อนุญาต – สามารถใช้เพื่อตั้งค่าข้อยกเว้น เช่น เพื่ออนุญาตการเข้าถึงแต่ละโฟลเดอร์หรือทรัพยากรในไดเร็กทอรีที่ไม่ได้รับอนุญาต

- แผนผังเว็บไซต์ – ชี้บอทไปยังตำแหน่ง URL ของแผนผังเว็บไซต์

เฉพาะ User-agent และ Disallow เท่านั้นที่จำเป็นเพื่อให้ไฟล์ทำงานได้ อีกสองคำสั่งเป็นทางเลือก ตัวอย่างเช่น นี่คือวิธีบล็อกบอทไม่ให้เข้าถึงไซต์ของคุณ:

User-agent: * Disallow: /เครื่องหมายดอกจันแสดงว่ากฎต่อไปนี้ใช้กับตัวแทนผู้ใช้ทั้งหมด เครื่องหมายทับหลัง Disallow ระบุว่าไดเร็กทอรีทั้งหมดบนไซต์นี้ถูกจำกัด นี่คือไฟล์ robots.txt ที่คุณมักจะพบบนเว็บไซต์การพัฒนา ซึ่งเครื่องมือค้นหาไม่ควรจัดทำดัชนี

อย่างไรก็ตาม คุณยังสามารถตั้งกฎสำหรับบอทแต่ละตัวได้:

User-agent: Googlebot Allow: /private/resources/โปรดทราบว่า robots.txt ไม่มีการเชื่อมโยง เฉพาะบอทจากองค์กรที่ปฏิบัติตาม Robots Exclusion Protocol เท่านั้นที่จะปฏิบัติตามคำสั่งของมัน บอทที่เป็นอันตราย เช่น ผู้ที่มองหาข้อบกพร่องด้านความปลอดภัยบนไซต์ของคุณสามารถและจะเพิกเฉยต่อข้อบกพร่องเหล่านั้น และคุณต้องใช้มาตรการเพิ่มเติมเพื่อต่อต้านข้อบกพร่องเหล่านี้

แม้แต่องค์กรที่ปฏิบัติตามมาตรฐานก็ยังเพิกเฉยต่อคำสั่งบางอย่าง เราจะพูดถึงตัวอย่างเพิ่มเติมด้านล่าง

เหตุใด robots.txt จึงมีความสำคัญ

ไม่จำเป็นที่ไซต์ WordPress ของคุณจะต้องมีไฟล์ robots.txt เว็บไซต์ของคุณจะทำงานได้หากไม่มีเว็บไซต์ดังกล่าว และเครื่องมือค้นหาจะไม่ลงโทษคุณหากไม่มีเว็บไซต์ดังกล่าว อย่างไรก็ตาม การรวมรายการดังกล่าวจะทำให้คุณสามารถ:

- เก็บเนื้อหาออกจากผลการค้นหา เช่น หน้าเข้าสู่ระบบหรือไฟล์มีเดียบางไฟล์

- ป้องกันโปรแกรมรวบรวมข้อมูลการค้นหาไม่ให้เปลืองงบประมาณในการรวบรวมข้อมูลกับส่วนที่ไม่สำคัญของไซต์ ซึ่งอาจเพิกเฉยต่อหน้าเว็บที่คุณต้องการให้จัดทำดัชนี

- ชี้เครื่องมือค้นหาไปที่แผนผังไซต์ของคุณเพื่อให้สามารถสำรวจส่วนอื่นๆ ของเว็บไซต์ได้ง่ายขึ้น

- อนุรักษ์ทรัพยากรเซิร์ฟเวอร์โดยกำจัดบอทที่สิ้นเปลือง

ทั้งหมดนี้ช่วยทำให้ไซต์ของคุณดีขึ้น โดยเฉพาะ SEO ของคุณ ซึ่งเป็นสาเหตุว่าทำไมคุณจึงต้องเข้าใจวิธีใช้ robots.txt

วิธีค้นหา แก้ไข และสร้าง WordPress robots.txt ของคุณ

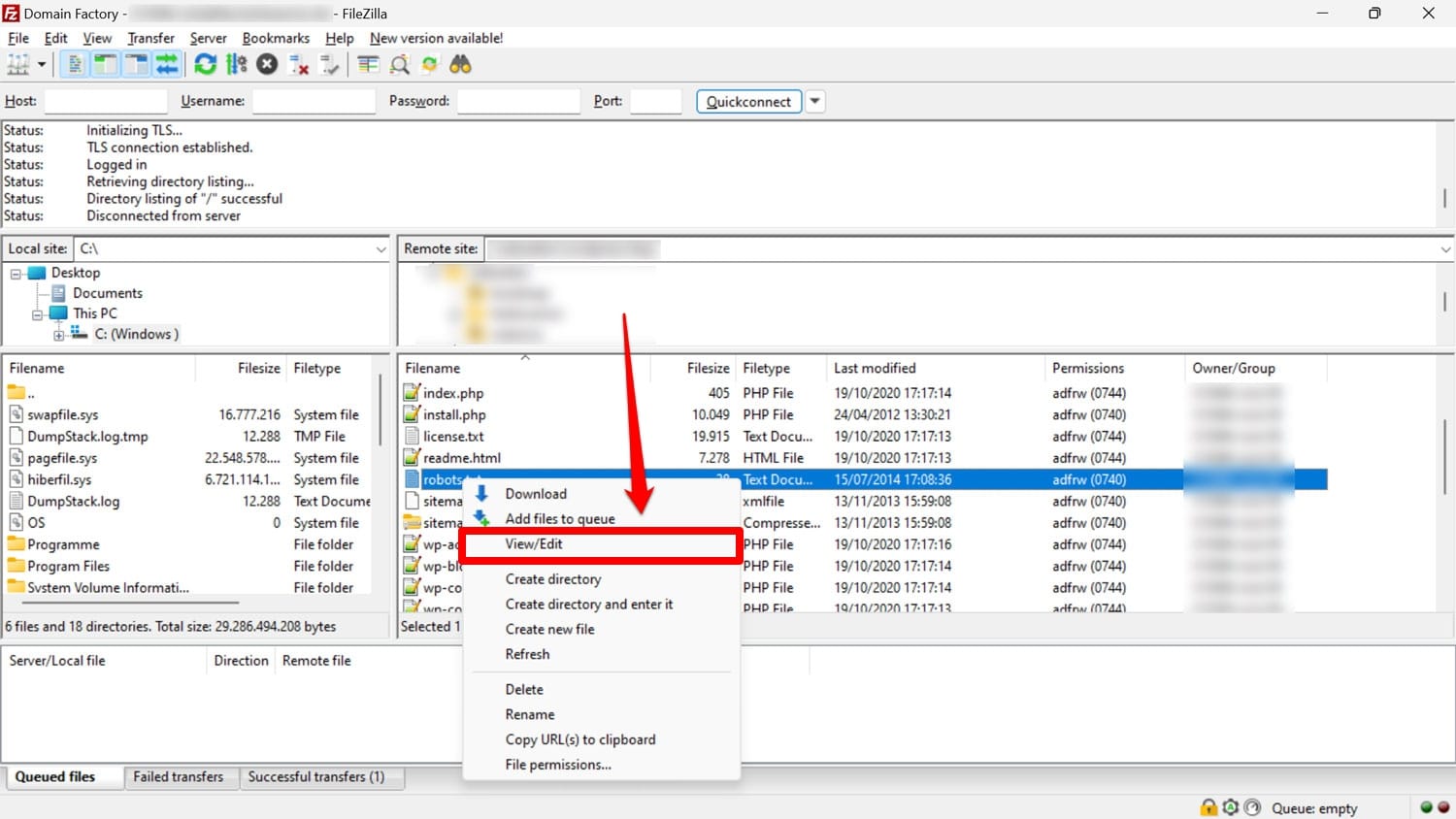

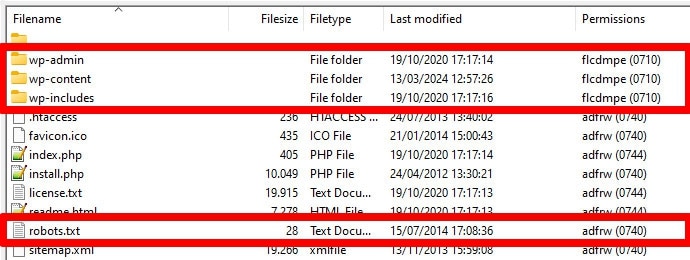

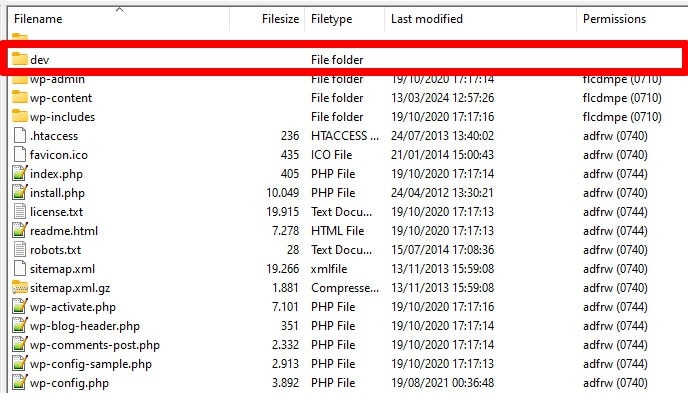

ตามที่กล่าวไว้ robots.txt มักจะอยู่ในโฟลเดอร์รูทของเว็บไซต์ของคุณบนเซิร์ฟเวอร์ คุณสามารถเข้าถึงได้ด้วยไคลเอนต์ FTP เช่น FileZilla และแก้ไขด้วยโปรแกรมแก้ไขข้อความใดก็ได้

หากคุณยังไม่มี คุณสามารถสร้างไฟล์ข้อความเปล่า ตั้งชื่อเป็น "robots.txt" กรอกคำสั่ง แล้วอัปโหลด

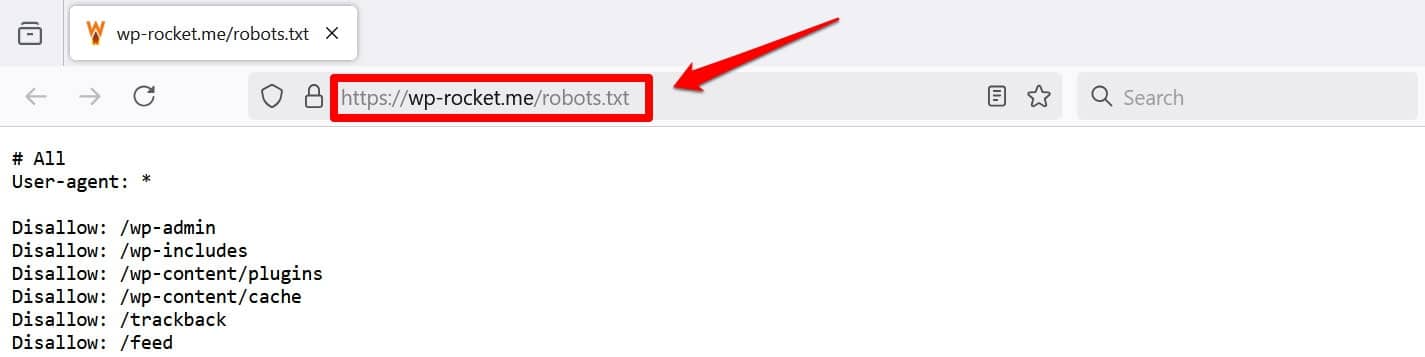

อย่างน้อยอีกวิธีหนึ่งในการดูไฟล์ของคุณคือการเพิ่ม /robots.txt ไปยังโดเมนของคุณ เช่น https://wp-rocket.me/robots.txt

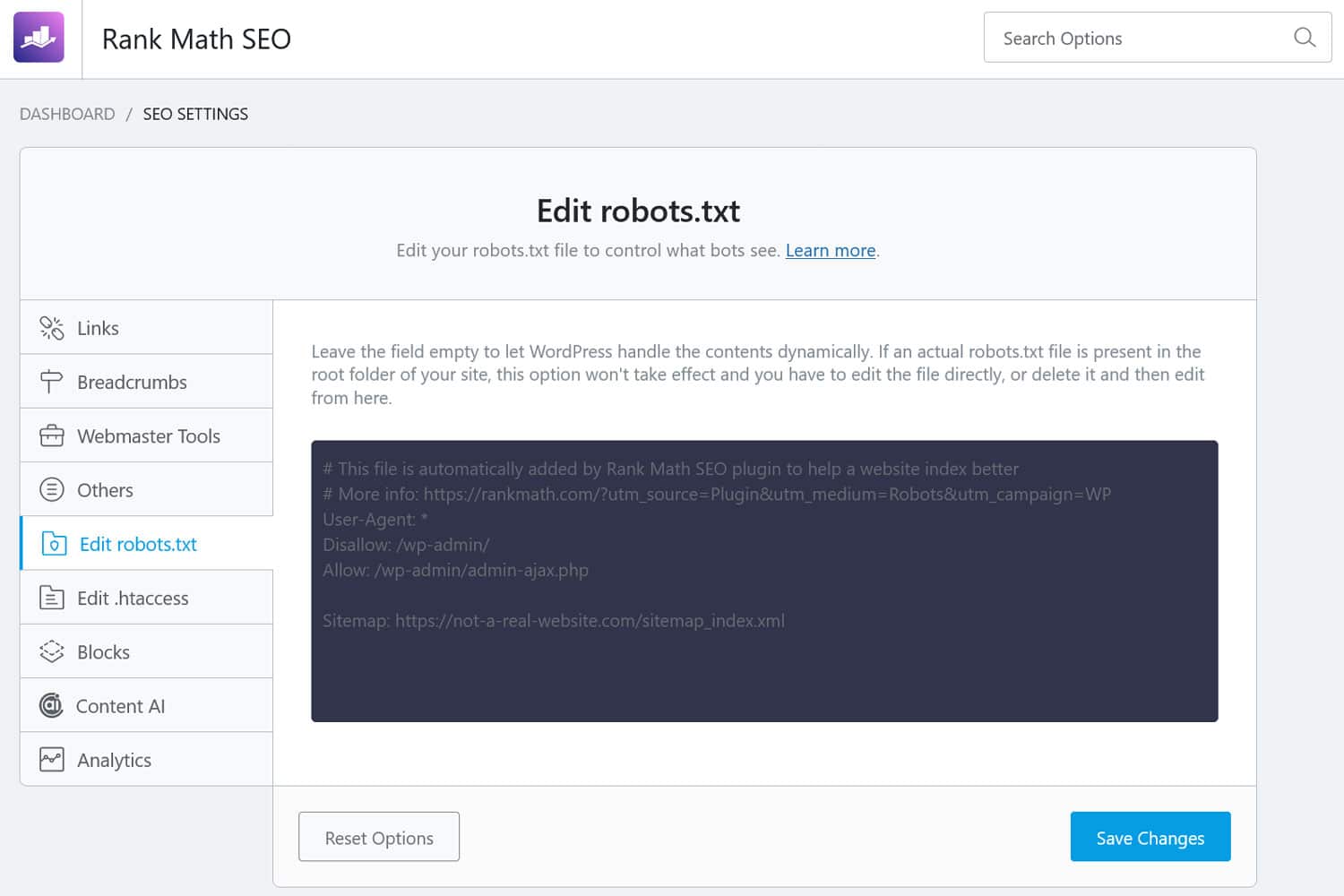

นอกจากนี้ยังมีวิธีเข้าถึงไฟล์จากส่วนหลังของ WordPress ปลั๊กอิน SEO จำนวนมากช่วยให้คุณเห็นและมักจะทำการเปลี่ยนแปลงจากอินเทอร์เฟซการดูแลระบบ

หรือคุณสามารถใช้ปลั๊กอินเช่น WPCode ได้

ไฟล์ robots.txt ของ WordPress ที่ดีมีลักษณะอย่างไร

ไม่มีคำตอบเดียวสำหรับว่าคำสั่งใดควรอยู่ในไฟล์เว็บไซต์ของคุณ ขึ้นอยู่กับการตั้งค่าของคุณ นี่คือตัวอย่างที่เหมาะสมสำหรับเว็บไซต์ WordPress หลายแห่ง:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php Sitemap: https://yourwebsite.com/sitemap.xmlตัวอย่างนี้ให้ผลลัพธ์หลายประการ:

- มันบล็อกการเข้าถึงพื้นที่ผู้ดูแลระบบ

- อนุญาตให้เข้าถึงฟังก์ชันผู้ดูแลระบบที่จำเป็น

- ระบุตำแหน่งแผนผังเว็บไซต์

การตั้งค่านี้สร้างความสมดุลระหว่างความปลอดภัย ประสิทธิภาพ SEO และการรวบรวมข้อมูลที่มีประสิทธิภาพ

อย่าทำข้อผิดพลาด 14 ประการของ WordPress robots.txt

หากเป้าหมายของคุณคือการตั้งค่าและเพิ่มประสิทธิภาพ robots.txt สำหรับไซต์ของคุณเอง โปรดหลีกเลี่ยงข้อผิดพลาดต่อไปนี้

1. ละเว้น WordPress ภายใน robots.txt

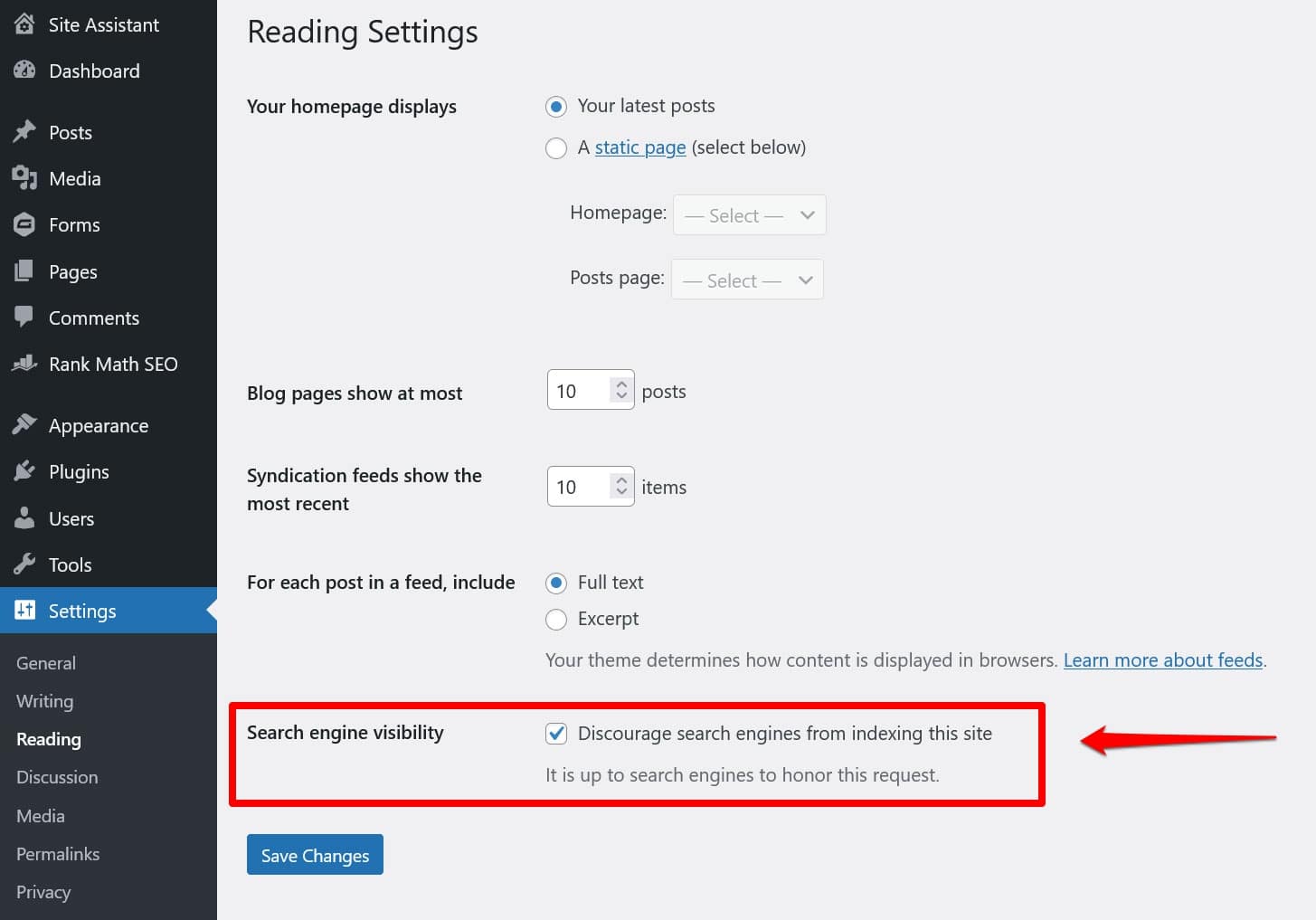

แม้ว่าคุณจะไม่มีไฟล์ robots.txt “จริง” ในไดเรกทอรีรากของเว็บไซต์ของคุณ WordPress ก็มาพร้อมกับไฟล์เสมือนของตัวเอง นั่นเป็นสิ่งสำคัญอย่างยิ่งที่ต้องจำไว้หากคุณพบว่าเครื่องมือค้นหาไม่ได้จัดทำดัชนีเว็บไซต์ของคุณ

ในกรณีดังกล่าว มีโอกาสที่ดีที่คุณได้เปิดใช้งานตัวเลือกเพื่อกีดกันพวกเขาจากการดำเนินการดังกล่าวภายใต้ การตั้งค่า > การอ่าน

ซึ่งจะทำให้มีคำสั่งไม่ให้โปรแกรมรวบรวมข้อมูลการค้นหาทั้งหมดอยู่ใน robots.txt เสมือน หากต้องการปิดใช้งาน ให้ยกเลิกการเลือกช่องแล้วบันทึกที่ด้านล่าง

2. การวางไว้ในตำแหน่งที่ไม่ถูกต้อง

บอท โดยเฉพาะโปรแกรมรวบรวมข้อมูลการค้นหา จะค้นหาไฟล์ robots.txt ของคุณจากที่เดียวเท่านั้น ซึ่งก็คือไดเรกทอรีรากของเว็บไซต์ของคุณ หากคุณวางไว้ที่อื่น เช่น ในโฟลเดอร์ พวกเขาจะไม่พบและจะเพิกเฉยต่อมัน

ไดเร็กทอรีรากของคุณควรอยู่ในตำแหน่งที่คุณไปถึงเมื่อคุณเข้าถึงเซิร์ฟเวอร์ผ่าน FTP เว้นแต่คุณจะวาง WordPress ไว้ในไดเร็กทอรีย่อย หากคุณเห็นโฟลเดอร์ wp-admin , wp-content และ wp-includes แสดง ว่าคุณมาถูกที่แล้ว

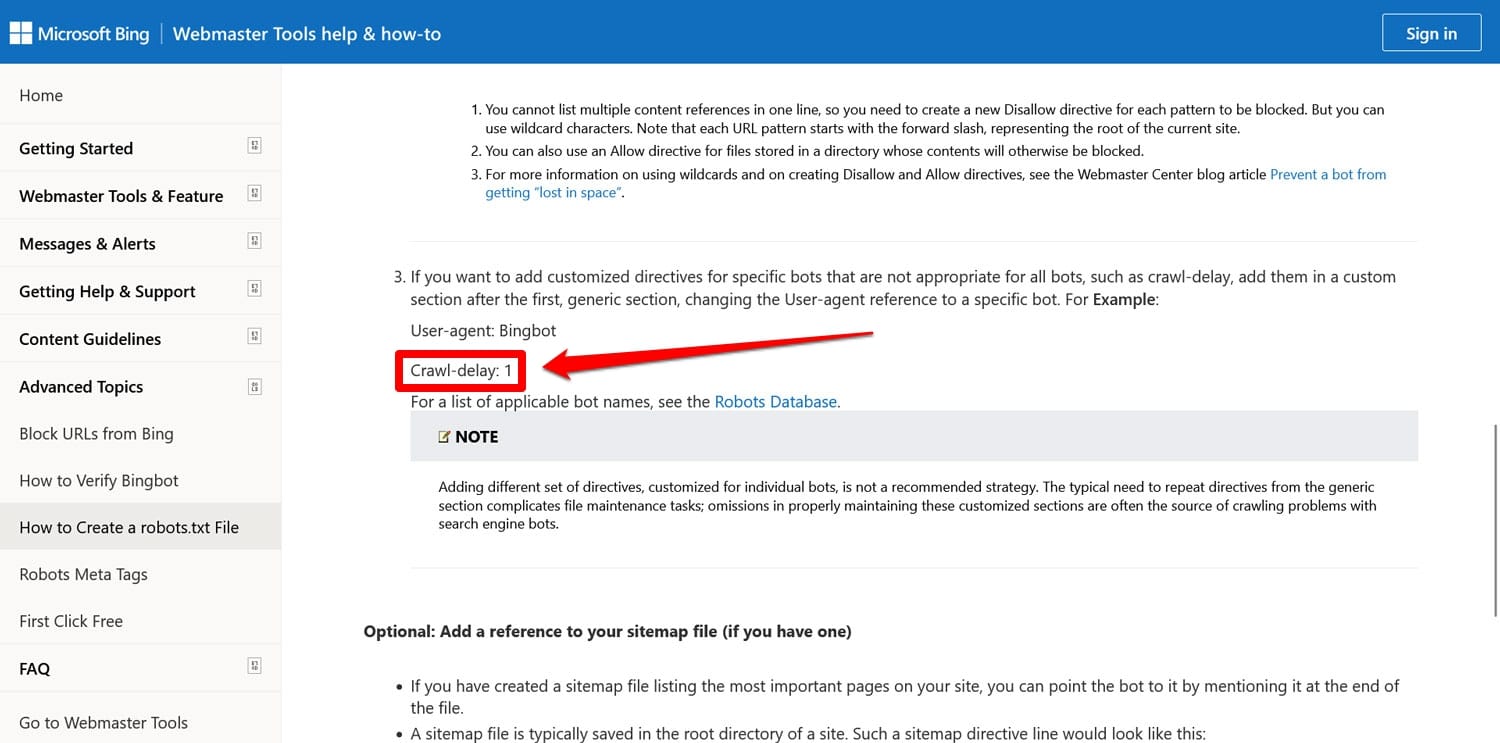

3. รวมถึงมาร์กอัปที่ล้าสมัย

นอกจากคำสั่งที่กล่าวมาข้างต้นแล้ว ยังมีอีกสองคำสั่งที่คุณอาจยังพบในไฟล์ robots.txt ของเว็บไซต์เก่าๆ:

- Noindex – ใช้เพื่อระบุ URL ที่เครื่องมือค้นหาไม่ควรจัดทำดัชนีในเว็บไซต์ของคุณ

- การรวบรวมข้อมูล-ความล่าช้า – คำสั่งที่มีไว้เพื่อควบคุมโปรแกรมรวบรวมข้อมูลเพื่อไม่ให้โหลดทรัพยากรของเว็บเซิร์ฟเวอร์มากเกินไป

ขณะนี้คำสั่งทั้งสองนี้ถูกละเลย อย่างน้อยก็โดย Google อย่างน้อย Bing ก็ยังคงให้เกียรติการรวบรวมข้อมูลล่าช้า

ส่วนใหญ่จะเป็นการดีที่สุดที่จะไม่ใช้คำสั่งเหล่านี้ สิ่งนี้ช่วยให้ไฟล์ของคุณมีขนาดกะทัดรัดและลดความเสี่ยงของข้อผิดพลาด

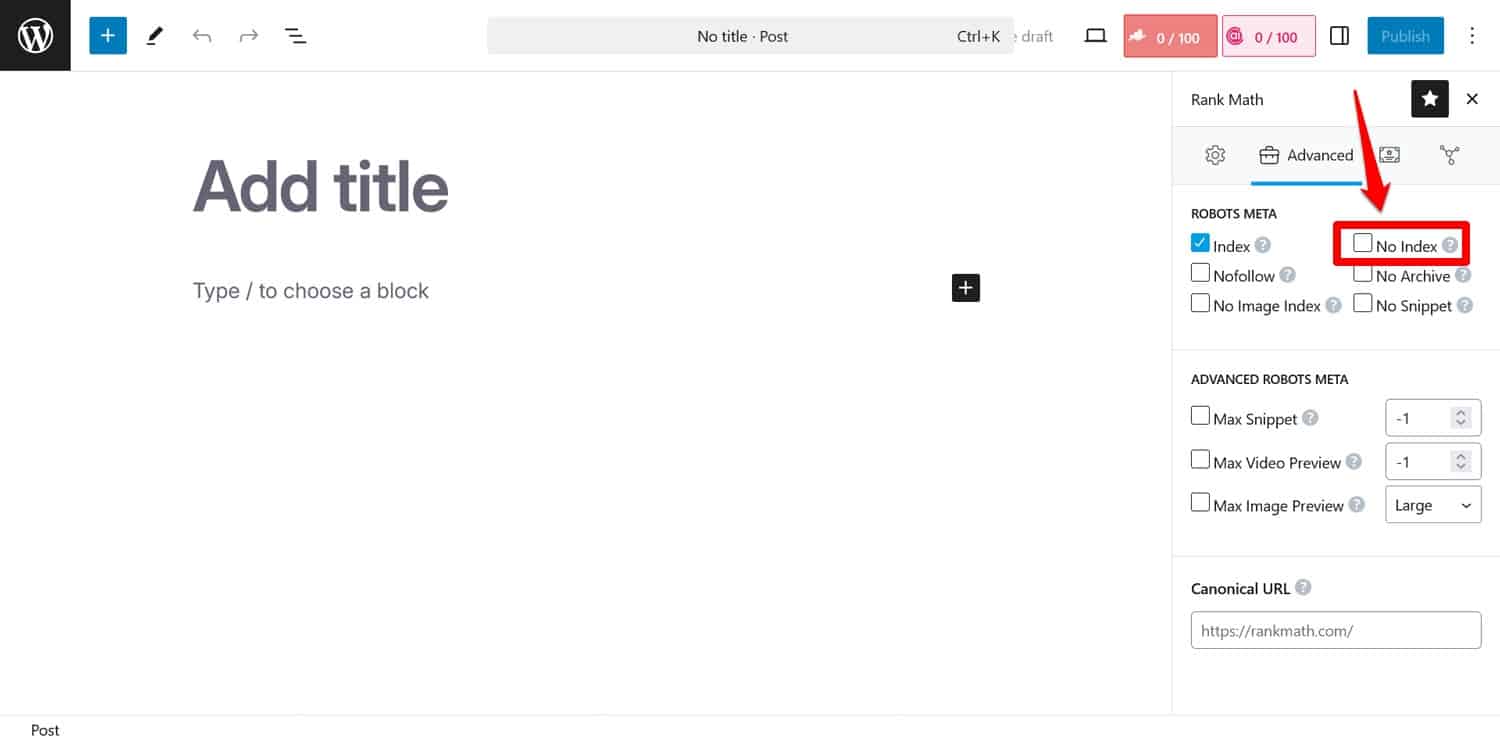

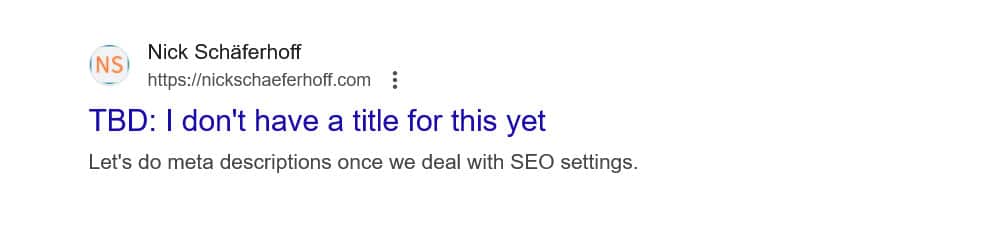

เคล็ดลับ: หากเป้าหมายของคุณคือการป้องกันไม่ให้เครื่องมือค้นหาจัดทำดัชนีหน้าเว็บบางหน้า ให้ใช้เมตาแท็ก noindex แทน คุณสามารถใช้งานด้วยปลั๊กอิน SEO ในแต่ละหน้าได้

หากคุณบล็อกหน้าเว็บผ่าน robots.txt โปรแกรมรวบรวมข้อมูลจะไม่ได้ไปยังส่วนที่เห็นแท็ก noindex ด้วยวิธีนี้ พวกเขาอาจยังคงจัดทำดัชนีหน้าเว็บของคุณ แต่ไม่มีเนื้อหา ซึ่งแย่กว่านั้น

4. การปิดกั้นทรัพยากรที่จำเป็น

หนึ่งในข้อผิดพลาดที่ผู้คนทำคือการใช้ robots.txt เพื่อบล็อกการเข้าถึงสไตล์ชีททั้งหมด (ไฟล์ CSS) และสคริปต์ (ไฟล์ JavaScript) บนไซต์ WordPress เพื่อรักษางบประมาณการรวบรวมข้อมูล

อย่างไรก็ตาม นั่นไม่ใช่ความคิดที่ดี บอทเครื่องมือค้นหาจะเรนเดอร์เพจให้ "เห็น" ด้วยวิธีเดียวกับที่ผู้เยี่ยมชมทำ ซึ่งจะช่วยให้พวกเขาเข้าใจเนื้อหาเพื่อให้สามารถจัดทำดัชนีได้ตามนั้น

การบล็อกทรัพยากรเหล่านี้อาจทำให้เครื่องมือค้นหาแสดงผลหน้าเว็บของคุณไม่ถูกต้อง ซึ่งอาจทำให้ไม่ได้รับการจัดทำดัชนีอย่างถูกต้องหรือทำให้อันดับเสียหาย

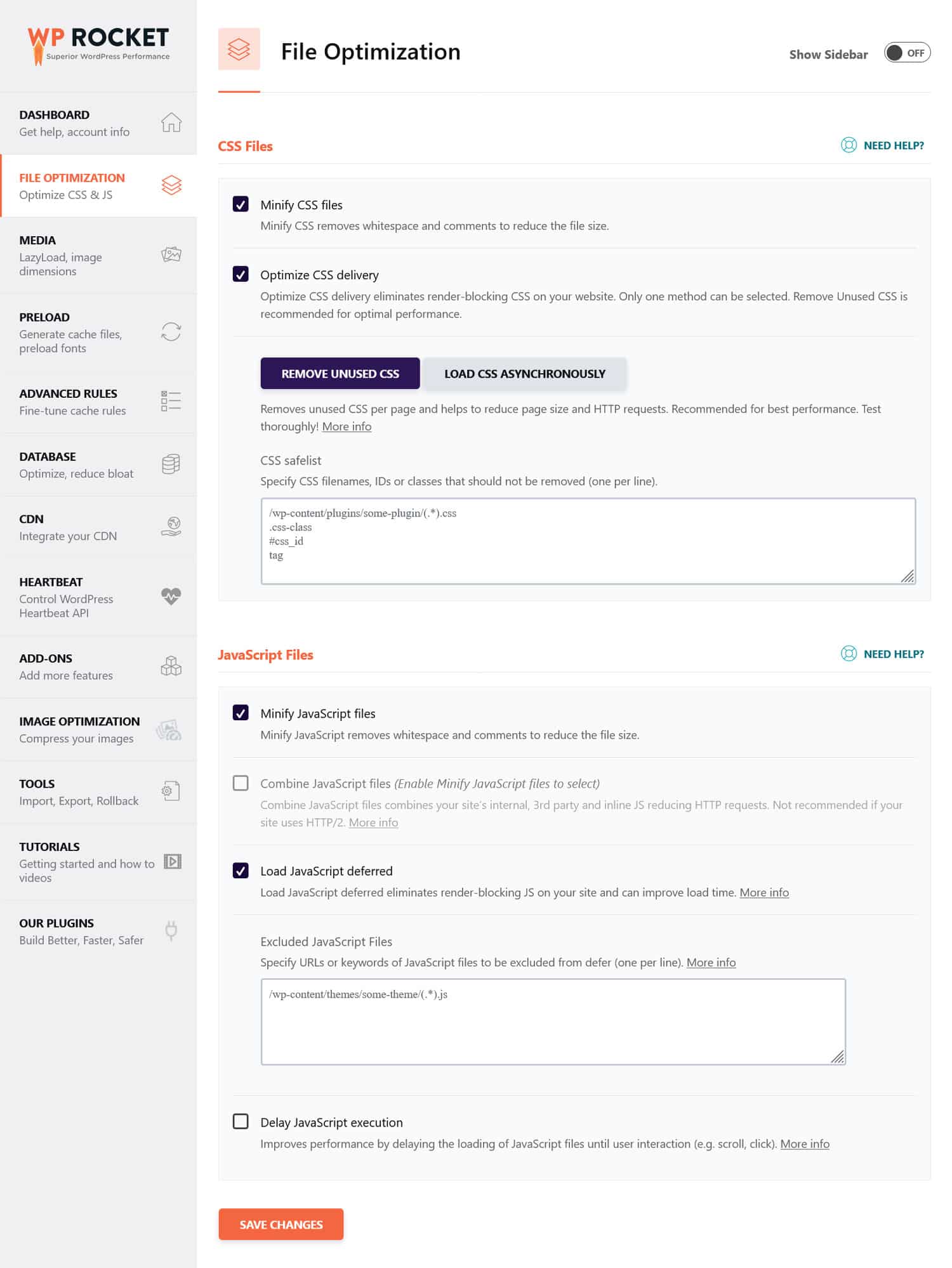

หากคุณคิดว่าไฟล์ CSS และ JavaScript อาจขัดขวางประสิทธิภาพไซต์ของคุณ เป็นความคิดที่ดีกว่าที่จะเพิ่มประสิทธิภาพให้โหลดได้รวดเร็วทั้งสำหรับบอทและผู้เยี่ยมชมทั่วไป คุณสามารถทำได้โดยการลดขนาดโค้ดและบีบอัดไฟล์เว็บไซต์เพื่อให้ส่งได้เร็วขึ้น นอกจากนี้ ยังสามารถเพิ่มประสิทธิภาพการจัดส่งได้โดยกำจัดโค้ดที่ไม่ได้ใช้และเลื่อนทรัพยากรที่บล็อกการแสดงผลออกไป

เคล็ดลับ : คุณสามารถทำให้กระบวนการนี้ง่ายขึ้นได้โดยใช้ปลั๊กอินประสิทธิภาพเช่น WP Rocket อินเทอร์เฟซที่เป็นมิตรต่อผู้ใช้ทำให้คุณสามารถเพิ่มประสิทธิภาพการจัดส่งไฟล์ได้โดยการกาเครื่องหมายบางช่องในเมนู File Optimization

WP Rocket ยังมาพร้อมกับคุณสมบัติเพิ่มเติมเพื่อปรับปรุงประสิทธิภาพของเว็บไซต์ ได้แก่:

- การแคชด้วยแคชมือถือโดยเฉพาะ

- ขี้เกียจโหลดรูปภาพและวิดีโอ

- กำลังโหลดแคช ลิงก์ ไฟล์ภายนอก และแบบอักษรล่วงหน้า

- การเพิ่มประสิทธิภาพฐานข้อมูล

นอกจากนี้ ปลั๊กอินยังดำเนินขั้นตอนการปรับให้เหมาะสมหลายขั้นตอนโดยอัตโนมัติ ตัวอย่าง ได้แก่ การแคชของเบราว์เซอร์และเซิร์ฟเวอร์ การบีบอัด GZIP และการเพิ่มประสิทธิภาพรูปภาพครึ่งหน้าบนเพื่อปรับปรุง LCP ด้วยวิธีนี้ เว็บไซต์ของคุณจะเร็วขึ้นเพียงแค่เปิด WP Rocket

ปลั๊กอินยังมีการรับประกันคืนเงินภายใน 14 วัน ดังนั้นคุณจึงสามารถทดสอบได้โดยปราศจากความเสี่ยง

5. ไม่สามารถอัปเดตการพัฒนา robots.txt ของคุณ

เมื่อสร้างเว็บไซต์ นักพัฒนามักจะรวมไฟล์ robots.txt ที่ห้ามไม่ให้บอททั้งหมดเข้าถึงมัน สิ่งนี้สมเหตุสมผล สิ่งสุดท้ายที่คุณต้องการคือให้ไซต์ที่ยังสร้างไม่เสร็จปรากฏในผลการค้นหา

ปัญหาจะเกิดขึ้นเฉพาะเมื่อคุณถ่ายโอนไฟล์นี้ไปยังเซิร์ฟเวอร์ที่ใช้งานจริงของคุณโดยไม่ตั้งใจ และบล็อกเครื่องมือค้นหาไม่ให้จัดทำดัชนีเว็บไซต์ที่ใช้งานจริงของคุณเช่นกัน ตรวจสอบสิ่งนี้อย่างแน่นอนหากเนื้อหาของคุณปฏิเสธที่จะปรากฏในผลการค้นหา

6. ไม่รวมลิงก์ไปยังแผนผังไซต์ของคุณ

การลิงก์ไปยังแผนผังไซต์ของคุณจาก robots.txt ช่วยให้โปรแกรมรวบรวมข้อมูลของเครื่องมือค้นหามีรายการเนื้อหาทั้งหมดของคุณ สิ่งนี้จะเพิ่มโอกาสของคุณที่พวกเขาจะจัดทำดัชนีมากกว่าหน้าปัจจุบันที่พวกเขาเข้าไป

สิ่งที่ต้องทำคือหนึ่งบรรทัด:

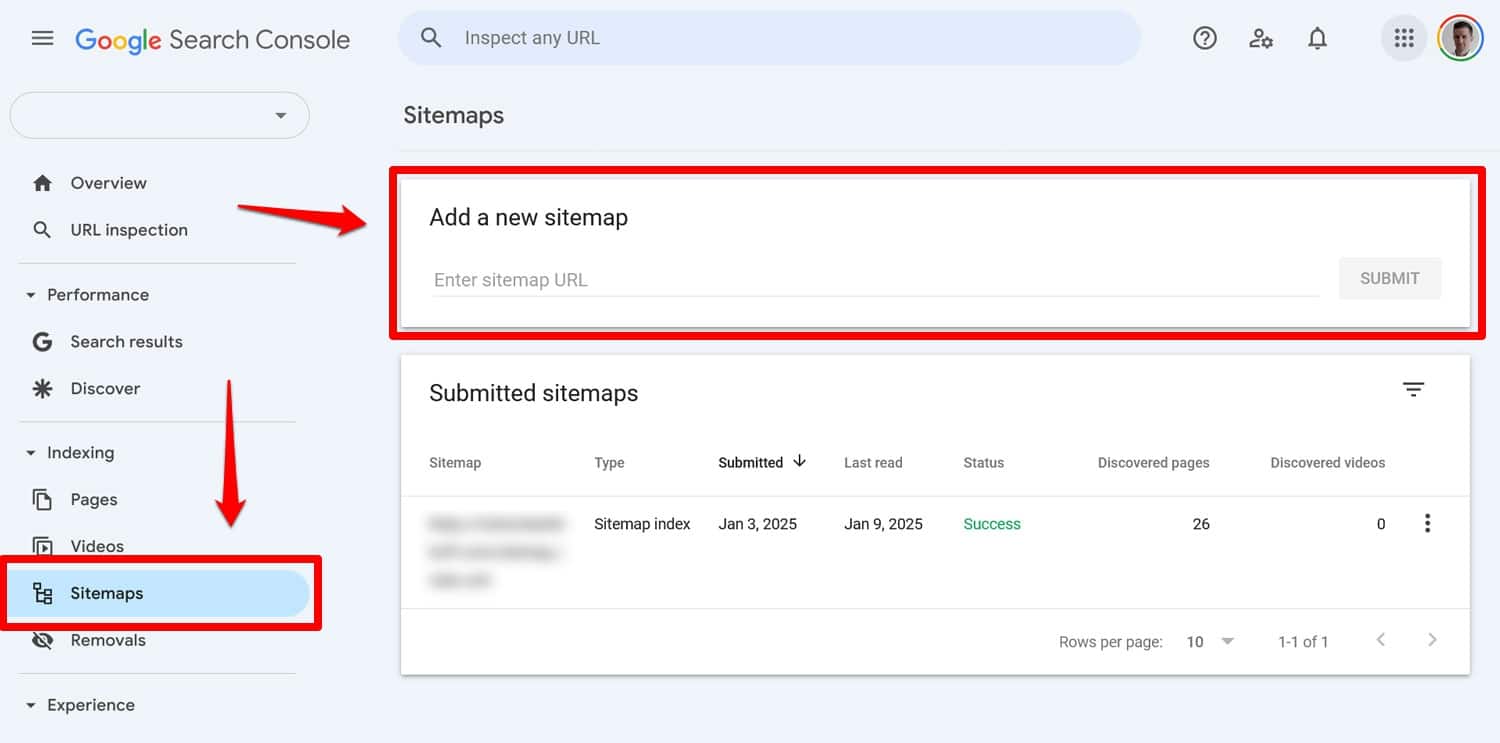

Sitemap: https://yourwebsite.com/sitemap.xmlใช่ คุณยังสามารถส่งแผนผังไซต์ของคุณได้โดยตรงในเครื่องมือเช่น Google Search Console

อย่างไรก็ตาม การรวมไว้ในไฟล์ robots.txt ของคุณยังคงมีประโยชน์ โดยเฉพาะอย่างยิ่งสำหรับเครื่องมือค้นหาที่คุณไม่ได้ใช้เครื่องมือของผู้ดูแลเว็บ

7. การใช้กฎที่ขัดแย้งกัน

ข้อผิดพลาดทั่วไปอย่างหนึ่งในการสร้างไฟล์ robots.txt คือการเพิ่มกฎที่ขัดแย้งกัน เช่น:

User-agent: * Disallow: /blog/ Allow: /blog/คำสั่งข้างต้นทำให้เครื่องมือค้นหาไม่ชัดเจนว่าควรรวบรวมข้อมูลไดเรกทอรี /blog/ หรือไม่ สิ่งนี้นำไปสู่ผลลัพธ์ที่คาดเดาไม่ได้และอาจสร้างความเสียหายให้กับ SEO ของคุณได้

| อยากรู้ว่ามีอะไรอีกที่อาจเป็นอันตรายต่ออันดับการค้นหาของเว็บไซต์ของคุณ และจะหลีกเลี่ยงได้อย่างไร เรียนรู้เกี่ยวกับเรื่องนี้ในคำแนะนำเกี่ยวกับข้อผิดพลาด SEO |

เพื่อหลีกเลี่ยงความขัดแย้ง ให้ปฏิบัติตามแนวทางปฏิบัติที่ดีที่สุดเหล่านี้:

- ใช้กฎเฉพาะก่อน – วางกฎที่เฉพาะเจาะจงมากขึ้นก่อนกฎที่กว้างขึ้น

- หลีกเลี่ยงความซ้ำซ้อน – อย่ารวมคำสั่งที่ขัดแย้งกันสำหรับเส้นทางเดียวกัน

- ทดสอบไฟล์ robots.txt ของคุณ – ใช้เครื่องมือเพื่อยืนยันว่ากฎทำงานตามที่คาดไว้ เพิ่มเติมเกี่ยวกับเรื่องนั้นด้านล่าง

8. พยายามซ่อนเนื้อหาที่ละเอียดอ่อนด้วย robots.txt

ตามที่กล่าวไว้ข้างต้น robots.txt ไม่ใช่เครื่องมือในการกันเนื้อหาออกจากผลการค้นหา เนื่องจากไฟล์ดังกล่าวสามารถเข้าถึงได้แบบสาธารณะ การใช้ไฟล์ดังกล่าวเพื่อบล็อกเนื้อหาที่ละเอียดอ่อนจึงอาจเปิดเผยได้อย่างแน่ชัดว่าเนื้อหานั้นอยู่ที่ใดโดยไม่ได้ตั้งใจ

เคล็ดลับ : ใช้เมตาแท็ก noindex เพื่อกันเนื้อหาออกจากผลการค้นหา นอกจากนี้ ให้ใช้รหัสผ่านป้องกันพื้นที่ละเอียดอ่อนในเว็บไซต์ของคุณเพื่อให้ปลอดภัยจากทั้งโรบ็อตและผู้ใช้ที่ไม่ได้รับอนุญาต

9. การใช้ Wildcards อย่างไม่เหมาะสม

Wildcard ช่วยให้คุณสามารถรวมเส้นทางหรือไฟล์กลุ่มใหญ่ไว้ในคำสั่งของคุณได้ เราเคยเจอกันแล้วอันหนึ่งคือสัญลักษณ์ * หมายถึง “ทุกอินสแตนซ์” และมีการใช้บ่อยที่สุดในการตั้งค่ากฎที่ใช้กับตัวแทนผู้ใช้ทั้งหมด

สัญลักษณ์ตัวแทนอีกอันคือ $ ซึ่งใช้กฎกับส่วนท้ายของ URL คุณสามารถใช้มันได้ เช่น หากคุณต้องการบล็อกโปรแกรมรวบรวมข้อมูลไม่ให้เข้าถึงไฟล์ PDF ทั้งหมดบนเว็บไซต์ของคุณ:

Disallow: /*.pdf$แม้ว่าไวด์การ์ดจะมีประโยชน์ แต่ก็สามารถส่งผลกระทบในวงกว้างได้ ใช้อย่างระมัดระวัง และทดสอบไฟล์ robots.txt ของคุณเสมอเพื่อให้แน่ใจว่าคุณไม่มีข้อผิดพลาดใดๆ

10. URL แบบสัมบูรณ์และแบบสัมพันธ์ที่สับสน

ความแตกต่างระหว่าง URL แบบสัมบูรณ์และแบบสัมพันธ์มีดังนี้

- URL ที่แน่นอน – https://yourwebsite.com/private/

- URL ที่เกี่ยวข้อง – /ส่วนตัว/

ขอแนะนำให้คุณใช้ URL ที่เกี่ยวข้องในคำสั่ง robots.txt ของคุณ เช่น:

Disallow: /private/URL ที่สมบูรณ์อาจทำให้เกิดปัญหาที่บอทอาจเพิกเฉยหรือตีความคำสั่งผิด ข้อยกเว้นเพียงอย่างเดียวคือเส้นทางไปยังแผนผังไซต์ของคุณ ซึ่งต้องเป็น URL ที่สมบูรณ์

11. ละเว้นความอ่อนไหวของตัวพิมพ์เล็กและตัวพิมพ์ใหญ่

คำสั่ง Robots.txt คำนึงถึงตัวพิมพ์เล็กและตัวพิมพ์ใหญ่ ซึ่งหมายความว่าสองคำสั่งต่อไปนี้ไม่สามารถใช้แทนกันได้:

Disallow: /Private/ Disallow: /private/หากคุณพบว่าไฟล์ robots.txt ของคุณไม่ทำงานตามที่คาดไว้ ให้ตรวจสอบว่าการใช้อักษรตัวพิมพ์ใหญ่ที่ไม่ถูกต้องอาจเป็นปัญหาหรือไม่

12. การใช้เครื่องหมายทับต่อท้ายไม่ถูกต้อง

เครื่องหมายทับต่อท้ายคือเครื่องหมายทับที่ส่วนท้ายของ URL:

- โดยไม่มีเครื่องหมายทับต่อท้าย : /directory

- ด้วยเครื่องหมายทับต่อท้าย : /directory/

ใน robots.txt จะกำหนดว่าทรัพยากรไซต์ใดที่ได้รับอนุญาตและไม่อนุญาต นี่คือตัวอย่าง:

Disallow: /private/กฎข้างต้นบล็อกไม่ให้โปรแกรมรวบรวมข้อมูลเข้าถึงไดเร็กทอรี "ส่วนตัว" บนไซต์ของคุณและทุกสิ่งในนั้น ในทางกลับกัน สมมติว่าคุณละเครื่องหมายสแลชต่อท้ายไว้ เช่น:

Disallow: /privateในกรณีนี้ กฎจะบล็อกอินสแตนซ์อื่นๆ ที่ขึ้นต้นด้วย "ส่วนตัว" บนไซต์ของคุณ เช่น:

- https://yourwebsite.com/private.html

- https://yourwebsite.com/privateer

ดังนั้นสิ่งสำคัญคือต้องแม่นยำ หากมีข้อสงสัย ให้ทดสอบไฟล์ของคุณ

13. ไม่มี robots.txt สำหรับโดเมนย่อย

แต่ละโดเมนย่อยบนเว็บไซต์ของคุณ (เช่น dev.yourwebsite.com) จำเป็นต้องมีไฟล์ robots.txt ของตัวเอง เนื่องจากเครื่องมือค้นหาถือว่าโดเมนย่อยเหล่านี้เป็นหน่วยงานเว็บที่แยกจากกัน หากไม่มีไฟล์ คุณอาจเสี่ยงที่โปรแกรมรวบรวมข้อมูลจะสร้างดัชนีส่วนต่างๆ ของไซต์ที่คุณตั้งใจจะซ่อนไว้

ตัวอย่างเช่น หากเวอร์ชันการพัฒนาของคุณอยู่ในโฟลเดอร์ชื่อ "dev" และใช้โดเมนย่อย ตรวจสอบให้แน่ใจว่าเวอร์ชันนั้นมีไฟล์ robots.txt เฉพาะเพื่อบล็อกโปรแกรมรวบรวมข้อมูลการค้นหา

14. ไม่ทดสอบไฟล์ robots.txt ของคุณ

ข้อผิดพลาดที่ใหญ่ที่สุดประการหนึ่งเมื่อกำหนดค่าไฟล์ robots.txt ของ WordPress คือการไม่สามารถทดสอบไฟล์ได้ โดยเฉพาะหลังจากทำการเปลี่ยนแปลง

ดังที่เราได้เห็นแล้วว่าข้อผิดพลาดเล็กน้อยในด้านไวยากรณ์หรือตรรกะก็อาจทำให้เกิดปัญหา SEO ที่สำคัญได้ ดังนั้น ให้ทดสอบไฟล์ robots.txt ของคุณเสมอ

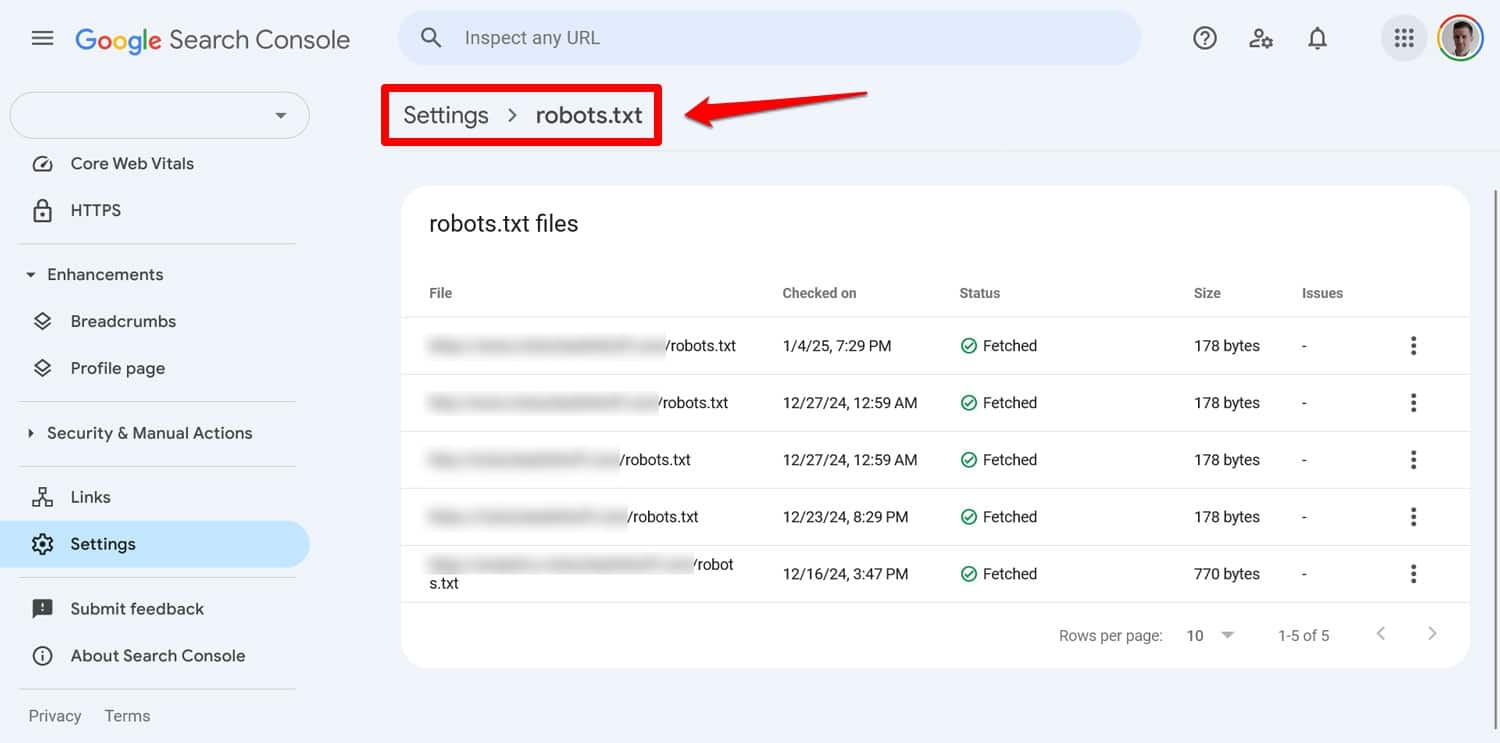

คุณสามารถดูปัญหาเกี่ยวกับไฟล์ของคุณได้ใน Google Search Console ในส่วน การตั้งค่า > robots.txt

อีกวิธีหนึ่งคือการจำลองพฤติกรรมการรวบรวมข้อมูลด้วยเครื่องมือเช่น Screaming Frog นอกจากนี้ ให้ใช้สภาพแวดล้อมชั่วคราวเพื่อตรวจสอบผลกระทบของกฎใหม่ก่อนที่จะนำไปใช้กับไซต์ที่ใช้งานอยู่ของคุณ

วิธีการกู้คืนจากข้อผิดพลาด robots.txt

ข้อผิดพลาดในไฟล์ robots.txt เกิดขึ้นได้ง่าย แต่โชคดีที่ข้อผิดพลาดเหล่านี้มักจะแก้ไขได้ง่ายเมื่อคุณพบข้อผิดพลาดแล้ว

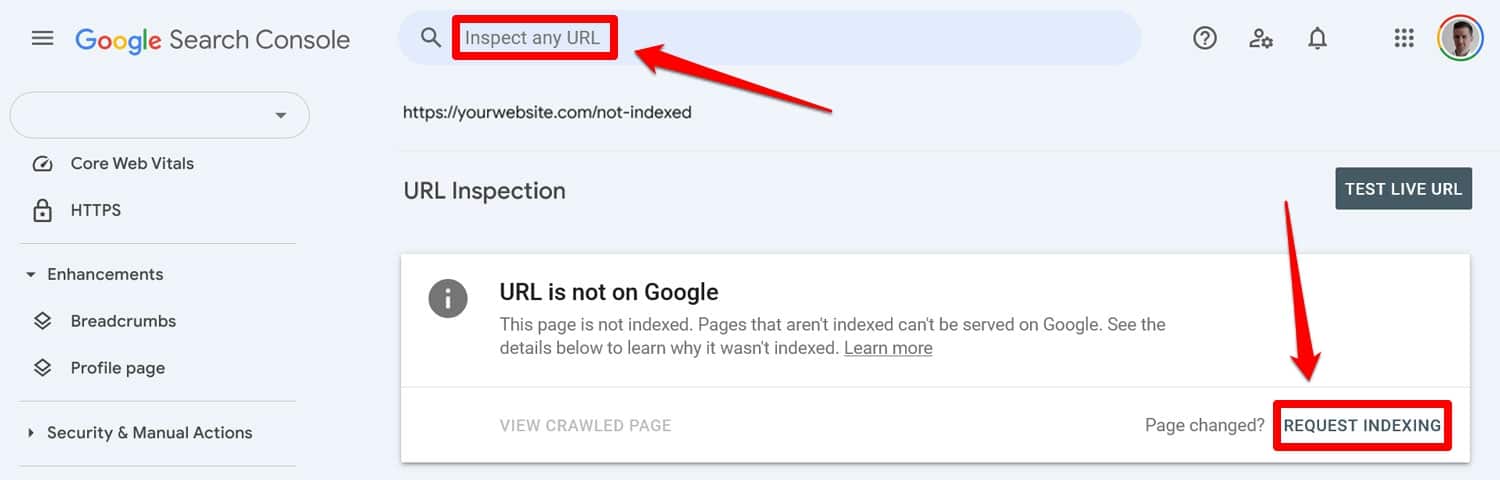

เริ่มต้นด้วยการเรียกใช้ไฟล์ robots.txt ที่อัปเดตผ่านเครื่องมือทดสอบ จากนั้น หากก่อนหน้านี้หน้าเว็บถูกบล็อกโดยคำสั่ง robots.txt ให้ป้อนข้อมูลด้วยตนเองใน Google Search Console หรือ Bing Webmaster Tools เพื่อขอการจัดทำดัชนี

นอกจากนี้ ให้ส่งแผนผังเว็บไซต์เวอร์ชันล่าสุดของคุณอีกครั้ง

หลังจากนั้นก็เป็นเพียงเกมที่รอคอย เครื่องมือค้นหาจะกลับมาเยี่ยมชมเว็บไซต์ของคุณอีกครั้ง และหวังว่าจะทำให้ตำแหน่งของคุณในการจัดอันดับกลับคืนมาอย่างรวดเร็ว

ควบคุม WordPress robots.txt ของคุณ

ด้วยไฟล์ robots.txt การป้องกันหนึ่งออนซ์ย่อมดีกว่าการรักษาหนึ่งปอนด์ โดยเฉพาะอย่างยิ่งบนเว็บไซต์ขนาดใหญ่ ไฟล์ที่ผิดพลาดอาจสร้างความเสียหายให้กับการจัดอันดับ การรับส่งข้อมูล และรายได้

ด้วยเหตุนี้ การเปลี่ยนแปลงใดๆ ใน robots.txt ของเว็บไซต์ของคุณจึงควรดำเนินการอย่างระมัดระวังและผ่านการทดสอบอย่างละเอียด การตระหนักถึงข้อผิดพลาดที่คุณสามารถทำได้คือขั้นตอนแรกในการป้องกันข้อผิดพลาดเหล่านั้น

เมื่อคุณทำผิดพลาด พยายามอย่าตื่นตระหนก วินิจฉัยสิ่งผิดปกติ แก้ไขข้อผิดพลาด และส่งแผนผังไซต์ของคุณอีกครั้งเพื่อให้มีการรวบรวมข้อมูลไซต์ของคุณอีกครั้ง

สุดท้าย ตรวจสอบให้แน่ใจว่าประสิทธิภาพไม่ใช่สาเหตุที่เครื่องมือค้นหาไม่สามารถรวบรวมข้อมูลไซต์ของคุณได้อย่างถูกต้อง ลองใช้ WP Rocket ตอนนี้เพื่อทำให้เว็บไซต์ของคุณเร็วขึ้นทันที!