Robots.txt: Nedir ve Nasıl Oluşturulur (Komple Kılavuz)

Yayınlanan: 2023-05-05Bir web sitesine sahipseniz veya içeriğini yönetiyorsanız, muhtemelen robots.txt'yi duymuşsunuzdur. Bu, arama motoru robotlarına web sitenizin sayfalarını nasıl tarayacakları ve dizine ekleyecekleri konusunda talimat veren bir dosyadır. Arama motoru optimizasyonundaki (SEO) önemine rağmen, birçok web sitesi sahibi, iyi tasarlanmış bir robots.txt dosyasının önemini gözden kaçırır.

Bu eksiksiz kılavuzda, robots.txt'nin ne olduğunu, SEO için neden önemli olduğunu ve web siteniz için bir robots.txt dosyasını nasıl oluşturacağınızı keşfedeceğiz.

Robots.txt Dosyası Nedir?

Robots.txt, arama motoru robotlarına (aynı zamanda tarayıcılar veya örümcekler olarak da bilinir) bir web sitesinin hangi sayfalarının veya bölümlerinin taranması gerektiğini söyleyen bir dosyadır. Bir web sitesinin kök dizininde bulunan bir düz metin dosyasıdır ve genellikle web yöneticisinin arama motorunun indekslemesini veya taramasını engellemek istediği dizinlerin, dosyaların veya URL'lerin bir listesini içerir.

Bir robots.txt dosyası şu şekilde görünür:

Robots.txt Neden Önemli?

robots.txt dosyasının web siteniz için önemli olmasının üç ana nedeni vardır:

1. Tarama Bütçesini En Üst Düzeye Çıkarın

"Tarama bütçesi", Google'ın herhangi bir zamanda sitenizde tarayacağı sayfa sayısı anlamına gelir. Sayı, sitenizdeki geri bağlantıların boyutuna, sağlığına ve miktarına bağlıdır.

Tarama bütçesi önemlidir çünkü sitenizdeki sayfa sayısı tarama bütçesini aşarsa dizine alınmayan sayfalarınız olur.

Ayrıca indekslenmeyen sayfalar hiçbir sıralamada yer almayacaktır.

Googlebot (Google'ın web tarayıcısı), gereksiz sayfaları engellemek için robots.txt'yi kullanarak tarama bütçenizin daha fazlasını önemli sayfalara harcayabilir.

2. Herkese Açık Olmayan Sayfaları Engelleyin

Sitenizde dizine eklemek istemediğiniz birçok sayfa var.

Örneğin, dahili bir arama sonuçları sayfanız veya oturum açma sayfanız olabilir. Bu sayfaların var olması gerekiyor. Ancak, rastgele insanların üzerlerine inmesini istemezsiniz.

Bu durumda, arama motoru tarayıcılarının ve botların belirli sayfalara erişmesini engellemek için robots.txt dosyasını kullanırsınız.

3. Kaynakların İndekslenmesini Önleyin

Bazen Google'ın PDF'ler, videolar ve görseller gibi kaynakları arama sonuçlarından hariç tutmasını isteyebilirsiniz.

Muhtemelen bu kaynakları gizli tutmak istiyorsunuz veya Google'ın daha önemli içeriğe odaklanmasını istiyorsunuz.

Bu gibi durumlarda, robots.txt'yi kullanmak, dizine eklenmesini önlemek için en iyi yaklaşımdır.

Bir Robots.txt Dosyası Nasıl Çalışır?

Robots.txt dosyaları, arama motoru botlarına web sitesinin hangi sayfalarını veya dizinlerini taramaları veya dizine eklememeleri gerektiğini bildirir.

Tarama yaparken, arama motoru botları bağlantıları bulur ve takip eder. Bu süreç onları milyarlarca bağlantı ve web sitesi üzerinden X sitesinden Y sitesine ve Z sitesine yönlendirir.

Bir bot bir siteyi ziyaret ettiğinde yaptığı ilk şey bir robots.txt dosyası aramaktır.

Bir tane algılarsa, başka bir şey yapmadan önce dosyayı okuyacaktır.

Örneğin, DuckDuckGo dışındaki tüm botların sitenizi taramasına izin vermek istediğinizi varsayalım:

User-agent: DuckDuckBot Disallow: /

Not: Bir robots.txt dosyası yalnızca talimat verebilir; onları empoze edemez. Davranış kurallarına benzer. İyi botlar (arama motoru botları gibi) kurallara uyarken, kötü botlar (spam botları gibi) onları görmezden gelir.

Robots.txt Dosyası Nasıl Bulunur?

Robots.txt dosyası, web sitenizdeki diğer tüm dosyalar gibi sunucunuzda barındırılır.

Ana sayfanın tam URL'sini girip sonuna /robots.txt ekleyerek herhangi bir web sitesinin robots.txt dosyasına erişebilirsiniz, örneğin https://pickupwp.com/robots.txt.

Ancak web sitesinde robots.txt dosyası yoksa “404 Bulunamadı” hata mesajı alırsınız.

Robots.txt Dosyası Nasıl Oluşturulur?

Bir robots.txt dosyasının nasıl oluşturulacağını göstermeden önce robots.txt sözdizimine bakalım.

Bir robots.txt dosyasının sözdizimi aşağıdaki bileşenlere ayrılabilir:

- User-agent: Bu, kaydın geçerli olduğu robotu veya gezgini belirtir. Örneğin, "User-agent: Googlebot" yalnızca Google'ın arama tarayıcısına, "User-agent: *" ise tüm tarayıcılara uygulanır.

- İzin Verme: Bu, robotun taramaması gereken sayfaları veya dizinleri belirtir. Örneğin, "Disallow: /private/", robotların "private" dizindeki sayfaları taramasını engeller.

- İzin Ver: Bu, üst dizine izin verilmese bile robotun taramasına izin verilmesi gereken sayfaları veya dizinleri belirtir. Örneğin, "İzin ver: /public/", üst dizine izin verilmemiş olsa bile robotların "genel" dizindeki sayfaları taramasına izin verir.

- Tarama gecikmesi: Bu, robotun web sitesini taramadan önce beklemesi gereken süreyi saniye cinsinden belirtir. Örneğin, "Tarama gecikmesi: 10", robota web sitesini taramadan önce 10 saniye beklemesi talimatını verir.

- Site Haritası: Bu, web sitesinin site haritasının konumunu belirtir. Örneğin, "Site Haritası: https://www.example.com/sitemap.xml" robota web sitesinin site haritasının konumunu bildirir.

İşte bir robots.txt dosyası örneği:

User-agent: Googlebot Disallow: /private/ Allow: /public/ Crawl-delay: 10 Sitemap: https://www.example.com/sitemap.xml

Not: robots.txt dosyalarının büyük/küçük harfe duyarlı olduğunu unutmamak önemlidir, bu nedenle URL'leri belirtirken doğru büyük/küçük harf kullanmak önemlidir.

Örneğin, /public/, /Public/ ile aynı değildir.

Öte yandan, “İzin Ver” ve “İzin Verme” gibi Yönergeler büyük/küçük harfe duyarlı değildir, bu nedenle büyük harfle yazıp yazmamak size kalmış.

robots.txt sözdizimini öğrendikten sonra, robots.txt oluşturma aracını kullanarak bir robots.txt dosyası oluşturabilir veya kendiniz oluşturabilirsiniz.

Sadece dört adımda bir robots.txt dosyasını nasıl oluşturacağınız aşağıda açıklanmıştır:

1. Yeni Bir Dosya Oluşturun ve Robots.txt Olarak Adlandırın

Bir .txt belgesini herhangi bir metin düzenleyici veya web tarayıcısı ile açmanız yeterlidir.

Ardından, belgeye robots.txt adını verin. Çalışması için robots.txt olarak adlandırılmalıdır.

İşiniz bittiğinde, artık yönergeleri yazmaya başlayabilirsiniz.

2. Robots.txt Dosyasına Direktifler Ekleyin

Bir robots.txt dosyası, her biri birden fazla talimat satırı içeren bir veya daha fazla direktif grubu içerir.

Her grup bir "User-agent" ile başlar ve aşağıdaki verileri içerir:

- Grubun kime başvurduğu (kullanıcı aracısı)

- Aracı hangi dizinlere (sayfalara) veya dosyalara erişebilir?

- Temsilci hangi dizinlere (sayfalara) veya dosyalara erişemez?

- Arama motorlarını önemli olduğuna inandığınız siteler ve dosyalar hakkında bilgilendirmek için bir site haritası (isteğe bağlı).

Bu direktiflerin hiçbiriyle eşleşmeyen satırlar, tarayıcılar tarafından dikkate alınmaz.

Örneğin, Google'ın /private/ dizininizi taramasını engellemek istiyorsunuz.

Şöyle görünecek:

User-agent: Googlebot Disallow: /private/

Google için bunun gibi başka talimatlarınız olsaydı, bunları doğrudan aşağıdaki gibi ayrı bir satıra koyardınız:

User-agent: Googlebot Disallow: /private/ Disallow: /not-for-google

Ayrıca, Google'ın özel talimatlarıyla işiniz bittiğinde ve yeni bir direktif grubu oluşturmak istiyorsanız.

Örneğin, tüm arama motorlarının /archive/ ve /support/ dizinlerinizi taramasını engellemek istiyorsanız.

Şöyle görünecek:

User-agent: Googlebot Disallow: /private/ Disallow: /not-for-google User-agent: * Disallow: /archive/ Disallow: /support/

Bitirdiğinizde, site haritanızı ekleyebilirsiniz.

Tamamlanan robots.txt dosyanız şöyle görünmelidir:

User-agent: Googlebot Disallow: /private/ Disallow: /not-for-google User-agent: * Disallow: /archive/ Disallow: /support/ Sitemap: https://www.example.com/sitemap.xml

Ardından, robots.txt dosyanızı kaydedin. Unutmayın, robots.txt olarak adlandırılmalıdır.

Daha kullanışlı robots.txt kuralları için Google'ın bu yararlı kılavuzuna göz atın.

3. Robots.txt Dosyasını Yükleyin

robots.txt dosyanızı bilgisayarınıza kaydettikten sonra web sitenize yükleyin ve arama motorlarının tarayabileceği şekilde açın.

Ne yazık ki, bu adımda yardımcı olabilecek bir araç yok.

robots.txt dosyasının yüklenmesi, sitenizin dosya yapısına ve web barındırmaya bağlıdır.

robots.txt dosyanızı nasıl yükleyeceğinizle ilgili talimatlar için çevrimiçi arama yapın veya barındırma sağlayıcınızla iletişime geçin.

4. Robots.txt Dosyanızı Test Edin

robots.txt dosyasını yükledikten sonra, bunu kimsenin görüp göremediğini ve Google'ın okuyup okuyamadığını kontrol edebilirsiniz.

Tarayıcınızda yeni bir sekme açın ve robots.txt dosyanızı arayın.

Örneğin, https://pickupwp.com/robots.txt.

robots.txt dosyanızı görüyorsanız, işaretlemeyi (HTML kodu) test etmeye hazırsınız demektir.

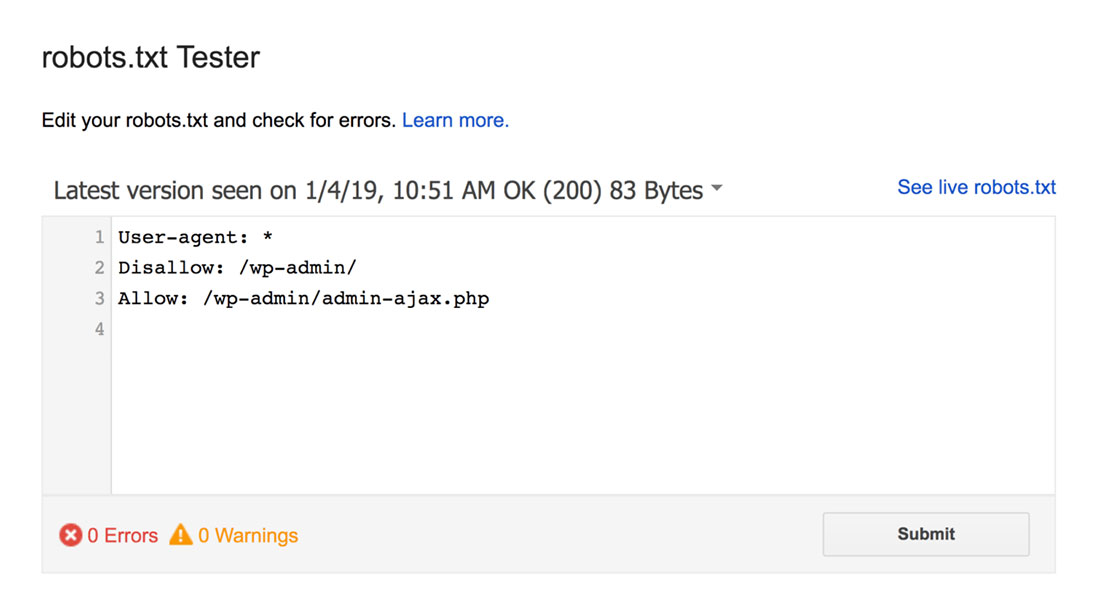

Bunun için bir Google robots.txt Test Aracı kullanabilirsiniz.

Not: robots.txt dosyanızı robots.txt Tester kullanarak test etmek için ayarlanmış bir Search Console hesabınız var.

robots.txt test aracı sözdizimi uyarılarını veya mantık hatalarını bulur ve bunları vurgular.

Ayrıca, düzenleyicinin altında size uyarıları ve hataları da gösterir.

Sayfadaki hataları veya uyarıları düzenleyebilir ve gerektiği kadar sıklıkta yeniden test edebilirsiniz.

Sayfada yapılan değişikliklerin sitenize kaydedilmediğini unutmayın.

Herhangi bir değişiklik yapmak için bunu kopyalayıp sitenizin robots.txt dosyasına yapıştırın.

Robots.txt En İyi Uygulamaları

Bazı yaygın hatalardan kaçınmak için robots.txt dosyanızı oluştururken bu en iyi uygulamaları aklınızda bulundurun.

1. Her Yönerge İçin Yeni Satır Kullanın

Arama motoru tarayıcılarının kafa karışıklığını önlemek için her yönergeyi robots.txt dosyanızdaki yeni bir satıra ekleyin. Bu, hem İzin Ver hem de İzin Verme kuralları için geçerlidir.

Örneğin, bir web tarayıcısının blogunuzu veya iletişim sayfanızı taramasını istemiyorsanız aşağıdaki kuralları ekleyin:

Disallow: /blog/ Disallow: /contact/

2. Her Kullanıcı Aracısını Yalnızca Bir Kez Kullanın

Aynı kullanıcı aracısını tekrar tekrar kullanırsanız, botların herhangi bir sorunu yoktur.

Ancak, yalnızca bir kez kullanmak her şeyi düzenli tutar ve insan hatası olasılığını azaltır.

3. Talimatları Basitleştirmek İçin Joker Karakterler Kullanın

Engellenecek çok sayıda sayfanız varsa, her biri için bir kural eklemek zaman alabilir. Neyse ki, talimatlarınızı basitleştirmek için joker karakterler kullanabilirsiniz.

Joker karakter, bir veya daha fazla karakteri temsil edebilen bir karakterdir. En sık kullanılan joker karakter yıldız işaretidir (*).

Örneğin, .jpg ile biten tüm dosyaları engellemek istiyorsanız, aşağıdaki kuralı eklersiniz:

Disallow: /*.jpg

4. Bir URL'nin Sonunu Belirtmek İçin “$” Kullanın

Dolar işareti ($), bir URL'nin sonunu belirtmek için kullanılabilecek başka bir joker karakterdir. Bu, belirli bir sayfayı kısıtlamak istiyorsanız ancak ondan sonrakileri kısıtlamak istemiyorsanız kullanışlıdır.

İletişim sayfasını engellemek istediğinizi ancak iletişim başarılı sayfasını engellemek istediğinizi varsayalım, aşağıdaki kuralı eklersiniz:

Disallow: /contact$

5. Yorum Eklemek İçin Hash (#) Kullanın

Karma (#) ile başlayan her şey tarayıcılar tarafından göz ardı edilir.

Sonuç olarak, geliştiriciler robots.txt dosyasına yorum eklemek için genellikle karmayı kullanır. Belgeyi düzenli ve okunabilir halde tutar.

Örneğin, .jpg ile biten tüm dosyaları engellemek istiyorsanız, aşağıdaki yorumu ekleyebilirsiniz:

# Block all files that end in .jpg Disallow: /*.jpg

Bu, herkesin kuralın ne için olduğunu ve neden orada olduğunu anlamasına yardımcı olur.

6. Her alt alan için ayrı Robots.txt Dosyaları Kullanın

Birden fazla alt alana sahip bir web siteniz varsa, her biri için ayrı bir robots.txt dosyası oluşturmanız önerilir. Bu, işleri düzenli tutar ve arama motoru tarayıcılarının kurallarınızı daha kolay kavramasına yardımcı olur.

Tamamlanıyor!

Robots.txt dosyası, arama motoru botlarına neyin indekslenip neyin indekslenmeyeceği konusunda talimat verdiği için kullanışlı bir SEO aracıdır.

Ancak, dikkatli kullanmak önemlidir. Yanlış bir yapılandırma, web sitenizin dizininin tamamen kaldırılmasına neden olabileceğinden (örneğin, Disallow: / kullanarak).

Genel olarak, arama motorlarının hassas bilgileri korurken ve yinelenen içerikten kaçınırken sitenizin mümkün olduğunca büyük bir bölümünü taramasına izin vermek iyi bir yoldur. Örneğin, belirli sayfaları veya dizinleri engellemek için Disallow yönergesini veya belirli bir sayfa için bir Disallow kuralını geçersiz kılmak için Allow yönergesini kullanabilirsiniz.

Tüm botların robots.txt dosyasında sağlanan kurallara uymadığını da belirtmekte fayda var, bu nedenle nelerin dizine alınacağını kontrol etmek için mükemmel bir yöntem değildir. Ancak yine de SEO stratejinizde olması gereken değerli bir araçtır.

Bu kılavuzun robots.txt dosyasının ne olduğunu ve nasıl oluşturulacağını öğrenmenize yardımcı olacağını umuyoruz.

Daha fazlası için, diğer yararlı kaynaklara göz atabilirsiniz:

- Yeni Blog Yazarları İçin 15 Eyleme Geçirilebilir Bloglama İpucu

- Uzun Kuyruklu Anahtar Kelimelerin Gücünü Ortaya Çıkarma (Yeni Başlayanlar Kılavuzu)

Son olarak, yeni makalelerle ilgili düzenli güncellemeler için bizi Twitter'da takip edin.