WordPress robots.txt Dosyası… Nedir ve Ne İşe Yarar

Yayınlanan: 2020-11-25Robots.txt dosyasının ne olduğunu ve ne işe yaradığını hiç merak ettiniz mi? Robots.txt, Google ve diğer arama motorları tarafından kullanılan web tarayıcıları (botlar olarak bilinir) ile iletişim kurmak için kullanılır. Onlara web sitenizin hangi bölümlerinin dizine ekleneceğini ve hangilerinin göz ardı edileceğini söyler. Bu nedenle robots.txt dosyası, SEO çabalarınızı gerçekleştirmenize (veya potansiyel olarak bozmanıza!) yardımcı olabilir. Web sitenizin iyi bir sıralamaya sahip olmasını istiyorsanız, o zaman robots.txt dosyasını iyi anlamak çok önemlidir!

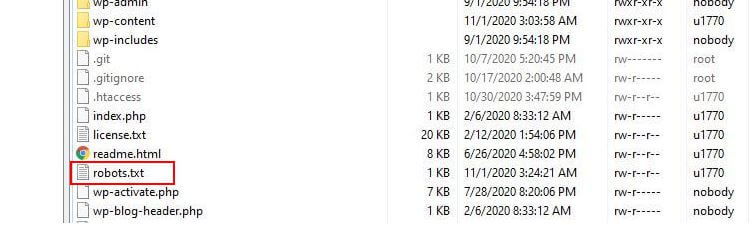

Robots.txt Nerede Bulunur?

WordPress tipik olarak 'sanal' bir robots.txt dosyası çalıştırır, bu da dosyaya SFTP aracılığıyla erişilemediği anlamına gelir. Bununla birlikte, etkialaniniz.com/robots.txt adresine giderek temel içeriğini görüntüleyebilirsiniz. Muhtemelen şöyle bir şey göreceksiniz:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.phpİlk satır, kuralların hangi botlara uygulanacağını belirtir. Örneğimizde yıldız işareti, kuralların tüm botlara uygulanacağı anlamına gelir (örn. Google, Bing ve benzeri).

İkinci satır, /wp-admin klasörüne botların erişimini engelleyen bir kuralı tanımlar ve üçüncü satır, botların /wp-admin/admin-ajax.php dosyasını ayrıştırmasına izin verildiğini belirtir.

Kendi Kurallarınızı Ekleyin

Basit bir WordPress web sitesi için, WordPress tarafından robots.txt dosyasına uygulanan varsayılan kurallar fazlasıyla yeterli olabilir. Bununla birlikte, daha fazla kontrol ve web sitenizi nasıl indeksleyeceğiniz konusunda arama motoru botlarına daha spesifik talimatlar vermek için kendi kurallarınızı ekleme yeteneği istiyorsanız, o zaman kendi fiziksel robots.txt dosyanızı oluşturmanız ve onu kök dizinin altına koymanız gerekir. kurulumunuzun dizini.

robots.txt dosyanızı yeniden yapılandırmak ve bu botların tam olarak ne taramasına izin verileceğini tanımlamak isteyebilecek birkaç neden vardır. Bunun temel nedenlerinden biri, sitenizi tarayan bir bot tarafından harcanan zamanla ilgilidir. Google (ve diğerleri) botların her web sitesinde sınırsız zaman geçirmesine izin vermiyor… trilyonlarca sayfayla, en yararlı bilgileri çıkarmak için botlarının neyi tarayacağı ve neyi görmezden geleceği konusunda daha incelikli bir yaklaşım benimsemek zorundalar. bir web sitesi hakkında.

Botların web sitenizdeki tüm sayfaları taramasına izin verdiğinizde, tarama süresinin bir kısmı önemli olmayan hatta alakalı olmayan sayfalarda harcanır. Bu, onlara sitenizin daha alakalı alanlarında çalışmak için daha az zaman bırakır. Botların web sitenizin bazı bölümlerine erişmesine izin vermeyerek, botların sitenizin en alakalı bölümlerinden (umarız dizine eklenir) bilgi alması için mevcut süreyi artırırsınız. Tarama daha hızlı olduğundan, Google'ın web sitenizi yeniden ziyaret etmesi ve sitenizin dizinlerini güncel tutması daha olasıdır. Bu, yeni blog gönderilerinin ve diğer yeni içeriğin daha hızlı dizine ekleneceği anlamına gelir, bu da iyi bir haberdir.

Robots.txt Düzenleme Örnekleri

robots.txt özelleştirme için bolca alan sunar. Bu nedenle, botların sitenizi nasıl dizine ekleyeceğini belirlemek için kullanılabilecek bir dizi kural örneği sağladık.

Botlara İzin Verme veya İzin Vermeme

İlk olarak, belirli bir botu nasıl kısıtlayabileceğimize bakalım. Bunu yapmak için tek yapmamız gereken yıldız işaretini (*) engellemek istediğimiz bot kullanıcı aracısının adıyla değiştirmek, örneğin 'MSNBot'. Bilinen kullanıcı aracılarının kapsamlı bir listesi burada mevcuttur.

User-agent: MSNBot Disallow: /İkinci satıra bir tire koymak, botun tüm dizinlere erişimini kısıtlayacaktır.

Yalnızca tek bir botun sitemizi taramasına izin vermek için 2 adımlı bir süreç kullanırdık. İlk önce bu botu bir istisna olarak belirledik ve ardından bunun gibi tüm botlara izin vermedik:

User-agent: Google Disallow: User-agent: * Disallow: /Tüm içerikteki tüm botlara erişime izin vermek için şu iki satırı ekliyoruz:

User-agent: * Disallow:Aynı etki, basitçe bir robots.txt dosyası oluşturup ardından onu boş bırakarak da elde edilebilir.

Belirli Dosyalara Erişimi Engelleme

Botların web sitenizdeki belirli dosyaları dizine eklemesini durdurmak mı istiyorsunuz? Bu kolay! Aşağıdaki örnekte, arama motorlarının web sitemizdeki tüm .pdf dosyalarına erişmesini engelledik.

User-agent: * Disallow: /*.pdf$URL'nin sonunu tanımlamak için “$” sembolü kullanılır. Bu büyük/küçük harf duyarlı olduğundan, my.PDF adlı bir dosya taranmaya devam edecektir (CAPS'e dikkat edin).

Karmaşık Mantıksal İfadeler

Google gibi bazı arama motorları, daha karmaşık normal ifadelerin kullanımını anlar. Ancak, tüm arama motorlarının robots.txt dosyasındaki mantıksal ifadeleri anlayamayabileceğini belirtmek önemlidir.

Bunun bir örneği $ sembolünü kullanmaktır. robots.txt dosyalarında bu sembol bir url'nin sonunu belirtir. Bu nedenle, aşağıdaki örnekte, arama botlarının .php ile biten dosyaları okumasını ve dizine eklemesini engelledik.

Disallow: /*.php$Bu, /index.php'nin indekslenemeyeceği, ancak /index.php?p=1 olabileceği anlamına gelir. Bu yalnızca çok özel durumlarda yararlıdır ve dikkatli kullanılması gerekir, aksi takdirde istemediğiniz dosyalara bot erişimini engelleme riskiyle karşı karşıya kalırsınız!

Ayrıca her bot için ayrı ayrı geçerli olan kuralları belirterek farklı kurallar da belirleyebilirsiniz. Aşağıdaki örnek kod, tüm botlar için wp-admin klasörüne erişimi kısıtlarken aynı zamanda Bing arama motoru için tüm siteye erişimi engeller. Bunu mutlaka yapmak istemezsiniz ama bu, bir robots.txt dosyasındaki kuralların ne kadar esnek olabileceğinin yararlı bir gösterimidir.

User-agent: * Disallow: /wp-admin/ User-agent: Bingbot Disallow: /XML Site Haritaları

XML site haritaları, arama botlarının web sitenizin düzenini anlamasına gerçekten yardımcı olur. Ancak faydalı olması için botun site haritasının nerede olduğunu bilmesi gerekir. 'Site haritası yönergesi', arama motorlarına a) sitenizin bir site haritasının bulunduğunu ve b) onu nerede bulabileceklerini özellikle söylemek için kullanılır.

Sitemap: http://www.example.com/sitemap.xml User-agent: * Disallow:Birden çok site haritası konumu da belirtebilirsiniz:

Sitemap: http://www.example.com/sitemap_1.xml Sitemap: http://www.example.com/sitemap_2.xml User-agent:* DisallowBot Tarama Gecikmeleri

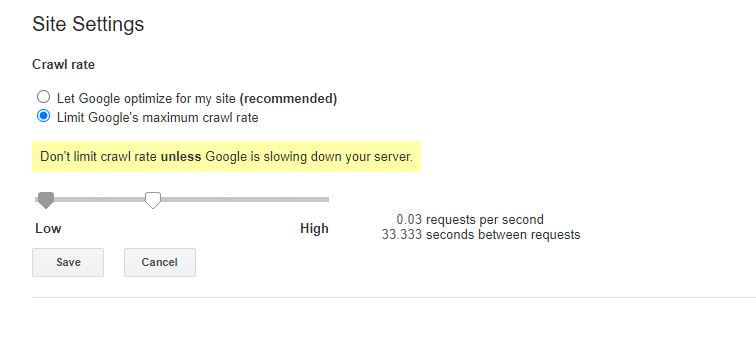

robots.txt dosyası aracılığıyla gerçekleştirilebilecek başka bir işlev, botlara sitenizi taramalarını 'yavaşlatmalarını' söylemektir. Bu, sunucunuzun yüksek bot trafiği seviyeleri tarafından aşırı yüklendiğini tespit ediyorsanız gerekli olabilir. Bunu yapmak için, yavaşlatmak istediğiniz kullanıcı aracısını belirtir ve ardından bir gecikme eklersiniz.

User-agent: BingBot Disallow: /wp-admin/ Crawl-delay: 10Bu örnekteki tırnak sayısı (10), sitenizdeki tek tek sayfaları taramak arasında gerçekleşmesini istediğiniz gecikmedir. Bu nedenle, yukarıdaki örnekte Bing Bot'tan taradığı her sayfa arasında on saniye beklemesini istedik ve bunu yaparken sunucumuza biraz nefes alma alanı sağladık.

Bu belirli robots.txt kuralıyla ilgili tek kötü haber, Google'ın botunun buna saygı göstermemesidir. Bununla birlikte, botlarına Google Arama Konsolu içinden yavaşlama talimatı verebilirsiniz.

robots.txt kuralları hakkında notlar:

- Tüm robots.txt kuralları büyük/küçük harfe duyarlıdır. Dikkatlice yazın!

- Satırın başındaki komuttan önce boşluk olmadığından emin olun.

- robots.txt dosyasında yapılan değişikliklerin botlar tarafından fark edilmesi 24-36 saat sürebilir.

WordPress robots.txt Dosyanızı Test Etme ve Gönderme

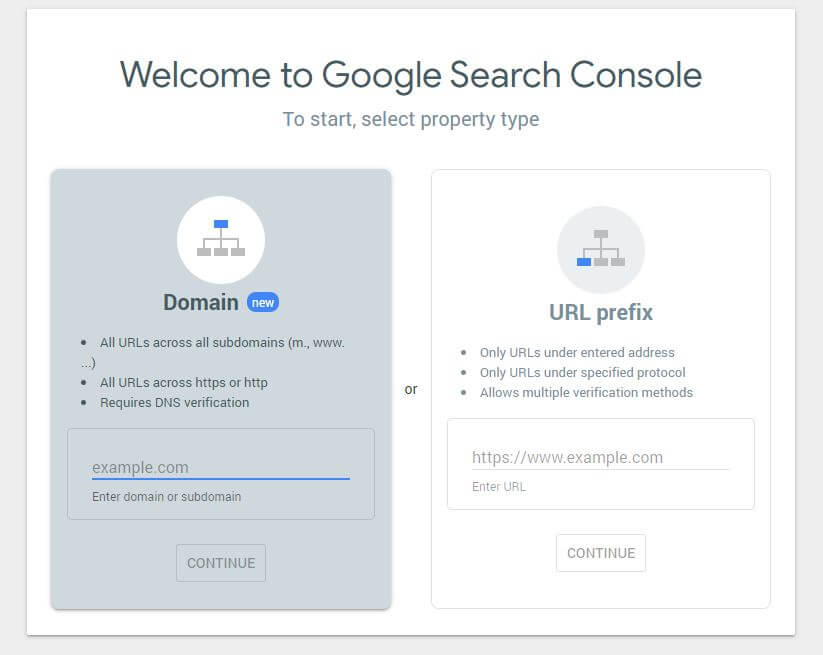

Yeni bir robots.txt dosyası oluşturduğunuzda, içinde hata olup olmadığını kontrol etmeye değer. Bunu Google Arama Konsolunu kullanarak yapabilirsiniz.

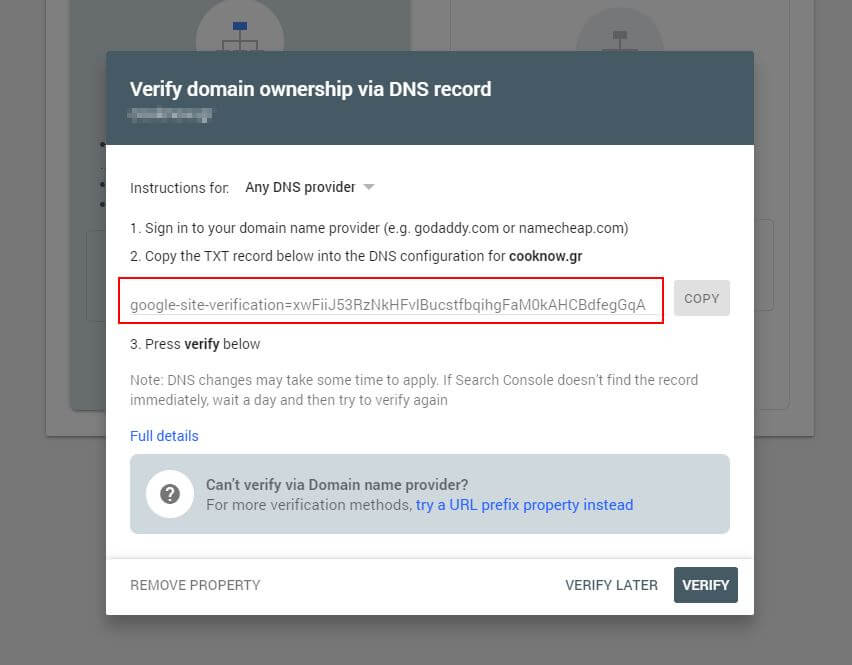

İlk olarak, alan adınızı göndermeniz gerekir (web sitesi kurulumunuz için henüz bir Search Console hesabınız yoksa). Google, etki alanınızı doğrulamak için DNS'nize eklenmesi gereken bir TXT kaydı sağlayacaktır.

Bu DNS güncellemesi yayıldıktan sonra (sabırsız hissederek… DNS'nizi yönetmek için Cloudflare kullanmayı deneyin) robots.txt test cihazını ziyaret edebilir ve robots.txt dosyanızın içeriği hakkında herhangi bir uyarı olup olmadığını kontrol edebilirsiniz.

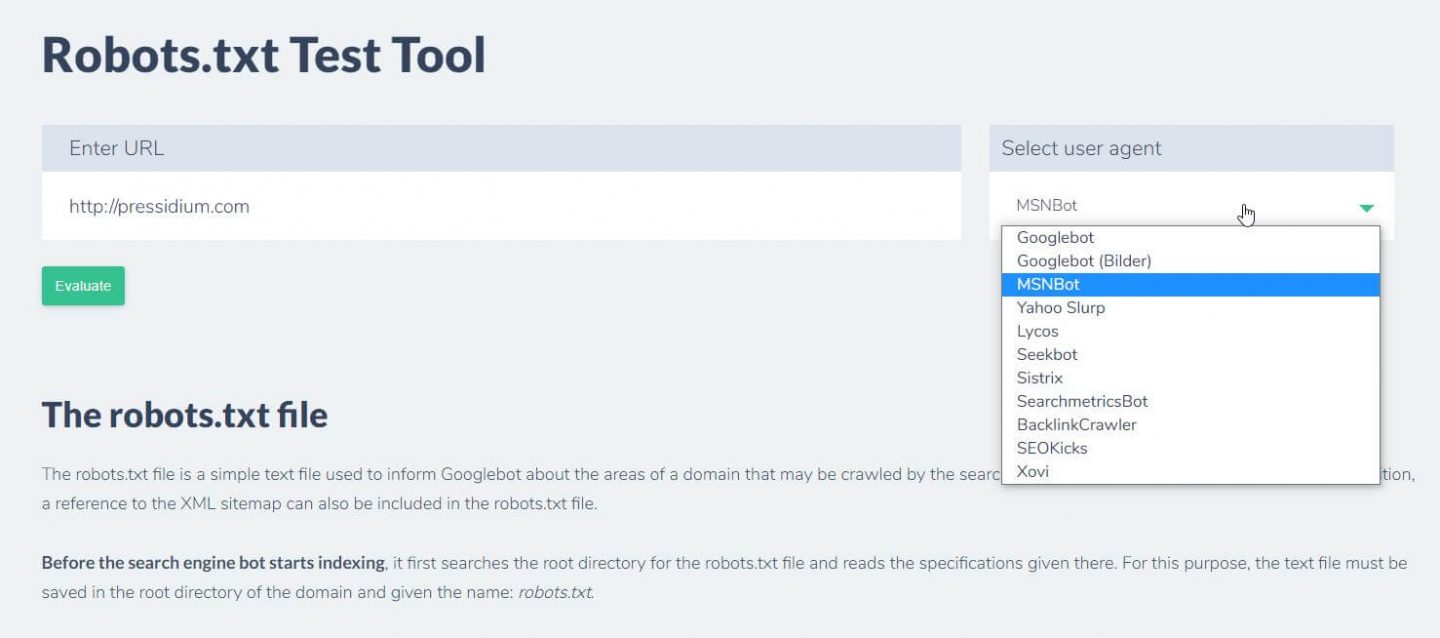

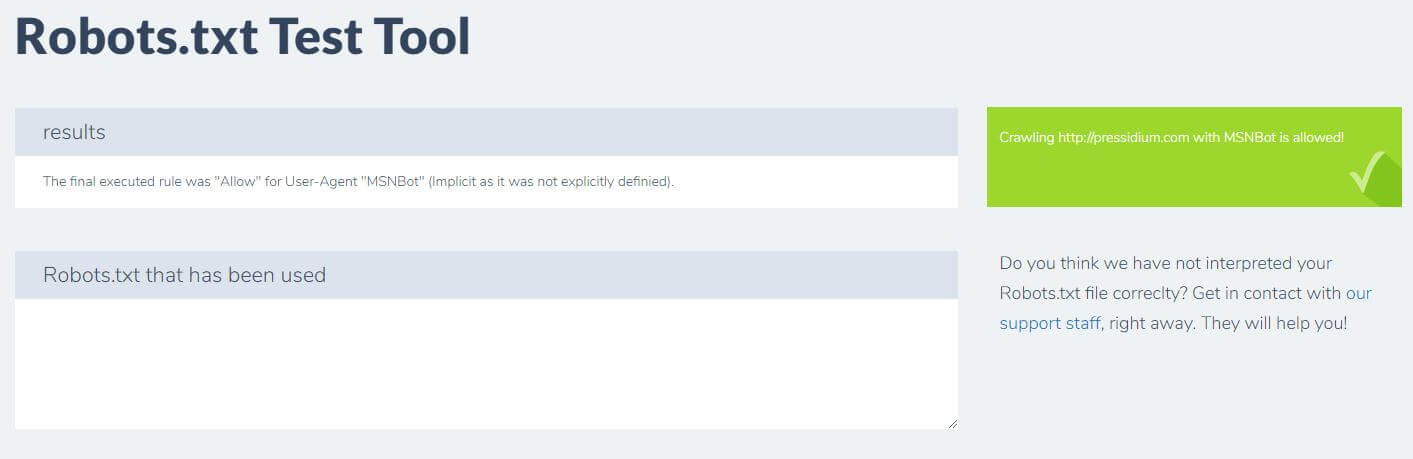

Sahip olduğunuz kuralların istenen etkiye sahip olup olmadığını test etmek için yapabileceğiniz başka bir şey de Ryte gibi bir robots.txt test aracı kullanmaktır.

Sadece etki alanınızı girin ve sağdaki panelden bir kullanıcı aracısı seçin. Bunu gönderdikten sonra sonuçlarınızı göreceksiniz.

Çözüm

Robots.txt'nin nasıl kullanılacağını bilmek, Geliştirici araç setinizdeki başka bir faydalı araçtır. Bu eğitimden alacağınız tek şey robots.txt dosyanızın Google gibi botları engellemediğini kontrol etme yeteneğiyse (ki bunu yapmak istemeniz pek olası değildir), o zaman bu kötü bir şey değil! Aynı şekilde, gördüğünüz gibi robots.txt, web siteniz üzerinde bir gün yararlı olabilecek bir dizi daha ayrıntılı kontrol sunar.