如何针对 SEO 优化您的 WordPress Robots.txt

已发表: 2022-08-23在本博客中,我们将学习一些技巧,说明如何通过优化 robts.txt 文件来改进网站的 SEO。

实际上,Robots.txt 文件在 SEO 方面起着重要作用,因为它告诉搜索引擎如何抓取您的网站。 这就是为什么 Robot.txt 文件被认为是 SEO 最强大的工具之一的原因。

稍后,您还将了解如何为 SEO 构建和优化 WordPress Robots.txt 。

robots.txt 文件是什么意思?

网站所有者创建的文本文件告诉搜索引擎机器人他们如何在他们的网站上爬行并可以索引页面被称为 Robots.txt

实际上,在根目录中,存储了该文件。 此目录也称为您网站的主文件夹。 下面提到的是 robots.txt 文件的文件格式

用户代理:[用户代理名称] Disallow: [不被抓取的 URL 字符串] 用户代理:[用户代理名称] 允许:[要抓取的 URL 字符串] 站点地图:[您的 XML 站点地图的 URL]

要允许或禁止特定 URL,您可以使用不同的指令行。 另外,您也可以添加不同的站点地图。 如果允许 URL,搜索引擎机器人将考虑允许它们抓取页面。

robots.txt 的示例如下所示

用户代理: * 允许:/wp-content/uploads/ 禁止:/wp-content/plugins/ 禁止:/wp-admin/ 站点地图:https://example.com/sitemap_index.xml

在上面给出的示例中,我们允许搜索引擎抓取页面并获取 WordPress 上传文件夹中的索引文件。

在此之后,我们不允许搜索机器人抓取和索引 WordPress 管理文件夹和插件。

最后,我们提到了 XML 站点地图的 URL。

对于您的 WordPress 网站,您是否需要 Robots.txt 文件?

即使您没有文本文件(即 Robots.txt),搜索引擎也会开始抓取您的网页并将其编入索引。 但不幸的是,您无法通知您的搜索引擎它应该抓取哪个特定文件夹或页面。

如果您刚刚创建了一个内容较少的网站或博客,它将不会获利或不会留下任何影响。

但是,一旦您设置了包含大量内容的网站并且当它开始增长时,您将需要控制您网站的已抓取和索引页面。

第一个原因如下

对于每个网站,搜索机器人都有一个抓取配额。

这显然意味着在抓取会话期间,它将抓取特定数量的页面。 假设您网站上的抓取仍然不完整,那么它将再次返回并在另一个会话中恢复抓取。

正因为如此,您网站的网站索引率将是一个摊牌。

您可以通过不允许搜索机器人不抓取此类不必要的页面来解决此问题。 一些不重要的页面可能包括插件文件、WordPress 管理页面和主题文件夹。

可以通过不允许抓取不需要的页面来节省抓取配额。 这一步会更有帮助,因为搜索引擎现在将抓取网站的页面,并能够尽快将它们编入索引。

下面给出了您应该使用和优化 WordPress Robots.txt 文件的另一个原因

每当您需要阻止搜索引擎索引您网站上的页面或帖子时,您都可以使用此文件。

实际上,这是从公众那里覆盖您的网站内容的最不恰当的方式之一,但它将被证明是保护它们出现在搜索结果中的最佳支持。

Robots.txt 文件如何出现?

大多数流行的博客都使用一个非常简单的 robots.txt 文件。 与特定网站的要求相比,内容可能有所不同。

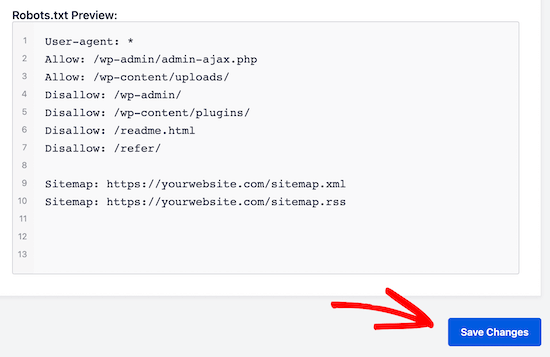

用户代理: * 不允许: 站点地图:http://www.example.com/post-sitemap.xml 站点地图:http://www.example.com/page-sitemap.xml robots.txt 文件将允许所有机器人索引每个内容并提供指向 XML 站点地图网站的链接。 在 robots.txt 文件中提到了需要遵循的以下规则 用户代理: * 允许:/wp-content/uploads/ 禁止:/wp-content/plugins/ 禁止:/wp-admin/ 禁止:/readme.html 禁止:/refer/ 站点地图:http://www.example.com/post-sitemap.xml 站点地图:http://www.example.com/page-sitemap.xml

这将指示机器人索引所有 WordPress 文件和图像。 这将不允许搜索机器人索引 WordPress 管理区域、WordPress 插件文件、附属链接和 WordPress 自述文件。

在 robots.txt 文件中,您可以添加站点地图,以帮助 Google 漫游器识别您网站上的所有页面。

现在您知道 robots.txt 文件的样子,现在我们将了解如何在 WordPress 中创建 robots.txt 文件。

在 WordPress 中,如何构建 robots.txt 文件?

要在 WordPress 中创建 robots.txt 文件,有很多方法。 下面列出了一些顶级方法,您可以选择其中任何一种最适合您。

方法一:使用All in One SEO,修改Robots.txt文件

All in One SEO 是市场上最著名的 WordPress SEO 插件,被超过 100 万个网站使用。

多合一 SEO 插件非常易于使用,因此它提供了 robotx.txt 文件生成器。 优化 WordPress Robots.txt 也很有帮助

如果您尚未集成此 SEO 插件,请先从 WordPress 仪表板安装并激活它。 免费版本也可供初学者用户使用,这样他们就可以在不投资的情况下使用它的功能。

激活插件后,您可以开始使用它直接从您的 WordPress 管理区域构建或修改 robots.txt 文件。

使用它

- 转到多合一 SEO

- 现在编辑 robots.txt 文件,点击工具

- 现在通过单击“启用自定义 robots.txt”,您将打开编辑选项

- 在 WordPress 中,您还可以使用此切换构建自定义 robots.txt 文件。

- 现在,您现有的 robots.txt 文件将由“robots.txt 预览”部分中的“多合一 SEO 插件”显示。 这可以在您的网页屏幕底部查看。

通过 WordPress,添加的默认规则将在此版本中显示

获得的默认规则似乎向您的搜索引擎建议他们不需要抓取核心 WordPress 文件,提供指向 XML 站点地图网站的链接,并允许机器人索引其所有内容。

为了增强您的 robots.txt 的 SEO,可以添加新的自定义规则。

在“用户代理”字段中添加用户代理,以添加规则。 该规则将通过使用 *.

现在选择您是否希望允许或不允许搜索引擎抓取页面。

现在在“目录路径”字段中添加目录路径和文件名。

规则将自动应用到您的 robots.txt。 单击“添加规则”按钮以添加新规则。

除非您创建理想的 robotsx.txt 格式,否则我们建议您添加新规则。

您添加的自定义规则将如下所示

要存储您的更改,请不要错过点击“保存更改”

方法二:通过FTP手动修改Robots.txt文件

优化 WordPress Robots.txt 的另一种方法是利用 FTP 客户端的功能开始修改 robots.txt 文件

您只需要在 FTP 客户端的帮助下连接您的 WordPress 托管帐户

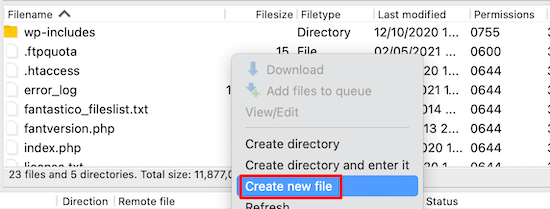

登录后,在网站的根文件夹中,您将能够查看 robots.txt 文件。

如果您无法找到它,则意味着您没有 robots.txt 文件

在这种情况下,您需要创建 robots.txt 文件。

如前所述,robots.txt 文件通常是一个简单的文本文件,可以下载到您的计算机上。 但是,您甚至可以借助 TextEdit、记事本或写字板等纯文本编辑器对其进行修改。

一旦您执行了所有更改,现在是时候保存它了。 您可以将此文件上传到您网站的根文件夹。

如何对 Robots.txt 文件进行测试?

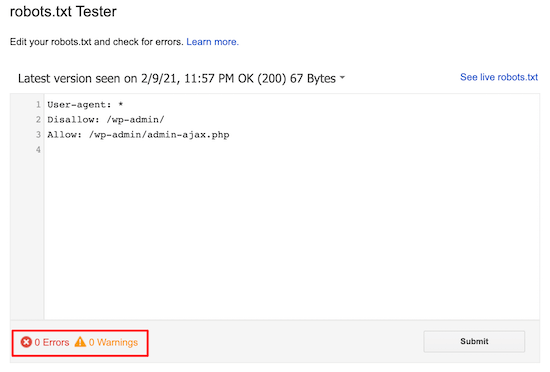

您可以在 robots.txt 测试工具的帮助下执行测试。

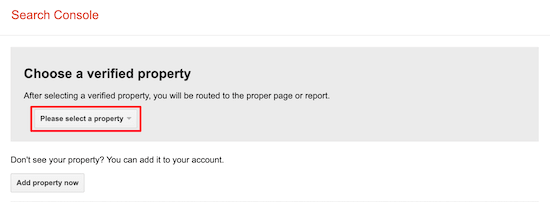

在网上,你会发现很多 robots.txt 测试工具。 最好的之一是谷歌搜索控制台。

要使用此工具,您首先需要有一个与 Google 搜索控制台连接的网站。 在此之后,您可以开始使用它的功能。

从下拉列表中,您只需选择您的属性。

但是,它会自动选择您网站的 robots.txt 文件,并突出显示所有警告和错误。 这是帮助您轻松优化 WordPress Robots.txt 文件的最佳工具之一。

结论:

优化此 robots.txt 文件的主要座右铭是保护页面不被抓取。 例如 WordPress 管理文件夹中的页面或 wp-plugin 文件夹中的页面。

最常见的误区是,你可以通过屏蔽 WordPress 类别、实现页面和标签来提高爬取率并使其索引更快并获得更高的排名。

但这不起作用,因为根据 Google 的网站管理员指南,它会出错。

我们强烈建议您阅读并考虑上述所有要点。

我们希望本博客能帮助您使用适合您网站的格式创建 robots.txt 文件。 它将帮助您优化 WordPress Robots.txt。