如何使用 Yoast SEO 优化 WordPress Robots.txt 以进行 SEO

已发表: 2023-10-25搜索引擎优化 (SEO) 是构建有效网站的关键部分,而实现 SEO 成功的最重要因素之一是使用正确的工具来优化您的网站。 其中一种工具是 Robots.txt 文件,它控制搜索引擎爬网程序如何访问和索引您的内容。

优化您的 WordPress Robots.txt 文件可以帮助您获得更好的搜索引擎排名、提高网站的可见性并增加流量。

然而,尽管它很重要,但许多网站所有者并不熟悉如何正确配置其 Robots.txt 文件。 在这篇博文中,我们将指导您了解掌握 WordPress Robots.txt 进行 SEO 所需了解的一切,并释放网站 SEO 的全部潜力。

了解 robots.txt 在 SEO 中的作用

了解 robots.txt 文件在搜索引擎优化中的功能对于充分利用 WordPress 网站优化工作并生成最佳结果至关重要。 名为 Robots.txt 的文本文件(也可能称为机器人排除协议)向搜索引擎爬网程序提供应爬行和索引网站的哪些区域的说明。

当搜索引擎的机器人访问您的网站时,它们做的第一件事就是在根目录中检查名为 robots.txt 的文件。 该文件充当机器人的指南,向它们提供有关允许其访问以及不允许访问的网站和文件的建议。

如果正确配置 robots.txt 文件,您可以完全控制向搜索引擎显示的内容以及向搜索引擎隐藏的内容。

您网站的扫描效率主要应通过使用 robots.txt 文件来提高。 它可以帮助搜索引擎机器人专注于对网站最重要的部分进行爬网和索引,从而避免在非必要网站或不应向公众提供的敏感材料上浪费资源。

Robots.txt 文件到底是什么?

一个名为 Robots.txt 的简单文本文件将搜索引擎使用的网络爬虫引导至您网站上的某些网页。 此外,它还指示机器人不要抓取某些网站。

在我们继续深入分析本文之前,您必须了解搜索引擎的操作。

抓取、索引和排名是搜索引擎执行的三个主要活动。

搜索引擎做的第一件事就是在整个万维网上派遣网络爬虫,也称为蜘蛛或机器人。 这些程序被称为机器人,是智能软件,它们在整个网络上爬行以搜索新的连接、页面和网站。 爬行是指在网络上搜索内容的过程的术语。

您网站的页面将被组织成一个数据结构,可以在机器人发现它们后使用。 索引是这个过程的名称。

最终,一切都归结为排名。 当用户输入搜索查询时,搜索引擎应该根据用户正在寻找的内容向用户提供可以找到的最佳且最相关的信息。

Robots.txt 文件看起来如何?

robots.txt 文件是网站结构和功能的重要组成部分,但您有没有想过它实际上是如何显示的?

该文件适用于访问该网站的所有搜索引擎机器人,如用户代理后面的星号所示。 每个搜索引擎都使用不同的用户代理来探索互联网。

例如,Google 利用 Googlebot 为您的网站内容编制索引以供 Google 搜索。 这些用户代理的数量有数百个。 可以为每个用户代理配置自定义指令。 例如,robots.txt 文件的第一行应该是:“如果您想为 Googlebot 设置特定指令,它将被称为用户代理:Googlebot。

抓取预算到底是什么?

抓取预算是指搜索引擎在给定时间范围内愿意在网站上抓取的页面数量。 它由网站的权威性、受欢迎程度以及服务器处理抓取请求的能力等多种因素决定。 此外,您应该确保尽可能有效地利用您网站的抓取预算。

如果您的网站有多个页面,那么机器人肯定首先会抓取最重要的页面。 因此,您必须在 robots.txt 文件中明确说明这一点。

如何在WordPress中找到并编辑robots.txt文件?

在 WordPress 中查找并编辑 robots.txt 文件是针对搜索引擎优化网站的关键一步。 通过正确配置此文件,您可以控制搜索引擎爬网程序可以访问网站的哪些部分,确保它们专注于最重要的页面和内容。

要在 WordPress 中找到并编辑 robots.txt 文件,请按照以下简单步骤操作:

1. 登录您的 WordPress 仪表板。

2. 导航至左侧菜单上的“设置”选项卡。

3. 点击“阅读”进入阅读设置。

4. 向下滚动直到找到“搜索引擎可见性”部分。

5. 在这里,您将看到一个选项,显示“阻止搜索引擎为此网站建立索引”。 确保未选中此选项,因为它将生成一个基本的 robots.txt 文件,该文件限制搜索引擎对您的整个网站的访问。

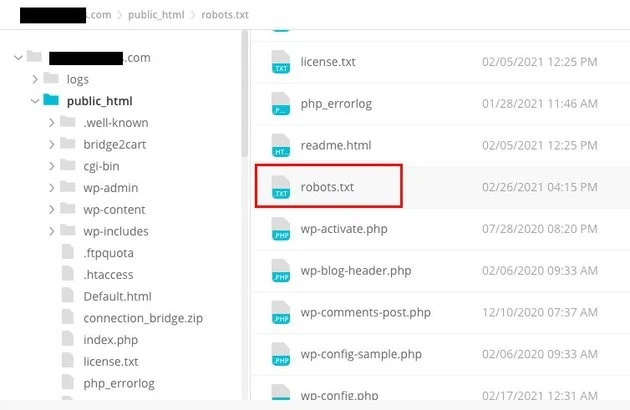

6. 如果您想进一步自定义 robots.txt 文件,可以通过访问网站的根目录来实现。 这通常可以通过 FTP 客户端或 cPanel 文件管理器来完成。

7. 找到根目录后,查找名为“robots.txt”的文件。

8. 将现有 robots.txt 文件的副本下载到您的计算机作为备份,以防编辑过程中出现任何问题。

9. 使用文本编辑器打开 robots.txt 文件。

10. 根据您的需要自定义文件。 您可以添加特定指令以允许或禁止访问站点的某些区域。 例如,您可以通过添加以下行来阻止搜索引擎抓取您的管理区域:

1. 禁止:/wp-admin/

11. 保存对 robots.txt 文件的更改并将其上传回您网站的根目录,替换以前的版本。

12. 最后,使用 Google 的 robots.txt 测试工具或其他类似工具测试您的 robots.txt 文件,以确保其配置正确。

在 WordPress 中,可以通过识别和修改适当位置的 robots.txt 文件来控制搜索引擎爬虫与您的网站交互的方式。 这将使您在网站的可见性和排名方面获得最佳结果。 如果您投入时间学习并成为搜索引擎优化 (SEO) 这方面的专家,您将顺利为您的 WordPress 网站带来成功。

如何在 WordPress 中创建 Robots.txt 文件?

既然我们已经讨论了 robots.txt 文件是什么以及为什么它如此重要,那么让我们继续创建一个用于 SEO 的 WordPress Robots.txt。 WordPress 为您提供了两个不同的选项来生成 robots.txt 文件。 第一种方法涉及使用 WordPress 插件,而第二种方法涉及手动将文件上传到网站的根文件夹。

第1步:这是使用Yoast SEO插件创建Robots.txt文件

您可以利用 SEO 插件来帮助您优化基于 WordPress 构建的网站。 这些插件中的大多数在其安装包中提供了自己的 robots.txt 文件生成器。

首先,下载并安装插件。

导航到插件菜单并单击“添加新插件”。 下一步是寻找 Yoast SEO 插件,下载它,如果还没有,请将其打开。

第二步创建robots.txt文件

使用 Yoast 创建 robots txt 文件

您会注意到使用一些默认指令创建的文件。

Yoast SEO 的 robots.txt 文件生成器将自动包含以下指令:

用户代理:* 不允许:/wp-admin/ 允许:/wp-admin/admin-ajax.php

向 robots.txt 添加额外的说明。 编辑 robots.txt 后,单击“保存”。

输入您的域名和“/robots.txt”。 如果浏览器显示默认指令,则您的 robots.txt 文件已完成,如下所示。

生成机器人txt文件

我们还建议您在 robots.txt 中添加站点地图 URL。

默认机器人txt文件

启用插件后,转到 Yoast SEO > 工具,然后从下拉菜单中选择文件编辑器。 继续填写您的域名,然后添加“/robots.txt”。 如果您查看浏览器,您会注意到显示了一些默认指令。

步骤2:使用FTP手动创建Robots.txt文件

- 该过程的下一步是在本地计算机上创建 robots.txt 文件,然后将其上传到 WordPress 网站的根文件夹。

- 除此之外,您还需要通过使用 Filezilla 等 FTP 程序访问您的 WordPress 托管。 如果您还没有登录所需的凭据,您可以通过托管服务的控制面板访问这些凭据。 因此,您可以在使用 FTP 程序登录后检查网站根文件夹中是否存在 robots.txt 文件。

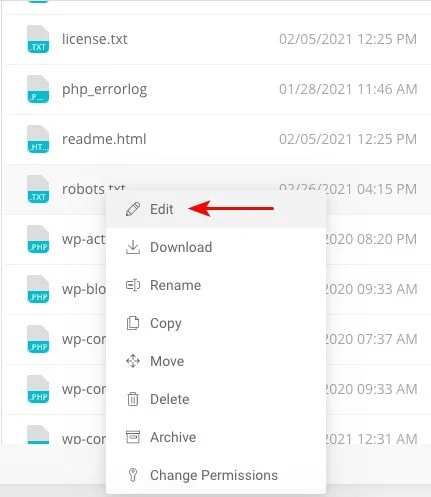

- 右键单击该文件并选择编辑(如果存在)。

因此,当您成功登录 FTP 客户端后,您将能够检查网站根文件夹中是否存在 robots.txt 文件。 输入您的域名,后跟“/robots.txt”是确定文件是否上传成功的最佳方法。

进行更改后,单击“保存”。

如果该文件尚不存在,则必须创建该文件。 可以通过使用记事本等基本文本编辑器将指令添加到文件中来完成。 例如

用户代理:* 不允许:/wp-admin/ 允许:/wp-admin/admin-ajax.php

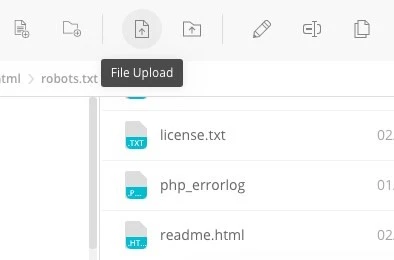

单击 FTP 客户端中的“文件上传”,将文件上传到网站的根文件夹。

输入您的域名和“/robots.txt”以查看您的文件是否已成功上传。

这是手动将 robots.txt 文件上传到 WordPress 网站的方法!

Robots.txt:知道它的优点和缺点

使用 robots.txt 文件的好处

它指示搜索引擎不要将时间花在您不希望被索引的网站上,这有助于优化搜索引擎的抓取预算。 通过这样做,您可以增加搜索引擎抓取对您最重要的网站的可能性。

阻止以这种方式浪费 Web 服务器资源的机器人有助于优化服务器。

它对于隐藏感谢页面、登陆页面、登录页面和其他不需要搜索引擎索引的页面非常有用。

robots.txt 文件的负面影响

您现在应该可以使用此处提供的信息在任何网站上查看 robots.txt 文件。 这并不难理解。 只需输入域名,然后输入“/robots.txt”,然后按 Enter 键即可。

然而,这在某种程度上也存在危险。 用于 SEO 的 WordPress Robots.txt 文件可能包含您网站的某些内部页面的 URL,您不希望这些页面被搜索引擎索引。

例如,可能有一个登录页面出于某种原因您不希望被索引。 然而,robots.txt 文件中提到的这一事实使得攻击者有可能看到该网站。 如果您试图隐藏某些敏感信息,同样的情况也适用。

即使您在编写 robots.txt 文件时犯了一个拼写错误,它也会导致您所有的搜索引擎优化 (SEO) 工作付诸东流。 即使文件很容易创建,情况也是如此。

Robots.txt 文件的放置位置

假设此时您熟悉 robots.txt 文件的插入位置。

您网站的 robots.txt 文件应始终位于网站的根目录中。 如果您的域名是 yourdomain.com,则您网站上的 robots.txt 文件的 URL 将为 https://yourdomain.com/robots.txt。

除了将 robots.txt 文件放置在网站的根目录中之外,以下是应遵循的其他一些建议做法:

- 将文件命名为 robots.txt 是非常有必要的。

- 名字大写很重要。 因此,您需要正确获取它,否则它将无法发挥作用。

- 每条指令需要放在单独的行上。

- 当 URL 完整时,应标有“$”符号。

- 每个用户代理只能使用一个实例。

- 为了向人们提供 robots.txt 文件内容的解释,请使用注释,每行以井号 (#) 开头。

测试和验证您的 robots.txt 文件

测试和验证 robots.txt 文件是确保搜索引擎正确抓取您的网站并将其编入索引的关键步骤。 优化良好的robots.txt文件可以防止搜索引擎访问敏感或不相关的页面,提高抓取效率,并最终增强网站的整体性能。

要开始测试您的 robots.txt 文件,您可以利用专门为此目的设计的各种在线工具。 这些工具允许您输入 robots.txt 指令并模拟搜索引擎如何解释和遵循它们。

通过分析结果,您可以识别文件中的任何潜在问题或错误配置。 定期监控和更新 robots.txt 文件至关重要,尤其是在更改网站结构或内容时。

通过保持警惕,您可以快速识别并纠正可能出现的任何问题。 这种细致的方法最终将有助于提高您网站的可感知性、索引度以及在数字领域的整体成功。

我们在这里建议的工具是 Google Search Console

您可以通过转到“立即添加资源”链接并按照屏幕上显示的简单说明操作,将您的网站添加到 Google Search Console。 完成后,标有“请选择属性”的下拉菜单将在选项中包含您的网站。

选择网站后,该工具将自动获取与您的网站关联的 robots.txt 文件,并突出显示任何错误或警告(如果有)。

您的 WordPress 网站需要 Robots.txt 文件吗?

事实上,您的 WordPress 网站确实需要 robots.txt 文件。 即使您的网站没有 robots.txt 文件,搜索引擎仍然会对其进行抓取和索引。 既然我们已经讨论了 robots.txt 的用途、工作方式和抓取预算,那么您为什么要省略其中一项呢?

搜索引擎通过 robots.txt 文件接受训练,了解哪些内容可以抓取,更重要的是,哪些内容不可以抓取。

考虑到抓取预算的负面后果是添加 robots.txt 的主要原因之一。

如前所述,每个网站都有一个抓取预算。 这一切都取决于机器人在单个会话中访问的站点数量。 如果机器人在该会话中未完成网站上的所有页面,它将返回并在后续会话中继续抓取。

此外,这还会降低您的网站被索引的速度。

您可以通过阻止搜索机器人扫描媒体资产、主题目录、插件和无关网站来快速解决此问题,从而节省抓取配额。

最后的话

在处理您的网站时,我们会优先考虑内容优化、关键字研究、构建反向链接、创建 sitemap.xml 以及其他 SEO 相关任务。 WordPress Robots.txt 对于 SEO 来说是一些网站站长忽视的一个方面。

当您的网站首次启动时,robots.txt 文件可能不是很重要。 话虽这么说,当您的网站变得更大并拥有更多页面时,如果我们开始使用推荐的 robots.txt 文件,将会获得丰厚的回报。