如何輕鬆優化WordPress Robots.txt?

已發表: 2023-02-28介紹

有許多技術可以提高您網站的搜索引擎優化。 優化 WordPress Robots.txt 是最好的方法之一。 由於它允許搜索引擎掃描您的網站,因此 Robots.txt 文件是眾所周知的強大 SEO 工具。 因此,您可以通過調整 Robots.txt 文件自由地改進站點的 SEO。 我們將在今天的這篇博文中明確介紹一些優化 WordPress Robots.txt 的方法。

Robots.txt文件的定義

以下是 WordPress 的 Robots.txt 文件的摘要。

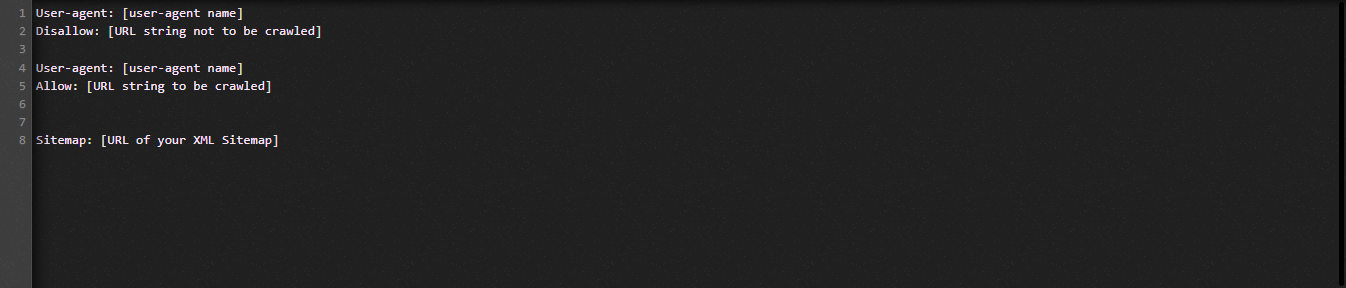

現在讓我們看一下 Robot.txt 文件的基本結構:

讓我們為您定義 Robots.txt 文件中使用的術語:

- User-agent:爬蟲的名字

- 禁止:阻止抓取網站的頁面、文件夾或文件。

- 允許:啟用目錄、文件和頁面抓取

- 站點地圖(如果提供):顯示站點地圖的位置:代表數字或字母。

- *:代表數字或字符

- $:您可以使用它來限制包含特定擴展名的網頁,方法是站在該行的末尾。

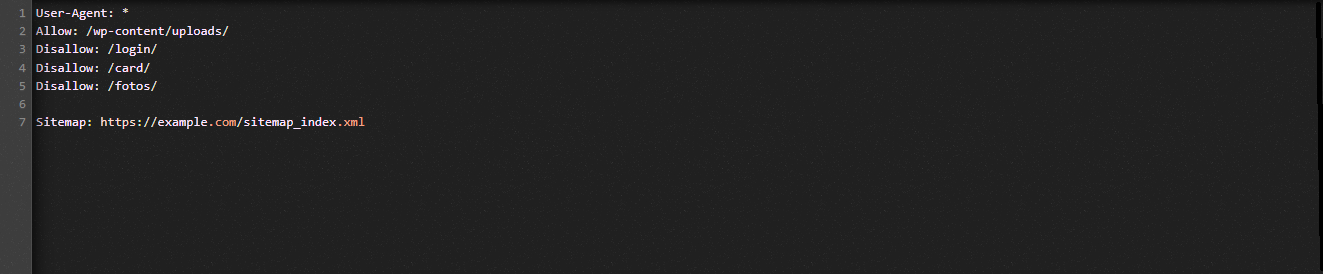

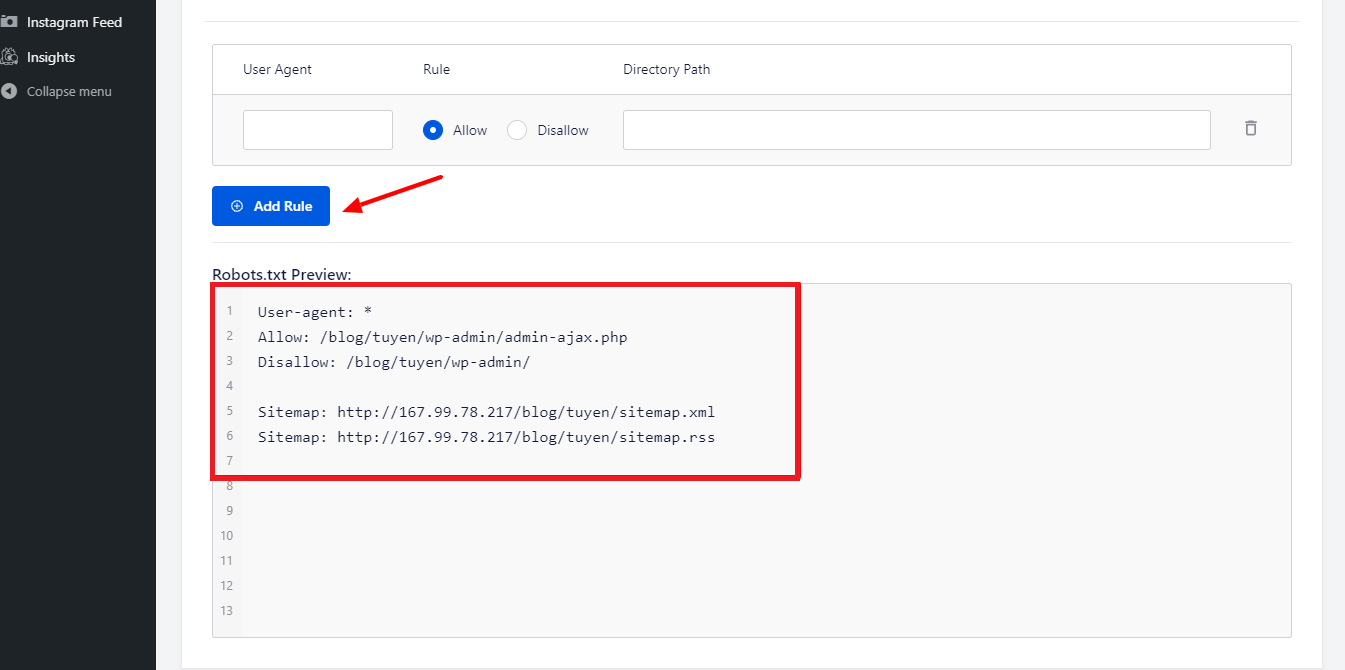

讓我們看下圖來幫助您理解:

在 Robot.txt 示例中,我們允許搜索引擎抓取 WordPress 上傳文件夾中的文件。

但是,我們限制搜索引擎訪問登錄名、卡片和照片文件夾。

最後,我們為它提供站點地圖的 URL。

為什麼要為您的 WordPress 網站創建 Robots.txt 文件?

如果沒有 Robots.txt 文件,搜索引擎仍會抓取網站的每個頁面並為其編制索引。 然而,他們會抓取您網站上的所有資料,而不僅僅是您指定的文件夾或頁面。

出於兩個主要原因,您應該為您的網站創建一個 Robots.txt 文件。 首先,您可以在它的幫助下毫不費力地管理您網站上的所有信息。 頁面或目錄是否應該被爬網或索引由您決定。 這意味著諸如插件文件、管理頁面或主題目錄之類的頁面不會被搜索引擎抓取。 因此,它將有助於您網站的索引加載速度。

防止不需要的帖子或頁面被搜索引擎索引的要求是另一個理由。 因此,您可以輕鬆方便地阻止 WordPress 頁面或帖子出現在搜索結果中。

如何更高效地優化WordPress Robots.txt

在此教學博客中,我們將向您展示如何使用兩種不同的方法在您的 WordPress 網站上創建和改進 Robots.txt 文件:

- 使用插件更改 Robots.txt 文件:All in One SEO

- 使用 FTP 手動編輯 Robots.txt 文件

要使 Robots.txt 文件更有效,請使用 All in One SEO 插件。

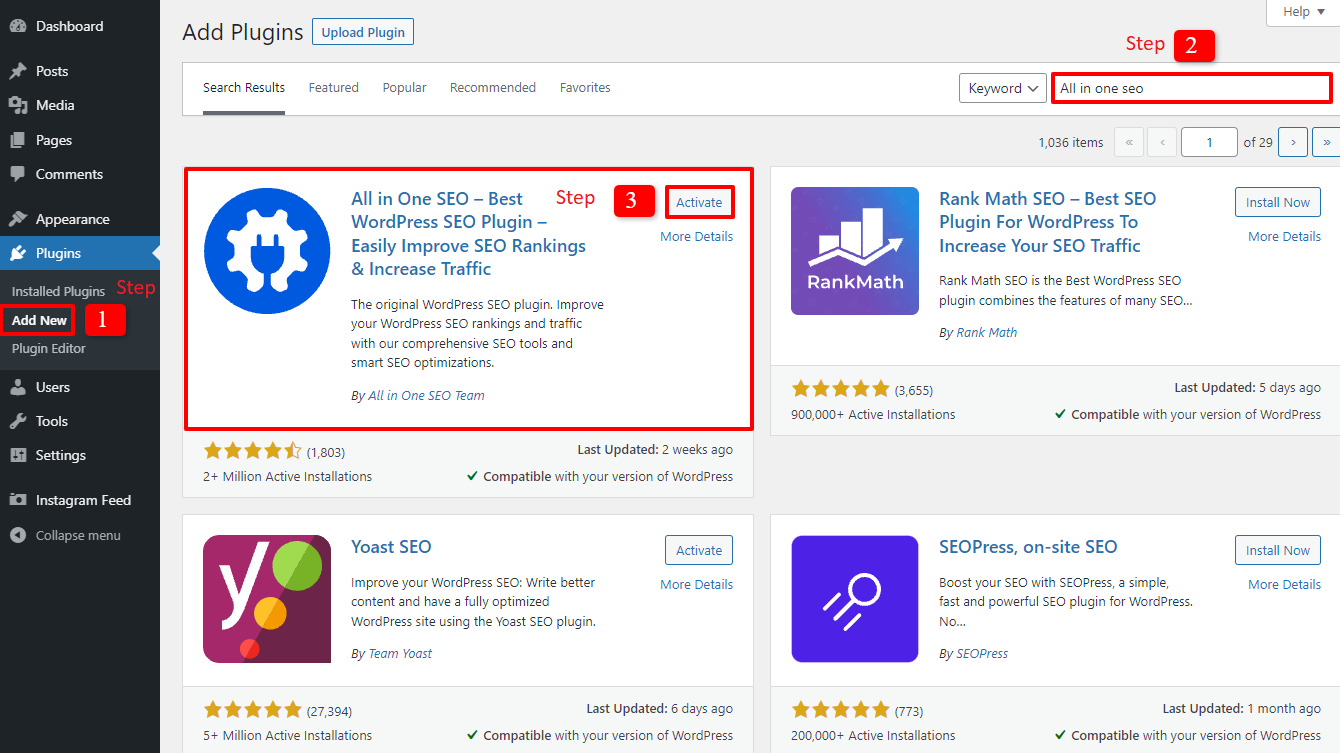

在 WordPress 市場上有幾個 WordPress SEO 插件可以幫助您解決這個問題。 但在本文中,我們選擇使用 All in One SEO(一個擁有超過 200 萬用戶的廣受歡迎的插件)來幫助您。

讓我們先通過選擇Plugins -> Add New來安裝它。 然後查找插件的名稱,安裝它,然後激活它。

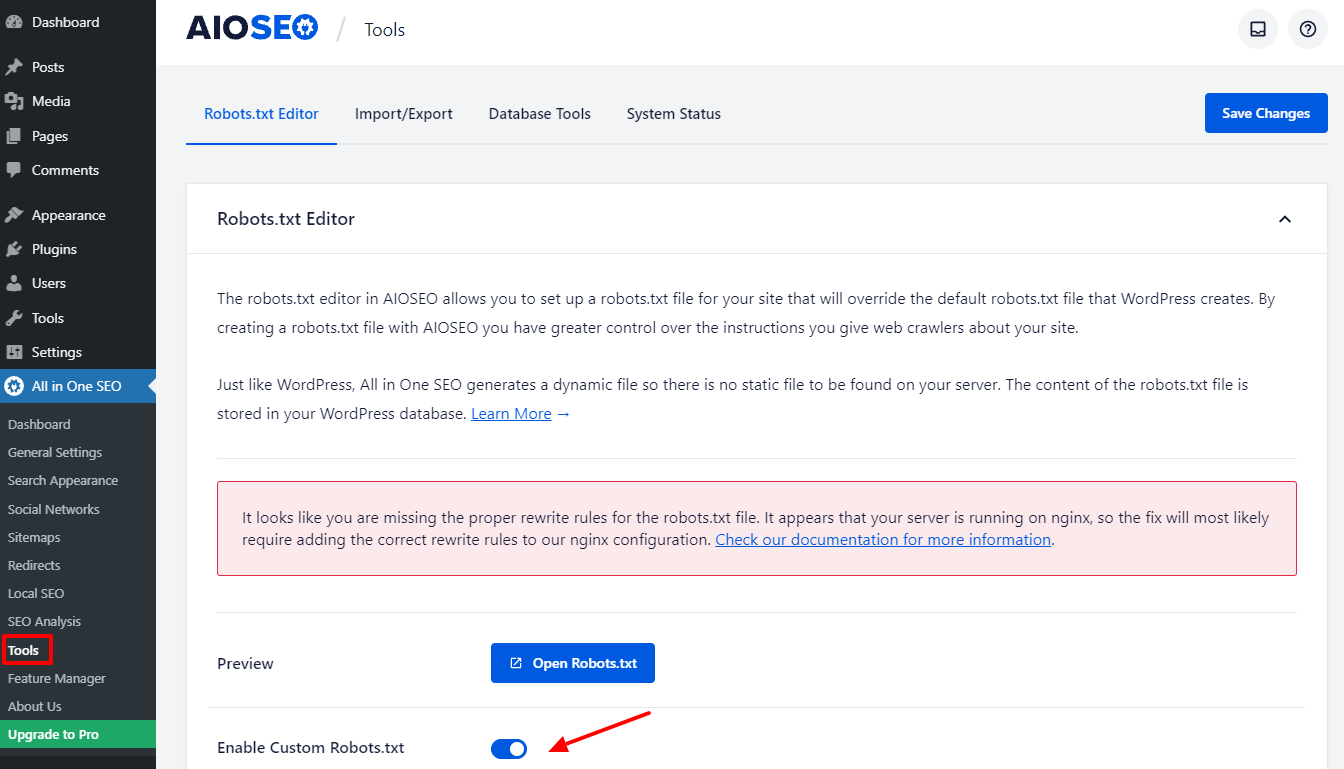

完成幾個簡單的步驟後,您將返回到管理儀表板。 立即轉到All in one SEO -> Tools 。

讓我們切換 Robots.txt 編輯器部分中的啟用自定義 Robots.txt按鈕以使其處於活動狀態。 開啟後,您可以在 WordPress 中編輯默認的 Robots.txt 文件。

當我們向下滾動時,您會注意到該插件顯示一個框,其中包含 Robots.txt 文件的預覽。 這些是 WordPress 的默認規則。

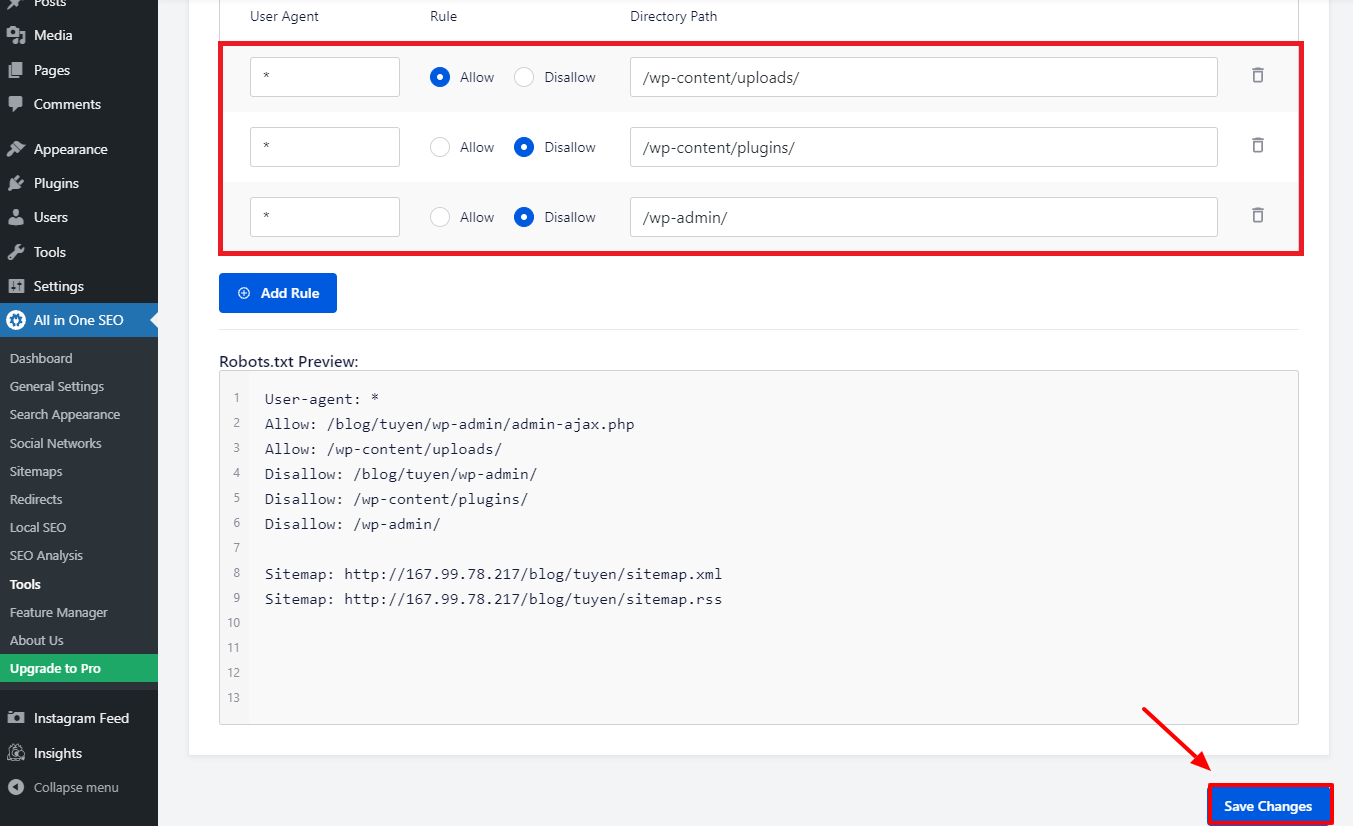

通過選擇“添加規則”按鈕,您可以添加更多您自己的特定規則來幫助您網站的 SEO。

讓我們在User-Agent字段中輸入 * 以將規則應用於所有用戶代理以添加新規則。

您只需要選擇允許或不允許搜索機器人在下一階段進行爬行。

之後不要忘記在“目錄路徑”字段中輸入文件名或目錄路徑。

完成所有首選項後,讓我們按下“保存更改”按鈕。

您已經添加的所有附加規則現在將立即應用於 Robots.txt 文件。

使用FTP手動修改和優化WordPress Robots.txt

這是您可能會喜歡的一種不同的 WordPress Robots.txt 優化方法。 您必須使用 FTP 客戶端編輯 Robots.txt 文件才能實現此目的。

為了方便使用 FPT 客戶端,讓我們首先建立與您的 WordPress 主機帳戶的連接。 當您訪問網站的根文件夾時,您可以很容易地註意到 Robots.txt 文件。 讓我們通過單擊鼠標右鍵來選擇查看/編輯。

另一方面,如果找不到,您可能什麼也沒有。 因此,讓我們首先通過使用鼠標右鍵選擇創建新文件來為您的網站創建一個 Robots.txt 文件。

Robots.txt 文件是純文本文件,因此您可以下載它並使用純文本編輯器(如記事本或 TextEdit 等)對其進行編輯。 之後您只需將其上傳回您網站的根文件夾即可。 看起來很容易,你不覺得嗎?

確保您的 WordPress 站點的 Robots.txt 文件正在運行。

一旦準備好並配置好 Robots.txt 文件,就必須對其進行測試,以便識別和報告任何問題。 因此,您必須使用 Robots.txt 測試器工具對其進行測試。 試試 Google Search Console,我們強烈推薦它。

如果您想使用此服務,您必須確保您的網站已鏈接到 Google Search Console。 然後,您可以通過從選擇列表中選擇屬性來使用機器人測試工具。 現在將自動添加您網站的 Robots.txt 文件。 如果有錯誤,它會提醒你。

結論

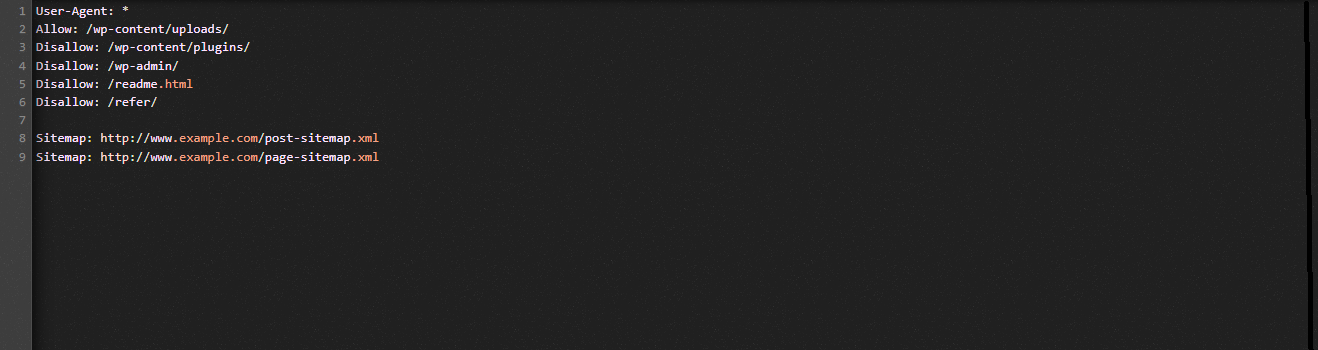

總體而言,優化 Robots.txt 文件的主要目標是阻止搜索機器人訪問公眾不需要的頁面,包括插件文件夾或管理文件夾。 因此,阻止 WordPress 標籤、類別或存檔頁面對您的 SEO 沒有幫助。 換句話說,要為您的 WordPress 網站創建一個完美的 Robots.txt 文件,您應該遵循以下模式。

我們希望您會發現今天的博文對優化 WordPress Robots.txt 有所幫助。 請記住將其轉發給您的熟人和其他網站管理員。 另外,如果您有任何問題,請在下方留言。 因此,我們會盡快回复您。 是時候優化 WordPress Robots.txt 了。 直到未來的博客,保重。

順便說一下,我們有大量現代的、吸引人的、免費的 WordPress 主題,它們完全支持這個有用的功能。 我們去見他們,請其中一位重新設計您的網站