如何使用 Yoast SEO 優化 WordPress Robots.txt 以進行 SEO

已發表: 2023-10-25搜尋引擎優化 (SEO) 是建立有效網站的關鍵部分,而實現 SEO 成功的最重要因素之一是使用正確的工具來優化您的網站。 其中一個工具是 Robots.txt 文件,它控制搜尋引擎爬網程式如何存取和索引您的內容。

優化您的 WordPress Robots.txt 檔案可以幫助您獲得更好的搜尋引擎排名、提高網站的可見度並增加流量。

然而,儘管它很重要,但許多網站所有者並不熟悉如何正確配置其 Robots.txt 檔案。 在這篇文章中,我們將引導您了解掌握 WordPress Robots.txt 進行 SEO 所需了解的一切,並釋放網站 SEO 的全部潛力。

了解 robots.txt 在 SEO 中的作用

了解 robots.txt 檔案在搜尋引擎優化中的功能對於充分利用 WordPress 網站優化工作並產生最佳結果至關重要。 名為 Robots.txt 的文字檔案(也可能稱為機器人排除協議)向搜尋引擎爬網程式提供應爬行和索引網站的哪些區域的說明。

當搜尋引擎的機器人造訪您的網站時,它們做的第一件事就是在根目錄中檢查名為 robots.txt 的檔案。 該文件充當機器人的指南,向它們提供有關允許其訪問以及不允許訪問的網站和文件的建議。

如果正確配置 robots.txt 文件,您可以完全控制向搜尋引擎顯示的內容以及向搜尋引擎隱藏的內容。

您網站的掃描效率主要應透過使用 robots.txt 檔案來提高。 它可以幫助搜尋引擎機器人專注於對網站最重要的部分進行爬網和索引,從而避免在非必要網站或不應向公眾提供的敏感資料上浪費資源。

Robots.txt 檔案到底是什麼?

一個名為 Robots.txt 的簡單文字檔案將搜尋引擎使用的網路爬蟲引導至您網站上的某些網頁。 此外,它還指示機器人不要抓取某些網站。

在我們繼續深入分析本文之前,您必須了解搜尋引擎的操作。

抓取、索引和排名是搜尋引擎執行的三個主要活動。

搜尋引擎做的第一件事就是在整個萬維網上派遣網路爬蟲,也稱為蜘蛛或機器人。 這些程式被稱為機器人,是智慧軟體,它們在整個網路上爬行以搜尋新的連接、頁面和網站。 爬行是指在網路上搜尋內容的過程的術語。

您網站的頁面將被組織成一個資料結構,可以在機器人發現它們後使用。 索引是這個過程的名稱。

最終,一切都歸結於排名。 當使用者輸入搜尋查詢時,搜尋引擎應該根據使用者正在尋找的內容向使用者提供可以找到的最佳且最相關的資訊。

Robots.txt 檔案看起來如何?

robots.txt 檔案是網站結構和功能的重要組成部分,但您有沒有想過它實際上是如何顯示的?

該文件適用於訪問該網站的所有搜尋引擎機器人,如用戶代理後面的星號所示。 每個搜尋引擎都使用不同的用戶代理來探索互聯網。

例如,Google 利用 Googlebot 為您的網站內容編制索引以供 Google 搜尋。 這些用戶代理的數量有數百個。 可以為每個使用者代理程式配置自訂指令。 例如,robots.txt 檔案的第一行應該是:「如果您想為 Googlebot 設定特定指令,它將被稱為使用者代理:Googlebot。

抓取預算到底是什麼?

抓取預算是指搜尋引擎在給定時間範圍內願意在網站上抓取的頁面數量。 它由網站的權威性、受歡迎程度以及伺服器處理抓取請求的能力等多種因素決定。 此外,您應該確保盡可能有效地利用您網站的抓取預算。

如果您的網站有多個頁面,那麼機器人肯定會先抓取最重要的頁面。 因此,您必須在 robots.txt 檔案中明確說明這一點。

如何在WordPress中找到並編輯robots.txt檔案?

在 WordPress 中尋找並編輯 robots.txt 檔案是針對搜尋引擎優化網站的關鍵一步。 透過正確配置此文件,您可以控制搜尋引擎爬網程式可以存取網站的哪些部分,確保它們專注於最重要的頁面和內容。

要在 WordPress 中找到並編輯 robots.txt 文件,請按照以下簡單步驟操作:

1. 登入您的 WordPress 儀表板。

2. 導覽至左側選單上的「設定」標籤。

3. 點選「閱讀」進入閱讀設定。

4. 向下捲動直到找到「搜尋引擎可見性」部分。

5. 在這裡,您將看到一個選項,顯示「阻止搜尋引擎為此網站建立索引」。 確保未選取此選項,因為它將產生一個基本的 robots.txt 文件,該文件限制搜尋引擎對您的整個網站的存取。

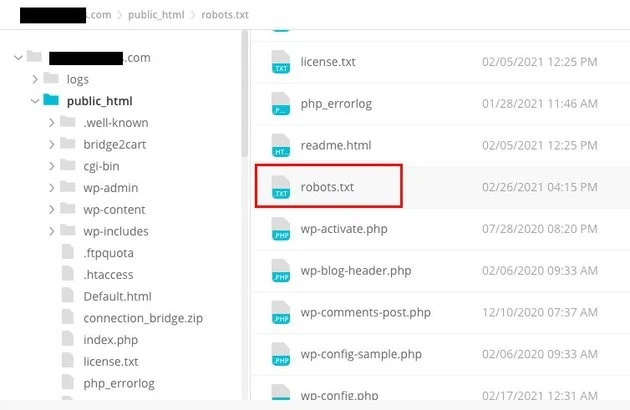

6. 如果您想進一步自訂 robots.txt 文件,可以透過造訪網站的根目錄來實現。 這通常可以透過 FTP 用戶端或 cPanel 檔案管理器來完成。

7. 找到根目錄後,尋找名為「robots.txt」的檔案。

8. 將現有 robots.txt 檔案的副本下載到您的電腦作為備份,以防編輯過程中出現任何問題。

9. 使用文字編輯器開啟 robots.txt 檔案。

10. 根據您的需求自訂文件。 您可以新增特定指令以允許或禁止存取網站的某些區域。 例如,您可以透過新增以下行來阻止搜尋引擎抓取您的管理區域:

1. 禁止:/wp-admin/

11. 儲存 robots.txt 檔案的變更並將其上傳回您網站的根目錄,替換先前的版本。

12. 最後,使用 Google 的 robots.txt 測試工具或其他類似工具測試您的 robots.txt 文件,以確保其配置正確。

在 WordPress 中,可以透過識別和修改適當位置的 robots.txt 檔案來控制搜尋引擎爬蟲與您的網站互動的方式。 這將使您在網站的可見性和排名方面獲得最佳結果。 如果您投入時間學習並成為搜尋引擎優化 (SEO) 這方面的專家,您將順利為您的 WordPress 網站帶來成功。

如何在 WordPress 中建立 Robots.txt 檔案?

既然我們已經討論了 robots.txt 檔案是什麼以及為什麼它如此重要,那麼讓我們繼續創建一個用於 SEO 的 WordPress Robots.txt。 WordPress 為您提供了兩個不同的選項來產生 robots.txt 檔案。 第一種方法涉及使用 WordPress 插件,而第二種方法涉及手動將文件上傳到網站的根資料夾。

步驟1:這是使用Yoast SEO外掛程式建立Robots.txt文件

您可以利用 SEO 外掛程式來幫助您優化基於 WordPress 建立的網站。 這些外掛程式中的大多數在其安裝包中提供了自己的 robots.txt 檔案產生器。

首先,下載並安裝插件。

導航到插件選單並點擊“新增插件”。 下一步是尋找 Yoast SEO 插件,下載它,如果還沒有,請將其打開。

第二步建立robots.txt文件

使用 Yoast 建立 robots txt 文件

您會注意到使用一些預設指令建立的檔案。

Yoast SEO 的 robots.txt 檔案產生器將自動包含以下指令:

使用者代理:* 不允許:/wp-admin/ 允許:/wp-admin/admin-ajax.php

向 robots.txt 添加額外的說明。 編輯 robots.txt 後,按一下「儲存」。

輸入您的網域和“/robots.txt”。 如果瀏覽器顯示預設指令,則您的 robots.txt 檔案已完成,如下所示。

產生機器人txt檔案

我們也建議您在 robots.txt 中新增網站地圖 URL。

預設機器人txt檔案

啟用外掛程式後,請前往 Yoast SEO > 工具,然後從下拉式選單中選擇文件編輯器。 繼續填寫您的域名,然後添加“/robots.txt”。 如果您查看瀏覽器,您會注意到顯示了一些預設指令。

步驟2:使用FTP手動建立Robots.txt文件

- 流程的下一步是在本機電腦上建立 robots.txt 文件,然後將其上傳到 WordPress 網站的根資料夾。

- 除此之外,您還需要透過使用 Filezilla 等 FTP 程式存取您的 WordPress 託管。 如果您還沒有登入所需的憑證,您可以透過託管服務的控制面板存取這些憑證。 因此,您可以在使用 FTP 程式登入後檢查網站根資料夾中是否存在 robots.txt 檔案。

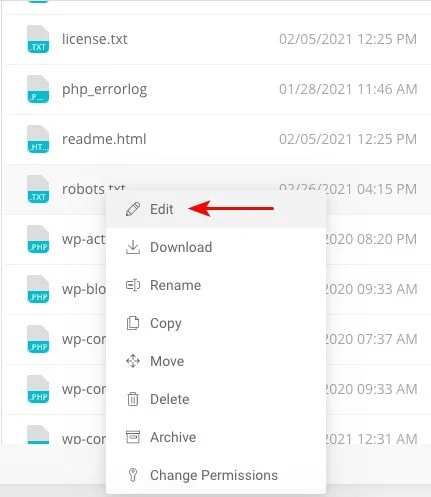

- 右鍵單擊該文件並選擇編輯(如果存在)。

因此,當您成功登入 FTP 用戶端後,您將能夠檢查網站根資料夾中是否存在 robots.txt 檔案。 輸入您的域名,後面跟著“/robots.txt”是確定文件是否上傳成功的最佳方法。

進行更改後,按一下“儲存”。

如果該文件尚不存在,則必須建立該文件。 可以透過使用記事本等基本文字編輯器將指令新增至文件來完成。 例如

使用者代理:* 不允許:/wp-admin/ 允許:/wp-admin/admin-ajax.php

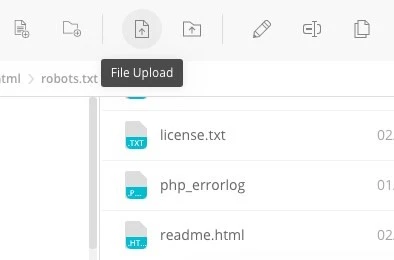

點擊 FTP 用戶端中的“檔案上傳”,將檔案上傳到網站的根資料夾。

輸入您的網域和“/robots.txt”以查看您的檔案是否已成功上傳。

這是手動將 robots.txt 檔案上傳到 WordPress 網站的方法!

Robots.txt:知道它的優點和缺點

使用 robots.txt 檔案的好處

它指示搜尋引擎不要將時間花在您不希望被索引的網站上,這有助於優化搜尋引擎的抓取預算。 透過這樣做,您可以增加搜尋引擎抓取對您最重要的網站的可能性。

阻止以這種方式浪費 Web 伺服器資源的機器人有助於優化伺服器。

它對於隱藏感謝頁面、登陸頁面、登入頁面和其他不需要搜尋引擎索引的頁面非常有用。

robots.txt 檔案的負面影響

您現在應該可以使用此處提供的資訊在任何網站上查看 robots.txt 檔案。 這並不難理解。 只需輸入域名,然後輸入“/robots.txt”,然後按 Enter 鍵即可。

然而,這在某種程度上也存在危險。 用於 SEO 的 WordPress Robots.txt 檔案可能包含您網站的某些內部頁面的 URL,您不希望這些頁面被搜尋引擎索引。

例如,可能有一個登入頁面出於某種原因您不希望被索引。 然而,robots.txt 檔案中提到的這一事實使得攻擊者有可能看到該網站。 如果您試圖隱藏某些敏感訊息,同樣的情況也適用。

即使您在編寫 robots.txt 檔案時犯了一個拼字錯誤,它也會導致您所有的搜尋引擎優化 (SEO) 工作付諸東流。 即使文件很容易創建,情況也是如此。

Robots.txt 檔案的放置位置

假設此時您熟悉 robots.txt 檔案的插入位置。

您網站的 robots.txt 檔案應始終位於網站的根目錄中。 如果您的網域是 yourdomain.com,則您網站上的 robots.txt 檔案的 URL 將為 https://yourdomain.com/robots.txt。

除了將 robots.txt 檔案放置在網站的根目錄中之外,以下是應遵循的其他一些建議做法:

- 將文件命名為 robots.txt 是非常必要的。

- 名字大寫很重要。 因此,您需要正確獲取它,否則它將無法發揮作用。

- 每條指令需要放在單獨的行上。

- 當 URL 完整時,應標示「$」符號。

- 每個使用者代理只能使用一個實例。

- 為了向人們提供 robots.txt 檔案內容的解釋,請使用註釋,每行以井號 (#) 開頭。

測試和驗證您的 robots.txt 文件

測試和驗證 robots.txt 檔案是確保搜尋引擎正確抓取您的網站並將其編入索引的關鍵步驟。 優化良好的robots.txt檔案可以防止搜尋引擎存取敏感或不相關的頁面,提高抓取效率,並最終增強網站的整體效能。

要開始測試您的 robots.txt 文件,您可以利用專門為此目的設計的各種線上工具。 這些工具可讓您輸入 robots.txt 指令並模擬搜尋引擎如何解釋和遵循它們。

透過分析結果,您可以識別文件中的任何潛在問題或錯誤配置。 定期監控和更新 robots.txt 檔案至關重要,尤其是在更改網站結構或內容時。

透過保持警惕,您可以快速識別並糾正可能出現的任何問題。 這種細緻的方法最終將有助於提高您網站的可感知性、索引度以及在數位領域的整體成功。

我們在這裡建議的工具是 Google Search Console

您可以透過前往「立即新增資源」連結並按照螢幕上顯示的簡單說明操作,將您的網站新增至 Google Search Console。 完成後,標有“請選擇屬性”的下拉式選單將在選項中包含您的網站。

選擇網站後,工具將自動取得與您的網站關聯的 robots.txt 文件,並突出顯示任何錯誤或警告(如果有)。

您的 WordPress 網站需要 Robots.txt 檔案嗎?

事實上,您的 WordPress 網站確實需要 robots.txt 檔案。 即使您的網站沒有 robots.txt 文件,搜尋引擎仍然會對其進行抓取和索引。 既然我們已經討論了 robots.txt 的用途、運作方式和抓取預算,那麼您為什麼要省略其中一項呢?

搜尋引擎透過 robots.txt 檔案接受訓練,了解哪些內容可以抓取,更重要的是,哪些內容不可以抓取。

考慮到抓取預算的負面後果是增加 robots.txt 的主要原因之一。

如前所述,每個網站都有一個抓取預算。 這一切都取決於機器人在單一會話中訪問的網站數量。 如果機器人在該會話中未完成網站上的所有頁面,它將返回並在後續會話中繼續抓取。

此外,這還會降低您的網站被索引的速度。

您可以透過阻止搜尋機器人掃描媒體資產、主題目錄、外掛程式和無關網站來快速解決此問題,從而節省抓取配額。

最後的話

在處理您的網站時,我們會優先考慮內容優化、關鍵字研究、建立反向連結、建立 sitemap.xml 以及其他 SEO 相關任務。 WordPress Robots.txt 對於 SEO 來說是一些網站管理員忽略的一個面向。

當您的網站首次啟動時,robots.txt 檔案可能不是很重要。 話雖這麼說,當您的網站變得更大並擁有更多頁面時,如果我們開始使用推薦的 robots.txt 文件,將會獲得豐厚的回報。